Comment fonctionne Azure Synapse Analytics ?

En réponse aux besoins d’analyse des entreprises d’aujourd’hui, Azure Synapse Analytics combine un service centralisé de stockage et de traitement des données avec une architecture extensible au travers de laquelle des services liés permettent d’intégrer des magasins de données, des plateformes de traitement et des outils de visualisation couramment utilisés.

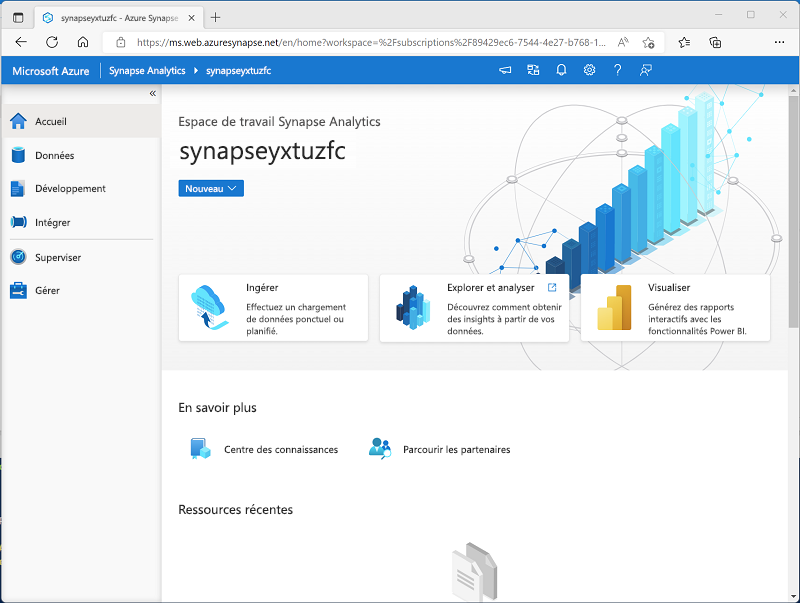

Création et utilisation d’un espace de travail Azure Synapse Analytics

Un espace de travail Synapse Analytics définit une instance du service Synapse Analytics dans laquelle vous pouvez gérer les services et les ressources de données nécessaires pour votre solution d’analyse. Vous pouvez créer un espace de travail Synapse Analytics dans un abonnement Azure de manière interactive via le portail Azure, ou vous pouvez automatiser le déploiement à l’aide d’Azure PowerShell, de l’interface de ligne de commande Azure ou d’un modèle Azure Resource Manager ou Bicep.

Après avoir créé un espace de travail Synapse Analytics, vous pouvez gérer les services qu’il contient et effectuer des tâches d’analytique données avec ceux-ci en utilisant Synapse Studio, un portail web pour Azure Synapse Analytics.

Utilisation de fichiers dans un lac de données

L’une des principales ressources dans un espace de travail Synapse Analytics est un Lac de données dans lequel stocker et traiter les fichiers de données à grande échelle. Un espace de travail possède généralement un lac de données par défaut qui est implémenté en tant que service lié dans un conteneur Azure Data Lake Storage Gen2. Vous pouvez ajouter des services liés pour plusieurs lacs de données basés sur différentes plateformes de stockage, en fonction des besoins.

Ingestion et transformation de données avec des pipelines

Dans la plupart des solutions d’analytique données d’entreprise, les données sont extraites de plusieurs sources opérationnelles et transférées vers un lac de données ou un entrepôt de données central à des fins d’analyse. Azure Synapse Analytics inclut la prise en charge intégrée de la création, de l’exécution et de la gestion de pipelines qui orchestrent les activités nécessaires pour récupérer des données à partir d’une série de sources, transformer les données au gré des besoins, et charger les données transformées dans un magasin analytique.

Notes

Les pipelines dans Azure Synapse Analytics sont basés sur la même technologie sous-jacente qu’Azure Data Factory. Si vous connaissez déjà Azure Data Factory, vous pouvez tirer parti de vos compétences existantes pour générer des solutions d’ingestion et de transformation de données dans Azure Synapse Analytics.

Interrogation et manipulation de données avec SQL

SQL est un langage omniprésent pour l’interrogation et la manipulation de données, qui constitue la base des bases de données relationnelles, dont Microsoft SQL Server, plateforme de base de données bien connue. Azure Synapse Analytics prend en charge l’interrogation et la manipulation de données SQL par le biais de deux sortes de pools SQL basés sur le moteur de base de données relationnelle SQL Server :

- Un pool serverless intégré, optimisé pour l’utilisation de la sémantique SQL relationnelle pour interroger des données basées sur des fichiers dans un lac de données.

- Des pools SQL dédiés personnalisés qui hébergent des entrepôts de données relationnelles.

Le système Azure Synapse SQL utilise un modèle de traitement des requêtes distribuées pour paralléliser les opérations SQL, ce qui se traduit par une solution hautement évolutive pour le traitement des données relationnelles. Vous pouvez utiliser le pool serverless intégré pour l’analyse et le traitement rentables des données de fichiers dans le lac de données, et vous servir de pools SQL dédiés pour créer des entrepôts de données relationnelles pour la modélisation de données d’entreprise et la création de rapports.

Traitement et analyse de données avec Apache Spark

Apache Spark est une plateforme open source pour l’analytique de Big Data. Spark effectue un traitement distribué de fichiers dans un lac de données en exécutant des tâches qui peuvent être implémentées à l’aide d’une série de langages de programmation pris en charge. Les langages pris en charge dans Spark sont Python, Scala, Java, SQL et C# .

Dans Azure Synapse Analytics, vous pouvez créer un ou plusieurs pools Spark, et utiliser des notebooks interactifs pour combiner du code et des notes lorsque vous créez des solutions pour l’analytique données, l’apprentissage automatique et la visualisation de données.

Exploration des données avec Data Explorer

Azure Synapse Data Explorer est un moteur de traitement des données dans Azure Synapse Analytics, qui est basé sur le service Azure Data Explorer. Data Explorer utilise une syntaxe de requête intuitive nommée Langage de requête Kusto (KQL) pour permettre une analyse haute performance et à faible latence de données de traitement par lots et de diffusion en continu.

Intégration avec d’autres services de données Azure

Azure Synapse Analytics peut être intégré avec d’autres services de données Azure pour des solutions d’analyse de bout en bout. Les solutions intégrées sont les suivantes :

- L’intégration d’Azure Synapse Link permet une synchronisation en quasi-temps réel entre des données opérationnelles dans Azure Cosmos DB, Azure SQL Database, SQL Server et Microsoft Power Platform Dataverse, et un stockage de données analytiques interrogeable dans Azure Synapse Analytics.

- L’intégration de Microsoft Power BI permet aux analystes de données d’intégrer un espace de travail Power BI dans un espace de travail Synapse, et d’effectuer une visualisation interactive des données dans Azure Synapse Studio.

- L’intégration de Microsoft Purview permet aux organisations de cataloguer des ressources de données dans Azure Synapse Analytics, et facilite pour les ingénieurs de données la recherche de ressources de données et le suivi de traçabilité des données lors de l’implémentation de pipelines de données qui ingèrent des données dans Azure Synapse Analytics.

- L’intégration d’Azure Machine Learning permet aux analystes et aux scientifiques des données d’intégrer l’apprentissage et la consommation de modèles prédictifs dans des solutions analytiques.