Fonctionnalités et technologies intégrées logicielles et matérielles (SH)

Ces fonctionnalités ont à la fois des composants logiciels et matériels. Le logiciel est intimement lié aux fonctionnalités matérielles requises pour que la fonctionnalité fonctionne. Par exemple, VMMQ, VMQ, Déchargement de la somme de contrôle IPv4 côté envoi et RSS. Pour en savoir plus, consultez Besoins relatifs aux réseaux hôtes pour Azure Stack HCI.

Conseil

Les fonctionnalités SH et HO sont disponibles si la carte réseau installée les prend en charge. Les descriptions de fonctionnalités ci-dessous expliquent comment déterminer si votre carte réseau prend en charge la fonctionnalité.

NIC Convergé

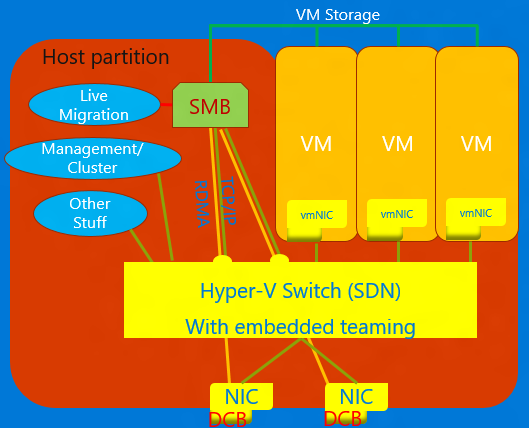

La carte réseau convergée est une technologie qui permet aux cartes réseau virtuelles de l’hôte Hyper-V d’exposer les services RDMA aux processus hôtes. Windows Server 2016 ne nécessite plus de cartes réseau distinctes pour RDMA. La fonctionnalité de carte réseau convergée permet aux cartes réseau virtuelles de la partition hôte (vNIC) d’exposer RDMA à la partition hôte et de partager la bande passante des cartes réseau entre le trafic RDMA et la machine virtuelle et tout autre trafic TCP/UDP de manière équitable et gérable.

Vous pouvez gérer l’opération de carte réseau convergée via VMM ou Windows PowerShell. Les applets de commande PowerShell sont les mêmes que celles utilisées pour RDMA (voir ci-dessous).

Pour utiliser la fonctionnalité de carte réseau convergée :

Veillez à configurer l’hôte pour DCB.

Veillez à activer RDMA sur la carte réseau ou, dans le cas d’une équipe SET, les cartes réseau sont liées au commutateur Hyper-V.

Veillez à activer RDMA sur les cartes réseau virtuelles désignées pour RDMA dans l’hôte.

Pour plus de détails sr Accès direct à la mémoire à distance (RDMA, Remote Direct Memory Access) et SET, consultez RDMA (accès direct à la mémoire à distance) et SET (Switch Embedded Teaming).

DCB (Data Center Bridging)

Le GCN est une suite de normes de l'Institute of Electrical and Electronics Engineers (IEEE) qui permet d'utiliser des tissus convergents dans les centres de données. DCB fournit une gestion de la bande passante basée sur la file d’attente matérielle dans un hôte avec la coopération du commutateur adjacent. Tout le trafic pour le stockage, la mise en réseau des données, la communication Inter-Process de cluster (IPC) et la gestion partagent la même infrastructure réseau Ethernet. Dans Windows Server 2016, DCB peut être appliqué à n’importe quelle carte réseau individuellement et cartes réseau liées au commutateur Hyper-V.

Pour DCB, Windows Server utilise le contrôle de flux basé sur la priorité (PFC), standardisé dans IEEE 802.1Qbb. PFC crée une infrastructure réseau (presque) sans perte en empêchant le dépassement de capacité dans les classes de trafic. Windows Server utilise également la sélection de transmission améliorée (ETS), standardisée dans IEEE 802.1Qaz. ETS permet la division de la bande passante en parties réservées pour jusqu’à huit classes de trafic. Chaque classe de trafic a sa propre file d’attente de transmission et, grâce à l’utilisation de PFC, peut démarrer et arrêter la transmission au sein d’une classe.

Virtualisation de réseau Hyper-V

| Version | Description |

|---|---|

| v1 (HNVv1) | La virtualisation de réseau Hyper-V (HNV), introduite dans Windows Server 2012, virtualise les réseaux clients sur une infrastructure réseau physique partagée. Les modifications à apporter à l’infrastructure réseau physique étant minimes, HNV confère aux fournisseurs de services l’agilité nécessaire pour déployer et migrer des charges de travail de locataire dans l’ensemble des trois clouds : le cloud du fournisseur de services, le cloud privé ou le cloud public Microsoft Azure. |

| v2 NVGRE (HNVv2 NVGRE) | Dans Windows Server 2016 et System Center Virtual Machine Manager, Microsoft fournit une solution de virtualisation de réseau de bout en bout qui comprend la passerelle RAS, l’équilibrage de charge logicielle, le contrôleur de réseau, etc. Pour plus d’informations, consultez Vue d’ensemble de la virtualisation de réseau Hyper-V dans Windows Server 2016. |

| v2 VxLAN (HNVv2 VxLAN) | Dans Windows Server 2016, fait partie de l’extension SDN, que vous gérez via le contrôleur de réseau. |

Déchargement de tâches IPsec (IPsecTO)

Le déchargement de tâche IPsec est une fonctionnalité de carte réseau qui permet au système d’exploitation d’utiliser le processeur sur la carte réseau pour le travail de chiffrement IPsec.

Important

Le déchargement de tâches IPsec est une technologie héritée qui n’est pas prise en charge par la plupart des cartes réseau et, là où elle existe, elle est désactivée par défaut.

Réseau local virtuel privé (PVLAN).

Les PVLAN autorisent la communication uniquement entre les machines virtuelles sur le même serveur de virtualisation. Un réseau virtuel privé n'est pas lié à une carte réseau physique. Un réseau virtuel privé est isolé de l’ensemble du trafic réseau externe sur le serveur de virtualisation ainsi que tout trafic réseau entre le système d’exploitation de gestion et le réseau externe. Ce type de réseau est utile lorsque vous avez besoin de créer un environnement réseau isolé, comme un domaine de test isolé. Les piles Hyper-V et SDN prennent uniquement en charge le mode port isolé PVLAN.

Pour plus d’informations sur l’isolation PVLAN, consultez System Center : Blog de l’ingénierie Virtual Machine Manager.

Accès direct à la mémoire à distance (RDMA, Remote Direct Memory Access)

RDMA est une technologie de mise en réseau qui fournit une communication à débit élevé et à faible latence qui réduit l’utilisation du processeur. RDMA prend en charge la mise en réseau sans copie en permettant à la carte réseau de transférer des données directement vers ou à partir de la mémoire d’application. Compatible RDMA signifie que la carte réseau (physique ou virtuelle) est capable d’exposer RDMA à un client RDMA. En revanche, avec RDMA, une carte réseau compatible RDMA expose l’interface RDMA dans la pile.

Pour plus de détails sr Accès direct à la mémoire à distance (RDMA, Remote Direct Memory Access), consultez RDMA (accès direct à la mémoire à distance) et SET (Switch Embedded Teaming).

Receive Side Scaling (RSS)

RSS est une fonctionnalité de carte réseau qui sépare différents ensembles de flux et les transmet à différents processeurs pour le traitement. RSS parallélise le traitement réseau, ce qui permet à un hôte de mettre à l’échelle des débits de données très élevés.

Pour plus de détails, consultez Partage du trafic entrant (RSS, Receive Side Scaling).

SR-IOV (Single-Root Input-Output Virtualization)

SR-IOV permet au trafic de machine virtuelle de se déplacer directement de la carte réseau vers la machine virtuelle sans passer par l’hôte Hyper-V. SR-IOV est une amélioration incroyable des performances d’une machine virtuelle, mais l’hôte ne peut pas gérer ce canal. Utilisez SR-IOV uniquement lorsque la charge de travail est bien conduite, approuvée et généralement la seule machine virtuelle de l’hôte.

Le trafic qui utilise SR-IOV contourne le commutateur Hyper-V, ce qui signifie que les stratégies, par exemple les listes de contrôle d’accès ou la gestion de la bande passante, ne seront pas appliquées. Le trafic SR-IOV ne peut pas non plus être transmis via une fonctionnalité de virtualisation réseau. L’encapsulation NV-GRE ou VxLAN ne peut donc pas être appliquée. Utilisez SR-IOV uniquement pour des charges de travail fiables dans des situations spécifiques. En outre, vous ne pouvez pas utiliser les stratégies d’hôte, la gestion de la bande passante et les technologies de virtualisation.

À l’avenir, deux technologies permettront sr-IOV : les tables de flux génériques (GFT) et le déchargement de QoS matérielle (gestion de la bande passante dans la carte réseau) une fois que les cartes réseau de notre écosystème les prennent en charge. La combinaison de ces deux technologies rendrait SR-IOV utile pour toutes les machines virtuelles, permettrait d’appliquer des stratégies, des règles de virtualisation et de gestion de la bande passante, et pourrait entraîner de grands pas en avant dans l’application générale de SR-IOV.

Pour plus d’informations, consultez Vue d’ensemble de la virtualisation d’E/S racine unique (SR-IOV).

Déchargement TCP Chimney

TCP Chimney Offload, également appelé TCP Engine Offload (TOE), est une technologie qui permet à l’hôte de décharger tous les traitements TCP sur la carte réseau. Étant donné que la pile TCP Windows Server est presque toujours plus efficace que le moteur TOE, l’utilisation de TCP Chimney Offload n’est pas recommandée.

Important

TCP Chimney Offload est une technologie déconseillée. Nous vous recommandons de ne pas utiliser TCP Chimney Offload, car Microsoft pourrait cesser de le prendre en charge à l’avenir.

Réseau local virtuel (VLAN)

VLAN est une extension de l’en-tête de trame Ethernet pour permettre le partitionnement d’un réseau local en plusieurs réseaux locaux virtuels, chacun utilisant son propre espace d’adressage. Dans Windows Server 2016, les réseaux locaux virtuels sont définis sur les ports du commutateur Hyper-V ou en définissant les interfaces d’équipe sur les équipes d’association de cartes réseau.

File d’attente d’ordinateurs virtuels (VMQ, Virtual Machine Queue)

VMQ est une fonctionnalité de carte réseau qui alloue une file d’attente pour chaque machine virtuelle. Chaque fois qu’Hyper-V est activé ; vous devez également activer VMQ. Dans Windows Server 2016, les VMQs utilisent les vPorts de commutateur de carte réseau avec une seule file d’attente affectée au vPort pour fournir les mêmes fonctionnalités.

VMMQ (Virtual Machine Multi-Queue)

VMMQ est une fonctionnalité de carte réseau qui permet au trafic d’une machine virtuelle de s’étendre sur plusieurs files d’attente, chacune traitée par un processeur physique différent. Le trafic est ensuite passé à plusieurs LPs dans la machine virtuelle comme il le serait dans vRSS, ce qui permet de fournir une bande passante réseau importante à la machine virtuelle.