Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

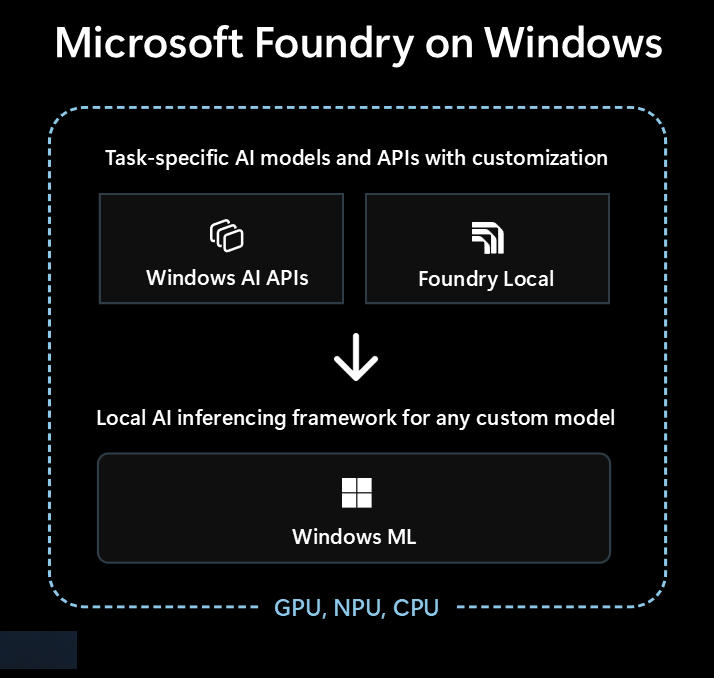

Microsoft Foundry on Windows est la première solution pour les développeurs qui cherchent à intégrer des fonctionnalités d’IA locales dans leurs applications Windows.

Microsoft Foundry on Windows fournit aux développeurs...

- Modèles et API IA prêts à l’emploi via Windows AI APIs et Foundry Local

- Infrastructure d’inférence d’IA pour exécuter n’importe quel modèle localement via Windows ML

Que vous soyez nouveau dans l’IA ou un expert en Machine Learning (ML) expérimenté, Microsoft Foundry on Windows vous avez quelque chose pour vous.

Modèles et API IA prêts à l’emploi

Votre application peut facilement utiliser les modèles et API IA locaux suivants en moins d’une heure. La distribution et le runtime des fichiers de modèle sont gérés par Microsoft et les modèles sont partagés entre les applications. L’utilisation de ces modèles et API ne prend qu’une poignée de lignes de code, sans expertise ML nécessaire.

| Type de modèle ou API | Qu’est-ce que c’est | Options et appareils pris en charge |

|---|---|---|

| Modèles de langage volumineux (LLMs) | Modèles de texte génératifs | Phi Silicon via AI APIs (prend en charge le réglage précis) ou 20+ modèles LLM OSS via Foundry Local Pour en savoir plus, consultez les machines virtuelles llms locales . |

| Description de l’image | Obtenir une description de texte en langage naturel d’une image | Description de l’image via AI APIs (PC Copilot+) |

| Extracteur de premier plan d’image | Segmenter le premier plan d’une image | Extracteur de premier plan d'image via AI APIs (PC Copilot+) |

| Génération d’images | Générer des images à partir du texte | Génération d’images via AI APIs (Pc Copilot+ ) |

| Effacement de l’objet Image | Effacer les objets des images | Effacement d'objet d'image via AI APIs (PC Copilot+) |

| Extracteur d’objets image | Segmenter des objets spécifiques dans une image | Extracteur d'objets à partir d'images via AI APIs (PCs Copilot+ ) |

| Super résolution d’image | Augmenter la résolution des images | Super résolution d’image via AI APIs (PC Copilot+ ) |

| Recherche sémantique | Rechercher sémantiquement du texte et des images | Recherche de contenu d’application via AI APIs (Pc Copilot+ ) |

| Reconnaissance vocale | Convertir la parole en texte | Chuchoter via Foundry Local ou reconnaissance vocale via le Kit de développement logiciel (SDK) Windows Pour en savoir plus, consultez reconnaissance vocale . |

| Reconnaissance de texte (OCR) | Reconnaître du texte à partir d’images | OCR via AI APIs (Pc Copilot+ ) |

| Video Super Resolution (VSR) | Augmenter la résolution des vidéos | Vidéo Super Résolution via AI APIs (Pc Copilot+ ) |

Utilisation d’autres modèles avec Windows ML

Vous pouvez utiliser un large éventail de modèles à partir de Hugging Face ou d’autres sources, ou même entraîner vos propres modèles, et les exécuter localement sur des PC Windows 10 et versions ultérieures à l’aide Windows MLde (la compatibilité et les performances des modèles varient en fonction du matériel de l’appareil).

Pour en savoir plus, consultez comment rechercher ou entraîner des modèles pour une utilisation avec Windows ML.

Quelle option commencer par

Suivez cet arbre de décision pour sélectionner la meilleure approche pour votre application et votre scénario :

Vérifiez si Windows intégré AI APIs couvre les scénarios et si vous ciblez des PC Copilot+. Il s’agit du chemin le plus rapide vers le marché avec un effort de développement minimal.

Si Windows AI APIs n’a pas ce dont vous avez besoin, ou si vous devez prendre en charge Windows 10 et plus, envisagez Foundry Local pour les scénarios de LLM ou de transcription vocale.

Si vous avez besoin de modèles personnalisés, souhaitez tirer parti des modèles existants à partir de Hugging Face ou d’autres sources, ou avoir des exigences de modèle spécifiques qui ne sont pas couvertes par les options ci-dessus, Windows ML vous offre la possibilité de trouver ou d’entraîner vos propres modèles (et prend en charge Windows 10 et versions ultérieures).

Votre application peut également utiliser une combinaison de ces trois technologies.

Technologies disponibles pour l’IA locale

Les technologies suivantes sont disponibles dans Microsoft Foundry on Windows:

| Windows AI APIs | Foundry Local | Windows ML | |

|---|---|---|---|

| Qu’est-ce que c’est | Modèles et API IA prêts à l’emploi sur différents types de tâches, optimisés pour les PC Copilot+ | Modèles LLM prêts à l’emploi et voix à texte | ONNX Runtime framework pour l’exécution de modèles que vous recherchez ou entraînez |

| Appareils pris en charge | Copilot+ PC | PC Windows 10 et versions ultérieures et multiplateforme (Les performances varient en fonction du matériel disponible, et non de tous les modèles disponibles) |

PC Windows 10 et versions ultérieures, et multiplateforme via open source ONNX Runtime (Les performances varient en fonction du matériel disponible) |

| Types de modèles et API disponibles |

LLM Description de l’image Extracteur de premier plan d’image Génération d’images Effacement de l’objet Image Extracteur d’objets image Super résolution d’image Recherche sémantique Reconnaissance de texte (OCR) Super résolution vidéo |

Grands Modèles de Langage (LLMs) (multiple) voix à texte Parcourir plus de 20 modèles disponibles |

Rechercher ou entraîner vos propres modèles |

| Distribution de modèle | Hébergé par Microsoft, acquis au moment de l’exécution et partagé entre les applications | Hébergé par Microsoft, acquis au moment de l’exécution et partagé entre les applications | Distribution gérée par votre application (les bibliothèques d’applications peuvent partager des modèles entre les applications) |

| En savoir plus | Lire la AI APIs documentation | Lire la Foundry Local documentation | Lire la Windows ML documentation |

Microsoft Foundry on Windows inclut également des outils de développement tels que AI Toolkit visual Studio Code et ai Dev Gallery qui vous aideront à créer des fonctionnalités d’IA.

AI Toolkit pour Visual Studio Code est une extension VS Code qui vous permet de télécharger et d’exécuter des modèles IA localement, notamment l’accès à l’accélération matérielle pour améliorer les performances et l’échelle via DirectML. La AI Toolkit peut également vous aider pour :

- Test de modèles dans un terrain de jeu intuitif ou dans votre application avec une API REST.

- Réglage précis de votre modèle IA, localement ou dans le cloud (sur une machine virtuelle) pour créer de nouvelles compétences, améliorer la fiabilité des réponses, définir le ton et le format de la réponse.

- Réglage des modèles populaires de langues à faibles ressources (SLMs), comme Phi-3 et Mistral.

- Déployez votre fonctionnalité IA dans le cloud ou avec une application qui s’exécute sur un appareil.

- Tirez parti de l’accélération matérielle pour améliorer les performances avec les fonctionnalités IA à l’aide de DirectML. DirectML est une API de bas niveau qui permet à votre matériel d’appareil Windows d’accélérer les performances des modèles ML à l’aide du GPU d’appareil ou du NPU. L’appairage de DirectML avec le ONNX Runtime est généralement le moyen le plus simple pour les développeurs d’apporter l’IA accélérée matériellement à leurs utilisateurs à grande échelle. En savoir plus : Vue d’ensemble de DirectML.

- Quantifiez et validez un modèle pour une utilisation sur NPU en utilisant les capacités de conversion de modèle.

Idées pour tirer parti de l’IA locale

Voici quelques façons dont les applications Windows peuvent tirer parti de l’IA locale pour améliorer leurs fonctionnalités et leur expérience utilisateur :

- Les applications peuvent utiliser des modèles d'IA générative LLM pour comprendre des rubriques complexes afin de résumer, réécrire, faire un rapport ou développer.

- Les applications peuvent utiliser des modèles LLM pour transformer du contenu de forme libre en un format structuré que votre application peut comprendre.

- Les applications peuvent utiliser des modèles de recherche sémantique qui permettent aux utilisateurs de rechercher du contenu en signification et de trouver rapidement du contenu associé.

- Les applications peuvent utiliser des modèles de traitement du langage naturel pour raisonner sur les exigences complexes du langage naturel, et planifier et exécuter des actions pour accomplir la demande de l’utilisateur.

- Les applications peuvent utiliser des modèles de manipulation d’images pour modifier intelligemment des images, effacer ou ajouter des sujets, une mise à l’échelle ou générer du nouveau contenu.

- Les applications peuvent utiliser des modèles de diagnostic prédictifs pour identifier et prédire les problèmes et guider l’utilisateur ou le faire pour eux.

Utilisation de modèles IA cloud

Si l’utilisation de fonctionnalités IA locales n’est pas le bon chemin pour vous, l’utilisation de modèles et de ressources IA cloud peut être une solution.

Utiliser des pratiques d’IA responsable

Chaque fois que vous incorporez des fonctionnalités IA dans votre application Windows, nous vous recommandons vivement de suivre le guide pratique Développement d’applications et de fonctionnalités d’IA générative responsable sur Windows.