Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Remarque

Les tutoriels Mixed Reality Academy ont été conçus pour les appareils HoloLens (1re génération) et les casques immersifs de réalité mixte. Nous estimons qu’il est important de laisser ces tutoriels à la disposition des développeurs qui recherchent encore des conseils pour développer des applications sur ces appareils. Notez que ces tutoriels ne sont pas mis à jour avec les derniers ensembles d’outils ou interactions utilisés pour HoloLens 2. Ils sont fournis dans le but de fonctionner sur les appareils pris en charge. Il y aura une nouvelle série de tutoriels qui seront publiés à l’avenir qui montreront comment développer pour HoloLens 2. Cet avis sera mis à jour avec un lien vers ces didacticiels lorsqu’ils sont publiés.

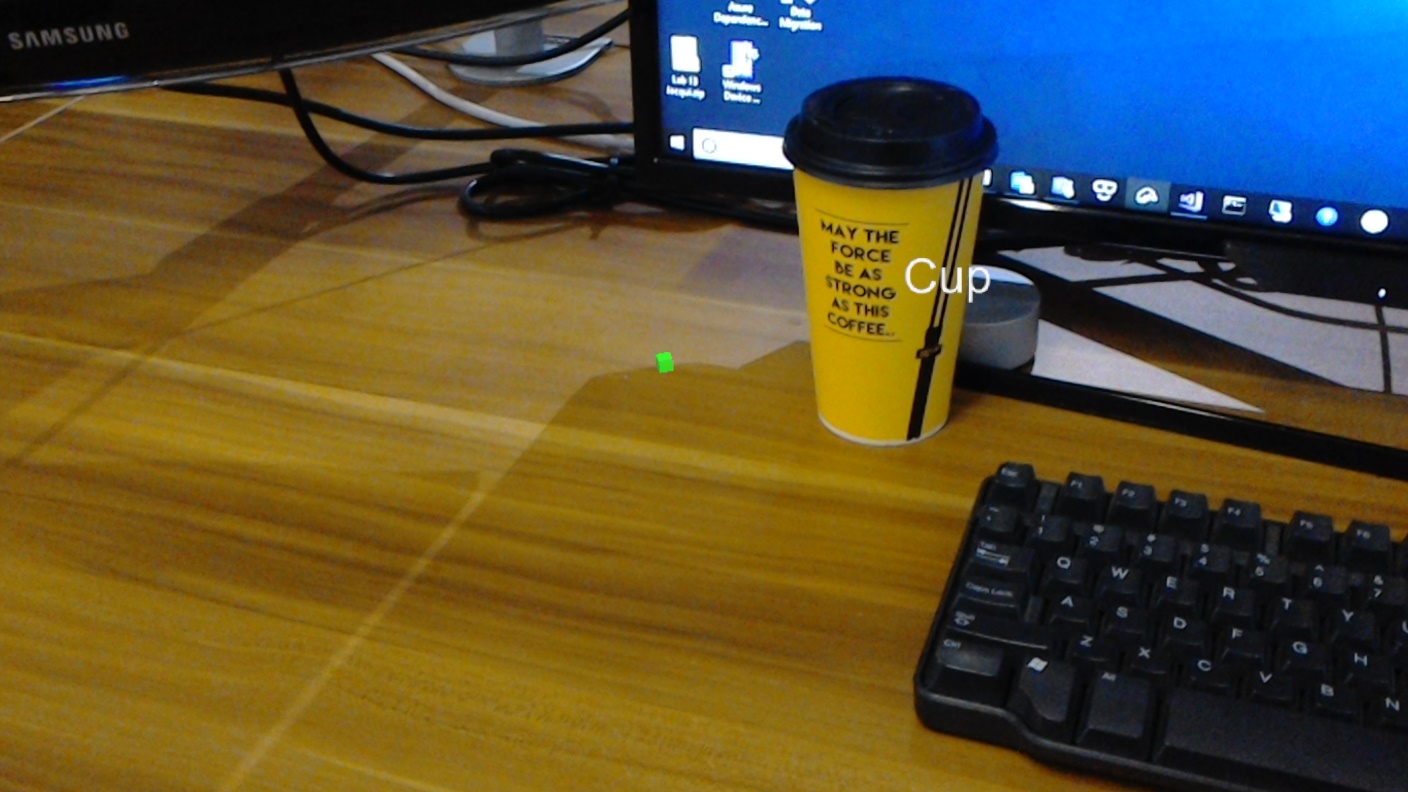

Dans ce cours, vous allez apprendre à reconnaître le contenu visuel personnalisé et sa position spatiale au sein d’une image fournie, à l’aide des fonctionnalités « Détection d’objets » d’Azure Custom Vision dans une application de réalité mixte.

Ce service vous permet d’entraîner un modèle Machine Learning à l’aide d’images objet. Vous allez ensuite utiliser le modèle entraîné pour reconnaître des objets similaires et estimer leur emplacement dans le monde réel, comme fourni par la capture d’appareil photo de Microsoft HoloLens ou une caméra se connectent à un PC pour les casques immersifs (VR).

Azure Custom Vision, Object Detection est un service Microsoft qui permet aux développeurs de créer des classifieurs d’images personnalisés. Ces classifieurs peuvent ensuite être utilisés avec de nouvelles images pour détecter des objets au sein de cette nouvelle image, en fournissant des limites box au sein de l’image elle-même. Le service fournit un portail en ligne simple et facile à utiliser pour simplifier ce processus. Pour plus d’informations, consultez les liens suivants :

Une fois ce cours terminé, vous aurez une application de réalité mixte qui sera en mesure d’effectuer les opérations suivantes :

- L’utilisateur sera en mesure de regarder un objet, qu’il a entraîné à l’aide du service Azure Custom Vision, détection d’objets.

- L’utilisateur utilise le mouvement Tap pour capturer une image de ce qu’il examine.

- L’application envoie l’image au service Azure Custom Vision.

- Il y aura une réponse du service qui affichera le résultat de la reconnaissance en tant que texte d’espace universel. Pour ce faire, utilisez le suivi spatial de Microsoft HoloLens, comme moyen de comprendre la position mondiale de l’objet reconnu, puis en utilisant la balise associée à ce qui est détecté dans l’image, pour fournir le texte de l’étiquette.

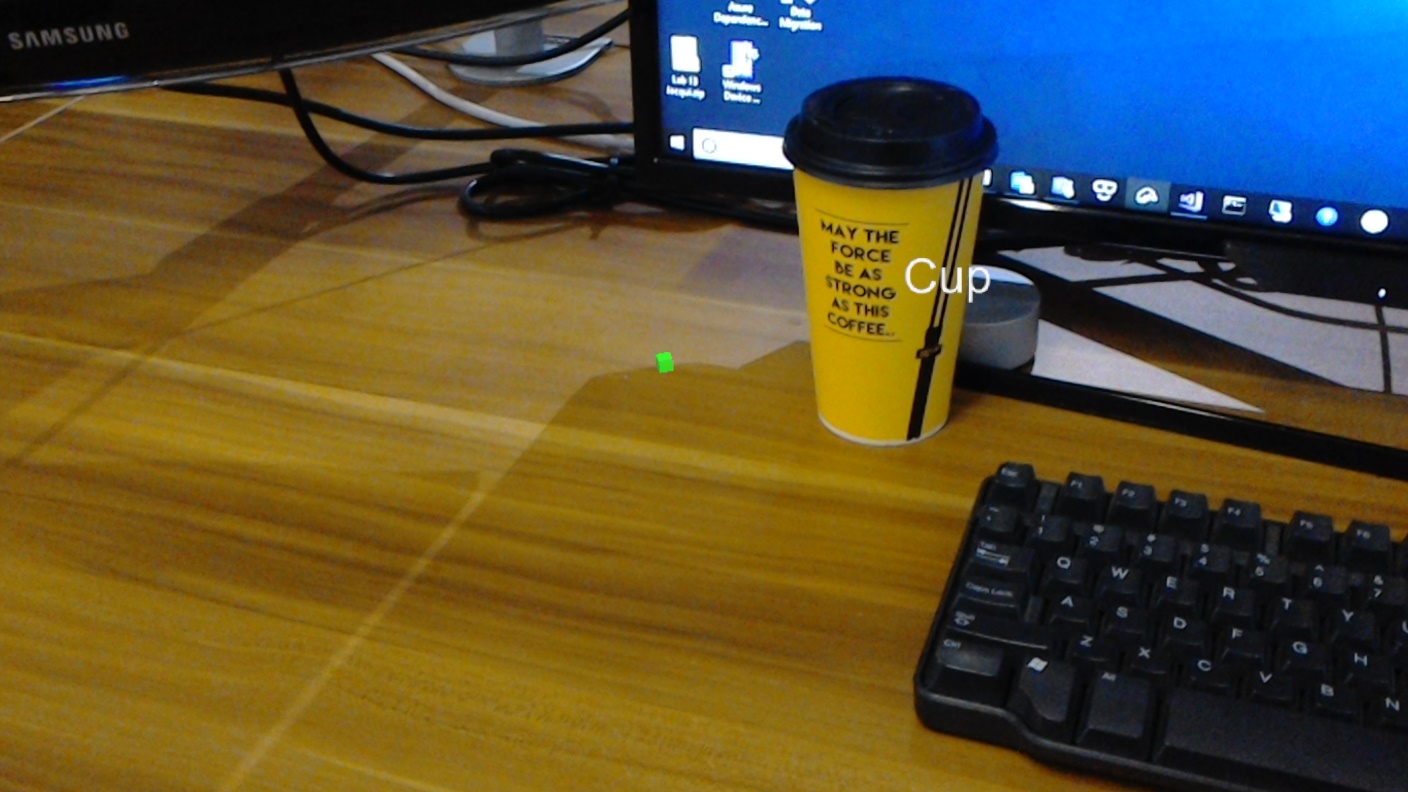

Le cours couvre également le chargement manuel d’images, la création de balises et l’apprentissage du service pour reconnaître différents objets (dans l’exemple fourni, une tasse) en définissant la zone de limite dans l’image que vous envoyez.

Important

Après la création et l’utilisation de l’application, le développeur doit revenir au service Azure Custom Vision et identifier les prédictions effectuées par le service, et déterminer s’ils étaient corrects ou non (par le biais de l’étiquetage de tout ce que le service a manqué et de l’ajustement des zones englobantes). Le service peut ensuite être réentraîné, ce qui augmentera la probabilité qu’il reconnaisse les objets réels.

Ce cours vous apprendra à obtenir les résultats du service Azure Custom Vision, de la détection d’objets, dans un exemple d’application basé sur Unity. Il vous sera possible d’appliquer ces concepts à une application personnalisée que vous créez peut-être.

Prise en charge des appareils

| Cours | HoloLens | Casques immersifs |

|---|---|---|

| MR et Azure 310 : Détection d’objets | ✔️ |

Prérequis

Remarque

Ce tutoriel est conçu pour les développeurs qui ont une expérience de base avec Unity et C#. Sachez également que les conditions préalables et les instructions écrites contenues dans ce document représentent ce qui a été testé et vérifié au moment de l’écriture (juillet 2018). Vous êtes libre d’utiliser le logiciel le plus récent, comme indiqué dans l’article d’installation des outils , bien qu’il ne soit pas supposé que les informations de ce cours correspondent parfaitement à ce que vous trouverez dans les logiciels plus récents que ceux répertoriés ci-dessous.

Nous vous recommandons le matériel et les logiciels suivants pour ce cours :

- Un PC de développement

- Windows 10 Fall Creators Update (ou version ultérieure) avec le mode développeur activé

- Le sdk Windows 10 le plus récent

- Unity 2017.4 LTS

- Visual Studio 2017

- Microsoft HoloLens avec le mode développeur activé

- Accès Internet pour la configuration d’Azure et la récupération du service Custom Vision

- Une série d’au moins quinze (15) images sont requises) pour chaque objet que vous souhaitez que Custom Vision reconnaisse. Si vous le souhaitez, vous pouvez utiliser les images déjà fournies avec ce cours, une série de tasses).

Avant de commencer

- Pour éviter de rencontrer des problèmes lors de la création de ce projet, il est fortement recommandé de créer le projet mentionné dans ce didacticiel dans un dossier racine ou quasi-racine (des chemins de dossier longs peuvent provoquer des problèmes au moment de la génération).

- Configurez et testez votre HoloLens. Si vous avez besoin de prise en charge pour cela, consultez l’article sur la configuration de HoloLens.

- Il est judicieux d’effectuer l’étalonnage et le réglage des capteurs lors du développement d’une nouvelle application HoloLens (parfois, il peut aider à effectuer ces tâches pour chaque utilisateur).

Pour obtenir de l’aide sur l’étalonnage, suivez ce lien vers l’article d’étalonnage HoloLens.

Pour obtenir de l’aide sur le réglage des capteurs, suivez ce lien vers l’article Paramétrage du capteur HoloLens.

Chapitre 1 - Portail Custom Vision

Pour utiliser le service Azure Custom Vision, vous devez configurer une instance de celle-ci pour qu’elle soit mise à la disposition de votre application.

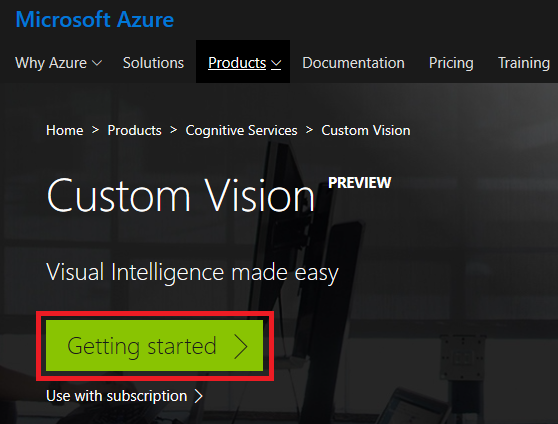

Accédez à la page principale du service Custom Vision.

Cliquez sur Prise en main.

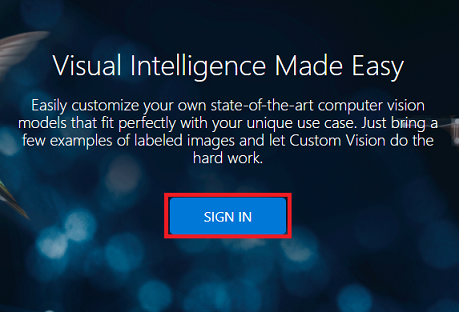

Connectez-vous au portail Custom Vision.

Si vous n’avez pas encore de compte Azure, vous devez en créer un. Si vous suivez ce tutoriel dans une situation de salle de classe ou de laboratoire, demandez à votre instructeur ou à l’un des proctoreurs de vous aider à configurer votre nouveau compte.

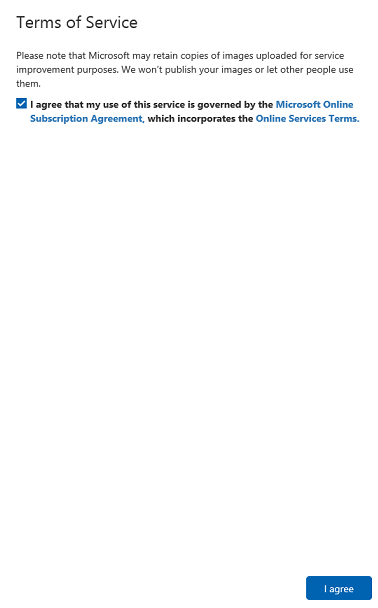

Une fois que vous êtes connecté pour la première fois, vous serez invité à utiliser le panneau Conditions d’utilisation . Cochez la case pour accepter les conditions. Cliquez ensuite sur J’accepte.

Après avoir accepté les termes, vous êtes maintenant dans la section Mes projets . Cliquez sur Nouveau projet.

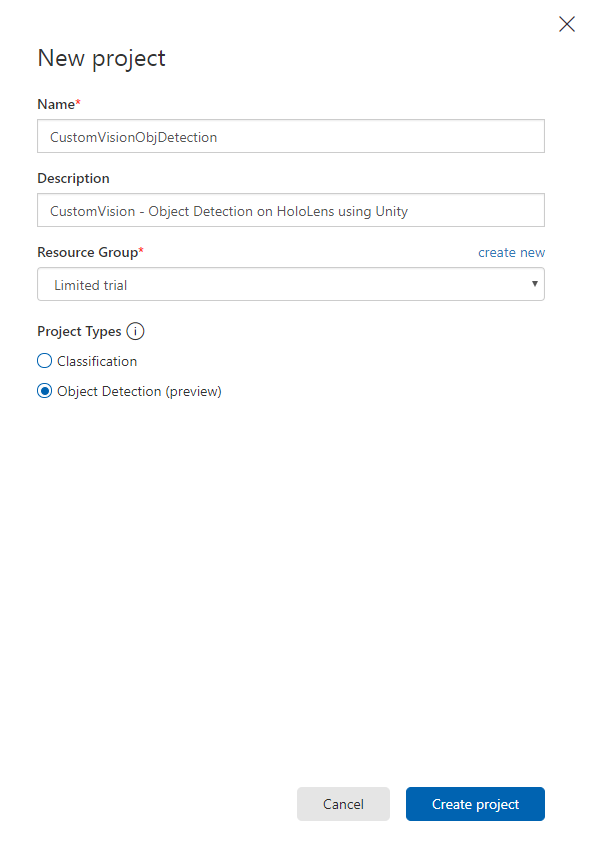

Un onglet s’affiche sur le côté droit, ce qui vous invite à spécifier certains champs pour le projet.

Insérer un nom pour votre projet

Insérer une description pour votre projet (facultatif)

Choisissez un groupe de ressources ou créez-en un. Un groupe de ressources permet de surveiller, de contrôler l’accès, de provisionner et de gérer la facturation d’une collection de ressources Azure. Il est recommandé de conserver tous les services Azure associés à un seul projet (par exemple, ces cours) sous un groupe de ressources commun.

Remarque

Si vous souhaitez en savoir plus sur les groupes de ressources Azure, accédez à la documentation associée.

Définissez les types de projet en tant que détection d’objets (préversion).

Une fois que vous avez terminé, cliquez sur Créer un projet et vous êtes redirigé vers la page du projet Service Custom Vision.

Chapitre 2 - Formation de votre projet Custom Vision

Une fois dans le portail Custom Vision, votre objectif principal est d’entraîner votre projet pour reconnaître des objets spécifiques dans des images.

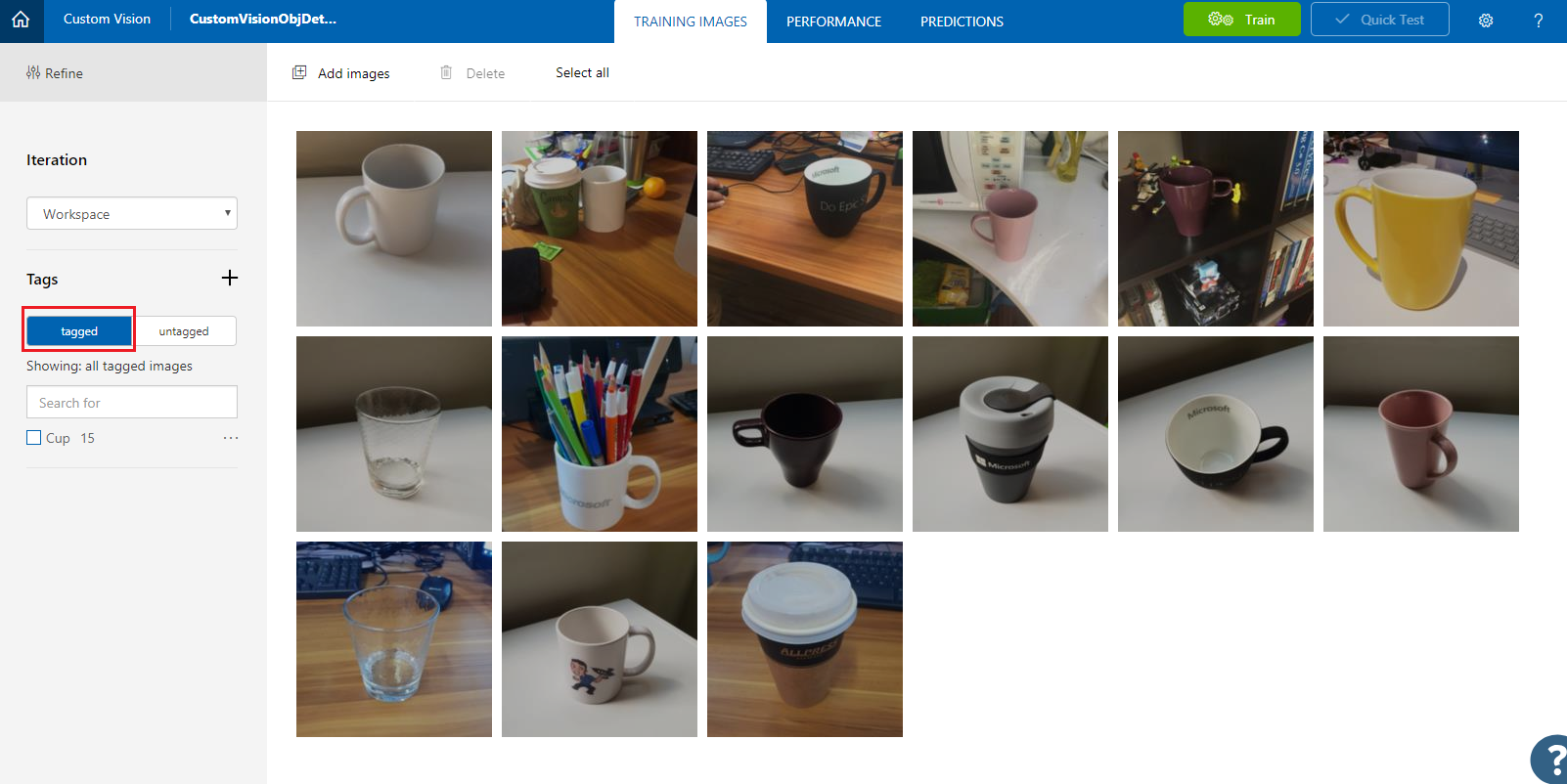

Vous avez besoin d’au moins quinze images (15) pour chaque objet que vous souhaitez que votre application reconnaisse. Vous pouvez utiliser les images fournies avec ce cours (une série de tasses).

Pour entraîner votre projet Custom Vision :

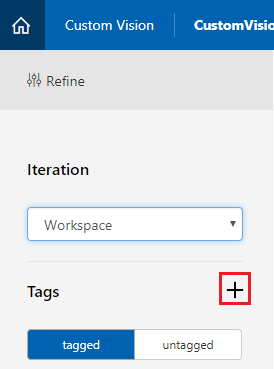

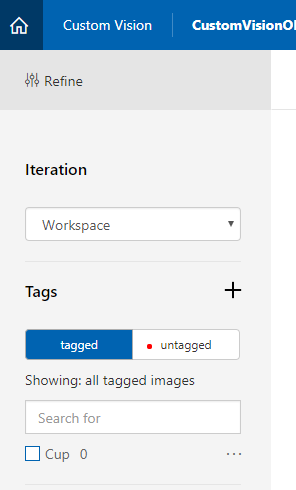

Cliquez sur le + bouton en regard des balises.

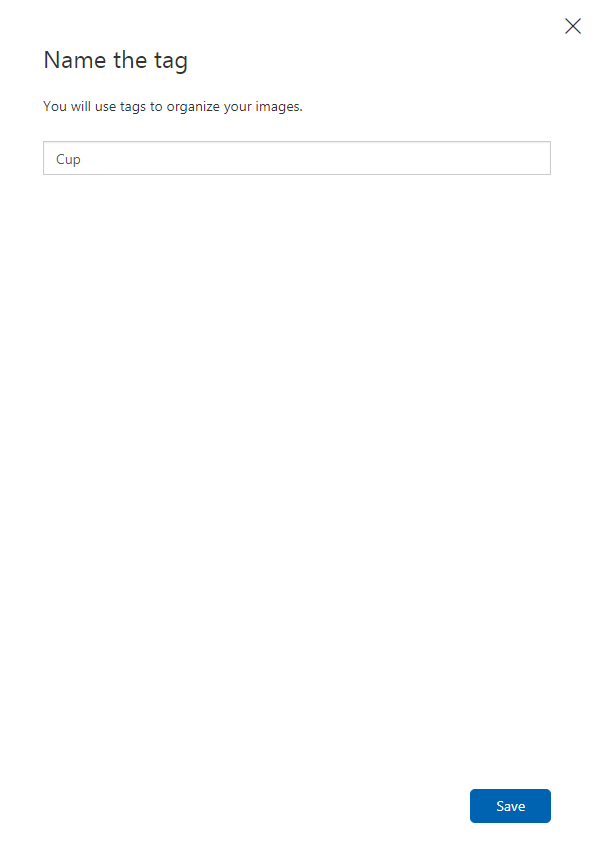

Ajoutez un nom pour la balise qui sera utilisée pour associer vos images. Dans cet exemple, nous utilisons des images de tasses pour la reconnaissance. Par conséquent, nous avons nommé la balise pour cette coupe. Cliquez sur Enregistrer une fois terminé.

Vous remarquerez que votre balise a été ajoutée (vous devrez peut-être recharger votre page pour qu’elle apparaisse).

Cliquez sur Ajouter des images dans le centre de la page.

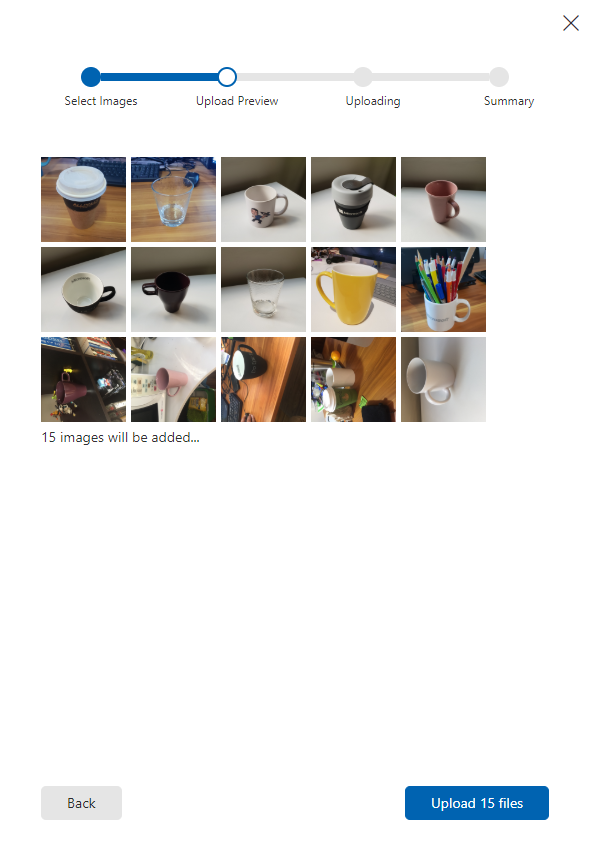

Cliquez sur Parcourir les fichiers locaux et accédez aux images que vous souhaitez charger pour un objet, avec au minimum quinze (15).

Conseil

Vous pouvez sélectionner plusieurs images à la fois pour charger.

Appuyez sur Charger des fichiers une fois que vous avez sélectionné toutes les images avec lesquelles vous souhaitez effectuer l’apprentissage du projet. Les fichiers commencent à être chargés. Une fois que vous avez confirmé le chargement, cliquez sur Terminé.

À ce stade, vos images sont chargées, mais pas marquées.

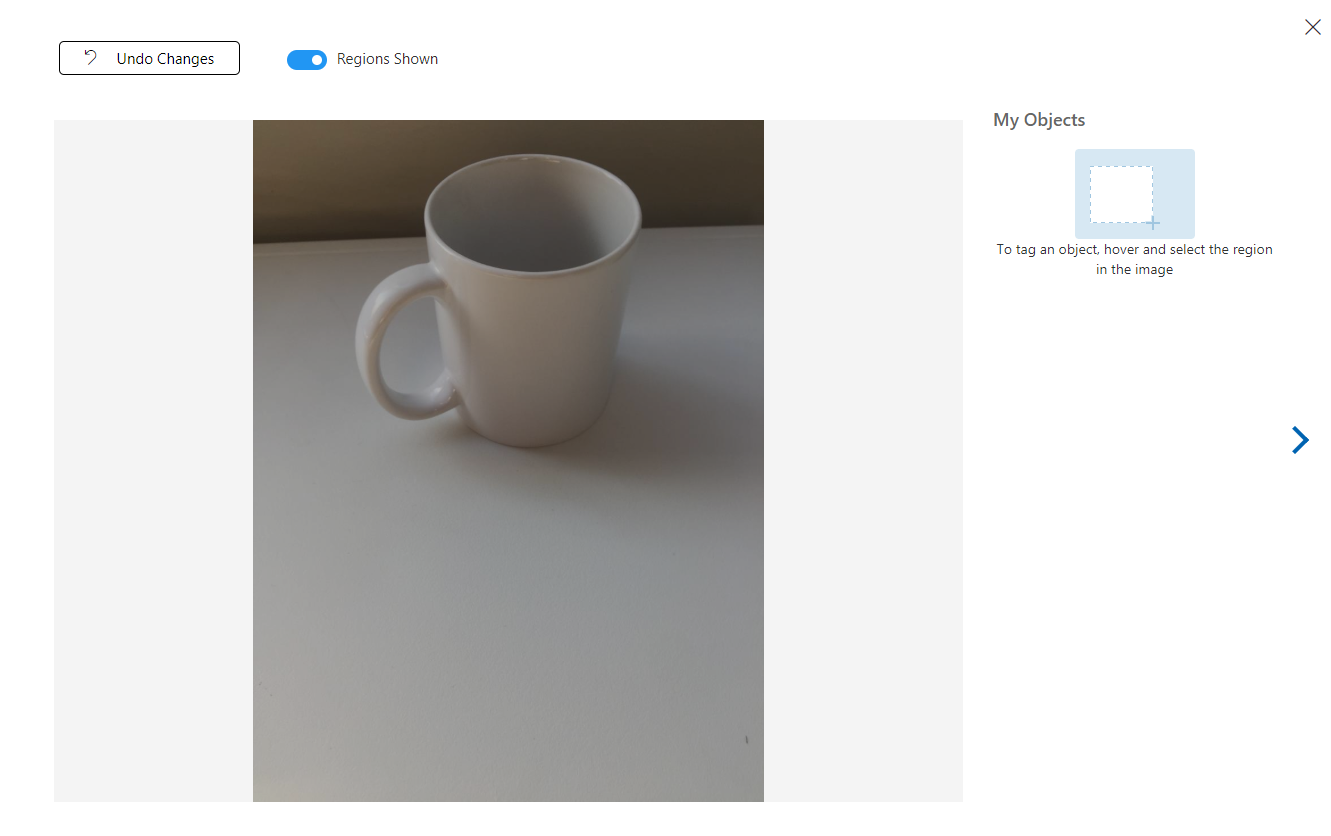

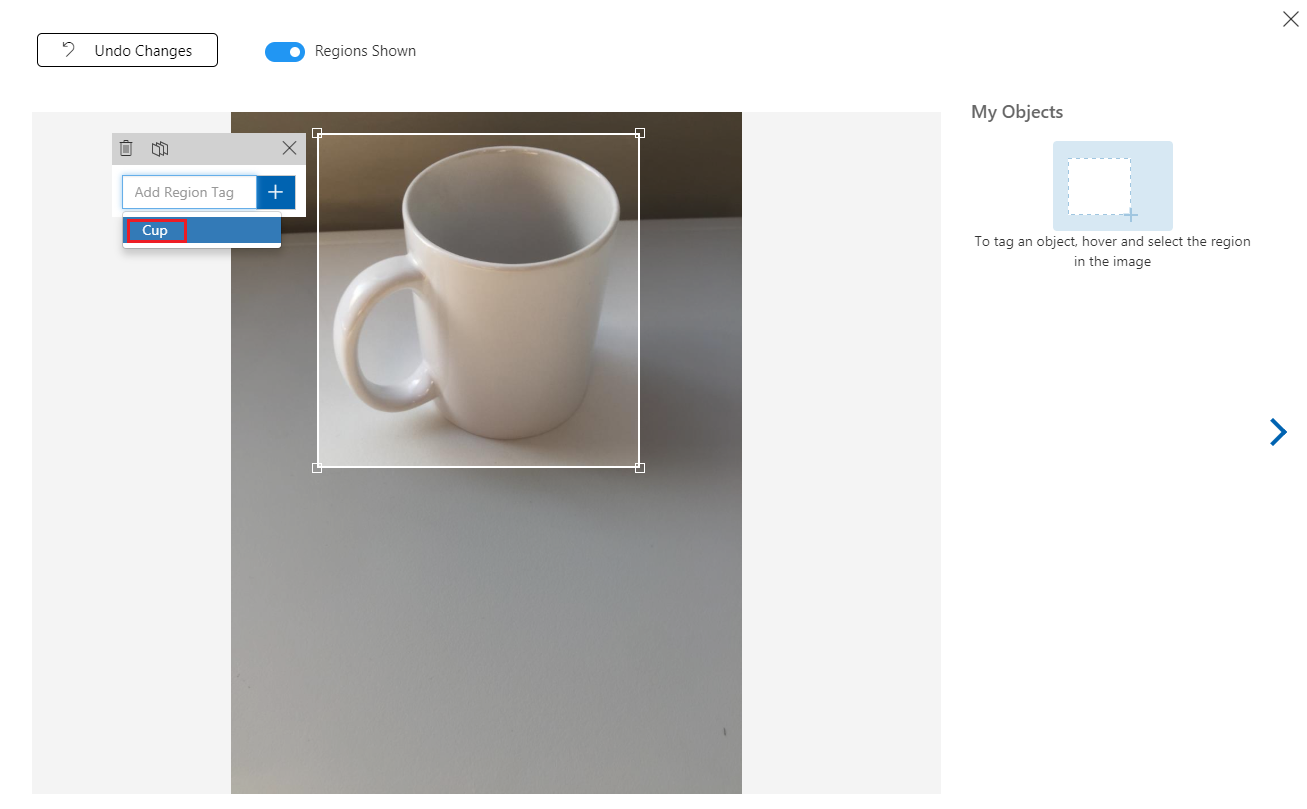

Pour étiqueter vos images, utilisez votre souris. Lorsque vous pointez sur votre image, une sélection en surbrillance vous aidera à dessiner automatiquement une sélection autour de votre objet. S’il n’est pas exact, vous pouvez dessiner votre propre. Pour ce faire, maintenez le clic gauche sur la souris et faites glisser la zone de sélection pour englober votre objet.

Après la sélection de votre objet dans l’image, une petite invite vous demande d’ajouter une balise de région. Sélectionnez votre balise créée précédemment ('Cup', dans l’exemple ci-dessus), ou si vous ajoutez d’autres balises, tapez-la et cliquez sur le bouton + (plus).

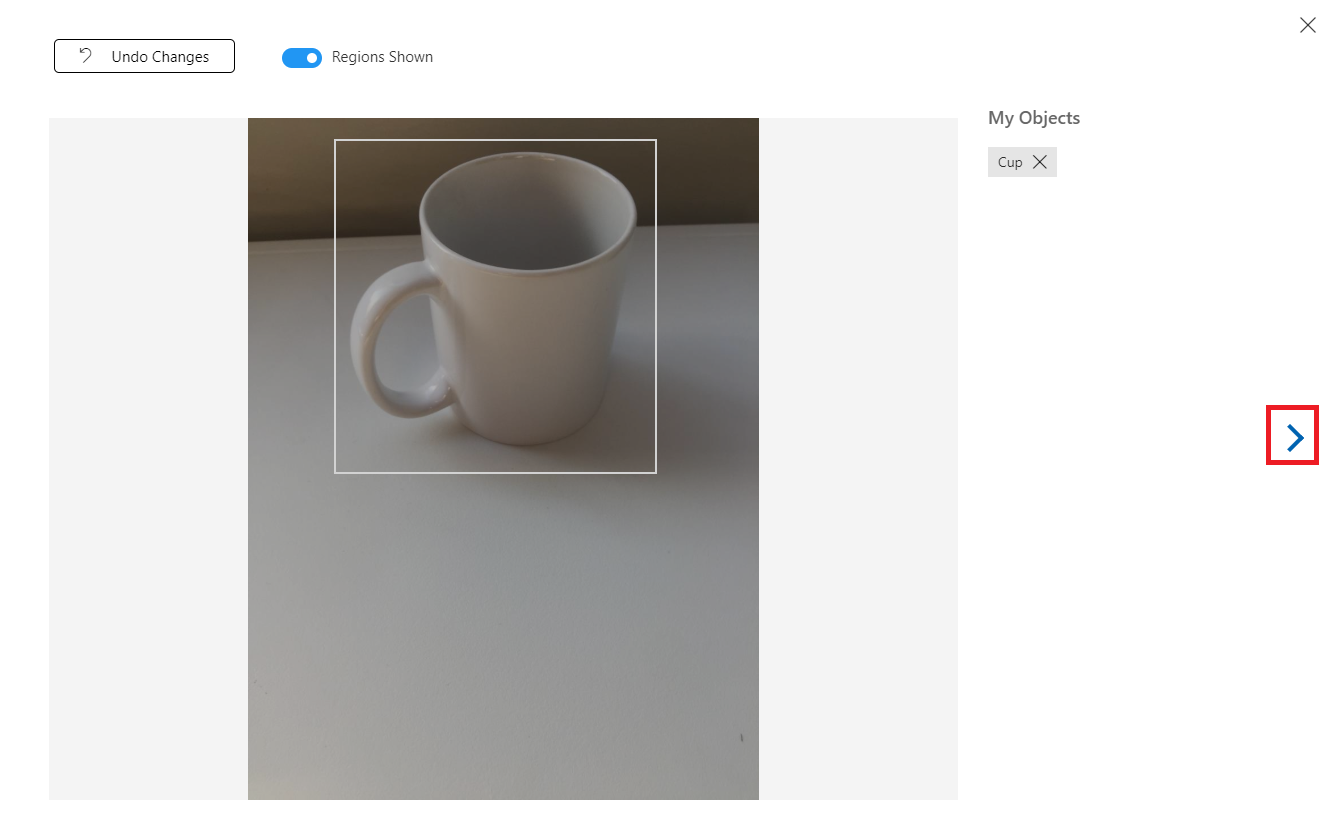

Pour baliser l’image suivante, vous pouvez cliquer sur la flèche à droite du panneau ou fermer le panneau de balise (en cliquant sur le X dans le coin supérieur droit du panneau), puis cliquer sur l’image suivante. Une fois l’image suivante prête, répétez la même procédure. Effectuez cette opération pour toutes les images que vous avez chargées, jusqu’à ce qu’elles soient étiquetées.

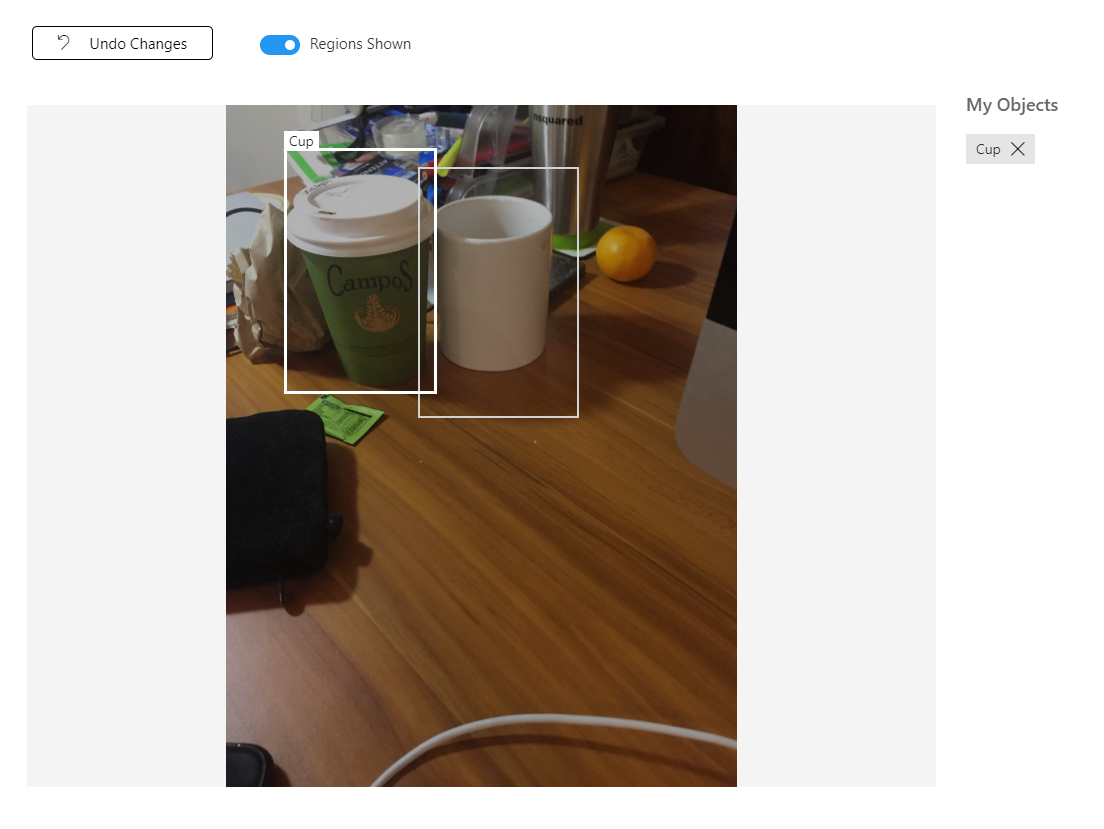

Remarque

Vous pouvez sélectionner plusieurs objets dans la même image, comme l’image ci-dessous :

Une fois que vous les avez étiquetés tous, cliquez sur le bouton marqué , à gauche de l’écran, pour afficher les images étiquetées.

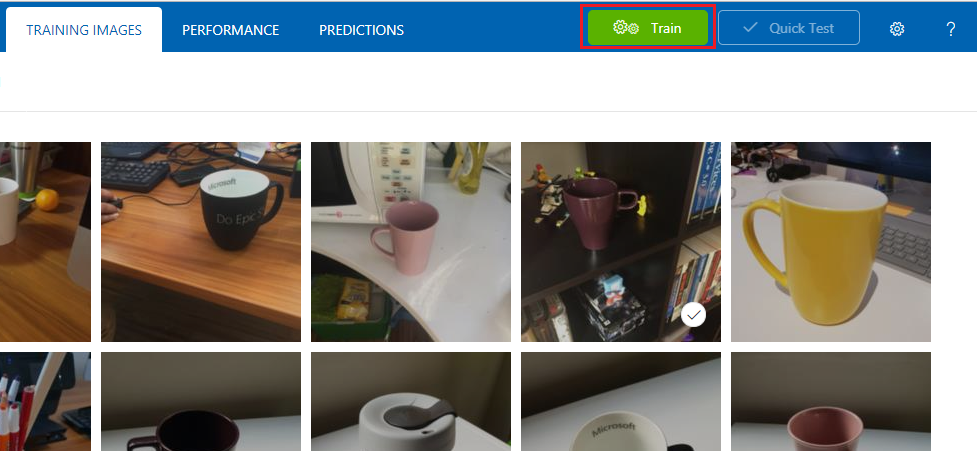

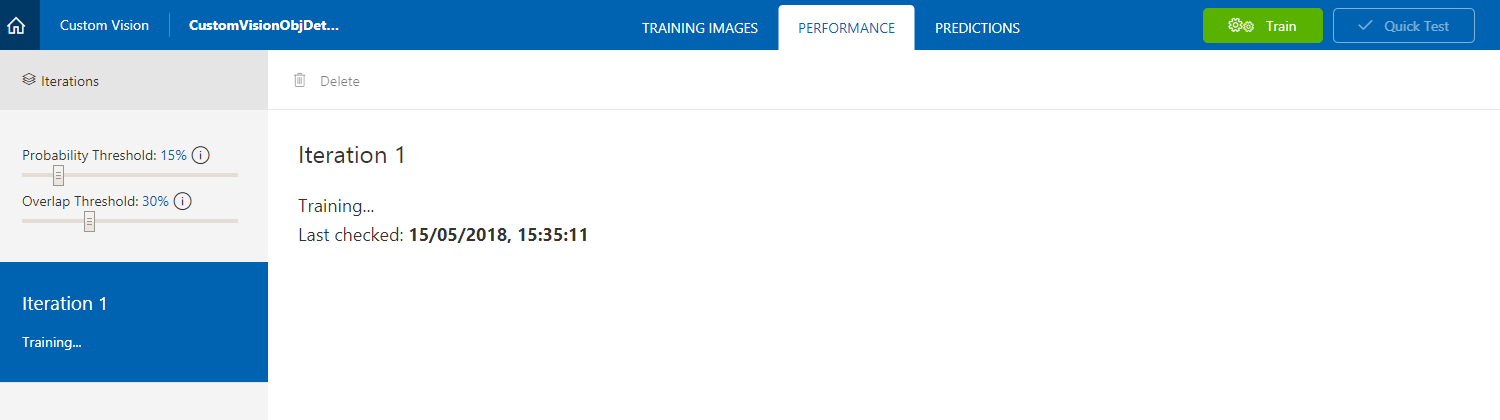

Vous êtes maintenant prêt à entraîner votre service. Cliquez sur le bouton Entraîner , et la première itération d’entraînement commence.

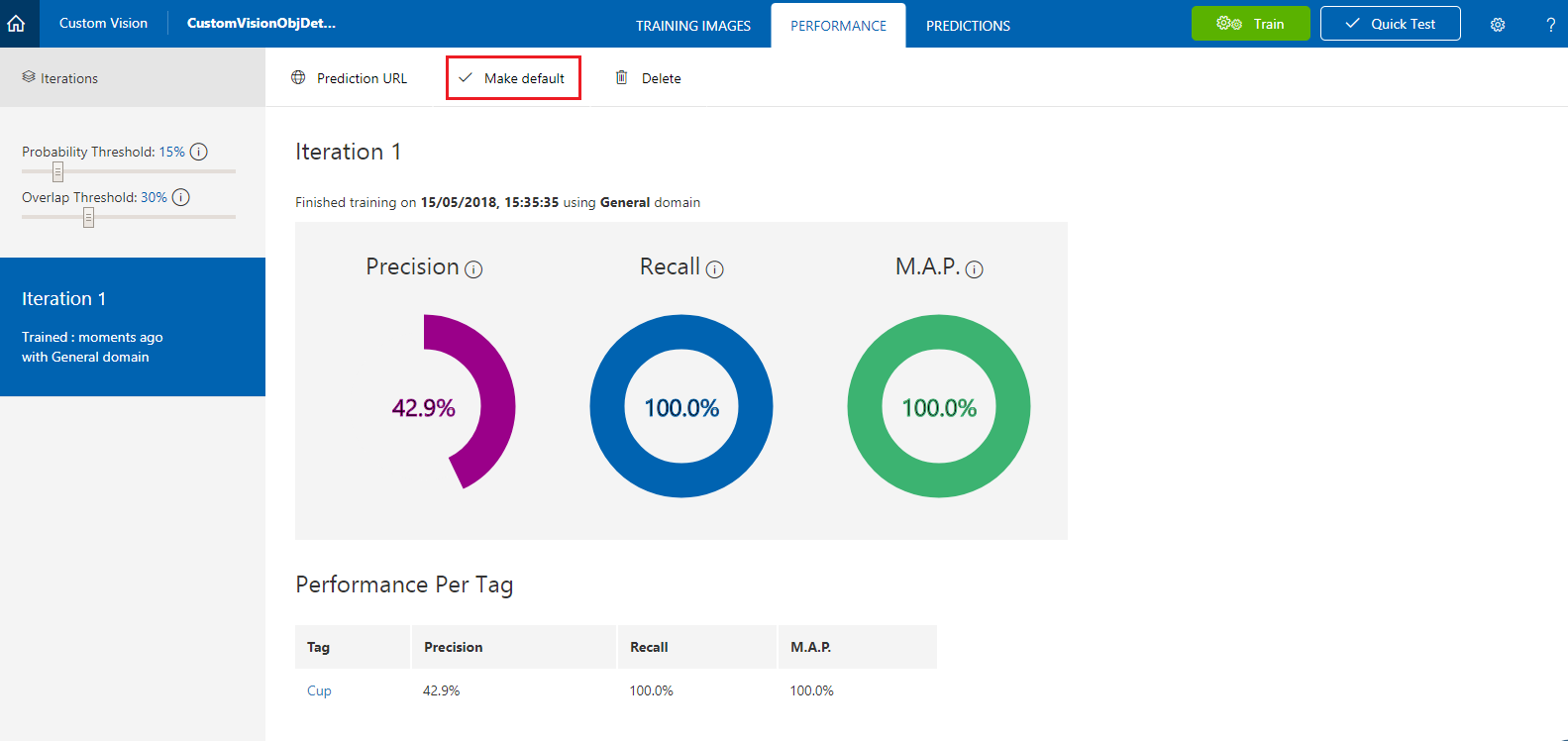

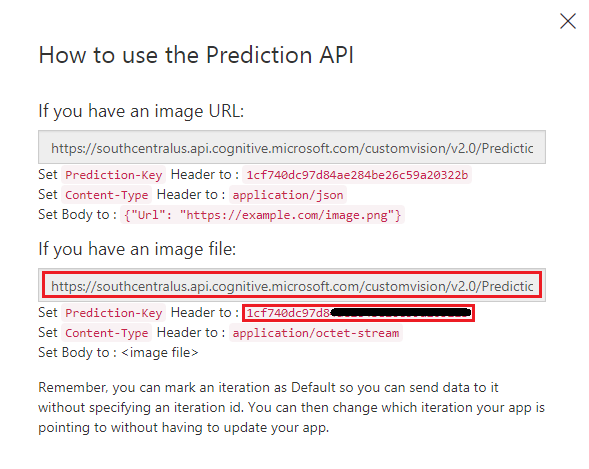

Une fois qu’il est généré, vous serez en mesure de voir deux boutons appelés Effectuer la valeur par défaut et l’URL de prédiction. Cliquez d’abord sur Définir la valeur par défaut , puis sur l’URL de prédiction.

Remarque

Le point de terminaison fourni à partir de ce point de terminaison est défini sur la valeur par défaut de l’itération. Par conséquent, si vous effectuez ultérieurement une nouvelle itération et que vous la mettez à jour comme valeur par défaut, vous n’aurez pas besoin de modifier votre code.

Une fois que vous avez cliqué sur l’URL de prédiction, ouvrez le Bloc-notes, puis copiez et collez l’URL (également appelée votre point de terminaison de prédiction) et la clé de prédiction du service, afin de pouvoir la récupérer lorsque vous en avez besoin ultérieurement dans le code.

Chapitre 3 - Configurer le projet Unity

Voici une configuration classique pour le développement avec la réalité mixte, et en tant que tel, est un bon modèle pour d’autres projets.

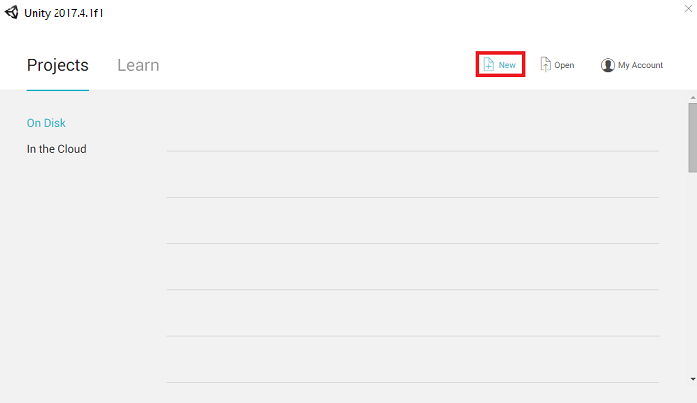

Ouvrez Unity , puis cliquez sur Nouveau.

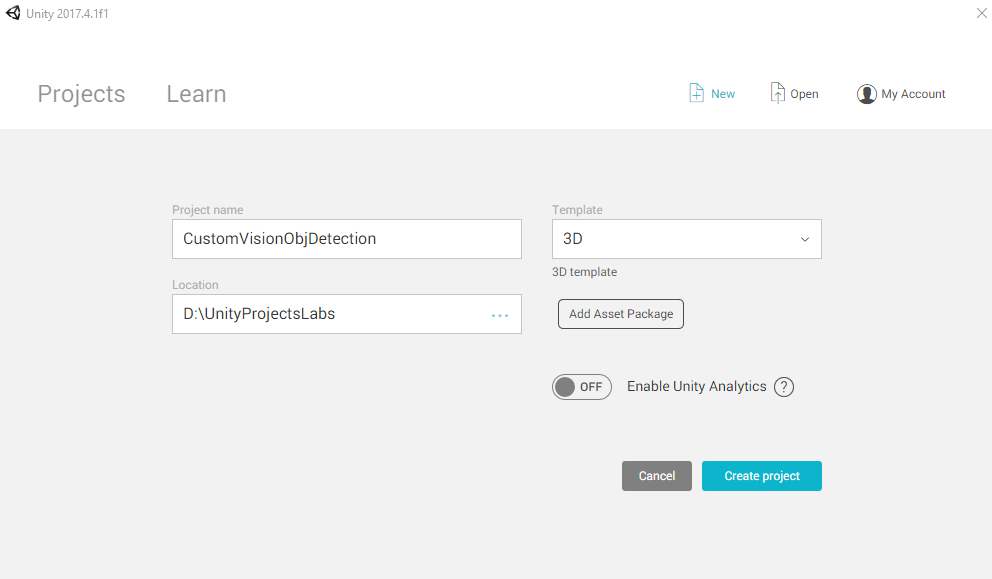

Vous devez maintenant fournir un nom de projet Unity. Insérez CustomVisionObjDetection. Assurez-vous que le type de projet est défini sur 3D et définissez l’emplacement sur un emplacement approprié pour vous (n’oubliez pas que les répertoires racines sont plus proches). Cliquez ensuite sur Créer un projet.

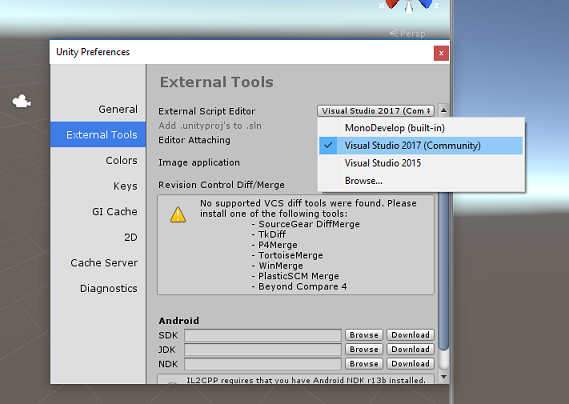

Avec Unity ouvert, il vaut la peine de vérifier que l’éditeur de script par défaut est défini sur Visual Studio. Accédez à Modifier>les préférences, puis à partir de la nouvelle fenêtre, accédez à Outils externes. Remplacez l’éditeur de script externe par Visual Studio. Fermez la fenêtre Préférences.

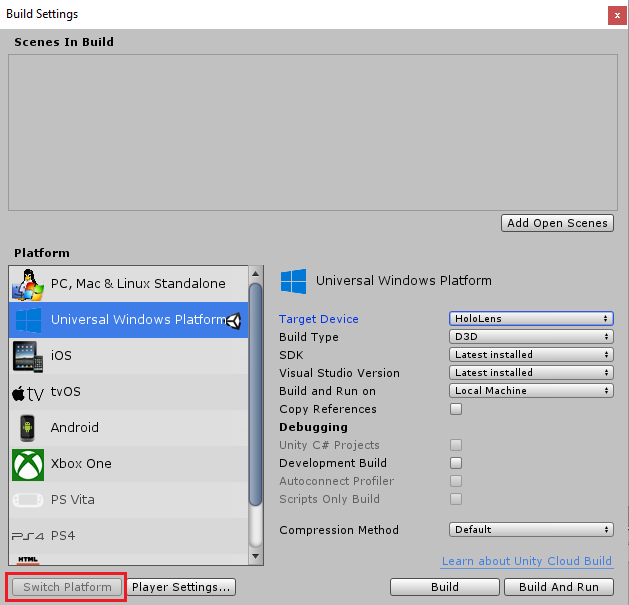

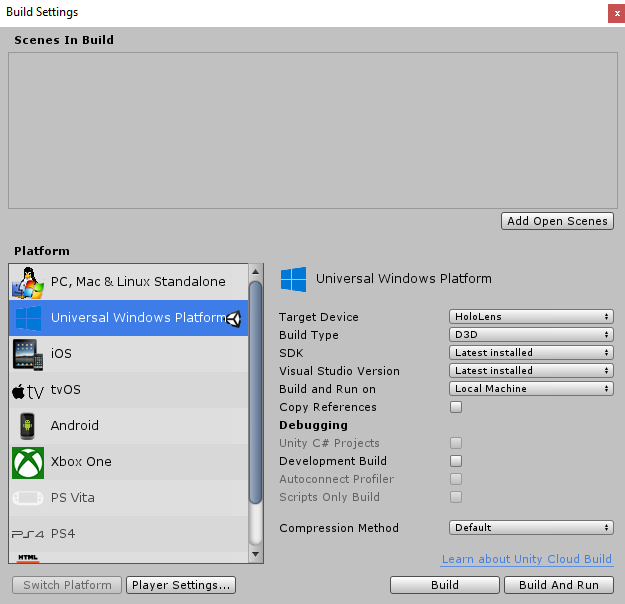

Ensuite, accédez aux paramètres de génération de fichiers > et basculez la plateforme vers plateforme Windows universelle, puis cliquez sur le bouton Basculer la plateforme.

Dans la même fenêtre Paramètres de build, vérifiez que les éléments suivants sont définis :

L’appareil cible est défini sur HoloLens

Le type de build est défini sur D3D

Le KIT SDK est défini sur La dernière version installée

La version de Visual Studio est définie sur La dernière version installée

La génération et l’exécution sont définies sur Ordinateur local

Les paramètres restants, dans Paramètres de build, doivent être laissés comme valeurs par défaut pour l’instant.

Dans la même fenêtre Paramètres de génération, cliquez sur le bouton Paramètres du lecteur, ce qui ouvre le panneau associé dans l’espace où se trouve l’inspecteur.

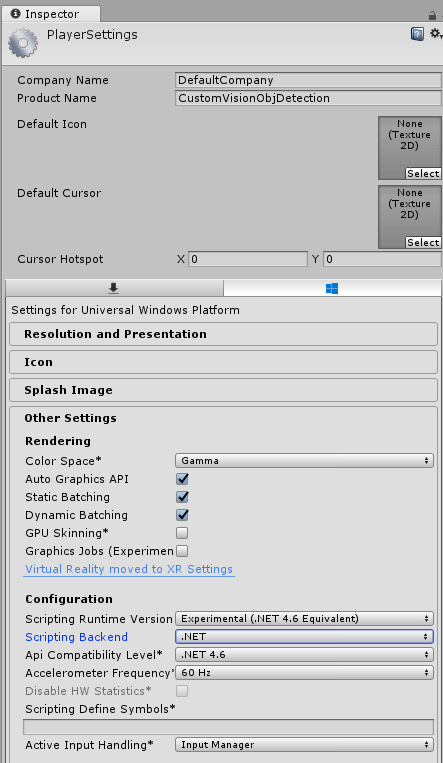

Dans ce panneau, quelques paramètres doivent être vérifiés :

Sous l’onglet Autres paramètres :

La version du runtime de script doit être expérimentale (équivalent .NET 4.6), ce qui déclenche un redémarrage de l’éditeur.

Le serveur principal de script doit être .NET.

Le niveau de compatibilité de l’API doit être .NET 4.6.

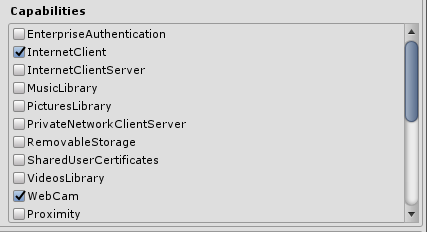

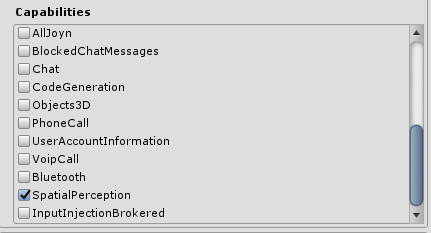

Sous l’onglet Paramètres de publication, sous Fonctionnalités, vérifiez :

InternetClient

Webcam

SpatialPerception

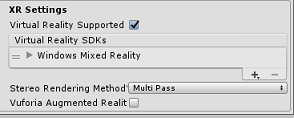

Plus loin dans le panneau, dans les paramètres XR (trouvés ci-dessous paramètres de publication), cochez Virtual Reality Pris en charge, puis vérifiez que le Kit de développement logiciel (SDK ) Windows Mixed Reality est ajouté.

De retour dans les paramètres de build, les projets C# Unity ne sont plus grisés : cochez la case en regard de cela.

Fermez la fenêtre Build Settings.

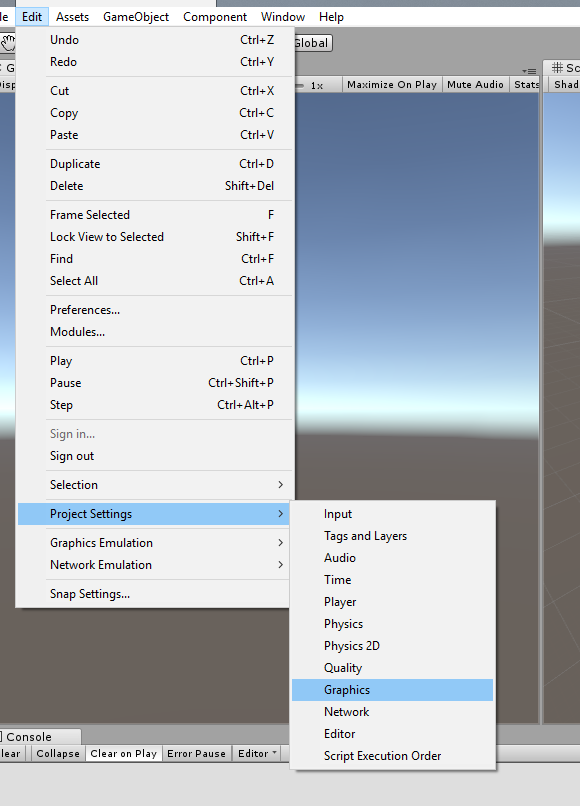

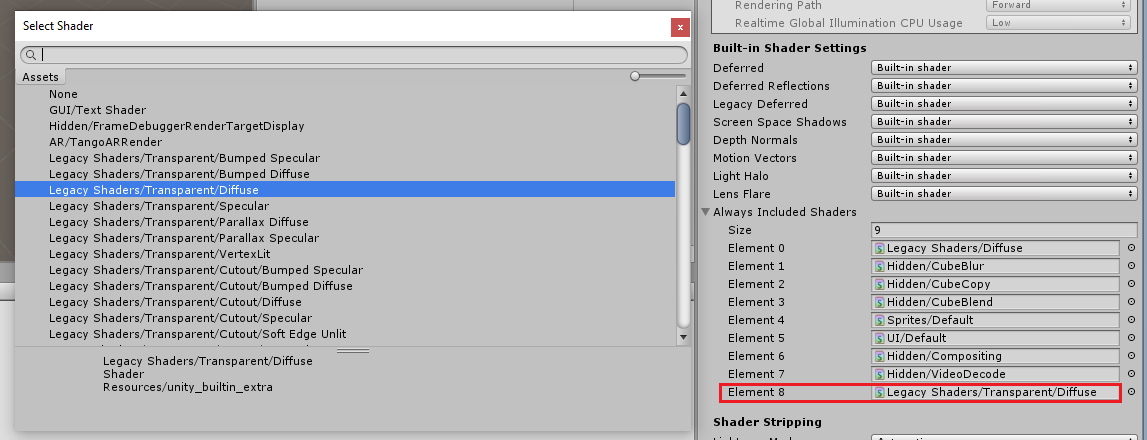

Dans l’éditeur, cliquez sur Modifier les>graphiques des paramètres>du projet.

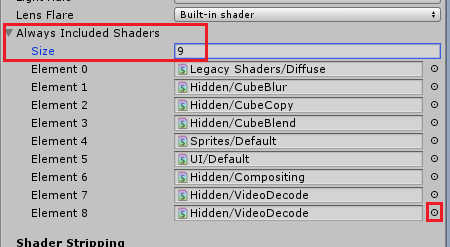

Dans le panneau Inspecteur, les paramètres graphiques sont ouverts. Faites défiler jusqu’à ce qu’un tableau appelé Nuanceurs Always Include s’affiche. Ajoutez un emplacement en augmentant la variable Taille par un (dans cet exemple, il était de 8 donc nous l’avons fait 9). Un nouvel emplacement s’affiche, à la dernière position du tableau, comme indiqué ci-dessous :

Dans l’emplacement, cliquez sur le petit cercle cible en regard de l’emplacement pour ouvrir une liste de nuanceurs. Recherchez les nuanceurs hérités/Nuanceur transparent/diffuse , puis double-cliquez dessus.

Chapitre 4 - Importation du package CustomVisionObjDetection Unity

Pour ce cours, vous disposez d’un package de ressources Unity appelé Azure-MR-310.unitypackage.

[TIP] Tous les objets pris en charge par Unity, y compris les scènes entières, peuvent être empaquetés dans un fichier .unitypackage et exportés / importés dans d’autres projets. Il s’agit du moyen le plus sûr et le plus efficace de déplacer des ressources entre différents projets Unity.

Vous trouverez le package Azure-MR-310 que vous devez télécharger ici.

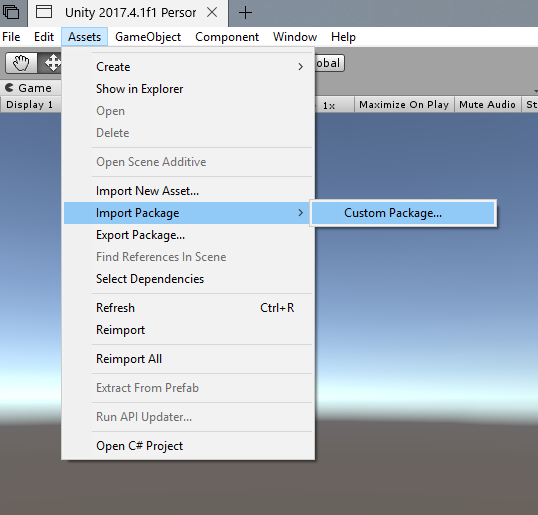

Avec le tableau de bord Unity devant vous, cliquez sur Ressources dans le menu en haut de l’écran, puis cliquez sur Importer un package personnalisé de package>.

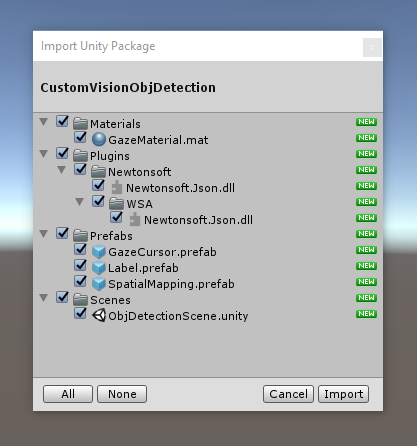

Utilisez le sélecteur de fichiers pour sélectionner le package Azure-MR-310.unitypackage , puis cliquez sur Ouvrir. Une liste de composants pour cette ressource s’affiche à vous. Confirmez l’importation en cliquant sur le bouton Importer .

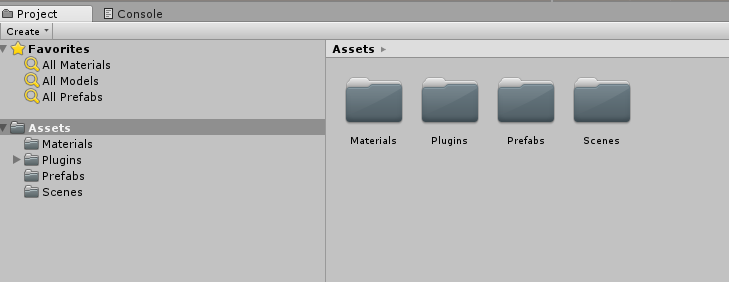

Une fois l’importation terminée, vous remarquerez que les dossiers du package ont maintenant été ajoutés à votre dossier Assets . Ce type de structure de dossiers est typique pour un projet Unity.

Le dossier Matériaux contient le matériau utilisé par le curseur de regard.

Le dossier Plugins contient la DLL Newtonsoft utilisée par le code pour désérialiser la réponse web du service. Les deux (2) versions différentes contenues dans le dossier et sous-dossier sont nécessaires pour permettre à la bibliothèque d’être utilisée et générée par l’éditeur Unity et la build UWP.

Le dossier Prefabs contient les préfabriqués contenus dans la scène. Il s’agit des suivants :

- GazeCursor, le curseur utilisé dans l’application. Collabore avec le préfabriqué SpatialMapping pour pouvoir être placé dans la scène sur des objets physiques.

- Label, qui est l’objet d’interface utilisateur utilisé pour afficher la balise d’objet dans la scène lorsque nécessaire.

- SpatialMapping, qui est l’objet qui permet à l’application d’utiliser la création d’une carte virtuelle, à l’aide du suivi spatial de Microsoft HoloLens.

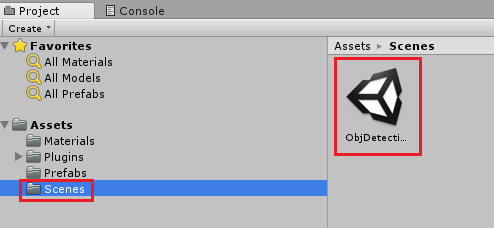

Dossier Scènes qui contient actuellement la scène prédéfinie pour ce cours.

Ouvrez le dossier Scènes , dans le volet projet, puis double-cliquez sur ObjDetectionScene pour charger la scène que vous utiliserez pour ce cours.

Remarque

Aucun code n’est inclus, vous allez écrire le code en suivant ce cours.

Chapitre 5 : Créez la classe CustomVisionAnalyser.

À ce stade, vous êtes prêt à écrire du code. Vous commencerez par la classe CustomVisionAnalyser .

Remarque

Les appels au service Custom Vision, effectués dans le code ci-dessous, sont effectués à l’aide de l’API REST Custom Vision. À l’aide de cela, vous verrez comment implémenter et utiliser cette API (utile pour comprendre comment implémenter quelque chose de similaire à votre propre). N’oubliez pas que Microsoft propose un SDK Custom Vision qui peut également être utilisé pour passer des appels au service. Pour plus d’informations, consultez l’article du Kit de développement logiciel (SDK) Custom Vision.

Cette classe est responsable des points suivants :

Chargement de la dernière image capturée sous la forme d’un tableau d’octets.

Envoi du tableau d’octets à votre instance azure Custom Vision Service à des fins d’analyse.

Réception de la réponse sous forme de chaîne JSON.

Désérialisation de la réponse et transmission de la prédiction résultante à la classe SceneOrganiser, qui s’occupera de la façon dont la réponse doit être affichée.

Pour créer cette classe :

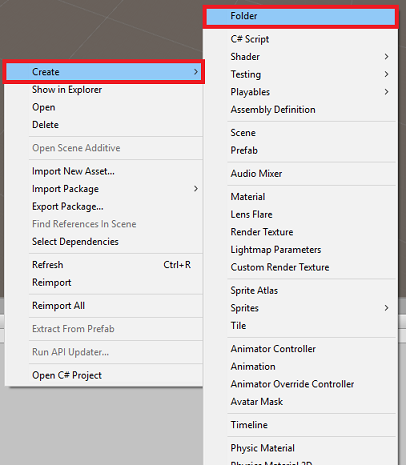

Cliquez avec le bouton droit dans le dossier de ressources, situé dans le volet projet, puis cliquez sur Créer>un dossier. Appelez les scripts du dossier.

Double-cliquez sur le dossier nouvellement créé pour l’ouvrir.

Cliquez avec le bouton droit dans le dossier, puis cliquez sur Créer>un script C#. Nommez le script CustomVisionAnalyser.

Double-cliquez sur le nouveau script CustomVisionAnalyser pour l’ouvrir avec Visual Studio.

Vérifiez que les espaces de noms suivants sont référencés en haut du fichier :

using Newtonsoft.Json; using System.Collections; using System.IO; using UnityEngine; using UnityEngine.Networking;Dans la classe CustomVisionAnalyser , ajoutez les variables suivantes :

/// <summary> /// Unique instance of this class /// </summary> public static CustomVisionAnalyser Instance; /// <summary> /// Insert your prediction key here /// </summary> private string predictionKey = "- Insert your key here -"; /// <summary> /// Insert your prediction endpoint here /// </summary> private string predictionEndpoint = "Insert your prediction endpoint here"; /// <summary> /// Bite array of the image to submit for analysis /// </summary> [HideInInspector] public byte[] imageBytes;Remarque

Veillez à insérer votre clé de prédiction de service dans la variable predictionKey et votre point de terminaison de prédiction dans la variable predictionEndpoint . Vous les avez copiées dans le Bloc-notes précédemment, dans le chapitre 2, étape 14.

Le code pour Awake() doit maintenant être ajouté pour initialiser la variable d’instance :

/// <summary> /// Initializes this class /// </summary> private void Awake() { // Allows this instance to behave like a singleton Instance = this; }Ajoutez la coroutine (avec la méthode GetImageAsByteArray() statique ci-dessous, qui obtient les résultats de l’analyse de l’image, capturées par la classe ImageCapture.

Remarque

Dans la coroutine AnalyseImageCapture , il existe un appel à la classe SceneOrganiser que vous n’êtes pas encore à créer. Par conséquent, laissez ces lignes commentées pour l’instant.

/// <summary> /// Call the Computer Vision Service to submit the image. /// </summary> public IEnumerator AnalyseLastImageCaptured(string imagePath) { Debug.Log("Analyzing..."); WWWForm webForm = new WWWForm(); using (UnityWebRequest unityWebRequest = UnityWebRequest.Post(predictionEndpoint, webForm)) { // Gets a byte array out of the saved image imageBytes = GetImageAsByteArray(imagePath); unityWebRequest.SetRequestHeader("Content-Type", "application/octet-stream"); unityWebRequest.SetRequestHeader("Prediction-Key", predictionKey); // The upload handler will help uploading the byte array with the request unityWebRequest.uploadHandler = new UploadHandlerRaw(imageBytes); unityWebRequest.uploadHandler.contentType = "application/octet-stream"; // The download handler will help receiving the analysis from Azure unityWebRequest.downloadHandler = new DownloadHandlerBuffer(); // Send the request yield return unityWebRequest.SendWebRequest(); string jsonResponse = unityWebRequest.downloadHandler.text; Debug.Log("response: " + jsonResponse); // Create a texture. Texture size does not matter, since // LoadImage will replace with the incoming image size. //Texture2D tex = new Texture2D(1, 1); //tex.LoadImage(imageBytes); //SceneOrganiser.Instance.quadRenderer.material.SetTexture("_MainTex", tex); // The response will be in JSON format, therefore it needs to be deserialized //AnalysisRootObject analysisRootObject = new AnalysisRootObject(); //analysisRootObject = JsonConvert.DeserializeObject<AnalysisRootObject>(jsonResponse); //SceneOrganiser.Instance.FinaliseLabel(analysisRootObject); } } /// <summary> /// Returns the contents of the specified image file as a byte array. /// </summary> static byte[] GetImageAsByteArray(string imageFilePath) { FileStream fileStream = new FileStream(imageFilePath, FileMode.Open, FileAccess.Read); BinaryReader binaryReader = new BinaryReader(fileStream); return binaryReader.ReadBytes((int)fileStream.Length); }Supprimez les méthodes Start() et Update(), car elles ne seront pas utilisées.

Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Important

Comme mentionné précédemment, ne vous inquiétez pas du code qui peut sembler avoir une erreur, car vous fournirez bientôt d’autres classes, ce qui les corrigera.

Chapitre 6 - Créer la classe CustomVisionObjects

La classe que vous allez créer est maintenant la classe CustomVisionObjects .

Ce script contient un certain nombre d’objets utilisés par d’autres classes pour sérialiser et désérialiser les appels effectués au service Custom Vision.

Pour créer cette classe :

Cliquez avec le bouton droit dans le dossier Scripts, puis cliquez sur Créer un>script C#. Appelez le script CustomVisionObjects.

Double-cliquez sur le nouveau script CustomVisionObjects pour l’ouvrir avec Visual Studio.

Vérifiez que les espaces de noms suivants sont référencés en haut du fichier :

using System; using System.Collections.Generic; using UnityEngine; using UnityEngine.Networking;Supprimez les méthodes Start() et Update() à l’intérieur de la classe CustomVisionObjects . Cette classe doit maintenant être vide.

Avertissement

Il est important que vous suiviez attentivement l’instruction suivante. Si vous placez les nouvelles déclarations de classe dans la classe CustomVisionObjects, vous obtiendrez des erreurs de compilation dans le chapitre 10, indiquant que AnalysisRootObject et BoundingBox sont introuvables.

Ajoutez les classes suivantes en dehors de la classe CustomVisionObjects . Ces objets sont utilisés par la bibliothèque Newtonsoft pour sérialiser et désérialiser les données de réponse :

// The objects contained in this script represent the deserialized version // of the objects used by this application /// <summary> /// Web request object for image data /// </summary> class MultipartObject : IMultipartFormSection { public string sectionName { get; set; } public byte[] sectionData { get; set; } public string fileName { get; set; } public string contentType { get; set; } } /// <summary> /// JSON of all Tags existing within the project /// contains the list of Tags /// </summary> public class Tags_RootObject { public List<TagOfProject> Tags { get; set; } public int TotalTaggedImages { get; set; } public int TotalUntaggedImages { get; set; } } public class TagOfProject { public string Id { get; set; } public string Name { get; set; } public string Description { get; set; } public int ImageCount { get; set; } } /// <summary> /// JSON of Tag to associate to an image /// Contains a list of hosting the tags, /// since multiple tags can be associated with one image /// </summary> public class Tag_RootObject { public List<Tag> Tags { get; set; } } public class Tag { public string ImageId { get; set; } public string TagId { get; set; } } /// <summary> /// JSON of images submitted /// Contains objects that host detailed information about one or more images /// </summary> public class ImageRootObject { public bool IsBatchSuccessful { get; set; } public List<SubmittedImage> Images { get; set; } } public class SubmittedImage { public string SourceUrl { get; set; } public string Status { get; set; } public ImageObject Image { get; set; } } public class ImageObject { public string Id { get; set; } public DateTime Created { get; set; } public int Width { get; set; } public int Height { get; set; } public string ImageUri { get; set; } public string ThumbnailUri { get; set; } } /// <summary> /// JSON of Service Iteration /// </summary> public class Iteration { public string Id { get; set; } public string Name { get; set; } public bool IsDefault { get; set; } public string Status { get; set; } public string Created { get; set; } public string LastModified { get; set; } public string TrainedAt { get; set; } public string ProjectId { get; set; } public bool Exportable { get; set; } public string DomainId { get; set; } } /// <summary> /// Predictions received by the Service /// after submitting an image for analysis /// Includes Bounding Box /// </summary> public class AnalysisRootObject { public string id { get; set; } public string project { get; set; } public string iteration { get; set; } public DateTime created { get; set; } public List<Prediction> predictions { get; set; } } public class BoundingBox { public double left { get; set; } public double top { get; set; } public double width { get; set; } public double height { get; set; } } public class Prediction { public double probability { get; set; } public string tagId { get; set; } public string tagName { get; set; } public BoundingBox boundingBox { get; set; } }Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Chapitre 7 - Créer la classe SpatialMapping

Cette classe définit l’collider de mappage spatial dans la scène afin de pouvoir détecter les collisions entre les objets virtuels et les objets réels.

Pour créer cette classe :

Cliquez avec le bouton droit dans le dossier Scripts, puis cliquez sur Créer un>script C#. Appelez le script SpatialMapping.

Double-cliquez sur le nouveau script SpatialMapping pour l’ouvrir avec Visual Studio.

Vérifiez que vous disposez des espaces de noms suivants référencés au-dessus de la classe SpatialMapping :

using UnityEngine; using UnityEngine.XR.WSA;Ensuite, ajoutez les variables suivantes à l’intérieur de la classe SpatialMapping , au-dessus de la méthode Start() :

/// <summary> /// Allows this class to behave like a singleton /// </summary> public static SpatialMapping Instance; /// <summary> /// Used by the GazeCursor as a property with the Raycast call /// </summary> internal static int PhysicsRaycastMask; /// <summary> /// The layer to use for spatial mapping collisions /// </summary> internal int physicsLayer = 31; /// <summary> /// Creates environment colliders to work with physics /// </summary> private SpatialMappingCollider spatialMappingCollider;Ajoutez l’éveil () et l’écran de démarrage() :

/// <summary> /// Initializes this class /// </summary> private void Awake() { // Allows this instance to behave like a singleton Instance = this; } /// <summary> /// Runs at initialization right after Awake method /// </summary> void Start() { // Initialize and configure the collider spatialMappingCollider = gameObject.GetComponent<SpatialMappingCollider>(); spatialMappingCollider.surfaceParent = this.gameObject; spatialMappingCollider.freezeUpdates = false; spatialMappingCollider.layer = physicsLayer; // define the mask PhysicsRaycastMask = 1 << physicsLayer; // set the object as active one gameObject.SetActive(true); }Supprimez la méthode Update().

Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Chapitre 8 - Créer la classe GazeCursor

Cette classe est chargée de configurer le curseur à l’emplacement approprié dans l’espace réel, en utilisant spatialMappingCollider, créé dans le chapitre précédent.

Pour créer cette classe :

Cliquez avec le bouton droit dans le dossier Scripts, puis cliquez sur Créer un>script C#. Appeler le script GazeCursor

Double-cliquez sur le nouveau script GazeCursor pour l’ouvrir avec Visual Studio.

Vérifiez que vous disposez de l’espace de noms suivant référencé au-dessus de la classe GazeCursor :

using UnityEngine;Ajoutez ensuite la variable suivante à l’intérieur de la classe GazeCursor, au-dessus de la méthode Start().

/// <summary> /// The cursor (this object) mesh renderer /// </summary> private MeshRenderer meshRenderer;Mettez à jour la méthode Start() avec le code suivant :

/// <summary> /// Runs at initialization right after the Awake method /// </summary> void Start() { // Grab the mesh renderer that is on the same object as this script. meshRenderer = gameObject.GetComponent<MeshRenderer>(); // Set the cursor reference SceneOrganiser.Instance.cursor = gameObject; gameObject.GetComponent<Renderer>().material.color = Color.green; // If you wish to change the size of the cursor you can do so here gameObject.transform.localScale = new Vector3(0.01f, 0.01f, 0.01f); }Mettez à jour la méthode Update() avec le code suivant :

/// <summary> /// Update is called once per frame /// </summary> void Update() { // Do a raycast into the world based on the user's head position and orientation. Vector3 headPosition = Camera.main.transform.position; Vector3 gazeDirection = Camera.main.transform.forward; RaycastHit gazeHitInfo; if (Physics.Raycast(headPosition, gazeDirection, out gazeHitInfo, 30.0f, SpatialMapping.PhysicsRaycastMask)) { // If the raycast hit a hologram, display the cursor mesh. meshRenderer.enabled = true; // Move the cursor to the point where the raycast hit. transform.position = gazeHitInfo.point; // Rotate the cursor to hug the surface of the hologram. transform.rotation = Quaternion.FromToRotation(Vector3.up, gazeHitInfo.normal); } else { // If the raycast did not hit a hologram, hide the cursor mesh. meshRenderer.enabled = false; } }Remarque

Ne vous inquiétez pas de l’erreur pour la classe SceneOrganiser introuvable, vous allez la créer dans le chapitre suivant.

Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Chapitre 9 - Créer la classe SceneOrganiser

Cette classe :

Configurez l’appareil photo principal en lui attachant les composants appropriés.

Lorsqu’un objet est détecté, il est responsable du calcul de sa position dans le monde réel et de placer une étiquette de balise près de celle-ci avec le nom de balise approprié.

Pour créer cette classe :

Cliquez avec le bouton droit dans le dossier Scripts, puis cliquez sur Créer un>script C#. Nommez le script SceneOrganiser.

Double-cliquez sur le nouveau script SceneOrganiser pour l’ouvrir avec Visual Studio.

Vérifiez que vous disposez des espaces de noms suivants référencés au-dessus de la classe SceneOrganiser :

using System.Collections.Generic; using System.Linq; using UnityEngine;Ajoutez ensuite les variables suivantes à l’intérieur de la classe SceneOrganiser , au-dessus de la méthode Start() :

/// <summary> /// Allows this class to behave like a singleton /// </summary> public static SceneOrganiser Instance; /// <summary> /// The cursor object attached to the Main Camera /// </summary> internal GameObject cursor; /// <summary> /// The label used to display the analysis on the objects in the real world /// </summary> public GameObject label; /// <summary> /// Reference to the last Label positioned /// </summary> internal Transform lastLabelPlaced; /// <summary> /// Reference to the last Label positioned /// </summary> internal TextMesh lastLabelPlacedText; /// <summary> /// Current threshold accepted for displaying the label /// Reduce this value to display the recognition more often /// </summary> internal float probabilityThreshold = 0.8f; /// <summary> /// The quad object hosting the imposed image captured /// </summary> private GameObject quad; /// <summary> /// Renderer of the quad object /// </summary> internal Renderer quadRenderer;Supprimez les méthodes Start() et Update().

Sous les variables, ajoutez la méthode Awake(), qui initialise la classe et configure la scène.

/// <summary> /// Called on initialization /// </summary> private void Awake() { // Use this class instance as singleton Instance = this; // Add the ImageCapture class to this Gameobject gameObject.AddComponent<ImageCapture>(); // Add the CustomVisionAnalyser class to this Gameobject gameObject.AddComponent<CustomVisionAnalyser>(); // Add the CustomVisionObjects class to this Gameobject gameObject.AddComponent<CustomVisionObjects>(); }Ajoutez la méthode PlaceAnalysisLabel(), qui instancie l’étiquette dans la scène (qui à ce stade est invisible à l’utilisateur). Il place également le quad (également invisible) où l’image est placée, et se chevauche avec le monde réel. Cela est important, car les coordonnées de zone récupérées à partir du service après l’analyse sont retracées dans ce quad pour déterminer l’emplacement approximatif de l’objet dans le monde réel.

/// <summary> /// Instantiate a Label in the appropriate location relative to the Main Camera. /// </summary> public void PlaceAnalysisLabel() { lastLabelPlaced = Instantiate(label.transform, cursor.transform.position, transform.rotation); lastLabelPlacedText = lastLabelPlaced.GetComponent<TextMesh>(); lastLabelPlacedText.text = ""; lastLabelPlaced.transform.localScale = new Vector3(0.005f,0.005f,0.005f); // Create a GameObject to which the texture can be applied quad = GameObject.CreatePrimitive(PrimitiveType.Quad); quadRenderer = quad.GetComponent<Renderer>() as Renderer; Material m = new Material(Shader.Find("Legacy Shaders/Transparent/Diffuse")); quadRenderer.material = m; // Here you can set the transparency of the quad. Useful for debugging float transparency = 0f; quadRenderer.material.color = new Color(1, 1, 1, transparency); // Set the position and scale of the quad depending on user position quad.transform.parent = transform; quad.transform.rotation = transform.rotation; // The quad is positioned slightly forward in font of the user quad.transform.localPosition = new Vector3(0.0f, 0.0f, 3.0f); // The quad scale as been set with the following value following experimentation, // to allow the image on the quad to be as precisely imposed to the real world as possible quad.transform.localScale = new Vector3(3f, 1.65f, 1f); quad.transform.parent = null; }Ajoutez la méthode FinaliseLabel(). Il est responsable de ce qui suit :

- Définition du texte d’étiquette avec l’étiquette de la prédiction avec la confiance la plus élevée.

- Appel du calcul du cadre englobant sur l’objet quad, positionné précédemment et plaçant l’étiquette dans la scène.

- Ajustement de la profondeur de l’étiquette à l’aide d’un Raycast vers le cadre englobant, qui doit entrer en collision avec l’objet dans le monde réel.

- Réinitialisation du processus de capture pour permettre à l’utilisateur de capturer une autre image.

/// <summary> /// Set the Tags as Text of the last label created. /// </summary> public void FinaliseLabel(AnalysisRootObject analysisObject) { if (analysisObject.predictions != null) { lastLabelPlacedText = lastLabelPlaced.GetComponent<TextMesh>(); // Sort the predictions to locate the highest one List<Prediction> sortedPredictions = new List<Prediction>(); sortedPredictions = analysisObject.predictions.OrderBy(p => p.probability).ToList(); Prediction bestPrediction = new Prediction(); bestPrediction = sortedPredictions[sortedPredictions.Count - 1]; if (bestPrediction.probability > probabilityThreshold) { quadRenderer = quad.GetComponent<Renderer>() as Renderer; Bounds quadBounds = quadRenderer.bounds; // Position the label as close as possible to the Bounding Box of the prediction // At this point it will not consider depth lastLabelPlaced.transform.parent = quad.transform; lastLabelPlaced.transform.localPosition = CalculateBoundingBoxPosition(quadBounds, bestPrediction.boundingBox); // Set the tag text lastLabelPlacedText.text = bestPrediction.tagName; // Cast a ray from the user's head to the currently placed label, it should hit the object detected by the Service. // At that point it will reposition the label where the ray HL sensor collides with the object, // (using the HL spatial tracking) Debug.Log("Repositioning Label"); Vector3 headPosition = Camera.main.transform.position; RaycastHit objHitInfo; Vector3 objDirection = lastLabelPlaced.position; if (Physics.Raycast(headPosition, objDirection, out objHitInfo, 30.0f, SpatialMapping.PhysicsRaycastMask)) { lastLabelPlaced.position = objHitInfo.point; } } } // Reset the color of the cursor cursor.GetComponent<Renderer>().material.color = Color.green; // Stop the analysis process ImageCapture.Instance.ResetImageCapture(); }Ajoutez la méthode CalculateBoundingBoxPosition(), qui héberge un certain nombre de calculs nécessaires pour traduire les coordonnées bounding Box récupérées à partir du service et les recréer proportionnellement sur le quad.

/// <summary> /// This method hosts a series of calculations to determine the position /// of the Bounding Box on the quad created in the real world /// by using the Bounding Box received back alongside the Best Prediction /// </summary> public Vector3 CalculateBoundingBoxPosition(Bounds b, BoundingBox boundingBox) { Debug.Log($"BB: left {boundingBox.left}, top {boundingBox.top}, width {boundingBox.width}, height {boundingBox.height}"); double centerFromLeft = boundingBox.left + (boundingBox.width / 2); double centerFromTop = boundingBox.top + (boundingBox.height / 2); Debug.Log($"BB CenterFromLeft {centerFromLeft}, CenterFromTop {centerFromTop}"); double quadWidth = b.size.normalized.x; double quadHeight = b.size.normalized.y; Debug.Log($"Quad Width {b.size.normalized.x}, Quad Height {b.size.normalized.y}"); double normalisedPos_X = (quadWidth * centerFromLeft) - (quadWidth/2); double normalisedPos_Y = (quadHeight * centerFromTop) - (quadHeight/2); return new Vector3((float)normalisedPos_X, (float)normalisedPos_Y, 0); }Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Important

Avant de continuer, ouvrez la classe CustomVisionAnalyser et, dans la méthode AnalyseLastImageCaptured(), supprimez les marques de commentaire des lignes suivantes :

// Create a texture. Texture size does not matter, since // LoadImage will replace with the incoming image size. Texture2D tex = new Texture2D(1, 1); tex.LoadImage(imageBytes); SceneOrganiser.Instance.quadRenderer.material.SetTexture("_MainTex", tex); // The response will be in JSON format, therefore it needs to be deserialized AnalysisRootObject analysisRootObject = new AnalysisRootObject(); analysisRootObject = JsonConvert.DeserializeObject<AnalysisRootObject>(jsonResponse); SceneOrganiser.Instance.FinaliseLabel(analysisRootObject);

Remarque

Ne vous inquiétez pas du message « impossible de trouver » de la classe ImageCapture , vous allez le créer dans le chapitre suivant.

Chapitre 10 - Créer la classe ImageCapture

La classe suivante que vous allez créer est la classe ImageCapture .

Cette classe est responsable des points suivants :

- Capture d’une image à l’aide de l’appareil photo HoloLens et le stockage dans le dossier d’application .

- Gestion des mouvements d’appui de l’utilisateur.

Pour créer cette classe :

Accédez au dossier Scripts que vous avez créé précédemment.

Cliquez avec le bouton droit dans le dossier, puis cliquez sur Créer>un script C#. Nommez le script ImageCapture.

Double-cliquez sur le nouveau script ImageCapture pour l’ouvrir avec Visual Studio.

Remplacez les espaces de noms en haut du fichier par les éléments suivants :

using System; using System.IO; using System.Linq; using UnityEngine; using UnityEngine.XR.WSA.Input; using UnityEngine.XR.WSA.WebCam;Ajoutez ensuite les variables suivantes à l’intérieur de la classe ImageCapture , au-dessus de la méthode Start() :

/// <summary> /// Allows this class to behave like a singleton /// </summary> public static ImageCapture Instance; /// <summary> /// Keep counts of the taps for image renaming /// </summary> private int captureCount = 0; /// <summary> /// Photo Capture object /// </summary> private PhotoCapture photoCaptureObject = null; /// <summary> /// Allows gestures recognition in HoloLens /// </summary> private GestureRecognizer recognizer; /// <summary> /// Flagging if the capture loop is running /// </summary> internal bool captureIsActive; /// <summary> /// File path of current analysed photo /// </summary> internal string filePath = string.Empty;Les méthodes Code for Awake() et Start() doivent maintenant être ajoutées :

/// <summary> /// Called on initialization /// </summary> private void Awake() { Instance = this; } /// <summary> /// Runs at initialization right after Awake method /// </summary> void Start() { // Clean up the LocalState folder of this application from all photos stored DirectoryInfo info = new DirectoryInfo(Application.persistentDataPath); var fileInfo = info.GetFiles(); foreach (var file in fileInfo) { try { file.Delete(); } catch (Exception) { Debug.LogFormat("Cannot delete file: ", file.Name); } } // Subscribing to the Microsoft HoloLens API gesture recognizer to track user gestures recognizer = new GestureRecognizer(); recognizer.SetRecognizableGestures(GestureSettings.Tap); recognizer.Tapped += TapHandler; recognizer.StartCapturingGestures(); }Implémentez un gestionnaire qui sera appelé lorsqu’un mouvement Tap se produit :

/// <summary> /// Respond to Tap Input. /// </summary> private void TapHandler(TappedEventArgs obj) { if (!captureIsActive) { captureIsActive = true; // Set the cursor color to red SceneOrganiser.Instance.cursor.GetComponent<Renderer>().material.color = Color.red; // Begin the capture loop Invoke("ExecuteImageCaptureAndAnalysis", 0); } }Important

Lorsque le curseur est vert, cela signifie que l’appareil photo est disponible pour prendre l’image. Lorsque le curseur est rouge, cela signifie que l’appareil photo est occupé.

Ajoutez la méthode utilisée par l’application pour démarrer le processus de capture d’image et stocker l’image :

/// <summary> /// Begin process of image capturing and send to Azure Custom Vision Service. /// </summary> private void ExecuteImageCaptureAndAnalysis() { // Create a label in world space using the ResultsLabel class // Invisible at this point but correctly positioned where the image was taken SceneOrganiser.Instance.PlaceAnalysisLabel(); // Set the camera resolution to be the highest possible Resolution cameraResolution = PhotoCapture.SupportedResolutions.OrderByDescending ((res) => res.width * res.height).First(); Texture2D targetTexture = new Texture2D(cameraResolution.width, cameraResolution.height); // Begin capture process, set the image format PhotoCapture.CreateAsync(true, delegate (PhotoCapture captureObject) { photoCaptureObject = captureObject; CameraParameters camParameters = new CameraParameters { hologramOpacity = 1.0f, cameraResolutionWidth = targetTexture.width, cameraResolutionHeight = targetTexture.height, pixelFormat = CapturePixelFormat.BGRA32 }; // Capture the image from the camera and save it in the App internal folder captureObject.StartPhotoModeAsync(camParameters, delegate (PhotoCapture.PhotoCaptureResult result) { string filename = string.Format(@"CapturedImage{0}.jpg", captureCount); filePath = Path.Combine(Application.persistentDataPath, filename); captureCount++; photoCaptureObject.TakePhotoAsync(filePath, PhotoCaptureFileOutputFormat.JPG, OnCapturedPhotoToDisk); }); }); }Ajoutez les gestionnaires qui seront appelés lorsque la photo a été capturée et pour le moment où elle est prête à être analysée. Le résultat est ensuite passé à CustomVisionAnalyser pour l’analyse.

/// <summary> /// Register the full execution of the Photo Capture. /// </summary> void OnCapturedPhotoToDisk(PhotoCapture.PhotoCaptureResult result) { try { // Call StopPhotoMode once the image has successfully captured photoCaptureObject.StopPhotoModeAsync(OnStoppedPhotoMode); } catch (Exception e) { Debug.LogFormat("Exception capturing photo to disk: {0}", e.Message); } } /// <summary> /// The camera photo mode has stopped after the capture. /// Begin the image analysis process. /// </summary> void OnStoppedPhotoMode(PhotoCapture.PhotoCaptureResult result) { Debug.LogFormat("Stopped Photo Mode"); // Dispose from the object in memory and request the image analysis photoCaptureObject.Dispose(); photoCaptureObject = null; // Call the image analysis StartCoroutine(CustomVisionAnalyser.Instance.AnalyseLastImageCaptured(filePath)); } /// <summary> /// Stops all capture pending actions /// </summary> internal void ResetImageCapture() { captureIsActive = false; // Set the cursor color to green SceneOrganiser.Instance.cursor.GetComponent<Renderer>().material.color = Color.green; // Stop the capture loop if active CancelInvoke(); }Veillez à enregistrer vos modifications dans Visual Studio avant de revenir à Unity.

Chapitre 11 - Configuration des scripts dans la scène

Maintenant que vous avez écrit tout le code nécessaire pour ce projet, il est temps de configurer les scripts dans la scène, et sur les préfabriqués, pour qu’ils se comportent correctement.

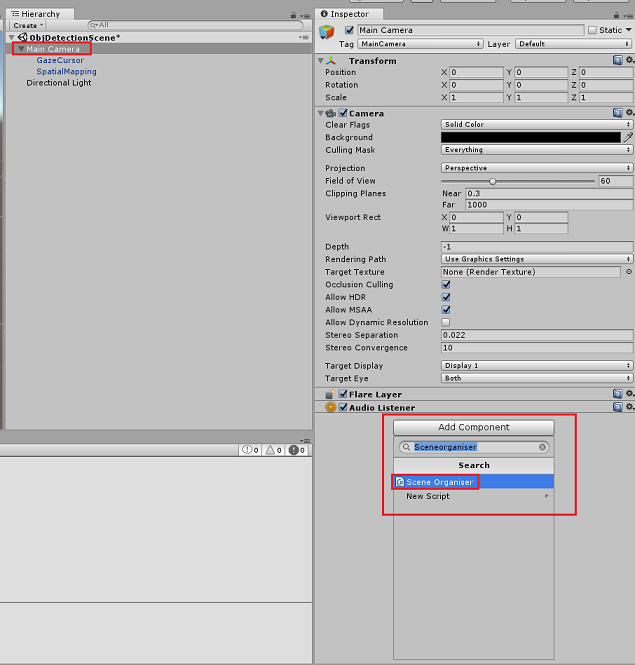

Dans l’Éditeur Unity, dans le panneau Hiérarchie, sélectionnez l’appareil photo principal.

Dans le panneau Inspecteur, avec l’appareil photo principal sélectionné, cliquez sur Ajouter un composant, puis recherchez le script SceneOrganiser , puis double-cliquez dessus pour l’ajouter.

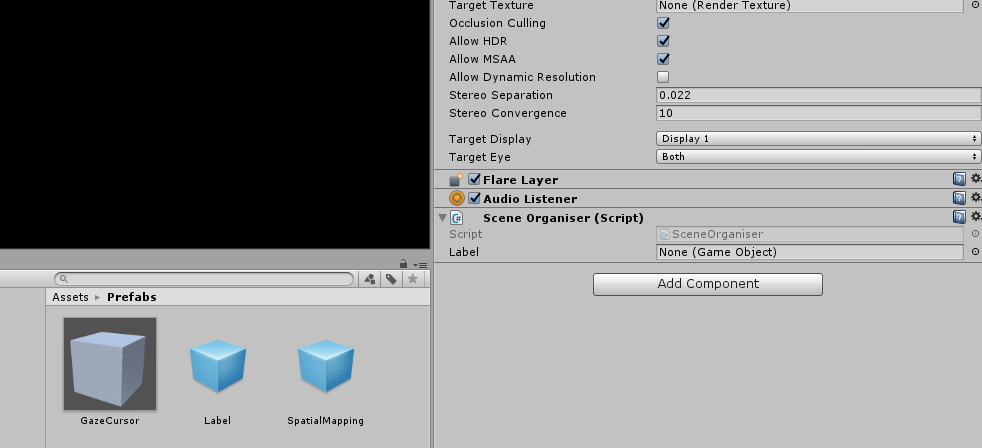

Dans le panneau projet, ouvrez le dossier Prefabs, faites glisser le préfabriqué d’étiquette dans la zone d’entrée cible de référence vide Label , dans le script SceneOrganiser que vous venez d’ajouter à la caméra principale, comme illustré dans l’image ci-dessous :

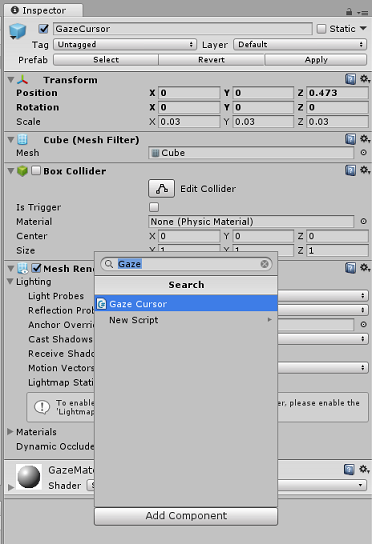

Dans le panneau Hiérarchie, sélectionnez l’enfant GazeCursor de la caméra principale.

Dans le panneau Inspecteur, avec l’option GazeCursor sélectionnée, cliquez sur Ajouter un composant, puis recherchez le script GazeCursor et double-cliquez pour l’ajouter.

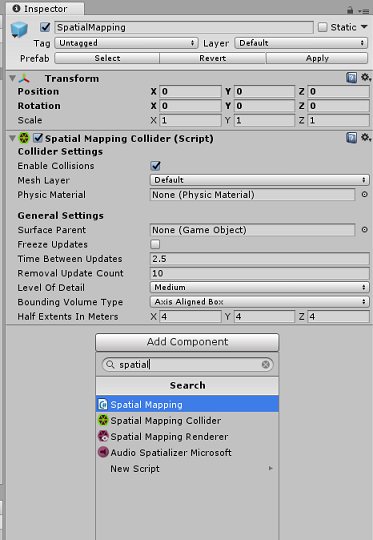

Là encore, dans le panneau Hiérarchie, sélectionnez l’enfant SpatialMapping de la caméra principale.

Dans le panneau Inspecteur, avec spatialMapping sélectionné, cliquez sur Ajouter un composant, puis recherchez le script SpatialMapping, puis double-cliquez dessus pour l’ajouter.

Les scripts restants que vous n’avez pas définis seront ajoutés par le code dans le script SceneOrganiser pendant l’exécution.

Chapitre 12 - Avant la construction

Pour effectuer un test approfondi de votre application, vous devez la charger de manière indépendante sur votre Microsoft HoloLens.

Avant de procéder, assurez-vous que :

Tous les paramètres mentionnés dans le chapitre 3 sont correctement définis.

Le script SceneOrganiser est attaché à l’objet Main Camera .

Le script GazeCursor est attaché à l’objet GazeCursor .

Le script SpatialMapping est attaché à l’objet SpatialMapping .

Dans le chapitre 5, étape 6 :

- Veillez à insérer votre clé de prédiction de service dans la variable predictionKey .

- Vous avez inséré votre point de terminaison de prédiction dans la classe predictionEndpoint .

Chapitre 13 - Générer la solution UWP et charger de manière test votre application

Vous êtes maintenant prêt à créer votre application en tant que solution UWP sur laquelle vous serez en mesure de déployer sur Microsoft HoloLens. Pour commencer le processus de génération :

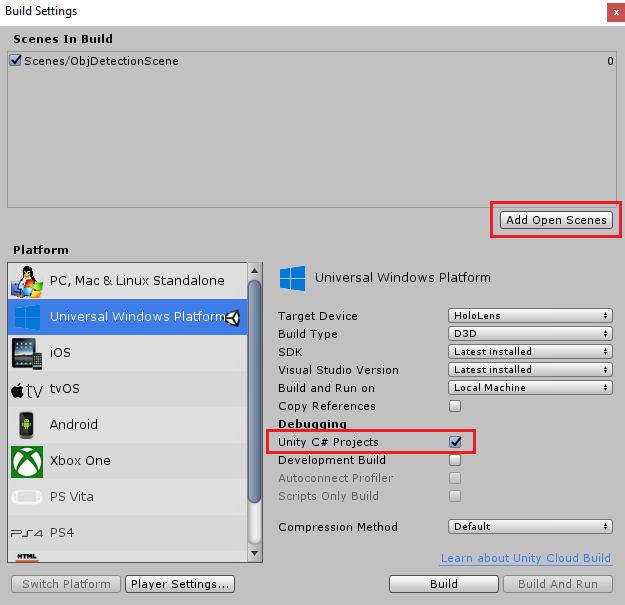

Accédez aux paramètres de génération de fichier>.

Cochez les projets C# Unity.

Cliquez sur Ajouter des scènes ouvertes. Cela ajoute la scène actuellement ouverte à la build.

Cliquez sur Générer. Unity lance une fenêtre Explorateur de fichiers, où vous devez créer, puis sélectionner un dossier dans lequel générer l’application. Créez maintenant ce dossier et nommez-le App. Ensuite, avec le dossier d’application sélectionné, cliquez sur Sélectionner un dossier.

Unity commence à générer votre projet dans le dossier Application .

Une fois que Unity a terminé la génération (cela peut prendre un certain temps), il ouvre une fenêtre de Explorateur de fichiers à l’emplacement de votre build (vérifiez votre barre des tâches, car elle peut ne pas toujours apparaître au-dessus de vos fenêtres, mais vous informera de l’ajout d’une nouvelle fenêtre).

Pour effectuer le déploiement sur Microsoft HoloLens, vous aurez besoin de l’adresse IP de cet appareil (pour le déploiement à distance) et de vous assurer qu’il dispose également du mode développeur défini. Pour ce faire :

Tout en portant votre HoloLens, ouvrez les paramètres.

Accéder aux options avancées réseau et Wi-FiInternet>>

Notez l’adresse IPv4 .

Ensuite, revenez aux paramètres, puis à Update &Security>for Developers

Définissez le mode développeur activé.

Accédez à votre nouvelle build Unity (dossier d’application ) et ouvrez le fichier solution avec Visual Studio.

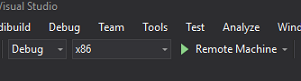

Dans la configuration de la solution, sélectionnez Déboguer.

Dans la plateforme de solutions, sélectionnez x86, Ordinateur distant. Vous serez invité à insérer l’adresse IP d’un appareil distant (Microsoft HoloLens, dans ce cas, que vous avez noté).

Accédez au menu Générer , puis cliquez sur Déployer la solution pour charger l’application sur votre HoloLens.

Votre application doit maintenant apparaître dans la liste des applications installées sur votre Microsoft HoloLens, prête à être lancée !

Pour utiliser l’application :

- Examinez un objet que vous avez entraîné avec votre service Azure Custom Vision, la détection d’objets et utilisez le mouvement Tap.

- Si l’objet est détecté avec succès, un texte d’étiquette d’espace mondial s’affiche avec le nom de la balise.

Important

Chaque fois que vous capturez une photo et que vous l’envoyez au service, vous pouvez revenir à la page Service et réentraîner le service avec les images nouvellement capturées. Au début, vous devrez probablement également corriger les rectangles englobants pour être plus précis et réentraîner le service.

Remarque

Le texte d’étiquette placé peut ne pas apparaître près de l’objet lorsque les capteurs Microsoft HoloLens et/ou spatialTrackingComponent dans Unity ne parvient pas à placer les collisionneurs appropriés, par rapport aux objets réels. Essayez d’utiliser l’application sur une autre surface si c’est le cas.

Votre application Custom Vision, Détection d’objets

Félicitations, vous avez créé une application de réalité mixte qui tire parti d’Azure Custom Vision, de l’API Détection d’objets, qui peut reconnaître un objet à partir d’une image, puis fournir une position approximative pour cet objet dans l’espace 3D.

Exercices bonus

Exercice 1

Ajout à l’étiquette de texte, utilisez un cube semi-transparent pour encapsuler l’objet réel dans un cadre englobant 3D.

Exercice 2

Entraîner votre service Custom Vision pour reconnaître d’autres objets.

Exercice 3

Lire un son lorsqu’un objet est reconnu.

Exercice 4

Utilisez l’API pour réentreîner votre service avec les mêmes images que celles que votre application analyse, afin de rendre le service plus précis (effectuez simultanément la prédiction et l’entraînement).