Impostazioni di amministrazione dell'area di lavoro Apache Spark in Microsoft Fabric

Si applica a: Ingegneria dei dati e data science in Microsoft Fabric

Quando si crea un'area di lavoro in Microsoft Fabric, viene creato automaticamente un pool di avvio associato a tale area di lavoro. Con la configurazione semplificata in Microsoft Fabric, non è necessario scegliere il nodo o le dimensioni del computer, perché queste opzioni vengono gestite automaticamente in background. Questa configurazione offre un'esperienza di avvio della sessione apache Spark più veloce (da 5 a 10 secondi) per consentire agli utenti di iniziare ed eseguire i processi Apache Spark in molti scenari comuni senza doversi preoccupare della configurazione del calcolo. Per scenari avanzati con requisiti di calcolo specifici, gli utenti possono creare un pool di Apache Spark personalizzato e ridimensionare i nodi in base alle esigenze di prestazioni.

Per apportare modifiche alle impostazioni di Apache Spark in un'area di lavoro, è necessario avere il ruolo di amministratore per tale area di lavoro. Per altre informazioni, vedere Ruoli nelle aree di lavoro.

Per gestire le impostazioni di Spark per il pool associato all'area di lavoro:

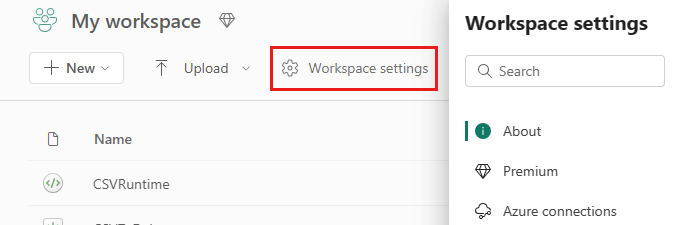

Passare alle impostazioni dell'area di lavoro nell'area di lavoro e scegliere l'opzione Ingegneria dei dati/Scienza per espandere il menu:

L'opzione Calcolo Spark viene visualizzata nel menu a sinistra:

Nota

Se si modifica il pool predefinito da Pool di avvio a un pool spark personalizzato, è possibile che venga visualizzato un avvio più lungo della sessione (~3 minuti).

Pool

Pool predefinito per l'area di lavoro

È possibile usare il pool di avvio creato automaticamente o creare pool personalizzati per l'area di lavoro.

Pool di avvio: pool live preidratati creati automaticamente per un'esperienza più veloce. Questi cluster sono di medie dimensioni. Il pool di avvio è impostato su una configurazione predefinita in base allo SKU di capacità infrastruttura acquistato. Gli amministratori possono personalizzare il numero massimo di nodi ed executor in base ai requisiti di scalabilità del carico di lavoro Spark. Per altre informazioni, vedere Configurare i pool di avvio

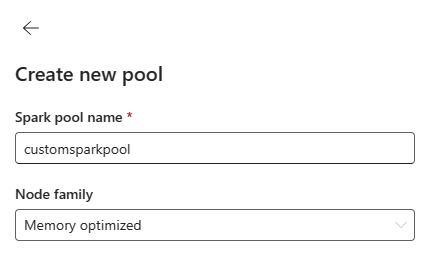

Pool di Spark personalizzato: è possibile ridimensionare i nodi, la scalabilità automatica e allocare dinamicamente gli executor in base ai requisiti del processo Spark. Per creare un pool di Spark personalizzato, l'amministratore della capacità deve abilitare l'opzione Pool di aree di lavoro personalizzate nella sezione Calcolo Spark delle impostazioni di amministrazione della capacità.

Nota

Il controllo a livello di capacità per i pool di aree di lavoro personalizzate è abilitato per impostazione predefinita. Per altre informazioni, vedere Configurare e gestire le impostazioni di data science e ingegneria dei dati per le capacità di Fabric.

Gli amministratori possono creare pool di Spark personalizzati in base ai requisiti di calcolo selezionando l'opzione Nuovo pool .

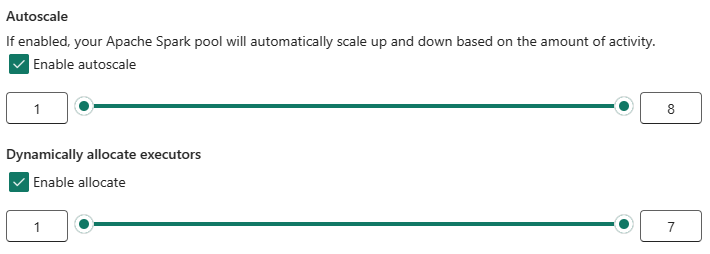

Apache Spark per Microsoft Fabric supporta cluster a nodo singolo, che consente agli utenti di selezionare una configurazione minima del nodo 1, nel qual caso il driver e l'executor vengono eseguiti in un singolo nodo. Questi cluster a nodo singolo offrono disponibilità elevata ripristinabile in caso di errori dei nodi e maggiore affidabilità dei processi per i carichi di lavoro con requisiti di calcolo più piccoli. È anche possibile abilitare o disabilitare l'opzione di scalabilità automatica per i pool di Spark personalizzati. Se abilitata con la scalabilità automatica, il pool acquisirà nuovi nodi entro il limite massimo di nodi specificato dall'utente e li ritirerà dopo l'esecuzione del processo per ottenere prestazioni migliori.

È anche possibile selezionare l'opzione per allocare dinamicamente executor al pool di executor in modo automatico ottimale all'interno del limite massimo specificato in base al volume di dati per ottenere prestazioni migliori.

Altre informazioni sul calcolo apache Spark per Fabric.

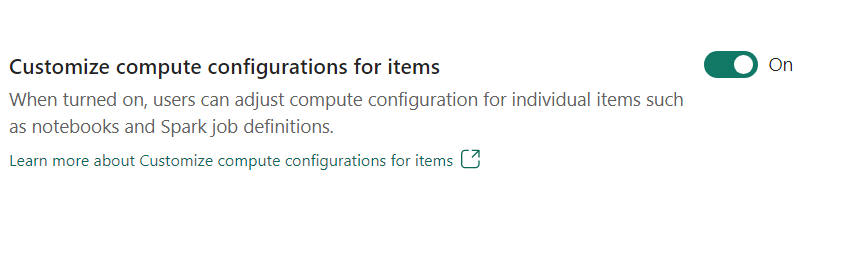

- Personalizzare la configurazione di calcolo per gli elementi: come amministratore dell'area di lavoro, è possibile consentire agli utenti di modificare le configurazioni di calcolo (proprietà a livello di sessione che includono Driver/Executor Core, Driver/Executor Memory) per singoli elementi, ad esempio notebook, definizioni di processi Spark tramite Ambiente.

Se l'impostazione è disattivata dall'amministratore dell'area di lavoro, il pool predefinito e le relative configurazioni di calcolo verranno usate per tutti gli ambienti nell'area di lavoro.

Ambiente

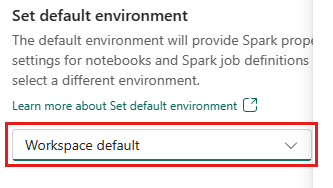

L'ambiente offre configurazioni flessibili per l'esecuzione dei processi Spark (notebook, definizioni di processi Spark). In un ambiente è possibile configurare le proprietà di calcolo, selezionare diverse dipendenze del pacchetto di runtime e di configurazione della libreria in base ai requisiti del carico di lavoro.

Nella scheda ambiente è possibile impostare l'ambiente predefinito. È possibile scegliere la versione di Spark da usare per l'area di lavoro.

In qualità di amministratore dell'area di lavoro infrastruttura, è possibile selezionare un ambiente come ambiente predefinito dell'area di lavoro.

È anche possibile crearne uno nuovo tramite l'elenco a discesa Ambiente .

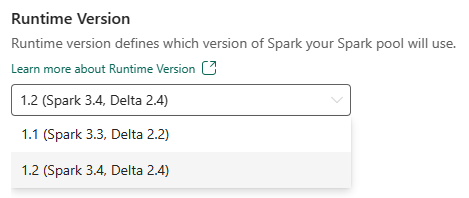

Se si disabilita l'opzione per avere un ambiente predefinito, è possibile selezionare la versione del runtime di Fabric dalle versioni di runtime disponibili elencate nell'elenco a discesa.

Altre informazioni sui runtime di Apache Spark.

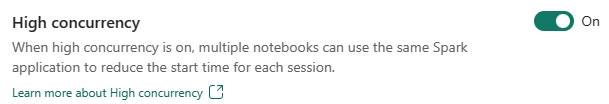

Concorrenza elevata

La modalità di concorrenza elevata consente agli utenti di condividere le stesse sessioni Spark in Apache Spark per la progettazione dei dati e i carichi di lavoro di data science di Apache Spark. Un elemento come un notebook usa una sessione Spark per l'esecuzione e, se abilitata, consente agli utenti di condividere una singola sessione Spark in più notebook.

Altre informazioni sulla concorrenza elevata in Apache Spark per Fabric.

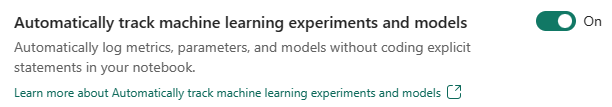

Registrazione automatica per modelli e esperimenti di Machine Learning

Gli amministratori possono ora abilitare l'assegnazione automatica dei tag per i modelli e gli esperimenti di Machine Learning. Questa opzione acquisisce automaticamente i valori dei parametri di input, delle metriche di output e degli elementi di output di un modello di Machine Learning durante il training. Altre informazioni sull'assegnazione automatica dei tag.

Contenuto correlato

- Informazioni sui runtime di Apache Spark in Fabric - Panoramica, controllo delle versioni, supporto di più runtime e aggiornamento del protocollo Delta Lake.

- Per altre informazioni, vedere la documentazione pubblica di Apache Spark.

- Risposte alle domande frequenti: Domande frequenti sulle impostazioni di amministrazione dell'area di lavoro Apache Spark.

Commenti e suggerimenti

In arrivo: Nel corso del 2024 verranno ritirati i problemi di GitHub come meccanismo di feedback per il contenuto e verranno sostituiti con un nuovo sistema di feedback. Per altre informazioni, vedi: https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per