Arricchire gli eventi di Apache Kafka® con attributi di ADLS Gen2 con Apache Flink®

Nota

Azure HDInsight su AKS verrà ritirato il 31 gennaio 2025. Prima del 31 gennaio 2025, sarà necessario eseguire la migrazione dei carichi di lavoro a Microsoft Fabric o a un prodotto Azure equivalente per evitare interruzioni improvvise dei carichi di lavoro. I cluster rimanenti nella sottoscrizione verranno arrestati e rimossi dall’host.

Solo il supporto di base sarà disponibile fino alla data di ritiro.

Importante

Questa funzionalità è attualmente disponibile solo in anteprima. Le Condizioni per l'utilizzo supplementari per le anteprime di Microsoft Azure includono termini legali aggiuntivi che si applicano a funzionalità di Azure in versione beta, in anteprima o in altro modo non ancora disponibili a livello generale. Per informazioni su questa anteprima specifica, vedere Informazioni sull'anteprima di Azure HDInsight nel servizio Azure Kubernetes. Per domande o suggerimenti sulle funzionalità, inviare una richiesta in AskHDInsight con i dettagli e seguire Microsoft per altri aggiornamenti nella Community di Azure HDInsight.

In questo articolo si apprenderà come arricchire gli eventi in tempo reale unendo un flusso da Kafka con una tabella in ADLS Gen2 usando Flink Streaming. L'API Flink Streaming viene usata per unire eventi da HDInsight Kafka con attributi di ADLS Gen2. Vengono inoltre usati eventi con join di attributi per eseguire il sink in un altro argomento Kafka.

Prerequisiti

- Cluster Flink in HDinsight su AKS

- Cluster Kafka in HDInsight

- Assicurarsi che le impostazioni di rete siano state prese in considerazione come descritto in Uso di Kafka in HDInsight per assicurarsi che HDInsight nei cluster del servizio Azure Kubernetes e HDInsight si trovino nella stessa rete virtuale

- Per questa dimostrazione, usiamo una macchina virtuale Window come ambiente di sviluppo del progetto maven nella stessa rete virtuale di HDInsight su Kubernetes

Preparazione dell'argomento Kafka

Si sta creando un argomento denominato user_events.

- Lo scopo è leggere un flusso di eventi in tempo reale da un argomento Kafka usando Flink. Ogni evento è disponibile con i campi seguenti:

user_id, item_id, type, timestamp,

Kafka 3.2.0

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --create --replication-factor 2 --partitions 3 --topic user_events --bootstrap-server wn0-contsk:9092

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --create --replication-factor 2 --partitions 3 --topic user_events_output --bootstrap-server wn0-contsk:9092

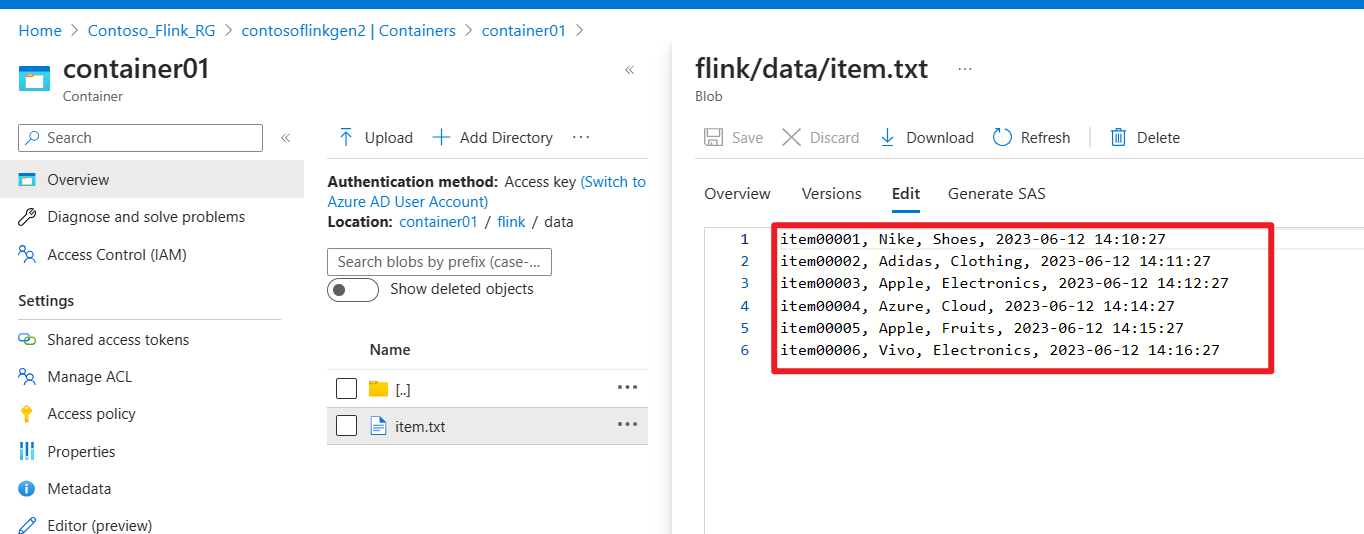

Preparare il file in ADLS Gen2

Si sta creando un file denominato item attributes nella risorsa di archiviazione

- Lo scopo è leggere un batch di

item attributesda un file in ADLS Gen2. Ogni elemento include i campi seguenti:item_id, brand, category, timestamp,

Sviluppare il processo Apache Flink

In questo passaggio vengono eseguite le attività seguenti

- Arricchire l'argomento

user_eventsda Kafka aggiungendoitem attributesda un file in ADLS Gen2. - Il risultato di questo passaggio viene eseguito come attività utente arricchita di eventi in un argomento Kafka.

Sviluppare un progetto Maven

pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>contoso.example</groupId>

<artifactId>FlinkKafkaJoinGen2</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<flink.version>1.17.0</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.12</scala.binary.version>

<kafka.version>3.2.0</kafka.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-java -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-clients -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-files -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-files</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>${flink.version}</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<appendAssemblyId>false</appendAssemblyId>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

Eseguire il join all'argomento Kafka con ADLS Gen2 File

KafkaJoinGen2Demo.java

package contoso.example;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.functions.RichMapFunction;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.api.java.tuple.Tuple4;

import org.apache.flink.api.java.tuple.Tuple7;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.connector.kafka.sink.KafkaRecordSerializationSchema;

import org.apache.flink.connector.kafka.sink.KafkaSink;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import java.io.BufferedReader;

import java.io.FileReader;

import java.util.HashMap;

import java.util.Map;

public class KafkaJoinGen2Demo {

public static void main(String[] args) throws Exception {

// 1. Set up the stream execution environment

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// Kafka source configuration, update with your broker IPs

String brokers = "<broker-ip>:9092,<broker-ip>:9092,<broker-ip>:9092";

String inputTopic = "user_events";

String outputTopic = "user_events_output";

String groupId = "my_group";

// 2. Register the cached file, update your container name and storage name

env.registerCachedFile("abfs://<container-name>@<storagename>.dfs.core.windows.net/flink/data/item.txt", "file1");

// 3. Read a stream of real-time user behavior event from a Kafka topic

KafkaSource<String> kafkaSource = KafkaSource.<String>builder()

.setBootstrapServers(brokers)

.setTopics(inputTopic)

.setGroupId(groupId)

.setStartingOffsets(OffsetsInitializer.earliest())

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

DataStream<String> kafkaData = env.fromSource(kafkaSource, WatermarkStrategy.noWatermarks(), "Kafka Source");

// Parse Kafka source data

DataStream<Tuple4<String, String, String, String>> userEvents = kafkaData.map(new MapFunction<String, Tuple4<String, String, String, String>>() {

@Override

public Tuple4<String, String, String, String> map(String value) throws Exception {

// Parse the line into a Tuple4

String[] parts = value.split(",");

if (parts.length < 4) {

// Log and skip malformed record

System.out.println("Malformed record: " + value);

return null;

}

return new Tuple4<>(parts[0], parts[1], parts[2], parts[3]);

}

});

// 4. Enrich the user activity events by joining the items' attributes from a file

DataStream<Tuple7<String,String,String,String,String,String,String>> enrichedData = userEvents.map(new MyJoinFunction());

// 5. Output the enriched user activity events to a Kafka topic

KafkaSink<String> sink = KafkaSink.<String>builder()

.setBootstrapServers(brokers)

.setRecordSerializer(KafkaRecordSerializationSchema.builder()

.setTopic(outputTopic)

.setValueSerializationSchema(new SimpleStringSchema())

.build()

)

.build();

enrichedData.map(value -> value.toString()).sinkTo(sink);

// 6. Execute the Flink job

env.execute("Kafka Join Batch gen2 file, sink to another Kafka Topic");

}

private static class MyJoinFunction extends RichMapFunction<Tuple4<String,String,String,String>, Tuple7<String,String,String,String,String,String,String>> {

private Map<String, Tuple4<String, String, String, String>> itemAttributes;

@Override

public void open(Configuration parameters) throws Exception {

super.open(parameters);

// Read the cached file and parse its contents into a map

itemAttributes = new HashMap<>();

try (BufferedReader reader = new BufferedReader(new FileReader(getRuntimeContext().getDistributedCache().getFile("file1")))) {

String line;

while ((line = reader.readLine()) != null) {

String[] parts = line.split(",");

itemAttributes.put(parts[0], new Tuple4<>(parts[0], parts[1], parts[2], parts[3]));

}

}

}

@Override

public Tuple7<String,String,String,String,String,String,String> map(Tuple4<String,String,String,String> value) throws Exception {

Tuple4<String, String, String, String> broadcastValue = itemAttributes.get(value.f1);

if (broadcastValue != null) {

return Tuple7.of(value.f0,value.f1,value.f2,value.f3,broadcastValue.f1,broadcastValue.f2,broadcastValue.f3);

} else {

return null;

}

}

}

}

Creare il pacchetto del file JAR e inviarlo ad Apache Flink

Il file JAR in pacchetto viene inviato a Flink:

Produrre un argomento di user_events in tempo reale su Kafka

È possibile produrre eventi di comportamento utente in tempo reale user_events in Kafka.

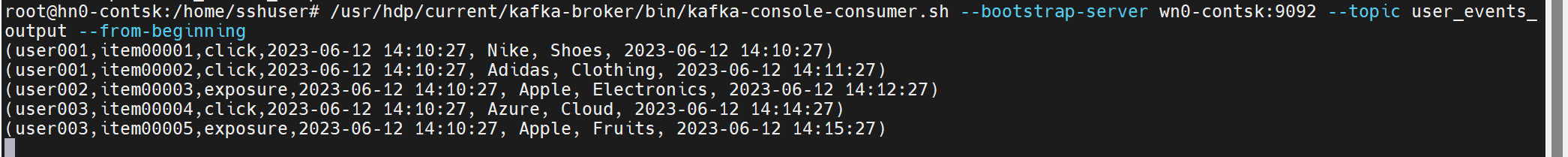

Utilizzare il join di itemAttributes con user_events in Kafka

Ora si sta usando itemAttributes sugli eventi di attività utente di join al file system user_events.

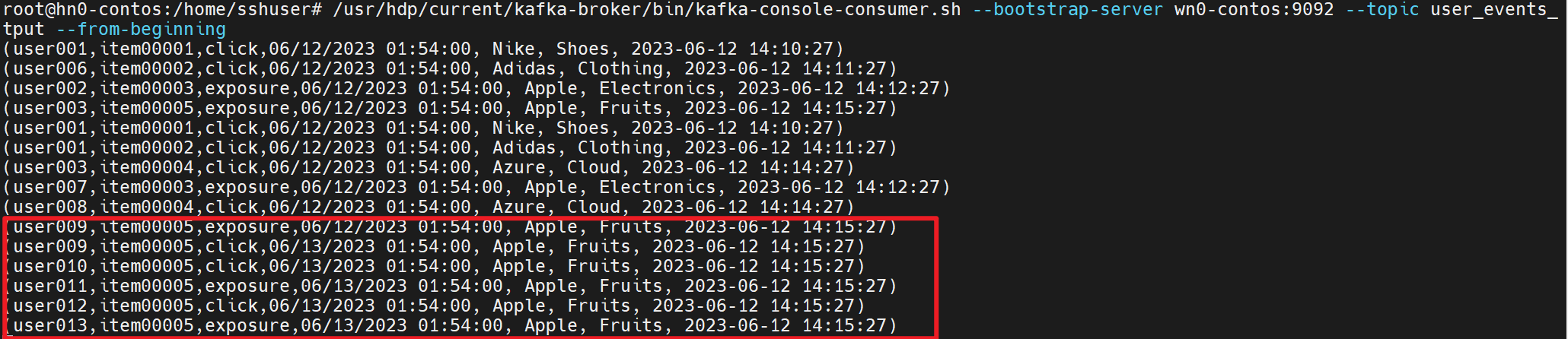

Continuiamo a generare e utilizzare gli attributi dell'attività utente e degli elementi nelle immagini seguenti

Riferimento

- Esempi di Flink

- Sito Web di Apache Flink

- Apache, Apache Kafka, Flink, Apache Flink, Flink e i nomi dei progetti open source associati sono marchi di Apache Software Foundation (ASF).