Elaborazione del flusso senza codice in Analisi di flusso di Azure

L'editor senza codice consente di sviluppare in modo facile un processo di analisi di flusso per elaborare i dati di streaming in tempo reale, usando la funzionalità di trascinamento della selezione, senza scrivere nemmeno una riga di codice. L'esperienza offre un'area di lavoro che consente di connettersi alle origini di input per visualizzare i dati di streaming in modo rapido. È quindi possibile trasformarlo prima di scrivere nelle destinazioni.

Con l'editor senza codice, si potrà facilmente:

- Modificare gli schemi di input.

- Eseguire operazioni di preparazione dei dati come join e filtri.

- Approcciare scenari avanzati come le aggregazioni di intervalli temporali (finestre a cascata, salto e sessione) per le operazioni raggruppate.

Dopo aver creato ed eseguito i processi di analisi di flusso, è possibile rendere facilmente operativi i carichi di lavoro di produzione. Usare il set corretto di metriche predefinite per il monitoraggio e la risoluzione dei problemi. I processi di analisi di flusso vengono fatturati in base al modello tariffario quando vengono eseguiti.

Prerequisiti

Prima di sviluppare i processi di analisi di flusso usando l'editor senza codice, è necessario soddisfare i seguenti requisiti:

- Le sorgenti di input di streaming e le risorse di destinazione per il processo di analisi di flusso devono essere accessibili pubblicamente e non possono trovarsi in una rete virtuale di Azure.

- È necessario disporre delle autorizzazioni necessarie per accedere alle sorgenti di input e output di streaming.

- È necessario mantenere le autorizzazioni per creare e modificare le risorse di Analisi di flusso di Azure.

Nota

L'editor senza codice non è attualmente disponibile nella regione della Cina.

Processo di Analisi di flusso di Azure

Un processo di analisi di flusso si basa su tre componenti principali: input di streaming, trasformazionie output. È possibile avere tutti i componenti che si desidera, diversi input, rami paralleli con più trasformazioni e diversi output. Per altre informazioni, vedere Documentazione di Analisi di flusso di Azure.

Nota

Le funzionalità e i tipi di output seguenti non sono disponibili quando si usa l'editor senza codice:

- Funzioni definite dall'utente.

- Modifica delle query nel pannello query di Analisi di flusso di Azure. Tuttavia, è possibile visualizzare la query generata dall'editor senza codice nel pannello query.

- Aggiunta di input/output nei pannelli di input/output di Analisi di flusso di Azure. Tuttavia, è possibile visualizzare l'input/output generato dall'editor senza codice nel pannello input/output.

- I tipi di output seguenti non sono disponibili: Funzione di Azure, ADLS Gen1, PostgreSQL DB, coda/argomento del bus di servizio, archiviazione tabelle.

Per accedere all'editor senza codice per la compilazione del processo di analisi di flusso, esistono due approcci:

Tramite il portale di Analisi di flusso di Azure (anteprima): creare un processo di analisi di flusso e quindi selezionare l'editor senza codice nella scheda Inizio nella pagina Panoramica, oppure selezionare Editor senza codice nel riquadro sinistro.

Tramite il portale di Hub eventi di Azure: aprire un'istanza di Hub eventi. Selezionare Elaborare dati, poi selezionare un qualunque modello predefinito.

I modelli predefiniti consentono di sviluppare ed eseguire un processo per risolvere vari scenari, tra cui:

- Creare una dashboard in tempo reale con il set di dati di Power BI

- Acquisire dati da Hub eventi in formato Delta Lake (anteprima)

- Filtrare e inserire in Azure Synapse SQL

- Acquisizione dei dati di Hub eventi in formato Parquet in Azure Data Lake Storage Gen2

- Materializzazione dei dati in Azure Cosmos DB

- Filtrare e inserire in Data Lake Storage Gen2

- Arricchire i dati e inserire nell’hub eventi

- Trasformare e archiviare i dati nel database SQL di Azure

- Filtrare e inserire in Esplora dati di Azure

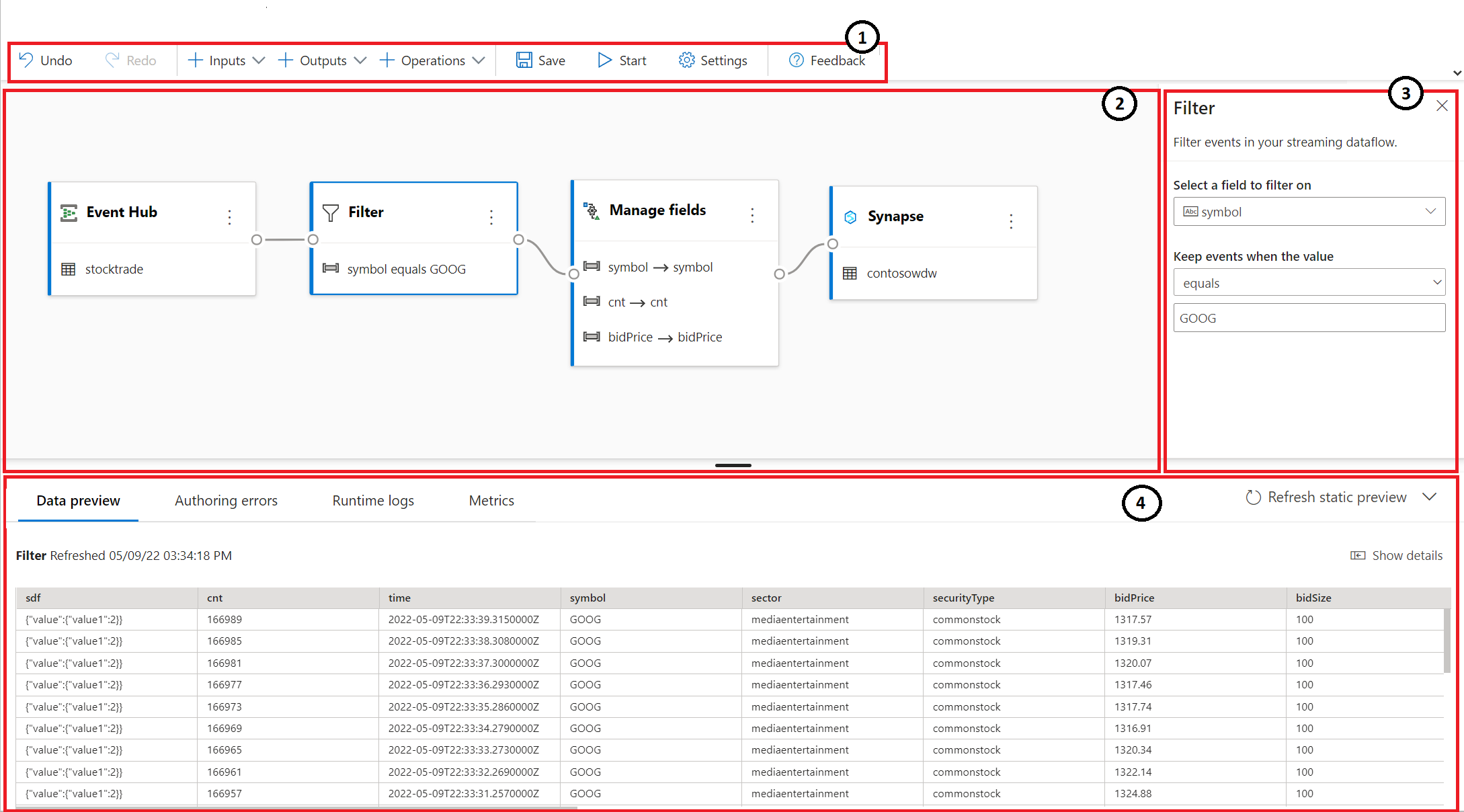

Lo screenshot seguente mostra un processo di analisi di flusso completo. Evidenzia tutte le sezioni disponibili durante la progettazione.

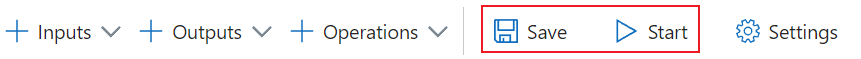

- Barra multifunzione: sulla barra multifunzione, le sezioni seguono l'ordine di un processo di analisi classica: un hub eventi come input (noto anche come origine dati), trasformazioni (streaming di Etract, trasformazioni e operazioni di caricamento), output, un pulsante per salvare lo stato di avanzamento e un pulsante per iniziare il processo.

- Visualizzazione diagramma: si tratta di una rappresentazione grafica del processo di analisi di flusso, dall'input, alle operazioni e output.

- Riquadro laterale: a seconda del componente selezionato nella visualizzazione diagramma, vengono visualizzate le impostazioni per modificare input, trasformazione o output.

- Schede per l'anteprima dei dati, la creazione di errori, i log di runtime e le metriche: per ogni riquadro, l'anteprima dei dati mostra i risultati per tale passaggio (live per gli input; su richiesta per trasformazioni e output). Questa sezione riepiloga anche eventuali errori o avvisi di creazione che potrebbero crearsi durante lo sviluppo del processo. Selezionando ogni errore o avviso viene selezionata la trasformazione. Fornisce anche le metriche del processo per monitorare l'integrità del processo in esecuzione.

Input dei dati in streaming

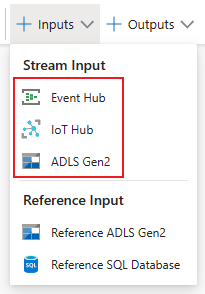

L'editor senza codice supporta l’input dei dati in streaming da tre tipi di risorse:

- Hub eventi di Azure

- Hub IoT di Azure

- Azure Data Lake Storage Gen2

Per altre informazioni sull’input dei dati in streaming, vedere Trasmettere dati come input in Analisi di flusso

Nota

L'editor senza codice nel portale di Hub eventi di Azure include solo Hub eventi come opzione di input.

Hub eventi di Azure come input di streaming

Hub eventi di Azure è una piattaforma di streaming di Big Data e un servizio di inserimento di eventi. È in grado di ricevere ed elaborare milioni di eventi al secondo. I dati inviati a un hub eventi possono essere trasformati e archiviati usando qualsiasi provider di analisi in tempo reale o adattatori di invio in batch/archiviazione.

Per configurare un hub eventi come input per il processo, selezionare l'icona dell'Hub eventi. Nella visualizzazione diagramma compare un riquadro, oltre a un riquadro laterale per la configurazione e la connessione.

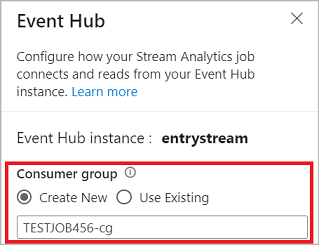

Quando ci si connette all'hub eventi nell'editor senza codice, è consigliabile creare un nuovo gruppo di consumer (opzione predefinita). Questo approccio evita che l'hub eventi raggiunga il limite dei lettori simultanei. Per altre informazioni sui gruppi di consumer e sulla necessità di selezionare un gruppo di consumer esistente o crearne uno nuovo, vedere Gruppi di consumer.

Se l'hub eventi si trova nel piano Basic, è possibile usare solo il gruppo di consumer $Defaultesistente. Se l'hub eventi si trova in un piano Standard o Premium, è possibile creare un nuovo gruppo di consumer.

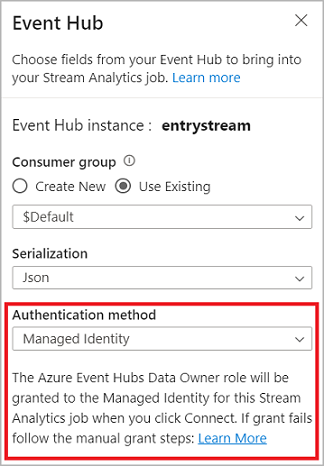

Quando ci si connette all'hub eventi, selezionando Identità gestita come modalità di autenticazione, al ruolo Proprietario dati di Hub eventi di Azure viene concessa l'identità gestita per il processo di analisi di flusso. Per altre informazioni sulle identità gestite per un hub eventi, vedere Usare le identità gestite per accedere a un hub eventi da un processo di Analisi di flusso di Azure.

Le identità gestite annullano le limitazioni dei metodi di autenticazione basati sull'utente. Queste limitazioni includono la necessità di ripetere l'autenticazione a causa delle modifiche apportate alla password o delle scadenze dei token utente che si verificano ogni 90 giorni.

Dopo aver configurato i dettagli dell'hub eventi e aver selezionato Connetti, è possibile aggiungere manualmente i campi usando + Aggiungi campo se si conoscono i nomi dei campi. Per rilevare automaticamente i campi e i tipi di dati in base a un campione dei messaggi in arrivo, selezionare Rilevare automativamente i campi. Se necessario, la selezione del simbolo dell'ingranaggio consente di modificare le credenziali.

Quando i processi di analisi di flusso rilevano i campi, questi vengono visualizzati nell'elenco. Viene visualizzata anche un'anteprima in tempo reale dei messaggi in ingresso nella tabella Anteprima dati nella visualizzazione diagramma.

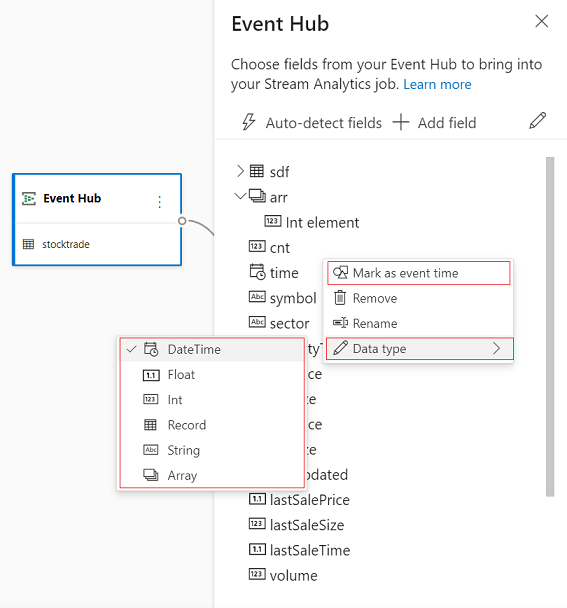

Modificare i dati di input

È possibile modificare i nomi dei campi, rimuovere il campo, modificare il tipo di dati oppure modificare l'ora dell'evento (Contrassegna come ora evento: clausola TIMESTAMP BY in caso di campo di tipo datetime), selezionando il simbolo a tre punti accanto a ogni campo. È anche possibile espandere, selezionare e modificare i campi annidati dai messaggi in arrivo, come illustrato nell'immagine seguente.

Suggerimento

Questo vale anche per i dati di input dell'hub IoT di Azure e di Azure Data Lake Storage Gen2.

I tipi di dati disponibili sono:

- DateTime: campo data e ora in formato ISO.

- Float: numero decimale.

- Int: numero intero.

- Record: oggetto annidato con più record.

- Stringa: Testo.

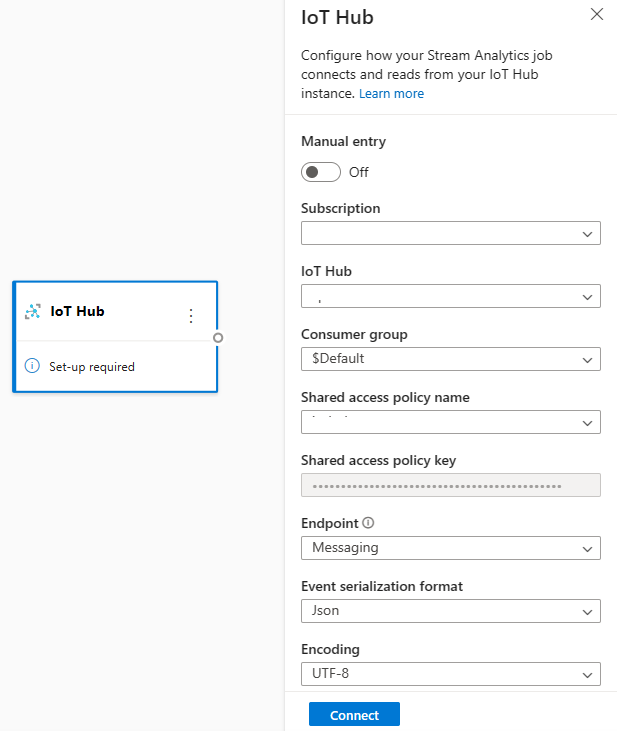

Hub IoT di Azure come input di streaming

L'hub IoT di Azure è un servizio gestito, ospitato nel cloud, che funge da hub centrale di messaggi per le comunicazioni bidirezionali tra l'applicazione di IoT e i relativi dispositivi collegati. I dati dei dispositivi IoT inviati all'hub IoT possono essere usati come input per un processo di analisi di flusso.

Nota

L'input dell'hub IoT di Azure è disponibile nell'editor senza codice nel portale di Analisi di flusso di Azure.

Per aggiungere un hub IoT come input di streaming per il processo, selezionare l'hub IoT in Input dalla barra multifunzione. Immettere quindi le informazioni necessarie nel riquadro destro per connettere l'hub IoT al processo. Per altre informazioni sui dettagli di ogni campo, vedere Trasmettere dati dall'hub IoT al processo di analisi di flusso.

Azure Data Lake Storage Gen2 come input di streaming

Azure Data Lake Storage Gen2 (ADLS Gen2) è una soluzione data lake aziendale basata sul cloud. È progettato per archiviare grandi quantità di dati in qualsiasi formato e facilitare carichi di lavoro analitici di Big Data. I dati archiviati in ADLS Gen2 possono essere elaborati come flusso di dati da Analisi di flusso. Per altre informazioni su questo tipo di input, vedere Trasmettere dati da ADLS Gen2 al processo di analisi di flusso

Nota

L'input di Azure Data Lake Storage Gen2 è disponibile nell'editor senza codice nel portale di Analisi di flusso di Azure.

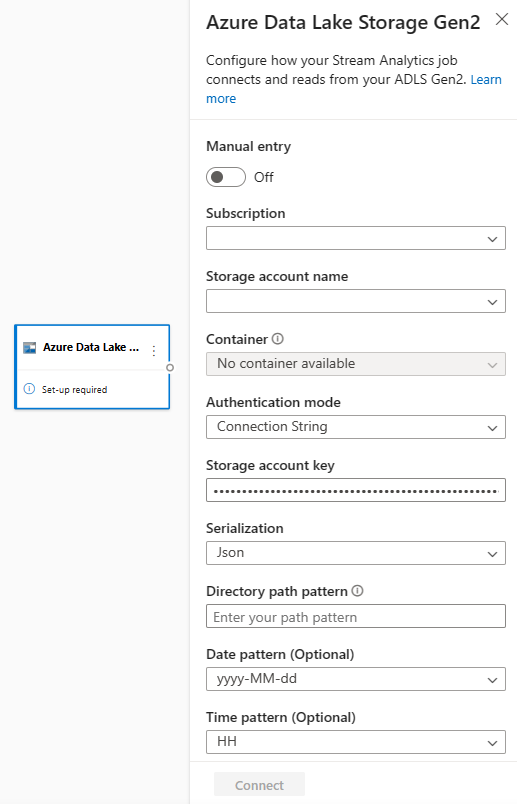

Per aggiungere un ADLS Gen2 come input di streaming per il processo, selezionare ADLS Gen2 inInputdalla barra multifunzione. Compilare quindi le informazioni necessarie nel riquadro destro per connettere ADLS Gen2 al processo. Per altre informazioni sui dettagli di ogni campo, vedere Trasmettere dati da ADLS Gen2 al processo di analisi di flusso

Input dei dati di riferimento

I dati di riferimento sono statici o cambiano lentamente nel tempo. Viene in genere usato per arricchire i flussi in ingresso ed eseguire ricerche nel processo. Ad esempio, è possibile unire gli input del flusso dei dati ai dati di riferimento, proprio come si esegue un join SQL per cercare valori statici. Per maggiori informazioni sugli input dei dati di riferimento, vedere Uso dei dati di riferimento per le ricerche in Analisi di flusso.

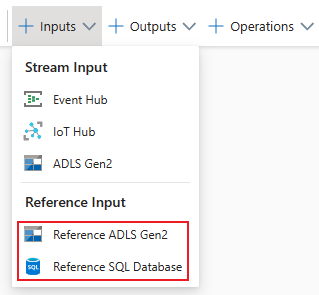

L'editor senza codice supporta ora due sorgenti di dati di riferimento:

- Azure Data Lake Storage Gen2

- database SQL di Azure

Azure Data Lake Storage Gen2 come dati di riferimento

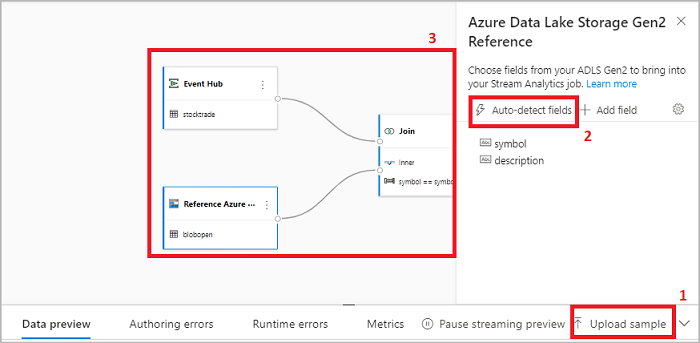

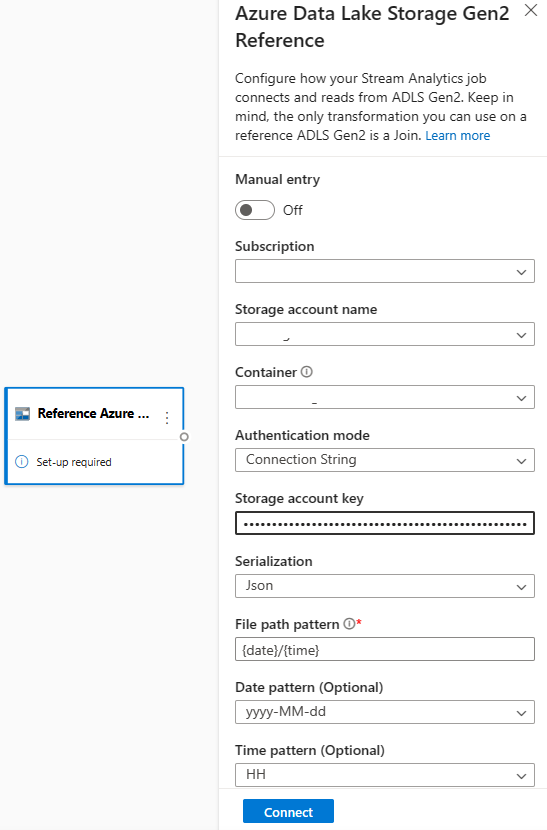

I dati di riferimento vengono modellati come sequenza di blob in ordine crescente della combinazione di data/ora specificata nel nome del blob. È possibile aggiungere blob alla fine della sequenza solo usando una data/ora maggiore di quella specificata nell'ultimo blob della sequenza. I blob vengono definiti nella configurazione di input.

Prima di tutto, nella sezione Input sulla barra multifunzione, selezionare Riferimento ADLS Gen2. Per informazioni dettagliate su ogni campo, vedere la sezione relativa all'archiviazione BLOB di Azure in Usare i dati di riferimento per le ricerche in Analisi di flusso.

Caricare quindi un file di matrice JSON. I campi nel file verranno rilevati. Usare questi dati di riferimento per eseguire la trasformazione con i dati di input di streaming da Hub eventi.

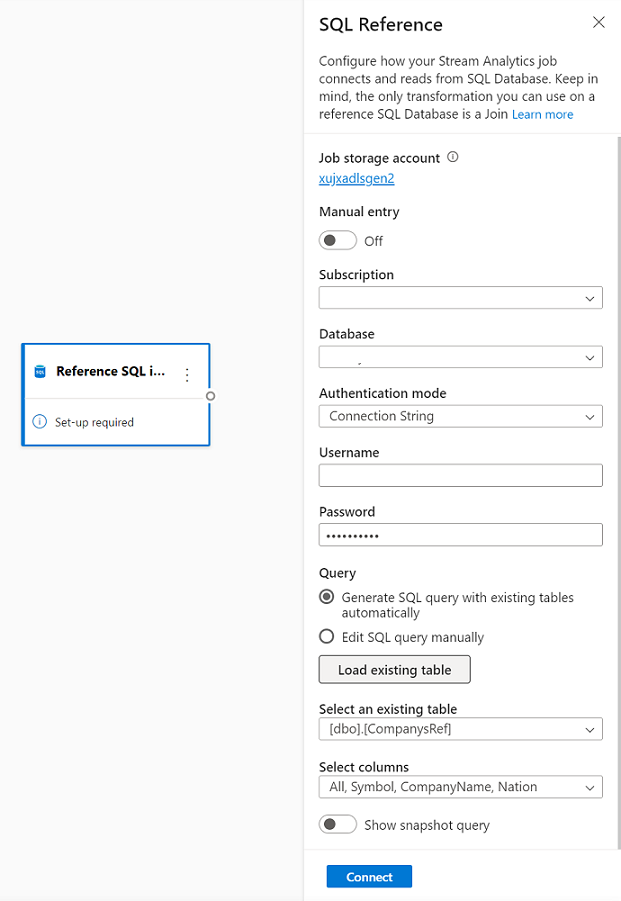

Database SQL di Azure come dati di riferimento

È possibile usare il database SQL di Azure come dati di riferimento per il processo di analisi di flusso nell'editor senza codice. Per maggiori informazioni, vedere la sezione relativa al database SQL in Usare i dati di riferimento per le ricerche in Analisi di flusso.

Per configurare il database SQL come input dei dati di riferimento, selezionare database SQL come riferimento nella sezione Input della barra multifunzione. Immettere quindi le informazioni per connettere il database di riferimento e selezionare la tabella con le colonne necessarie. È anche possibile recuperare i dati di riferimento dalla tabella modificando manualmente la query SQL.

Trasformazioni

Le trasformazioni dei dati di streaming sono intrinsecamente diverse dalle trasformazioni dei dati batch. Quasi tutti i dati di streaming hanno un componente temporale, che influisce sulle attività di preparazione dei dati coinvolte.

Per aggiungere una trasformazione dei dati di streaming al processo, selezionare il simbolo di trasformazione nella sezioneOperazioni sulla barra multifunzione per tale trasformazione. Il rispettivo riquadro verrà eliminato nella visualizzazione diagramma. Dopo averla selezionata, verrà visualizzato il riquadro laterale per la trasformazione per configurarla.

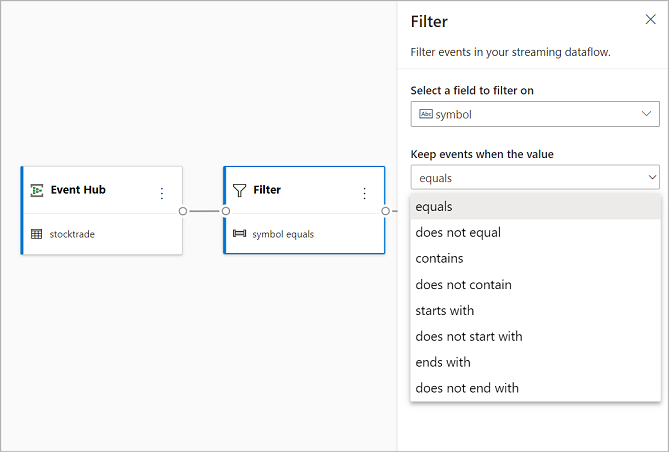

Filtro

Usare la trasformazione Filtro per filtrare gli eventi in base al valore di un campo nell'input. A seconda del tipo di dati (numero o testo), la trasformazione manterrà i valori corrispondenti alla condizione selezionata.

Nota

All'interno di ogni riquadro, verranno visualizzate informazioni sulle altre operazioni necessarie per la trasformazione. Ad esempio, quando si aggiunge un nuovo riquadro, verrà visualizzato un messaggio di Installazione obbligatoria. Se manca un connettore del nodo, verrà visualizzato un messaggio di Errore, oppure un messaggio di Avviso.

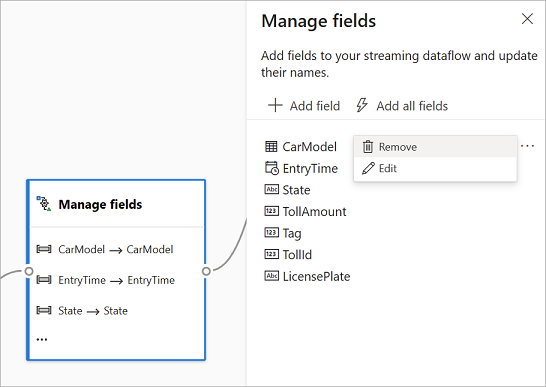

Gestire i campi

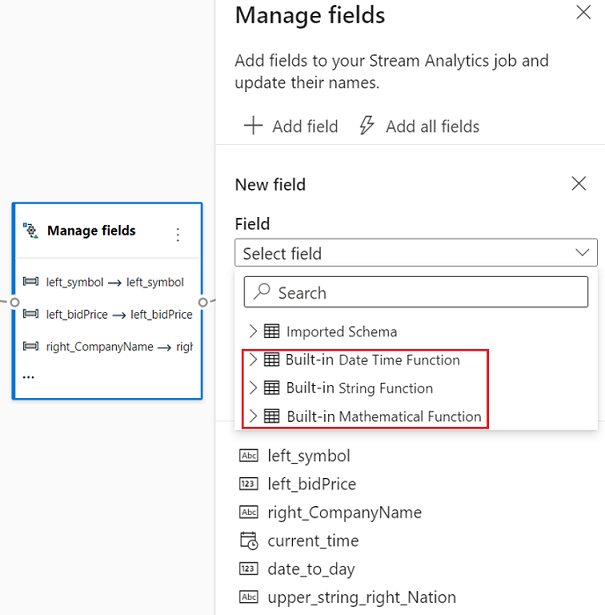

La trasformazione Gestisci campi consente di aggiungere, rimuovere o rinominare campi provenienti da un input o da un'altra trasformazione. Le impostazioni nel riquadro laterale permettono di aggiungere un nuovo campo selezionando Aggiungi campo o di aggiungere tutti i campi contemporaneamente.

È anche possibile aggiungere un nuovo campo con le Funzioni predefinite per aggregare i dati da upstream. Alcune delle funzioni predefinite attualmente supportate sono alcune funzioni in Funzioni stringa,Funzioni di data e ora, funzioni matematiche. Per altre informazioni sulle definizioni di queste funzioni, vedere Funzioni predefinite (Analisi di flusso di Azure).

Suggerimento

Dopo aver configurato un riquadro, la visualizzazione diagramma offre una panoramica delle impostazioni nel riquadro. Ad esempio, nell'area Gestisci campi dell'immagine precedente si vedono i primi tre campi gestiti con i rispettivi nuovi nomi assegnati. Ogni riquadro contiene informazioni pertinenti.

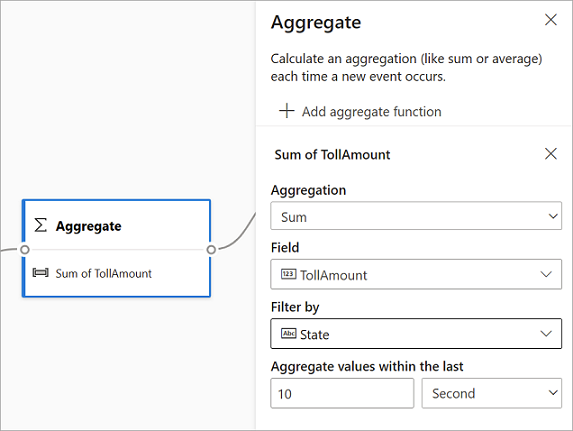

Aggregazione

È possibile usare la trasformazione Aggregazione per calcolare un'aggregazione (Somma, Minimo, Massimo o Media) ogni volta che si verifica un nuovo evento in un periodo di tempo. Questa operazione consente inoltre di filtrare o sezionare l'aggregazione in base ad altre dimensioni nei dati. È possibile avere una o più aggregazioni nella stessa trasformazione.

Per aggiungere un'aggregazione, selezionare il simbolo di trasformazione. Connettere quindi un input, selezionare l'aggregazione, aggiungere eventuali dimensioni filtro o sezione e selezionare il periodo di tempo in cui verrà calcolata l'aggregazione. In questo esempio, viene calcolata il valore totale del pedaggio in base allo stato di provenienza del veicolo negli ultimi 10 secondi.

Per aggiungere un'altra aggregazione alla stessa trasformazione, selezionare Aggiungi funzione di aggregazione. Tenere presente che il filtro o la sezione verranno applicati a tutte le aggregazioni nella trasformazione.

Join.

Usare la trasformazione Join per combinare gli eventi di due input in base alle coppie di campi selezionate. Se non si seleziona una coppia di campi, il join sarà effettuato in base al tempo, per impostazione predefinita. Il valore predefinito è ciò che rende questa trasformazione diversa da una batch.

Come per i normali join, sono disponibili opzioni per la logica di join:

- Inner join: includere solo i record di entrambe le tabelle dove la coppia corrisponde. In questo esempio, questa è la posizione in cui la targa corrisponde a entrambi gli input.

- Left outer join: includere tutti i record della tabella sinistra (prima) e solo i record della seconda che corrispondono alla coppia di campi. Se non esiste alcuna corrispondenza, i campi del secondo input saranno vuoti.

Per selezionare il tipo di join, selezionare il simbolo per il tipo preferito nel riquadro laterale.

Infine, selezionare il periodo per il quale si vuole calcolare il join. In questo esempio, il join esamina gli ultimi 10 secondi. Tenere presente che maggiore è il periodo, meno frequente è l'output e più risorse di elaborazione verranno usate per la trasformazione.

Per impostazione predefinita, vengono inclusi tutti i campi di entrambe le tabelle. I prefissi a sinistra (primo nodo) e a destra (secondo nodo) nell'output consentono di distinguere l'origine.

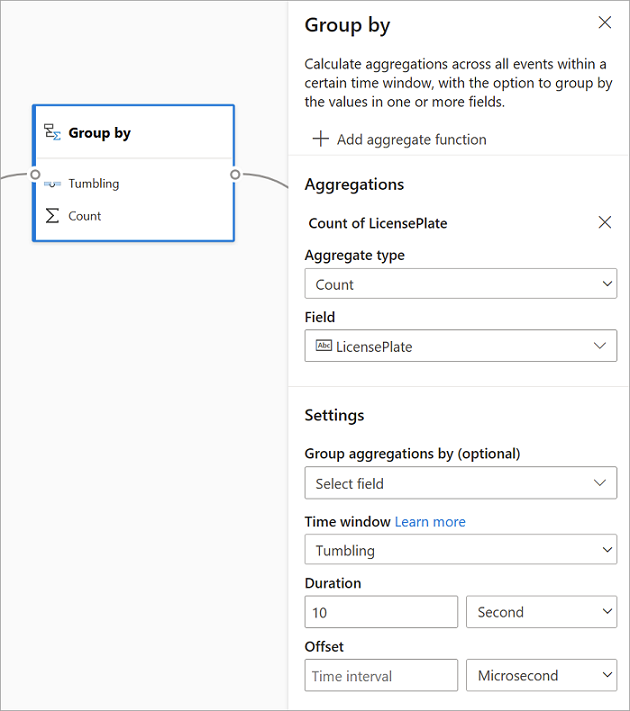

Raggruppa per

Usare la trasformazione Group by per calcolare le aggregazioni in tutti gli eventi in un determinato intervallo di tempo. Puoi raggruppare i valori di uno o più campi. È simile alla trasformazione Aggregazione, ma offre maggiori opzioni per le aggregazioni. Include anche opzioni più complesse per le finestre temporali. Come Aggregazione, è anche possibile aggiungere più aggregazioni per trasformazione.

Le aggregazioni disponibili nella trasformazione sono:

- Media

- Conteggio

- Massimo

- Minimo

- Percentile (continuo e discreto)

- Deviazione standard

- Sum

- Variance

Per configurare la trasformazione:

- Selezionare l'aggregazione preferita.

- Selezionare il campo su cui si vuole aggregare.

- Selezionare un campo facoltativo group-by se si desidera ottenere il calcolo aggregazione rispetto a un'altra dimensione o categoria. Ad esempio: Stato.

- Selezionare la funzione per le finestre temporali.

Per aggiungere un'altra aggregazione alla stessa trasformazione, selezionare Aggiungi funzione di aggregazione. Tenere presente che il campo Group by e la funzione windowing verranno applicati a tutte le aggregazioni nella trasformazione.

Un indicatore orario per la fine dell'intervallo di tempo viene visualizzato come parte dell'output della trasformazione per riferimento. Per maggiori informazioni sulle finestre temporali supportate dai processi di analisi di flusso, vedere Funzioni di windowing (Analisi di flusso di Azure).

Popolare

Usare la trasformazione Unione per connettere due o più input per aggiungere eventi con campi condivisi (con lo stesso nome e tipo di dati) in una tabella. I campi che non corrispondono verranno eliminati e non saranno inclusi nell'output.

Espandi matrice

Usare la trasformazione Espandi matrice per creare una nuova riga per ogni valore all'interno di una matrice.

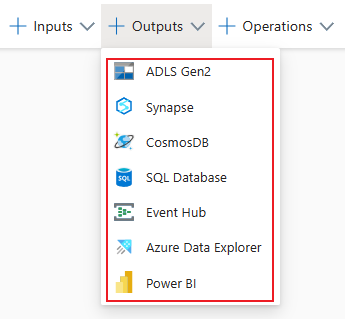

Output di streaming

L'esperienza di trascinamento della selezione senza codice supporta attualmente diversi sink di output per archiviare i dati elaborati in tempo reale.

Azure Data Lake Storage Gen2

Data Lake Storage Gen2 usa Archiviazione di Azure come base per la compilazione di Enterprise Data Lake (EDL) in Azure. Questo servizio è in grado di gestire diversi petabyte di informazioni supportando al tempo stesso centinaia di gigabit di velocità effettiva. Consente di gestire facilmente grandi quantità di dati. L'Archiviazione BLOB di Azure offre una soluzione conveniente e scalabile per archiviare grandi quantità di dati non strutturati nel cloud.

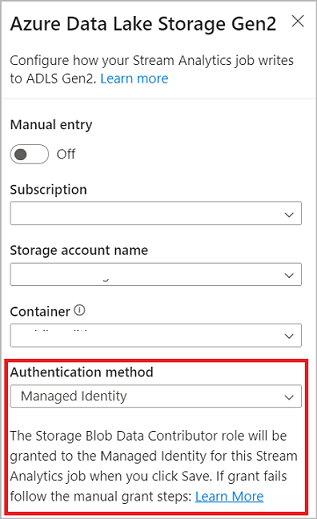

Nella sezione Output sulla barra multifunzione, selezionare ADLS Gen2 come output per il processo di analisi di flusso. Selezionare quindi il contenitore in cui si vuole inviare l'output del processo. Per altre informazioni sull'output di Azure Data Lake Gen2 per un processo di analisi di flusso, vedere Archiviazione BLOB e output di Azure Data Lake Gen2 da Analisi di flusso di Azure.

Quando ci si connette ad Azure Data Lake Storage Gen2, selezionando Identità gestita come modalità di autenticazione, all'identità gestita per il processo di analisi di flusso viene concesso il ruolo Collaboratore ai dati dei BLOB di archiviazione. Per maggiori informazioni sulle identità gestite per Azure Data Lake Storage Gen2, vedere Usare le identità gestite per autenticare il processo di Analisi di flusso di Azure in Archiviazione BLOB di Azure.

Le identità gestite annullano le limitazioni dei metodi di autenticazione basati sull'utente. Queste limitazioni includono la necessità di ripetere l'autenticazione a causa delle modifiche apportate alla password o delle scadenze dei token utente che si verificano ogni 90 giorni.

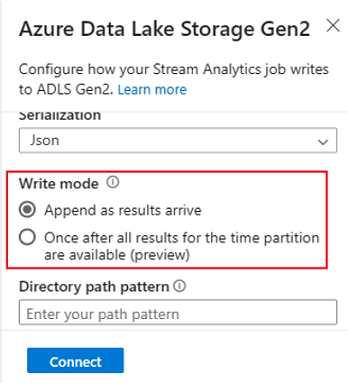

Consegna esattamente una volta (anteprima) è supportato in ADLS Gen2 come output dell'editor senza codice. È possibile abilitarlo nella sezione Modalità di scrittura nella configurazione di ADLS Gen2. Per maggiori informazioni su questa funzionalità, vedere Consegna esattamente una volta (anteprima) in Azure Data Lake Gen2

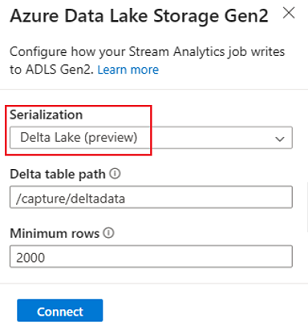

Scrittura nella tabella Delta Lake (anteprima) è supportata in ADLS Gen2 come output dell'editor senza codice. È possibile accedere a questa opzione nella sezione Serializzazione nella configurazione di ADLS Gen2. Per maggiori informazioni su questa funzionalità, vedere Scrivere nella tabella Delta Lake.

Azure Synapse Analytics

I processi di Analisi di flusso di Azure possono inviare output a una tabella del pool SQL dedicata in Azure Synapse Analytics e possono elaborare a una velocità effettiva fino a 200 MB al secondo. Analisi di flusso supporta le esigenze di analisi in tempo reale più impegnative e l'elaborazione dei dati dei percorsi ad accesso frequente per carichi di lavoro come la creazione di report e il dashboard.

Importante

La tabella dedicata del pool SQL deve esistere affinchè si possa aggiungere come output al processo di analisi di flusso. Lo schema della tabella deve corrispondere ai campi e ai relativi tipi nell'output del processo.

Nella sezione Output sulla barra multifunzione, selezionare Synapse come output per il processo di analisi di flusso. Selezionare quindi la tabella del pool SQL in cui si vuole inviare l'output del processo. Per maggiori informazioni sull'output di Azure Synapse per un processo di analisi di flusso, vedere Output di Azure Synapse Analytics da Analisi di flusso di Azure.

Azure Cosmos DB

Azure Cosmos DB è un servizio di database distribuito a livello globale che offre scalabilità elastica illimitata in tutto il mondo. Offre anche query avanzate e indicizzazione automatica su modelli di dati indipendenti dallo schema.

Nella sezione Output sulla barra multifunzione, selezionare CosmosDB come output per il processo di analisi di flusso. Per maggiori informazioni sull'output di Azure Cosmos DB per un processo di analisi di flusso, vedere Output di Azure Cosmos DB da Analisi di flusso di Azure.

Quando ci si connette ad Azure Cosmos DB, se si seleziona Identità gestita come modalità di autenticazione, il ruolo Collaboratore verrà concesso all'identità gestita per il processo di analisi di flusso. Per altremaggiori informazioni sulle identità gestite per Azure Cosmos DB, vedere Usare le identità gestite per accedere ad Azure Cosmos DB da un processo di Analisi di flusso di Azure (anteprima).

Il metodo di autenticazione delle identità gestite è supportato anche nell'output di Azure Cosmos DB nell'editor senza codice che ha lo stesso vantaggio di quello nell'output di ADLS Gen2 precedente.

Database SQL di Azure

Il database SQL di Azure è un motore di database Platform as a Service (PaaS) completamente gestito che permette di creare un livello di archiviazione dati a disponibilità elevata e ad alte prestazioni per le applicazioni e le soluzioni in Azure. Usando l'editor senza codice, è possibile configurare i processi di Analisi di flusso di Azure per scrivere i dati elaborati in una tabella esistente nel database SQL.

Per configurare il database SQL di Azure come output, selezionare Database SQL nella sezione Output sulla barra multifunzione. Compilare quindi le informazioni necessarie per connettere il database SQL e selezionare la tabella in cui scrivere i dati.

Importante

La tabella del database SQL di Azure deve esistere prima che sia possibile aggiungerla come output al processo di analisi di flusso. Lo schema della tabella deve corrispondere ai campi e ai relativi tipi nell'output del processo.

Per maggiori informazioni sull'output del database SQL di Azure per un processo di analisi di flusso, vedere Output del database SQL di Azure da Analisi di flusso di Azure.

Hub eventi di

Con i dati in tempo reale provenienti da ASA, l'editor senza codice può trasformare, arricchire e restituire i dati in un altro hub eventi. È possibile scegliere l'output Hub eventi quando si configura il processo di Analisi di flusso di Azure.

Per configurare Hub eventi come output, selezionare Hub eventi nella sezione Output della barra multifunzione. Immettere quindi le informazioni necessarie per connettere l'hub eventi in cui si vogliono scrivere i dati.

Per maggiori informazioni sull'output di Hub eventi per un processo di analisi di flusso, vedere Output di Hub eventi da Analisi di flusso di Azure.

Esplora dati di Azure

Esplora dati di Azure è una piattaforma di analisi dei Big Data completamente gestita e ad alte prestazioni che semplifica l'analisi di grandi volumi di dati. È possibile usare Esplora dati di Azure come output per il processo di Analisi di flusso di Azure anche usando l'editor senza codice.

Per configurare Esplora dati di Azure come output, selezionare Esplora dati di Azure nella sezione Output sulla barra multifunzione. Immettere quindi le informazioni necessarie per connettere il database di Esplora dati di Azure e specificare la tabella in cui scrivere i dati.

Importante

La tabella deve esistere nel database selezionato e lo schema della tabella deve corrispondere esattamente ai campi e ai relativi tipi nell'output del processo.

Per maggiori informazioni sull'output di Esplora dati di Azure per un processo di analisi di flusso, vedere Output di Esplora dati di Azure da Analisi di flusso di Azure (anteprima).

Power BI

Power BI offre un'esperienza di visualizzazione completa per il risultato dell'analisi dei dati. Con l'output di Power BI in Analisi di flusso, i dati di streaming elaborati vengono scritti nel set di dati di streaming di Power BI, e possono poi essere usati per compilare il dashboard di Power BI near real-time. Per altre informazioni su come creare il dashboard near real-time, vedere Creare un dashboard in tempo reale con il set di dati di Power BI prodotto dall’editor senza codice dell’Analisi di flusso.

Per configurare Power BI come output, selezionare Power BI nella sezione Output della barra multifunzione. Compilare quindi le informazioni necessarie per connettere l'area di lavoro di Power BI e specificare i nomi per il set di dati di streaming e la tabella in cui si vogliono scrivere i dati. Per maggiori informazioni sui dettagli di ogni campo, vedere Output di Power BI da Analisi di flusso di Azure.

Anteprima dei dati, creazione di errori, log di runtime e metriche

L'esperienza di trascinamento della selezione senza codice offre strumenti che consentono di creare, risolvere i problemi e valutare le prestazioni della pipeline di analisi per i dati di streaming.

Anteprima dei dati in tempo reale per gli input

Quando ci si connette a un'origine di input, ad esempio hub eventi, e si seleziona il relativo riquadro nella visualizzazione diagramma (scheda Anteprima dati), si otterrà un'anteprima in tempo reale dei dati in arrivo se sono soddisfatte tutte le condizioni seguenti:

- Viene eseguito il push dei dati.

- L'input è configurato correttamente.

- Sono stati aggiunti campi.

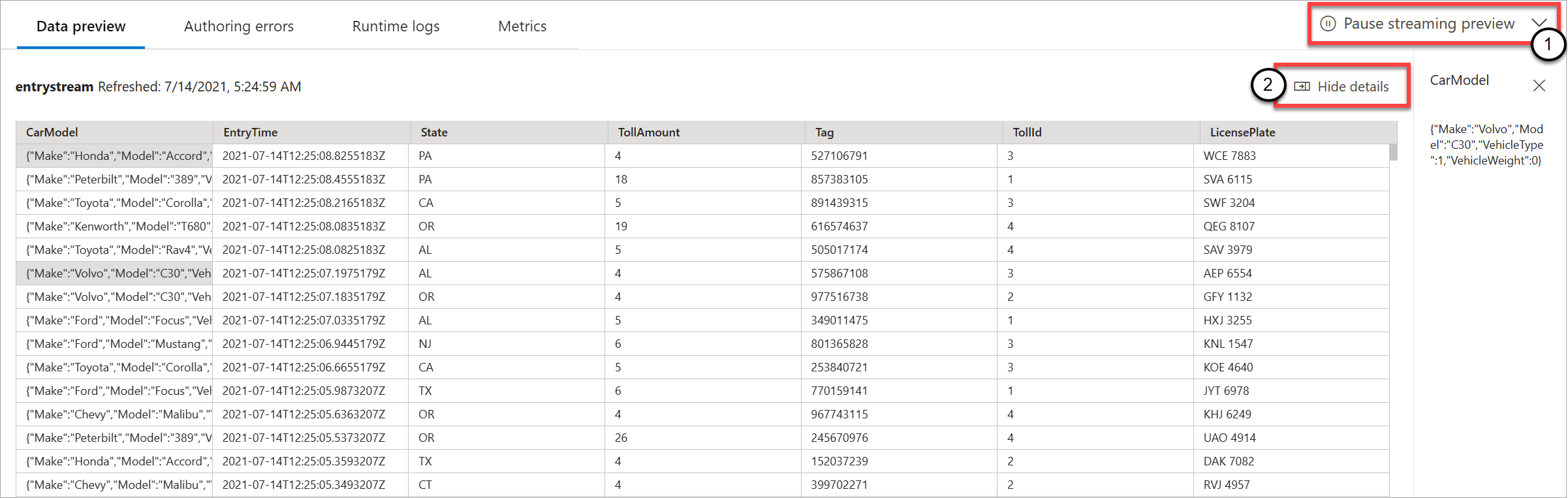

Come illustrato nello screenshot seguente, se si vuole visualizzare o eseguire il drill-down in un elemento specifico, è possibile sospendere l'anteprima (1). Oppure si può farlo ripartire dall’inizio, al termine.

È anche possibile visualizzare i dettagli di un record specifico, una cella nella tabella, selezionandola e quindi selezionando Mostra/Nascondi dettagli (2). Lo screenshot mostra la visualizzazione dettagliata di un oggetto annidato in un record.

Anteprima statica per trasformazioni e output

Dopo aver aggiunto e configurato tutti i passaggi nella visualizzazione diagramma, è possibile testarne il comportamento selezionando Ottieni anteprima statica.

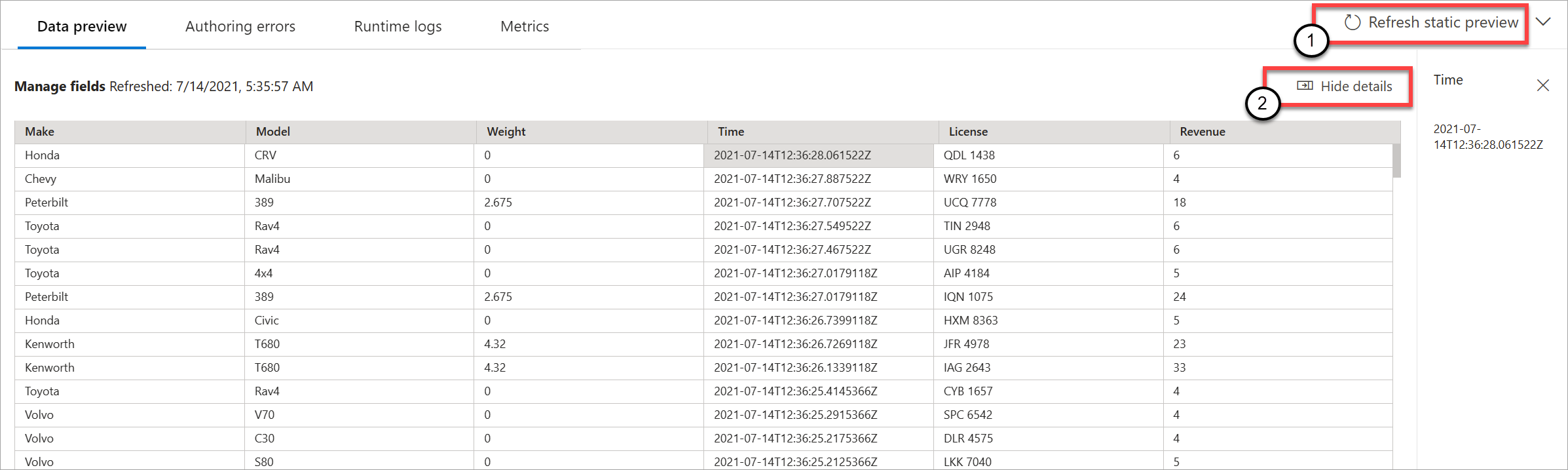

Al termine, il processo di analisi di flusso valuta tutte le trasformazioni e gli output per assicurarsi che siano configurati correttamente. Analisi di flusso visualizza quindi i risultati nell'anteprima dei dati statici, come illustrato nell'immagine seguente.

È possibile aggiornare l'anteprima selezionando Aggiorna anteprima statica (1). Quando si aggiorna l'anteprima, il processo di analisi di flusso accetta nuovi dati dall'input e valuta tutte le trasformazioni. In seguito, invia nuovamente l'output con tutti gli aggiornamenti che potrebbero essere stati eseguiti. L'opzione Mostra/Nascondi dettagli è disponibile anche (2).

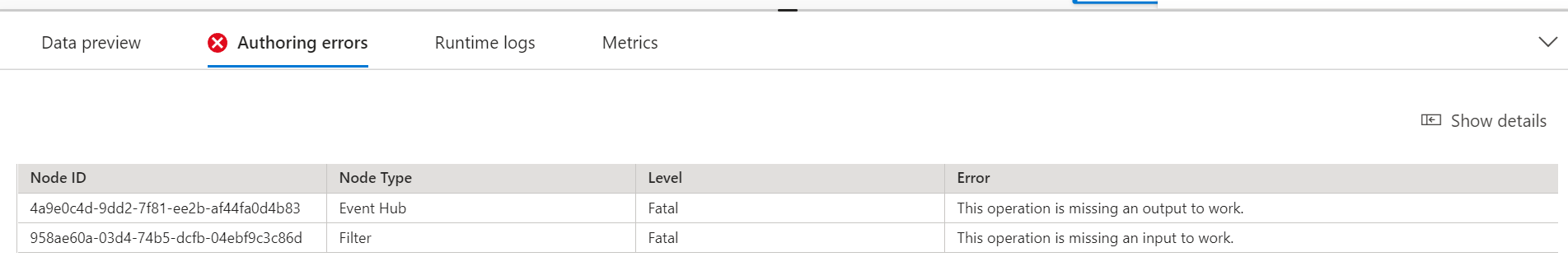

Errori di creazione

Se sono presenti errori o avvisi di creazione, questi verranno elencati nella scheda Errori di creazione, come illustrato nello screenshot seguente. L'elenco include informazioni dettagliate sull'errore o l'avviso, il tipo di scheda (input, trasformazione o output), il livello di errore e una descrizione dell'errore o avviso.

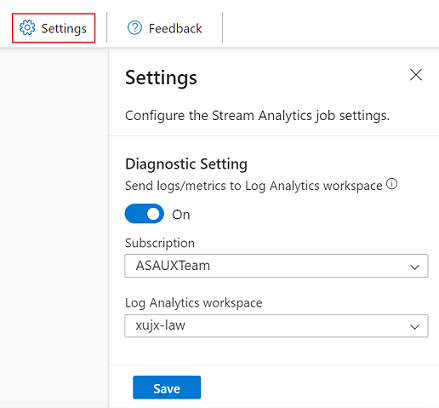

Log di runtime

I log di runtime vengono visualizzati a livello di avviso, errore o informazioni quando un processo è in esecuzione. Questi log sono utili quando si vuole modificare la topologia o la configurazione del processo di analisi di flusso per la risoluzione dei problemi. È consigliabile attivare i log di diagnostica e inviarli all'area di lavoro Log Analytics in Impostazioni per ottenere altre informazioni dettagliate sui processi in esecuzione per il debug.

Nell'esempio di screenshot seguente, l'utente ha configurato l'output del database SQL con uno schema di tabella che non corrisponde ai campi dell'output del processo.

Metrica

Se il processo è in esecuzione, è possibile monitorare l'integrità del processo nella scheda Metriche. Le quattro metriche visualizzate per impostazione predefinita sono Ritardo filigrana, Eventi di input, Eventi di input registrati e Eventi di output. È possibile usare queste metriche per capire se gli eventi vengono trasmessi all'interno e all'esterno del processo senza alcun backlog di input.

È possibile selezionare più metriche dall'elenco. Per comprendere in dettaglio tutte le metriche, vedere Metriche dei processi di Analisi di flusso di Azure.

Avviare un processo di Analisi di flusso

È possibile salvare il processo in qualsiasi momento durante la creazione. Dopo aver configurato gli input, le trasformazioni e gli output di streaming per il processo, è possibile avviare il processo.

Nota

Anche se l'editor senza codice nel portale di Analisi di flusso di Azure è in anteprima, il servizio Analisi di flusso di Azure è disponibile a livello generale.

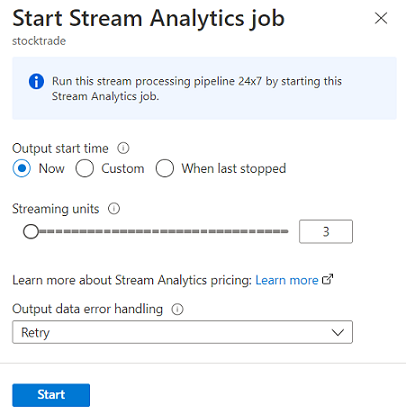

È possibile configurare queste opzioni:

- Ora di inizio dell'output: quando si avvia un processo, si seleziona un'ora in cui il processo inizia a creare l'output.

- Adesso: questa opzione rende il punto iniziale del flusso di eventi di output uguale a quello dell'avvio del processo.

- Personalizzato: è possibile scegliere il punto iniziale dell'output.

- Ultimo arresto: questa opzione è disponibile quando il processo è stato avviato in precedenza ma è stato arrestato manualmente o non è riuscito. Quando si sceglie questa opzione, per riavviare il processo verrà usata l'ora dell'ultimo output, così i dati non vengono persi.

- Unità di streaming: le Unità di streaming (SU) rappresentano la quantità di calcolo e memoria assegnata al processo durante la sua esecuzione. Se non si sa quante SU scegliere, è consigliabile iniziare con tre e regolare in base alle esigenze.

- Gestione degli errori dei dati di output: i criteri per la gestione degli errori dei dati di output si applicano solo quando l'evento di output prodotto da un processo di analisi di flusso non è conforme allo schema del sink di destinazione. È possibile configurare questo criterio scegliendo tra Riprova oppure Rilascia. Per maggiori informazioni, vedere Criteri di errore di output di Analisi di flusso di Azure.

- Avvio: questo pulsante avvia il processo di analisi di flusso.

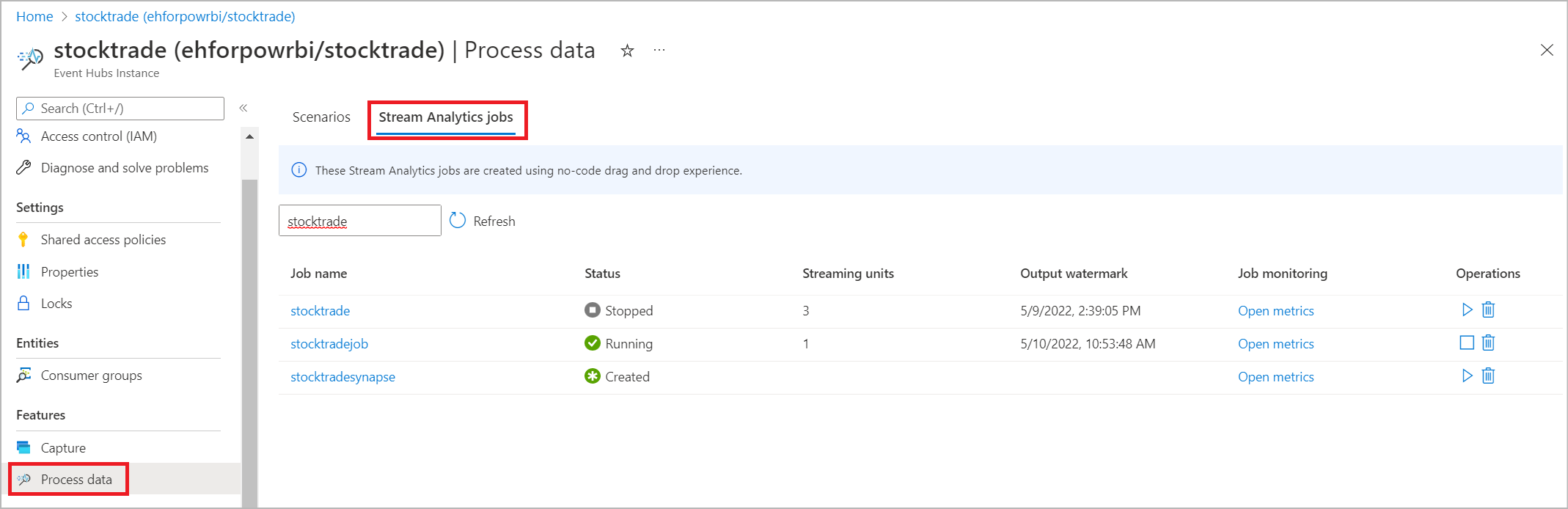

Elenco dei processi di analisi di flusso nel portale di Hub eventi di Azure

Per visualizzare un elenco di tutti i processi dianalisi di flusso che sono stati creati usando l'esperienza di trascinamento senza codice nel portale di Hub eventi di Azure, selezionareElabora dati>processi di analisi di flusso.

Questi sono gli elementi della scheda Processi di Analisi di flusso:

- Filtro: è possibile filtrare l'elenco per nome del processo.

- Aggiorna: attualmente l'elenco non viene aggiornato automaticamente. Usare il pulsante Aggiorna per aggiornare l'elenco e visualizzare l’ultimo stato.

- Nome processo: il nome in questa area è quello fornito nel primo passaggio della creazione del processo. Non è possibile modificarlo. Selezionare il nome del processo per aprire il processo nell'esperienza di trascinamento senza codice, in cui è possibile arrestare il processo, modificarlo e riavviarlo.

- Stato: quest'area mostra lo stato del processo. Selezionare Aggiornanella parte superiore dell'elenco per visualizzare l’ultimo stato.

- Unità di streaming: questa area mostra il numero di unità di streaming selezionate al momento dell'avvio del processo.

- Filigrana di output: questa area fornisce un indicatore di vivacità per i dati prodotti dal processo. Tutti gli eventi prima dell’indicatore orario sono già calcolati.

- Monitoraggio dei processi: selezionare Apri metriche per visualizzare le metriche correlate a questo processo di Analisi di flusso. Per maggiori informazioni sulle metriche che è possibile usare per monitorare il processo di Analisi di flusso, vedere Metriche dei processi di Analisi di flusso di Azure.

- Operazioni: avviare, arrestare o eliminare il processo.

Passaggi successivi

Informazioni su come usare l'editor senza codice per gestire scenari comuni usando modelli predefiniti: