Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Si applica a: ✔️ macchine virtuali Linux ✔️ macchine virtuali Windows ✔️ set di scalabilità flessibili ✔️ set di scalabilità uniformi

Un server serie HBv3 dispone di 2 * CPU EPYC 7V73X a 64 core per un totale di 128 core fisici "Zen3" con AMD 3D V-Cache. Il multithreading simultaneo (SMT) è disabilitato in HBv3. Questi 128 core sono suddivisi in 16 sezioni (8 per socket), ognuna delle quali contiene 8 core di processore con accesso uniforme a una cache L3 da 96 MB. I server Azure HBv3 eseguono anche le impostazioni del BIOS AMD seguenti:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

Di conseguenza, il server viene avviato con 4 domini NUMA (2 per socket). Ogni dominio ha dimensioni pari a 32 core. Ogni NUMA ha accesso diretto a 4 canali di DRAM fisica che operano a 3.200 MT/s.

Per fornire spazio all'hypervisor Azure affinché operi senza interferire con la macchina virtuale, vengono riservati 8 core fisici per server.

Topologia della macchina virtuale

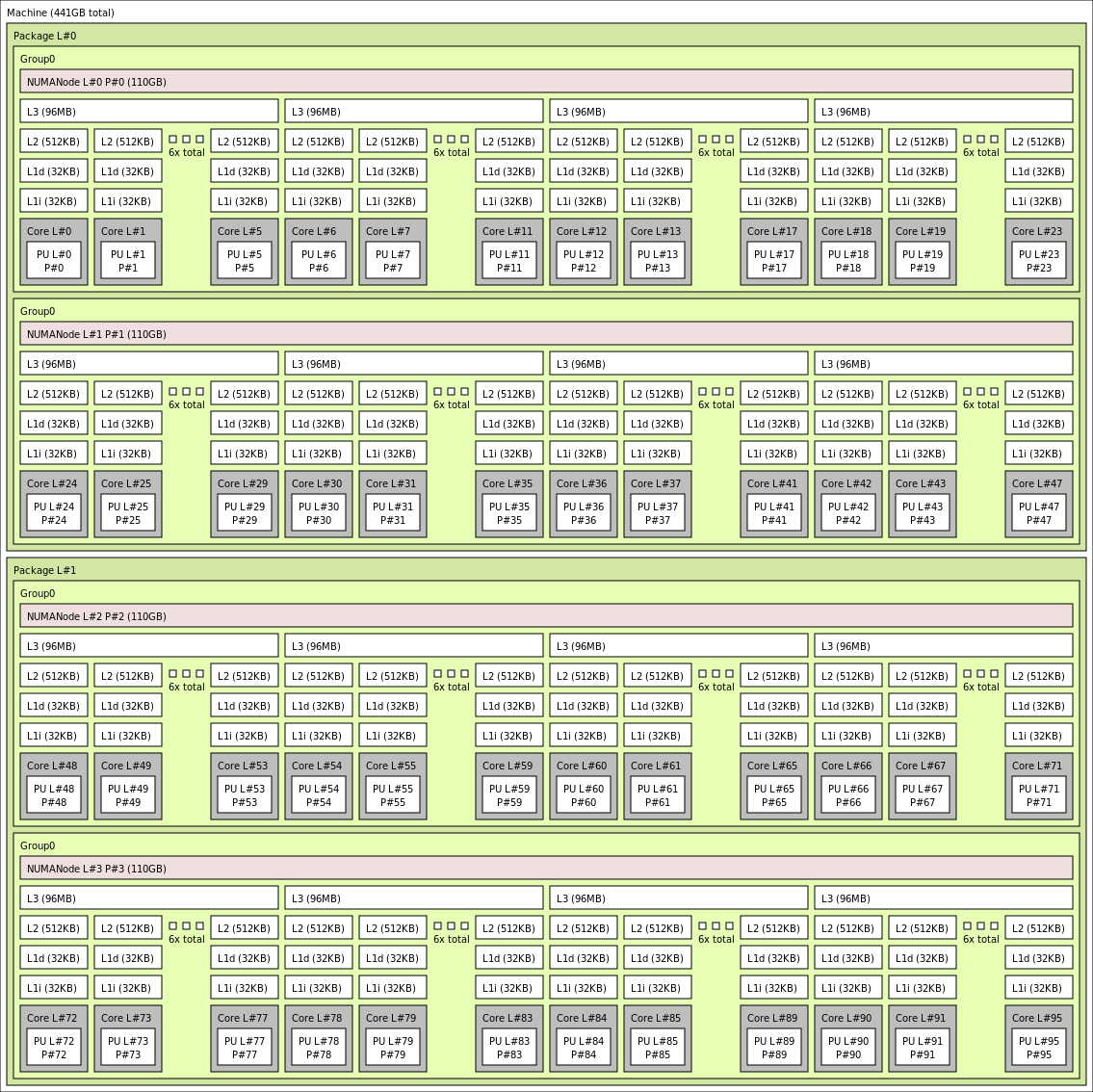

Il diagramma seguente illustra la topologia del server. Questi 8 core dell’host hypervisor (giallo) vengono riservati simmetricamente in entrambi i socket della CPU, prendendo i primi 2 core da specifici Core Complex Dies (CCD) in ogni dominio NUMA, mentre i core rimanenti sono destinati alla macchina virtuale serie HBv3 (verde).

Il limite CCD non è equivalente a un limite NUMA. In HBv3, un gruppo di quattro CCD consecutivi (4) è configurato come dominio NUMA, sia a livello di server host che all'interno di una macchina virtuale guest. Di conseguenza, tutte le dimensioni delle macchine virtuali HBv3 espongono 4 domini NUMA visualizzati dal sistema operativo e dall’applicazione, come illustrato. 4 domini NUMA uniformi, ognuno con un numero di core diverso a seconda delle specifiche dimensioni della macchina virtuale HBv3.

Ogni dimensione della macchina virtuale HBv3 è simile per layout fisico, funzionalità e prestazioni a una CPU della serie AMD EPYC 7003 diversa, come indicato di seguito:

| Dimensioni della macchina virtuale serie HBv3 | Domini NUMA | Core per dominio NUMA | Similarità con AMD EPYC |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | Dual-socket EPYC 7773X |

| Standard_HB120-96rs_v3 | 4 | 24 | Dual-socket EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | Dual-socket EPYC 7573X |

| Standard_HB120-32rs_v3 | 4 | 8 | Dual-socket EPYC 7373X |

| Standard_HB120-16rs_v3 | 4 | 4 | Dual-socket EPYC 72F3 |

Nota

Le dimensioni delle macchine virtuali con core vincolati riducono solo il numero di core fisici esposti alla macchina virtuale. Tutti gli asset condivisi globali (RAM, larghezza di banda della memoria, cache L3, connettività GMI e xGMI, InfiniBand, rete Ethernet di Azure, unità SSD locale) rimangono costanti. Ciò consente al cliente di scegliere le dimensioni della macchina virtuale più adatte a un determinato set del carico di lavoro o alle esigenze di licenza del software.

Il mapping NUMA virtuale di ogni dimensione della macchina virtuale HBv3 viene mappato in base alla topologia NUMA fisica sottostante. Non esiste un'astrazione potenzialmente fuorviante della topologia hardware.

La topologia esatta per le varie dimensioni della macchina virtuale HBv3 viene visualizzata come segue usando l'output di lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Fare clic per visualizzare l'output di lstopo per Standard_HB120rs_v3

Fare clic per visualizzare l'output di lstopo per Standard_HB120rs-96_v3

Fare clic per visualizzare l'output di lstopo per Standard_HB120rs-64_v3

Fare clic per visualizzare l'output di lstopo per Standard_HB120rs-32_v3

Fare clic per visualizzare l'output di lstopo per Standard_HB120rs-16_v3

Rete InfiniBand

Le macchine virtuali HBv3 dispongono inoltre di adattatori di rete Nvidia Mellanox HDR InfiniBand (ConnectX-6) che operano fino a 200 Gigabit/sec. La scheda di interfaccia di rete viene passata alla macchina virtuale tramite SRIOV, consentendo al traffico di rete di ignorare l'hypervisor. Di conseguenza, i clienti caricano driver OFED standard di Mellanox nelle macchine virtuali HBv3 come farebbero in un ambiente bare metal.

Le macchine virtuali HBv3 supportano il routing adattivo, il trasporto connesso dinamico (DCT, insieme ai trasporti standard RC e UD) e l'offload basato su hardware dei collettivi MPI al processore di bordo dell'adattatore ConnectX-6. Queste funzionalità migliorano le prestazioni, la scalabilità e la coerenza dell'applicazione e se ne consiglia l'uso.

Archiviazione temporanea

Le macchine virtuali HBv3 dispongono di 3 dispositivi SSD locali fisici. Uno dei dispositivi viene preformattato per fungere da file di pagina e visualizzato all'interno della macchina virtuale come dispositivo generico "SSD".

Altre due unità SSD di dimensioni maggiori vengono fornite come dispositivi NVMe a blocchi non formattati tramite NVMeDirect. Poiché il dispositivo NVMe a blocchi ignora l'hypervisor, ha una larghezza di banda maggiore, operazioni di I/O al secondo più elevate e una latenza inferiore per IOP.

Se abbinato in una matrice con striping, l'unità SSD NVMe fornisce fino a 7 GB/s in lettura e 3 GB/s in scrittura e fino a 186.000 operazioni di I/O al secondo (letture) e 201.000 operazioni di I/O al secondo (scritture) per profondità di coda profonde.

Specifiche hardware

| Specifiche hardware | Macchine virtuali serie HBv3 |

|---|---|

| Core | 120, 96, 64, 32 o 16 (SMT disabilitato) |

| CPU | AMD EPYC 7V73X |

| Frequenza CPU (non AVX) | 3,0 GHz (tutti i core), 3,5 GHz (fino a 10 core) |

| Memoria | 448 GB (la RAM per core dipende dalle dimensioni della macchina virtuale) |

| Disco locale | 2 * 960 GB NVMe (blocco), SSD da 480 GB (file di pagina) |

| Infiniband | InfiniBand da 200 Gb/s Mellanox ConnectX-6 HDR |

| Rete | Ethernet 50 Gb (utilizzabile 40 Gb/s) SmartNIC di seconda generazione di Azure |

Specifiche software

| Specifiche software | Macchine virtuali serie HBv3 |

|---|---|

| Dimensioni massime processo MPI | 36.000 core (300 macchine virtuali in un singolo set di scalabilità di macchine virtuali con singlePlacementGroup=true) |

| Supporto MPI | HPC-X, Intel MPI, OpenMPI, MVAPICH2, MPICH |

| Framework aggiuntivi | UCX, libfabric, PGAS |

| Supporto di Archiviazione di Azure | Dischi Standard e Premium (massimo 32 dischi) |

| Supporto del sistema operativo per SRIOV RDMA | RHEL 7.9+, Ubuntu 18.04+, SLES 15.4, WinServer 2016+ |

| Sistema operativo consigliato per le prestazioni | Windows Server 2019+ |

| Supporto di Orchestrator | Azure CycleCloud, Azure Batch, servizio Azure Kubernetes; opzioni di configurazione del cluster |

Nota

Windows Server 2012 R2 non è supportato in HBv3 e in altre macchine virtuali con più di 64 core (virtuali o fisici). Per altri dettagli, vedere Sistemi operativi guest Windows supportati per Hyper-V in Windows Server.

Importante

Questo documento fa riferimento a una versione di Linux prossima o alla fine del servizio (EOL). Prendere in considerazione l'aggiornamento a una versione più recente.

Passaggi successivi

- Per informazioni sugli annunci più recenti, sugli esempi di carico di lavoro HPC e sui risultati delle prestazioni, vedere i Blog della community tecnica di Calcolo di Azure.

- Per un quadro generale sull'architettura per l'esecuzione di carichi di lavoro HPC, vedere HPC (High Performance Computing) in Azure.