Istruzioni di avvio rapido: Studio di Sicurezza dei contenuti di Azure AI

Questo articolo illustra come iniziare a usare il servizio Content Safety di Azure per intelligenza artificiale usando Content Safety Studio nel browser.

Attenzione

Alcuni dei contenuti di esempio forniti da Content Safety Studio potrebbero essere offensivi. Le immagini di esempio sono sfocate per impostazione predefinita. La discrezione dell'utente è consigliata.

Prerequisiti

- Un account Azure. Se non hai un account, puoi crearlo gratuitamente.

- Risorsa di Sicurezza dei contenuti di Azure.

- Assegnare il ruolo utente servizi cognitivi all'account. Passare alla portale di Azure, passare alla risorsa Sicurezza del contenuto o alla risorsa servizi di intelligenza artificiale di Azure e selezionare Controllo di accesso nella barra di spostamento a sinistra, quindi selezionare + Aggiungi assegnazione di ruolo, scegliere il ruolo Utente servizi cognitivi e selezionare il membro dell'account a cui è necessario assegnare questo ruolo, quindi esaminare e assegnare. L'applicazione dell'assegnazione potrebbe richiedere alcuni minuti.

- Accedere a Studio di Sicurezza dei contenuti con la sottoscrizione di Azure e la risorsa Content Safety.

Importante

Per usare l'esperienza di studio, è necessario assegnare il ruolo utente di Servizi cognitivi all'account Azure. Passare alla portale di Azure, passare alla risorsa Sicurezza del contenuto o alla risorsa servizi di intelligenza artificiale di Azure e selezionare Controllo di accesso nella barra di spostamento a sinistra, quindi selezionare + Aggiungi assegnazione di ruolo, scegliere il ruolo Utente servizi cognitivi e selezionare il membro dell'account a cui è necessario assegnare questo ruolo, quindi esaminare e assegnare. L'applicazione dell'assegnazione potrebbe richiedere alcuni minuti.

Analizzare il contenuto di testo

La pagina Contenuto di testo moderato offre la possibilità di provare rapidamente la moderazione del testo.

- Selezionare il pannello Moderare il contenuto di testi.

- Aggiungere del testo nel campo di input, oppure selezionare testo di esempio dai pannelli nella pagina.

Suggerimento

Dimensioni e granularità del testo

Vedere Requisiti di input per le limitazioni massime della lunghezza del testo.

- Selezionare Esegui test.

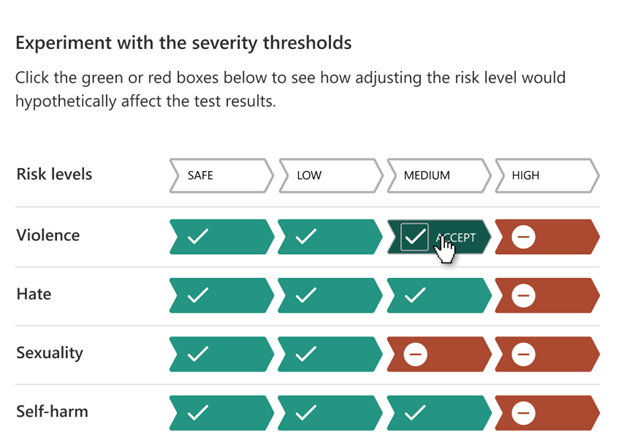

Il servizio restituisce tutte le categorie rilevate, con il livello di gravità per ognuno: 0-Safe, 2-Low, 4-Medium, 6-High. Restituisce anche un risultato Accettato/Rifiutato binario, in base ai filtri configurati. Usare la matrice nella scheda Configura filtri per impostare i livelli di gravità consentiti/non consentiti per ogni categoria. È quindi possibile eseguire di nuovo il testo per vedere il funzionamento del filtro.

La scheda Usa blocklist consente di creare, modificare e aggiungere un elenco di blocchi al flusso di lavoro di moderazione. Se è presente una blocklist abilitata durante l’esecuzione del test, verrà visualizzato un pannello Rilevamento blocklist in Risultati. Segnala eventuali corrispondenze con la blocklist.

Rilevare gli attacchi di input utente

Il pannello Prompt Shields consente di provare il rilevamento dei rischi di input dell'utente. Rilevare le richieste utente progettate per provocare il modello di intelligenza artificiale generativa in comportamenti di cui è stato eseguito il training per evitare o interrompere le regole impostate nel messaggio di sistema. Questi attacchi possono variare da un gioco di ruolo intricato a una velata sovversione dell'obiettivo di sicurezza.

- Selezionare il pannello Prompt Shields.

- Selezionare un testo di esempio nella pagina o immettere il proprio contenuto per il test. È anche possibile caricare un file CSV per eseguire un test batch.

- Selezionare Esegui test.

Il servizio restituisce il flag di rischio e il tipo per ogni esempio.

Per altre informazioni, vedere la guida concettuale Prompt Shields.

Analizzare il contenuto delle immagini

La pagina Contenuto di immagine moderato offre la possibilità di provare rapidamente la moderazione dell’immagine.

- Selezionare il pannello Moderare il contenuto di immagini.

- Selezionare un'immagine di esempio dai pannelli nella pagina o caricare un’immagine personale. La dimensione massima per gli invii di immagini è di 4 MB e le dimensioni dell'immagine devono essere comprese tra 50 x 50 pixel e 2.048 x 2.048 pixel. Le immagini possono essere in formati JPEG, PNG, GIF, BMP, TIFF o WEBP.

- Selezionare Esegui test.

Il servizio restituisce tutte le categorie rilevate, con il livello di gravità per ognuno: 0-Safe, 2-Low, 4-Medium, 6-High. Restituisce anche un risultato Accettato/Rifiutato binario, in base ai filtri configurati. Usare la matrice nella scheda Configura filtri sulla destra per impostare i livelli di gravità consentiti/non consentiti per ogni categoria. È quindi possibile eseguire di nuovo il testo per vedere il funzionamento del filtro.

Visualizzare ed esportare codice

È possibile usare la funzionalità Visualizza codice nelle pagine Analizza contenuto di testo o Analizza contenuto immagine per visualizzare e copiare il codice di esempio, che include la configurazione per le funzioni di filtro della gravità, elenchi di blocchi e moderazione. È quindi possibile distribuire il codice dal proprio lato.

Monitorare l'attività online

Il pannello Monitoraggio attività online consente di visualizzare l'utilizzo e le tendenze dell'API.

È possibile scegliere il tipo di supporto da monitorare. È anche possibile specificare l'intervallo di tempo che si desidera controllare selezionando Mostra dati per l'ultimo/gli ultimi __.

Nel grafico Rifiuta frequenza in base categoria è anche possibile modificare le soglie di gravità per ogni categoria.

È anche possibile modificare le blocklisti se si desidera modificare alcuni termini, in base al grafico dei primi 10 termini bloccati.

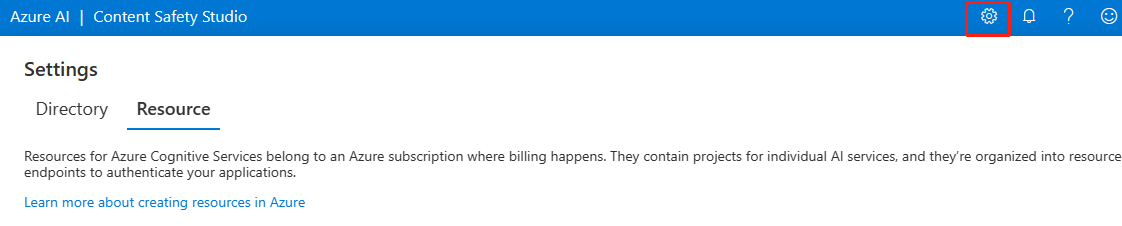

Gestire la risorsa

Per visualizzare i dettagli delle risorse, ad esempio nome e piano tariffario, selezionare l'icona Impostazioni nell'angolo in alto a destra della home page di Studio di Sicurezza dei contenuti e selezionare la scheda Risorsa. Se si hanno altre risorse, è anche possibile cambiare risorsa qui.

Pulire le risorse

Se si desidera pulire e rimuovere una risorsa a Servizi di Azure AI, è possibile eliminare la risorsa o il gruppo di risorse. L'eliminazione del gruppo di risorse comporta anche l'eliminazione di tutte le altre risorse associate.

Passaggio successivo

Successivamente, iniziare a usare Sicurezza dei contenuti di Azure AI tramite le API REST o un SDK client, in modo da poter integrare facilmente il servizio nell'applicazione.