Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

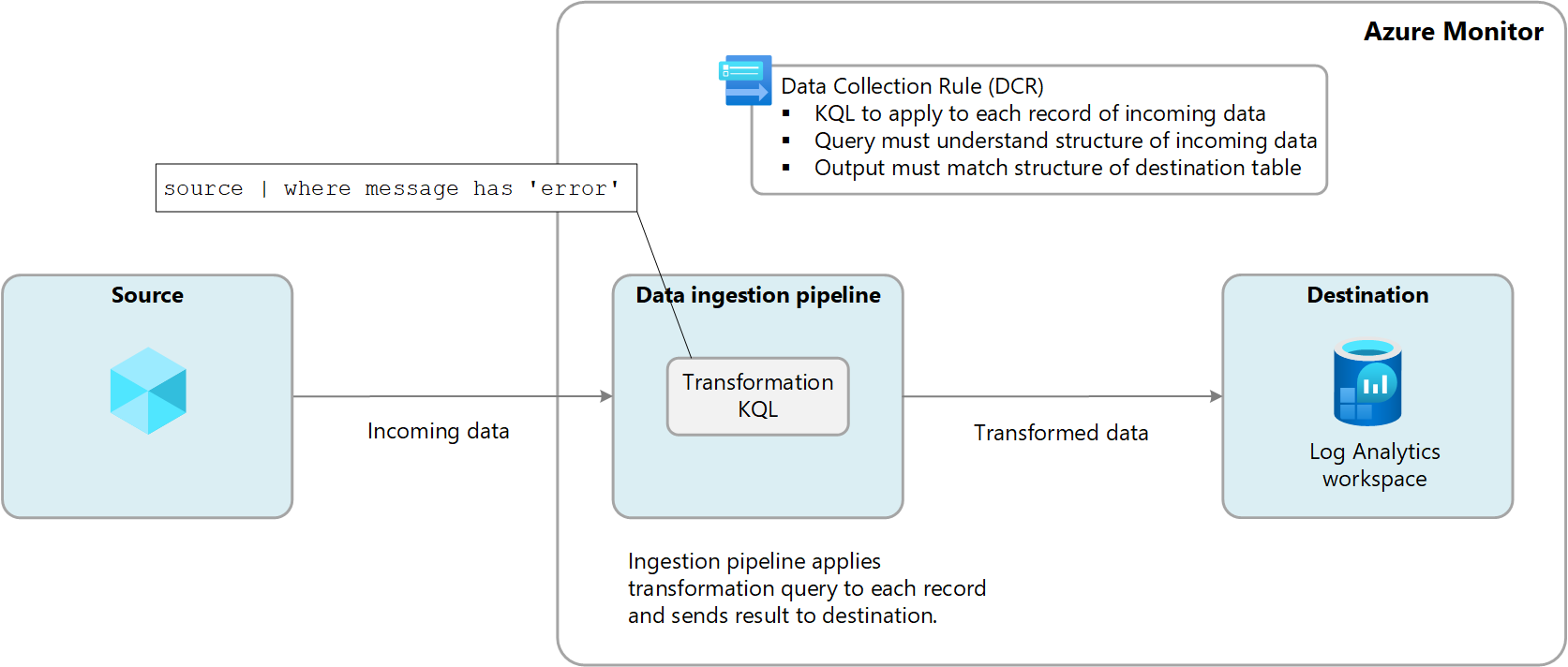

Le trasformazioni in Monitoraggio di Azure consentono di filtrare o modificare i dati in ingresso prima dell'invio a un'area di lavoro Log Analytics. Le trasformazioni vengono eseguite dopo che l'origine dati recapita i dati e prima che vengano inviati alla destinazione. Vengono definiti in una regola di raccolta dati (DCR) e usano un'istruzione del linguaggio di query Kusto (KQL) applicata singolarmente a ciascuna voce dei dati in ingresso.

Il diagramma seguente illustra il processo di trasformazione per i dati in ingresso e mostra una query di esempio che potrebbe essere usata. In questo esempio vengono raccolti solo i record in cui la message colonna contiene la parola error .

Tabelle supportate

Le tabelle seguenti in un'area di lavoro Log Analytics supportano le trasformazioni.

- Qualsiasi tabella di Azure elencata in tabelle che supportano le trasformazioni nei log di Monitoraggio di Azure. È anche possibile usare il riferimento ai dati di Monitoraggio di Azure che elenca gli attributi per ogni tabella, incluso se supporta le trasformazioni.

- Qualsiasi tabella personalizzata creata per l'agente di Monitoraggio di Azure

Creare una trasformazione

Esistono alcuni scenari di raccolta dati che consentono di aggiungere una trasformazione usando il portale di Azure, ma la maggior parte degli scenari richiede la creazione di un nuovo record di dominio usando la relativa definizione JSON o l'aggiunta di una trasformazione a un record di dominio esistente. Vedere Creare una trasformazione in Monitoraggio di Azure per opzioni diverse e procedure consigliate ed esempi di trasformazione in Monitoraggio di Azure per query di esempio applicate a scenari comuni.

DCR di trasformazione dell'area di lavoro

Le trasformazioni vengono definite in una regola di raccolta dati (DCR), ma esistono ancora raccolte di dati in Azure Monitor che non usano ancora una DCR. Ad esempio, i log delle risorse raccolti dalle impostazioni di diagnostica e dai dati dell'applicazione raccolti da Application Insights.

La regola di raccolta dati (DCR) della trasformazione dell'area di lavoro è una DCR speciale applicata direttamente a un'area di lavoro Log Analytics. Lo scopo di questo DCR consiste nell'eseguire trasformazioni sui dati che non utilizzano ancora un DCR per la loro raccolta e quindi non hanno modo di definire una trasformazione.

Per ogni area di lavoro può essere presente una sola DCR; tuttavia, la suddetta può includere trasformazioni per un numero qualsiasi di tabelle supportate. Queste trasformazioni vengono applicate a tutti i dati inviati a queste tabelle, a meno che tali dati non provengano da un'altra DCR.

Ad esempio, la tabella Event viene usata per archiviare gli eventi dalle macchine virtuali Windows. Se si crea una trasformazione per la tabella Eventi nella DCR di trasformazione dell'area di lavoro, la trasformazione verrà applicata agli eventi raccolti dalle macchine virtuali che eseguono l'agente di Log Analytics 1 perché questo agente non usa una DCR. La trasformazione verrebbe ignorata dai dati inviati dall'Agente di Monitoraggio di Azure (AMA) in quanto utilizza una DCR per definire la propria raccolta dei dati. È comunque possibile usare una trasformazione con l'Agente di Monitoraggio di Azure, ma è necessario includerla nella DCR associata all'agente e non a quella di trasformazione dell'area di lavoro.

1 L'agente di Log Analytics è stato deprecato, ma alcuni ambienti potrebbero comunque usarlo. È solo un esempio di una fonte di dati che non utilizza un DCR.

Costo per le trasformazioni

L'elaborazione dei log (trasformazione e filtro) nella pipeline cloud di Monitoraggio di Azure ha implicazioni di fatturazione diverse a seconda del tipo di tabella in cui vengono inseriti i dati in un'area di lavoro Log Analytics.

Log ausiliari

I log di supporto vengono addebitati per i dati elaborati e i dati inseriti in un'area di lavoro Log Analytics. L'addebito per l'elaborazione dei dati si applica a tutti i dati in ingresso ricevuti dalla pipeline cloud di Azure Monitor se la destinazione è una tabella di Log ausiliari in un'area di lavoro di Log Analytics. L'addebito per l'inserimento dati si applica solo ai dati dopo la trasformazione, che vengono inseriti come tabella di log ausiliari in un'area di lavoro di Log Analytics. Le trasformazioni possono aumentare le dimensioni dei dati.

Le tabelle seguenti illustrano alcuni esempi:

| Dimensioni dei dati in ingresso | Dati eliminati o aggiunti dalla trasformazione | Dati acquisiti in uno spazio di lavoro di Log Analytics come tabella di log ausiliari | GB fatturabili per l'elaborazione dei dati | GB fatturabili per l'inserimento dati |

|---|---|---|---|---|

| 20 GB | 12 GB eliminati | 8 GB | 20 GB | 8 GB |

| 20 GB | 8 GB eliminati | 12 GB | 20 GB | 12 GB |

| 20 GB | 4 GB aggiunti | 24 GB | 20 GB | 24 GB |

Vedere Prezzi di Monitoraggio di Azure per i prezzi per l'elaborazione dei log e l'inserimento dei dati di log.

Log analitici o di base

Per l'analisi o i log di base, le trasformazioni in genere non comportano costi, ma gli scenari seguenti possono comportare costi aggiuntivi:

- Se una trasformazione aumenta le dimensioni dei dati in ingresso, ad esempio aggiungendo una colonna calcolata, viene addebitata la tariffa di inserimento standard per i dati aggiuntivi.

- Se una trasformazione riduce i dati inseriti di oltre il 50%, verrà addebitato l'importo dei dati filtrati superiore al 50%.

Per calcolare l'addebito per l'elaborazione dati risultante dalle trasformazioni, usare la formula seguente:

[GB dati scartati dalla trasformazione] - ([GB dati in ingresso] / 2).

Nella tabella seguente sono illustrati alcuni esempi.

| Dimensioni dei dati in ingresso | Dati eliminati o aggiunti dalla trasformazione | Dati inseriti in un'area di lavoro di Log Analytics come tabella di analisi o log di base | GB fatturabili per l'elaborazione dei dati | GB fatturabili per l'inserimento dati |

|---|---|---|---|---|

| 20 GB | 12 GB eliminati | 8 GB | 2GB | 8 GB |

| 20 GB | 8 GB eliminati | 12 GB | 0 GB | 12 GB |

| 20 GB | 4 GB aggiunti | 24 GB | 0 GB | 24 GB |

Per evitare questo addebito, è consigliabile filtrare i dati inseriti usando metodi alternativi prima di applicare trasformazioni. In questo modo, è possibile ridurre la quantità di dati elaborati dalle trasformazioni e, di conseguenza, ridurre al minimo eventuali costi aggiuntivi.

Vedere Prezzi di Monitoraggio di Azure per i prezzi per l'elaborazione dei log e l'inserimento dei dati di log.

Importante

Se Microsoft Sentinel è abilitato per l'area di lavoro Log Analytics, non è previsto alcun costo per la trasformazione nelle tabelle di Analytics indipendentemente dalla quantità di dati filtrata dai filtri di trasformazione.