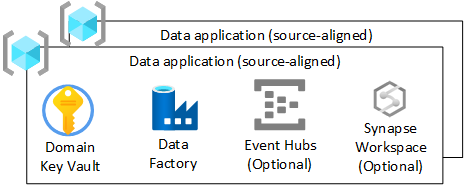

Applicazioni dati (allineate all'origine)

Se si è scelto di non implementare un motore agnostico dei dati per l'inserimento di dati una volta dalle origini operative o se le connessioni complesse non sono semplificate nel motore agnostico dei dati, è necessario creare un'applicazione dati allineata all'origine. Deve seguire lo stesso flusso di un motore di dati agnostico quando si inseriscono dati da origini dati esterne.

Panoramica

Il gruppo di risorse dell'applicazione è responsabile dell'inserimento e dell'arricchimento dei dati solo da origini esterne, ad esempio dati di telemetria, finanza o CRM. Questo livello può funzionare in tempo reale, batch e micro-batch.

Questa sezione illustra l'infrastruttura distribuita per ogni gruppo di risorse (allineato all'origine) all'interno della zona di destinazione dei dati.

Suggerimento

Per la mesh dei dati, è possibile scegliere di distribuire una di queste per origine o una per dominio. I principi di standardizzazione dei dati, qualità dei dati e derivazione dei dati devono comunque essere seguiti. I team operativi della piattaforma dati possono sviluppare frammenti di codice standard e chiamarli per ottenere questo risultato.

Per ogni gruppo di risorse dell'applicazione dati (allineato all'origine) nella zona di destinazione dei dati, è necessario creare:

- Un Key Vault di Azure

- Un Azure Data Factory, per eseguire pipeline di ingegneria sviluppate che trasformano i dati da non elaborati a arricchiti

- Entità servizio usata dall'applicazione dati (allineata all'origine) per la distribuzione di processi di inserimento in Azure Databricks (solo se si usa Azure Databricks)

È anche possibile creare istanze di altri servizi, ad esempio Hub eventi di Azure, hub IoT di Azure, Analisi di flusso di Azure e Azure Machine Learning.

Nota

È necessario usare un motore spark come Azure Synapse Spark o Azure Databricks per applicare lo standard delta lake.

Se si decide di usare Azure Databricks, è consigliabile distribuire Azure Data Factory anziché Azure Synapse'area di lavoro Analisi per ridurre l'area di superficie solo alle funzionalità necessarie.

Tuttavia, se è necessaria un'area di sviluppo all-includente con pipeline e spark, usare Azure Synapse Analytics. Applicare un criterio per consentire solo l'uso di spark e pipeline in modo da evitare la creazione di silos in un pool SQL di Azure Synapse.

Insieme di credenziali chiave di Azure

Usare la funzionalità di Azure Key Vault per archiviare i segreti in Azure ogni volta che è possibile.

Ogni applicazione dati (allineata all'origine) o un dominio di dati (se mesh) avrà un Key Vault di Azure. In questo modo, la chiave di crittografia, il segreto e la derivazione del certificato soddisfano i requisiti dell'ambiente. Ciò consente una migliore separazione dei compiti amministrativi e riduce anche il rischio di combinare chiavi, integrazioni e segreti di classificazioni diverse.

Tutte le chiavi relative all'applicazione dati (allineate all'origine) devono essere contenute nell'Key Vault di Azure.

Importante

Gli insiemi di credenziali delle chiavi dell'applicazione dati (allineati all'origine) devono seguire il modello con privilegi minimi ed evitare limiti di scalabilità delle transazioni e condivisione privata tra ambienti.

Azure Data Factory

Distribuire un Azure Data Factory per consentire alle pipeline scritte dal team dell'applicazione dati di accettare dati da non elaborati e arricchiti usando pipeline sviluppate. Usare i flussi di dati di mapping per le trasformazioni e interrompere l'uso dell'area di lavoro di Azure Databricks (inserimento) o Azure Synapse Spark per trasformazioni complesse.

È necessario connettersi Azure Data Factory all'istanza devOps del repository dell'applicazione dati (allineato all'origine). Questa connessione consente distribuzioni CI/CD.

Hub eventi

Se l'applicazione dati (allineata all'origine) ha un requisito per trasmettere i dati, è possibile distribuire hub eventi downstream nel gruppo di risorse dell'applicazione dati (allineato all'origine).