Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Importante

Queste istruzioni si applicano ai modelli di accesso ai dati legacy. Databricks consiglia di usare percorsi esterni del catalogo Unity per l'accesso ai dati. ConsultaConnettersi all'archiviazione di oggetti cloud usando il Catalogo Unity.

Questo articolo descrive come gestire le proprietà di accesso ai dati per sql warehouse in un'area di lavoro.

Importante

La modifica di queste impostazioni riavvia tutti i warehouse SQL in esecuzione.

Configurare un'entità servizio

Per configurare l'accesso per i magazzini SQL a un account di archiviazione Azure Data Lake Storage utilizzando i principi di servizio, seguire questi passaggi:

Registrare un'applicazione Microsoft Entra ID (in precedenza Azure Active Directory) e registrare le proprietà seguenti:

- ID applicazione (client): un ID che identifica in modo univoco l'applicazione Microsoft Entra ID.

- ID directory (tenant): Un ID che identifica in modo univoco l'istanza di Microsoft Entra ID (denominata ID directory (tenant) in Azure Databricks).

- Segreto client: valore di un segreto client creato per la registrazione dell'applicazione. L'applicazione userà questa stringa segreta per dimostrare la propria identità.

Nell'account di archiviazione aggiungere un'assegnazione di ruolo per l'applicazione registrata nel passaggio precedente per concedere l'accesso all'account di archiviazione.

Creare un ambito dei segreti supportato da Azure Key Vault o con ambito Databricks, vedere Gestire le ambiti dei segreti e registrare il valore della proprietà nome dell'ambito:

- Nome ambito segreto: il nome dell'ambito segreto creato.

Se si usa Azure Key Vault, creare un segreto in Azure Key Vault usando il segreto client nel campo Valore. Tieni traccia del nome segreto che hai scelto.

- Nome segreto: nome del segreto di Azure Key Vault creato.

Se si usa un ambito supportato da Databricks, creare un nuovo segreto usando l'interfaccia della riga di comando di Databricks e usarlo per archiviare il segreto client ottenuto nel passaggio 1. Mantenere un record della chiave privata immessa in questo passaggio.

- Chiave segreta: La chiave del segreto creato con supporto Databricks.

Nota

Facoltativamente, è possibile creare un segreto aggiuntivo per archiviare l'ID client ottenuto al passaggio 1.

Clicca sul tuo nome utente nella barra superiore dell'area di lavoro e seleziona Impostazioni dall'elenco a discesa.

Fare clic sulla scheda Calcolo .

Fare clic su Gestisci accanto a SQL Warehouse.

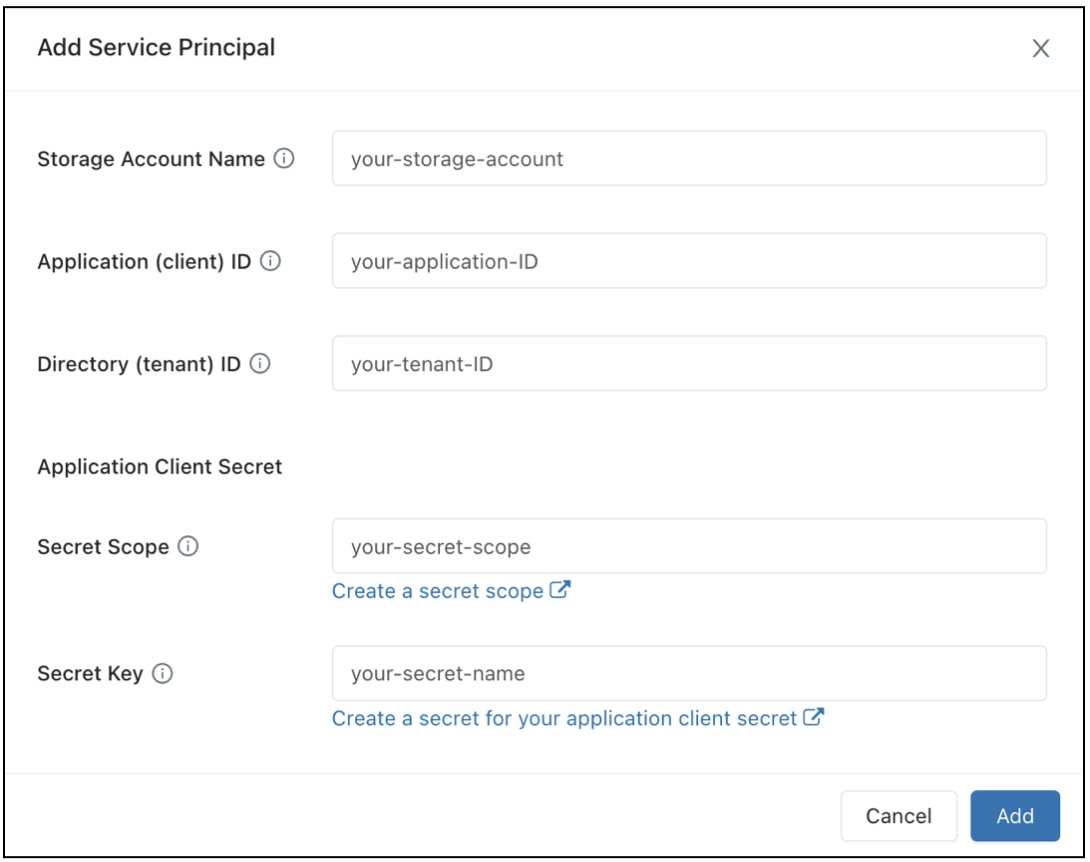

Nel campo Configurazione accesso ai dati, fare clic sul pulsante Aggiungi principale del servizio.

Configurare le proprietà per l'account di archiviazione di Azure Data Lake Storage.

Fare clic su Aggiungi.

Si noterà che le nuove voci sono state aggiunte alla casella di testo Configurazione accesso ai dati.

Fare clic su Salva.

È anche possibile modificare direttamente le voci della casella di testo Configurazione accesso ai dati.

Configurare le proprietà di accesso ai dati per SQL Warehouse

Per configurare tutti i warehouse con le proprietà di accesso ai dati:

Clicca sul tuo nome utente nella barra superiore dell'area di lavoro e seleziona Impostazioni dall'elenco a discesa.

Fare clic sulla scheda Calcolo .

Fare clic su Gestisci accanto a SQL Warehouse.

Nella casella di testo di Configurazione di accesso ai dati, specifica coppie chiave-valore contenenti le proprietà del metastore.

Importante

Per configurare una proprietà in Spark al valore di un segreto senza esporre il valore del segreto a Spark, impostare il valore su

{{secrets/<secret-scope>/<secret-name>}}. Sostituire<secret-scope>con l'ambito del segreto e<secret-name>con il nome del segreto. Il valore deve iniziare con e terminare con{{secrets/}}. Per altre informazioni su questa sintassi, vedere Gestire i segreti.Fare clic su Salva.

È anche possibile configurare le proprietà di accesso ai dati usando il provider Databricks Terraform e databricks_sql_global_config.

Proprietà supportate

Per una voce che termina con

*, sono supportate tutte le proprietà all'interno di tale prefisso.Ad esempio,

spark.sql.hive.metastore.*indica che siaspark.sql.hive.metastore.jarsespark.sql.hive.metastore.versionsono supportate e tutte le altre proprietà che iniziano conspark.sql.hive.metastore.Per le proprietà i cui valori contengono informazioni riservate, è possibile archiviare le informazioni riservate in un segreto e impostare il valore della proprietà sul nome del segreto usando la sintassi seguente:

secrets/<secret-scope>/<secret-name>.

Per i warehouse SQL sono supportate le proprietà seguenti:

spark.sql.hive.metastore.*spark.sql.warehouse.dirspark.hadoop.datanucleus.*spark.hadoop.fs.*spark.hadoop.hive.*spark.hadoop.javax.jdo.option.*spark.hive.*

Per ulteriori informazioni su come impostare queste proprietà, vedere metastore Hive esterno.