Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo descrive il formato predefinito del notebook in Azure Databricks, come modificare il formato del notebook e come gestire i commit di output se il notebook si trova in una cartella controllata dall'origine.

Per impostazione predefinita, i notebook in Databricks vengono creati in formato .ipynb (IPython o Jupyter). È anche possibile scegliere di usare il formato di origine.

È comunque possibile importare ed esportare notebook in vari formati. Vedere Importare ed esportare notebook di Databricks.

Formati di notebook

Databricks supporta la creazione e la modifica di notebook in due formati: IPYNB (impostazione predefinita) e sorgente.

È possibile gestire i file di origine, inclusi i notebook, usando cartelle Git. Solo alcuni tipi di asset Databricks sono supportati nelle cartelle Git. Il formato influisce sulla modalità di commit dei notebook nei repository remoti, come descritto nella tabella seguente.

| Formato sorgente notebook | Descrizione |

|---|---|

| fonte | Formato di base che acquisisce solo il codice sorgente, con un suffisso che segnala il linguaggio di codice, ad esempio .py, .scala, .r e .sql. |

| IPYNB (Jupyter) | Formato avanzato che acquisisce il codice sorgente, l'ambiente notebook, le definizioni di visualizzazione, i widget del notebook e gli output facoltativi. Un notebook IPYNB può contenere codice in qualsiasi linguaggio supportato dai notebook di Databricks (nonostante la parte py di .ipynb). Usando il formato IPYNB, è possibile gestire opzionalmente le versioni dell'output di un notebook insieme al notebook stesso. |

Il formato IPYNB supporta anche un'esperienza di visualizzazione migliore per i notebook di Databricks nei repository Git remoti. Se si usa GitHub o GitLab, è possibile abilitare funzionalità che offrono differenze avanzate dei notebook nei pull requests, semplificando la visualizzazione e le revisioni di codice delle modifiche apportate a un notebook.

Per ulteriori informazioni sul supporto di GitHub per le differenze avanzate dei notebook IPYNB, vedere Feature Preview: Rich Jupyter Notebook Diffs. Per ulteriori informazioni sul supporto offerto da GitLab per le differenze nei file notebook IPYNB, consultare File di Jupyter Notebook.

Per distinguere i notebook in formato di origine dai normali file Python, Scala e SQL, Azure Databricks aggiunge il commento "Databricks notebook source" all'inizio dei notebook Python, Scala e SQL. Questo commento garantisce che Azure Databricks analizzi correttamente il file come notebook anziché come file di script.

Modificare l'impostazione predefinita del formato del notebook

I notebook IPYNB sono il formato predefinito durante la creazione di un nuovo notebook in Azure Databricks.

Per modificare il formato sorgente predefinito di Azure Databricks, accedere all'area di lavoro di Azure Databricks, fare clic sul profilo nell'angolo in alto a destra della pagina, quindi fare clic su Impostazioni e navigare fino a Sviluppatore. Modificare il formato predefinito del notebook sotto il titolo delle impostazioni dell'Editor .

Convertire il formato del notebook

È possibile convertire un notebook esistente in un altro formato tramite l'interfaccia utente di Azure Databricks.

Per convertire un notebook esistente in un altro formato:

Aprire il notebook nell'area di lavoro.

Selezionare File dal menu dell'area di lavoro, selezionare Formato notebook e scegliere il formato desiderato. È possibile scegliere Jupyter (.ipynb) (scelta consigliata) oppure Codice sorgente (.scala, .py, .sql, .r). Il formato corrente del notebook è disattivato e ha un segno di spunta accanto.

Per altre informazioni sui tipi di notebook supportati in Azure Databricks, vedere Importare ed esportare notebook di Databricks.

Gestire i commit di output del notebook IPYNB

Gli output sono i risultati dell'esecuzione di un notebook sulla piattaforma Databricks, inclusi i display delle tabelle e le visualizzazioni. Per i notebook IPYNB nelle cartelle controllate dall'origine, è possibile gestire il commit degli output dei notebook nel repository remoto.

Consenti il commit degli output del notebook di .ipynb

È possibile eseguire il commit degli output solo se un amministratore dell'area di lavoro ha abilitato questa funzionalità. Per impostazione predefinita, l'impostazione amministrativa per le cartelle Git non consente il salvataggio dell'output del notebook. Se si dispone dei privilegi di amministratore per l'area di lavoro, è possibile modificare questa impostazione:

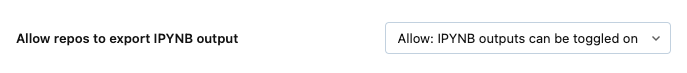

Passare a Impostazioni amministratore,,>,, Impostazioni area di lavoro nella console di amministrazione di Azure Databricks.

In cartelle Git, scegliere Consenti alle cartelle Git di esportare gli output IPYNB e quindi selezionare Consenti: gli output IPYNB possono essere attivati o disattivati.

Importante

Quando gli output sono inclusi, le configurazioni di visualizzazione e dashboard vengono incluse nei notebook.ipynb che crei.

Controllo dei commit degli artefatti di output del notebook IPYNB

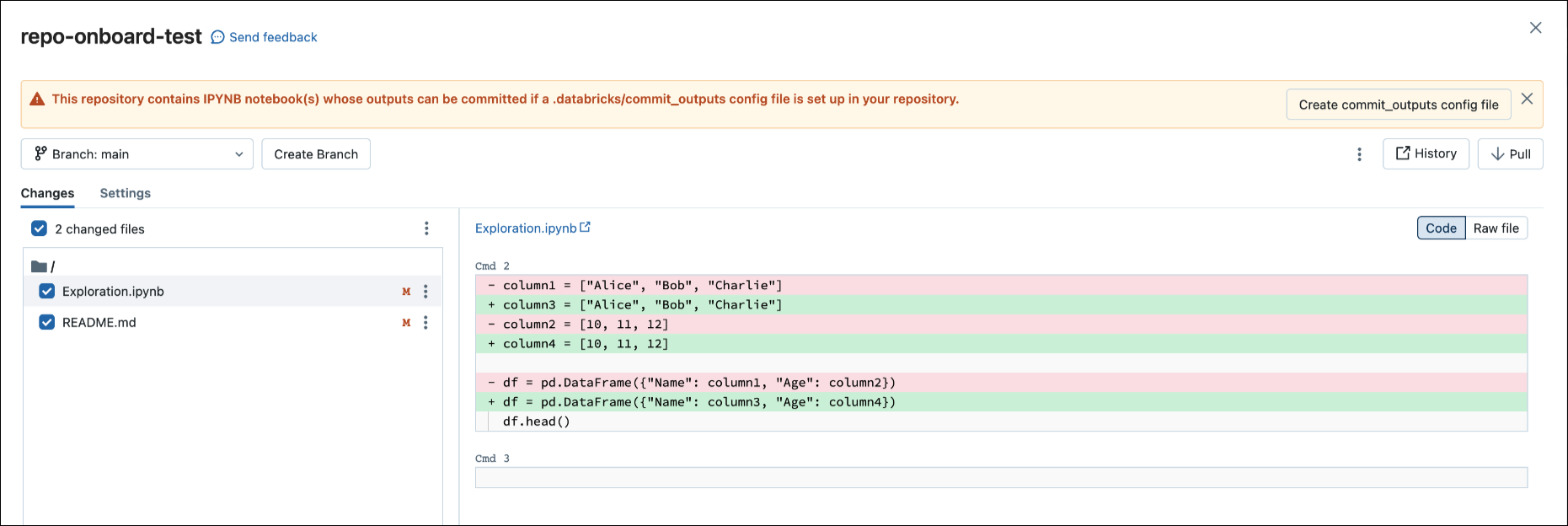

Quando si esegue il commit di un file di .ipynb, Databricks crea un file di configurazione che consente di controllare la modalità di commit degli output: .databricks/commit_outputs.

Se si dispone di un file di notebook

.ipynbma non è presente alcun file di configurazione nel repository remoto, passa alla finestra di dialogo Git Status.Nella finestra di dialogo di notifica selezionare Crea commit_outputs file di configurazione.

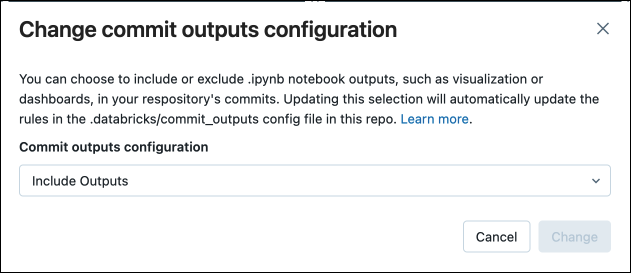

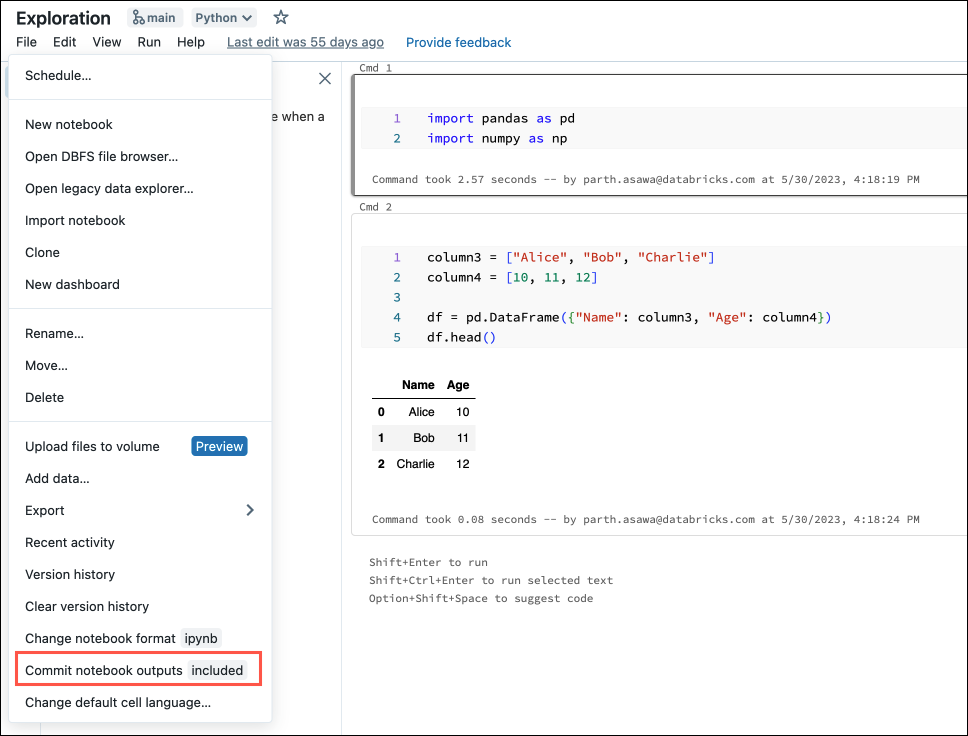

È anche possibile generare file di configurazione dal menu file. Il menu File dispone di un controllo per aggiornare automaticamente il file di configurazione dove puoi specificare l'inclusione o l'esclusione degli output per un notebook IPYNB specifico.

Nel menu File selezionare Commit output dei notebook.

Nella finestra di dialogo confermare la scelta di eseguire il commit degli output del notebook.