Note sulla versione di Azure DevOps Server 2020

Developer Community Requisiti di | licenza dei requisiti | disistema DevOps | | Blog SHA-1 Hashs

In questo articolo sono disponibili informazioni sulla versione più recente per Azure DevOps Server.

Per altre informazioni sull'installazione o l'aggiornamento di una distribuzione di Azure DevOps Server, vedere requisiti di Azure DevOps Server. Per scaricare i prodotti Azure DevOps, visitare la pagina Azure DevOps Server Download.

L'aggiornamento diretto a Azure DevOps Server 2020 è supportato da Azure DevOps Server 2019 o Team Foundation Server 2015 o versione successiva. Se la distribuzione di TFS si trova in TFS 2010 o versioni precedenti, è necessario eseguire alcuni passaggi provvisori prima di eseguire l'aggiornamento a Azure DevOps Server 2019. Per altre informazioni, vedere Installare e configurare Azure DevOps in locale.

Aggiornamento sicuro da Azure DevOps Server 2019 a Azure DevOps Server 2020

Azure DevOps Server 2020 introduce un nuovo modello di conservazione di esecuzione della pipeline (compilazione) che funziona in base alle impostazioni a livello di progetto.

Azure DevOps Server 2020 gestisce la conservazione della compilazione in modo diverso, in base ai criteri di conservazione a livello di pipeline. Alcune configurazioni dei criteri comportano l'eliminazione delle esecuzioni della pipeline dopo l'aggiornamento. Le esecuzioni della pipeline mantenute manualmente o mantenute da una versione non verranno eliminate dopo l'aggiornamento.

Per altre informazioni su come eseguire l'aggiornamento sicuro da Azure DevOps Server 2019 a Azure DevOps Server 2020, leggere il post di blog.

Azure DevOps Server 2020 Update 0.2 Patch 6 Data di rilascio: 14 novembre 2023

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- Estensione dell'elenco di caratteri consentiti per Abilitare la convalida dei parametri degli argomenti delle attività della shell.

Nota

Per implementare le correzioni per questa patch, è necessario seguire una serie di passaggi per aggiornare manualmente le attività.

Installare le patch

Importante

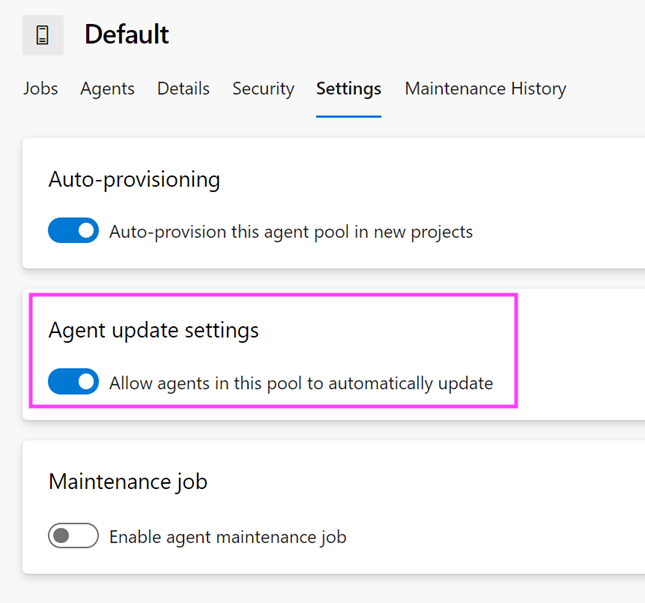

Sono stati rilasciati aggiornamenti all'agente di Azure Pipelines con patch 4 rilasciati il 12 settembre 2023. Se gli aggiornamenti dell'agente non sono stati installati come descritto nelle note sulla versione per patch 4, è consigliabile installare questi aggiornamenti prima di installare patch 6. La nuova versione dell'agente dopo l'installazione della patch 4 sarà 3.225.0.

Configurare TFX

- Seguire la procedura descritta nella documentazione relativa al caricamento delle attività nella raccolta di progetti per installare e accedere con tfx-cli.

Aggiornare le attività con TFX

| File | Hash SHA-256 |

|---|---|

| Tasks20231103.zip | 389BA66EEBC32622FB83402E2E21373CE20AE040F70461B9F9AF9EFCED5034D2E5 |

- Scaricare ed estrarre Tasks20231103.zip.

- Modificare la directory nei file estratti.

- Eseguire i comandi seguenti per caricare le attività:

tfx build tasks upload --task-zip-path AzureFileCopyV1.1.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV2.2.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV3.3.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV4.4.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV5.5.230.0.zip

tfx build tasks upload --task-zip-path BashV3.3.226.2.zip

tfx build tasks upload --task-zip-path BatchScriptV1.1.226.0.zip

tfx build tasks upload --task-zip-path PowerShellV2.2.230.0.zip

tfx build tasks upload --task-zip-path SSHV0.0.226.1.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV1.1.230.0.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV2.2.230.0.zip

Requisiti della pipeline

Per usare il nuovo comportamento, è necessario impostare una variabile AZP_75787_ENABLE_NEW_LOGIC = true nelle pipeline che usano le attività interessate.

In versione classica:

Definire la variabile nella scheda della variabile nella pipeline.

Esempio YAML:

variables:

- name: AZP_75787_ENABLE_NEW_LOGIC

value: true

Azure DevOps Server 2020 Update 0.2 Patch 5 Release Date: 10 ottobre 2023

Importante

Sono stati rilasciati aggiornamenti all'agente di Azure Pipelines con patch 4 rilasciati il 12 settembre 2023. Se gli aggiornamenti dell'agente non sono stati installati come descritto nelle note sulla versione per patch 4, è consigliabile installare questi aggiornamenti prima di installare patch 5. La nuova versione dell'agente dopo l'installazione della patch 4 sarà 3.225.0.

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- Correzione di un bug per cui l'identità "Proprietario analisi" viene visualizzata come Identità inattiva nei computer di aggiornamento delle patch.

Azure DevOps Server 2020 Update 0.2 Patch 4 Data di rilascio: 12 settembre 2023

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- CVE-2023-33136: Azure DevOps Server vulnerabilità di esecuzione del codice remoto.

- CVE-2023-38155: vulnerabilità di elevazione dei privilegi di Azure DevOps Server e Team Foundation Server.

Importante

Distribuire la patch in un ambiente di test e assicurarsi che le pipeline dell'ambiente funzionino come previsto prima di applicare la correzione all'ambiente di produzione.

Nota

Per implementare le correzioni per questa patch, è necessario seguire una serie di passaggi per aggiornare manualmente l'agente e le attività.

Installare le patch

- Scaricare e installare Azure DevOps Server 2020 Update 0.2 patch 4.

Aggiornare l'agente di Azure Pipelines

- Scaricare l'agente da: https://github.com/microsoft/azure-pipelines-agent/releases/tag/v3.225.0 - Agent_20230825.zip

- Usare i passaggi descritti nella documentazione degli agenti Windows self-hosted per distribuire l'agente.

Nota

Il AZP_AGENT_DOWNGRADE_DISABLED deve essere impostato su "true" per impedire il downgrade dell'agente. In Windows è possibile usare il comando seguente in un prompt dei comandi amministrativo, seguito da un riavvio. setx AZP_AGENT_DOWNGRADE_DISABLED true /M

Configurare TFX

- Seguire la procedura descritta nella documentazione relativa al caricamento delle attività nella raccolta di progetti per installare e accedere con tfx-cli.

Aggiornare le attività con TFX

- Scaricare ed estrarre Tasks_20230825.zip.

- Modificare la directory nei file estratti.

- Eseguire i comandi seguenti per caricare le attività:

tfx build tasks upload --task-zip-path AzureFileCopyV1.1.226.3.zip

tfx build tasks upload --task-zip-path AzureFileCopyV2.2.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV3.3.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV4.4.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV5.5.226.2.zip

tfx build tasks upload --task-zip-path BashV3.3.226.2.zip

tfx build tasks upload --task-zip-path BatchScriptV1.1.226.0.zip

tfx build tasks upload --task-zip-path PowerShellV2.2.226.1.zip

tfx build tasks upload --task-zip-path SSHV0.0.226.1.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV1.1.226.2.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV2.2.226.2.zip

Requisiti della pipeline

Per usare il nuovo comportamento, è necessario impostare una variabile AZP_75787_ENABLE_NEW_LOGIC = true nelle pipeline che usano le attività interessate.

In versione classica:

Definire la variabile nella scheda della variabile nella pipeline.

Esempio YAML:

variables:

- name: AZP_75787_ENABLE_NEW_LOGIC

value: true

Azure DevOps Server 2020 Update 0.2 Patch 3 Data di rilascio: 8 agosto 2023

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- Correzione di un bug che interferisce con il push dei pacchetti durante l'aggiornamento da 2018 o versioni precedenti.

Azure DevOps Server 2020 Update 0.2 Patch 2 Data di rilascio: 13 giugno 2023

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- Correzione di un bug che interferisce con il push dei pacchetti durante l'aggiornamento da 2018 o versioni precedenti.

Azure DevOps Server 2020 Update 0.2 Patch 1 Data di rilascio: 18 ottobre 2022

È stata rilasciata una patch per Azure DevOps Server 2020 Update 0.2 che include correzioni per quanto segue.

- Risolvere il problema relativo alla mancata visualizzazione delle identità di Active Directory appena aggiunte nei selettore identità della finestra di dialogo di sicurezza.

- Consente di risolvere un problema relativo al filtro Del gruppo richiesto dal membro del gruppo nelle impostazioni di webhook.

- Correzione dell'errore di compilazione del check-in controllato quando le impostazioni organizzazione per la pipeline avevano l'ambito di autorizzazione del processo configurato come Limitare l'ambito di autorizzazione del processo al progetto corrente per le pipeline non di rilascio.

Azure DevOps Server 2020.0.2 Data di rilascio: 17 maggio 2022

Azure DevOps Server 2020.0.2 è un rollup di correzioni di bug. È possibile installare direttamente Azure DevOps Server 2020.0.2 o eseguire l'aggiornamento da Azure DevOps Server 2020 o Team Foundation Server 2013 o versione successiva.

Nota

Lo strumento di migrazione dei dati sarà disponibile per Azure DevOps Server 2020.0.2 circa tre settimane dopo questa versione. È possibile visualizzare l'elenco delle versioni attualmente supportate per l'importazione qui.

Questa versione include correzioni per quanto segue:

Impossibile ignorare la coda di compilazione usando il pulsante "Esegui successivo". In precedenza, il pulsante "Esegui successivo" era abilitato solo per gli amministratori della raccolta di progetti.

Revocare tutti i token di accesso personale dopo che l'account Active Directory di un utente è disabilitato.

Azure DevOps Server 2020.0.1 Patch 9 Data di rilascio: 26 gennaio 2022

È stata rilasciata una patch per Azure DevOps Server 2020.0.1 che include correzioni per quanto segue.

- Email le notifiche non sono state inviate quando si usa il @mention controllo in un elemento di lavoro.

- Correzione TF400813 errore durante il cambio di account. Questo errore si è verificato durante l'aggiornamento da TFS 2018 a Azure DevOps Server 2020.0.1.

- Correzione del problema relativo al mancato caricamento della pagina di riepilogo della panoramica del progetto.

- Miglioramento della sincronizzazione utente di Active Directory.

- È stata risolta la vulnerabilità di Elasticsearch rimuovendo la classe jndilookup dai file binari log4j.

Procedura di installazione

- Aggiornare il server con patch 9.

- Controllare il valore del Registro di sistema in

HKLM:\Software\Elasticsearch\Version. Se il valore del Registro di sistema non è presente, aggiungere un valore stringa e impostare Version su 5.4.1 (Name = Version, Value = 5.4.1). - Eseguire il comando

PS C:\Program Files\{TFS Version Folder}\Search\zip> .\Configure-TFSSearch.ps1 -Operation updateupdate come specificato nel file leggimi. Può restituire un avviso simile a: Impossibile connettersi al server remoto. Non chiudere la finestra, perché l'aggiornamento esegue nuovi tentativi fino al completamento.

Nota

Se Azure DevOps Server e Elasticsearch sono installati in computer diversi, seguire questa procedura.

- Aggiornare il server con patch 9..

- Controllare il valore del Registro di sistema in

HKLM:\Software\Elasticsearch\Version. Se il valore del Registro di sistema non è presente, aggiungere un valore stringa e impostare Version su 5.4.1 (Name = Version, Value = 5.4.1). - Copiare il contenuto della cartella denominata zip, che si trova nella

C:\Program Files\{TFS Version Folder}\Search\zipcartella dei file remoti di Elasticsearch. - Eseguire

Configure-TFSSearch.ps1 -Operation updatenel computer del server Elasticsearch.

Hash SHA-256: B0C05A972C73F253154AEEB7605605EF2E596A96A3720AE942D7A9DDD881545E

Azure DevOps Server 2020.0.1 Patch 8 Data di rilascio: 15 dicembre 2021

La patch 8 per Azure DevOps Server 2020.0.1 include correzioni per quanto segue.

- Problema di localizzazione per gli stati di layout degli elementi di lavoro personalizzati.

- Problema di localizzazione nel modello di notifica tramite posta elettronica.

- Problema con i log della console che vengono troncati quando sono presenti più collegamenti identici in una riga.

- Problema con la valutazione delle regole NOTSAMEAS quando sono state definite più regole NOTSAMEAS per un campo.

Azure DevOps Server 2020.0.1 Patch 7 Data di rilascio: 26 ottobre 2021

La patch 7 per Azure DevOps Server 2020.0.1 include correzioni per quanto segue.

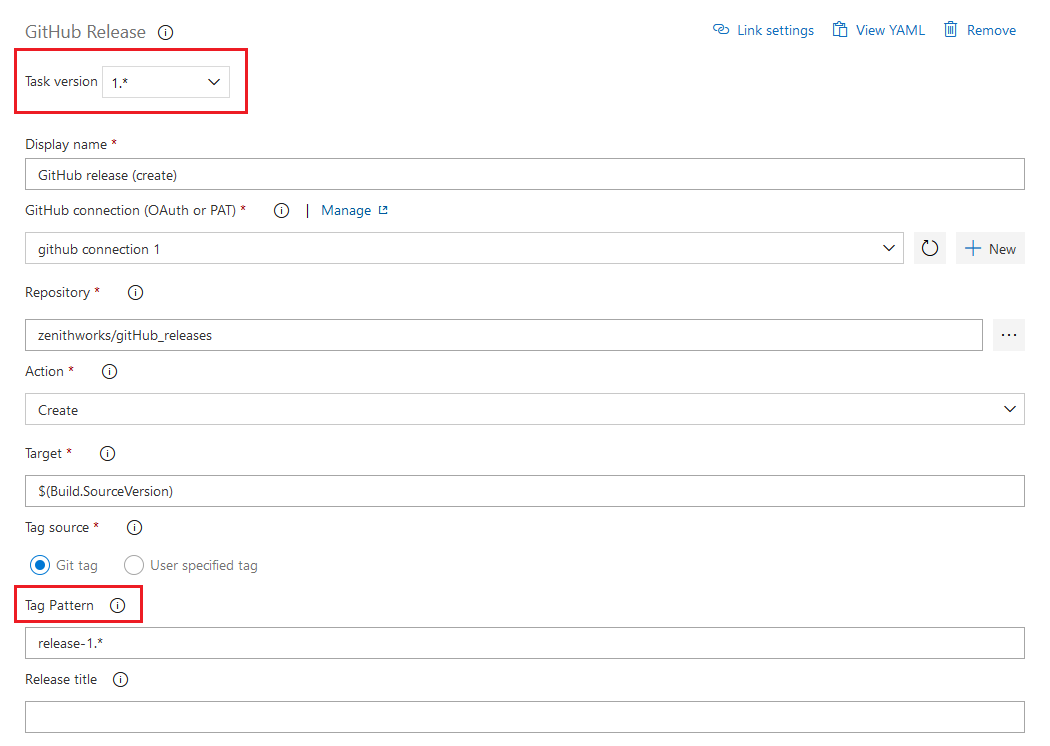

- In precedenza, Azure DevOps Server poteva creare connessioni solo a GitHub Enterprise Server. Con questa patch, gli amministratori del progetto possono creare connessioni tra Azure DevOps Server e repository in GitHub.com. È possibile trovare questa impostazione nella pagina Connessioni GitHub in Impostazioni progetto.

- Risolvere il problema con il widget Piano di test. Il report sull'esecuzione del test mostrava un utente non corretto nei risultati.

- Correzione del problema relativo al mancato caricamento della pagina di riepilogo della panoramica del progetto.

- Consente di risolvere il problema relativo al mancato invio dei messaggi di posta elettronica per confermare l'aggiornamento del prodotto.

Azure DevOps Server 2020.0.1 Patch 6 Data di rilascio: 14 settembre 2021

La patch 6 per Azure DevOps Server 2020.0.1 include correzioni per quanto segue.

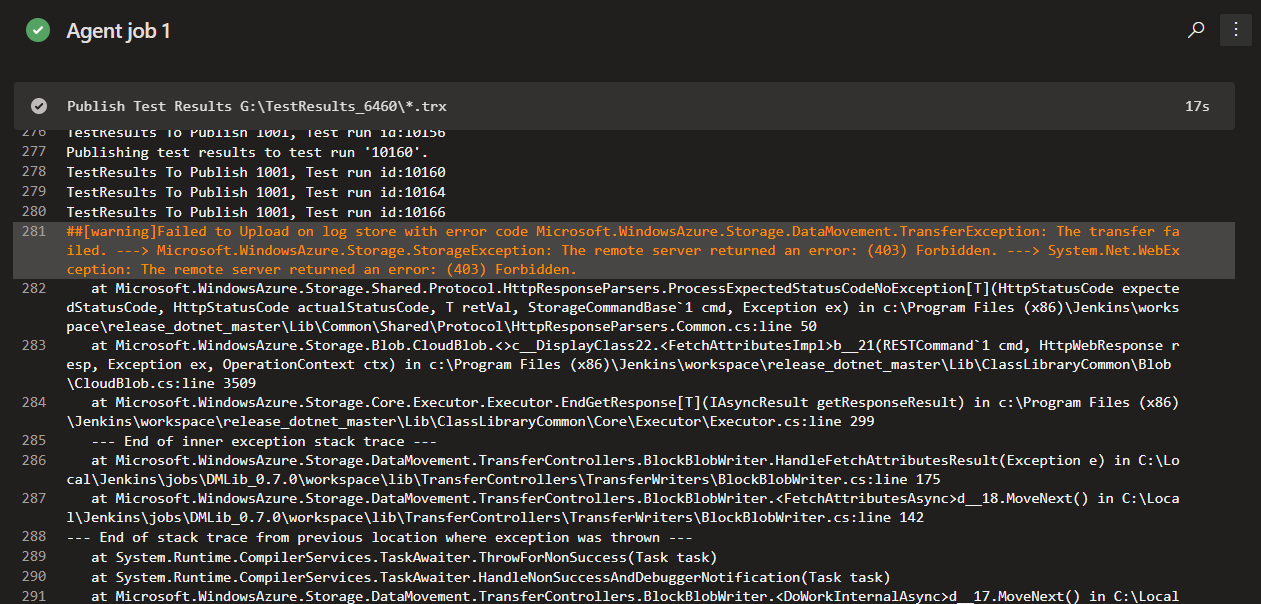

- Correzione dell'errore di download/caricamento degli artefatti.

- Risolvere il problema relativo ai dati dei risultati dei test incoerenti.

Azure DevOps Server 2020.0.1 Patch 5 Data di rilascio: 10 agosto 2021

La patch 5 per Azure DevOps Server 2020.0.1 include correzioni per quanto segue.

- Correzione dell'errore dell'interfaccia utente della definizione di compilazione.

- È stata modificata la cronologia di esplorazione per visualizzare i file anziché il repository radice.

- Correzione del problema relativo ai processi di recapito tramite posta elettronica per alcuni tipi di elementi di lavoro.

Azure DevOps Server 2020.0.1 Patch 4 Data di rilascio: 15 giugno 2021

La patch 4 per Azure DevOps Server 2020.0.1 include correzioni per quanto segue.

- Correzione del problema relativo all'importazione dei dati. L'importazione dei dati richiedeva molto tempo per i clienti che hanno molti test case non aggiornati. Ciò è dovuto a riferimenti che hanno aumentato le dimensioni della

tbl_testCaseReferencestabella. Con questa patch sono stati rimossi riferimenti a test case non aggiornati per velocizzare il processo di importazione dei dati.

Azure DevOps Server 2020.0.1 Patch 3 Data di rilascio: 11 maggio 2021

È stata rilasciata una patch per Azure DevOps Server 2020.0.1 che corregge quanto segue.

- Dati dei risultati dei test incoerenti quando si usa Microsoft.TeamFoundation.TestManagement.Client.

Se è Azure DevOps Server 2020.0.1, è necessario installare Azure DevOps Server 2020.0.1 Patch 3.

Verifica dell'installazione

Opzione 1: eseguire

devops2020.0.1patch3.exe CheckInstall, devops2020.0.1patch3.exe è il file scaricato dal collegamento precedente. L'output del comando indica che la patch è stata installata o che non è installata.Opzione 2: Controllare la versione del file seguente:

[INSTALL_DIR]\Azure DevOps Server 2020\Application Tier\bin\Microsoft.Teamfoundation.Framework.Server.dll. Azure DevOps Server 2020.0.1 è installato perc:\Program Files\Azure DevOps Server 2020impostazione predefinita. Dopo aver installato Azure DevOps Server 2020.0.1 Patch 3, la versione sarà 18.170.31228.1.

Azure DevOps Server 2020.0.1 Patch 2 Data di rilascio: 13 aprile 2021

Nota

Se si dispone di Azure DevOps Server 2020, è necessario prima eseguire l'aggiornamento a Azure DevOps Server 2020.0.1 . Una volta nella versione 2020.0.1, installare Azure DevOps Server 2020.0.1 Patch 2

È stata rilasciata una patch per Azure DevOps Server 2020.0.1 che corregge quanto segue.

- CVE-2021-27067: divulgazione di informazioni

- CVE-2021-28459: Elevazione dei privilegi

Per implementare le correzioni per questa patch, è necessario seguire i passaggi elencati di seguito per l'installazione generale delle patch, AzureResourceGroupDeploymentV2 e AzureResourceManagerTemplateDeploymentV3 .

Installazione generale delle patch

Se si dispone di Azure DevOps Server 2020.0.1, è necessario installare Azure DevOps Server 2020.0.1 Patch 2.

Verifica dell'installazione

Opzione 1: eseguire

devops2020.0.1patch2.exe CheckInstall, devops2020.0.1patch2.exe è il file scaricato dal collegamento precedente. L'output del comando indica che la patch è stata installata o che non è installata.Opzione 2: Controllare la versione del file seguente:

[INSTALL_DIR]\Azure DevOps Server 2020\Application Tier\bin\Microsoft.Teamfoundation.Framework.Server.dll. Azure DevOps Server 2020.0.1 è installato perc:\Program Files\Azure DevOps Server 2020impostazione predefinita. Dopo aver installato Azure DevOps Server 2020.0.1 Patch 2, la versione sarà 18.170.31123.3.

Installazione dell'attività AzureResourceGroupDeploymentV2

Nota

Tutti i passaggi indicati di seguito devono essere eseguiti in un computer Windows

Installare

Estrarre il pacchetto AzureResourceGroupDeploymentV2.zip in una nuova cartella del computer. Ad esempio: D:\tasks\AzureResourceGroupDeploymentV2.

Scaricare e installare Node.js 14.15.1 e npm (incluso nel download Node.js) in base al computer.

Aprire un prompt dei comandi in modalità amministratore ed eseguire il comando seguente per installare tfx-cli.

npm install -g tfx-cli

Create un token di accesso personale con privilegi di accesso completo e copiarlo. Questo token di accesso personale verrà usato quando si esegue il comando tfx login .

Eseguire il comando seguente dal prompt dei comandi. Quando richiesto, immettere l'URL del servizio e il token di accesso personale.

~$ tfx login

Copyright Microsoft Corporation

> Service URL: {url}

> Personal access token: xxxxxxxxxxxx

Logged in successfully

- Eseguire il comando seguente per caricare l'attività nel server. Usare il percorso del file .zip estratto dal passaggio 1.

~$ tfx build tasks upload --task-path *<Path of the extracted package>*

Installazione dell'attività AzureResourceManagerTemplateDeploymentV3

Nota

Tutti i passaggi indicati di seguito devono essere eseguiti in un computer Windows

Installare

Estrarre il pacchetto AzureResourceManagerTemplateDeploymentV3.zip in una nuova cartella del computer. Ad esempio:D:\tasks\AzureResourceManagerTemplateDeploymentV3.

Scaricare e installare Node.js 14.15.1 e npm (inclusi nel download di Node.js) in base alle esigenze del computer.

Aprire un prompt dei comandi in modalità amministratore ed eseguire il comando seguente per installare tfx-cli.

npm install -g tfx-cli

Create un token di accesso personale con privilegi di accesso completo e copiarlo. Questo token di accesso personale verrà usato quando si esegue il comando tfx login .

Eseguire il comando seguente dal prompt dei comandi. Quando richiesto, immettere l'URL del servizio e il token di accesso personale.

~$ tfx login

Copyright Microsoft Corporation

> Service URL: {url}

> Personal access token: xxxxxxxxxxxx

Logged in successfully

- Eseguire il comando seguente per caricare l'attività nel server. Usare il percorso del file .zip estratto dal passaggio 1.

~$ tfx build tasks upload --task-path *<Path of the extracted package>*

Azure DevOps Server 2020.0.1 Patch 1 Data di rilascio: 9 febbraio 2021

È stata rilasciata una patch per Azure DevOps Server 2020.0.1 che corregge quanto segue. Vedere il post di blog per altre informazioni.

- Risolvere il problema segnalato in questo ticket di feedback Developer Community| Nuovo pulsante Test Case non funzionante

- Includere le correzioni rilasciate con Azure DevOps Server 2020 Patch 2.

Azure DevOps Server 2020 Patch 3 Data di rilascio: 9 febbraio 2021

È stata rilasciata una patch per Azure DevOps Server 2020 che corregge quanto segue. Vedere il post di blog per altre informazioni.

- Risolvere il problema segnalato in questo ticket di feedback Developer Community| Nuovo pulsante Test Case non funzionante

Azure DevOps Server 2020.0.1 Data di rilascio: 19 gennaio 2021

Azure DevOps Server 2020.0.1 è un rollup di correzioni di bug. È possibile installare direttamente Azure DevOps Server 2020.0.1 o eseguire l'aggiornamento da un'installazione esistente. Le versioni supportate per l'aggiornamento sono Azure DevOps Server 2020, Azure DevOps Server 2019 e Team Foundation Server 2012 o versione successiva.

Questa versione include correzioni per i bug seguenti:

- Risolvere un problema di aggiornamento da Azure DevOps Server 2019 in cui il proxy Git potrebbe smettere di funzionare dopo l'aggiornamento.

- Correggere l'eccezione System.OutOfMemoryException per le raccolte non ENU precedenti a Team Foundation Server 2017 durante l'aggiornamento a Azure DevOps Server 2020. Risolve il problema segnalato in questo ticket di feedback Developer Community.

- Errore di manutenzione causato da Microsoft.Azure.DevOps.ServiceEndpoints.Sdk.Server.Extensions.dll mancanti. Risolve il problema segnalato in questo ticket di feedback Developer Community.

- Correzione dell'errore di nome di colonna non valido in Analytics durante l'aggiornamento a Azure DevOps Server 2020. Risolve il problema segnalato in questo ticket di feedback Developer Community.

- XSS archiviato quando vengono visualizzati i passaggi del test case nei risultati del test case.

- Errore del passaggio di aggiornamento durante la migrazione dei dati dei risultati dei punti a TCM.

Azure DevOps Server 2020 Patch 2 Data di rilascio: 12 gennaio 2021

È stata rilasciata una patch per Azure DevOps Server 2020 che corregge quanto segue. Vedere il post di blog per altre informazioni.

- I dettagli dell'esecuzione dei test non visualizzano i dettagli dei passaggi di test per i dati di test migrati tramite la migrazione di OpsHub

- Eccezione nell'inizializzatore per 'Microsoft.TeamFoundation.TestManagement.Server.TCMLogger'

- Le compilazioni non gestite vengono eliminate immediatamente dopo la migrazione a Azure DevOps Server 2020

- Correzione dell'eccezione del provider di dati

Azure DevOps Server 2020 Patch 1 Data: 8 dicembre 2020

È stata rilasciata una patch per Azure DevOps Server 2020 che corregge quanto segue. Vedere il post di blog per altre informazioni.

- CVE-2020-17145: vulnerabilità di spoofing di Azure DevOps Server e Team Foundation Services

data di rilascio Azure DevOps Server 2020: 6 ottobre 2020

Azure DevOps Server 2020 è un rollup di correzioni di bug. Include tutte le funzionalità del Azure DevOps Server 2020 RC2 rilasciate in precedenza.

Nota

Azure DevOps 2020 Server presenta un problema con l'installazione di uno degli assembly usati dal file system virtuale Git (GVFS).

Se si esegue l'aggiornamento da Azure DevOps 2019 (qualsiasi versione) o da un candidato alla versione finale di Azure DevOps 2020 e si installa nella stessa directory della versione precedente, l'assembly Microsoft.TeamFoundation.Git.dll non verrà installato. È possibile verificare di aver riscontrato il problema cercando Microsoft.TeamFoundation.Git.dll in <Install Dir>\Version Control Proxy\Web Services\bin, <Install Dir>\Application Tier\TFSJobAgent e <Install Dir>\Tools cartelle. Se il file non è presente, è possibile eseguire un ripristino per ripristinare i file mancanti.

Per eseguire un ripristino, passare alla macchina o alla Settings -> Apps & Features macchina virtuale Azure DevOps Server ed eseguire un ripristino nel server Azure DevOps 2020. Al termine del ripristino, è possibile riavviare il computer o la macchina virtuale.

data di rilascio Azure DevOps Server 2020 RC2: 11 agosto 2020

Azure DevOps Server 2020 RC2 è un rollup di correzioni di bug. Include tutte le funzionalità del Azure DevOps Server 2020 RC1 rilasciate in precedenza.

Azure DevOps Server 2020 RC1 re-release Date: 10 luglio 2020

Microsoft ha ri-rilasciato Azure DevOps Server 2020 RC1 per correggere questo ticket di feedback Developer Community.

In precedenza, dopo l'aggiornamento da Azure DevOps Server 2019 Update 1.1 a Azure DevOps Server 2020 RC1, non è stato possibile visualizzare i file in Repos, Pipelines e Wiki dell'interfaccia utente Web. Si è verificato un messaggio di errore che indica che si è verificato un errore imprevisto all'interno di questa area della pagina. È possibile provare a ricaricare questo componente o aggiornare l'intera pagina. Con questa versione è stato risolto questo problema. Vedere il post di blog per altre informazioni.

data di rilascio Azure DevOps Server 2020 RC1: 30 giugno 2020

Riepilogo delle novità di Azure DevOps Server 2020

Azure DevOps Server 2020 introduce molte nuove funzionalità. Tra le caratteristiche principali:

- Pipeline in più fasi

- Distribuzione continua in YAML

- Tenere traccia dello stato di avanzamento degli elementi padre usando rollup nel backlog boards

- Aggiungere il filtro "Elemento di lavoro padre" alla scheda attività e al backlog dello sprint

- Nuova interfaccia utente Web per Azure Repos pagine di destinazione

- Amministrazione dei criteri dei rami tra repository

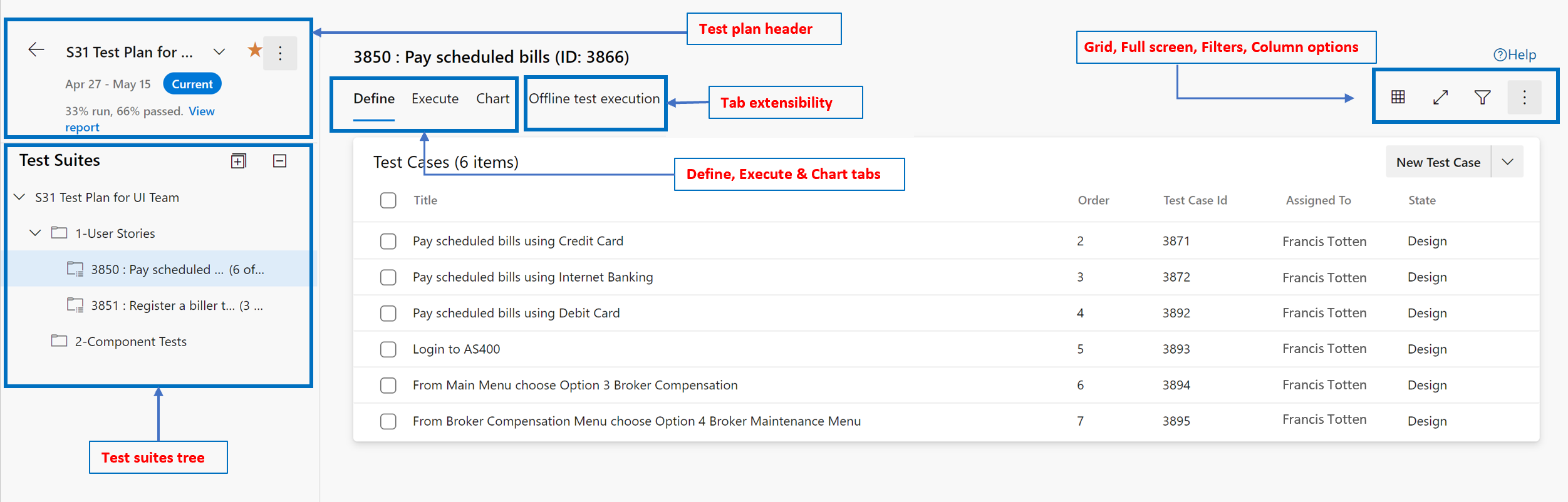

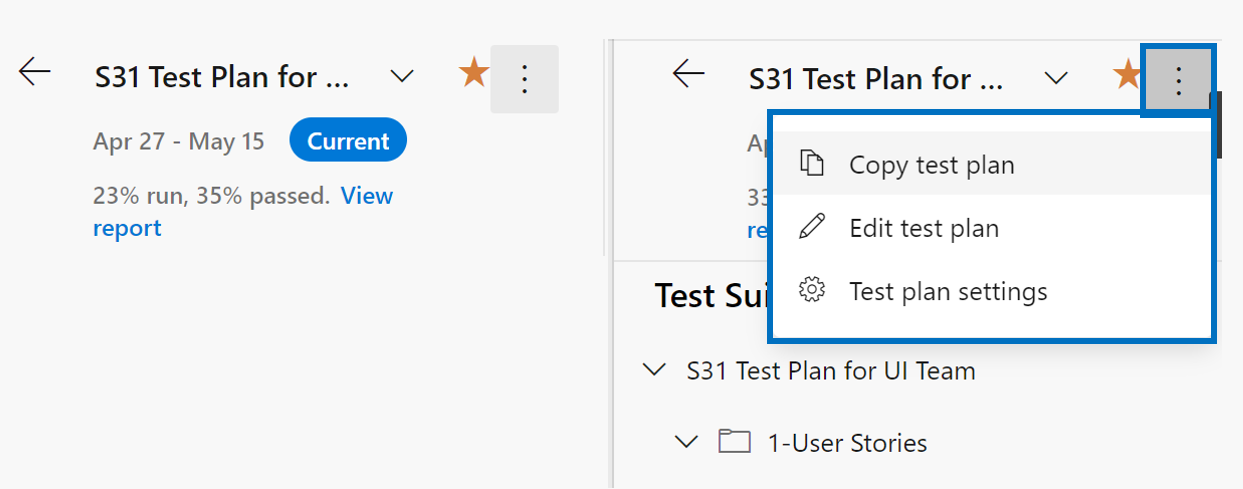

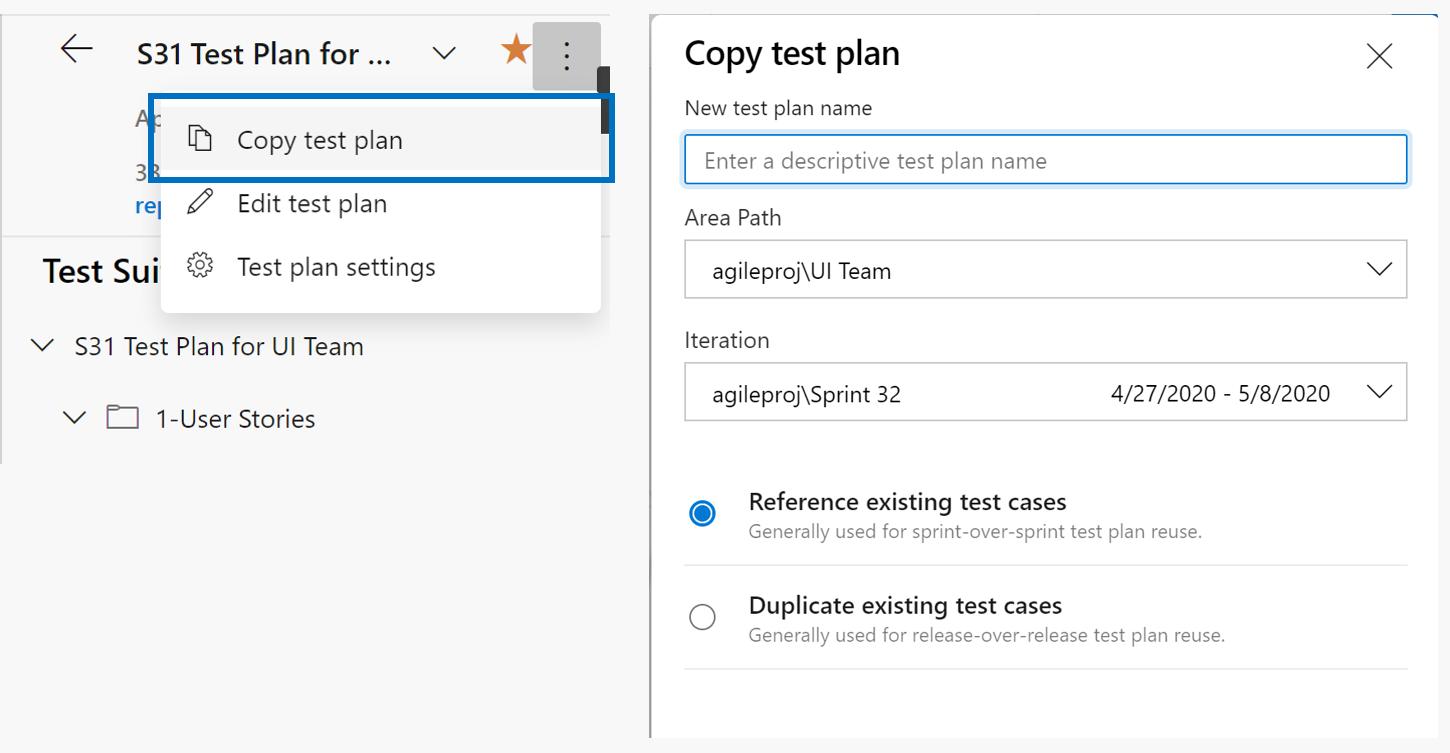

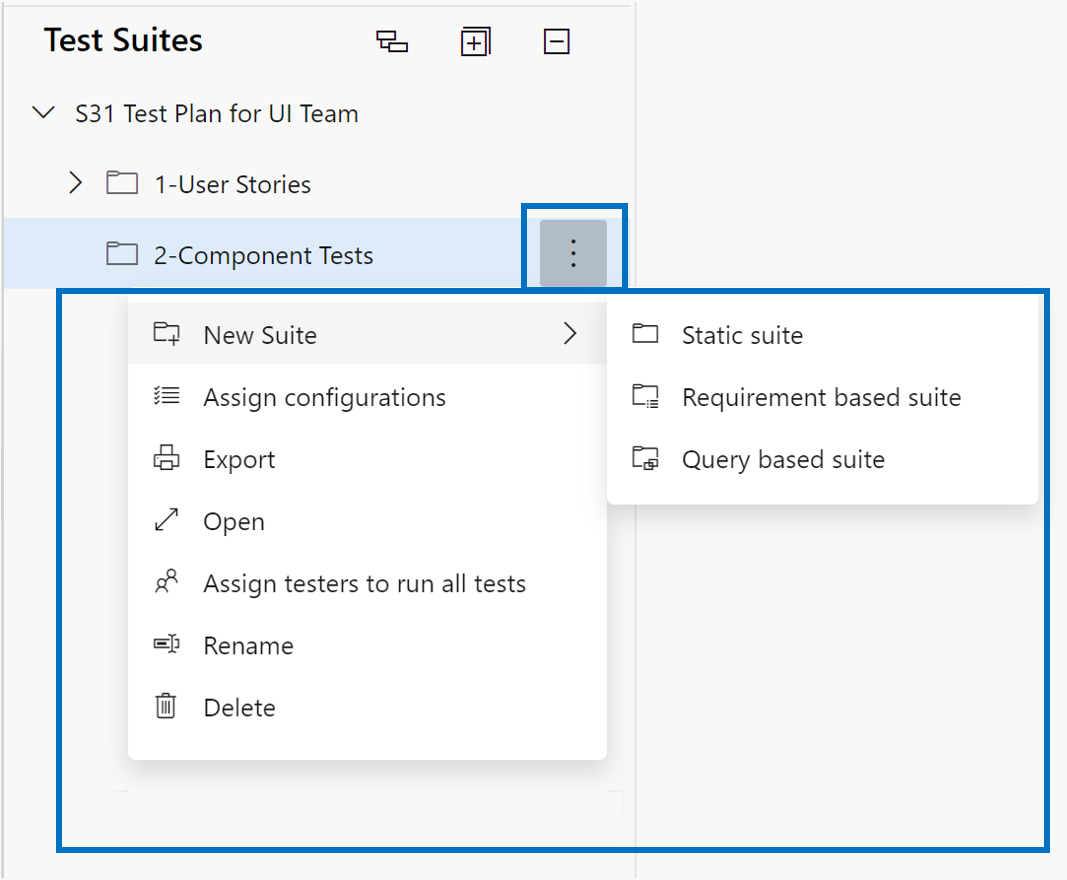

- Pagina Nuovo piano di test

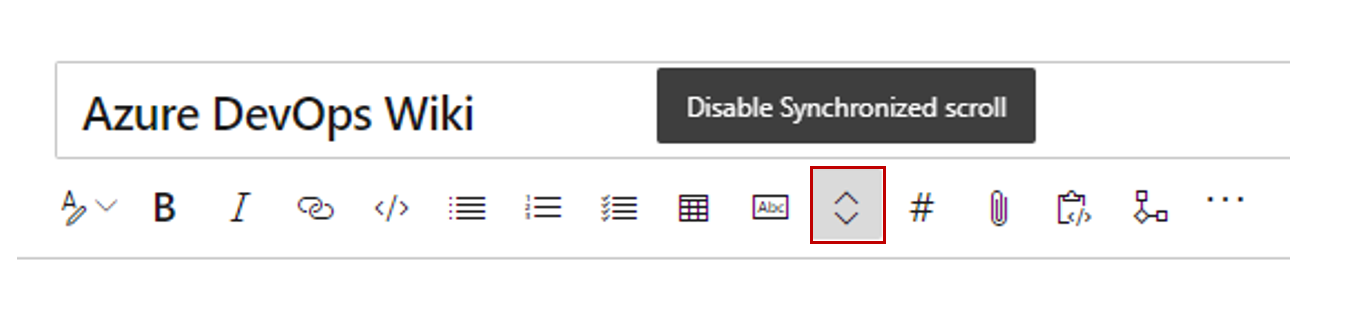

- Modifica avanzata per le pagine wiki del codice

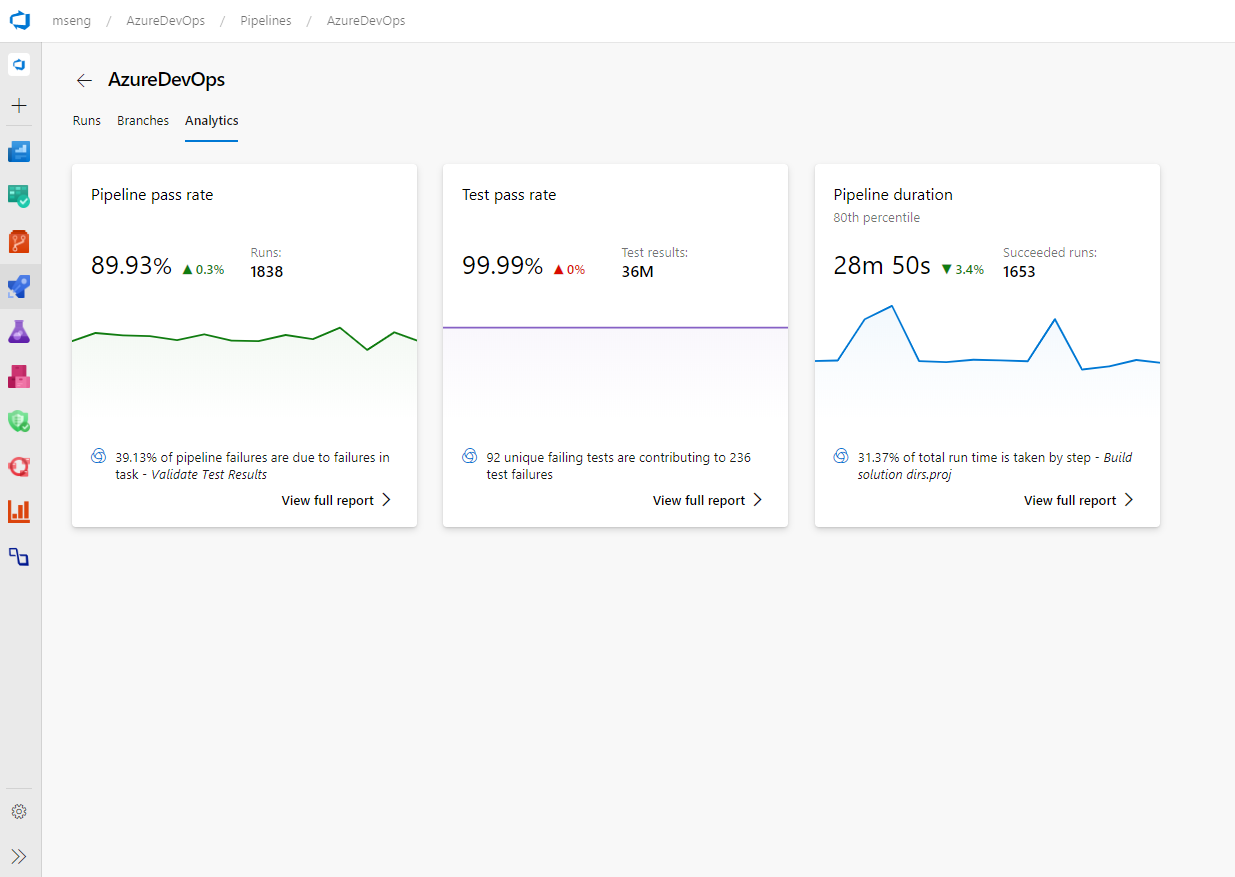

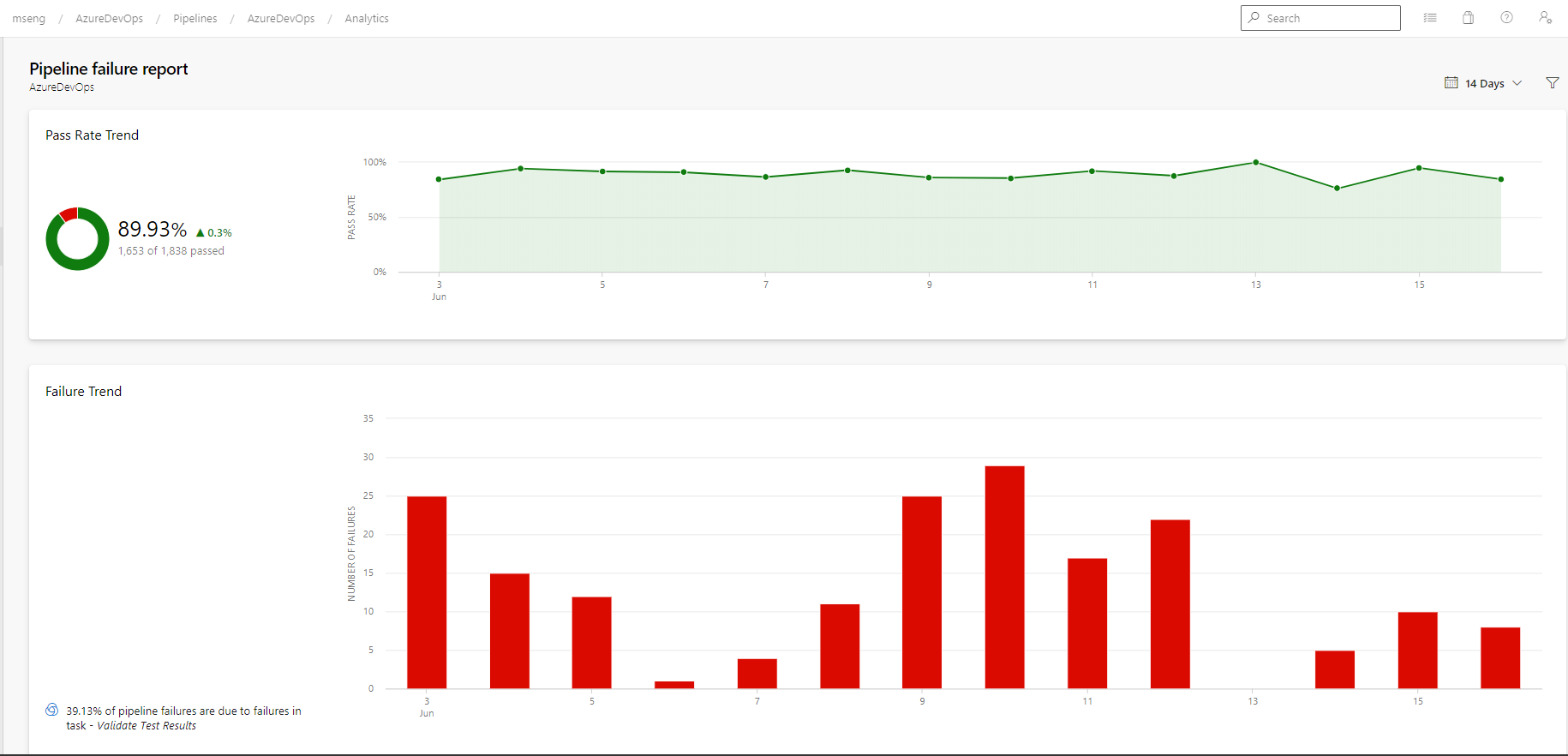

- Report relativi a errori e durata della pipeline

È anche possibile passare a singole sezioni per visualizzare tutte le nuove funzionalità per ogni servizio:

Generale

Disponibilità generale dell'interfaccia della riga di comando di Azure DevOps

A febbraio è stata introdotta l'estensione Azure DevOps per l'interfaccia della riga di comando di Azure. L'estensione consente di interagire con Azure DevOps dalla riga di comando. Sono stati raccolti commenti e suggerimenti che hanno consentito di migliorare l'estensione e aggiungere altri comandi. Siamo lieti di annunciare che l'estensione è disponibile a livello generale.

Per altre informazioni sull'interfaccia della riga di comando di Azure DevOps, vedere la documentazione qui.

Usare il profilo di pubblicazione per distribuire App Web di Azure per Windows dal Centro distribuzione

È ora possibile usare l'autenticazione basata su profilo di pubblicazione per distribuire le app Web di Azure per Windows dal Centro distribuzione. Se si dispone dell'autorizzazione per la distribuzione in un'app Web di Azure per Windows usando il profilo di pubblicazione, sarà possibile configurare la pipeline usando questo profilo nei flussi di lavoro del Centro distribuzione.

Boards

Aggiungere il filtro "Elemento di lavoro padre" alla scheda attività e al backlog dello sprint

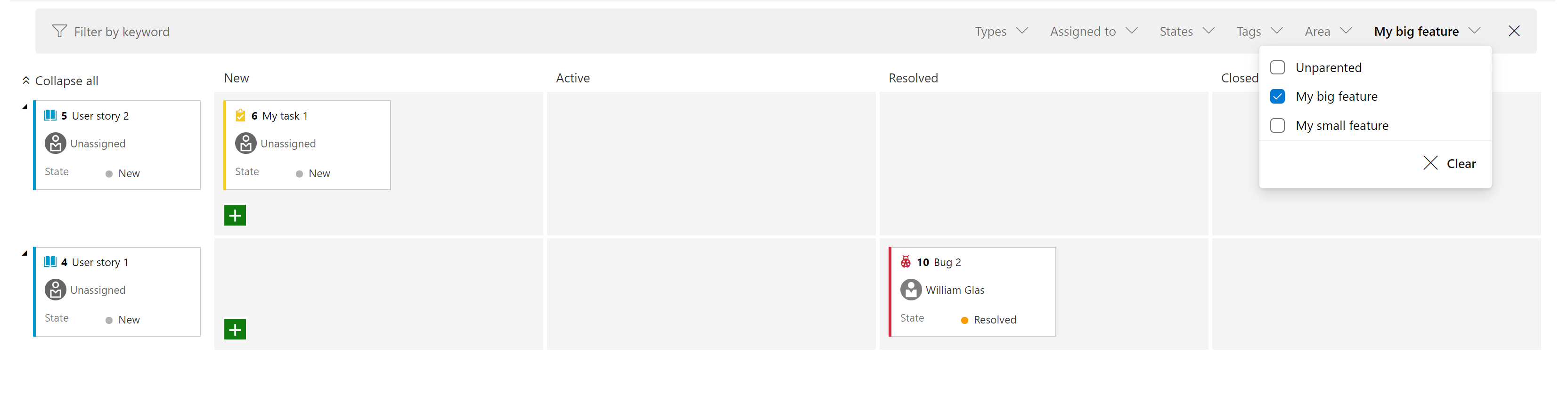

È stato aggiunto un nuovo filtro sia alla scheda Sprint che al backlog Sprint. In questo modo è possibile filtrare gli elementi backlog a livello di requisiti (prima colonna a sinistra) in base all'elemento padre. Ad esempio, nella schermata seguente è stata filtrata la visualizzazione per mostrare solo le storie utente in cui l'elemento padre è "My big feature".

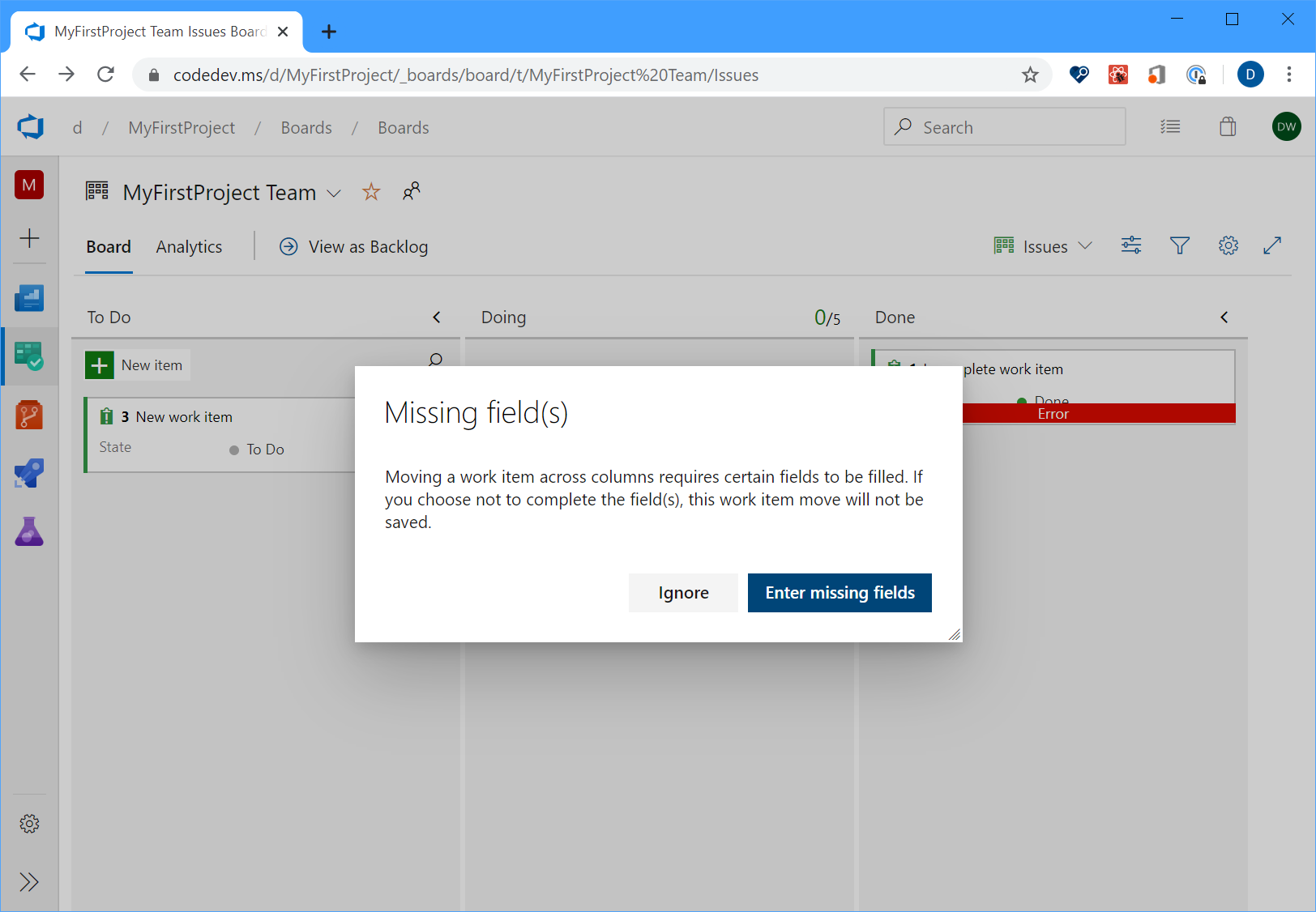

Migliorare l'esperienza di gestione degli errori: campi obbligatori in Bug/Attività

In passato, dalla scheda Kanban, se un elemento di lavoro è stato spostato da una colonna a un'altra in cui la modifica dello stato ha attivato le regole dei campi, la scheda visualizza semplicemente un messaggio di errore rosso che forza l'apertura dell'elemento di lavoro per comprendere la causa radice. Nello sprint 170 è stata migliorata l'esperienza in modo da poter fare clic sul messaggio di errore rosso per visualizzare i dettagli dell'errore senza dover aprire l'elemento di lavoro stesso.

Ricaricamento attivo degli elementi di lavoro

In precedenza, durante l'aggiornamento di un elemento di lavoro e un secondo membro del team apportava modifiche allo stesso elemento di lavoro, il secondo utente perdeva le modifiche. A questo punto, purché si modifichi entrambi campi diversi, verranno visualizzati gli aggiornamenti in tempo reale delle modifiche apportate all'elemento di lavoro.

Gestire i percorsi di iterazione e area dalla riga di comando

È ora possibile gestire i percorsi di iterazione e area dalla riga di comando usando i az boards iteration comandi e az boards area . Ad esempio, è possibile configurare e gestire in modo interattivo i percorsi di iterazione e area dall'interfaccia della riga di comando oppure automatizzare l'intera installazione usando uno script. Per altre informazioni sui comandi e sulla sintassi, vedere la documentazione qui.

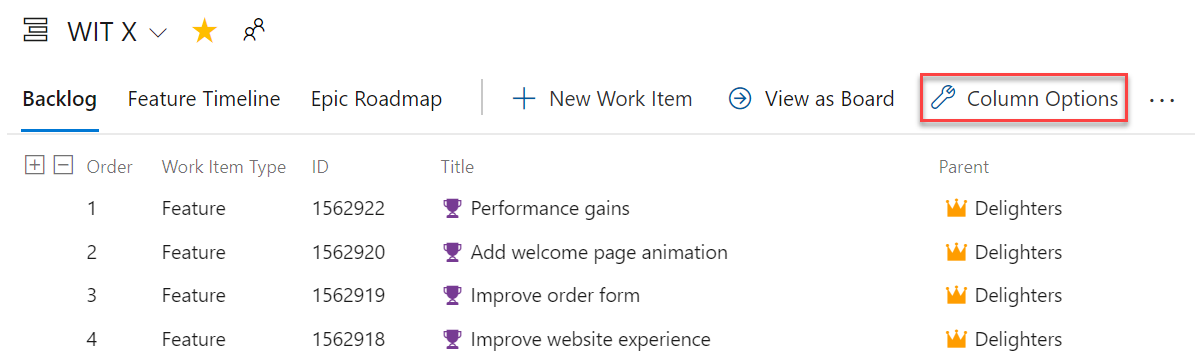

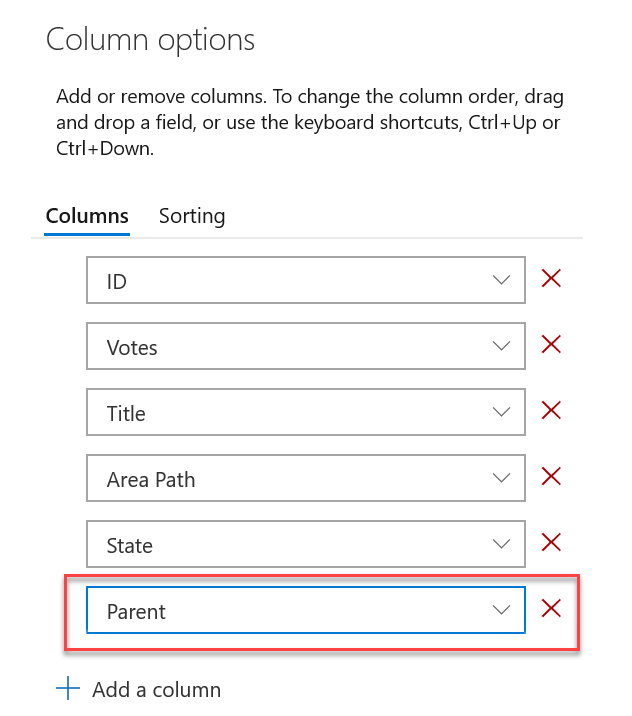

Opzione colonna padre elemento di lavoro come colonna

È ora possibile visualizzare l'elemento padre di ogni elemento di lavoro nel backlog del prodotto o nel backlog dello sprint. Per abilitare questa funzionalità, passare a Opzioni colonna nel backlog desiderato e quindi aggiungere la colonna Padre .

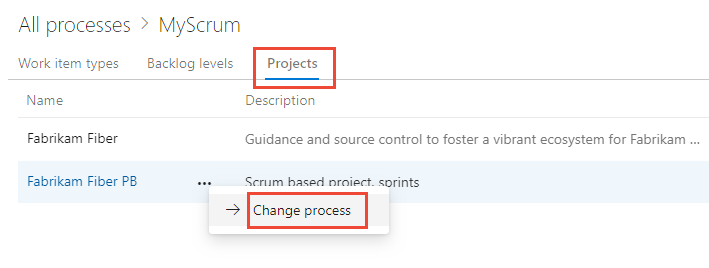

Modificare il processo usato da un progetto

Gli strumenti dovrebbero cambiare man mano che il team esegue questa operazione, è ora possibile passare da qualsiasi modello di processo predefinito a qualsiasi altro processo predefinito. Ad esempio, è possibile modificare il progetto da Agile a Scrum o Basic a Agile. La documentazione dettagliata è disponibile qui.

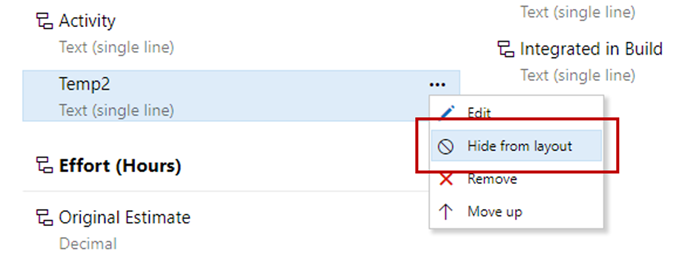

Nascondere campi personalizzati dal layout

È ora possibile nascondere i campi personalizzati dal layout del modulo durante la personalizzazione del processo. Il campo sarà ancora disponibile dalle query e dalle API REST. Ciò è utile per tenere traccia di campi aggiuntivi quando si esegue l'integrazione con altri sistemi.

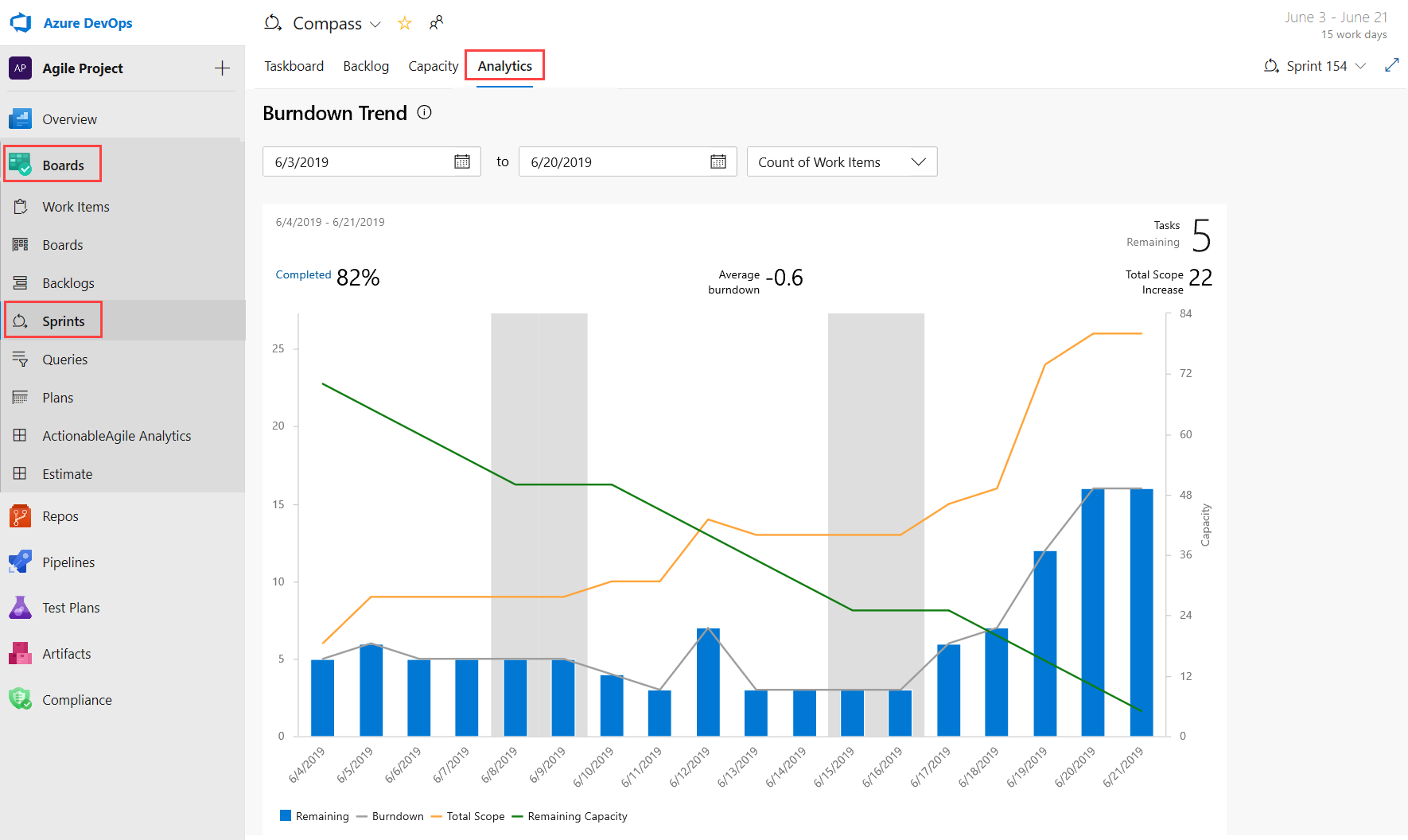

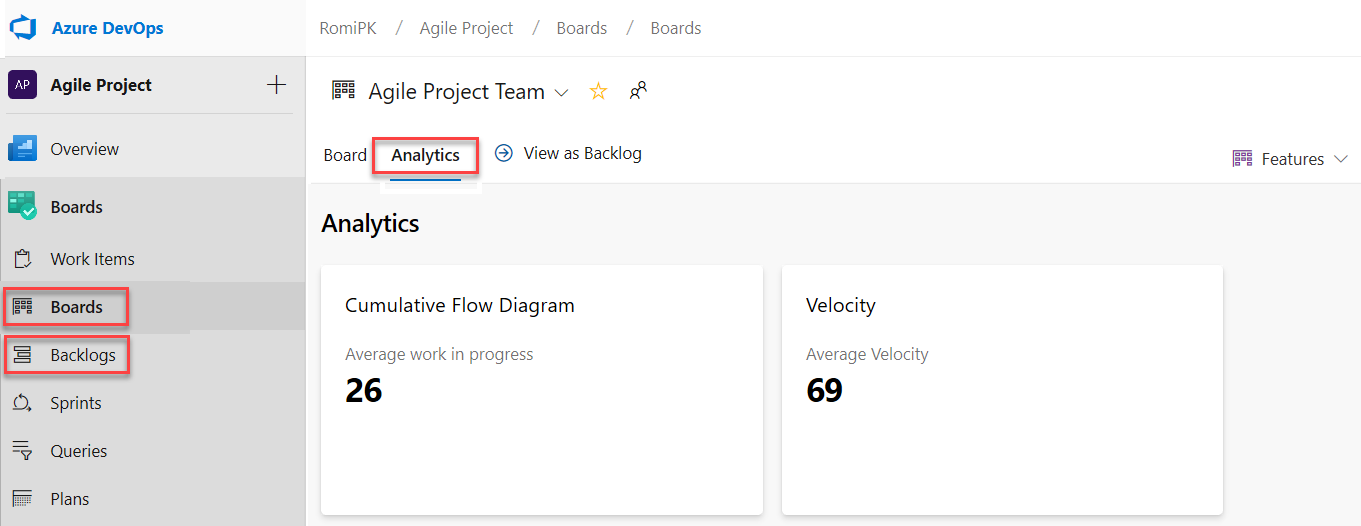

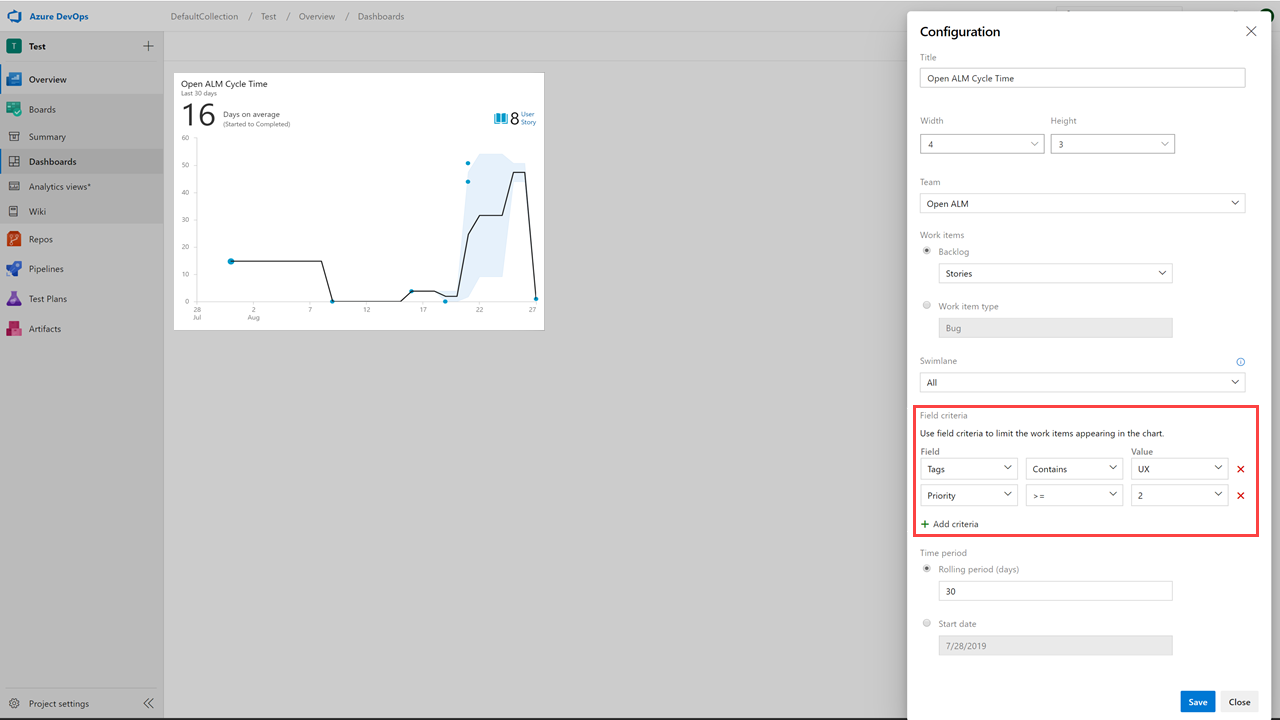

Ottenere informazioni dettagliate sull'integrità del team con tre nuovi report Azure Boards

Non è possibile correggere ciò che non è possibile visualizzare. Pertanto, si vuole tenere d'occhio lo stato e l'integrità dei processi di lavoro. Con questi report, è più semplice tenere traccia delle metriche importanti con un impegno minimo in Azure Boards.

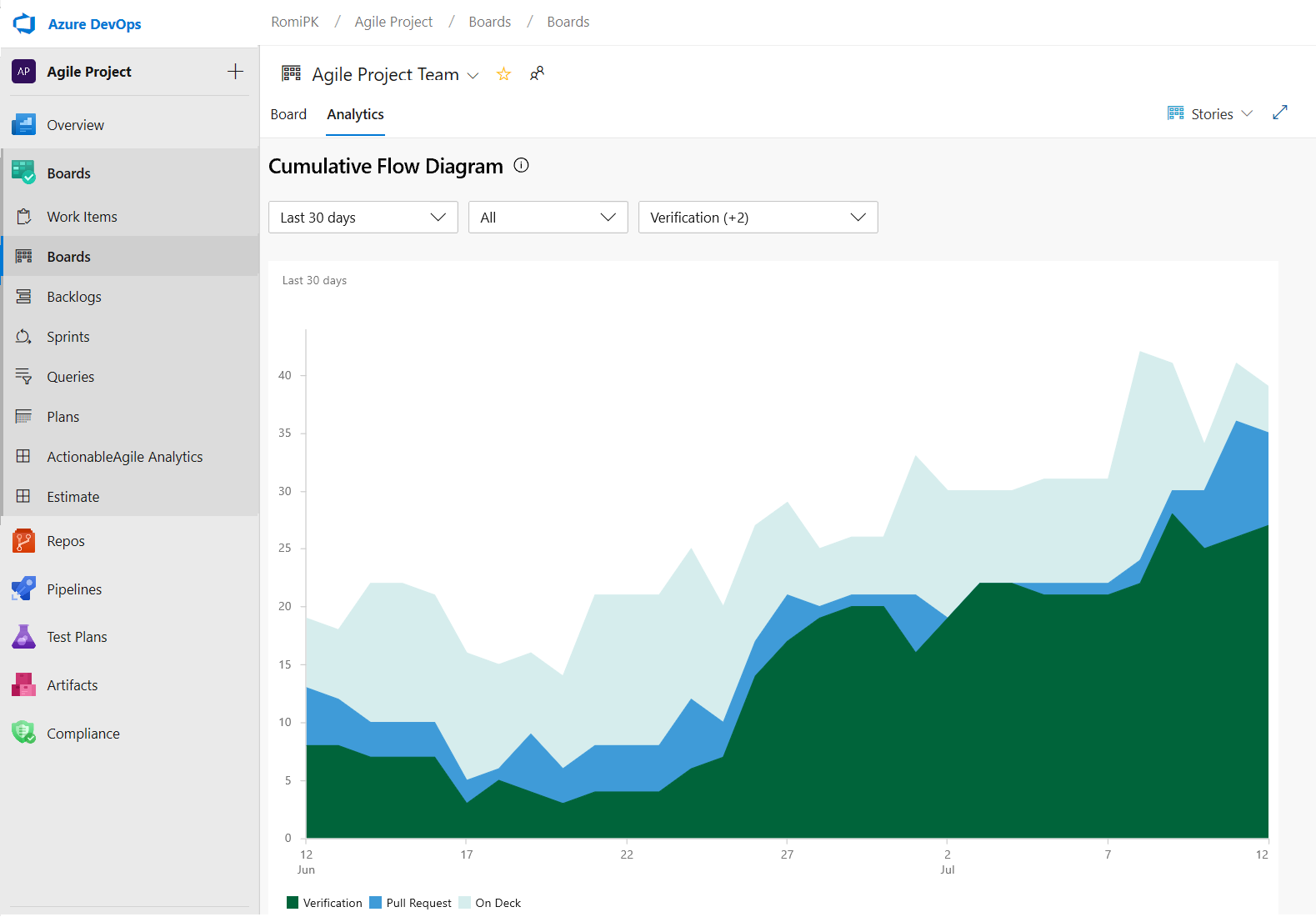

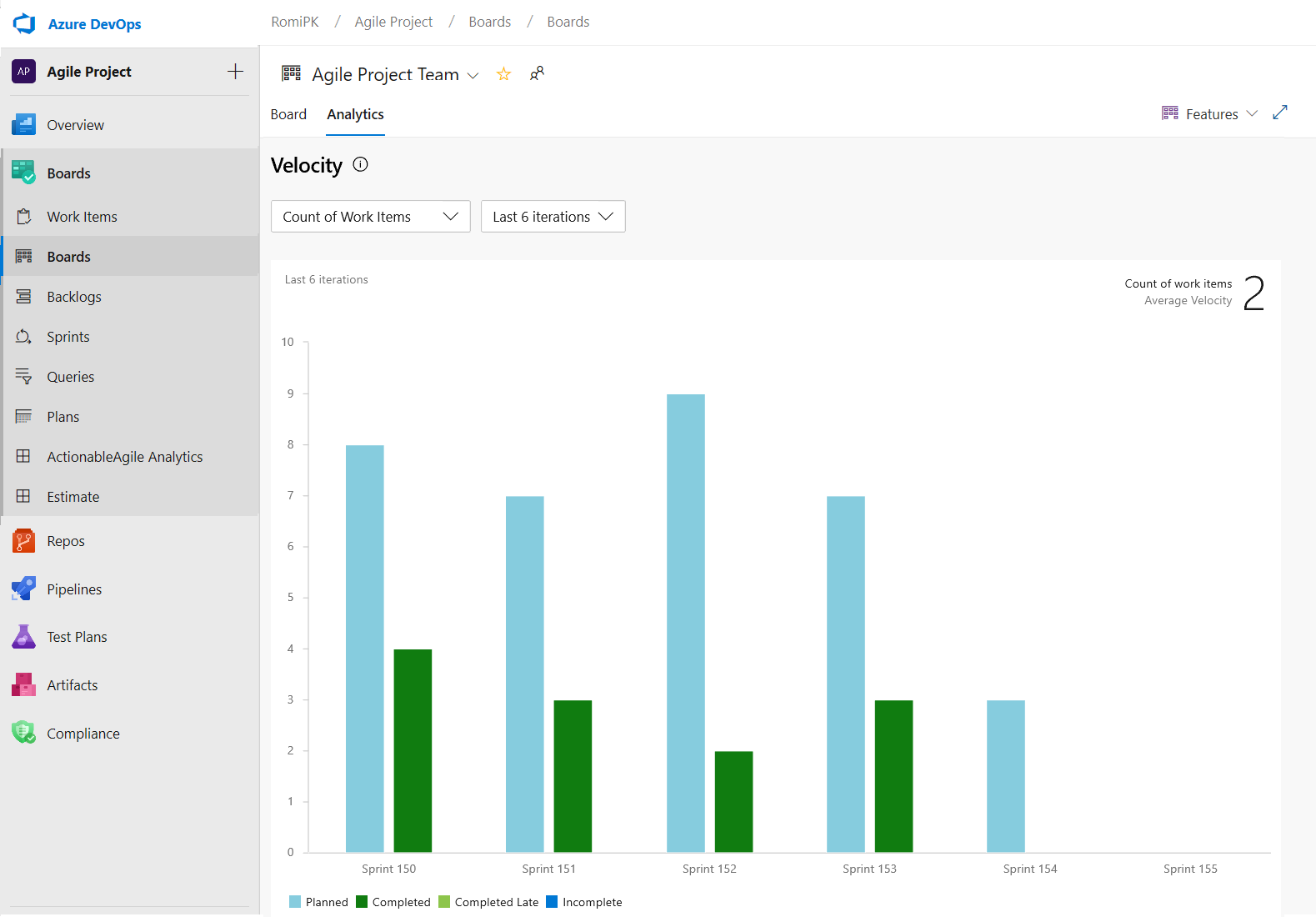

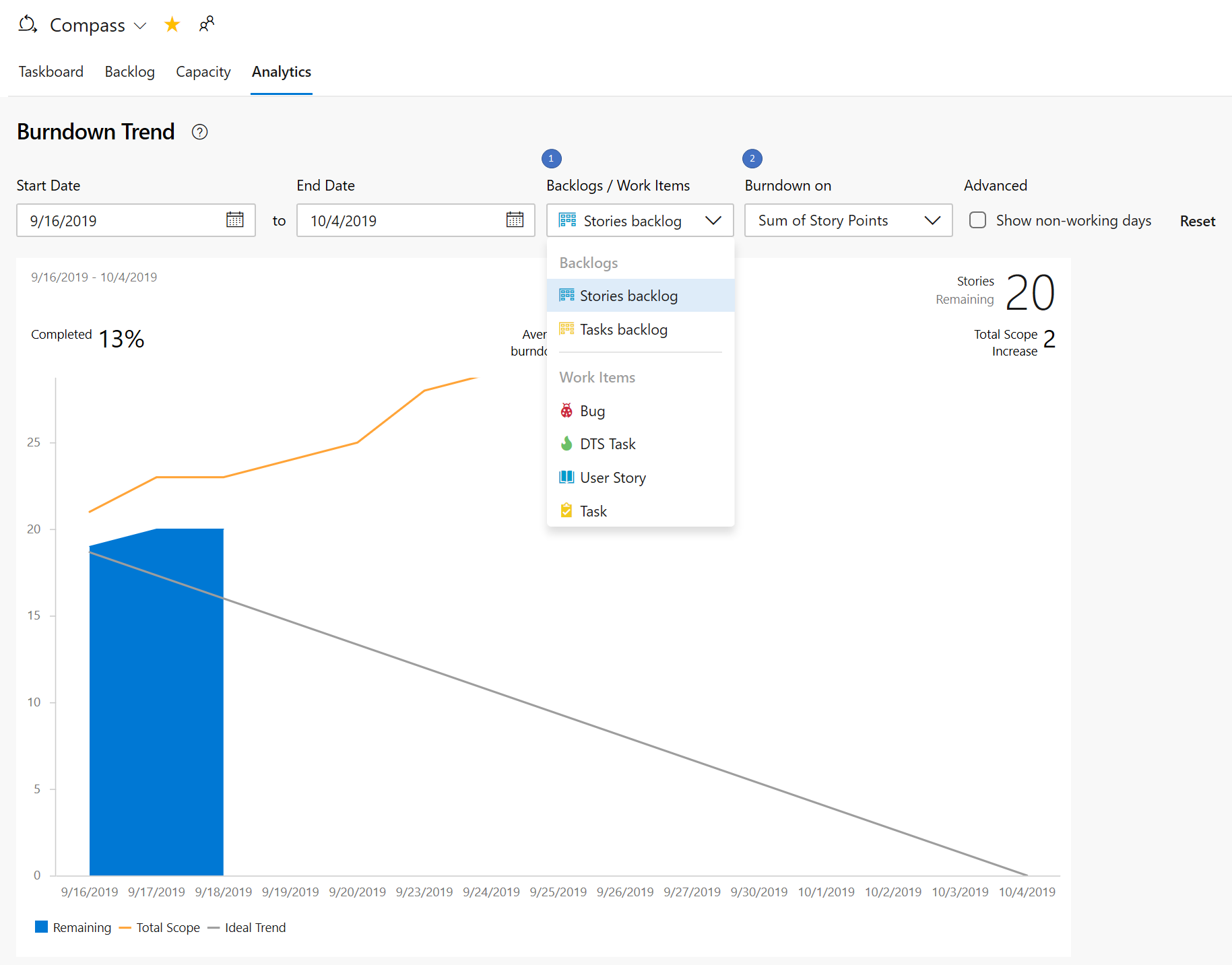

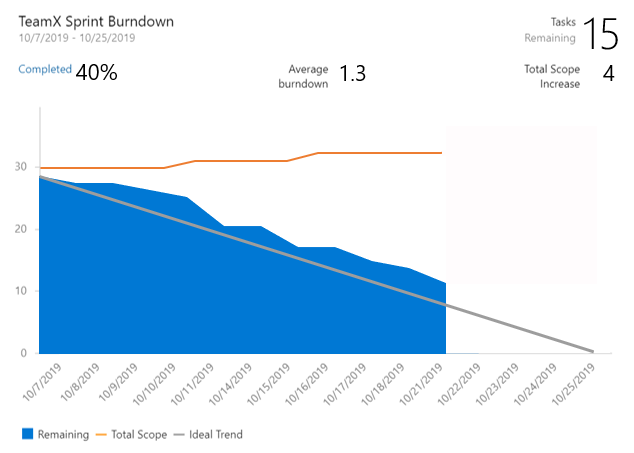

I tre nuovi report interattivi sono: Burndown, Cumulative Flow Diagram (CFD) e Velocity. È possibile visualizzare i report nella nuova scheda di analisi.

Le metriche come il burn-down sprint, il flusso di lavoro e la velocità del team offrono visibilità sullo stato di avanzamento del team e consentono di rispondere a domande come:

- Quanto lavoro abbiamo lasciato in questo sprint? Siamo in pista per completarlo?

- Quale passaggio del processo di sviluppo richiede più tempo? Possiamo fare qualcosa su di esso?

- In base alle iterazioni precedenti, quanto lavoro è necessario pianificare per il prossimo sprint?

Nota

I grafici illustrati in precedenza nelle intestazioni sono stati sostituiti con questi report avanzati.

I nuovi report sono completamente interattivi e consentono di modificarli per le proprie esigenze. È possibile trovare i nuovi report nella scheda Analisi in ogni hub.

Il grafico burn-down è disponibile nell'hub Sprint.

È possibile accedere ai report CFD e Velocity dalla scheda Analisi in Boards e Backlog facendo clic sulla scheda pertinente.

Con i nuovi report si hanno più controllo e informazioni sul team. Ecco alcuni esempi:

- I report Sprint Burndown e Velocity possono essere impostati per usare il conteggio degli elementi di lavoro o la somma del lavoro rimanente.

- È possibile modificare l'intervallo di tempo del burndown dello sprint senza influire sulle date del progetto. Pertanto, se il team trascorre in genere il primo giorno di ogni pianificazione dello sprint, è ora possibile trovare una corrispondenza con il grafico per riflettere tale situazione.

- Il grafico Burndown ha ora una filigrana che mostra i fine settimana.

- Il report CFD consente di rimuovere le colonne della lavagna, ad esempio Progettazione, per concentrarsi maggiormente sul flusso su cui i team hanno il controllo.

Ecco un esempio del report CFD che mostra il flusso per gli ultimi 30 giorni del backlog Stories.

È ora possibile tenere traccia del grafico Velocità per tutti i livelli di backlog. Ad esempio, è ora possibile aggiungere sia funzionalità che epiche, mentre prima del grafico precedente sono supportati solo i requisiti. Di seguito è riportato un esempio di report sulla velocità per le ultime 6 iterazioni del backlog Funzionalità.

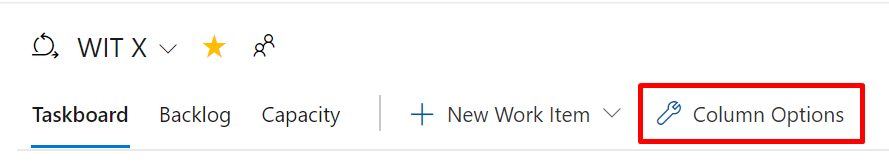

Personalizzare le colonne taskboard

Microsoft è lieta di annunciare che è stata aggiunta un'opzione che consente di personalizzare le colonne nella Scheda attività. È ora possibile aggiungere, rimuovere, rinominare e riordinare le colonne.

Per configurare le colonne nella Scheda attività, passare a Opzioni colonna.

Questa funzionalità è stata assegnata in ordine di priorità in base a un suggerimento del Developer Community.

Attiva/disattiva per visualizzare o nascondere gli elementi di lavoro figlio completati nel backlog

Molte volte, quando si affina il backlog, si vogliono visualizzare solo gli elementi che non sono stati completati. È ora possibile visualizzare o nascondere gli elementi figlio completati nel backlog.

Se l'interruttore è attivato, verranno visualizzati tutti gli elementi figlio in uno stato completato. Quando l'interruttore è disattivato, tutti gli elementi figlio in uno stato completato verranno nascosti dal backlog.

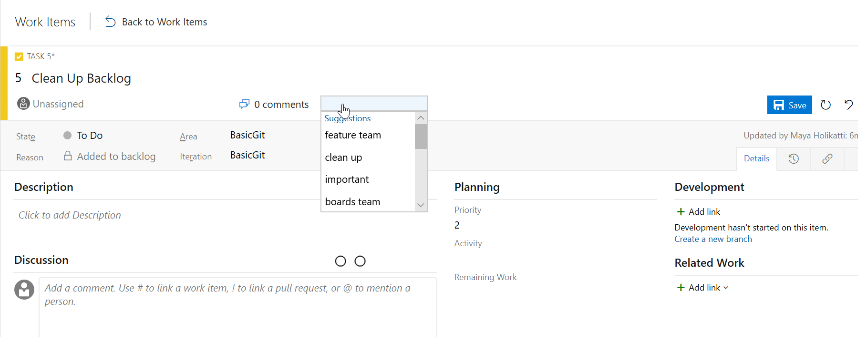

Tag più recenti visualizzati quando si contrassegna un elemento di lavoro

Quando si contrassegna un elemento di lavoro, l'opzione di completamento automatico ora visualizza fino a cinque dei tag usati più di recente. In questo modo sarà più semplice aggiungere le informazioni corrette agli elementi di lavoro.

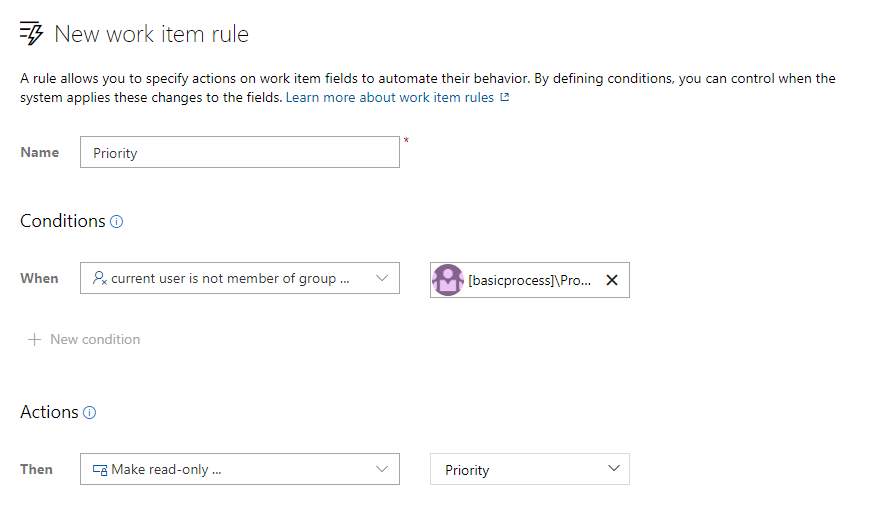

Regole di sola lettura e obbligatorie per l'appartenenza ai gruppi

Le regole degli elementi di lavoro consentono di impostare azioni specifiche sui campi degli elementi di lavoro per automatizzare il comportamento. È possibile creare una regola per impostare un campo in sola lettura o obbligatorio in base all'appartenenza al gruppo. Ad esempio, è possibile concedere ai proprietari del prodotto la possibilità di impostare la priorità delle funzionalità, rendendola di sola lettura per tutti gli altri utenti.

Personalizzare i valori dell'elenco a discesa di sistema

È ora possibile personalizzare i valori per qualsiasi elenco a discesa di sistema (ad eccezione del campo motivo), ad esempio Gravità, Attività, Priorità e così via. Le personalizzazioni dell'elenco a discesa sono con ambito in modo che sia possibile gestire valori diversi per lo stesso campo per ogni tipo di elemento di lavoro.

Nuovo parametro URL elemento di lavoro

Condividere i collegamenti agli elementi di lavoro con il contesto della scheda o del backlog con il nuovo parametro URL dell'elemento di lavoro. È ora possibile aprire una finestra di dialogo dell'elemento di lavoro nella scheda, nel backlog o nello sprint aggiungendo il parametro ?workitem=[ID] all'URL.

Chiunque condivida il collegamento verrà quindi visualizzato con lo stesso contesto che hai avuto quando hai condiviso il collegamento!

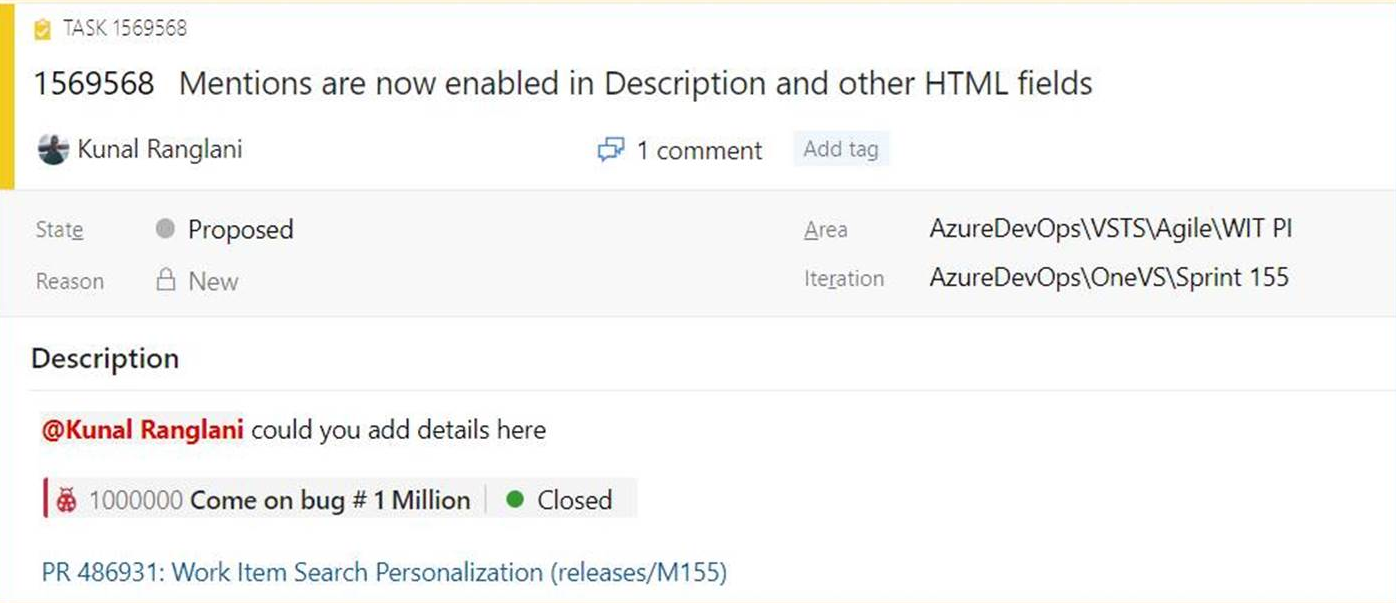

Menzionare persone, elementi di lavoro e richieste pull nei campi di testo

Durante l'ascolto dei commenti e suggerimenti, abbiamo sentito che hai voluto menzionare persone, elementi di lavoro e richieste pull nell'area di descrizione degli elementi di lavoro (e altri campi HTML) sull'elemento di lavoro e non solo nei commenti. In alcuni casi si collabora con un utente su un elemento di lavoro o si vuole evidenziare una richiesta pull nella descrizione dell'elemento di lavoro, ma non è stato possibile aggiungere tali informazioni. È ora possibile menzionare persone, elementi di lavoro e richieste pull in tutti i campi di testo lunghi nell'elemento di lavoro.

Un esempio è disponibile qui.

- Per usare menzioni di persone, digitare il @ segno e il nome della persona che si desidera menzionare. @mentions nei campi dell'elemento di lavoro genererà notifiche tramite posta elettronica come le operazioni che esegue per i commenti.

- Per usare le menzioni degli elementi di lavoro, digitare il # segno seguito dall'ID o dal titolo dell'elemento di lavoro. #mentions creerà un collegamento tra i due elementi di lavoro.

- Per usare le menzioni pull, aggiungere un valore ! seguito dall'ID o dal nome della richiesta pull.

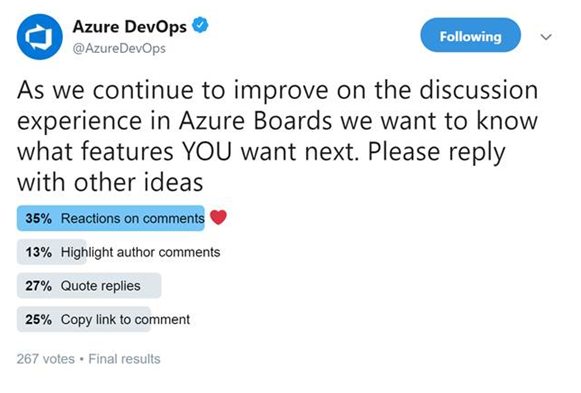

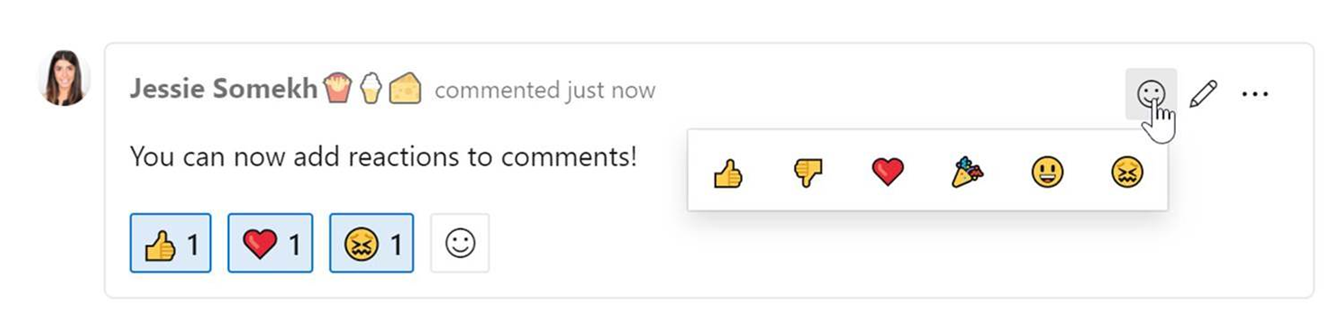

Reazioni sui commenti di discussione

Uno degli obiettivi principali è quello di rendere gli elementi di lavoro più collaborativi per i team. Recentemente abbiamo condotto un sondaggio su Twitter per scoprire quali funzionalità di collaborazione vuoi nelle discussioni sull'elemento di lavoro. Portando reazioni ai commenti ha vinto il sondaggio, quindi li aggiungiamo! Ecco i risultati del sondaggio di Twitter.

È possibile aggiungere reazioni a qualsiasi commento e ci sono due modi per aggiungere le tue reazioni: l'icona sorridente nell'angolo superiore destro di qualsiasi commento, nonché nella parte inferiore di un commento accanto a eventuali reazioni esistenti. Puoi aggiungere tutte e sei le reazioni se vuoi, o solo una o due. Per rimuovere la reazione, fare clic sulla reazione nella parte inferiore del commento e verrà rimossa. Di seguito è possibile vedere l'esperienza dell'aggiunta di una reazione, oltre a ciò che le reazioni sembrano su un commento.

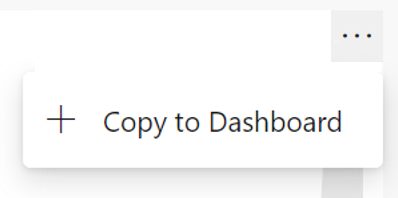

Aggiungere report Azure Boards al dashboard

Nell'aggiornamento sprint 155 sono state incluse le versioni aggiornate dei report CFD e Velocity. Questi report sono disponibili nella scheda Analisi di Schede e Backlog. È ora possibile aggiungere i report direttamente al dashboard. Per aggiungere i report, passare il puntatore del mouse sul report, selezionare i puntini di sospensione "..." menu e Copia nel dashboard.

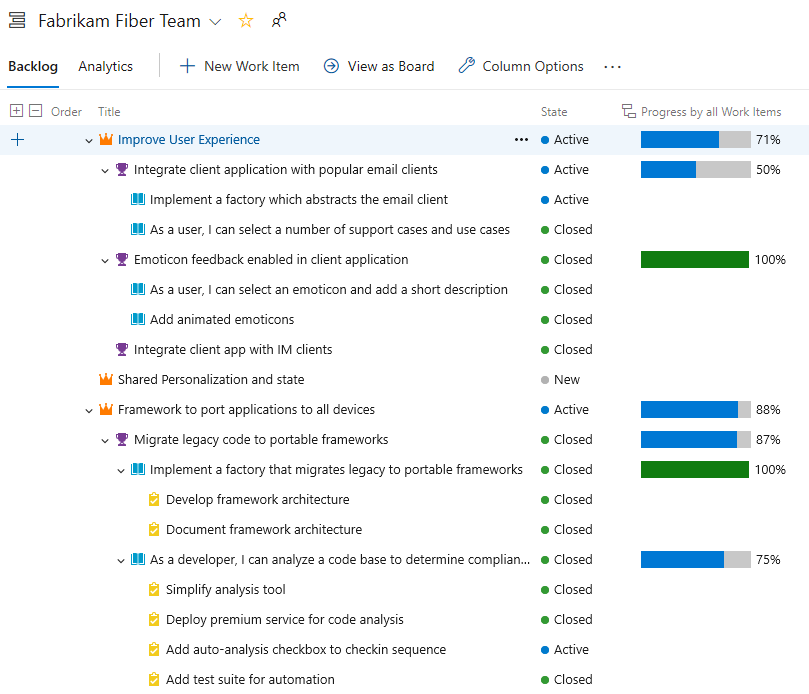

Tenere traccia dello stato di avanzamento degli elementi padre usando rollup nel backlog di Boards

Le colonne di rollup mostrano barre di stato e/o totali di campi numerici o elementi discendenti all'interno di una gerarchia. Gli elementi discendenti corrispondono a tutti gli elementi figlio all'interno della gerarchia. Una o più colonne di rollup possono essere aggiunte a un backlog di prodotto o portfolio.

Di seguito, ad esempio, viene illustrato Lo stato di avanzamento degli elementi di lavoro che visualizza le barre di stato per gli elementi di lavoro crescente in base alla percentuale di elementi discendenti chiusi. Gli elementi discendenti per Epics includono tutte le funzionalità figlio e gli elementi di lavoro figlio o figlio. Gli elementi discendenti per Funzionalità includono tutte le storie utente figlio e gli elementi di lavoro figlio.

Aggiornamenti live di Taskboard

La scheda attività viene ora aggiornata automaticamente quando si verificano modifiche. Mentre altri membri del team spostano o riordinano le schede nella scheda attività, la scheda aggiornerà automaticamente con queste modifiche. Non è più necessario premere F5 per visualizzare le modifiche più recenti.

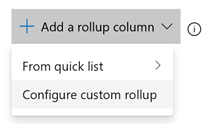

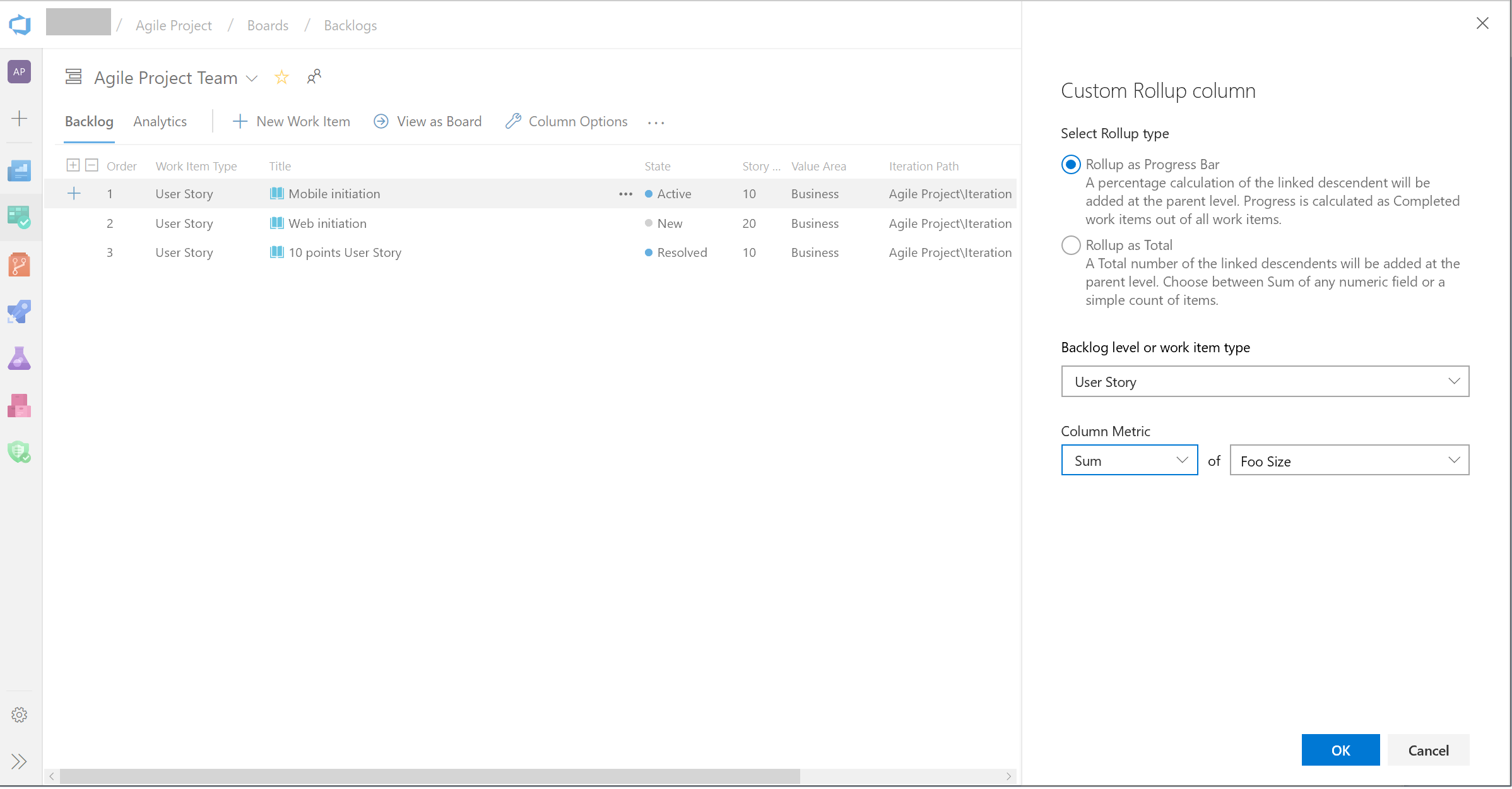

Supporto per i campi personalizzati nelle colonne rollup

È ora possibile eseguire l'rollup in qualsiasi campo, inclusi i campi personalizzati. Quando si aggiunge una colonna Rollup, è comunque possibile selezionare una colonna Rollup dall'elenco Rapido, tuttavia, se si vuole eseguire l'rollup nei campi numerici che non fanno parte del modello di processo out of the box, è possibile configurare il proprio come segue:

- Nel backlog fare clic su "Opzioni di colonna". Nel pannello fare quindi clic su "Aggiungi colonna rollup" e Configurare l'rollup personalizzato.

- Scegliere tra barra di stato e Totale.

- Selezionare un tipo di elemento di lavoro o un livello Backlog (in genere i backlog aggregano diversi tipi di elemento di lavoro).

- Selezionare il tipo di aggregazione. Numero di elementi di lavoro o Sum. Per Sum è necessario selezionare il campo da riepilogare.

- Il pulsante OK consente di tornare al pannello delle opzioni di colonna in cui è possibile riordinare la nuova colonna personalizzata.

Si noti che non è possibile modificare la colonna personalizzata dopo aver fatto clic su OK. Se è necessario apportare una modifica, rimuovere la colonna personalizzata e aggiungere un'altra come desiderato.

Nuova regola per nascondere i campi in un modulo dell'elemento di lavoro in base alla condizione

È stata aggiunta una nuova regola al motore regole ereditate per consentire di nascondere i campi in un modulo dell'elemento di lavoro. Questa regola nasconde i campi in base all'appartenenza al gruppo di utenti. Ad esempio, se l'utente appartiene al gruppo "proprietario del prodotto", è possibile nascondere un campo specifico per sviluppatori. Per altre informazioni, vedere la documentazione qui.

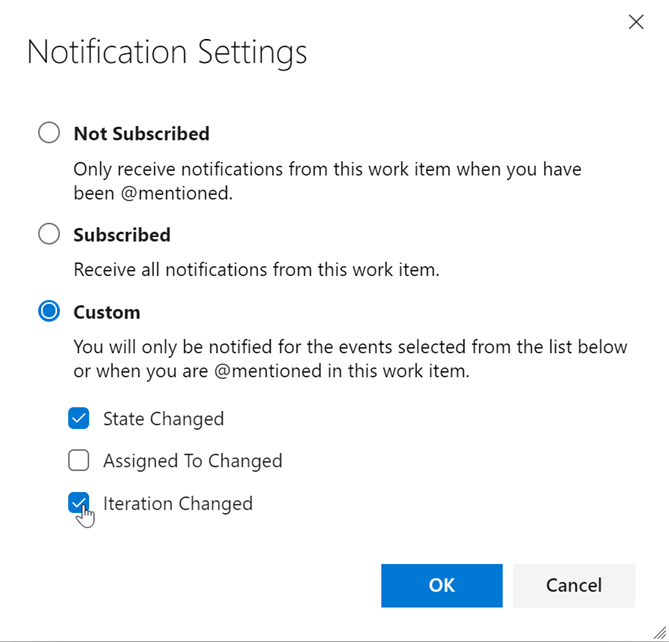

Impostazioni di notifica degli elementi di lavoro personalizzate

Rimanere aggiornati sugli elementi di lavoro rilevanti per l'utente o il team è incredibilmente importante. Aiuta i team a collaborare e rimanere traccia dei progetti e assicura che tutte le parti giuste siano coinvolte. Tuttavia, diversi stakeholder hanno diversi livelli di investimento in diversi sforzi, e riteniamo che sia necessario riflettere nella capacità di seguire lo stato di un elemento di lavoro.

In precedenza, se si vuole seguire un elemento di lavoro e ottenere notifiche su tutte le modifiche apportate, si otterrebbero notifiche di posta elettronica per qualsiasi e tutte le modifiche apportate all'elemento di lavoro. Dopo aver preso in considerazione il feedback, stiamo eseguendo un elemento di lavoro più flessibile per tutti gli stakeholder. A questo punto, verrà visualizzato un nuovo pulsante impostazioni accanto al pulsante Segui nell'angolo superiore destro dell'elemento di lavoro. Verrà visualizzata una finestra popup che consente di configurare le opzioni seguenti.

In Impostazioni di notifica è possibile scegliere tra tre opzioni di notifica. Prima di tutto, puoi essere completamente annullata. In secondo luogo, è possibile essere completamente sottoscritti, in cui si ottengono notifiche per tutte le modifiche all'elemento di lavoro. Infine, è possibile scegliere di ricevere una notifica per alcuni degli eventi di modifica principali e cruciali dell'elemento di lavoro. È possibile selezionare solo una o tutte e tre le opzioni. In questo modo i membri del team seguono gli elementi di lavoro a un livello superiore e non vengono distratti da ogni singola modifica apportata. Con questa funzionalità, elimineremo i messaggi di posta elettronica non necessari e ti permetterà di concentrarsi sulle attività cruciali a mano.

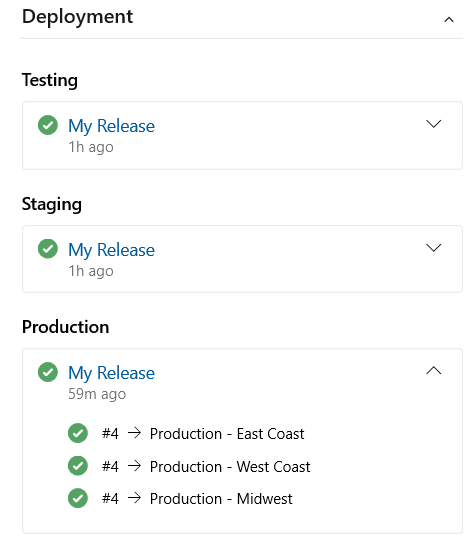

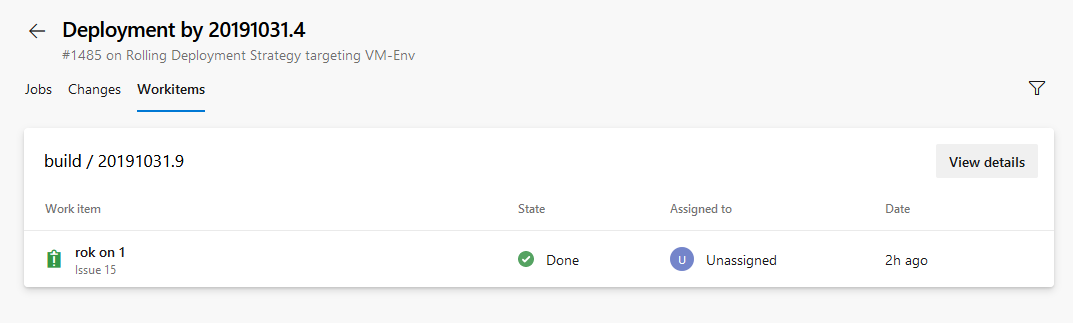

Collegare elementi di lavoro alle distribuzioni

È entusiasta di rilasciare il controllo Distribuzione nel modulo dell'elemento di lavoro. Questo controllo collega gli elementi di lavoro a una versione e consente di tenere traccia facilmente della posizione in cui è stato distribuito l'elemento di lavoro. Per altre informazioni, vedere la documentazione qui.

Importare elementi di lavoro da un file CSV

Fino a questo momento, l'importazione di elementi di lavoro da un file CSV dipende dall'uso del plug-in di Excel. In questo aggiornamento viene fornita un'esperienza di importazione di prima classe direttamente da Azure Boards in modo da poter importare elementi di lavoro nuovi o aggiornare gli elementi di lavoro esistenti. Per altre informazioni, vedere la documentazione qui.

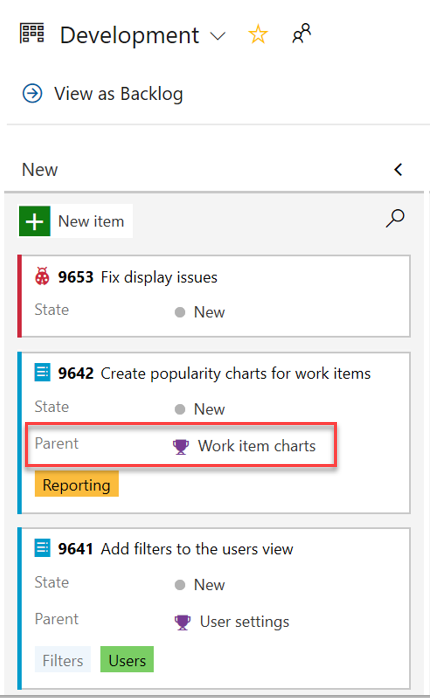

Aggiungere il campo padre alle schede dell'elemento di lavoro

Il contesto padre è ora disponibile nella scheda Kanban come nuovo campo per le schede dell'elemento di lavoro. È ora possibile aggiungere il campo Padre alle schede, ignorando la necessità di usare soluzioni alternative, ad esempio tag e prefissi.

Aggiungere il campo padre al backlog e alle query

Il campo padre è ora disponibile quando si visualizzano i backlog e i risultati delle query. Per aggiungere il campo padre, usare la visualizzazione Opzioni colonna .

Repos

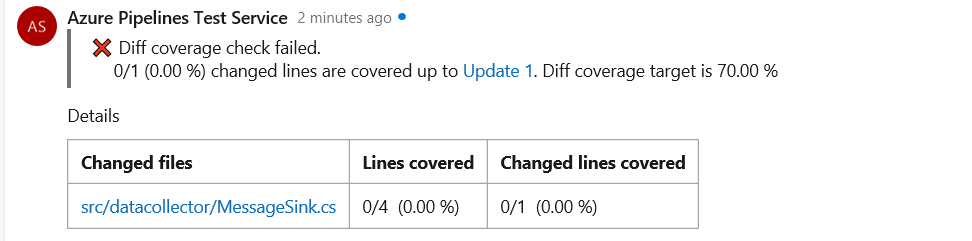

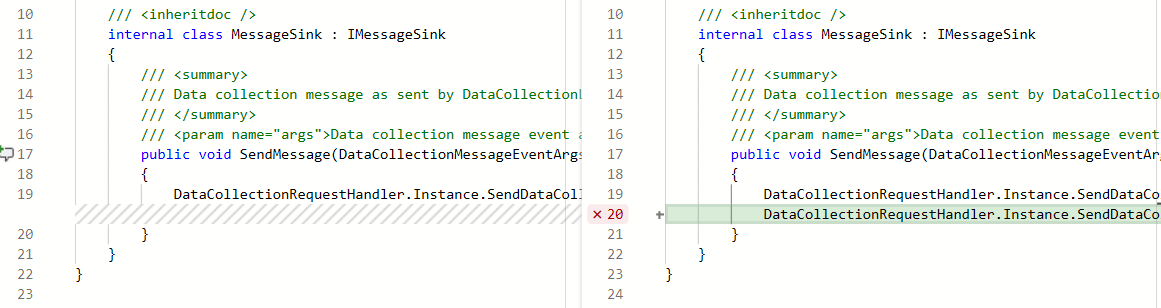

Metriche di code coverage e criteri di ramo per le richieste pull

È ora possibile visualizzare le metriche di code coverage per le modifiche all'interno della visualizzazione richiesta pull (PR). Ciò garantisce che le modifiche siano state testate adeguatamente tramite test automatizzati. Lo stato della copertura verrà visualizzato come commento nella panoramica della richiesta di richiesta. È possibile visualizzare i dettagli delle informazioni di copertura per ogni riga di codice modificata nella visualizzazione diff del file.

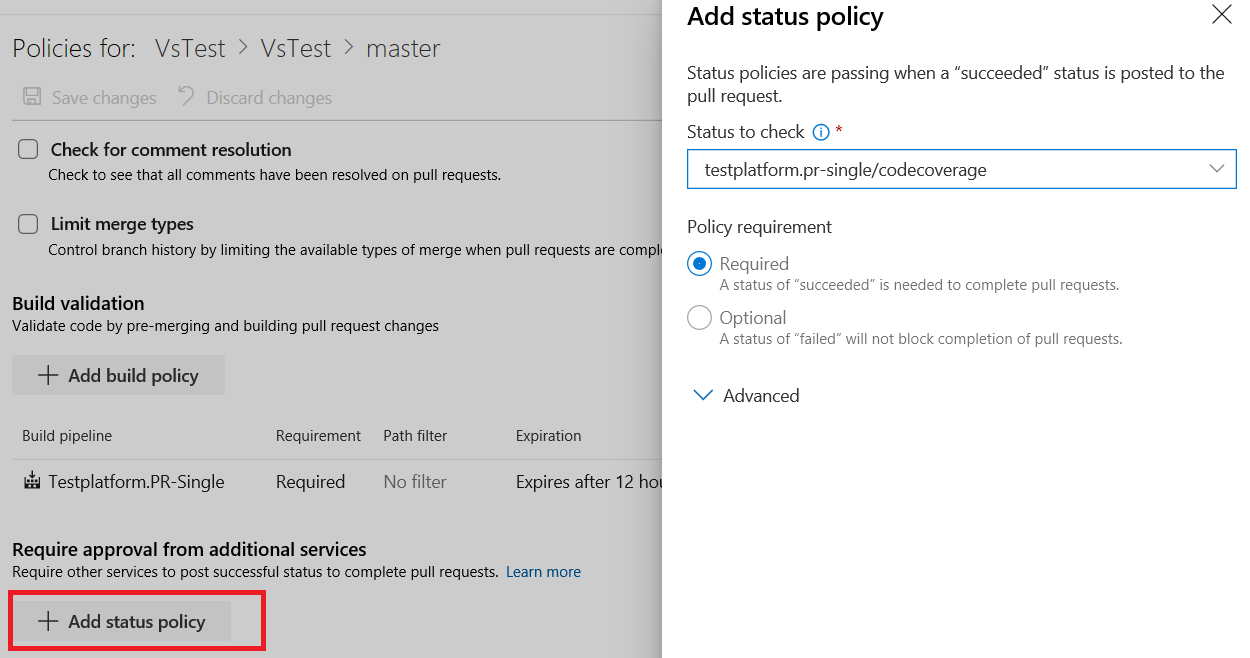

Inoltre, i proprietari del repository possono ora impostare i criteri di code coverage e impedire l'unione di modifiche di grandi dimensioni e non sottoposte a test in un ramo. Le soglie di copertura desiderate possono essere definite in un file di impostazioni archiviato nella radice del repository e dei criteri di copertura possono essere definiti usando la configurazione esistente di un azurepipelines-coverage.ymlcriterio di ramo per funzionalità di servizi aggiuntivi in Azure Repos.

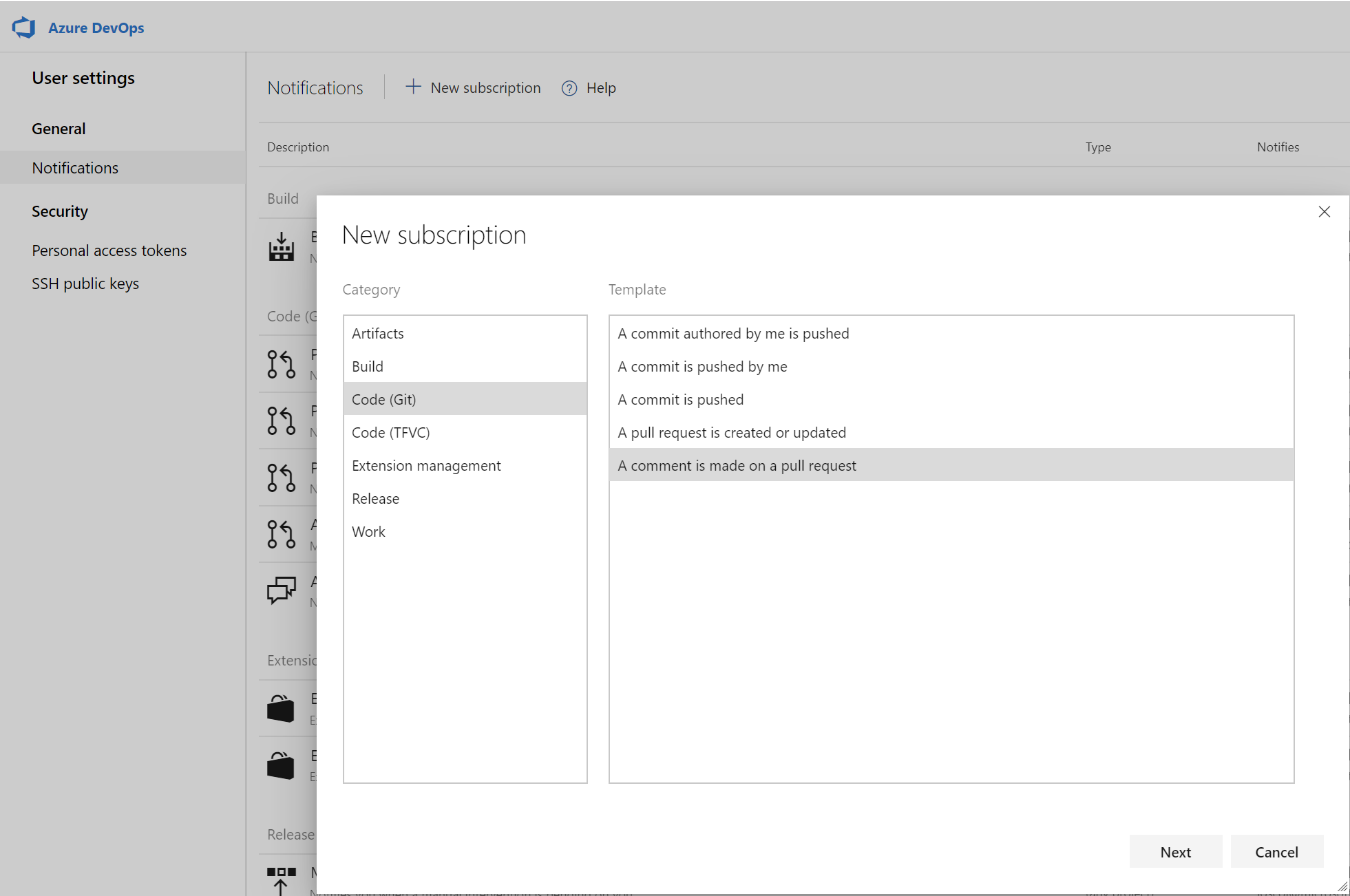

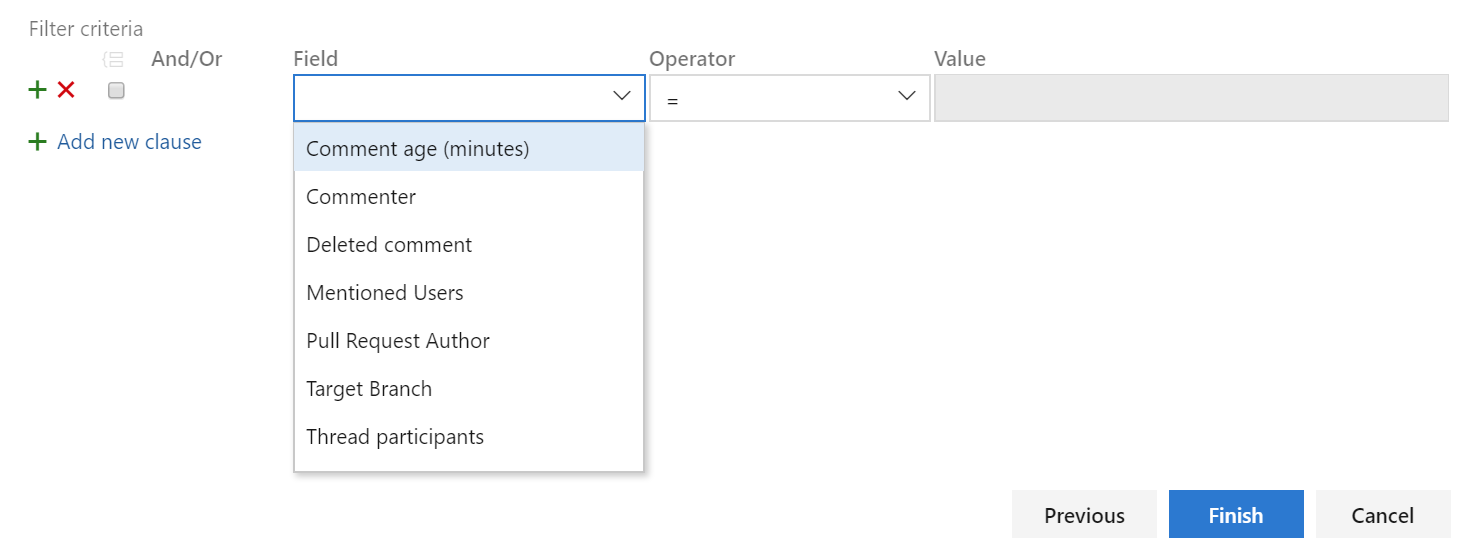

Filtrare le notifiche di commento dalle richieste pull

I commenti nelle richieste pull possono spesso generare un sacco di rumore a causa delle notifiche. È stata aggiunta una sottoscrizione personalizzata che consente di filtrare le notifiche di commento che si sottoscrivono in base all'età dei commenti, al commento, ai commenti eliminati, agli utenti menzionati, all'autore della richiesta pull, al ramo di destinazione e ai partecipanti al thread. È possibile creare queste sottoscrizioni di notifica facendo clic sull'icona utente nell'angolo superiore destro e passando a Impostazioni utente.

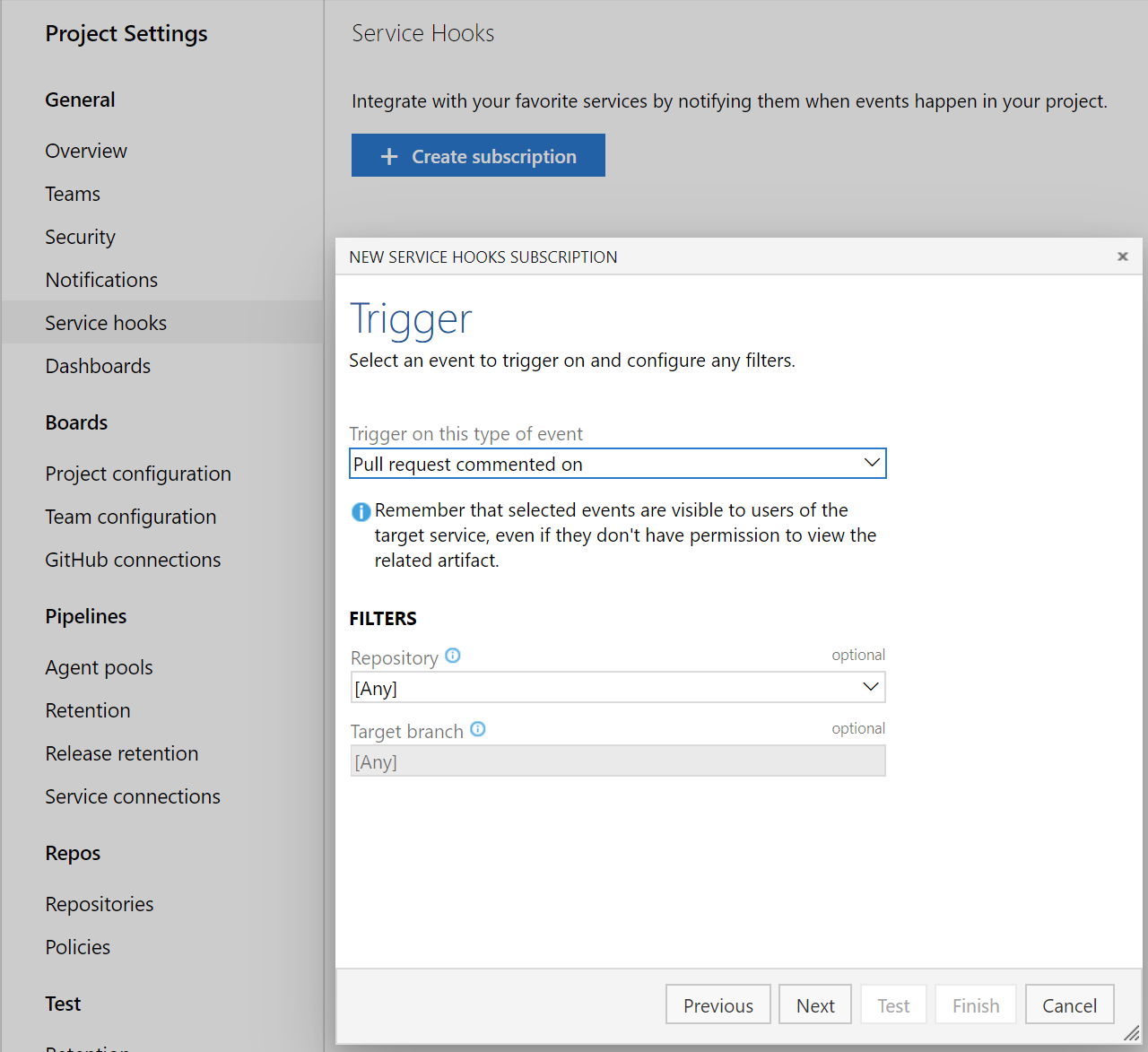

Hook di servizio per i commenti delle richieste pull

È ora possibile creare hook di servizio per i commenti in una richiesta pull in base al repository e al ramo di destinazione.

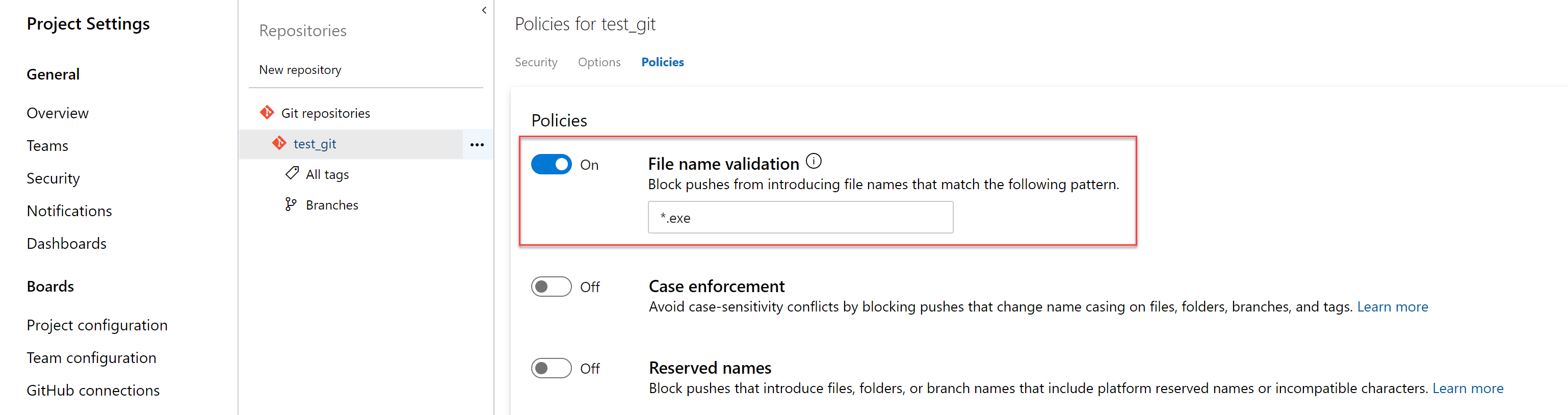

Criteri per bloccare i file con modelli specificati

Gli amministratori possono ora impostare un criterio per impedire il push dei commit in un repository in base ai tipi di file e ai percorsi. I criteri di convalida del nome file bloccano i push corrispondenti al modello specificato.

Risolvere gli elementi di lavoro tramite commit usando parole chiave

È ora possibile risolvere gli elementi di lavoro tramite commit eseguiti nel ramo predefinito usando parole chiave come correzione, correzioni o correzioni. Ad esempio, è possibile scrivere : "questa modifica è stata fissa #476" nel messaggio di commit e nell'elemento di lavoro #476 verrà completata quando il commit viene eseguito il push o l'unione nel ramo predefinito. Per altre informazioni, vedere la documentazione qui.

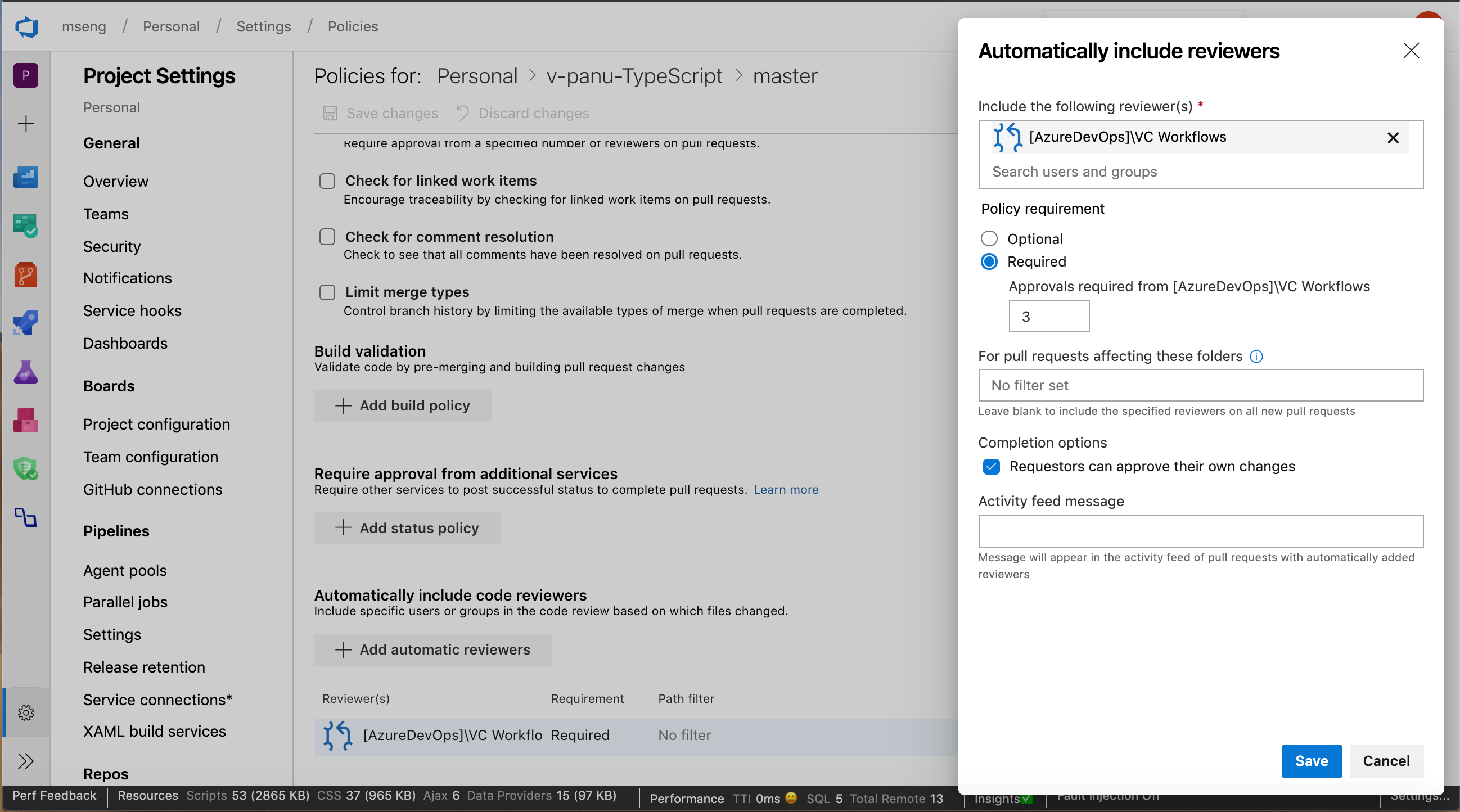

Granularità per i revisori automatici

In precedenza, quando si aggiungono revisori a livello di gruppo a una richiesta pull, è stata necessaria un'approvazione solo dal gruppo aggiunto. È ora possibile impostare criteri che richiedono più revisori da un team per approvare una richiesta pull quando si aggiungono revisori automatici. È inoltre possibile aggiungere un criterio per impedire ai richiedenti di approvare le proprie modifiche.

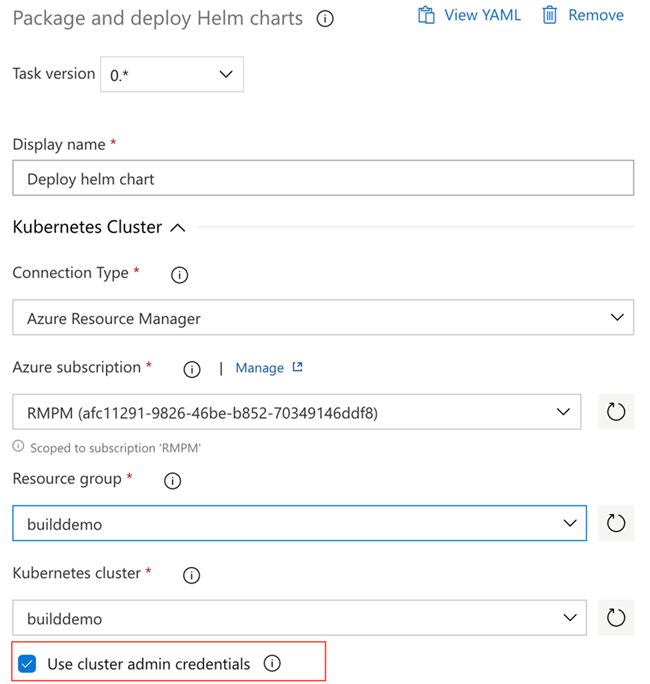

Usare l'autenticazione basata su account del servizio per connettersi al servizio Azure Kubernetes

In precedenza, durante la configurazione di Azure Pipelines dal Centro distribuzione del servizio Azure Kubernetes, è stata usata una connessione di Azure Resource Manager. Questa connessione ha avuto accesso all'intero cluster e non solo allo spazio dei nomi per cui è stata configurata la pipeline. Con questo aggiornamento, le pipeline useranno l'autenticazione basata su account del servizio per connettersi al cluster in modo che abbia accesso solo allo spazio dei nomi associato alla pipeline.

Anteprima dei file markdown nella richiesta pull diff side-by-side

È ora possibile visualizzare un'anteprima di come verrà visualizzato un file markdown usando il nuovo pulsante Anteprima . Inoltre, è possibile visualizzare il contenuto completo di un file dalla diff side-by-side selezionando il pulsante Visualizza .

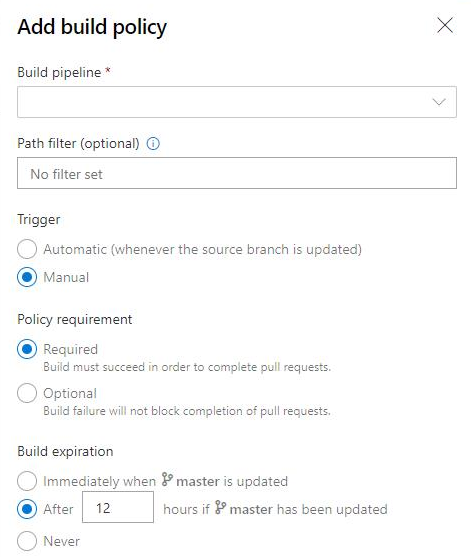

Scadenza dei criteri di compilazione per le compilazioni manuali

I criteri applicano gli standard di qualità del codice e di gestione delle modifiche del team. In precedenza, è possibile impostare criteri di scadenza per le compilazioni automatizzate. È ora possibile impostare i criteri di scadenza della compilazione per le compilazioni manuali.

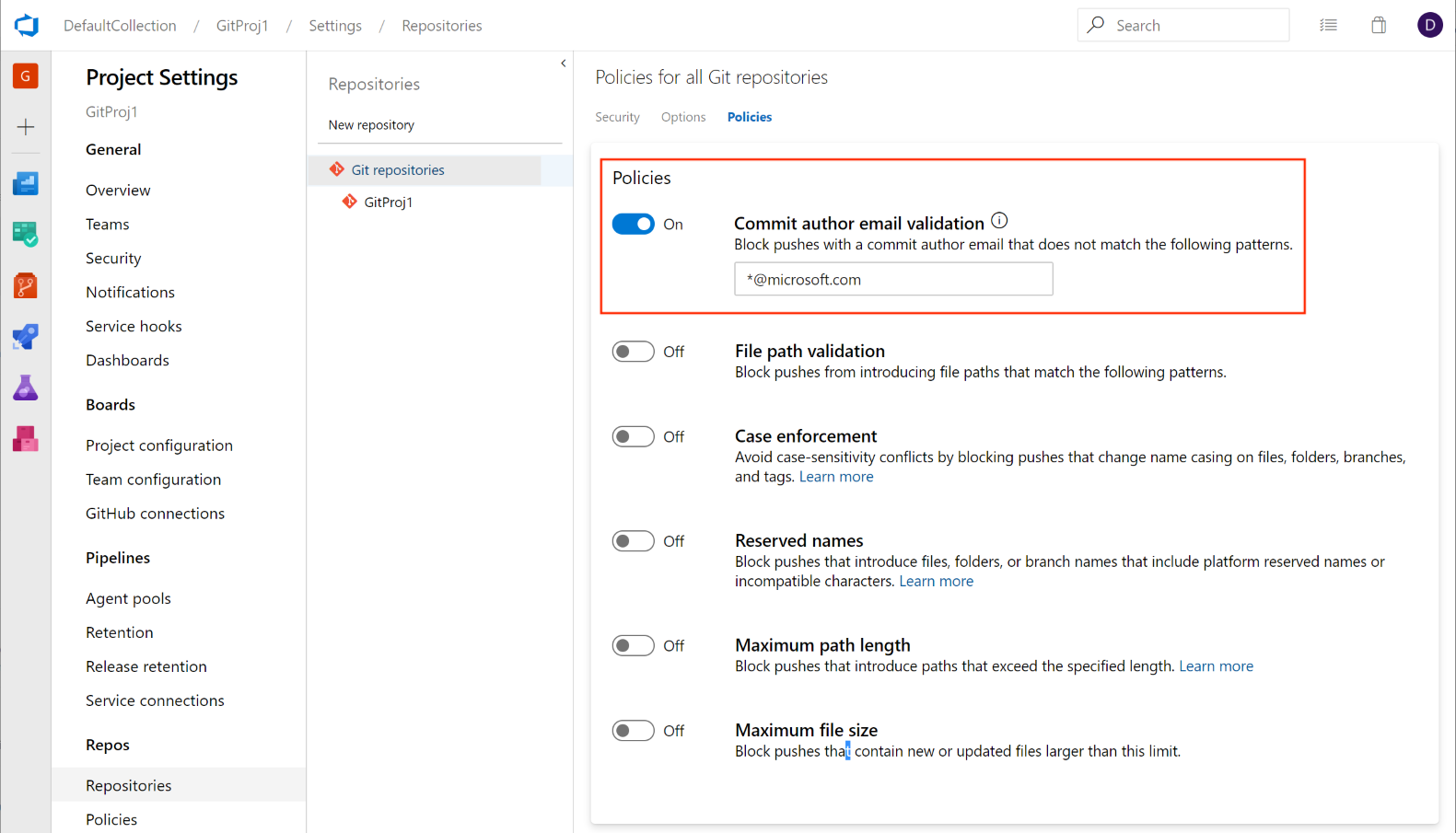

Aggiungere un criterio per bloccare i commit in base al messaggio di posta elettronica dell'autore del commit

Gli amministratori possono ora impostare un criterio push per impedire il push dei commit in un repository per il quale il messaggio di posta elettronica dell'autore del commit non corrisponde al modello specificato.

Questa funzionalità è stata prioritaria in base a un suggerimento del Developer Community per offrire un'esperienza simile. Continuerà a mantenere aperto il ticket e incoraggiare gli utenti a indicare quali altri tipi di criteri push si desidera visualizzare.

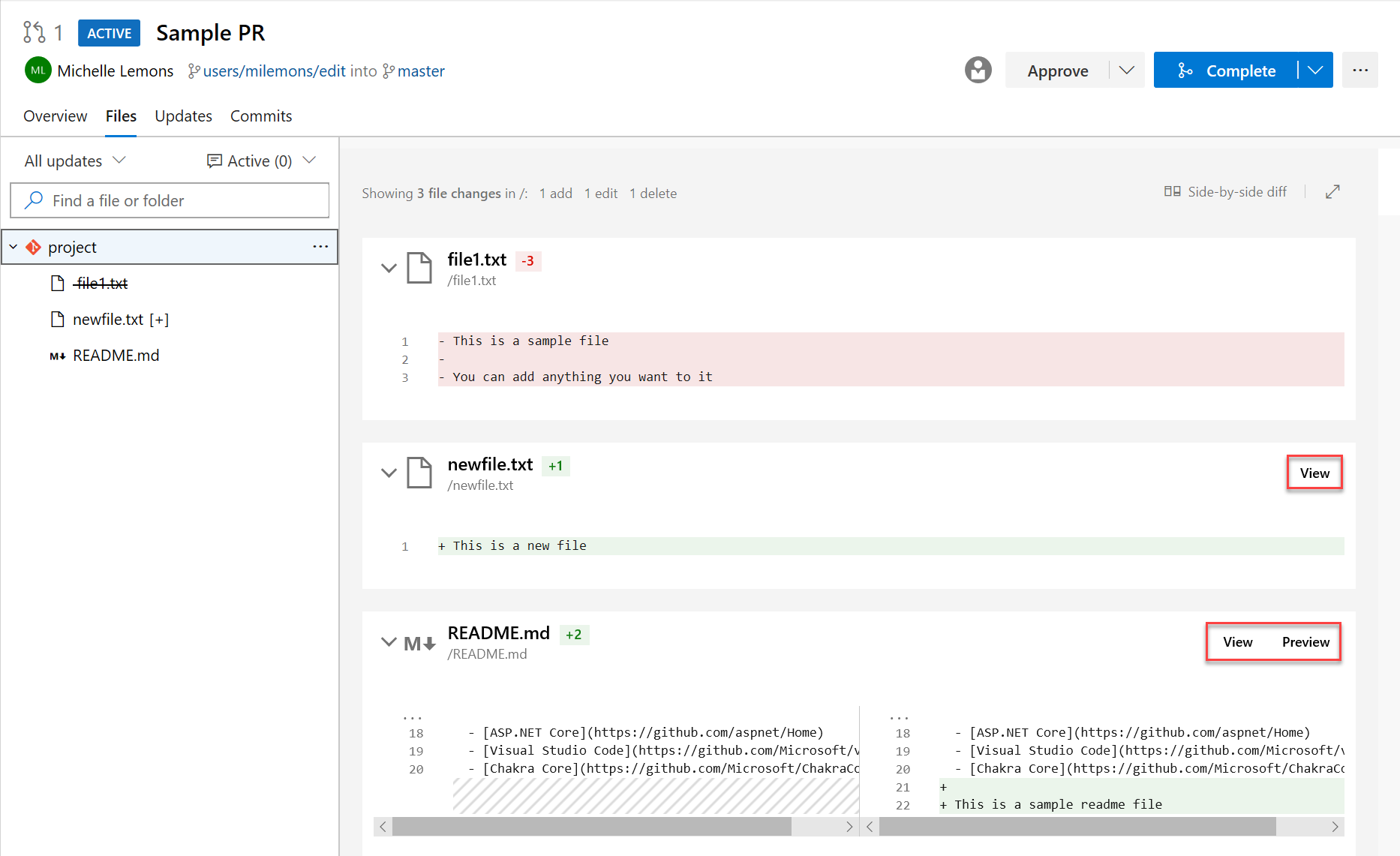

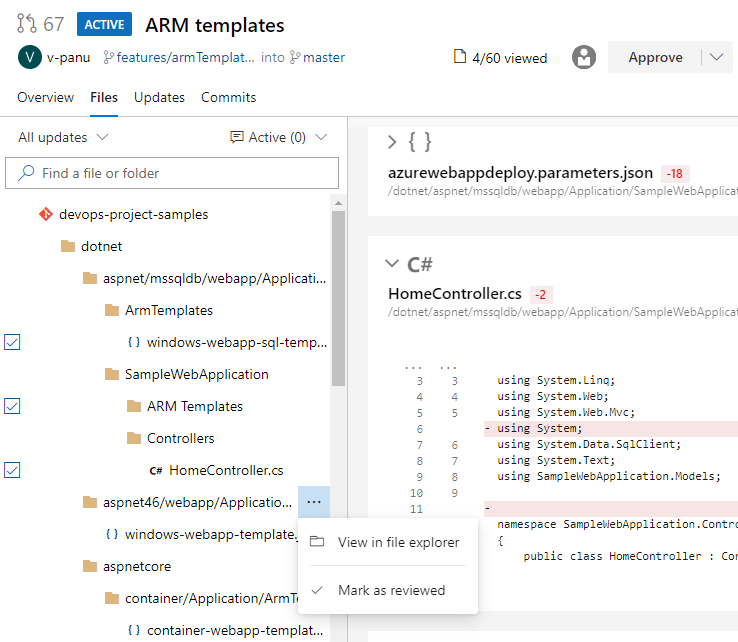

Contrassegnare i file come esaminati in una richiesta pull

A volte, è necessario esaminare le richieste pull che contengono modifiche a un numero elevato di file e può essere difficile tenere traccia dei file già esaminati. Ora è possibile contrassegnare i file come esaminati in una richiesta pull.

È possibile contrassegnare un file come esaminato usando il menu a discesa accanto a un nome file o facendo clic sul nome del file.

Nota

Questa funzionalità è destinata solo a tenere traccia dello stato di avanzamento durante la revisione di una richiesta pull. Non rappresenta il voto sulle richieste pull, pertanto questi contrassegni saranno visibili solo al revisore.

Questa funzionalità è stata prioritaria in base a un suggerimento del Developer Community.

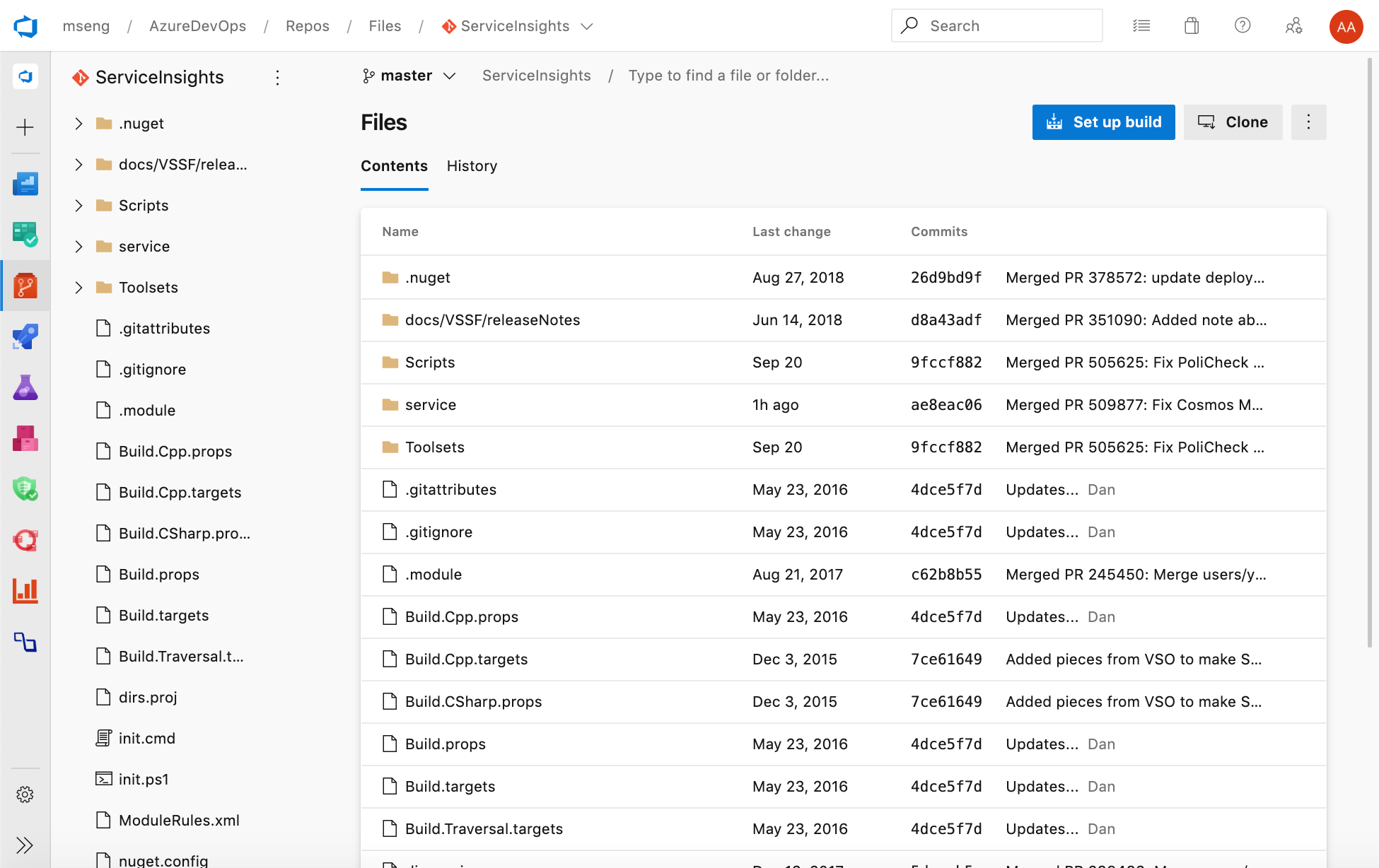

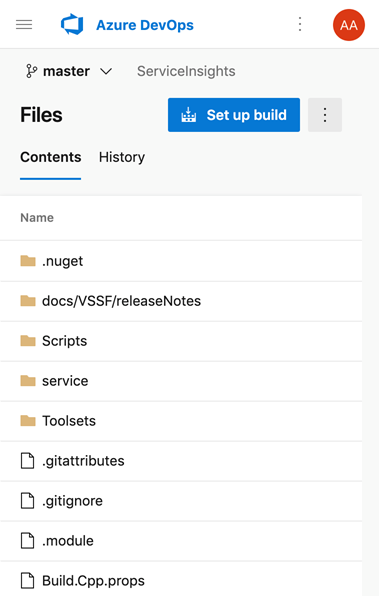

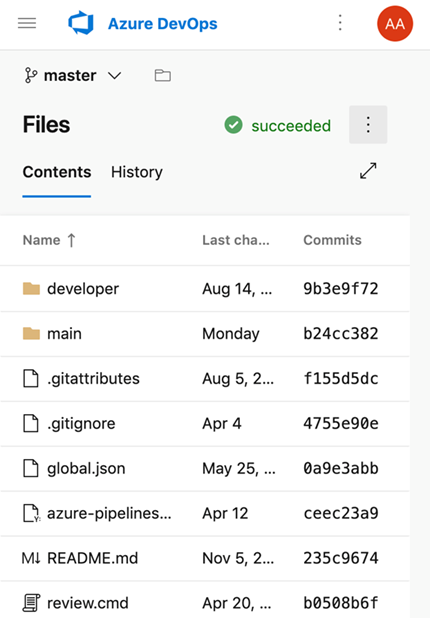

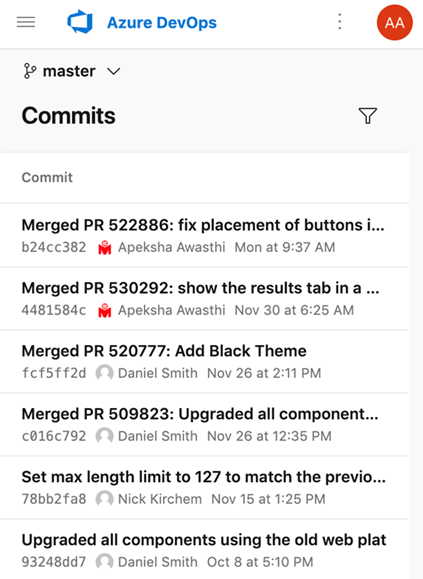

Nuova interfaccia utente Web per le pagine di destinazione Azure Repos

È ora possibile provare le nuove pagine di destinazione moderne, veloci e per dispositivi mobili all'interno di Azure Repos. Queste pagine sono disponibili come pagine di destinazione New Repos. Le pagine di destinazione includono tutte le pagine, ad eccezione dei dettagli della richiesta pull, dei dettagli del commit e del confronto tra rami.

Web

Dispositivi mobili

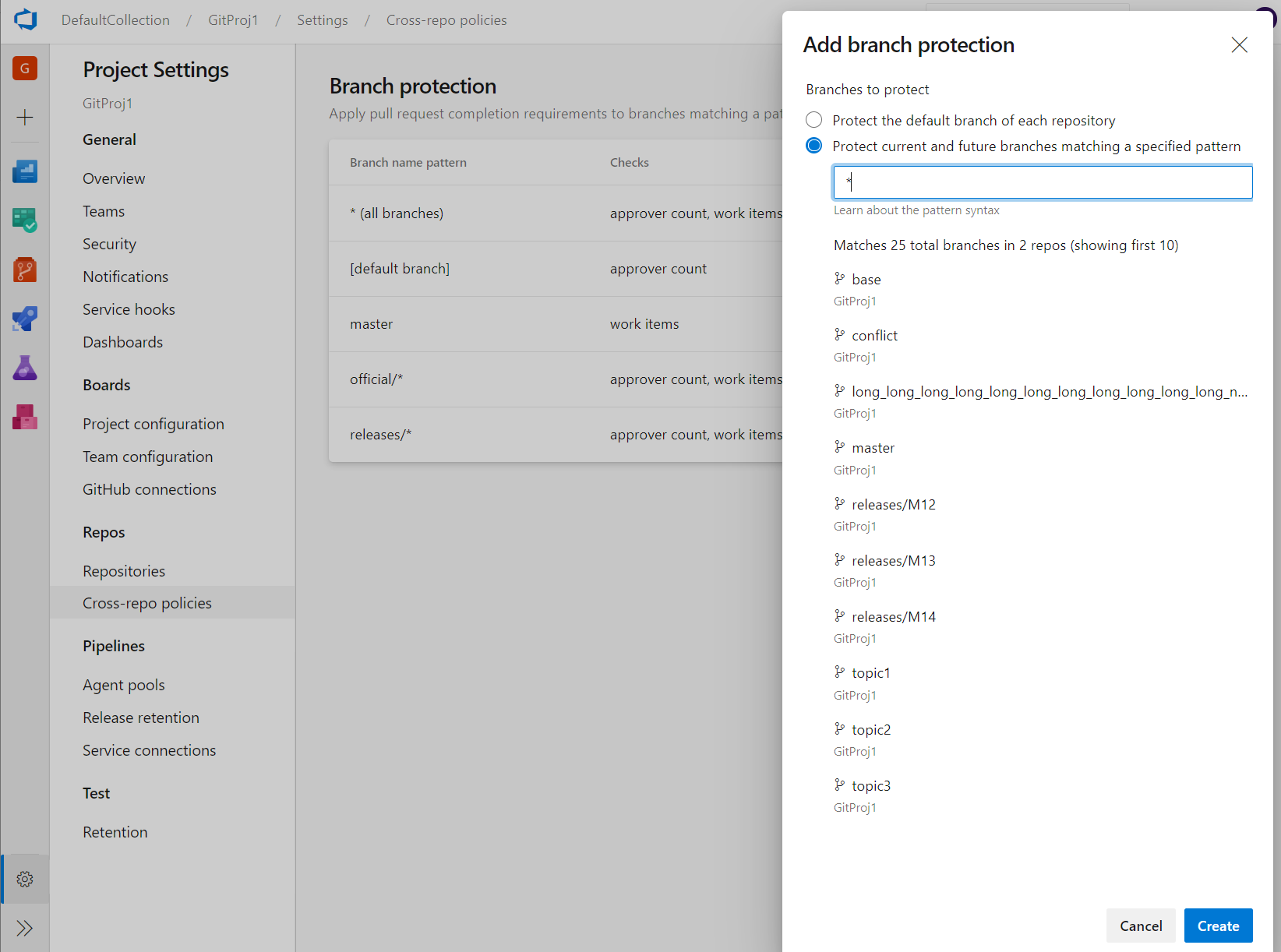

Amministrazione dei criteri di ramo tra repository

I criteri di ramo sono una delle potenti funzionalità di Azure Repos che consentono di proteggere rami importanti. Anche se la possibilità di impostare i criteri a livello di progetto esiste nell'API REST, non esiste alcuna interfaccia utente. A questo punto, gli amministratori possono impostare criteri in un ramo specifico o nel ramo predefinito in tutti i repository nel progetto. Ad esempio, un amministratore potrebbe richiedere due revisori minimi per tutte le richieste pull effettuate in ogni ramo principale in ogni repository nel progetto. È possibile trovare la funzionalità Aggiungi protezione ramo nelle impostazioni del progetto Repos.

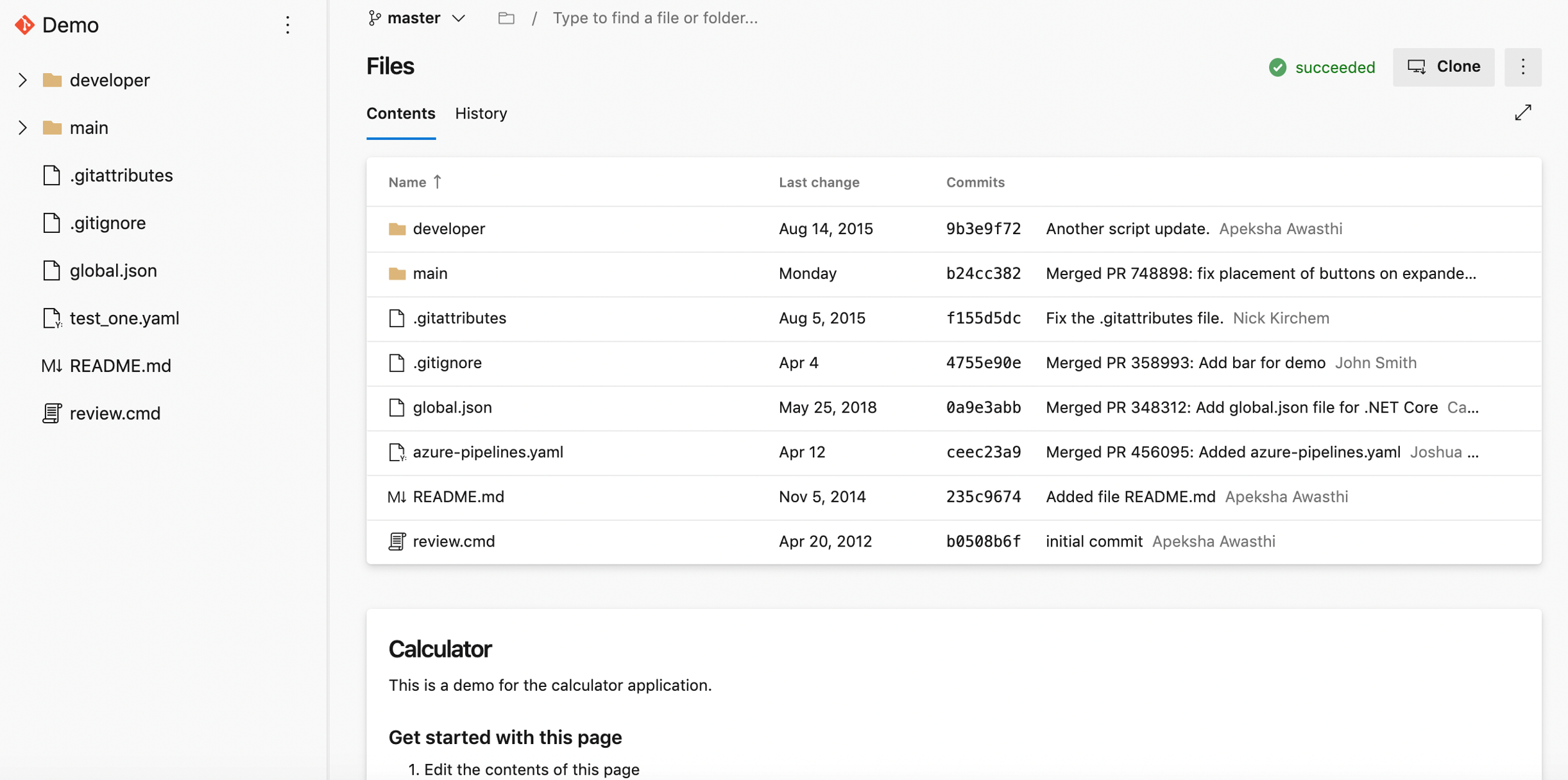

Nuove pagine di destinazione della piattaforma Web

L'esperienza utente delle pagine di destinazione repos è stata aggiornata per renderla moderna, veloce e semplice per dispositivi mobili. Ecco due esempi delle pagine aggiornate, continueremo ad aggiornare altre pagine negli aggiornamenti futuri.

Esperienza Web:

Esperienza per dispositivi mobili:

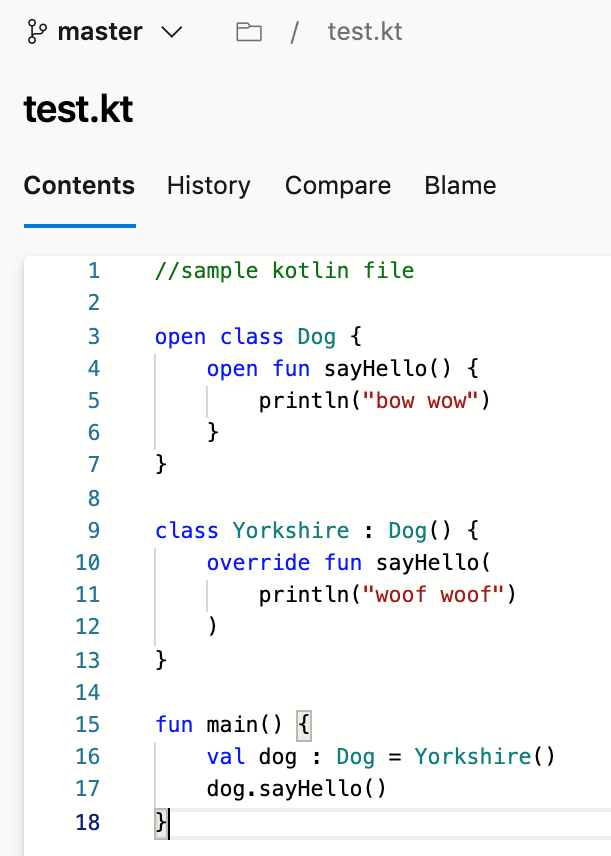

Supporto per il linguaggio Kotlin

Siamo lieti di annunciare che ora supportiamo l'evidenziazione del linguaggio Kotlin nell'editor di file. L'evidenziazione migliora la leggibilità del file di testo Kotlin e consente di analizzare rapidamente gli errori. Questa funzionalità è stata prioritaria in base a un suggerimento del Developer Community.

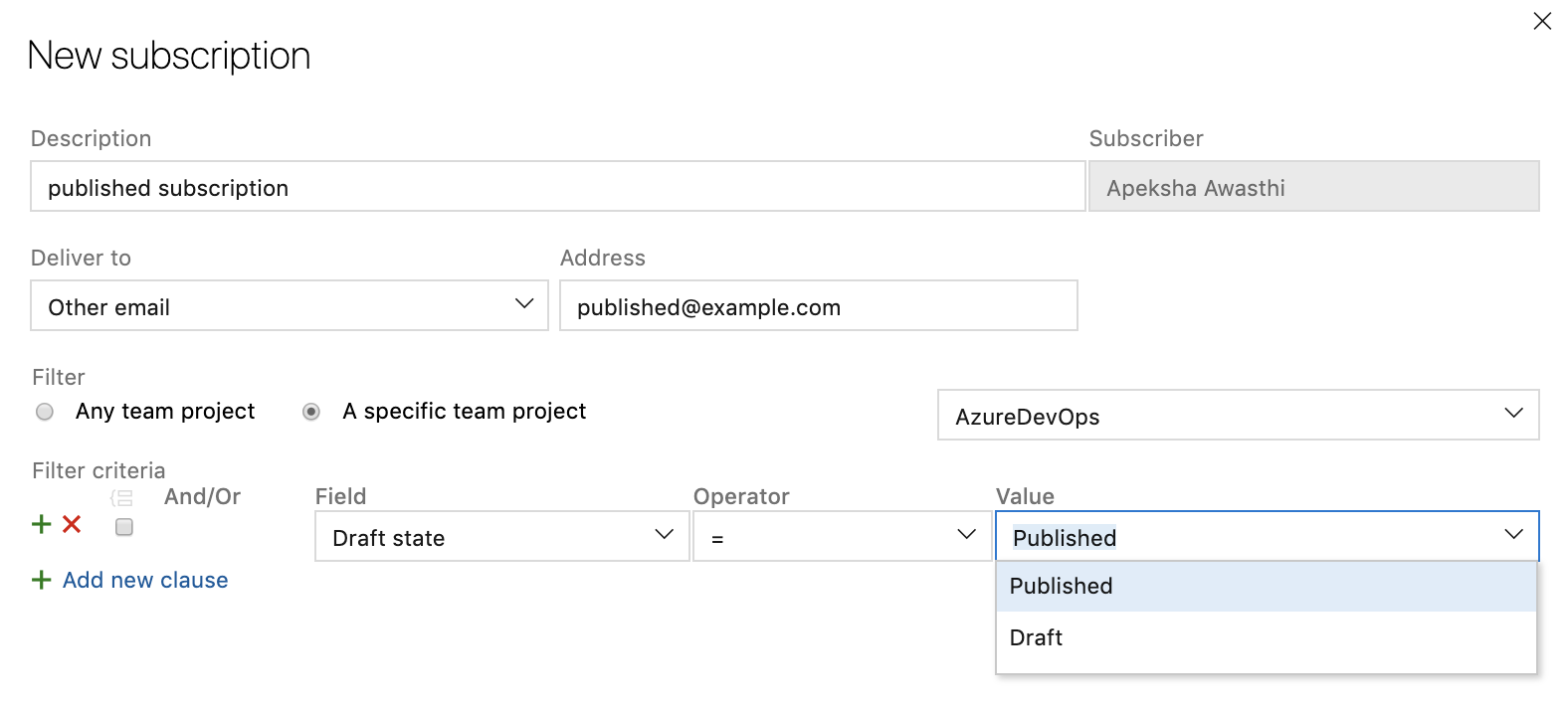

Sottoscrizione di notifica personalizzata per le richieste pull bozza

Per ridurre il numero di notifiche di posta elettronica da richieste pull, è ora possibile creare una sottoscrizione di notifica personalizzata per le richieste pull create o aggiornate nello stato bozza. È possibile ricevere messaggi di posta elettronica in particolare per le richieste pull bozza o filtrare i messaggi di posta elettronica dalle richieste pull bozza, in modo che il team non riceva una notifica prima che la richiesta pull sia pronta per essere esaminata.

Miglioramento dell'azione pr

Quando si hanno molte richieste pull da esaminare, comprendere dove eseguire l'azione prima può essere difficile. Per migliorare l'azione delle richieste pull, è ora possibile creare più query personalizzate nella pagina elenco richieste pull con diverse nuove opzioni da filtrare, ad esempio lo stato bozza. Queste query creeranno sezioni separate e collapible nella pagina della richiesta pull oltre a "Create by me" e "Assigned to me". È anche possibile rifiutare di esaminare una richiesta pull aggiunta tramite il menu Voto o il menu di scelta rapida nella pagina elenco richieste pull. Nelle sezioni personalizzate verranno ora visualizzate schede separate per le richieste pull fornite o rifiutate per la revisione. Queste query personalizzate funzioneranno tra repository nella scheda "Richieste pull personali" della home page della raccolta. Se si vuole tornare a una richiesta pull, è possibile contrassegnarlo e verrà visualizzato nella parte superiore dell'elenco. Infine, le richieste pull impostate sul completamento automatico verranno contrassegnate con una pillola che indica "Completamento automatico" nell'elenco.

Pipelines

Pipeline a più fasi

Si è lavorato su un'esperienza utente aggiornata per gestire le pipeline. Questi aggiornamenti rendono le pipeline moderne e coerenti con la direzione di Azure DevOps. Inoltre, questi aggiornamenti mettono insieme pipeline di compilazione classiche e pipeline YAML a più fasi in un'unica esperienza. È compatibile con dispositivi mobili e offre vari miglioramenti alla gestione delle pipeline. È possibile eseguire il drill-down e visualizzare i dettagli della pipeline, i dettagli dell'esecuzione, l'analisi della pipeline, i dettagli del processo, i log e altro ancora.

Le funzionalità seguenti sono incluse nella nuova esperienza:

- visualizzazione e gestione di più fasi

- approvazione delle esecuzioni della pipeline

- scorrere tutto il modo indietro nei log mentre una pipeline è ancora in corso

- Integrità per ramo di una pipeline.

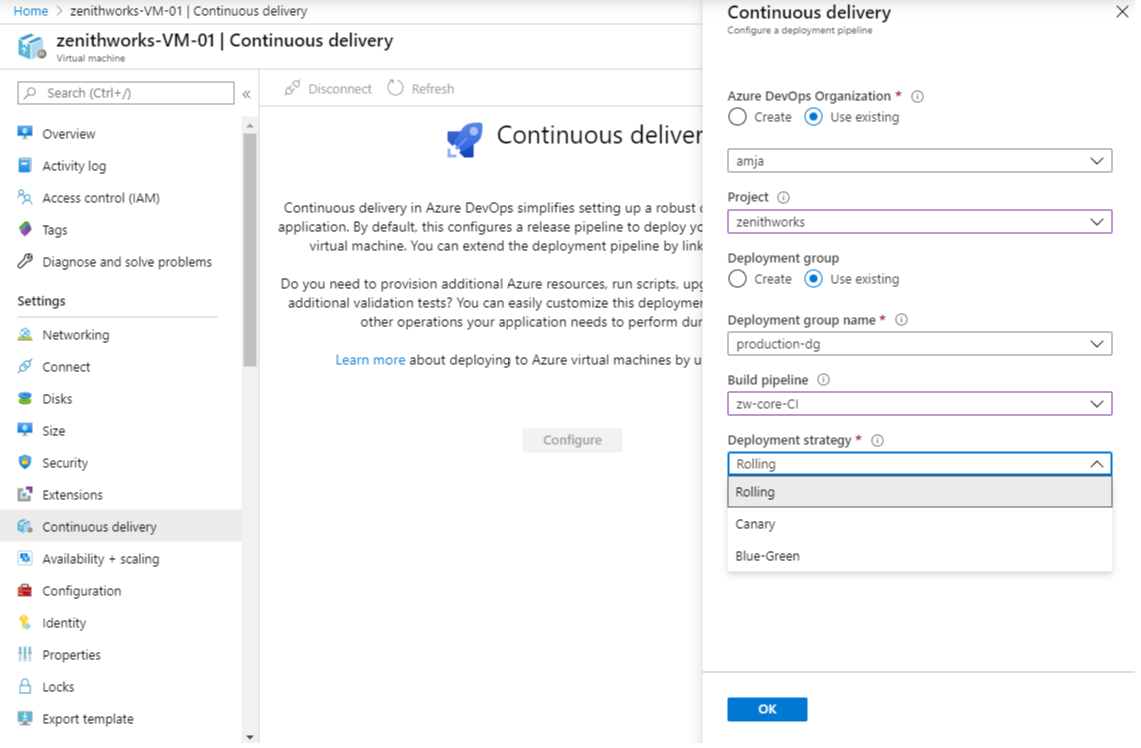

Distribuzione continua in YAML

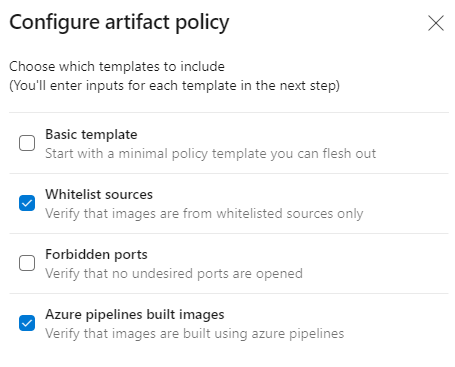

Siamo lieti di fornire funzionalità YAML di Azure Pipelines. Ora offriamo un'esperienza YAML unificata in modo da poter configurare ognuna delle pipeline in modo da eseguire insieme CI, CD o CI e CD. Le funzionalità di YAML CD introducono diverse nuove funzionalità avanzate disponibili per tutte le raccolte usando pipeline YAML a più fasi. Tra le caratteristiche principali:

- Pipeline YAML a più fasi (per CI e CD)

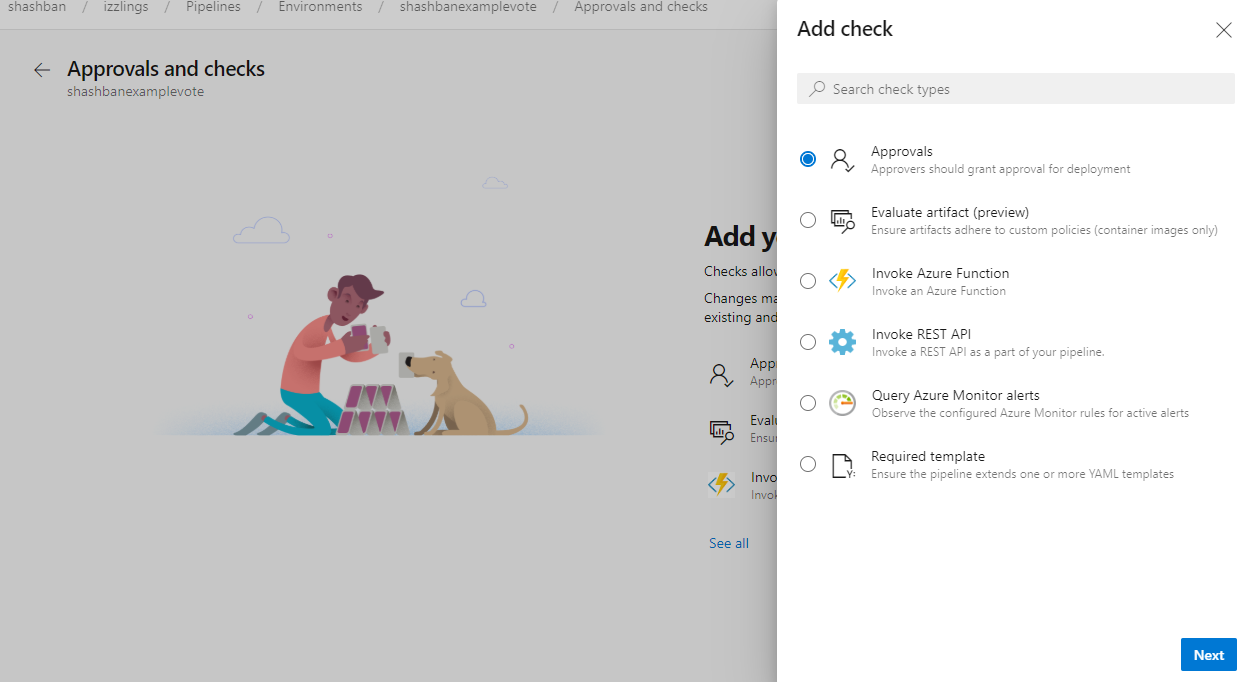

- Approvazioni e controlli sulle risorse

- Ambienti e strategie di distribuzione

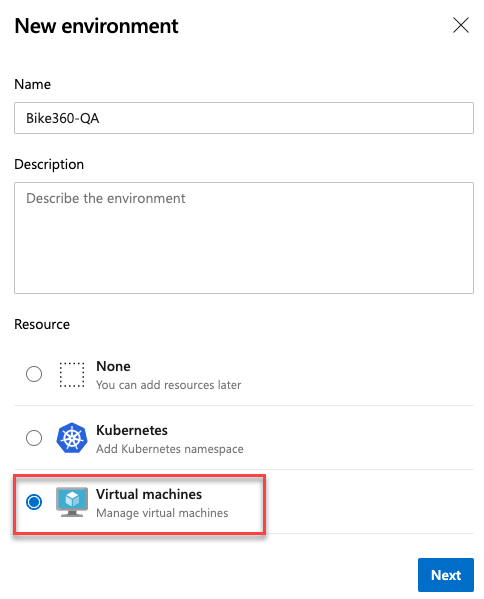

- Risorse di Kubernetes e macchina virtuale nell'ambiente

- Esaminare le app per la collaborazione

- Esperienza utente aggiornata per le connessioni al servizio

- Risorse nelle pipeline YAML

Se si è pronti per iniziare la compilazione, consultare la documentazione o il blog per la creazione di pipeline CI/CD a più fasi.

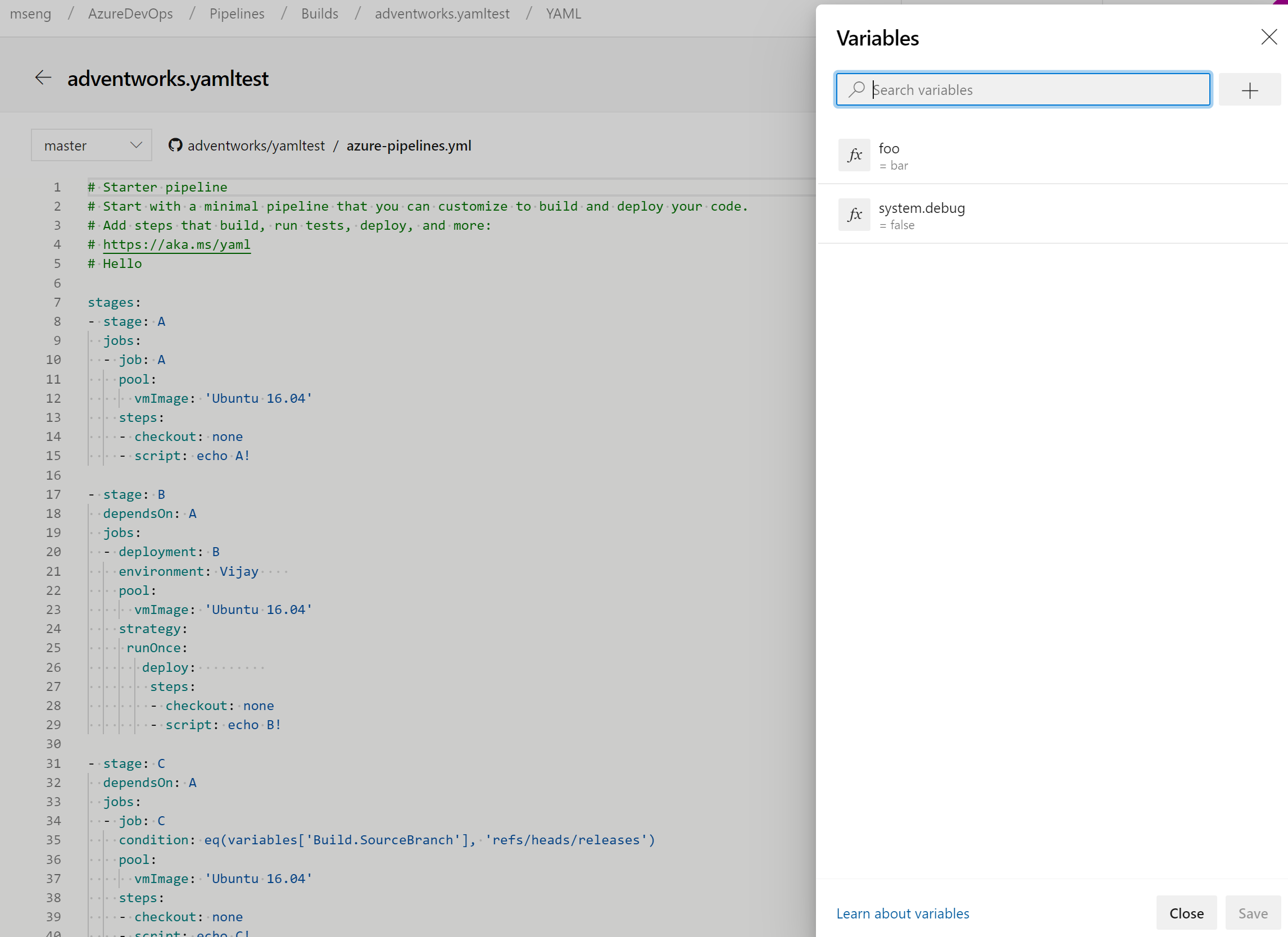

Gestire le variabili della pipeline nell'editor YAML

È stata aggiornata l'esperienza per la gestione delle variabili della pipeline nell'editor YAML. Non è più necessario passare all'editor classico per aggiungere o aggiornare variabili nelle pipeline YAML.

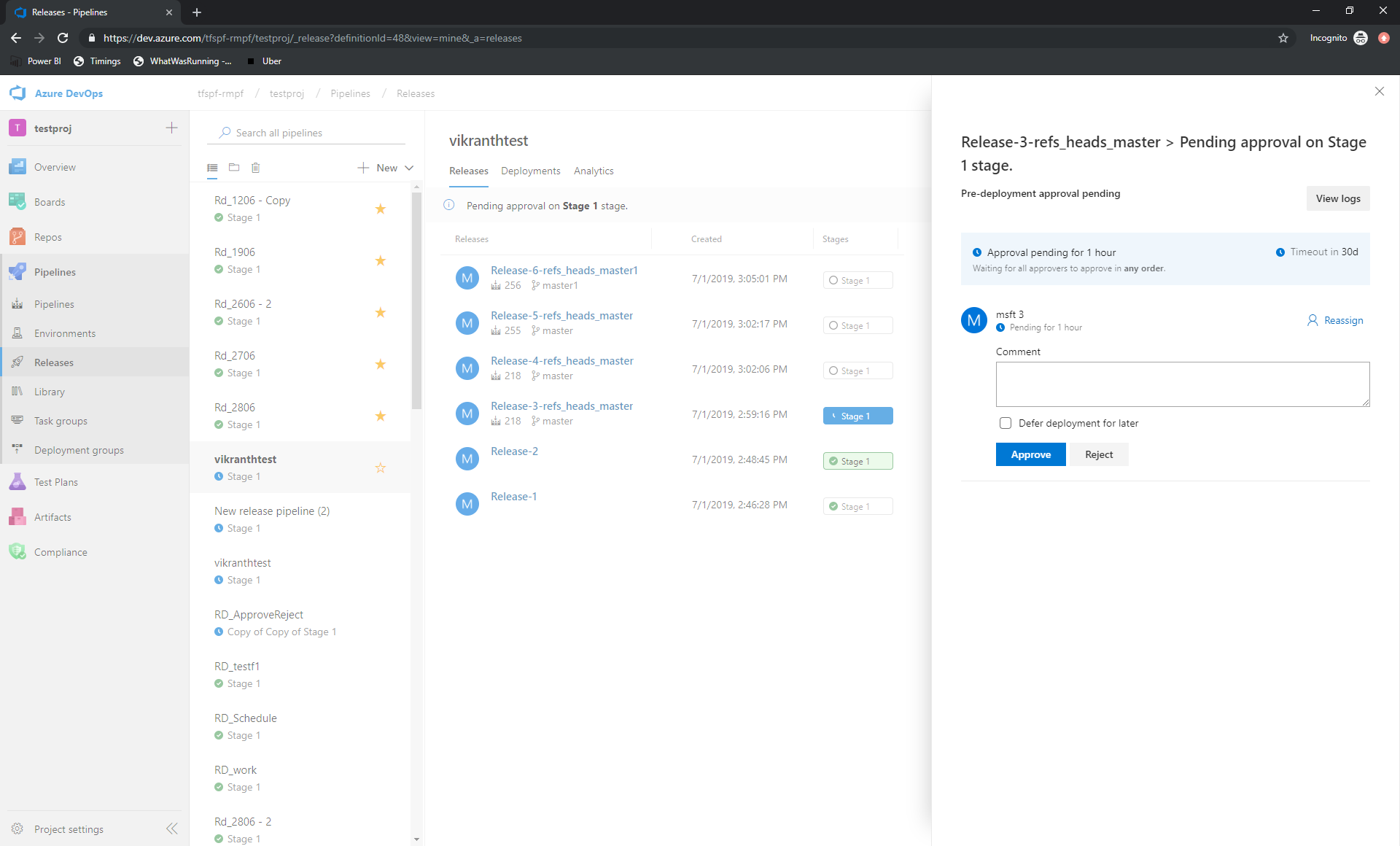

Approvare le versioni direttamente dall'hub Delle versioni

L'azione sulle approvazioni in sospeso è stata resa più semplice. In precedenza era possibile approvare una versione dalla pagina dei dettagli della versione. È ora possibile approvare le versioni direttamente dall'hub Delle versioni.

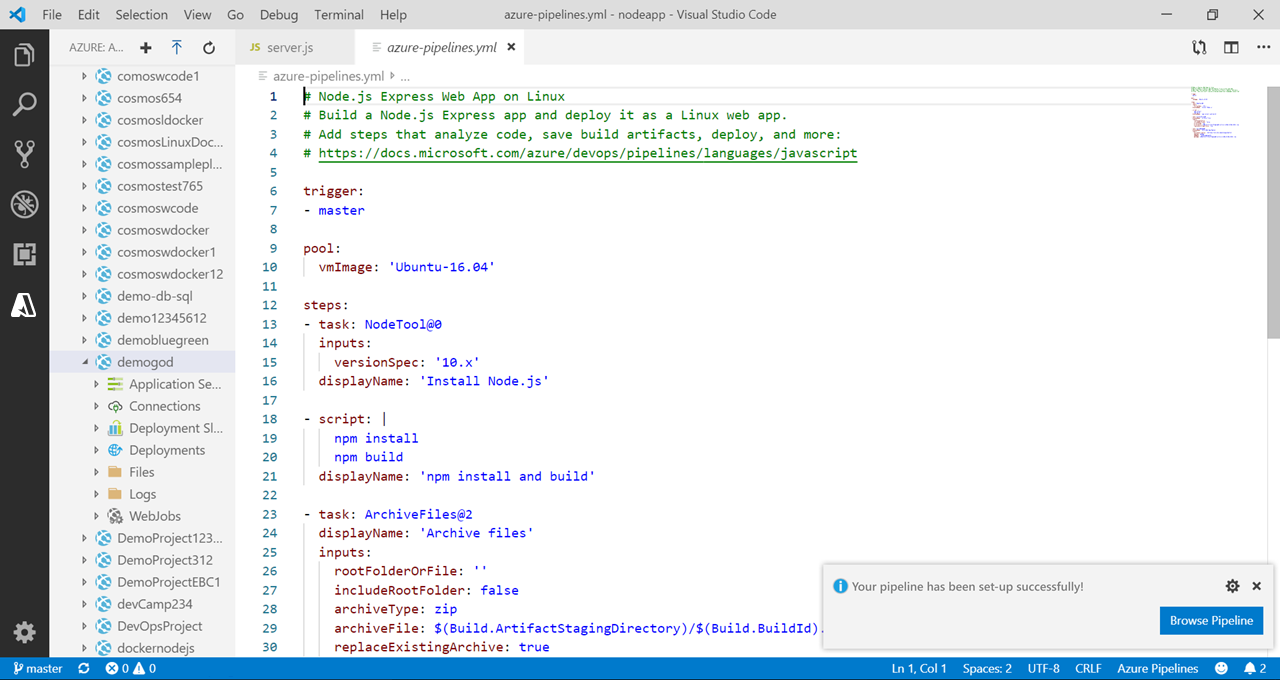

Miglioramenti apportati all'introduzione alle pipeline

Una richiesta comune con la procedura guidata introduttiva è stata la possibilità di rinominare il file generato. Attualmente, viene archiviato come azure-pipelines.yml nella radice del repository. È ora possibile aggiornare il file in un percorso o un nome file diverso prima di salvare la pipeline.

Infine, si avrà più controllo quando si archivia il azure-pipelines.yml file in un ramo diverso perché è possibile scegliere di ignorare la creazione di una richiesta pull da tale ramo.

Anteprima del documento YAML completamente analizzato senza eseguire il commit o l'esecuzione della pipeline

È stata aggiunta un'anteprima ma non la modalità di esecuzione per le pipeline YAML. È ora possibile provare una pipeline YAML senza eseguirne il commit in un repository o eseguirlo. Data una pipeline esistente e un nuovo payload YAML facoltativo, questa nuova API restituirà la pipeline YAML completa. Negli aggiornamenti futuri questa API verrà usata in una nuova funzionalità dell'editor.

Per gli sviluppatori: POST a con un corpo JSON simile al dev.azure.com/<org>/<project>/_apis/pipelines/<pipelineId>/runs?api-version=5.1-preview seguente:

{

"PreviewRun": true,

"YamlOverride": "

# your new YAML here, optionally

"

}

La risposta conterrà il codice YAML sottoposto a rendering.

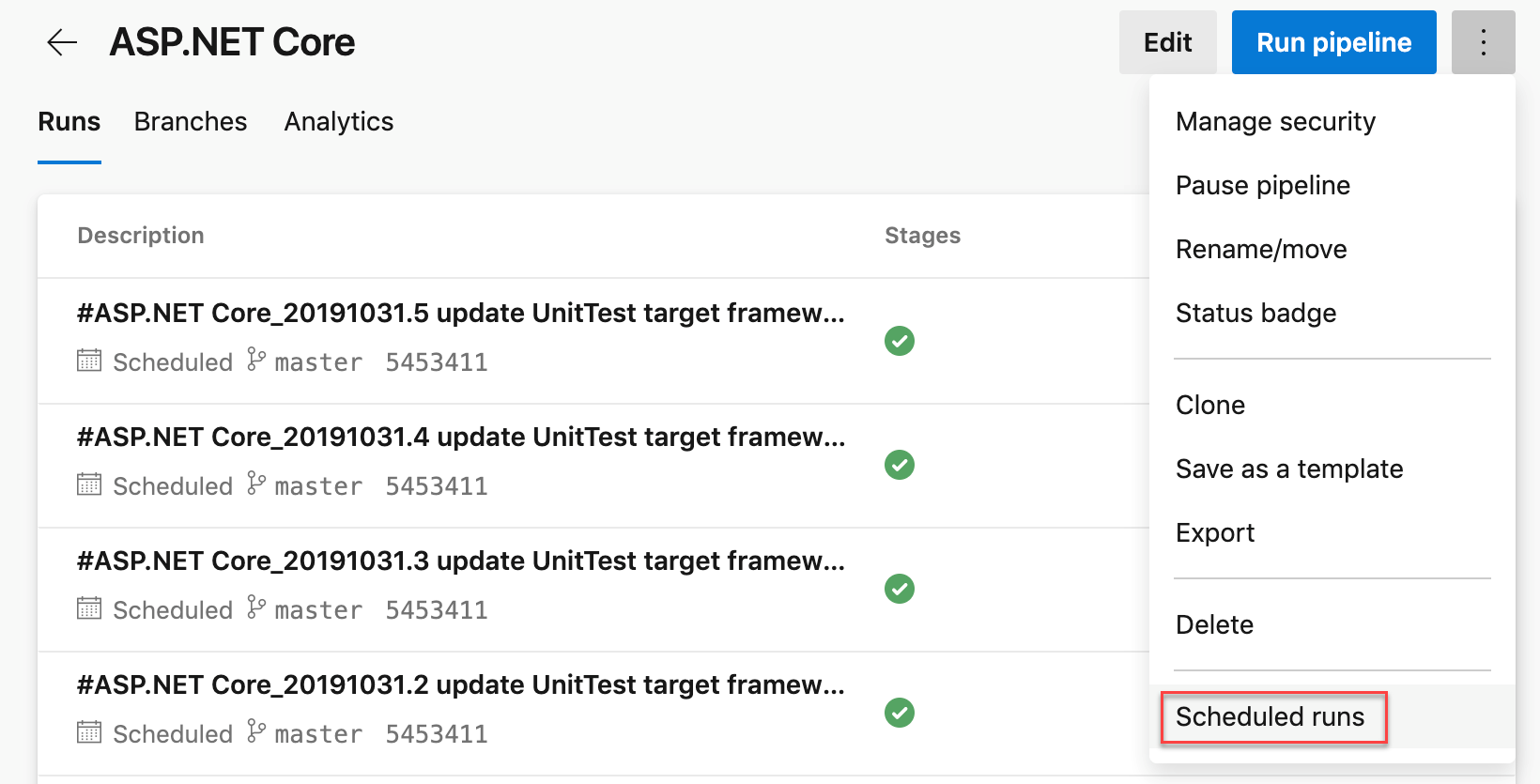

Pianificazioni Cron in YAML

In precedenza, è possibile usare l'editor dell'interfaccia utente per specificare un trigger pianificato per le pipeline YAML. Con questa versione è possibile pianificare le compilazioni usando la sintassi cron nel file YAML e sfruttare i vantaggi seguenti:

- Configurazione come codice: è possibile tenere traccia delle pianificazioni insieme alla pipeline come parte del codice.

- Espressivo: si ha maggiore potenza espressiva nella definizione di pianificazioni rispetto a quelle che è stato possibile usare con l'interfaccia utente. Ad esempio, è più semplice specificare una singola pianificazione che avvia un'esecuzione ogni ora.

- Standard del settore: molti sviluppatori e amministratori hanno già familiarità con la sintassi cron.

schedules:

- cron: "0 0 * * *"

displayName: Daily midnight build

branches:

include:

- main

- releases/*

exclude:

- releases/ancient/*

always: true

Abbiamo anche reso più semplice diagnosticare i problemi con le pianificazioni cron. Le esecuzioni pianificate nel menu Esegui pipeline offrono un'anteprima delle prossime esecuzioni pianificate per la pipeline per diagnosticare gli errori con le pianificazioni cron.

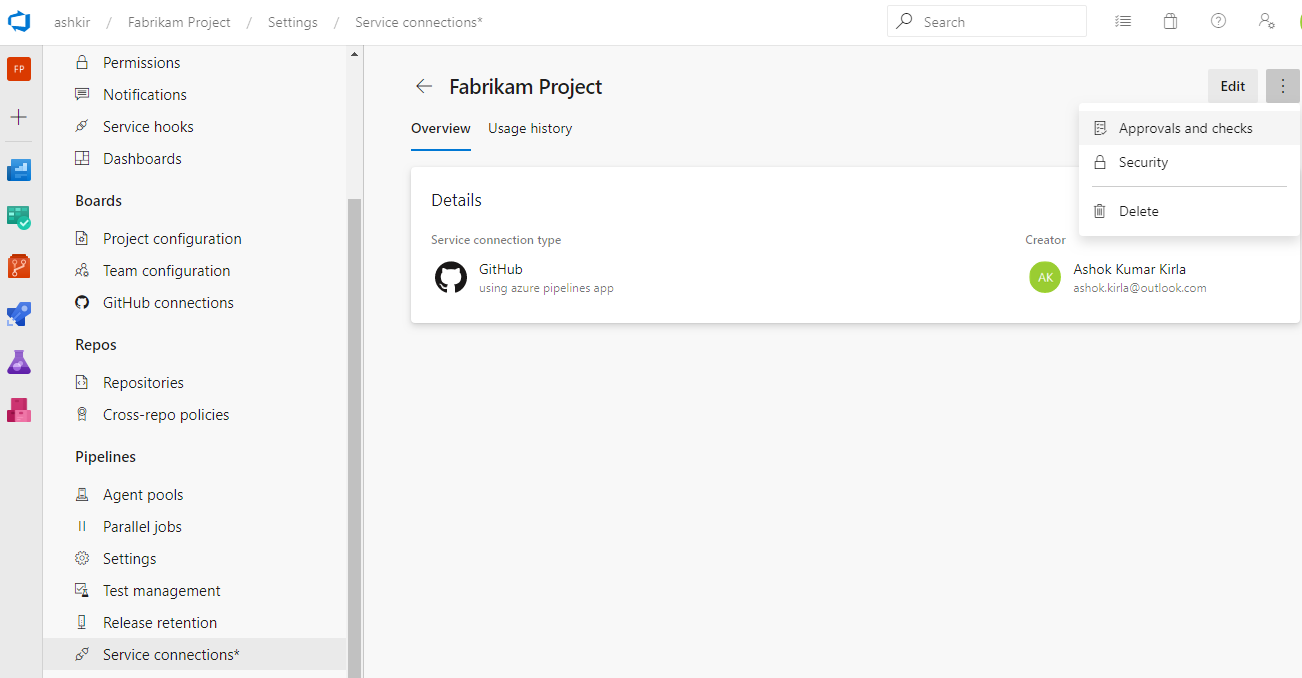

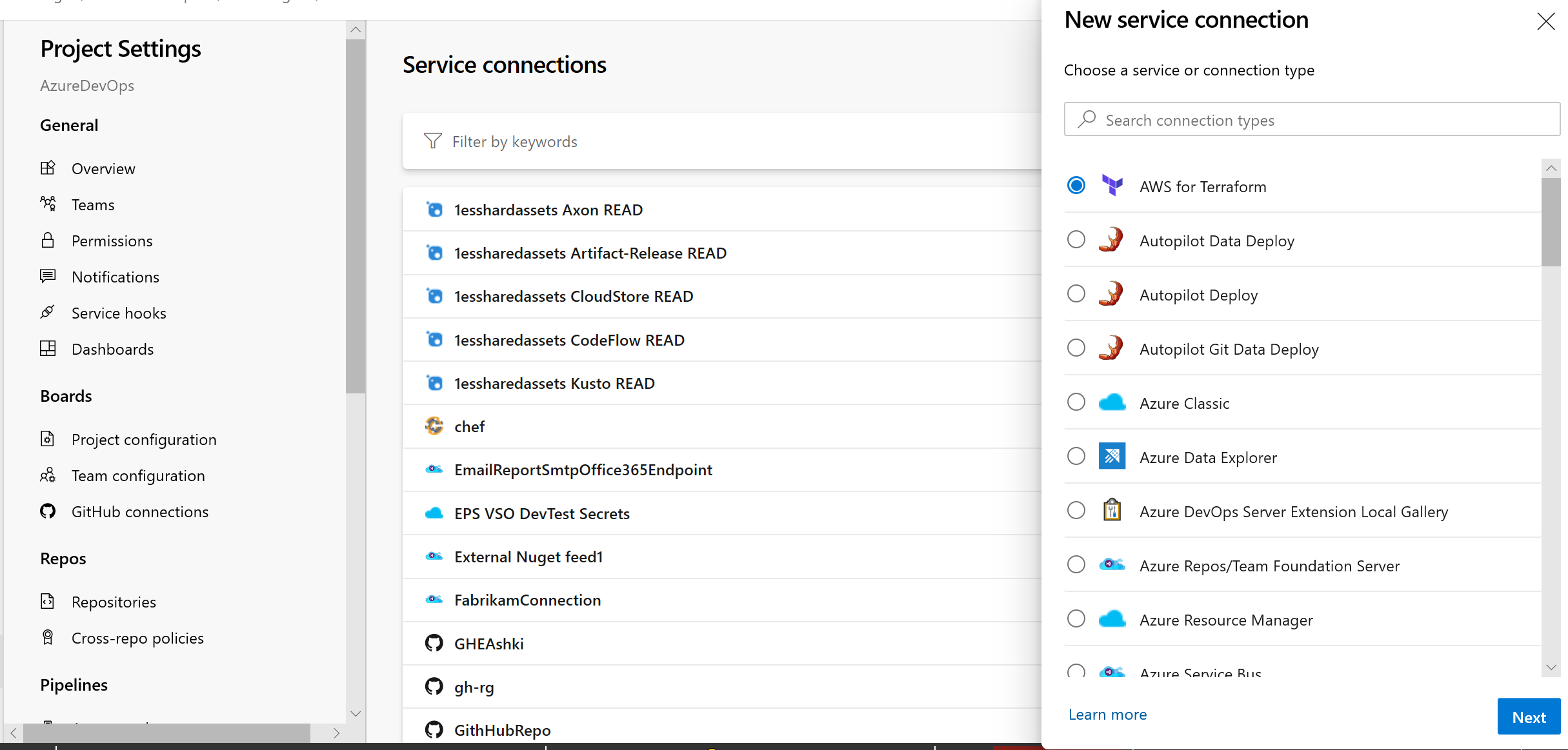

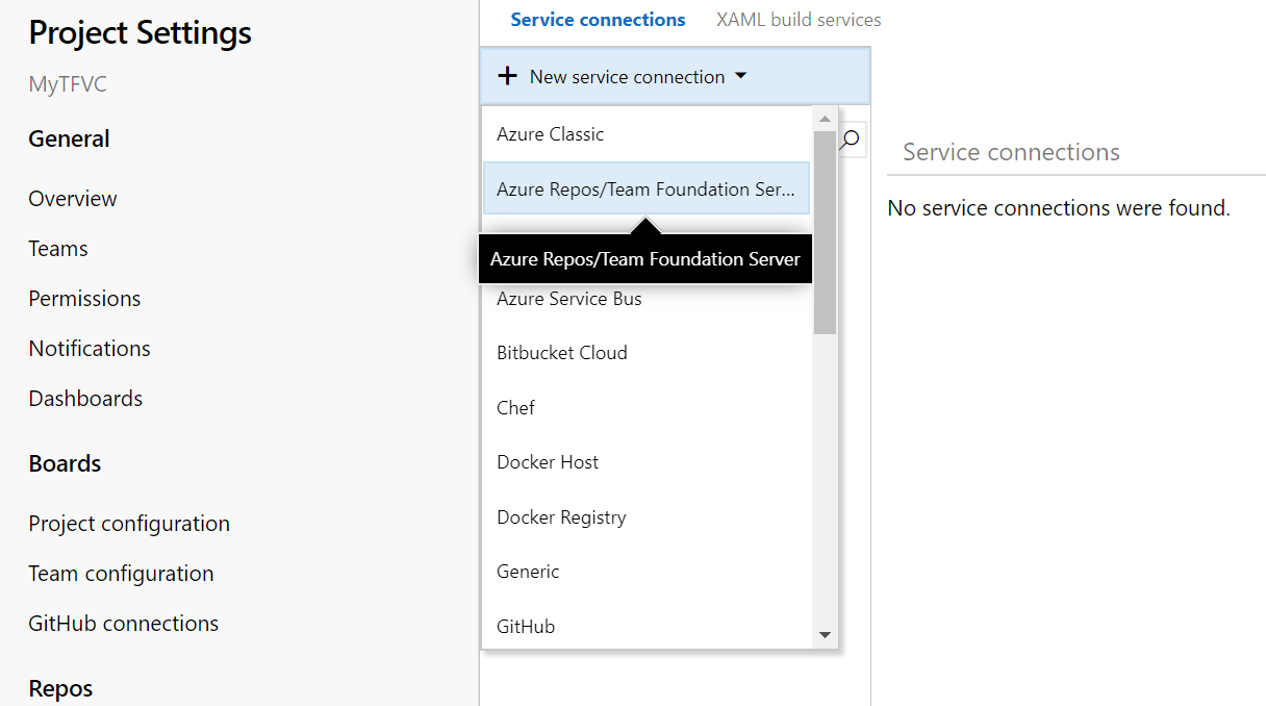

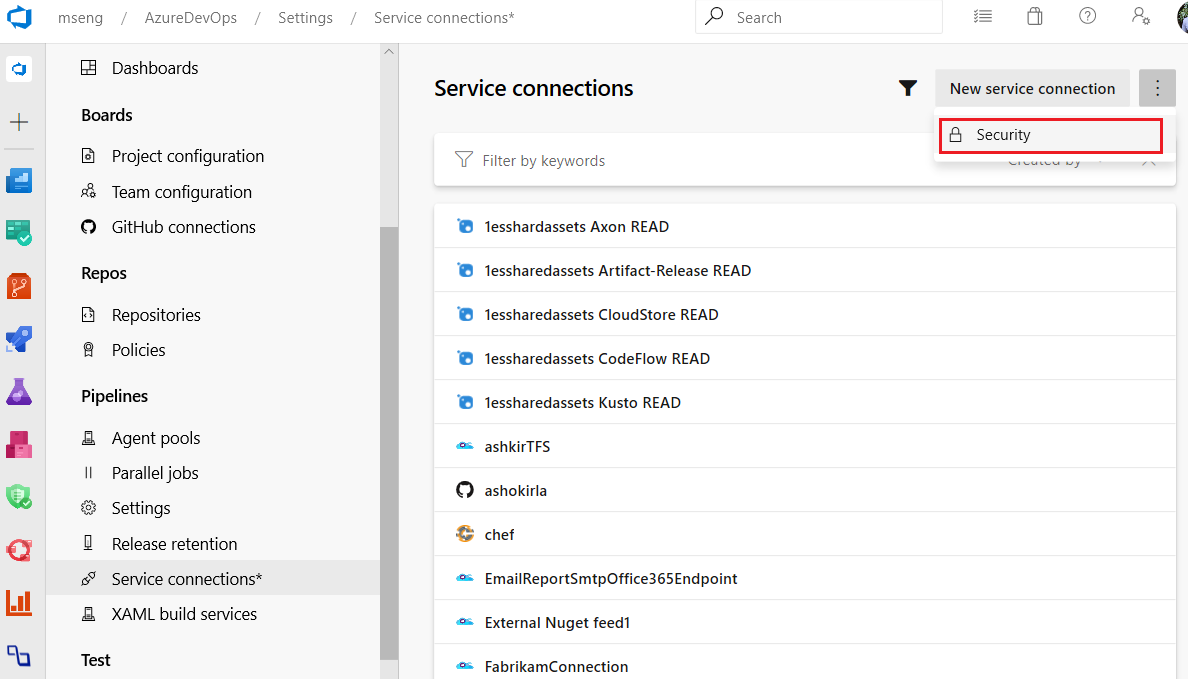

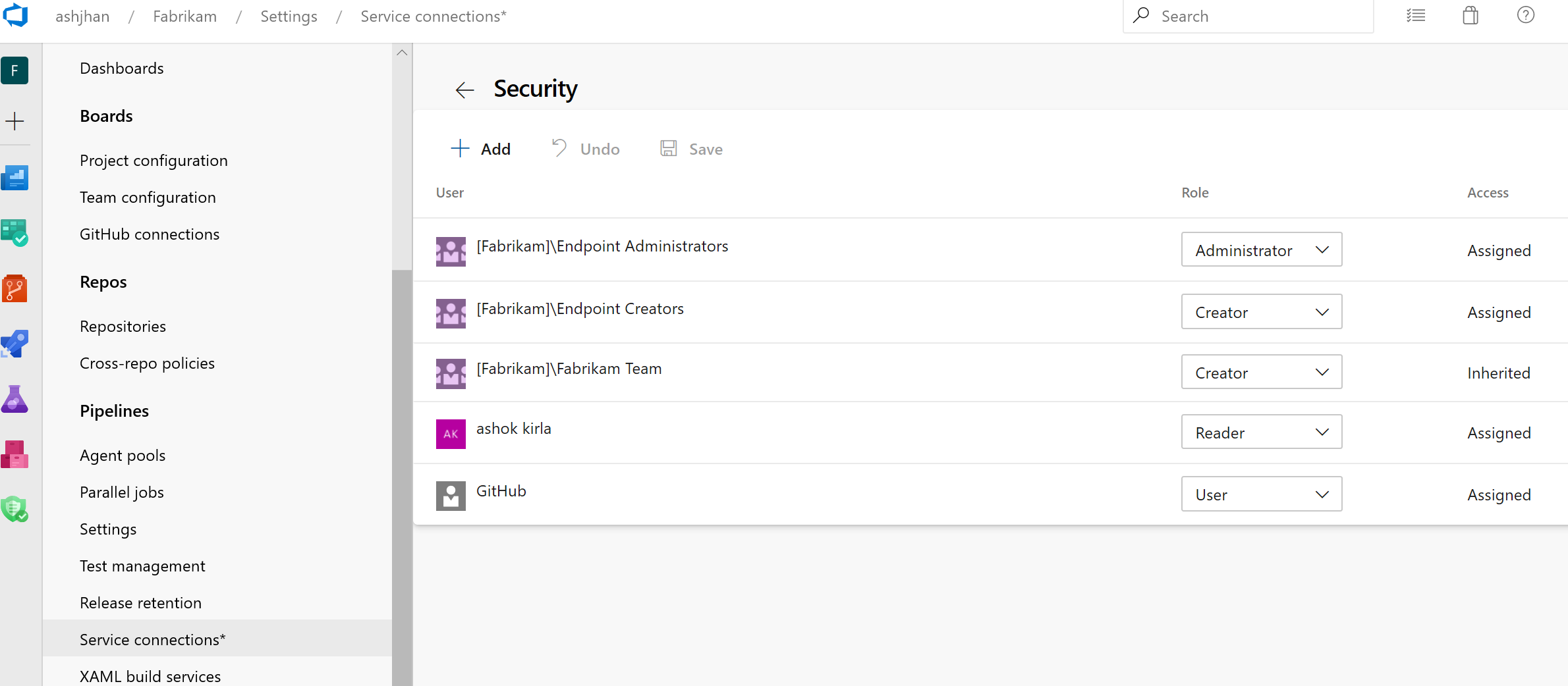

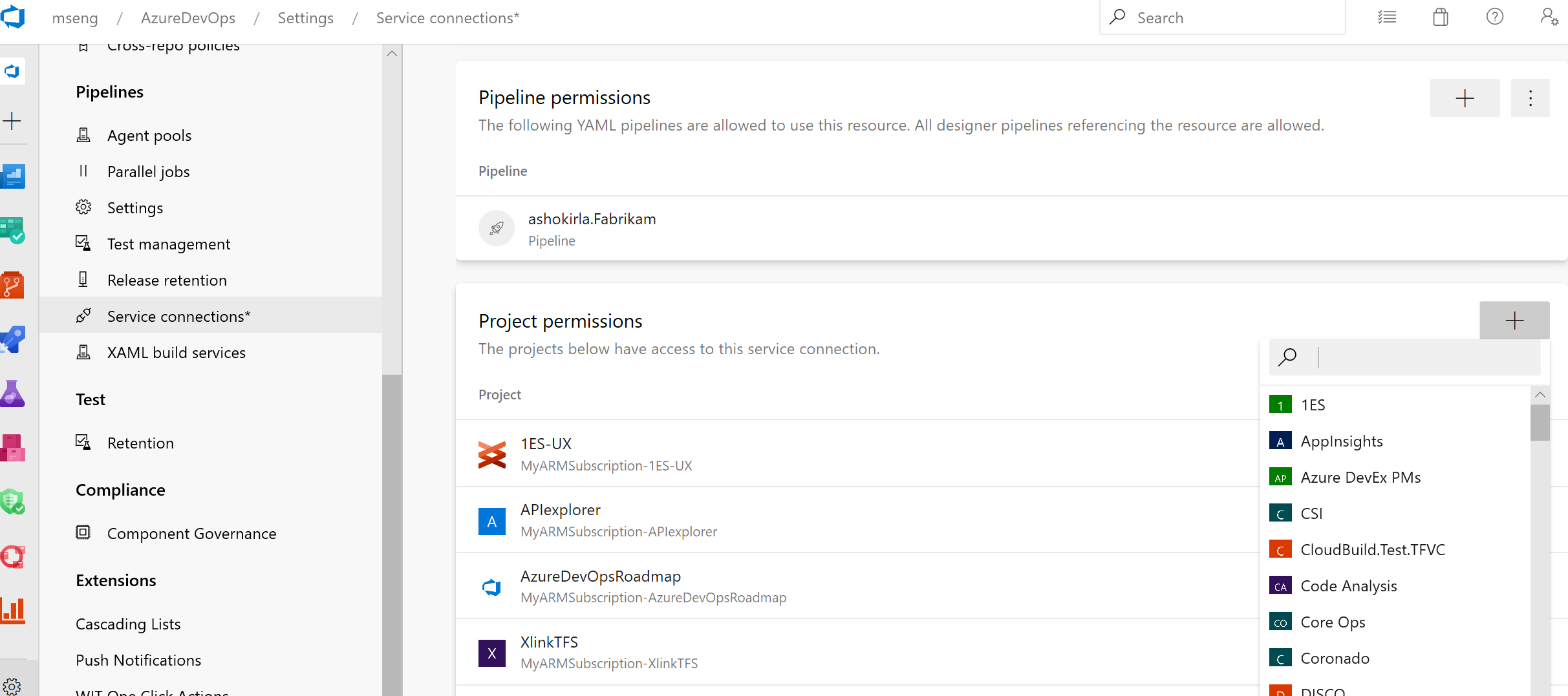

Aggiornamenti all'interfaccia utente delle connessioni al servizio

Microsoft sta lavorando a un'esperienza utente aggiornata per gestire le connessioni al servizio. Questi aggiornamenti rendono l'esperienza di connessione del servizio moderna e coerente con la direzione di Azure DevOps. Abbiamo introdotto la nuova interfaccia utente per le connessioni al servizio come funzionalità di anteprima all'inizio di quest'anno. Grazie a tutti coloro che hanno provato la nuova esperienza e hanno fornito il loro prezioso feedback a noi.

Oltre all'aggiornamento dell'esperienza utente, sono state aggiunte anche due funzionalità fondamentali per l'utilizzo delle connessioni al servizio nelle pipeline YAML: autorizzazioni e approvazioni e controlli della pipeline.

La nuova esperienza utente verrà attivata per impostazione predefinita con questo aggiornamento. Sarà comunque possibile rifiutare esplicitamente l'anteprima.

Nota

Si prevede di introdurre condivisione tra progetti di servizio Connections come nuova funzionalità. Altre informazioni sull'esperienza di condivisione e sui ruoli di sicurezza sono disponibili qui.

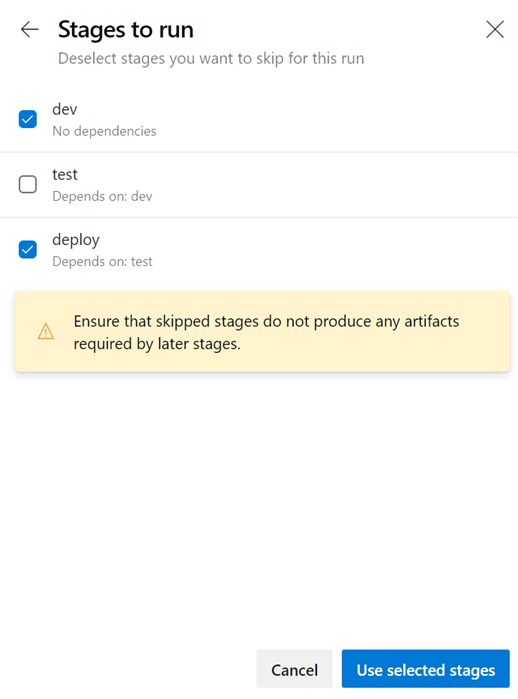

Ignorare le fasi in una pipeline YAML

Quando si avvia un'esecuzione manuale, a volte è possibile ignorare alcune fasi della pipeline. Ad esempio, se non si vuole eseguire la distribuzione nell'ambiente di produzione o se si vuole ignorare la distribuzione in alcuni ambienti nell'ambiente di produzione. È ora possibile eseguire questa operazione con le pipeline YAML.

Il pannello della pipeline di esecuzione aggiornato presenta un elenco di fasi del file YAML ed è possibile ignorare una o più di queste fasi. È necessario prestare attenzione quando si ignorano le fasi. Ad esempio, se la prima fase produce alcuni artefatti necessari per le fasi successive, non è consigliabile ignorare la prima fase. Il pannello di esecuzione visualizza un avviso generico ogni volta che si ignorano le fasi con dipendenze downstream. È necessario stabilire se tali dipendenze sono vere dipendenze degli artefatti o se sono presenti solo per la sequenziazione delle distribuzioni.

Ignorare una fase equivale a riwiring le dipendenze tra le fasi. Tutte le dipendenze downstream immediate della fase ignorata vengono effettuate in base all'elemento padre upstream della fase ignorata. Se l'esecuzione ha esito negativo e se si tenta di rieseguire una fase non riuscita, tale tentativo avrà anche lo stesso comportamento di salto. Per modificare le fasi ignorate, è necessario avviare una nuova esecuzione.

Connessioni al servizio nuova interfaccia utente come esperienza predefinita

È disponibile una nuova interfaccia utente per le connessioni al servizio. Questa nuova interfaccia utente è basata su standard di progettazione moderni e include varie funzionalità critiche per supportare pipeline CD YAML a più fasi, ad esempio approvazioni, autorizzazioni e condivisione tra progetti.

Altre informazioni sulle connessioni al servizio sono disponibili qui.

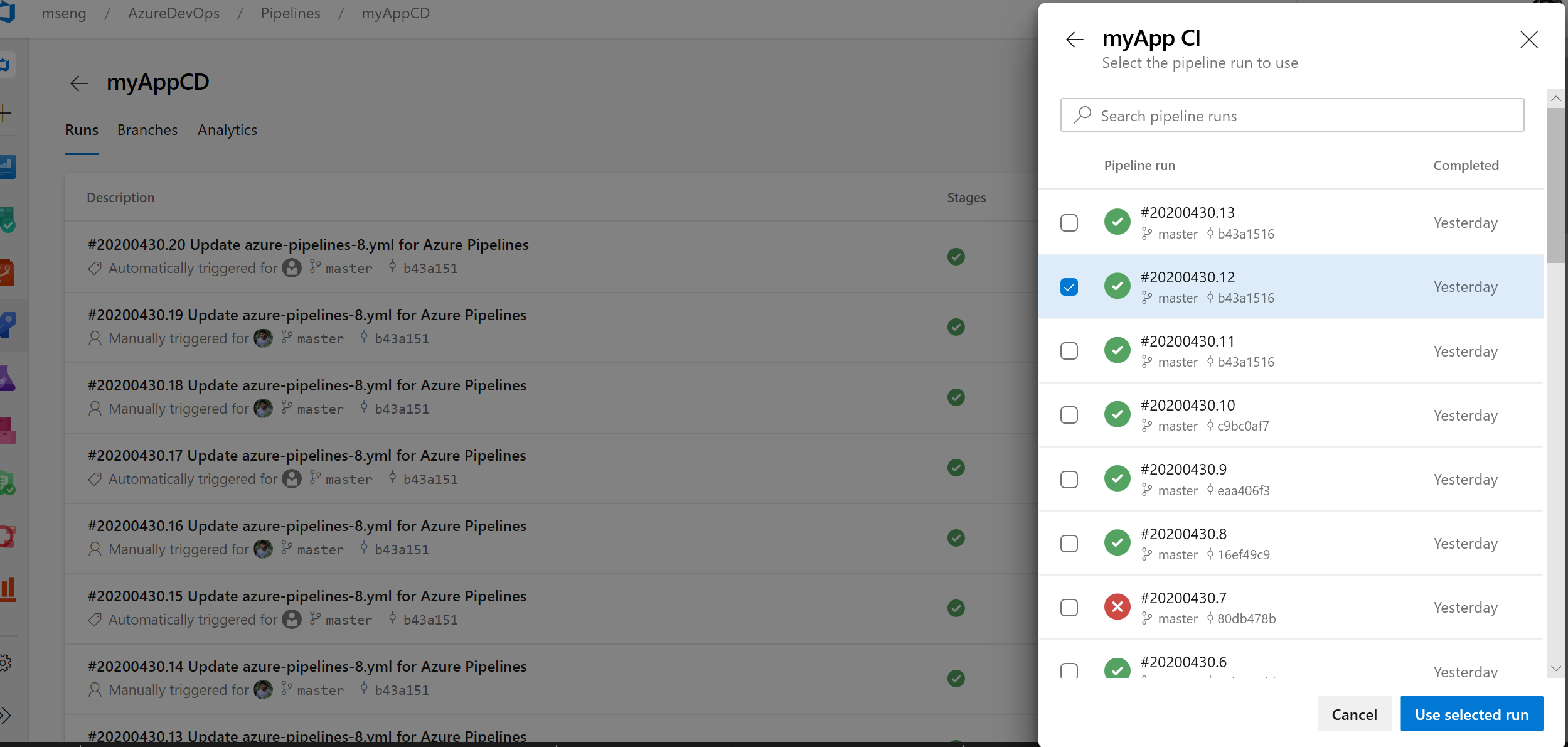

Selezione della versione della risorsa pipeline nella finestra di dialogo Crea esecuzione

È stata aggiunta la possibilità di selezionare manualmente le versioni delle risorse della pipeline nella finestra di dialogo di creazione dell'esecuzione. Se si usa una pipeline come risorsa in un'altra pipeline, è ora possibile selezionare la versione di tale pipeline durante la creazione di un'esecuzione.

az Miglioramenti dell'interfaccia della riga di comando per Azure Pipelines

Comandi di gestione delle variabili e del gruppo di variabili della pipeline

Può essere difficile convertire pipeline basate su YAML da un progetto a un altro perché è necessario configurare manualmente le variabili della pipeline e i gruppi di variabili. Tuttavia, con i comandi di gestione delle variabili della pipeline e del gruppo di variabili , è ora possibile creare script per la configurazione e la gestione delle variabili e dei gruppi di variabili che a loro volta possono essere controllati dalla versione, consentendo di condividere facilmente le istruzioni per spostare e configurare pipeline da un progetto a un altro.

Eseguire la pipeline per un ramo di richiesta pull

Quando si crea una richiesta pull, può essere difficile verificare se le modifiche potrebbero interrompere l'esecuzione della pipeline nel ramo di destinazione. Tuttavia, con la possibilità di attivare un'esecuzione della pipeline o di accodare una compilazione per un ramo pr, è ora possibile convalidare e visualizzare le modifiche in corso eseguendola nella pipeline di destinazione. Per altre informazioni, vedere la documentazione del comando az pipelines run e az pipelines build queue .

Ignorare la prima esecuzione della pipeline

Quando si creano pipeline, a volte si vuole creare ed eseguire il commit di un file YAML e non attivare l'esecuzione della pipeline perché può causare un'esecuzione non riuscita a causa di diversi motivi: l'infrastruttura non è pronta o deve creare e aggiornare gruppi di variabili/variabili e così via. Con l'interfaccia della riga di comando di Azure DevOps è ora possibile ignorare la prima esecuzione automatizzata della pipeline durante la creazione di una pipeline includendo il parametro --skip-first-run. Per altre informazioni, vedere la documentazione del comando az pipeline create .

Miglioramento dei comandi dell'endpoint di servizio

I comandi dell'interfaccia della riga di comando dell'endpoint di servizio supportano solo azure rm e l'endpoint di servizio github configurati e di gestione. Tuttavia, con questa versione, i comandi degli endpoint di servizio consentono di creare qualsiasi endpoint di servizio fornendo la configurazione tramite file e fornisce comandi ottimizzati: az devops service-endpoint github e az devops service-endpoint azurerm, che forniscono il supporto di prima classe per creare endpoint di servizio di questi tipi. Per altre informazioni, vedere la documentazione del comando .

Processi di distribuzione

Un processo di distribuzione è un tipo speciale di processo usato per distribuire l'app in un ambiente. Con questo aggiornamento è stato aggiunto il supporto per i riferimenti ai passaggi in un processo di distribuzione. Ad esempio, è possibile definire un set di passaggi in un file e farvi riferimento in un processo di distribuzione.

È stato aggiunto anche il supporto per proprietà aggiuntive al processo di distribuzione. Ecco ad esempio alcune proprietà di un processo di distribuzione che è ora possibile impostare,

- timeoutInMinutes - Durata dell'esecuzione del processo prima dell'annullamento automatico

- cancelTimeoutInMinutes - Tempo di esecuzione sempre anche se le attività annullate prima di terminarle

- condition : eseguire il processo in modo condizionale

- variabili : è possibile aggiungere direttamente valori hardcoded o gruppi di variabili, gruppo di variabili supportato da un insieme di credenziali delle chiavi di Azure oppure fare riferimento a un set di variabili definite in un file.

- continueOnError : se i processi futuri devono essere eseguiti anche se il processo di distribuzione ha esito negativo; il valore predefinito è 'false'

Per altre informazioni sui processi di distribuzione e sulla sintassi completa per specificare un processo di distribuzione, vedere Processo di distribuzione.

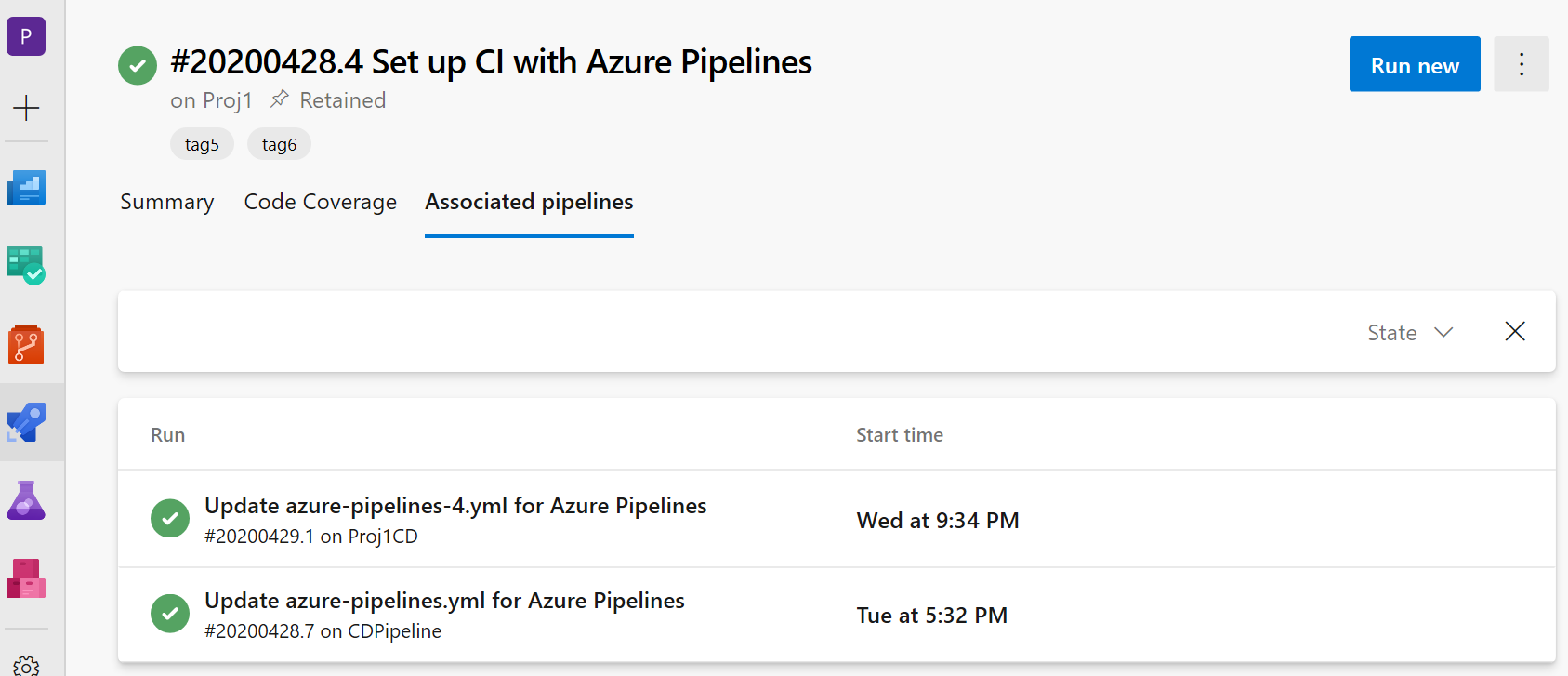

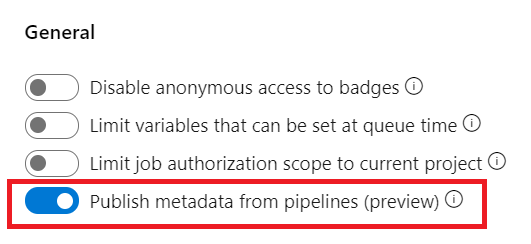

Visualizzazione delle informazioni sulle pipeline CD associate nelle pipeline CI

È stato aggiunto il supporto per le pipeline YAML CD in cui le pipeline CI vengono definite risorse della pipeline. Nella visualizzazione esecuzione della pipeline CI verrà ora visualizzata una nuova scheda "Pipeline associate" in cui è possibile trovare tutte le esecuzioni della pipeline che usano la pipeline e gli artefatti da esso.

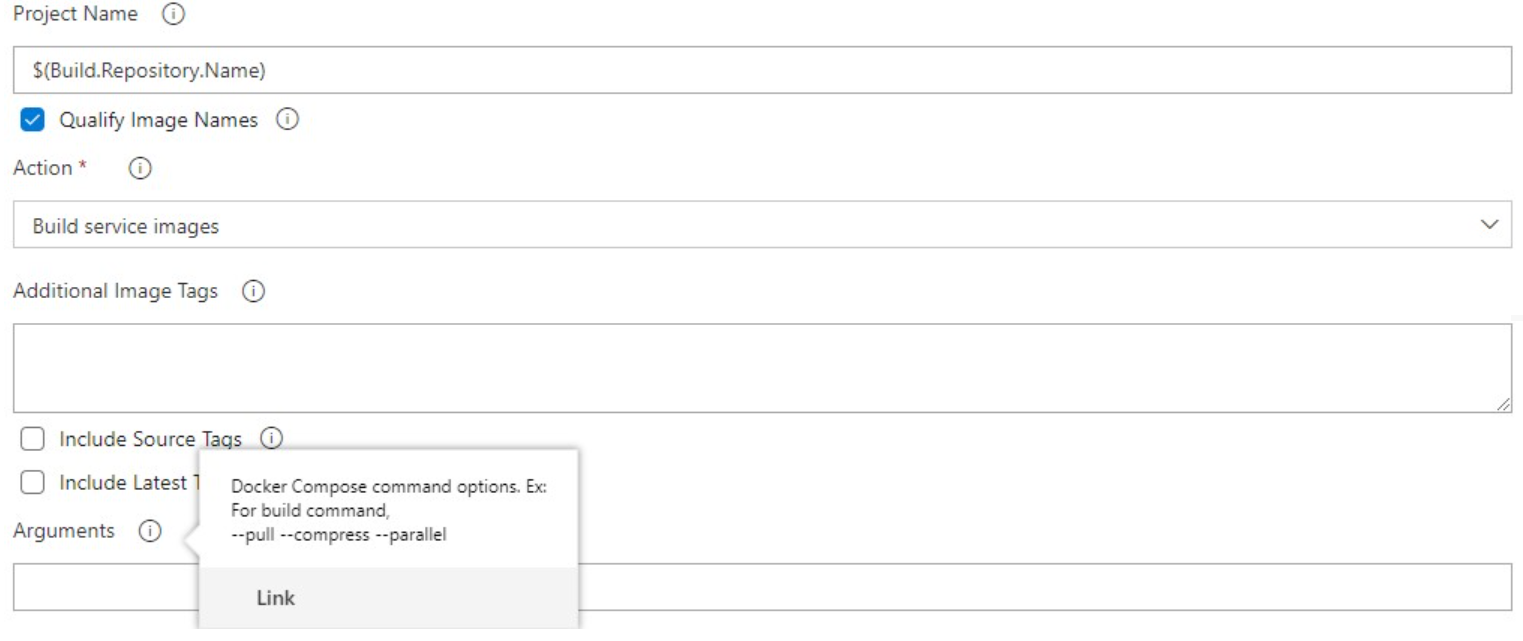

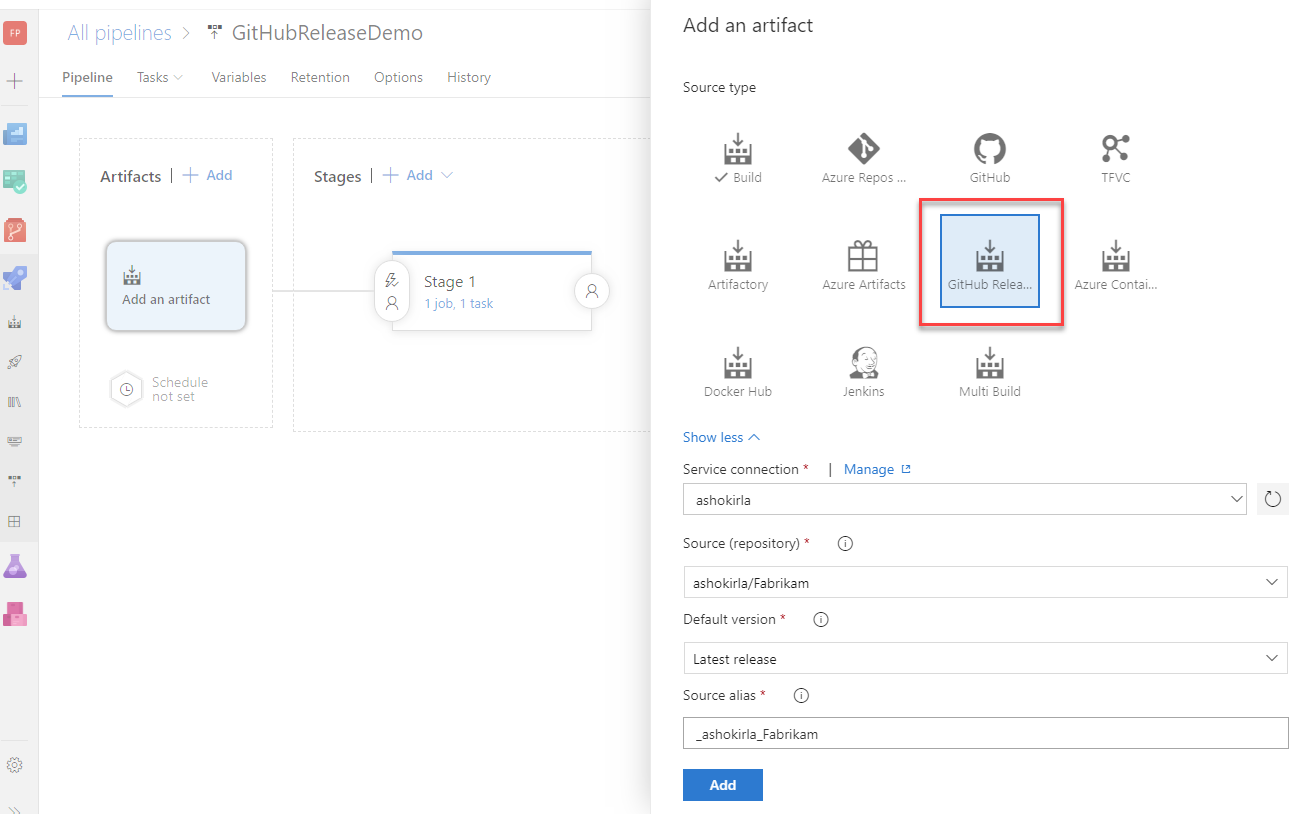

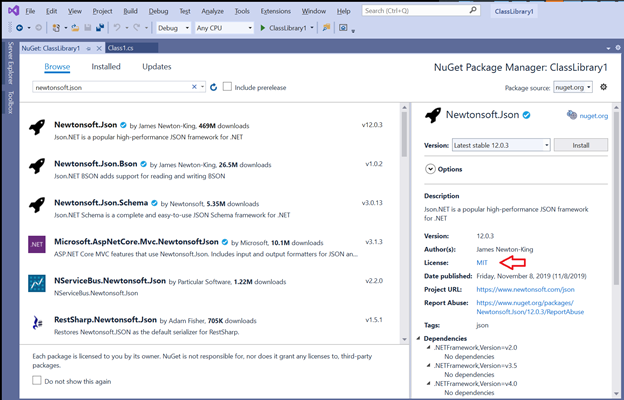

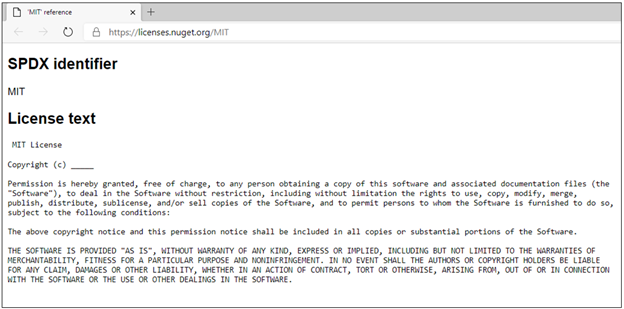

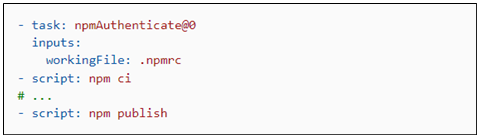

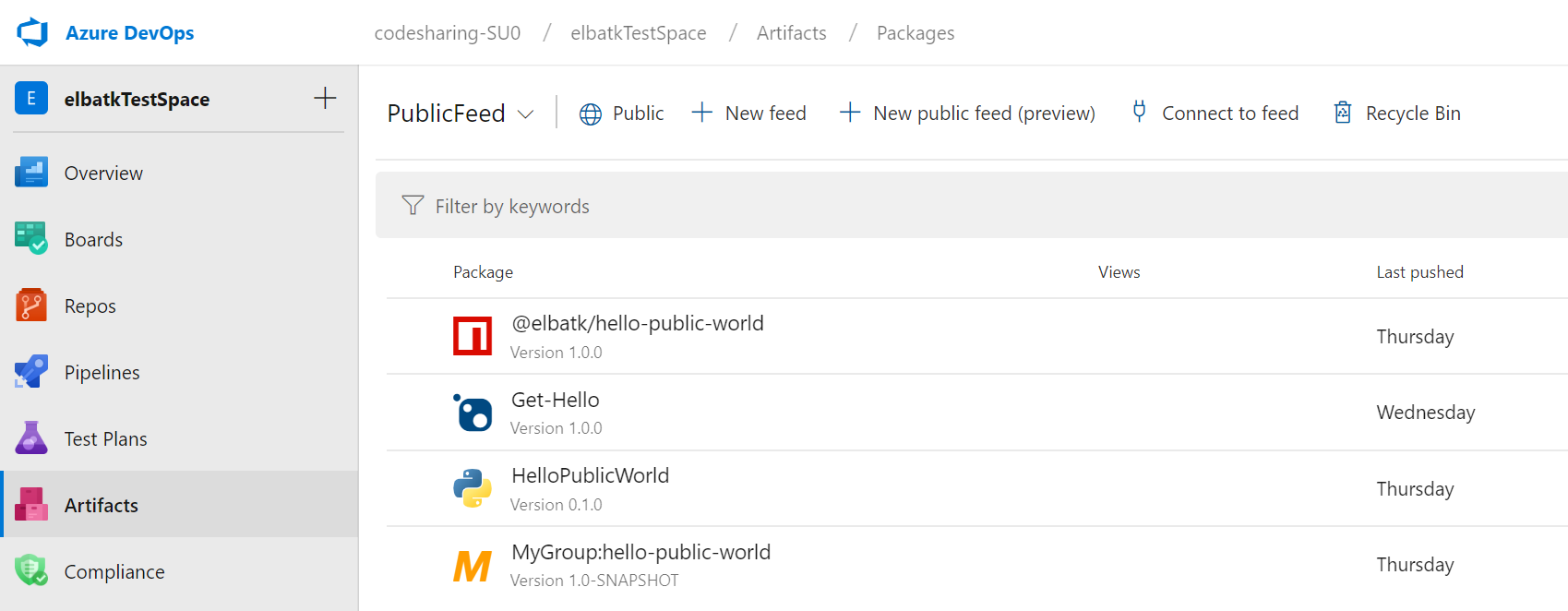

Supporto per i pacchetti GitHub nelle pipeline YAML

Di recente è stato introdotto un nuovo tipo di risorsa denominato pacchetti che aggiunge il supporto per l'utilizzo di pacchettiNuGet e npm da GitHub come risorsa nelle pipeline YAML. Come parte di questa risorsa, è ora possibile specificare il tipo di pacchetto (NuGet o npm) che si vuole usare da GitHub. È anche possibile abilitare trigger di pipeline automatizzati al rilascio di una nuova versione del pacchetto. Oggi il supporto è disponibile solo per l'utilizzo di pacchetti da GitHub, ma si prevede di estendere il supporto per l'utilizzo di pacchetti da altri repository di pacchetti, ad esempio NuGet, npm, AzureArtifacts e molti altri. Per informazioni dettagliate, vedere l'esempio seguente:

resources:

packages:

- package: myPackageAlias # alias for the package resource

type: Npm # type of the package NuGet/npm

connection: GitHubConn # Github service connection of type PAT

name: nugetTest/nodeapp # <Repository>/<Name of the package>

version: 1.0.9 # Version of the packge to consume; Optional; Defaults to latest

trigger: true # To enable automated triggers (true/false); Optional; Defaults to no triggers

Nota

Oggi i pacchetti GitHub supportano solo l'autenticazione basata su PAT, il che significa che la connessione al servizio GitHub nella risorsa del pacchetto deve essere di tipo PAT. Una volta revocata questa limitazione, verrà fornito il supporto per altri tipi di autenticazione.

Per impostazione predefinita, i pacchetti non vengono scaricati automaticamente nei processi, quindi perché è stata introdotta una macro getPackage che consente di usare il pacchetto definito nella risorsa. Per informazioni dettagliate, vedere l'esempio seguente:

- job: job1

pool: default

steps:

- getPackage: myPackageAlias # Alias of the package resource

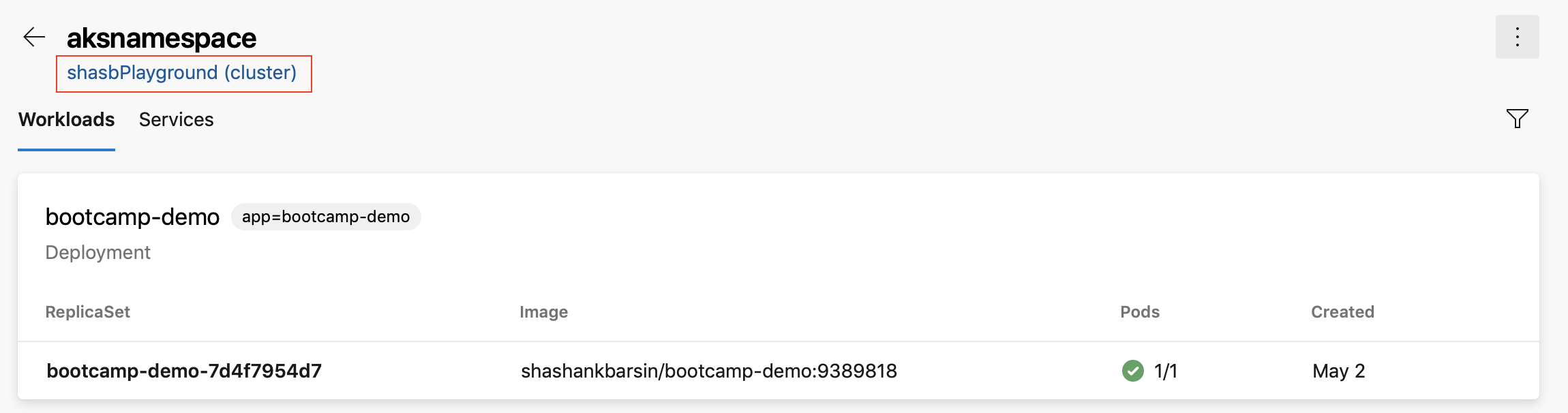

collegamento servizio Azure Kubernetes cluster nella visualizzazione risorse degli ambienti Kubernetes

È stato aggiunto un collegamento alla visualizzazione delle risorse degli ambienti Kubernetes in modo da poter passare al pannello di Azure per il cluster corrispondente. Questo vale per gli ambienti mappati agli spazi dei nomi nei cluster servizio Azure Kubernetes.

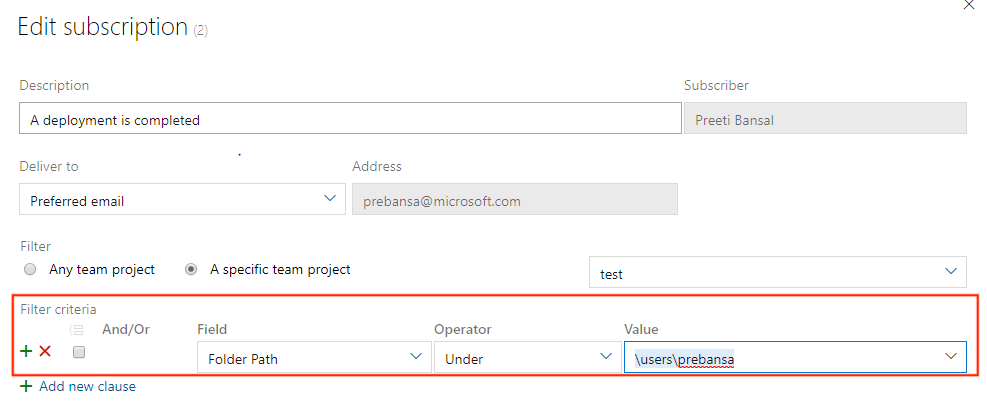

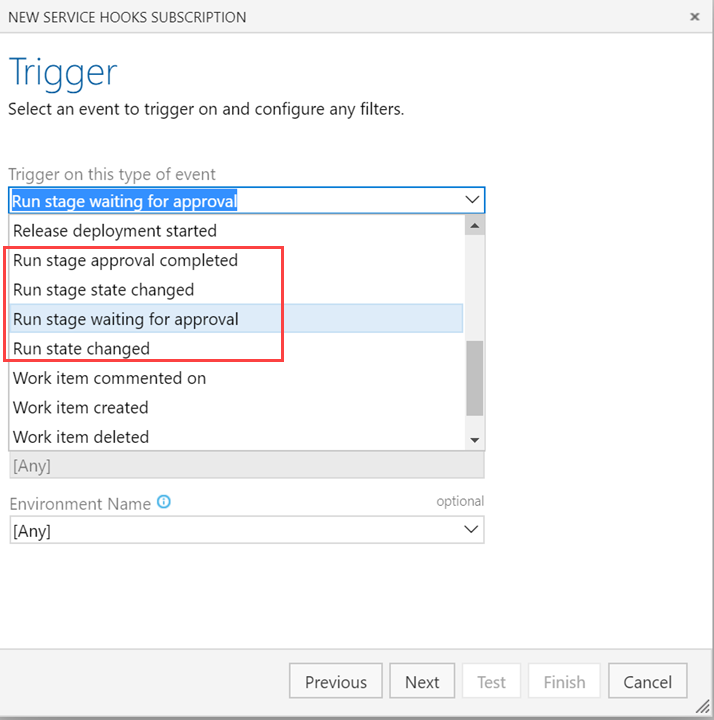

Filtri delle cartelle di rilascio nelle sottoscrizioni di notifica

Le cartelle consentono di organizzare le pipeline per semplificare la individuabilità e il controllo della sicurezza. Spesso è possibile configurare notifiche di posta elettronica personalizzate per tutte le pipeline di versione, rappresentate da tutte le pipeline in una cartella. In precedenza, è necessario configurare più sottoscrizioni o avere query complesse nelle sottoscrizioni per ottenere messaggi di posta elettronica incentrati. Con questo aggiornamento è ora possibile aggiungere una clausola di cartella di versione alla distribuzione completata e approvare gli eventi in sospeso e semplificare le sottoscrizioni.

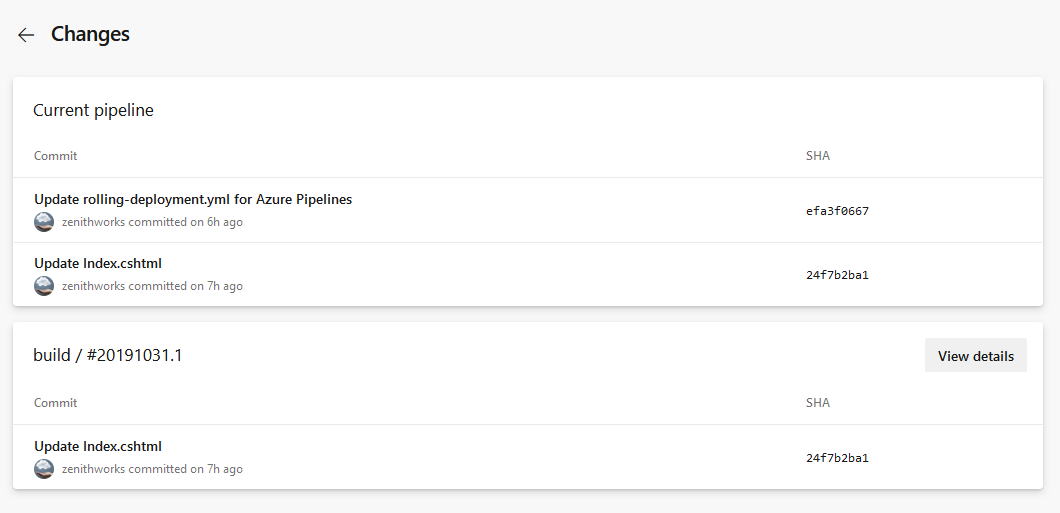

Collegare elementi di lavoro con pipeline YAML a più fasi

Attualmente è possibile collegare automaticamente gli elementi di lavoro alle compilazioni classiche. Tuttavia, questa operazione non è stata possibile con le pipeline YAML. Con questo aggiornamento abbiamo risolto questo divario. Quando si esegue correttamente una pipeline usando codice da un ramo specificato, Azure Pipelines associa automaticamente l'esecuzione a tutti gli elementi di lavoro (che vengono dedotti tramite i commit in tale codice). Quando si apre l'elemento di lavoro, sarà possibile visualizzare le esecuzioni in cui è stato compilato il codice per tale elemento di lavoro. Per configurare questa operazione, usare il pannello delle impostazioni di una pipeline.

Annullare la fase in una pipeline YAML a più fasi

Quando si esegue una pipeline YAML a più fasi, è ora possibile annullare l'esecuzione di una fase mentre è in corso. Questo è utile se si sa che la fase avrà esito negativo o se si ha un'altra esecuzione che si vuole avviare.

Fasi di ripetizione dei tentativi non riuscite

Una delle funzionalità più richieste nelle pipeline multi-stage è la possibilità di riprovare una fase non riuscita senza dover iniziare dall'inizio. Con questo aggiornamento si aggiunge una parte importante di questa funzionalità.

È ora possibile riprovare una fase della pipeline quando l'esecuzione ha esito negativo. Tutti i processi che non sono riusciti nel primo tentativo e quelli che dipendono in modo transitivo da tali processi non riusciti vengono tutti riprovati.

Ciò consente di risparmiare tempo in diversi modi. Ad esempio, quando si eseguono più processi in una fase, è possibile che ogni fase esegua test in una piattaforma diversa. Se i test in una piattaforma hanno esito negativo mentre altri passano, è possibile risparmiare tempo non eseguendo nuovamente i processi passati. Come un altro esempio, una fase di distribuzione potrebbe non essere riuscita a causa della connessione di rete flaky. Riprovare questa fase consente di risparmiare tempo non avendo la necessità di produrre un'altra compilazione.

Esistono alcune lacune note in questa funzionalità. Ad esempio, non è possibile ripetere una fase annullata in modo esplicito. Stiamo lavorando per chiudere queste lacune negli aggiornamenti futuri.

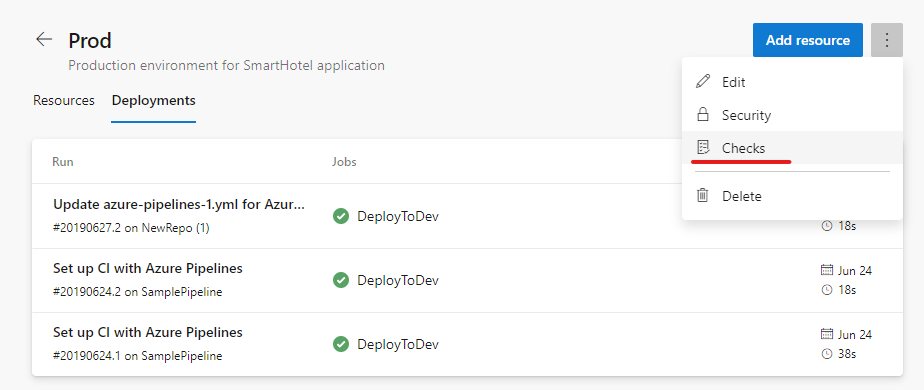

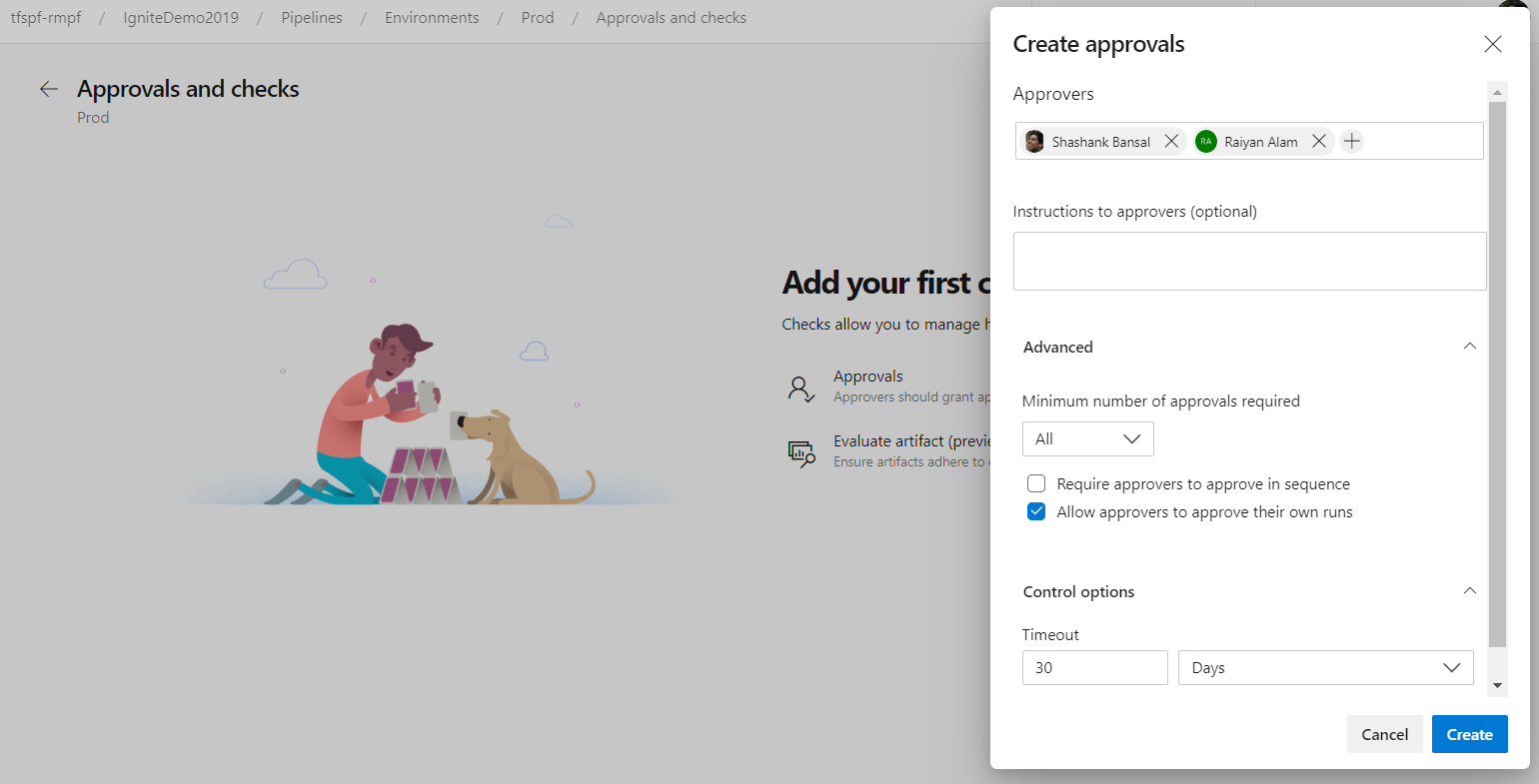

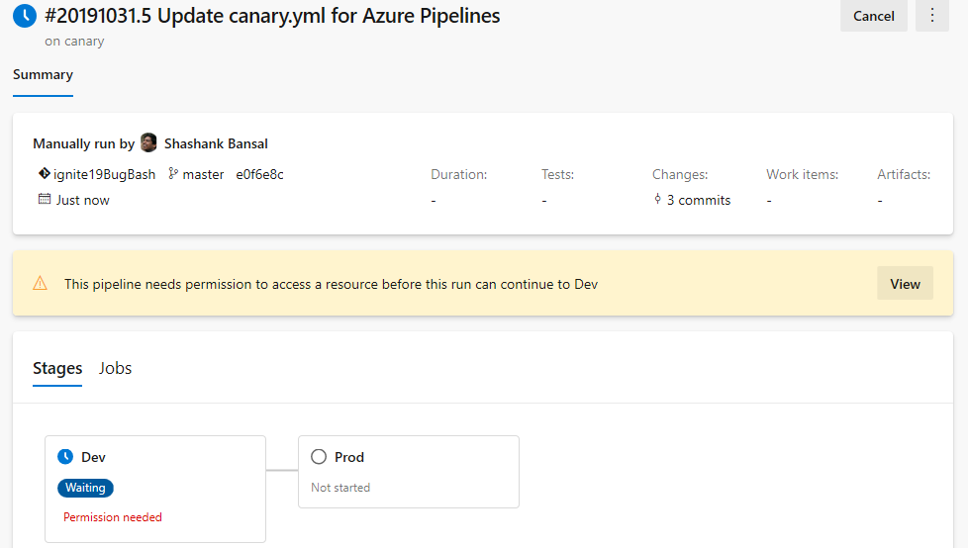

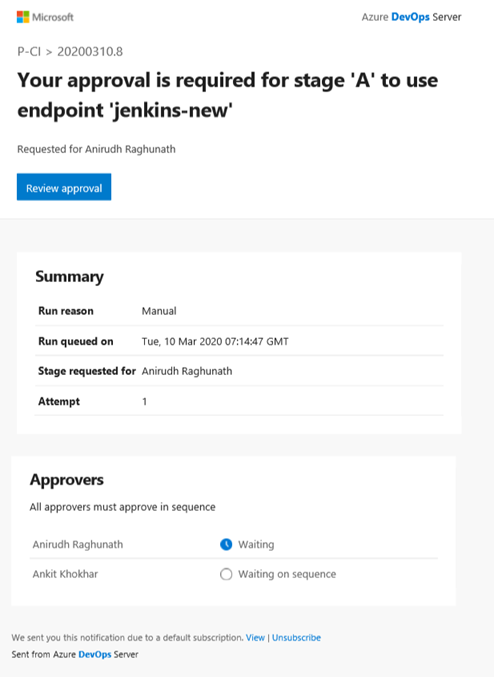

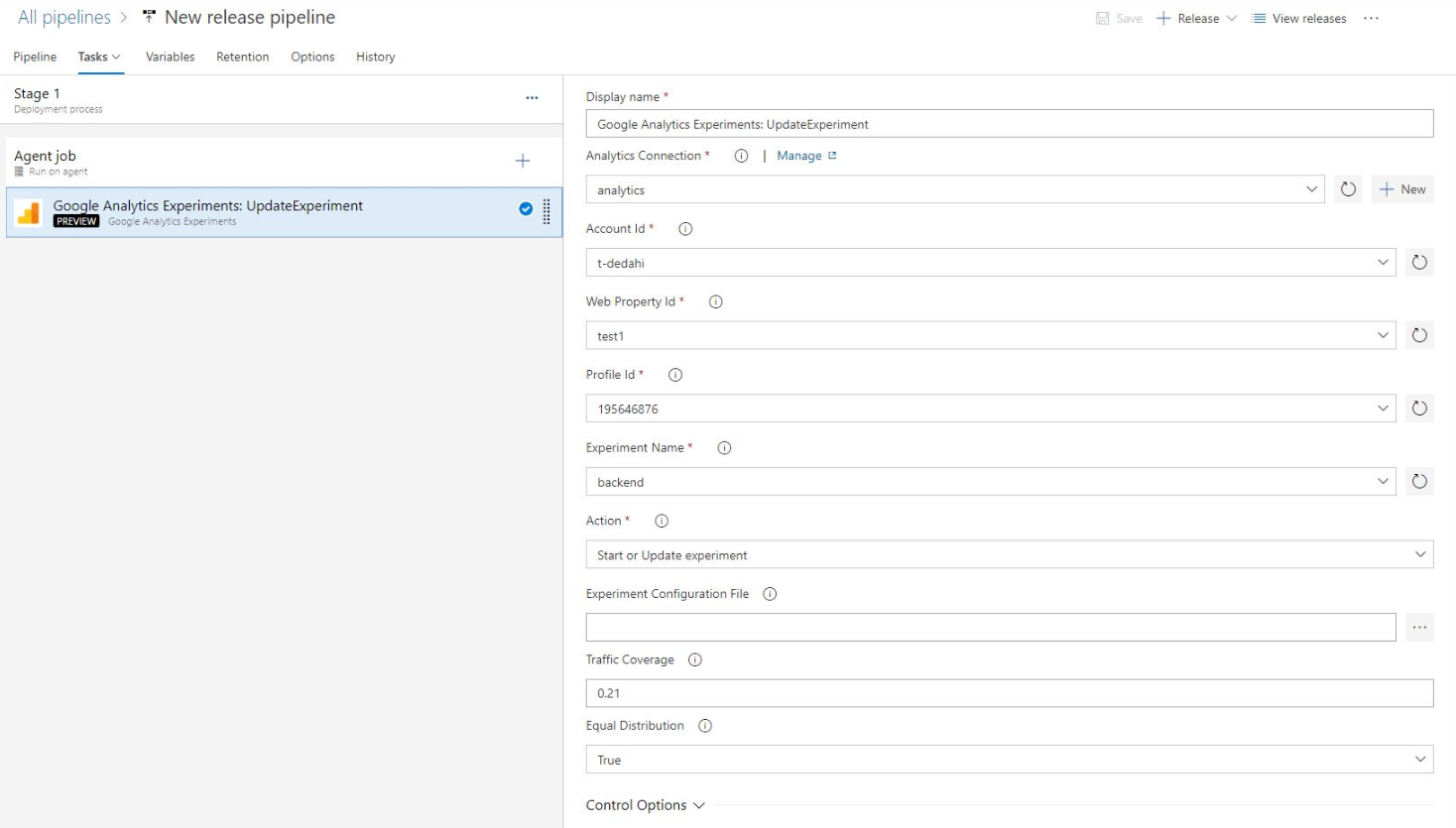

Approvazioni nelle pipeline YAML a più fasi

Le pipeline CD YAML possono contenere approvazioni manuali. I proprietari dell'infrastruttura possono proteggere gli ambienti e cercare approvazioni manuali prima di una fase in qualsiasi pipeline distribuirli. Con la separazione completa dei ruoli tra i proprietari dell'infrastruttura (ambiente) e dell'applicazione (pipeline), si garantisce l'accesso manuale per la distribuzione in una determinata pipeline e ottenere il controllo centrale nell'applicare gli stessi controlli in tutte le distribuzioni all'ambiente.

La pipeline esegue la distribuzione in fase di sviluppo si arresterà per l'approvazione all'inizio della fase.

Aumento del limite e della frequenza di timeout dei gate

In precedenza, il limite di timeout di gate nelle pipeline di rilascio era di tre giorni. Con questo aggiornamento, il limite di timeout è stato aumentato a 15 giorni per consentire le porte con durate più lunghe. Abbiamo anche aumentato la frequenza del cancello a 30 minuti.

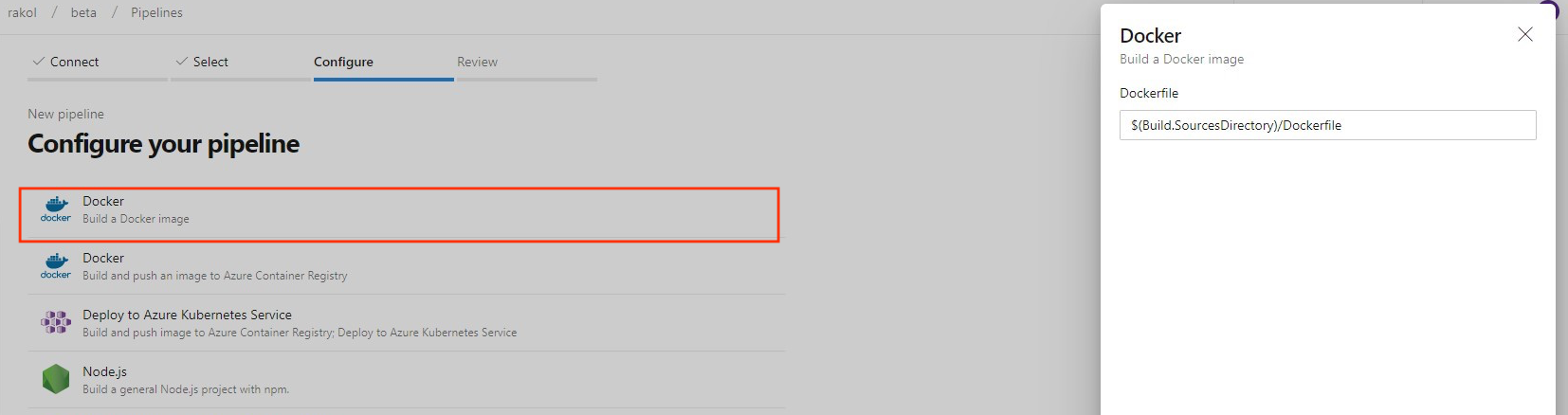

Nuovo modello di immagine di compilazione per Dockerfile

In precedenza, quando si crea una nuova pipeline per un Dockerfile nella nuova creazione della pipeline, il modello consiglia di eseguire il push dell'immagine in un Registro Azure Container e distribuirlo in un servizio Azure Kubernetes. È stato aggiunto un nuovo modello per consentire di compilare un'immagine usando l'agente senza la necessità di eseguire il push in un registro contenitori.

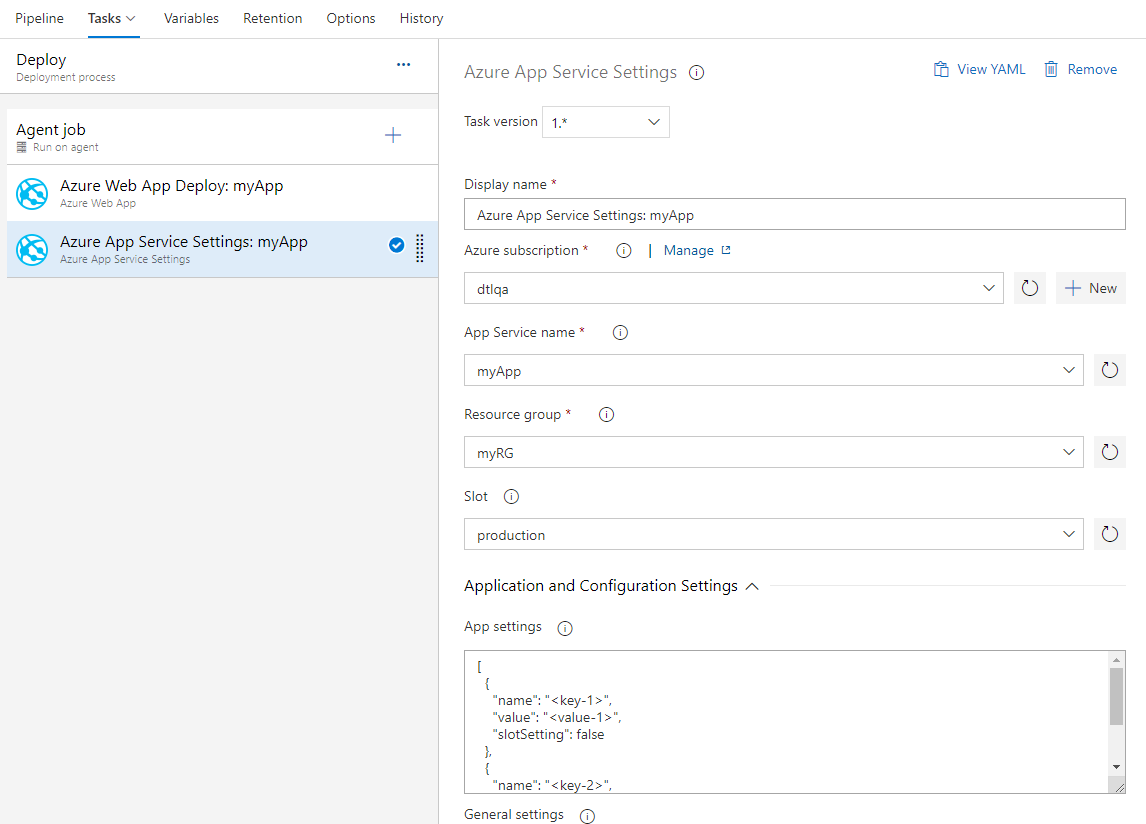

Nuova attività per la configurazione delle impostazioni dell'app Servizio app di Azure

Servizio app di Azure consente la configurazione tramite varie impostazioni, ad esempio impostazioni dell'app, stringhe di connessione e altre impostazioni di configurazione generali. È ora disponibile una nuova attività di Azure Pipelines Servizio app di Azure Impostazioni che supporta la configurazione di queste impostazioni in blocco usando la sintassi JSON nell'app Web o in uno dei relativi slot di distribuzione. Questa attività può essere usata insieme ad altre attività del servizio app per distribuire, gestire e configurare app Web, app per le funzioni o altri servizi app in contenitori.

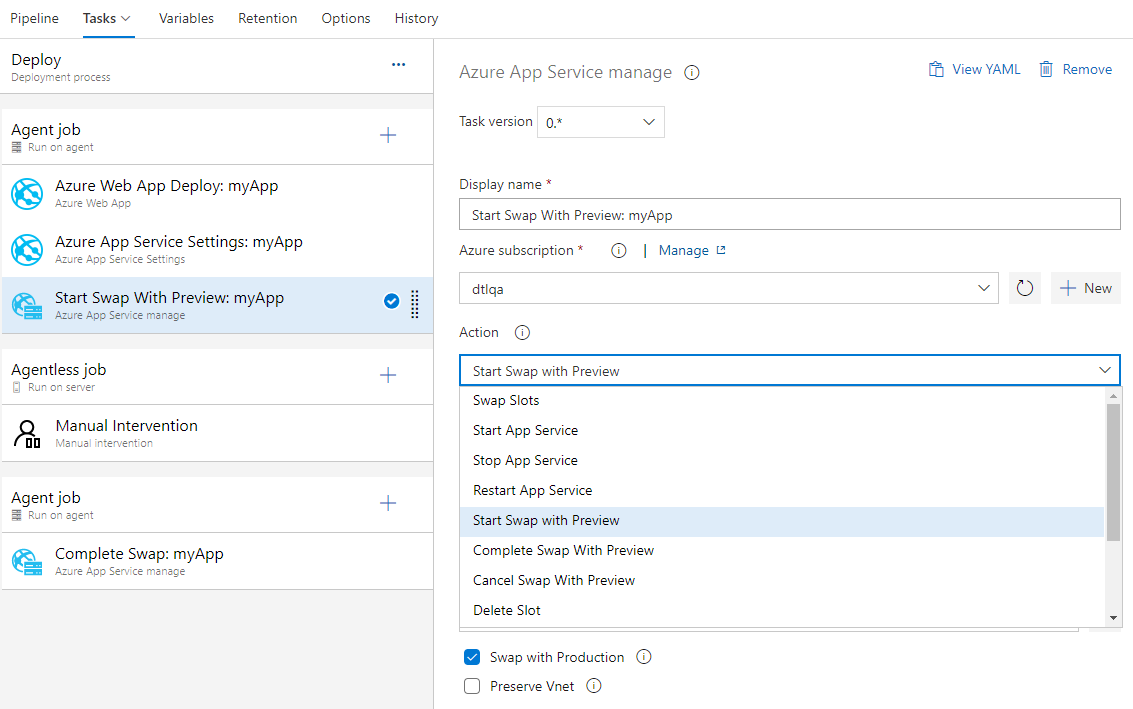

Servizio app di Azure ora supporta Lo scambio con l'anteprima

Servizio app di Azure ora supporta Lo scambio con anteprima sugli slot di distribuzione. Questo è un buon modo per convalidare l'app con la configurazione di produzione prima che l'app venga effettivamente scambiata da uno slot di staging nello slot di produzione. Ciò garantisce inoltre che lo slot di destinazione/produzione non verifichi tempi di inattività.

Servizio app di Azure attività supporta ora questo scambio a più fasi tramite le nuove azioni seguenti:

- Avvia scambio con anteprima : avvia uno scambio con un'anteprima (scambio a più fasi) e applica lo slot di destinazione (ad esempio, lo slot di produzione) allo slot di origine.

- Completare lo scambio con anteprima : quando si è pronti per completare lo scambio in sospeso, selezionare l'azione Completa scambio con anteprima.

- Annulla scambio con anteprima : per annullare uno scambio in sospeso, selezionare Annulla scambio con anteprima.

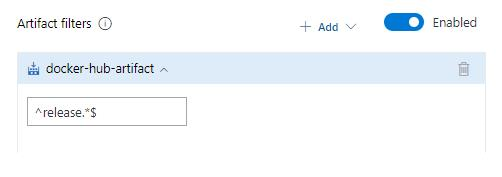

Filtro a livello di fase per Registro Azure Container e Docker Hub artefatti

In precedenza, i filtri delle espressioni regolari per Registro Azure Container e gli artefatti Docker Hub erano disponibili solo a livello di pipeline di rilascio. Sono stati aggiunti anche a livello di fase.

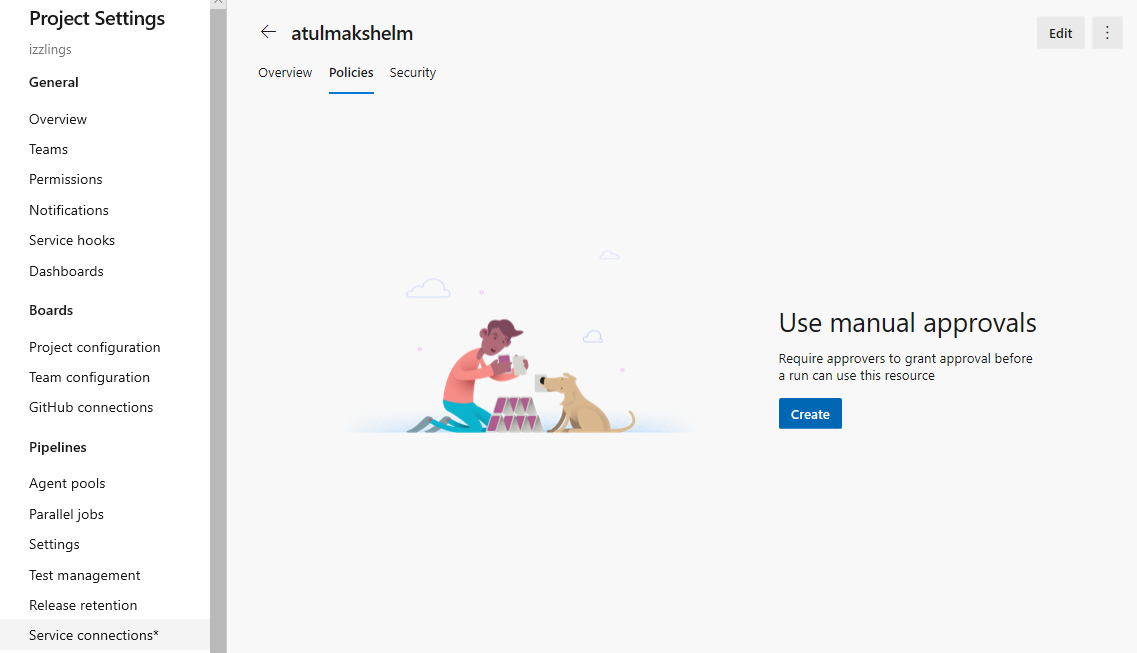

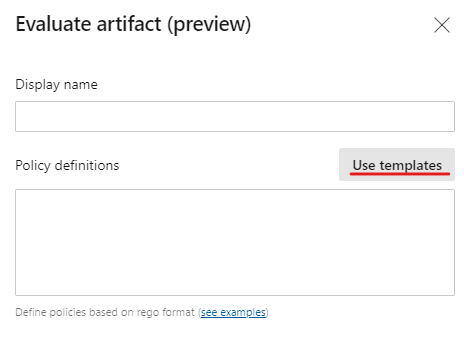

Miglioramenti alle approvazioni nelle pipeline YAML

È stata abilitata la configurazione delle approvazioni nelle connessioni di servizio e nei pool di agenti. Per le approvazioni, seguire la separazione dei ruoli tra i proprietari dell'infrastruttura e gli sviluppatori. Configurando le approvazioni sulle risorse, ad esempio ambienti, connessioni di servizio e pool di agenti, si garantisce che tutte le esecuzioni della pipeline che usano le risorse richiedono prima l'approvazione.

L'esperienza è simile alla configurazione delle approvazioni per gli ambienti. Quando un'approvazione è in sospeso in una risorsa a cui fa riferimento in una fase, l'esecuzione della pipeline attende fino a quando la pipeline non viene approvata manualmente.

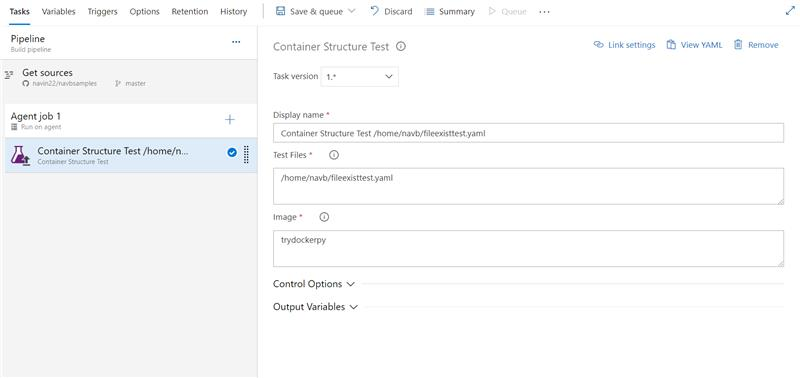

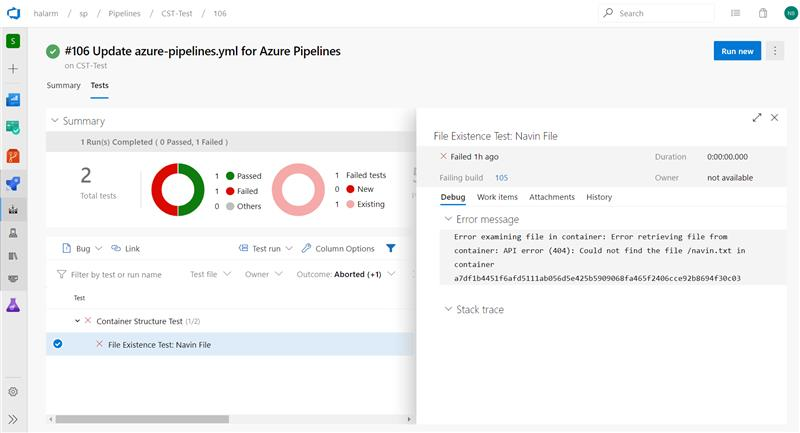

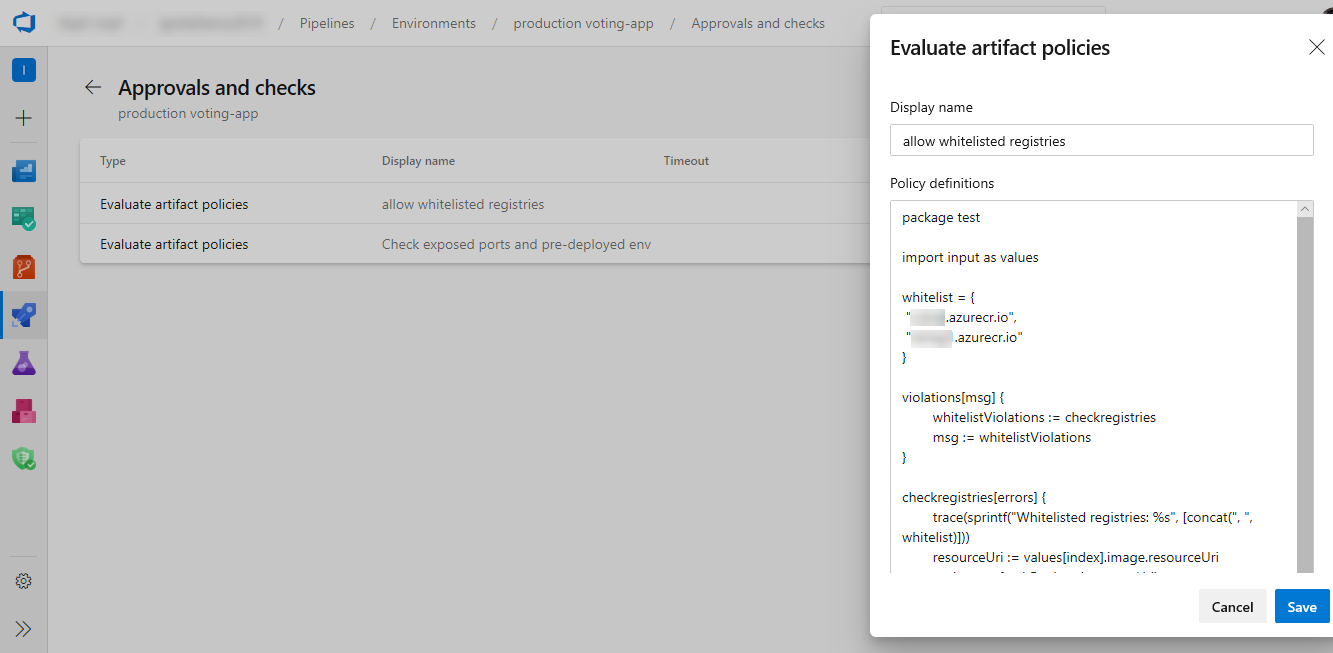

Supporto dei test della struttura dei contenitori in Azure Pipelines

L'utilizzo dei contenitori nelle applicazioni aumenta e quindi la necessità di test e convalida affidabili. Azure Pipelines offre ora supporto per i test della struttura dei contenitori. Questo framework offre un modo pratico e potente per verificare il contenuto e la struttura dei contenitori.

È possibile convalidare la struttura di un'immagine in base a quattro categorie di test che possono essere eseguiti insieme: test di comando, test di esistenza dei file, test di contenuto file e test dei metadati. È possibile usare i risultati nella pipeline per prendere decisioni su go/no. I dati di test sono disponibili nell'esecuzione della pipeline con un messaggio di errore che consente di risolvere meglio gli errori.

Immettere i dettagli del file di configurazione e dell'immagine

Testare i dati e il riepilogo

Decorator della pipeline per le pipeline di rilascio

I decoratori della pipeline consentono di aggiungere passaggi all'inizio e alla fine di ogni processo. Questa operazione è diversa dall'aggiunta di passaggi a una singola definizione perché si applica a tutte le pipeline in una raccolta.

Sono stati supportati elementi Decorator per le compilazioni e le pipeline YAML, con i clienti che li usano per controllare centralmente i passaggi nei processi. È ora in corso l'estensione del supporto anche per le pipeline di rilascio. È possibile creare estensioni per aggiungere passaggi destinati al nuovo punto di contributo e verranno aggiunti a tutti i processi dell'agente nelle pipeline di versione.

Distribuire Azure Resource Manager (ARM) a livello di sottoscrizione e gruppo di gestione

In precedenza, le distribuzioni sono supportate solo a livello di gruppo di risorse. Con questo aggiornamento è stato aggiunto il supporto per distribuire modelli di Resource Manager sia ai livelli della sottoscrizione che dei gruppi di gestione. Ciò consente di distribuire insieme un set di risorse, ma di inserirle in gruppi di risorse o sottoscrizioni diversi. Ad esempio, la distribuzione della macchina virtuale di backup per Azure Site Recovery in un gruppo di risorse e una posizione separati.

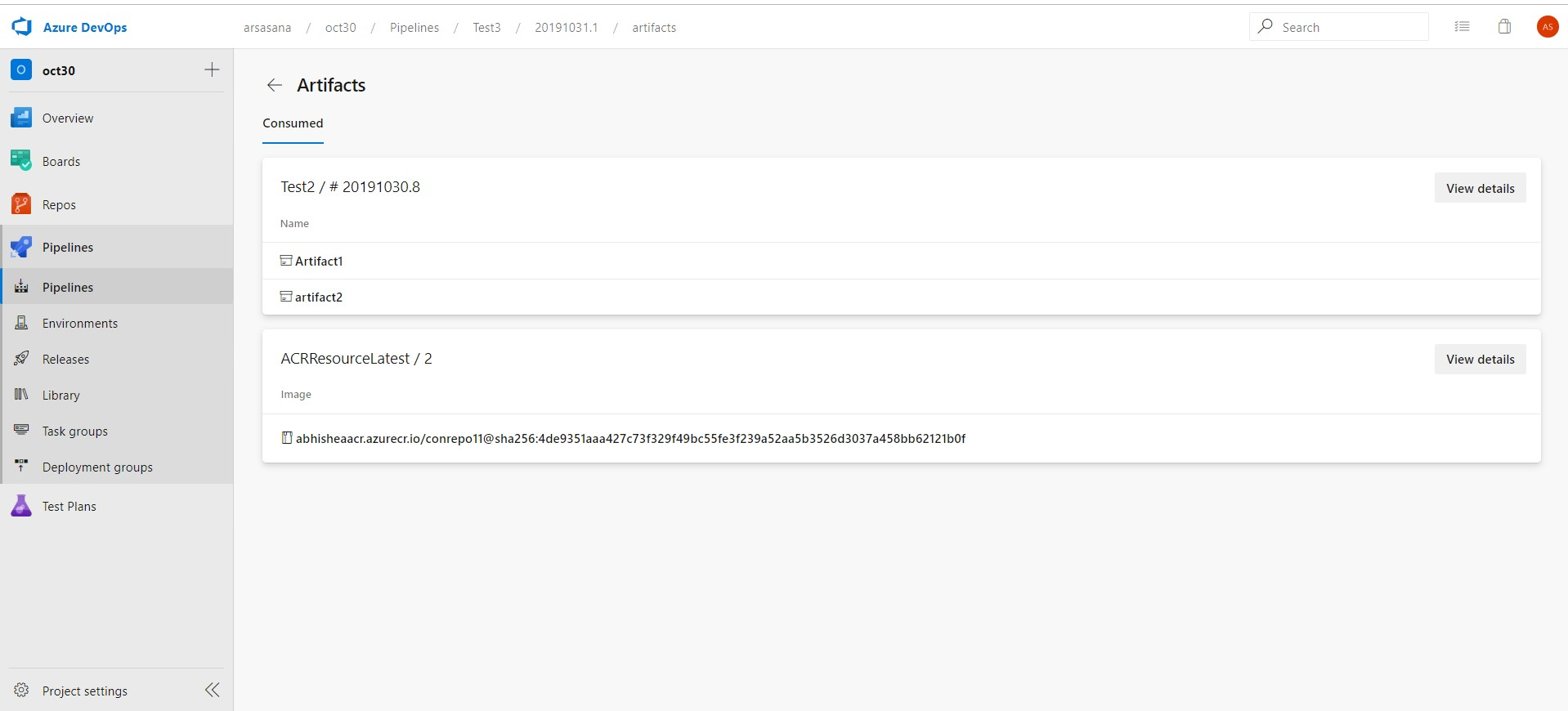

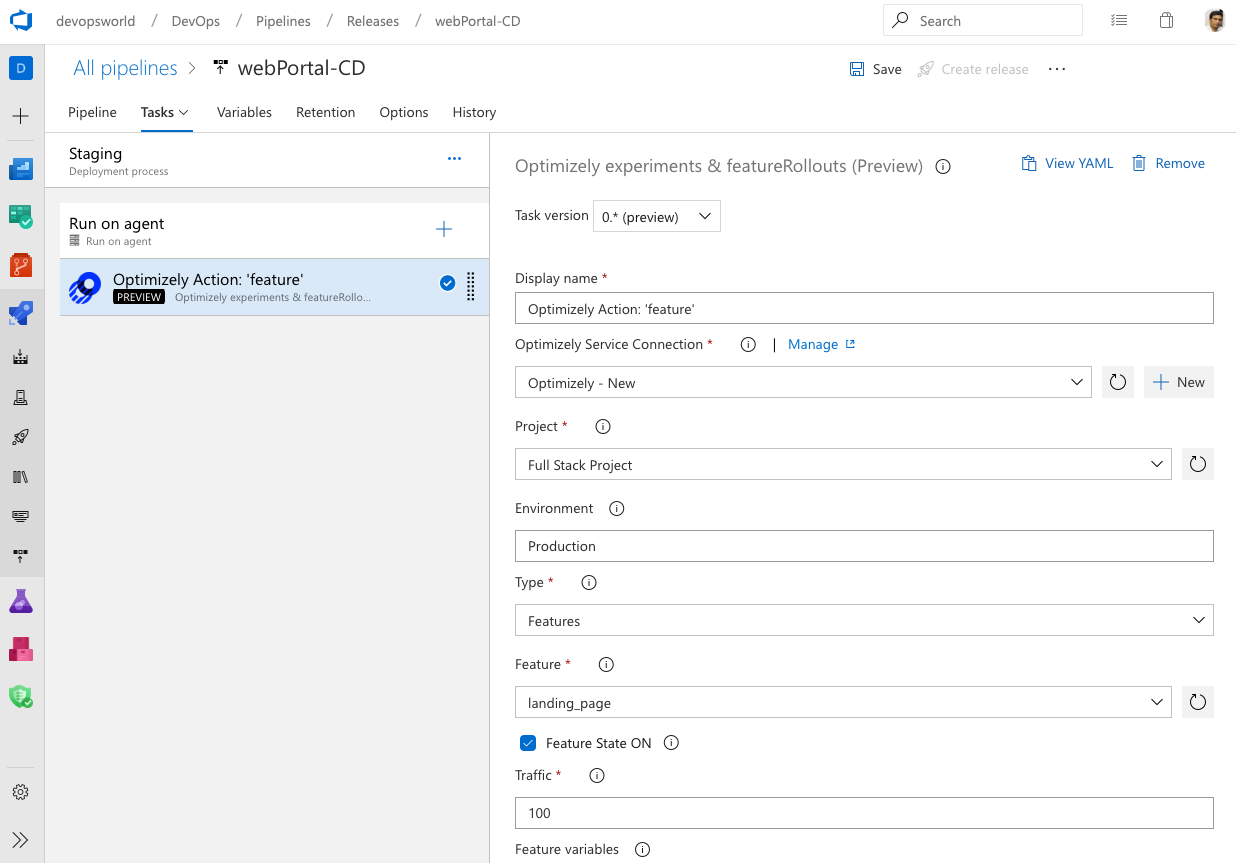

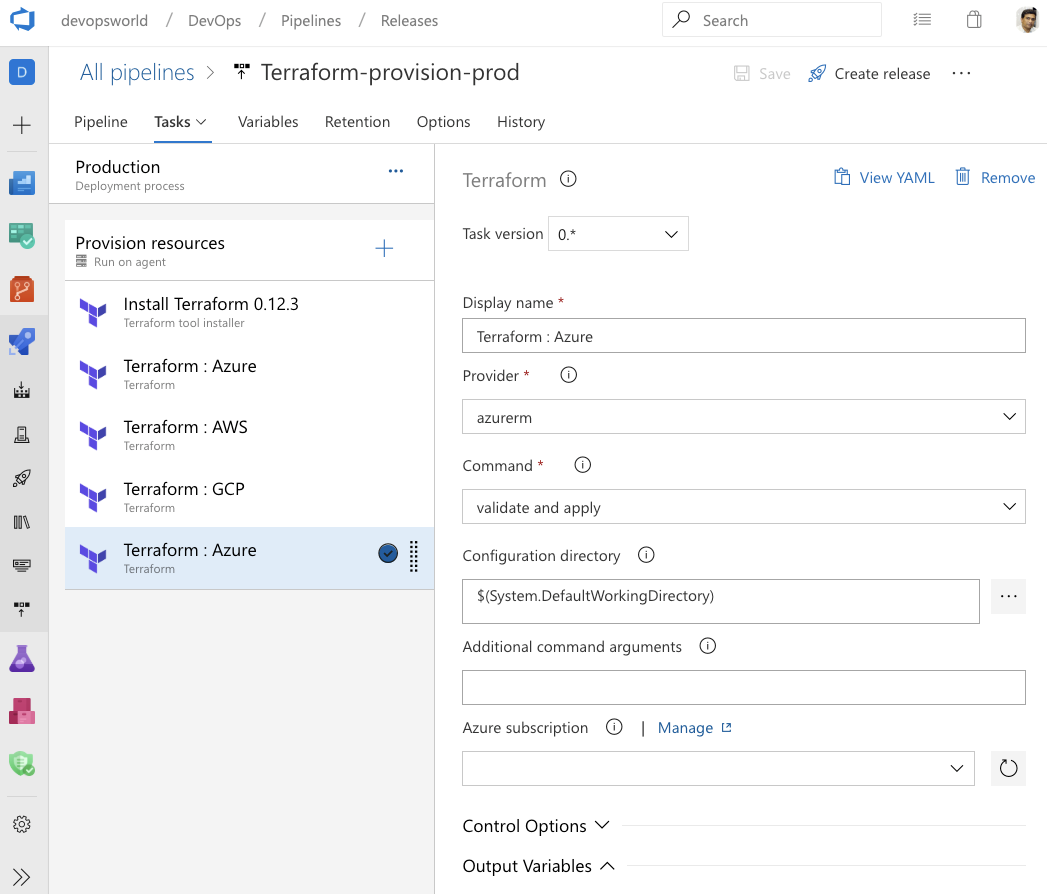

Funzionalità CD per le pipeline YAML in più fasi

È ora possibile usare gli artefatti pubblicati dalla pipeline CI e abilitare i trigger di completamento della pipeline. Nelle pipeline YAML in più fasi viene introdotto pipelines come risorsa. In YAML è ora possibile fare riferimento a un'altra pipeline e abilitare anche i trigger CD.