Elaborare i dati nella rete perimetrale con le pipeline di anteprima del processore di dati IoT di Azure

Importante

Anteprima delle operazioni di Azure IoT: abilitata da Azure Arc è attualmente disponibile in ANTEPRIMA. Non è consigliabile usare questo software di anteprima negli ambienti di produzione.

Vedere le condizioni per l'utilizzo supplementari per le anteprime di Microsoft Azure per termini legali aggiuntivi che si applicano a funzionalità di Azure in versione beta, in anteprima o in altro modo non ancora disponibili a livello generale.

Gli asset industriali generano dati in molti formati diversi e usano vari protocolli di comunicazione. Questa diversità di origini dati, abbinate a vari schemi e misure di unità, rende difficile l'uso e l'analisi dei dati industriali non elaborati in modo efficace. Inoltre, per motivi di conformità, sicurezza e prestazioni, non è possibile caricare tutti i set di dati nel cloud.

Per elaborare questi dati richiede tradizionalmente una progettazione dei dati costosa, complessa e dispendiosa in termini di tempo. Azure IoT Data Processor Preview è un servizio di elaborazione dati configurabile in grado di gestire le complessità e la diversità dei dati industriali. Usare il responsabile del trattamento dei dati per rendere i dati provenienti da origini diverse più comprensibili, utilizzabili e utili.

Che cos'è Azure IoT Data Processor Preview?

Azure IoT Data Processor Preview è un componente facoltativo di Azure IoT Operations Preview. Il responsabile del trattamento dei dati consente di aggregare, arricchire, normalizzare e filtrare i dati dai dispositivi. Il responsabile del trattamento dei dati è un motore di elaborazione dati basato su pipeline che consente di elaborare i dati nella rete perimetrale prima di inviarli agli altri servizi all'perimetro o nel cloud:

Il responsabile del trattamento dei dati inserisce dati in streaming in tempo reale da origini quali server OPC UA, storici e altri sistemi industriali. Normalizza questi dati convertendo vari formati di dati in un formato standardizzato e strutturato, che semplifica l'esecuzione di query e analisi. Il responsabile del trattamento dei dati può anche contestualizzare i dati, arricchire i dati con dati di riferimento o ultimi valori noti (LKV) per offrire una visione completa delle operazioni industriali.

L'output del responsabile del trattamento dei dati è costituito da dati puliti, arricchiti e standardizzati pronti per applicazioni downstream, ad esempio strumenti analitici e analitici in tempo reale. Il responsabile del trattamento dei dati riduce significativamente il tempo necessario per trasformare i dati non elaborati in informazioni dettagliate interattive.

Le funzionalità chiave del responsabile del trattamento dei dati includono:

Normalizzazione flessibile dei dati per convertire più formati di dati in una struttura standardizzata.

Arricchimento di flussi di dati con dati di riferimento o LKV per migliorare il contesto e migliorare le informazioni dettagliate.

Integrazione integrata di Microsoft Fabric per semplificare l'analisi dei dati puliti.

Possibilità di elaborare i dati da varie origini e pubblicare i dati in varie destinazioni.

Come piattaforma di elaborazione dati indipendente dai dati, il responsabile del trattamento dei dati può inserire dati in qualsiasi formato, elaborare i dati e quindi scriverli in una destinazione. Per supportare queste funzionalità, il responsabile del trattamento dei dati può deserializzare e serializzare vari formati. Ad esempio, può serializzare in parquet per scrivere file in Microsoft Fabric.

Criteri di ripetizione automatici e configurabili per gestire gli errori temporanei durante l'invio di dati alle destinazioni cloud.

Distribuire il responsabile del trattamento dei dati

Per impostazione predefinita, il responsabile del trattamento dei dati non è incluso in una distribuzione di Azure IoT Operations Preview. Se si prevede di usare il responsabile del trattamento dei dati, è necessario includerlo quando si distribuisce Azure IoT Operations Preview. Non è possibile aggiungerlo in un secondo momento. Per distribuire il responsabile del trattamento dei dati, usare l'argomento --include-dp quando si esegue il comando az iot ops init . Per altre informazioni, vedere Distribuire le estensioni di Anteprima operazioni IoT di Azure in un cluster Kubernetes.

Definizione di pipeline

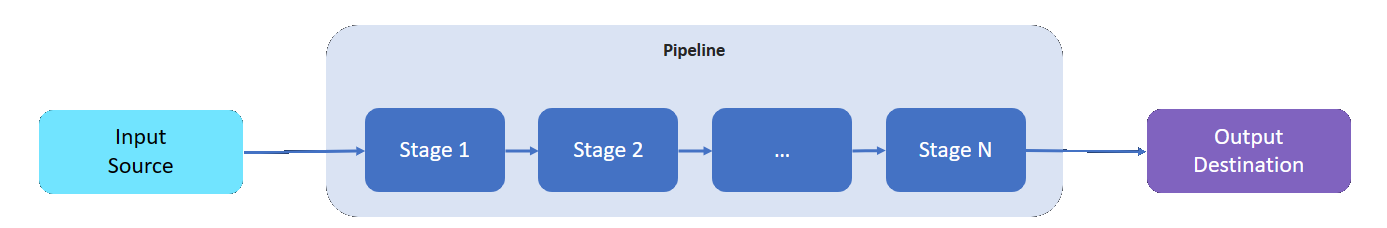

Una pipeline del responsabile del trattamento dei dati ha un'origine di input da cui legge i dati, una destinazione in cui scrive i dati elaborati e un numero variabile di fasi intermedie per elaborare i dati.

Le fasi intermedie rappresentano le diverse funzionalità di elaborazione dati disponibili:

- È possibile aggiungere tutte le fasi intermedie necessarie a una pipeline.

- È possibile ordinare le fasi intermedie di una pipeline in base alle esigenze. È possibile riordinare le fasi dopo aver creato una pipeline.

- Ogni fase è conforme a un'interfaccia di implementazione definita e a un contratto dello schema di input/output.

- Ogni fase è indipendente dalle altre fasi della pipeline.

- Tutte le fasi operano nell'ambito di una partizione. I dati non vengono condivisi tra partizioni diverse.

- I dati passano da una fase all'unica successiva.

Le pipeline del processore di dati possono usare le fasi seguenti:

| Fase | Descrizione |

|---|---|

| Origine - MQ | Recupera i dati da un broker MQTT. |

| Origine - Endpoint HTTP | Recupera i dati da un endpoint HTTP. |

| Origine - SQL | Recupera i dati da un database di Microsoft SQL Server. |

| Origine - InfluxDB | Recupera i dati da un database InfluxDB. |

| Filtra | Filtra i dati provenienti dalla fase. Ad esempio, filtrare qualsiasi messaggio con temperatura esterna all'intervallo 50F-150F . |

| Transform | Normalizza la struttura dei dati. Ad esempio, modificare la struttura da {"Name": "Temp", "value": 50} a {"temp": 50}. |

| LKV | Archivia i valori delle metriche selezionati in un archivio LKV. Ad esempio, archiviare solo le misurazioni di temperatura e umidità in LKV, ignorare il resto. Una fase successiva può arricchire un messaggio con i dati LKV archiviati. |

| Arricchire | Arricchisce i messaggi con i dati dell'archivio dati di riferimento. Ad esempio, aggiungere un nome di operatore e un numero di lotto dal set di dati delle operazioni. |

| Aggregazione | Aggrega i valori che passano attraverso la fase. Ad esempio, quando i valori di temperatura vengono inviati ogni 100 millisecondi, generare una metrica di temperatura media ogni 30 secondi. |

| Call out | Effettua una chiamata a un servizio HTTP o gRPC esterno. Ad esempio, chiamare una funzione di Azure per eseguire la conversione da un formato di messaggio personalizzato a JSON. |

| Destinazione - MQ | Scrive i dati elaborati, puliti e contestualizzati in un argomento MQTT. |

| Destinazione - Informazioni di riferimento | Scrive i dati elaborati nell'archivio di riferimento predefinito. Altre pipeline possono usare l'archivio di riferimento per arricchire i messaggi. |

| Destinazione - gRPC | Invia i dati elaborati, puliti e contestualizzati a un endpoint gRPC. |

| Destinazione - HTTP | Invia i dati elaborati, puliti e contestualizzati a un endpoint HTTP. |

| Destinazione - Fabric Lakehouse | Invia i dati elaborati, puliti e contestualizzati a un lakehouse di Microsoft Fabric nel cloud. |

| Destinazione - Azure Esplora dati | Invia i dati elaborati, puliti e contestualizzati a un endpoint Esplora dati di Azure nel cloud. |

Passaggio successivo

Per provare le pipeline del processore di dati, vedere le guide introduttive sulle operazioni di Azure IoT.

Per altre informazioni sul responsabile del trattamento dei dati, vedere:

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per