GlusterFS in VM di Azure in Red Hat Enterprise Linux per SAP NetWeaver

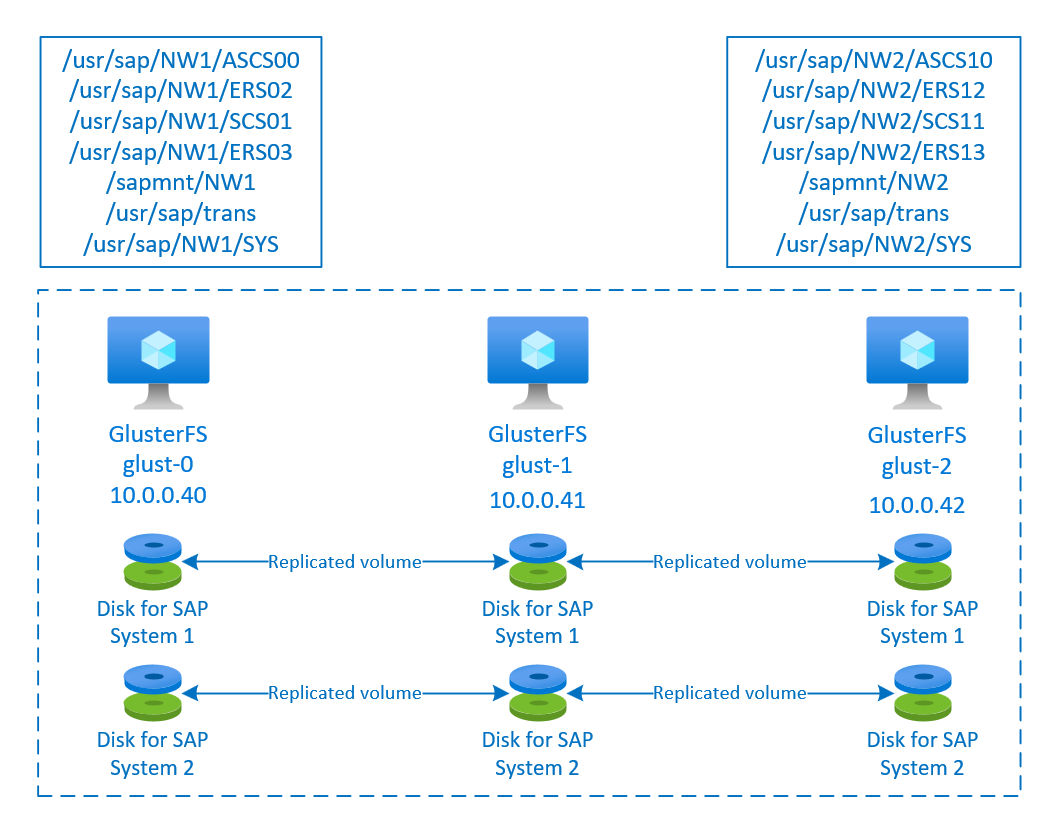

Questo articolo descrive come distribuire le macchine virtuali, configurare le macchine virtuali e installare un cluster GlusterFS che può essere usato per archiviare i dati condivisi di un sistema SAP a disponibilità elevata. Questa guida descrive come configurare il cluster GlusterFS usato da due sistemi SAP, NW1 e NW2. I nomi delle risorse, ad esempio delle macchine virtuali e delle reti virtuali, nell'esempio presuppongono che sia stato usato il modello di file server SAP con il prefisso di risorsa glust.

Tenere presente che come documentato in Red Hat Gluster Storage Life Cycle Red Hat Gluster Storage raggiungerà la fine della vita alla fine del 2024. La configurazione sarà supportata per SAP in Azure fino a quando non raggiunge la fine della fase di vita. GlusterFS non deve essere usato per le nuove distribuzioni. È consigliabile distribuire le directory condivise SAP in NFS in volumi File di Azure o Azure NetApp Files, come documentato in DISPONIBILITÀ elevata per SAP NW in RHEL con NFS in File di Azure o disponibilità elevata per SAP NW in RHEL con Azure NetApp Files.

Leggere prima di tutto le note e i documenti seguenti relativi a SAP

Nota SAP 1928533, contenente:

- Elenco delle dimensioni delle VM di Azure supportate per la distribuzione di software SAP

- Importanti informazioni sulla capacità per le dimensioni delle VM di Azure

- Software SAP e combinazioni di sistemi operativi e database supportati

- Versione del kernel SAP richiesta per Windows e Linux in Microsoft Azure

La nota SAP 2015553 elenca i prerequisiti per le distribuzioni di software SAP supportate da SAP in Azure.

La nota SAP 2002167 indica le impostazioni del sistema operativo consigliate per Red Hat Enterprise Linux

La nota SAP 2009879 contiene le linee guida di SAP HANA per Red Hat Enterprise Linux

La nota SAP 2178632 contiene informazioni dettagliate su tutte le metriche di monitoraggio segnalate per SAP in Azure.

La nota SAP 2191498 contiene la versione dell'agente host SAP per Linux necessaria in Azure.

La nota SAP 2243692 contiene informazioni sulle licenze SAP in Linux in Azure.

La nota SAP 1999351 contiene informazioni aggiuntive sulla risoluzione dei problemi per l'estensione di monitoraggio avanzato di Azure per SAP.

Community WIKI SAP contiene tutte le note su SAP necessarie per Linux.

Pianificazione e implementazione di Macchine virtuali di Azure per SAP in Linux

Distribuzione di Macchine virtuali di Microsoft Azure per SAP in Linux (questo articolo)

Distribuzione DBMS di Macchine virtuali di Azure per SAP in Linux

Documentazione generale di RHEL

- High Availability Add-On Overview (Panoramica dei componenti aggiuntivi a disponibilità elevata)

- High Availability Add-On Administration (Amministrazione dei componenti aggiuntivi a disponibilità elevata)

- High Availability Add-On Reference (Riferimento dei componenti aggiuntivi a disponibilità elevata)

- Ciclo di vita dell'archiviazione di Red Hat Gluster

Documentazione di RHEL specifica per Azure:

- Support Policies for RHEL High Availability Clusters - Microsoft Azure Virtual Machines as Cluster Members (Criteri di supporto per cluster RHEL a disponibilità elevata - Macchine virtuali di Microsoft Azure come membri del cluster)

- Installing and Configuring a Red Hat Enterprise Linux 7.4 (and later) High-Availability Cluster on Microsoft Azure (Installazione e configurazione di un cluster Red Hat Enterprise Linux 7.4 e versioni successive a disponibilità elevata in Microsoft Azure)

Panoramica

Per ottenere la disponibilità elevata, SAP NetWeaver richiede l'archiviazione condivisa. GlusterFS viene configurato in un cluster separato e può essere usato da più sistemi SAP.

Configurare GlusterFS

In questo esempio le risorse sono state distribuite manualmente tramite il portale di Azure.

Distribuire Linux manualmente tramite il portale di Azure

Questo documento presuppone che sia già stato distribuito un gruppo di risorse, una rete virtuale di Azure e una subnet.

Distribuire macchine virtuali per GlusterFS. Scegliere un'immagine RHEL appropriata supportata per l'archiviazione Gluster. È possibile distribuire una macchina virtuale in una delle opzioni di disponibilità: set di scalabilità, zona di disponibilità o set di disponibilità.

Configurare GlusterFS

Gli elementi seguenti sono preceduti dall'indicazione [A], applicabile a tutti i nodi, [1], applicabile solo al nodo 1, [2], applicabile solo al nodo 2, [3], applicabile solo al nodo 3.

[A] Configurare la risoluzione dei nomi host

È possibile usare un server DNS o modificare /etc/hosts in tutti i nodi. Questo esempio mostra come usare il file /etc/hosts. Sostituire l'indirizzo IP e il nome host nei comandi seguenti

sudo vi /etc/hostsInserire le righe seguenti in /etc/hosts. Modificare l'indirizzo IP e il nome host in base all'ambiente

# IP addresses of the Gluster nodes 10.0.0.40 glust-0 10.0.0.41 glust-1 10.0.0.42 glust-2[A] Eseguire la registrazione

Registrare le macchine virtuali e allegarle a un pool che contiene i repository per RHEL 7 e GlusterFS

sudo subscription-manager register sudo subscription-manager attach --pool=<pool id>[A] Abilitare il repository GlusterFS

Per installare i pacchetti necessari, abilitare i repository seguenti.

sudo subscription-manager repos --disable "*" sudo subscription-manager repos --enable=rhel-7-server-rpms sudo subscription-manager repos --enable=rh-gluster-3-for-rhel-7-server-rpms[A] Installare i pacchetti GlusterFS

Installare questi pacchetti in tutti i nodi GlusterFS

sudo yum -y install redhat-storage-serverRiavviare i nodi dopo l'installazione.

[A] Modificare il firewall

Aggiungere regole del firewall per consentire il traffico client verso i nodi GlusterFS.

# list the available zones firewall-cmd --get-active-zones sudo firewall-cmd --zone=public --add-service=glusterfs --permanent sudo firewall-cmd --zone=public --add-service=glusterfs[A] Abilitare e avviare il servizio GlusterFS

Avviare il servizio GlusterFS in tutti i nodi.

sudo systemctl start glusterd sudo systemctl enable glusterd[1] Creare il cluster GlusterFS

Eseguire i comandi seguenti per creare il cluster GlusterFS

sudo gluster peer probe glust-1 sudo gluster peer probe glust-2 # Check gluster peer status sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Accepted peer request (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Accepted peer request (Connected)[2] Test dello stato del peer

Testare lo stato del peer nel secondo nodo

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-2 # Uuid: 9e340385-12fe-495e-ab0f-4f851b588cba # State: Peer in Cluster (Connected)[3] Test dello stato del peer

Testare lo stato del peer nel terzo nodo

sudo gluster peer status # Number of Peers: 2 # # Hostname: glust-0 # Uuid: 6bc6927b-7ee2-461b-ad04-da123124d6bd # State: Peer in Cluster (Connected) # # Hostname: glust-1 # Uuid: 10d43840-fee4-4120-bf5a-de9c393964cd # State: Peer in Cluster (Connected)[A] Creare LVM

In questo esempio GlusterFS viene usato per due sistemi SAP, NW1 e NW2. Usare i comandi seguenti per creare le configurazioni LVM per questi sistemi SAP.

Usare questi comandi per NW1

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun0 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW1 /dev/disk/azure/scsi1/lun0 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW1/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW1/trans sudo lvcreate -l 10%FREE -n rhgs-NW1/sys sudo lvcreate -l 50%FREE -n rhgs-NW1/ascs sudo lvcreate -l 100%FREE -n rhgs-NW1/aers sudo lvscan sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW1/aers sudo mkdir -p /rhs/NW1/sapmnt sudo mkdir -p /rhs/NW1/trans sudo mkdir -p /rhs/NW1/sys sudo mkdir -p /rhs/NW1/ascs sudo mkdir -p /rhs/NW1/aers sudo chattr +i /rhs/NW1/sapmnt sudo chattr +i /rhs/NW1/trans sudo chattr +i /rhs/NW1/sys sudo chattr +i /rhs/NW1/ascs sudo chattr +i /rhs/NW1/aers echo -e "/dev/rhgs-NW1/sapmnt\t/rhs/NW1/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/trans\t/rhs/NW1/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/sys\t/rhs/NW1/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/ascs\t/rhs/NW1/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW1/aers\t/rhs/NW1/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -aUsare questi comandi per NW2

sudo pvcreate --dataalignment 1024K /dev/disk/azure/scsi1/lun1 sudo pvscan sudo vgcreate --physicalextentsize 256K rhgs-NW2 /dev/disk/azure/scsi1/lun1 sudo vgscan sudo lvcreate -l 50%FREE -n rhgs-NW2/sapmnt sudo lvcreate -l 20%FREE -n rhgs-NW2/trans sudo lvcreate -l 10%FREE -n rhgs-NW2/sys sudo lvcreate -l 50%FREE -n rhgs-NW2/ascs sudo lvcreate -l 100%FREE -n rhgs-NW2/aers sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sapmnt sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/trans sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/sys sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/ascs sudo mkfs.xfs -f -K -i size=512 -n size=8192 /dev/rhgs-NW2/aers sudo mkdir -p /rhs/NW2/sapmnt sudo mkdir -p /rhs/NW2/trans sudo mkdir -p /rhs/NW2/sys sudo mkdir -p /rhs/NW2/ascs sudo mkdir -p /rhs/NW2/aers sudo chattr +i /rhs/NW2/sapmnt sudo chattr +i /rhs/NW2/trans sudo chattr +i /rhs/NW2/sys sudo chattr +i /rhs/NW2/ascs sudo chattr +i /rhs/NW2/aers sudo lvscan echo -e "/dev/rhgs-NW2/sapmnt\t/rhs/NW2/sapmnt\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/trans\t/rhs/NW2/trans\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/sys\t/rhs/NW2/sys\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/ascs\t/rhs/NW2/ascs\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab echo -e "/dev/rhgs-NW2/aers\t/rhs/NW2/aers\txfs\tdefaults,inode64,nobarrier,noatime,nouuid 0 2" | sudo tee -a /etc/fstab sudo mount -a[1] Creare il volume distribuito

Usare i comandi seguenti per creare il volume GlusterFS per NW1 e avviarlo.

sudo gluster vol create NW1-sapmnt replica 3 glust-0:/rhs/NW1/sapmnt glust-1:/rhs/NW1/sapmnt glust-2:/rhs/NW1/sapmnt force sudo gluster vol create NW1-trans replica 3 glust-0:/rhs/NW1/trans glust-1:/rhs/NW1/trans glust-2:/rhs/NW1/trans force sudo gluster vol create NW1-sys replica 3 glust-0:/rhs/NW1/sys glust-1:/rhs/NW1/sys glust-2:/rhs/NW1/sys force sudo gluster vol create NW1-ascs replica 3 glust-0:/rhs/NW1/ascs glust-1:/rhs/NW1/ascs glust-2:/rhs/NW1/ascs force sudo gluster vol create NW1-aers replica 3 glust-0:/rhs/NW1/aers glust-1:/rhs/NW1/aers glust-2:/rhs/NW1/aers force sudo gluster volume start NW1-sapmnt sudo gluster volume start NW1-trans sudo gluster volume start NW1-sys sudo gluster volume start NW1-ascs sudo gluster volume start NW1-aersUsare i comandi seguenti per creare il volume GlusterFS per NW2 e avviarlo.

sudo gluster vol create NW2-sapmnt replica 3 glust-0:/rhs/NW2/sapmnt glust-1:/rhs/NW2/sapmnt glust-2:/rhs/NW2/sapmnt force sudo gluster vol create NW2-trans replica 3 glust-0:/rhs/NW2/trans glust-1:/rhs/NW2/trans glust-2:/rhs/NW2/trans force sudo gluster vol create NW2-sys replica 3 glust-0:/rhs/NW2/sys glust-1:/rhs/NW2/sys glust-2:/rhs/NW2/sys force sudo gluster vol create NW2-ascs replica 3 glust-0:/rhs/NW2/ascs glust-1:/rhs/NW2/ascs glust-2:/rhs/NW2/ascs force sudo gluster vol create NW2-aers replica 3 glust-0:/rhs/NW2/aers glust-1:/rhs/NW2/aers glust-2:/rhs/NW2/aers force sudo gluster volume start NW2-sapmnt sudo gluster volume start NW2-trans sudo gluster volume start NW2-sys sudo gluster volume start NW2-ascs sudo gluster volume start NW2-aers

Passaggi successivi

- Installare SAP ASCS e il database

- Pianificazione e implementazione di macchine virtuali di Azure per SAP

- Distribuzione di Macchine virtuali di Azure per SAP

- Distribuzione DBMS di macchine virtuali di Azure per SAP

- Per informazioni su come stabilire la disponibilità elevata e pianificare il ripristino di emergenza di SAP HANA in Azure (istanze di grandi dimensioni), vedere Disponibilità elevata e ripristino di emergenza di SAP HANA (istanze di grandi dimensioni) in Azure.

- Per informazioni su come ottenere la disponibilità elevata e un piano di ripristino di emergenza di SAP HANA nelle macchine virtuali di Azure vedere Disponibilità elevata di SAP HANA nelle macchine virtuali di Azure (VM)