Dimensioni delle macchine virtuali serie HB

Si applica a: ✔️ macchine virtuali Linux ✔️ macchine virtuali Windows ✔️ set di scalabilità flessibili ✔️ set di scalabilità uniformi

Sono stati eseguiti diversi test sulle dimensioni delle serie HB. Di seguito sono riportati alcuni dei risultati di questo test delle prestazioni.

| Carico di lavoro | HB |

|---|---|

| Triade STREAM | 260 GB/s (32-33 GB/s per CCX) |

| Linpack ad alte prestazioni (HPL) | 1.000 GigaFLOPS (Rpeak), 860 GigaFLOPS (Rmax) |

| Latenza e larghezza di banda RDMA | 1,27 microsecondi, 99,1 Gb/s |

| FIO nell'unità SSD NVMe locale | Letture da 1,7 GB/s, 1,0 GB/s |

| IOR su 4 * UNITÀ SSD Premium di Azure (P30 Managed Disks, RAID0)** | Letture da 725 MB/s, 780 MB/scritture |

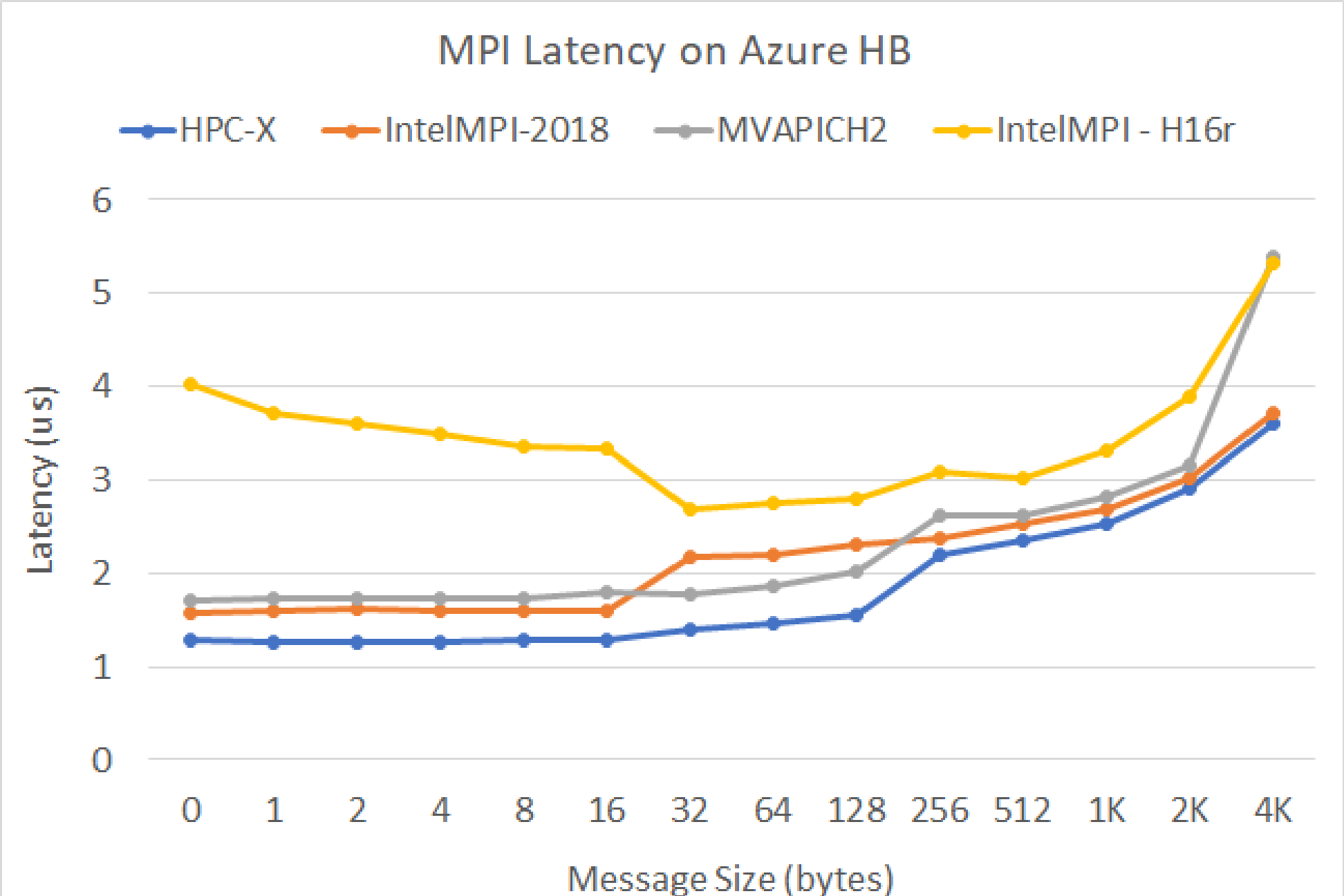

Latenza MPI

Viene eseguito il test di latenza MPI della suite microbenchmark OSU. Gli script di esempio si trovano in GitHub

./bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./osu_latency

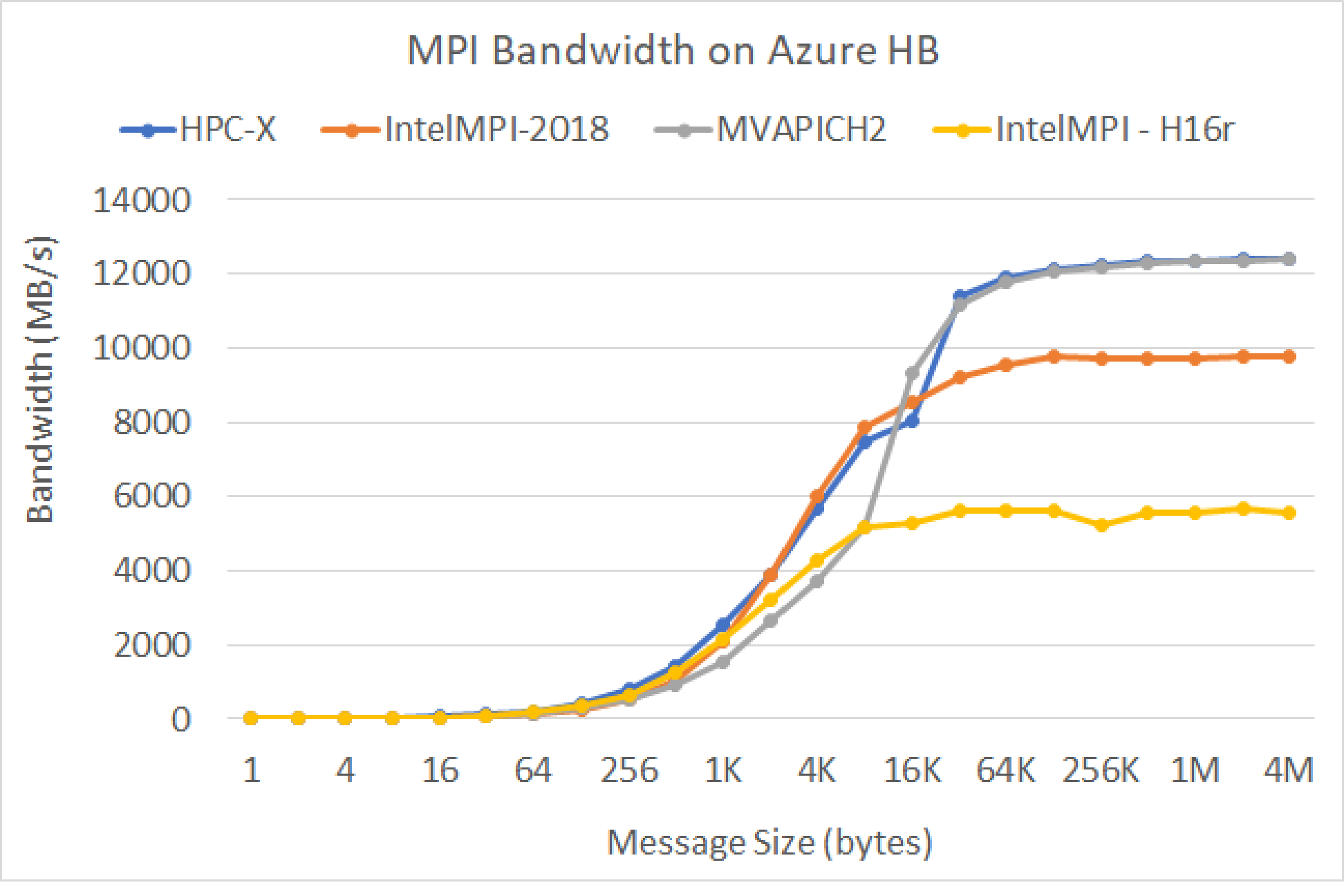

Larghezza di banda MPI

Viene eseguito il test della larghezza di banda MPI della suite microbenchmark OSU. Gli script di esempio si trovano in GitHub

./mvapich2-2.3.install/bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./mvapich2-2.3/osu_benchmarks/mpi/pt2pt/osu_bw

Mellanox Perftest

Il pacchetto Mellanox Perftest include molti test InfiniBand, ad esempio latenza (ib_send_lat) e larghezza di banda (ib_send_bw). Di seguito è riportato un comando di esempio.

numactl --physcpubind=[INSERT CORE #] ib_send_lat -a

Passaggi successivi

- Per informazioni sugli annunci più recenti, sugli esempi di carico di lavoro HPC e sui risultati delle prestazioni, vedere i Blog della community tecnica di Calcolo di Azure.

- Per un quadro generale sull'architettura per l'esecuzione di carichi di lavoro HPC, vedere High Performance Computing (HPC) in Azure.