Modulo 1: Creare una pipeline con Data Factory

Questo modulo richiede 10 minuti, l'inserimento di dati non elaborati dall'archivio di origine nella tabella Bronze di un data Lakehouse usando il attività Copy in una pipeline.

I passaggi generali del modulo 1 sono i seguenti:

- Creare una pipeline di dati.

- Usare un'attività di copia nella pipeline per caricare dati di esempio in un data Lakehouse.

Creare una pipeline di dati

È necessario un account tenant di Microsoft Fabric con una sottoscrizione attiva. Creare un account gratuito.

Assicurarsi di disporre di un'area di lavoro abilitata per Microsoft Fabric: Creare un'area di lavoro.

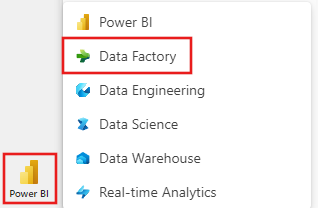

Accedi a Power BI.

Selezionare l'icona predefinita di Power BI nella parte inferiore sinistra della schermata e passare all'esperienza data factory .

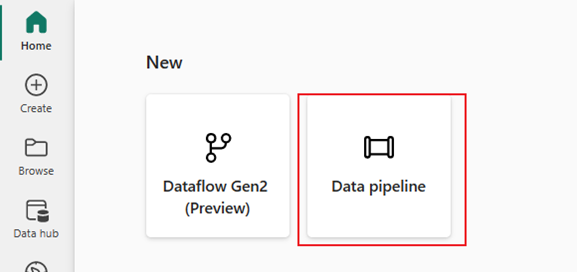

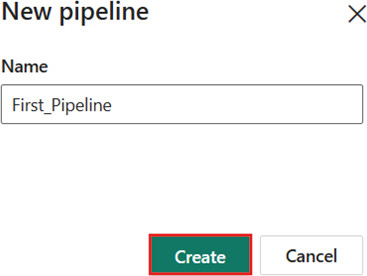

Selezionare Pipeline di dati e specificare un nome di pipeline. Selezionare Crea.

Usare un attività Copy nella pipeline per caricare dati di esempio in un data Lakehouse

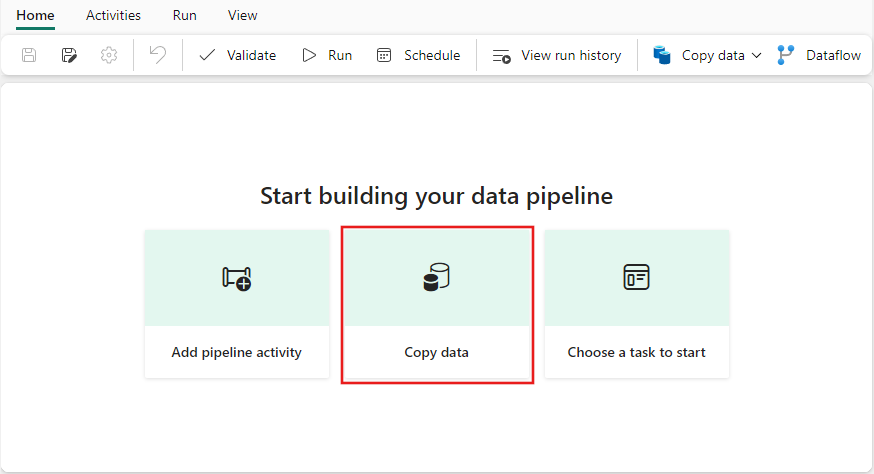

Passaggio 1: Usare l'assistente copia per configurare un'attività di copia.

Selezionare Copia dati per aprire lo strumento Di assistente copia.

Passaggio 2: Configurare le impostazioni nell'Assistente copia.

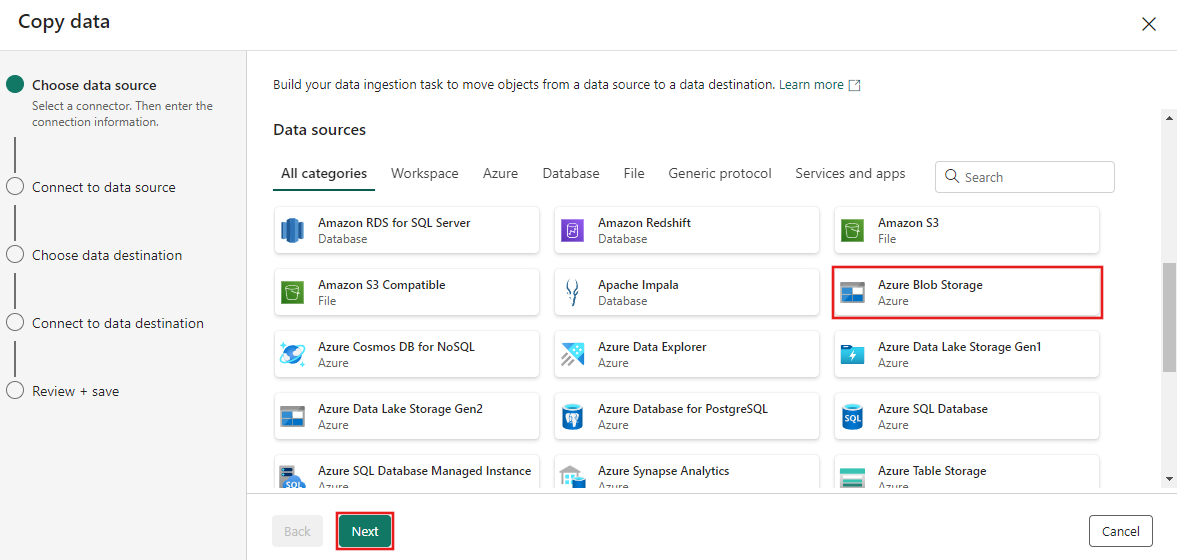

La finestra di dialogo Copia dati viene visualizzata con il primo passaggio, Scegliere l'origine dati, evidenziata. Scorrere verso il basso, se necessario, alla sezione Origini dati e selezionare il tipo di origine dati Archiviazione BLOB di Azure. Quindi seleziona Avanti.

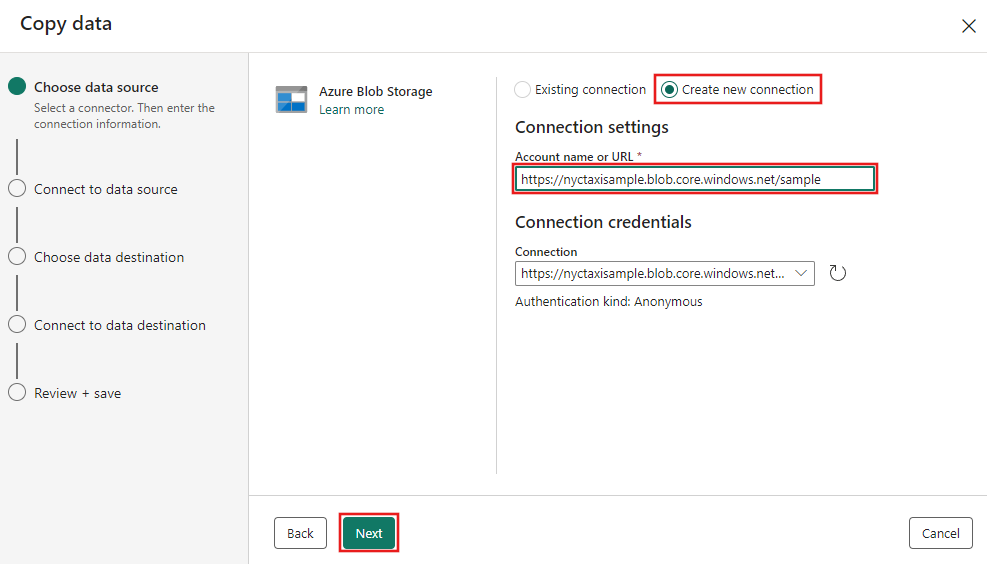

Nel passaggio successivo selezionare Crea nuova connessione e quindi specificare l'URL per l'archivio BLOB che ospita i dati di esempio forniti per questa esercitazione all'indirizzo

https://nyctaxisample.blob.core.windows.net/sample. Il tipo di autenticazione è Anonymous. Selezionare Avanti dopo aver specificato l'URL.

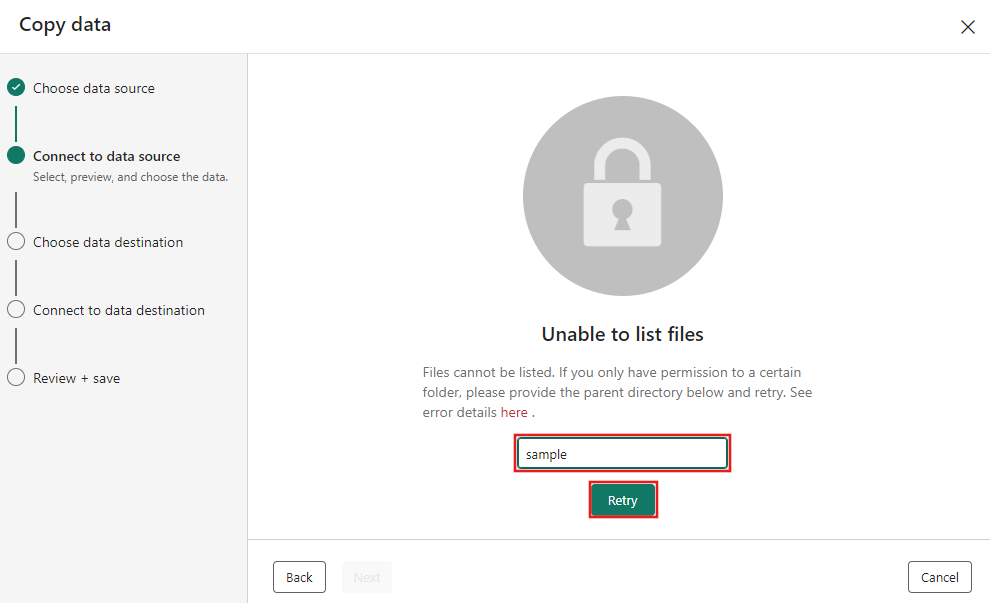

Viene visualizzato il passaggio Connessione all'origine dati e inizialmente viene visualizzato un errore Impossibile elencare i file, perché le autorizzazioni sono state concesse solo alla cartella di esempio nell'archivio BLOB. Specificare il nome della cartella, l'esempio e selezionare Riprova.

Nota

La cartella di archiviazione BLOB fa distinzione tra maiuscole e minuscole e deve essere in lettere minuscole.

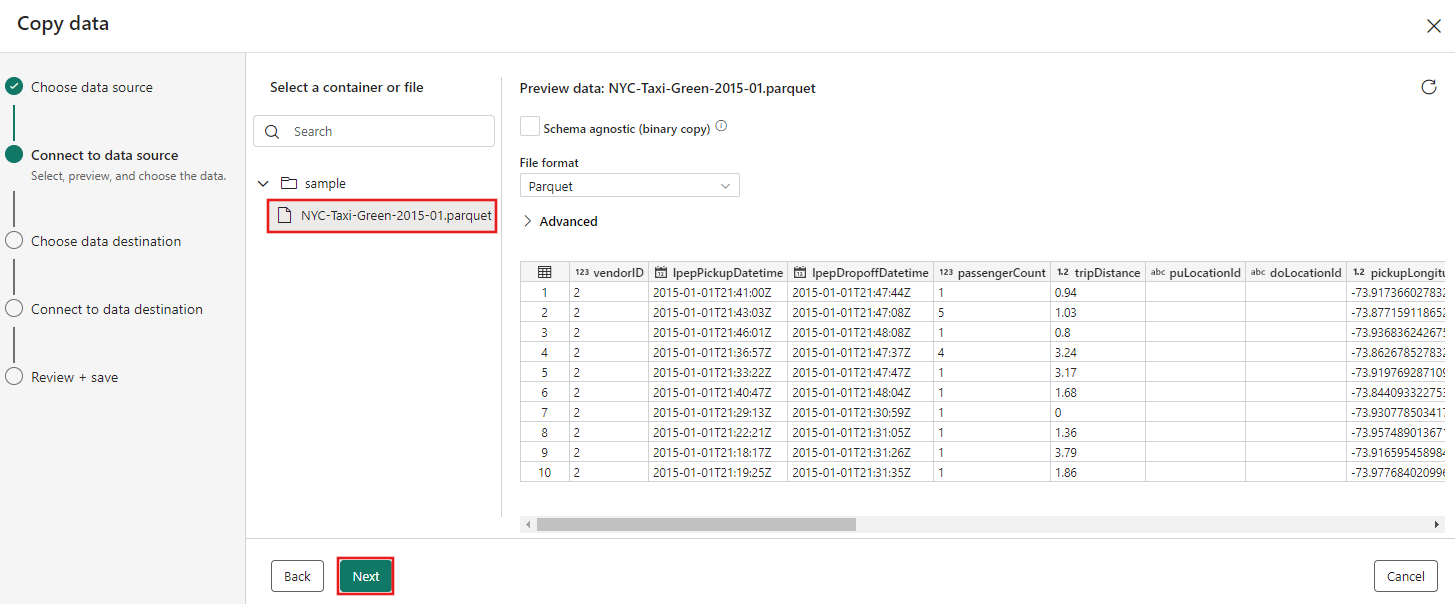

Verrà visualizzato il browser di archiviazione BLOB successivo. Selezionare il file NYC-Taxi-Green-2015-01.parquet e attendere la visualizzazione dell'anteprima dei dati. Quindi seleziona Avanti.

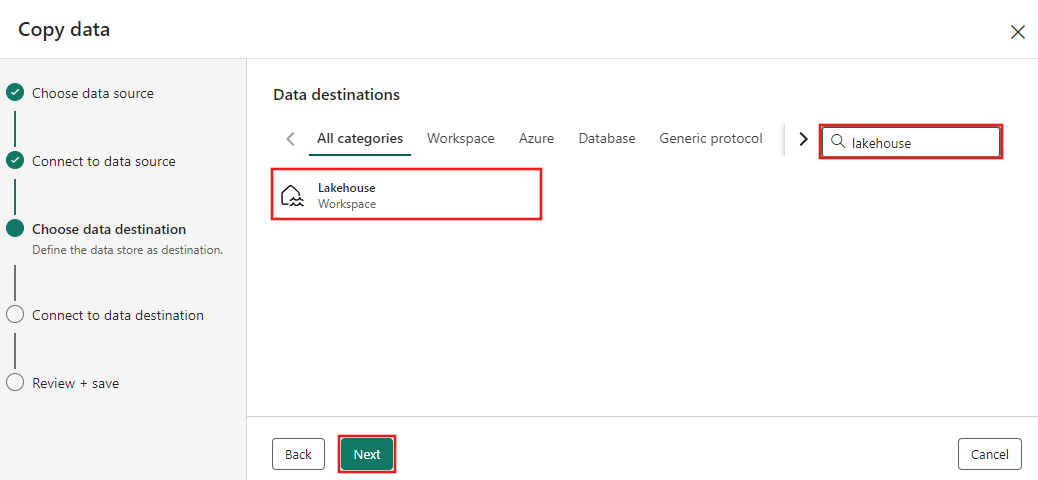

Per il passaggio Scegli destinazione dati dell'Assistente copia selezionare Lakehouse e quindi Avanti.

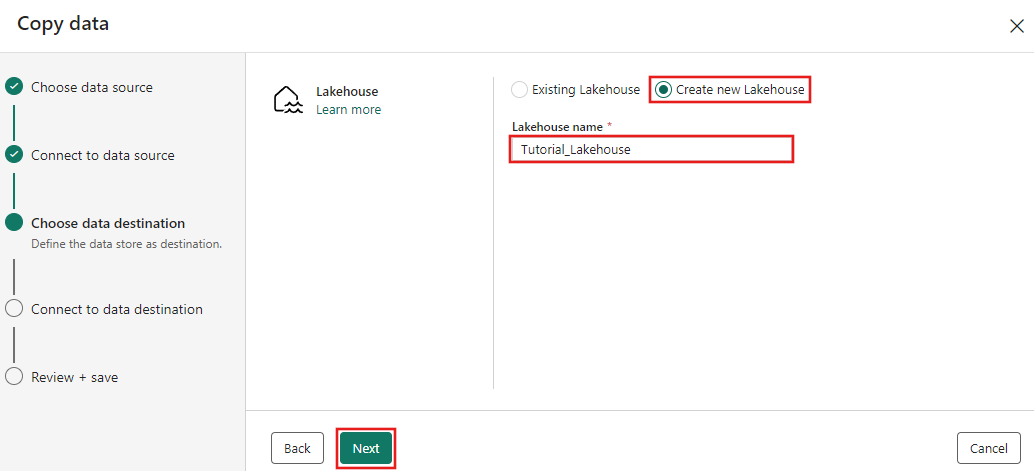

Selezionare Crea nuovo Lakehouse nella pagina di configurazione della destinazione dati visualizzata e immettere un nome per il nuovo Lakehouse. Selezionare quindi di nuovo Avanti .

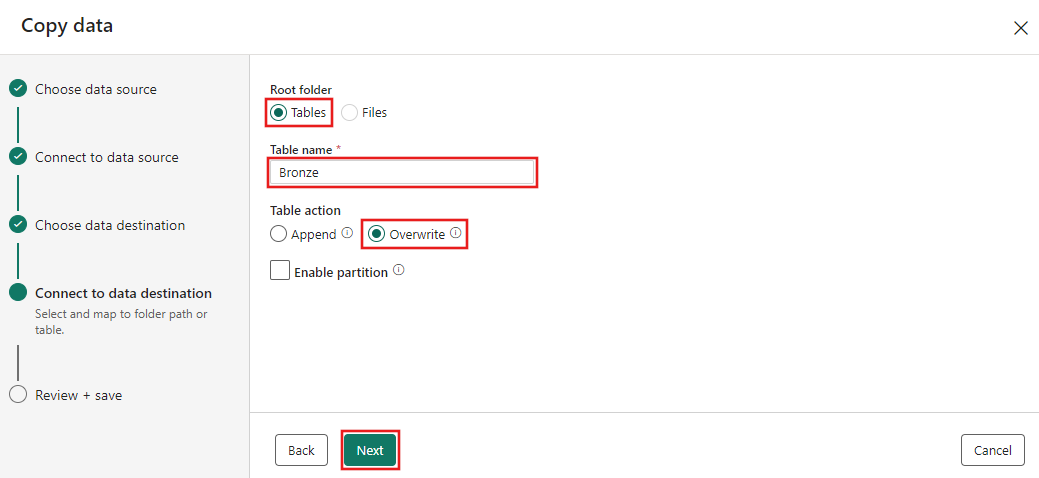

Configurare ora i dettagli della destinazione Lakehouse nella pagina Seleziona ed esegui il mapping al percorso o alla tabella della cartella. Selezionare Tabelle per la cartella Radice, specificare un nome di tabella e scegliere l'azione Sovrascrivi . Non selezionare la casella di controllo Abilita partizione visualizzata dopo aver selezionato l'azione Sovrascrivi tabella.

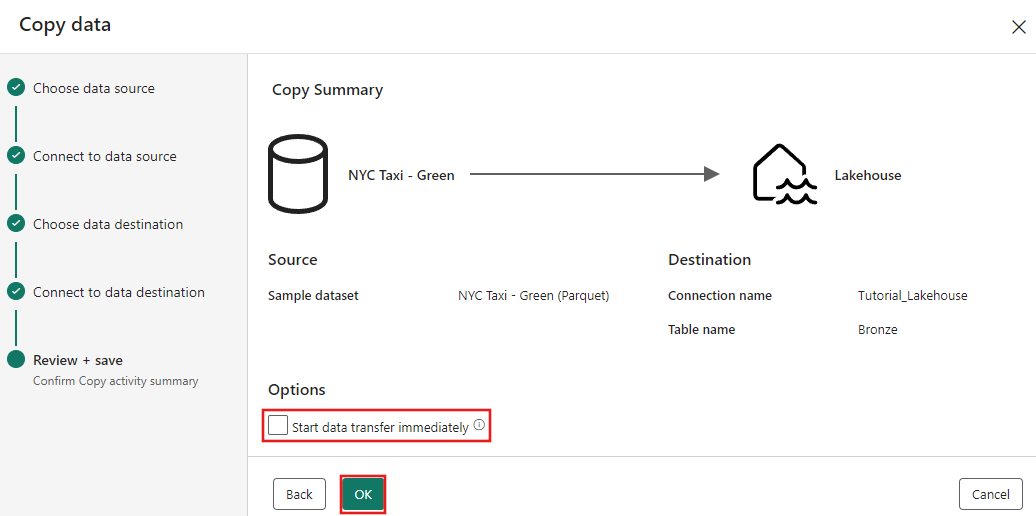

Infine, nella pagina Rivedi e salva dell'Assistente copia dati esaminare la configurazione. Per questa esercitazione deselezionare la casella di controllo Avvia trasferimento dati immediatamente , perché l'attività viene eseguita manualmente nel passaggio successivo. Selezionare OK.

Passaggio 3: Eseguire e visualizzare i risultati del attività Copy.

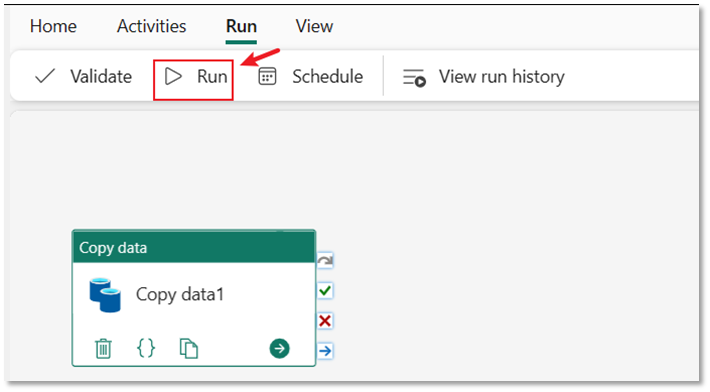

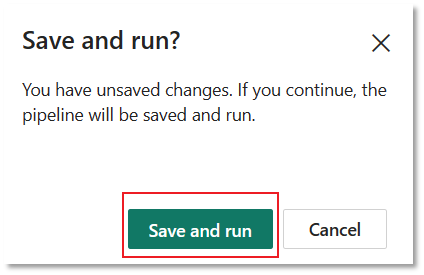

Selezionare la scheda Esegui nell'editor della pipeline. Selezionare quindi il pulsante Esegui, quindi Salvare ed eseguire al prompt per eseguire il attività Copy.

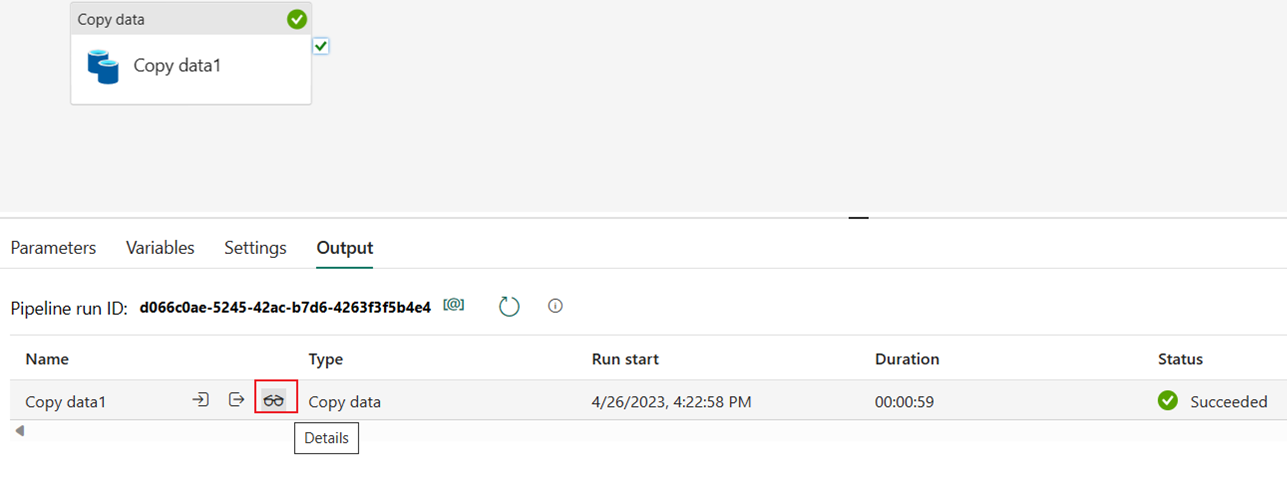

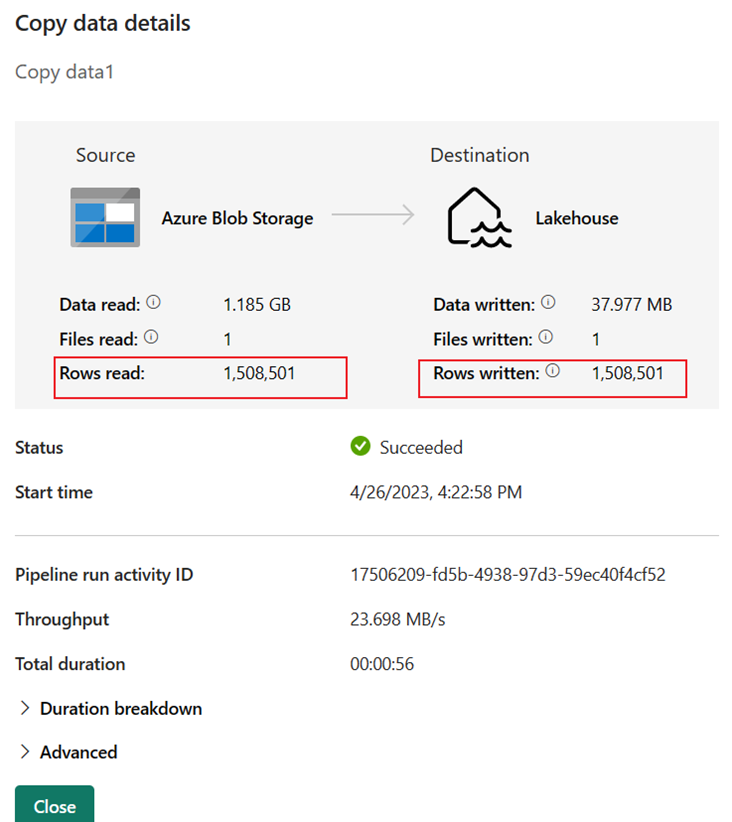

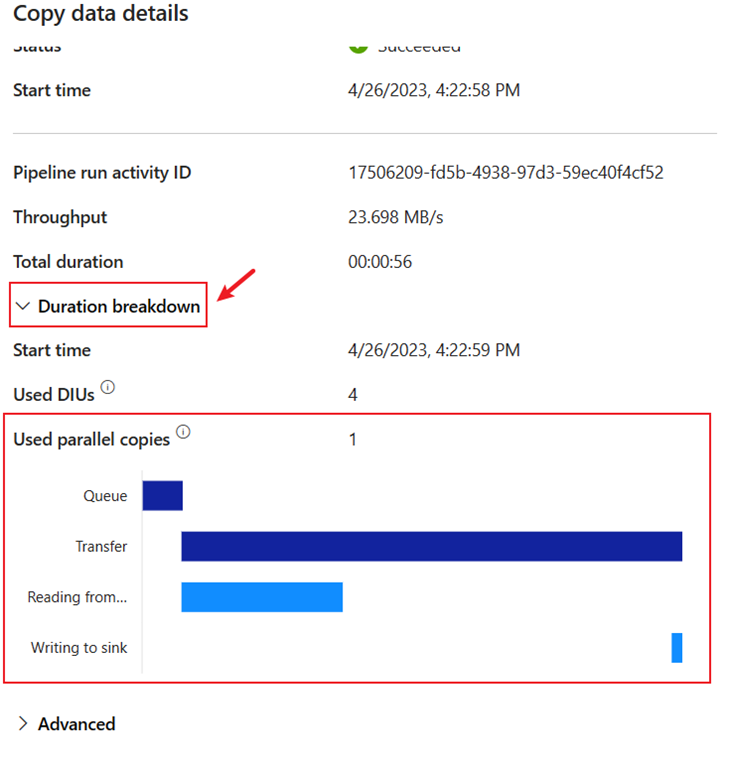

È possibile monitorare l'esecuzione e controllare i risultati nella scheda Output sotto l'area di disegno della pipeline. Selezionare il pulsante Dettagli esecuzione (icona "occhiali" visualizzata quando si passa il puntatore del mouse sull'esecuzione della pipeline) per visualizzare i dettagli dell'esecuzione.

I dettagli dell'esecuzione mostrano 1.508.501 righe lette e scritte.

Espandere la sezione Suddivisione durata per visualizzare la durata di ogni fase del attività Copy. Dopo aver esaminato i dettagli della copia, selezionare Chiudi.

Contenuto correlato

In questo primo modulo dell'esercitazione end-to-end per la prima integrazione dei dati con Data Factory in Microsoft Fabric si è appreso come:

- Creare una pipeline di dati.

- Aggiungere un attività Copy alla pipeline.

- Usare dati di esempio e creare un data Lakehouse per archiviare i dati in una nuova tabella.

- Eseguire la pipeline e visualizzarne i dettagli e la suddivisione della durata.

Continuare con la sezione successiva per creare il flusso di dati.

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per