Aggiungere una destinazione lakehouse a un eventstream

Questo articolo illustra come aggiungere una lakehouse come destinazione a un eventstream negli eventstream di Microsoft Fabric. Per prestazioni di streaming ottimizzate e query in tempo reale, prendere in considerazione la possibilità di trasmettere i dati a un eventhouse con l'aggiunta della destinazione Eventhouse a un eventstream e quindi abilitare la disponibilità di eventhouse OneLake.

Nota

Per usare funzionalità avanzate in anteprima, selezionare Funzionalità avanzate nella parte superiore. In caso contrario, selezionare Funzionalità standard. Per informazioni sulle funzionalità avanzate disponibili in anteprima, vedere Introduzione ai flussi di eventi di Fabric.

Importante

La scrittura dei dati in una tabella di destinazione di lakehouse è soggetta all'applicazione dello schema. Tutte le nuove scritture nella tabella devono essere compatibili con lo schema della tabella di destinazione in fase di scrittura, garantendo la qualità dei dati.

Quando l'output viene scritto in una nuova tabella delta, lo schema della tabella viene creato in base al primo record. Tutti i record dei dati di output vengono proiettati nello schema della tabella esistente.

Se i dati in ingresso contengono colonne che non si trovano nello schema di tabella esistente, le colonne aggiuntive non vengono incluse nei dati scritti nella tabella. Analogamente, se i dati in ingresso sono privi di colonne presenti nello schema di tabella esistente, le colonne mancanti vengono scritte nella tabella con i valori impostati su null.

Prerequisiti

- Accesso all'area di lavoro Premium di Fabric in cui si trova l'eventstream con autorizzazioni di collaboratore o superiori.

- Accedere all'area di lavoro Premium in cui si trova il lakehouse con autorizzazioni di collaboratore o superiori.

Nota

Il numero massimo di origini e destinazioni per un eventstream è 11.

Aggiungere una lakehouse come destinazione

Per aggiungere una destinazione lakehouse a un eventstream predefinito o derivato, seguire questa procedura.

In Modalità di modifica per l'eventstream selezionare Aggiungi destinazione sul nastro e selezionare Lakehouse dall'elenco a discesa.

Connettere il nodo lakehouse al nodo o all'operatore di flusso.

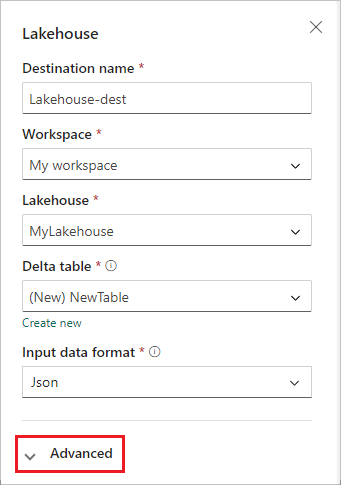

Nella schermata di configurazione lakehouse completare le informazioni seguenti:

- Immettere un nome di destinazione.

- Selezionare l'area di lavoro che contiene il lakehouse.

- Selezionare un lakehouse esistente nell'area di lavoro specificata.

- Selezionare una tabella Delta esistente o crearne una nuova per ricevere i dati.

- Selezionare il formato dei dati di input inviato al lakehouse. I formati di dati supportati sono JSON, Avro e CSV (con intestazione).

Seleziona Avanzate.

Sono disponibili due modalità di inserimento per una destinazione lakehouse. In base allo scenario, configurare queste modalità per ottimizzare il modo in cui i flussi di eventi di Fabric scrivono nel lakehouse.

Il numero minimo di righe è il numero minimo di righe che il lakehouse inserisce in un singolo file. Il valore minimo è 1 riga e il massimo è 2 milioni di righe per file. Minore è il numero minimo di righe, maggiore è il numero di file creati dal lakehouse durante l'inserimento.

La durata massima è la durata massima richiesta dal lakehouse per inserire un singolo file. Il limite minimo è 1 minuto e il massimo è 2 ore. Più lunga è la durata, più righe vengono inserite in un file.

Selezionare Salva.

Per implementare la destinazione lakehouse appena aggiunta, selezionare Pubblica.

Dopo aver completato questi passaggi, la destinazione lakehouse è disponibile per la visualizzazione in Visualizzazione in diretta. Nel riquadro Dettagli è possibile selezionare il collegamento Ottimizza tabella nel notebook per avviare un processo Apache Spark all'interno di un notebook, che consolida i piccoli file di streaming all'interno della tabella lakehouse di destinazione.

Contenuto correlato

Per informazioni su come aggiungere altre destinazioni a un eventstream, vedere gli articoli seguenti:

Prerequisiti

Prima di iniziare devi completare i seguenti prerequisiti:

- Ottenere l'accesso a un'area di lavoro Premium con autorizzazioni di Collaboratore o superiori in cui si trova l'eventstream.

- Ottenere l'accesso a un'area di lavoro Premium con autorizzazioni di collaboratore o superiori in cui si trova il lakehouse.

Nota

Il numero massimo di origini e destinazioni per un eventstream è 11.

Aggiungere una lakehouse come destinazione

Se nell'area di lavoro è stato creato un lakehouse, seguire questa procedura per aggiungerlo all'eventstream come destinazione:

Selezionare Nuova destinazione sul nastro o "+" nell'area di lavoro dell'editor principale e quindi selezionare Lakehouse. Viene visualizzata la schermata di configurazione della destinazione Lakehouse.

Immettere un nome per la destinazione eventstream e completare le informazioni relative al lakehouse.

Lakehouse: selezionare un lakehouse esistente dall'area di lavoro specificata.

Tabella Delta: selezionare una tabella delta esistente o crearne una nuova per ricevere i dati.

Nota

Quando si scrivono dati nella tabella lakehouse, è prevista l'applicazione dello schema. Ciò significa che tutte le nuove scritture in una tabella devono essere compatibili con lo schema della tabella di destinazione in fase di scrittura, garantendo la qualità dei dati.

Tutti i record dei dati di output vengono proiettati nello schema della tabella esistente. Quando si scrive l'output in una nuova tabella delta, lo schema della tabella viene creato in base al primo record. Se i dati in ingresso hanno una colonna aggiuntiva rispetto allo schema di tabella esistente, essi vengono scritti nella tabella senza includere la colonna aggiuntiva. Viceversa, se i dati in ingresso non contengono una colonna rispetto allo schema di tabella esistente, vengono scritti nella tabella con il valore della colonna impostato su null.

Formato dati di input: selezionare il formato per i dati (dati di input) inviati al lakehouse.

Nota

I formati di dati degli eventi di input supportati sono JSON, Avro e CSV (con intestazione).

Elaborazione eventi: è possibile usare l'editor di elaborazione eventi per specificare come devono essere elaborati i dati prima di inviarli al lakehouse. Selezionare Apri processore di eventi per aprire l'editor di elaborazione eventi. Per altre informazioni sull'elaborazione in tempo reale tramite il processore di eventi, vedere Elaborare i dati degli eventi con l'editor del processore di eventi. Al termine dell'editor, selezionare Fine per tornare alla schermata di configurazione della destinazione Lakehouse.

Sono disponibili due modalità di inserimento per una destinazione lakehouse. Selezionare una di queste modalità per ottimizzare il modo in cui la funzionalità flussi di eventi di Fabric scrive nel lakehouse in base allo scenario in uso.

Righe per file: numero minimo di righe che Lakehouse inserisce in un singolo file. Minore è il numero minimo di righe, più file Lakehouse crea durante l'inserimento. Il valore minimo è 1 riga. Il valore massimo è di 2 milioni di righe per file.

Durata: durata massima richiesta da Lakehouse per inserire un singolo file. Più lunga è la durata, più righe vengono inserite in un file. Il limite minimo è 1 minuto e il massimo è 2 ore.

Selezionare Aggiungi per aggiungere la destinazione lakehouse.

Collegamento di ottimizzazione tabella disponibile all'interno della destinazione lakehouse. Questa soluzione semplifica l'avvio di un processo Spark all'interno di un notebook, che consolida questi piccoli file di streaming all'interno della tabella Lakehouse di destinazione.

Una destinazione lakehouse viene visualizzata nell'area di lavoro, con un indicatore di stato rotante. Il sistema richiede alcuni minuti per modificare lo stato in Attivo.

Gestire una destinazione

Modifica/rimuovi: è possibile modificare o rimuovere una destinazione eventstream tramite il riquadro di spostamento o l'area di lavoro.

Quando si seleziona Modifica, il riquadro di modifica viene aperto sul lato destro dell'editor principale. È possibile modificare la configurazione nel modo desiderato, inclusa la logica di trasformazione degli eventi tramite l'editor del processore di eventi.

Contenuto correlato

Per informazioni su come aggiungere altre destinazioni a un eventstream, vedere gli articoli seguenti: