Uso di Azure Data Lake Storage Gen1 per i requisiti di Big Data

Nota

Azure Data Lake Storage Gen1 è ora ritirato. Vedere l'annuncio di ritiro qui. Le risorse di Data Lake Storage Gen1 non sono più accessibili.

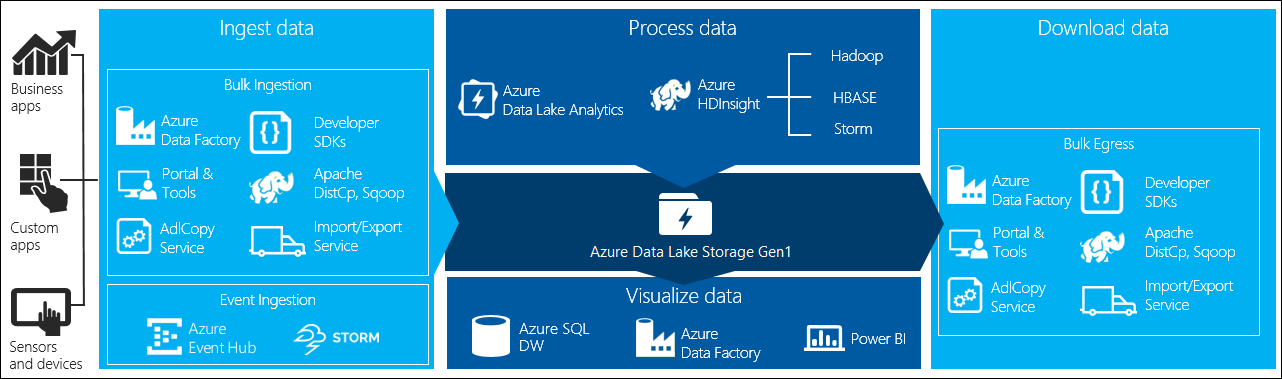

L'elaborazione di Big Data prevede quattro fasi principali:

- Inserimento di grandi quantità di dati in un archivio dati, in tempo reale o in batch

- Elaborazione dei dati

- Download dei dati

- Visualizzazione dei dati

In questo articolo vengono descritte queste fasi in relazione ad Azure Data Lake Storage Gen1, per illustrare le opzioni e gli strumenti disponibili per soddisfare le esigenze di Big Data.

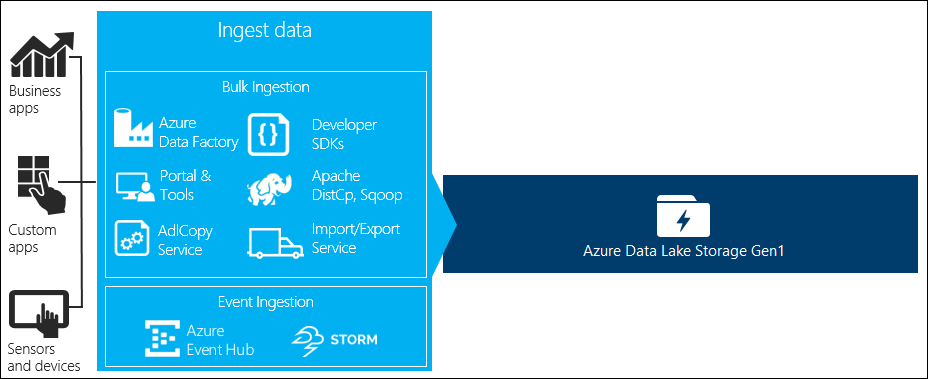

Inserire i dati in Data Lake Storage Gen1

Questa sezione descrive le diverse origini dei dati e i diversi modi in cui i dati possono essere inseriti in un account Data Lake Storage Gen1.

Dati ad hoc

Si tratta di set di dati di piccole dimensioni usati per la creazione del prototipo di un'applicazione Big Data. L'inserimento di dati ad hoc può essere eseguito in modi diversi, a seconda dell'origine dei dati.

| Origine dati | Inserire usando |

|---|---|

| Computer locale | |

| BLOB del servizio di archiviazione di Azure |

Dati inviati in streaming

Rappresenta i dati che possono essere generati da varie origini, ad esempio applicazioni, dispositivi, sensori e così via. Questi dati possono essere inseriti in Data Lake Storage Gen1 da un'ampia gamma di strumenti. Questi strumenti in genere acquisiscono ed elaborano i dati dei singoli eventi in tempo reale e quindi scrivono gli eventi in batch in Data Lake Storage Gen1 affinché possano essere elaborati ulteriormente.

Di seguito sono elencati gli strumenti che è possibile usare:

- Analisi di flusso di Azure: gli eventi inseriti in Hub eventi possono essere scritti in Azure Data Lake Storage Gen1 usando un output di Azure Data Lake Storage Gen1.

- EventProcessorHost: è possibile ricevere eventi da Hub eventi e scriverli in Data Lake Storage Gen1 usando .NET SDK di Data Lake Storage Gen1.

Dati relazionali

È inoltre possibile recuperare i dati dai database relazionali. I database relazionali raccolgono nel tempo elevate quantità di dati che possono fornire informazioni significative se elaborate tramite una pipeline Big Data. Per spostare tali dati in Data Lake Storage Gen1, è possibile usare gli strumenti seguenti.

Dati di log del server Web (caricamento tramite applicazioni personalizzate)

Questo tipo di set di dati è indicato in modo specifico perché l'analisi dei dati di log dei server Web è un caso d'uso comune per le applicazioni di Big Data e richiede il caricamento di grandi volumi di file di log in Data Lake Storage Gen1. Per scrivere script o applicazioni per il caricamento dei dati è possibile usare uno degli strumenti seguenti.

- Interfaccia della riga di comando di Azure

- Azure PowerShell

- .NET SDK di Azure Data Lake Storage Gen1

- Azure Data Factory

Per il caricamento di dati di log del server Web e per il caricamento di altri tipi di dati, ad esempio i dati delle valutazioni dei social network, è consigliabile scrivere script o applicazioni personalizzate che offrono la flessibilità di includere il componente di caricamento dei dati come parte dell'applicazione Big Data più grande. In alcuni casi, questo codice può essere rappresentato da uno script o un'utilità della riga di comando. In altri casi, il codice può essere usato per integrare l'elaborazione di Big Data in un'applicazione o una soluzione aziendale.

Dati associati ai cluster Azure HDInsight

La maggior parte dei tipi di cluster HDInsight (Hadoop, HBase, Storm) supporta Data Lake Storage Gen1 come repository di archiviazione dei dati. I cluster HDInsight accedono ai dati dai BLOB di archiviazione di Azure (WASB). Per prestazioni ottimali, è possibile copiare i dati da WASB a un account Data Lake Storage Gen1 associato al cluster. Per copiare i dati è possibile usare gli strumenti seguenti.

Dati archiviati in locale o in cluster IaaS Hadoop

Grandi quantità di dati possono essere archiviati in cluster Hadoop esistenti, localmente, nei computer che usano HDFS. I cluster Hadoop potrebbero essere in una distribuzione locale o all'interno di un cluster IaaS in Azure. Potrebbe essere necessario copiare tali dati in Azure Data Lake Storage Gen1 una sola volta o regolarmente. Sono disponibili diverse opzioni che è possibile usare per ottenere questo. Di seguito è riportato un elenco di alternative con i relativi compromessi.

| Approccio | Dettagli | Vantaggi | Considerazioni |

|---|---|---|---|

| Usare Azure Data Factory (ADF) per copiare i dati direttamente dai cluster Hadoop in Azure Data Lake Storage Gen1 | ADF supporta HDFS come origine dati | ADF fornisce il supporto nativo per HDFS e il monitoraggio e gestione end-to-end di prima classe | Richiede che il gateway di gestione dati sia distribuito localmente nel cluster IaaS |

| Esportare dati da Hadoop come file. Copiare quindi i file in Azure Data Lake Storage Gen1 usando un meccanismo appropriato. | È possibile copiare file in Azure Data Lake Storage Gen1 usando:

|

Guida introduttiva per iniziare. È possibile eseguire caricamenti personalizzati | Processo in più passaggi che prevede più tecnologie. La gestione e il monitoraggio miglioreranno fino a rappresentare una sfida nel corso del tempo data la natura personalizzata degli strumenti |

| Usare Distcp per copiare dati da Hadoop ad Archiviazione di Azure. Copiare quindi i dati da Archiviazione di Azure a Data Lake Storage Gen1 usando un meccanismo appropriato. | È possibile copiare dati da Archiviazione di Azure a Data Lake Storage Gen1 usando: | È possibile usare strumenti open source. | Processo in più passaggi che prevede più tecnologie |

Set di dati di grandi dimensioni

L'uso dei metodi descritti in precedenza per il caricamento di set di dati di più terabyte può talvolta risultare lento e costoso. In questi casi, è possibile usare le opzioni seguenti.

Uso di Azure ExpressRoute. Azure ExpressRoute consente di creare connessioni private tra i data center di Azure e l'infrastruttura locale. Ciò offre un'opzione affidabile per il trasferimento di grandi quantità di dati. Per altre informazioni, vedere la Documentazione su ExpressRoute.

Caricamento "offline" dei dati. Se l'uso di Azure ExpressRoute non è possibile per qualsiasi motivo, si può usare il servizio Importazione/Esportazione di Azure per inviare le unità disco rigido coi dati a un data center di Azure. I dati vengono caricati prima di tutto in BLOB di archiviazione di Azure. È quindi possibile usare Azure Data Factory o lo strumento AdlCopy per copiare i dati dai BLOB di archiviazione di Azure a Data Lake Storage Gen1.

Nota

Durante l'uso del servizio di Importazione/Esportazione, le dimensioni dei file nei dischi inviati al data center di Azure non devono superare i 195 GB.

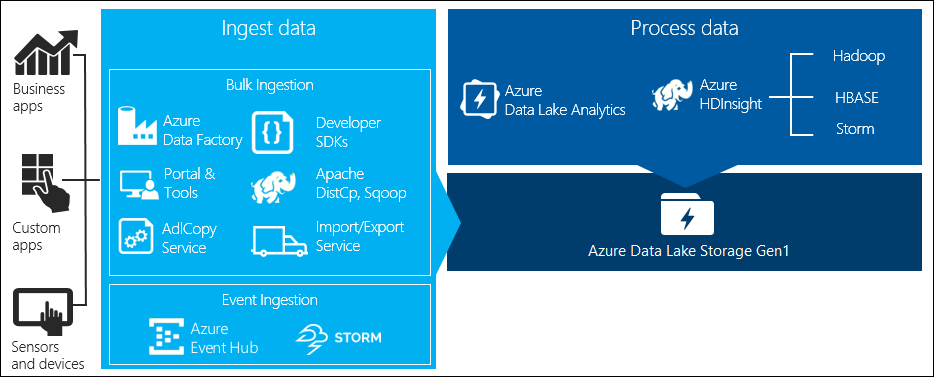

Elaborare i dati archiviati in Data Lake Storage Gen1

Quando i dati sono disponibili in Data Lake Storage Gen1, è possibile eseguire l'analisi sui dati tramite le applicazioni di Big Data supportate. Attualmente, è possibile usare Azure HDInsight e Azure Data Lake Analytics per eseguire processi di analisi dei dati sui dati archiviati in Data Lake Storage Gen1.

Esaminare gli esempi seguenti.

- Creare un cluster HDInsight con Data Lake Storage Gen1 come risorsa di archiviazione

- Usare Azure Data Lake Analytics con Data Lake Storage Gen1

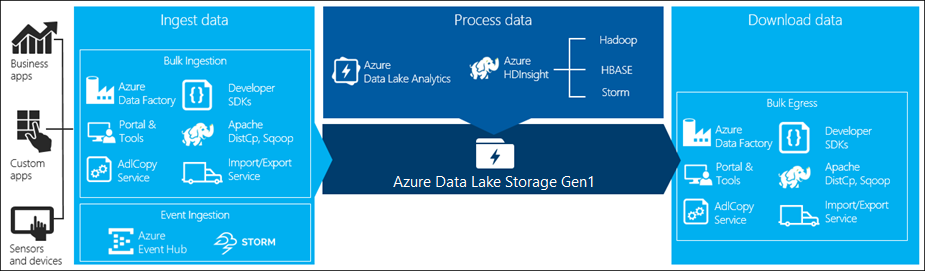

Scaricare i dati da Data Lake Storage Gen1

È anche possibile che si voglia scaricare o spostare i dati da Azure Data Lake Storage Gen1 per scenari simili ai seguenti:

- Spostare i dati in altri repository per l'interfaccia con le pipeline di elaborazione dati esistenti. Ad esempio, è possibile spostare i dati da Data Lake Storage Gen1 a database SQL di Azure o SQL Server.

- Scaricare i dati nel computer locale per l'elaborazione in ambienti IDE durante la creazione di prototipi di applicazioni.

In questi casi, è possibile usare le opzioni seguenti:

È anche possibile usare i metodi seguenti per scrivere un'applicazione o uno script personalizzato per scaricare i dati da Data Lake Storage Gen1.

- Interfaccia della riga di comando di Azure

- Azure PowerShell

- .NET SDK di Azure Data Lake Storage Gen1

Visualizzare i dati in Data Lake Storage Gen1

È possibile usare una combinazione di servizi per creare rappresentazioni visive dei dati archiviati in Data Lake Storage Gen1.

- È possibile iniziare usando Azure Data Factory per spostare i dati da Data Lake Storage Gen1 ad Azure Synapse Analytics

- Successivamente, è possibile integrare Power BI con Azure Synapse Analytics per creare una rappresentazione visiva dei dati.