Generazione di immagini

Annotazioni

Per altri dettagli, vedi la scheda Testo e immagini .

La stessa architettura del modello multilingue che consente all'intelligenza artificiale di creare risposte in linguaggio naturale all'input visivo, può essere usata anche per consentire la creazione di immagini in risposta alle richieste del linguaggio naturale. Identificando le funzionalità visive associate al linguaggio, un modello di sintesi delle immagini può assumere una descrizione di un'immagine o di un video desiderato e generarlo.

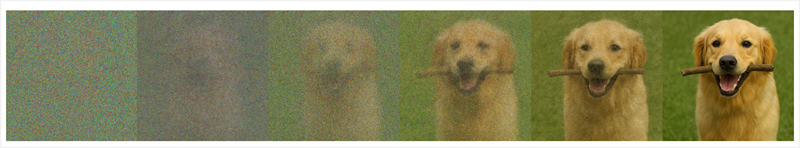

La maggior parte dei modelli moderni di generazione di immagini usa una tecnica denominata diffusione, in cui viene usata una richiesta per identificare un set di funzionalità visive correlate che possono essere combinate per creare un'immagine. L'immagine viene quindi creata in modo iterativo, a partire da un set casuale di valori pixel e rimuovendo "rumore" per creare la struttura. Dopo ogni iterazione, il modello valuta l'immagine finora per confrontarla con la richiesta, fino a quando non viene prodotta un'immagine finale che rappresenta la scena desiderata.

Ad esempio, il prompt "Un cane che porta un bastone in bocca" potrebbe comportare un processo di diffusione con le iterazioni seguenti:

Alcuni modelli possono applicare un processo simile alla generazione di video. Il processo di generazione di video usa la stessa tecnica per identificare le caratteristiche visive associate ai token del linguaggio, ma prende in considerazione anche fattori come il comportamento fisico degli oggetti nel mondo reale (come garantire che un cane cammina con i piedi a terra) e la progressione temporale (in modo che il video ritrae una sequenza logica di attività).