Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Queste funzionalità hanno componenti software e hardware. Il software è strettamente legato alle funzionalità hardware necessarie per il funzionamento della funzionalità. Tra questi esempi, sono inclusi VMMQ, VMQ, Offload checksum sul lato di trasmissione IPv4 e RSS. Per altre informazioni, vedere Requisiti di rete host per l'locale di Azure.

Suggerimento

Le funzionalità SH e HO sono disponibili se la scheda di interfaccia di rete installata la supporta. Le descrizioni delle funzionalità seguenti illustrano come stabilire se la NIC supporta la funzionalità.

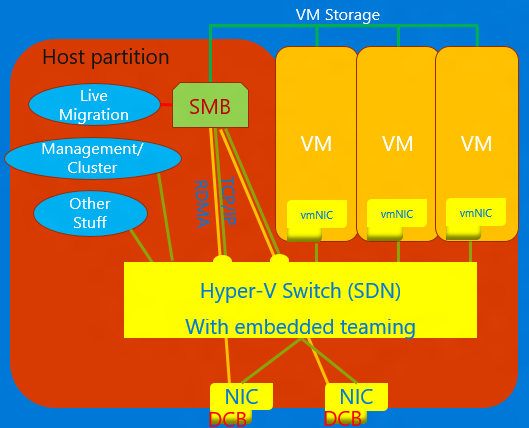

NIC convergente

La NIC convergente è una tecnologia che consente alle NIC virtuali nell'host Hyper-V di esporre i servizi RDMA ai processi host. Windows Server 2016 non richiede più NIC separate per RDMA. La funzionalità NIC convergente consente alle NIC virtuali nella partizione host (vNIC) di esporre RDMA alla partizione host e condividere la larghezza di banda delle NIC tra il traffico RDMA e la macchina virtuale e altro traffico TCP/UDP in modo equo e gestibile.

È possibile gestire l'operazione della NIC convergente tramite VMM o Windows PowerShell. I cmdlet di PowerShell sono gli stessi cmdlet usati per RDMA (vedere di seguito).

Per usare la funzionalità della NIC convergente:

Assicurarsi di impostare l'host per DCB.

Assicurarsi di abilitare RDMA nella NIC o nel caso di un team edizione Standard T, le NIC sono associate al commutatore Hyper-V.

Assicurarsi di abilitare RDMA nelle vNIC designate per RDMA nell'host.

Per maggiori informazioni su RDMA e SET, vedere RDMA (Remote Direct Memory Access) e SET (Switch Embedded Teaming).

Bridging del data center (DCB)

DCB è una suite di standard dell'Institute of Electrical and Electronics Engineers (IEEE) che abilita le infrastrutture convergenti nei data center. DCB fornisce la gestione della larghezza di banda basata su coda hardware in un host con la collaborazione dal commutatore adiacente. Tutto il traffico per l'archiviazione, la rete dei dati, il cluster Inter-Process Communication (IPC) e la gestione condividono la stessa infrastruttura di rete Ethernet. In Windows Server 2016, DCB può essere applicato a qualsiasi NIC individualmente e a NIC associate al commutatore Hyper-V.

Per DCB, Windows Server usa il controllo del flusso basato su priorità (PFC), standardizzato in IEEE 802.1Qbb. PFC crea un'infrastruttura di rete senza perdita (quasi) impedendo l'overflow all'interno delle classi di traffico. Windows Server usa anche Enhanced Transmission Selection (ETS), standardizzato in IEEE 802.1Qaz. ETS consente la divisione della larghezza di banda in parti riservate per un massimo di otto classi di traffico. Ogni classe di traffico ha una propria coda di trasmissione e, tramite l'uso di PFC, può avviare e arrestare la trasmissione all'interno di una classe.

Virtualizzazione rete Hyper-V

| Versione | Descrizione |

|---|---|

| v1 (HNVv1) | Introdotto in Windows Server 2012, Hyper-V rete Virtualizzazione consente la virtualizzazione di reti dei clienti su un'infrastruttura di rete fisica condivisa. Apportando modifiche minime necessari per l'infrastruttura di rete fisica, virtualizzazione RETE fornisce ai provider di servizi la flessibilità di distribuire e migrare i carichi di lavoro tenant ovunque in tre aree: il cloud di provider del servizio, il cloud privato o la cloud pubblica di Microsoft Azure. |

| v2 NVGRE (HNVv2 NVGRE) | In Windows Server 2016 e System Center Virtual Machine Manager, Microsoft offre una soluzione di virtualizzazione di rete end-to-end che include gateway RAS, bilanciamento del carico software, controller di rete e altro ancora. Per maggiori informazioni, consultare la sezione Panoramica virtualizzazione rete Hyper-V in Windows Server 2016. |

| v2 VxLAN (HNVv2 VxLAN) | In Windows Server 2016, fa parte dell'estensione SDN, gestita tramite il controller di rete. |

Offload attività IPsec (IPsecTO)

L'offload delle attività IPsec è una funzionalità della NIC che consente al sistema operativo di usare il processore nella NIC per il lavoro di crittografia IPsec.

Importante

L'offload dell'attività IPsec è una tecnologia legacy che non è supportata dalla maggior parte delle schede di rete e, dove esiste, è disabilitata per impostazione predefinita.

Rete locale virtuale privata (PVLAN).

Le PVLAN consentono la comunicazione solo tra macchine virtuali sullo stesso server di virtualizzazione. Una rete virtuale privata non è associata a una scheda di rete fisica. Una rete virtuale privata è isolata da tutto il traffico di rete esterno nel server di virtualizzazione, nonché da qualsiasi traffico di rete tra il sistema operativo di gestione e la rete esterna. Questo tipo di rete è utile quando è necessario creare un ambiente di rete isolato, ad esempio un dominio di test isolato. Gli stack Hyper-V e SDN supportano solo la modalità porta isolata PVLAN.

Per informazioni dettagliate sull'isolamento PVLAN, consultare la sezione System Center: blog di progettazione gestore VM.

RDMA (Remote Direct Memory Access)

RDMA è una tecnologia di rete che offre una comunicazione a bassa latenza e velocità effettiva elevata che riduce al minimo l'utilizzo della CPU. RDMA supporta la rete zero-copy, consentendo all'adattatore di rete di trasferire i dati direttamente da o verso una memoria dell'applicazione. Supporto per RDMA indica che la scheda di interfaccia di rete (fisica o virtuale) è in grado di esporre RDMA a un client RDMA. RdMA abilitato, invece, significa che una scheda di interfaccia di rete con supporto per RDMA espone l'interfaccia RDMA nello stack.

Per maggiori informazioni su RDMA e RDMA, consultare la sezione Remote Direct Memory Access (RDMA) e Switch Embedded Teaming (SET).

RSS (Receive-Side Scaling)

RSS è una funzionalità della NIC che separa diversi set di flussi e li distribuisce a processori diversi per l'elaborazione. RSS parallelizza l'elaborazione della rete, consentendo a un host di ridimensionarsi a frequenze di dati molto elevate.

Per maggiori dettagli, consultare la sezione Receive Side Scaling (RSS).

Virtualizzazione di input/output radice singola (SR-IOV)

SR-IOV consente al traffico della VM di passare direttamente dalla NIC alla VM senza passare attraverso l'host Hyper-V. SR-IOV è un miglioramento incredibile delle prestazioni per una VM, ma manca la possibilità per l'host di gestire tale pipe. Usare SR-IOV solo quando il carico di lavoro è ben comportamento, attendibile e in genere l'unica VM nell'host.

Il traffico che usa SR-IOV ignora il commutatore Hyper-V, il che significa che non verranno applicati criteri, ad esempio ACL o gestione della larghezza di banda. Anche il traffico SR-IOV non può essere passato attraverso alcuna funzionalità di virtualizzazione di rete, quindi non è possibile applicare l'incapsulamento NV-GRE o VxLAN. Usare SR-IOV solo per carichi di lavoro ben attendibili in situazioni specifiche. Inoltre, non è possibile usare i criteri host, la gestione della larghezza di banda e le tecnologie di virtualizzazione.

In futuro, due tecnologie consentono SR-IOV: tabelle di flusso generiche (GFT) e Offload QoS hardware (gestione della larghezza di banda nella NIC) una volta supportate dalle NIC nell'ecosistema. La combinazione di queste due tecnologie renderebbe SR-IOV utile per tutte le VM, consentirebbe l'applicazione di criteri, virtualizzazione e regole di gestione della larghezza di banda e potrebbe comportare grandi salti avanti nell'applicazione generale di SR-IOV.

Per maggiori informazioni, consultare la sezione Panoramica di Single Root I/O Virtualization (SR-IOV).

TCP scarico camino

TCP Chimney Offload, noto anche come TCP Engine Offload (TOE), è una tecnologia che consente all'host di eseguire l'offload di tutta l'elaborazione TCP nella NIC. Poiché lo stack TCP di Windows Server è quasi sempre più efficiente del motore TOE, non è consigliabile usare TCP Chimney Offload.

Importante

TCP Chimney Offload è una tecnologia deprecata. È consigliabile non usare TCP Chimney Offload perché Microsoft potrebbe smettere di supportarlo in futuro.

Rete locale virtuale (VLAN)

VLAN è un'estensione dell'intestazione di frame Ethernet per abilitare il partizionamento di una LAN in più VLAN, ognuna con il proprio spazio indirizzi. In Windows Server 2016, le VLAN vengono impostate sulle porte del commutatore Hyper-V o impostando le interfacce del team nei team di gruppo NIC.

Coda macchine virtuali (VMQ)

VmQs è una funzionalità della NIC che alloca una coda per ogni VM. Ogni volta che è abilitato Hyper-V; è anche necessario abilitare VMQ. In Windows Server 2016, le VMQ usano vPort del commutatore NIC con una singola coda assegnata al vPort per fornire la stessa funzionalità.

VMMQ (Virtual Machine Multi-Queue)

VMMQ è una funzionalità della NIC che consente al traffico di una macchina virtuale di distribuirsi tra più code, ognuna elaborata da un processore fisico diverso. Il traffico viene quindi passato a più LP nella VM, come sarebbe in vRSS, che consente di distribuire una larghezza di banda di rete sostanziale alla VM.