Input vocale in Unreal

L'input vocale in Unreal consente di interagire con un ologramma senza dover usare i movimenti della mano ed è supportato solo HoloLens 2. L'input vocale su HoloLens 2 è alimentato dallo stesso motore che supporta la voce in tutte le altre app di Windows universali, ma Unreal usa un motore più limitato per elaborare l'input vocale. Questo limita le funzionalità di input vocale in Unreal ai mapping vocali predefiniti, illustrati nelle sezioni seguenti.

Abilitazione del riconoscimento vocale

Se si usa Windows Mixed Reality Plug-in, l'input vocale non richiede api speciali Windows Mixed Reality, ma si basa sull'API di mapping di input di Unreal Engine 4 esistente. Se si usa OpenXR, è necessario installare anche il plug-in Microsoft OpenXR.

Per abilitare il riconoscimento vocale in HoloLens:

- Selezionare Project Settings > Platform HoloLens Capabilities (Piattaforma impostazioni progetto) > HoloLens Capabilities (Funzionalità holoLens>) e abilitare Microphone (Microfono).

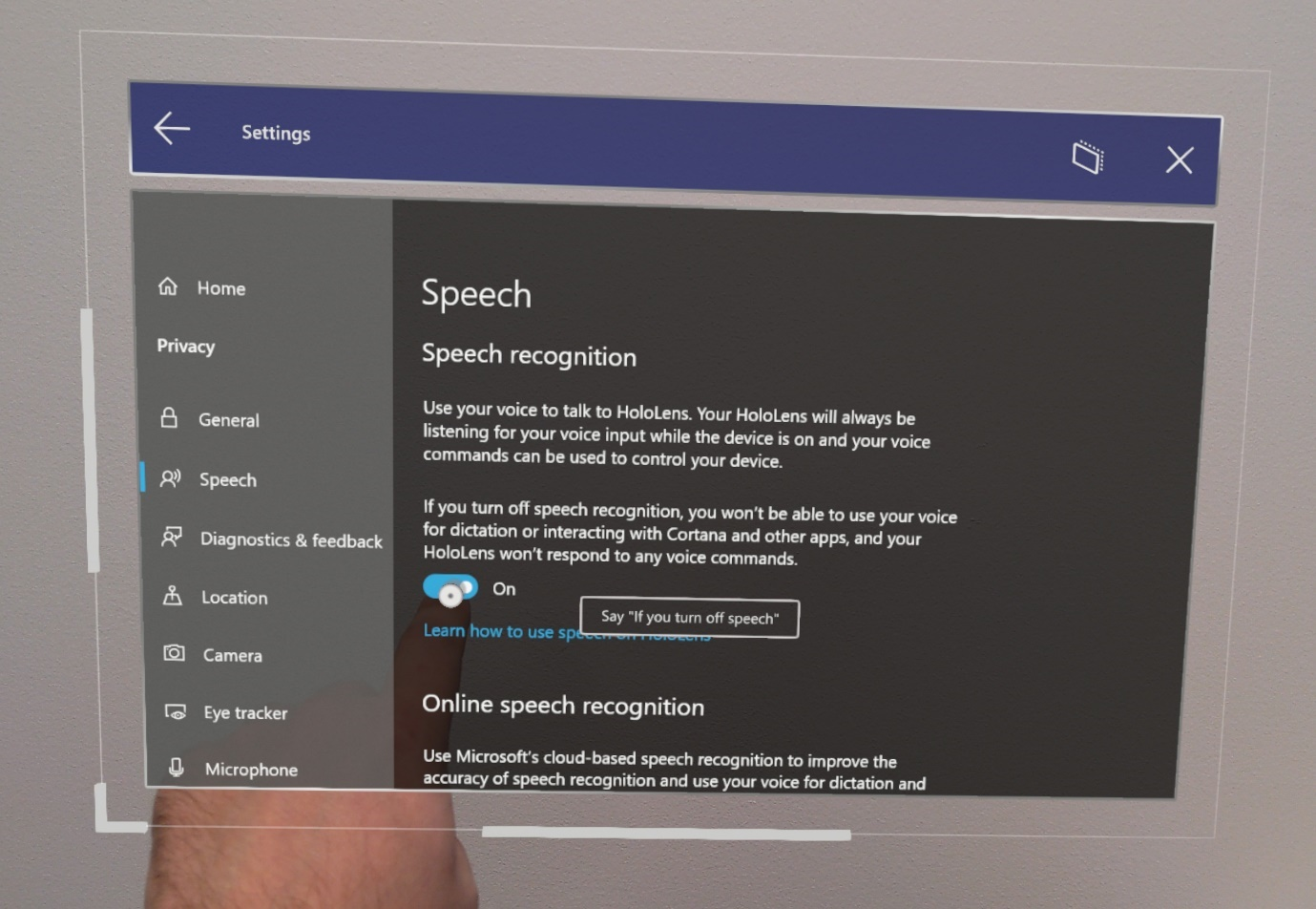

- Riconoscimento vocale abilitato in Impostazioni > Voce privacy > e selezionare Inglese.

Nota

Il riconoscimento vocale funziona sempre nella lingua di visualizzazione di Windows configurata nell'app Impostazioni . È consigliabile abilitare anche il riconoscimento vocale online per la migliore qualità del servizio.

- Verrà visualizzata una finestra di dialogo quando l'applicazione inizia per la prima volta a chiedere se si vuole abilitare il microfono. Selezionando Sì viene avviato l'input vocale nell'app.

Aggiunta di mapping voce

La connessione della voce all'azione è un passaggio importante quando si usa l'input vocale. Questi mapping monitorano l'app per le parole chiave vocali che un utente potrebbe pronunciare, quindi attiva un'azione collegata. È possibile trovare i mapping vocali in base a:

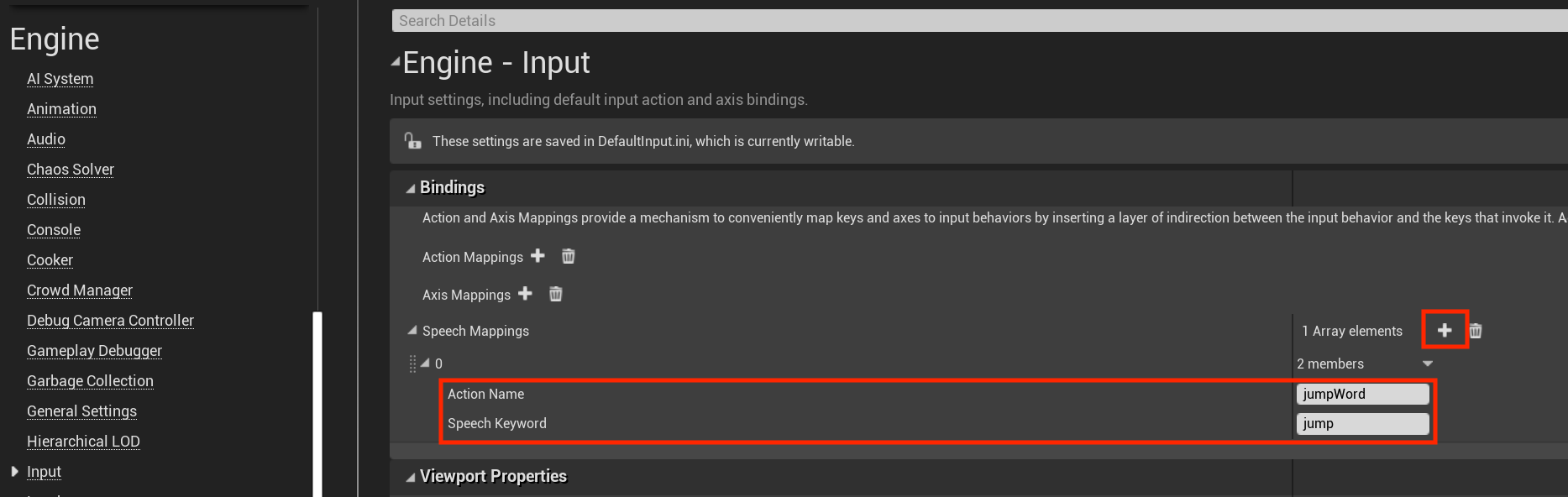

- Selezionare Modifica > impostazioni progetto, scorrere fino alla sezione Motore e fare clic su Input.

Per aggiungere un nuovo mapping vocale per un comando jump:

- Selezionare l'icona + accanto a Elementi matrice e compilare i valori seguenti:

- jumpWord per Nome azione

- Jump for Speech Keyword

Nota

Qualsiasi parola o frase breve può essere usata come parola chiave.

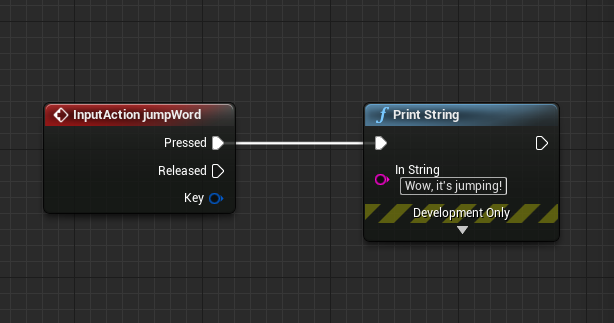

I mapping vocali possono essere usati come componenti di input come mapping di azioni o assi o come nodi di progetto nel grafico eventi. Ad esempio, è possibile collegare il comando jump per stampare due log diversi a seconda del momento in cui viene pronunciata la parola:

- Fare doppio clic su un progetto per aprirlo nel grafico eventi.

- Fare clic con il pulsante destro del mouse e cercare il nome azione del mapping vocale (in questo caso jumpWord), quindi premere INVIO per aggiungere un nodo Azione di input al grafico.

- Trascinare e rilasciare il segnaposto premuto sul nodo Stampa stringa , come illustrato nell'immagine seguente. È possibile lasciare vuoto il pin Rilasciato , non verrà eseguito alcun elemento per i mapping vocali.

- Riprodurre l'app, pronunciare la parola jump e watch la console di stampare i log.

Questa è tutta la configurazione che dovrai iniziare ad aggiungere l'input vocale alle app HoloLens in Unreal. Per altre informazioni sul riconoscimento vocale e sull'interattività, vedere i collegamenti seguenti e assicurarsi di considerare l'esperienza che si sta creando per gli utenti.

Successivo checkpoint di sviluppo

Se si sta seguendo il percorso di sviluppo Unreal definito, l'attività successiva consiste nell'esplorare le funzionalità e le API della piattaforma Realtà mista:

È sempre possibile tornare ai checkpoint per lo sviluppo con Unreal in qualsiasi momento.