Esempi di codice swapchain di composizione

Questi esempi di codice usano le librerie di implementazione di Windows (WIL). Un modo pratico per installare WIL consiste nel passare a Visual Studio, fare clic su Project>Manage NuGet Packages (Gestisci pacchetti NuGet).>Sfoglia, digita o incolla Microsoft.Windows.ImplementationLibrary nella casella di ricerca, seleziona l'elemento nei risultati della ricerca e quindi fai clic su Installa per installare il pacchetto per il progetto.

Esempio 1: Creazione di un gestore presentazioni nei sistemi che supportano l'API swapchain di composizione

Come accennato, l'API swapchain di composizione richiede driver supportati per funzionare. L'esempio seguente illustra come l'applicazione può creare un gestore presentazioni se il sistema supporta l'API. Questa operazione viene illustrata come funzione TryCreate-style che restituisce lo strumento di gestione presentazioni solo se l'API è supportata. Questa funzione illustra anche come creare correttamente un dispositivo Direct3D per eseguire il backup di un gestore di presentazioni.

Esempio di C++

bool TryCreatePresentationManager(

_In_ bool requestDirectPresentation,

_Out_ ID3D11Device** ppD3DDevice,

_Outptr_opt_result_maybenull_ IPresentationManager **ppPresentationManager)

{

// Null the presentation manager and Direct3D device initially

*ppD3DDevice = nullptr;

*ppPresentationManager = nullptr;

// Direct3D device creation flags. The composition swapchain API requires that applications disable internal

// driver threading optimizations, as these optimizations are incompatible with the

// composition swapchain API. If this flag is not present, then the API will fail the call to create the

// presentation factory.

UINT deviceCreationFlags =

D3D11_CREATE_DEVICE_BGRA_SUPPORT |

D3D11_CREATE_DEVICE_SINGLETHREADED |

D3D11_CREATE_DEVICE_PREVENT_INTERNAL_THREADING_OPTIMIZATIONS;

// Create the Direct3D device.

com_ptr_failfast<ID3D11DeviceContext> d3dDeviceContext;

FAIL_FAST_IF_FAILED(D3D11CreateDevice(

nullptr, // No adapter

D3D_DRIVER_TYPE_HARDWARE, // Hardware device

nullptr, // No module

deviceCreationFlags, // Device creation flags

nullptr, 0, // Highest available feature level

D3D11_SDK_VERSION, // API version

ppD3DDevice, // Resulting interface pointer

nullptr, // Actual feature level

&d3dDeviceContext)); // Device context

// Call the composition swapchain API export to create the presentation factory.

com_ptr_failfast<IPresentationFactory> presentationFactory;

FAIL_FAST_IF_FAILED(CreatePresentationFactory(

(*ppD3DDevice),

IID_PPV_ARGS(&presentationFactory)));

// Determine whether the system is capable of supporting the composition swapchain API based

// on the capability that's reported by the presentation factory. If your application

// wants direct presentation (that is, presentation without the need for DWM to

// compose, using MPO or iflip), then we query for direct presentation support.

bool isSupportedOnSystem;

if (requestDirectPresentation)

{

isSupportedOnSystem = presentationFactory->IsPresentationSupportedWithIndependentFlip();

}

else

{

isSupportedOnSystem = presentationFactory->IsPresentationSupported();

}

// Create the presentation manager if it is supported on the current system.

if (isSupportedOnSystem)

{

FAIL_FAST_IF_FAILED(presentationFactory->CreatePresentationManager(ppPresentationManager));

}

return isSupportedOnSystem;

}

Esempio 2: Creazione di un gestore di presentazioni e di una superficie di presentazione

L'esempio seguente illustra come l'applicazione creerebbe uno strumento di gestione presentazioni e una superficie di presentazione da associare a un oggetto visivo in una struttura ad albero visuale. Gli esempi successivi illustrano come associare la superficie di presentazione in alberi visivi DirectComposition e Windows.UI.Composition.

Esempio di C++ (DCompositionGetTargetStatistics)

bool MakePresentationManagerAndPresentationSurface(

_Out_ ID3D11Device** ppD3dDevice,

_Out_ IPresentationManager** ppPresentationManager,

_Out_ IPresentationSurface** ppPresentationSurface,

_Out_ unique_handle& compositionSurfaceHandle)

{

// Null the output pointers initially.

*ppD3dDevice = nullptr;

*ppPresentationManager = nullptr;

*ppPresentationSurface = nullptr;

compositionSurfaceHandle.reset();

com_ptr_failfast<IPresentationManager> presentationManager;

com_ptr_failfast<IPresentationSurface> presentationSurface;

com_ptr_failfast<ID3D11Device> d3d11Device;

// Call the function we defined previously to create a Direct3D device and presentation manager, if

// the system supports it.

if (TryCreatePresentationManager(

true, // Request presentation with independent flip.

&d3d11Device,

&presentationManager) == false)

{

// Return 'false' out of the call if the composition swapchain API is unsupported. Assume the caller

// will handle this somehow, such as by falling back to DXGI.

return false;

}

// Use DirectComposition to create a composition surface handle.

FAIL_FAST_IF_FAILED(DCompositionCreateSurfaceHandle(

COMPOSITIONOBJECT_ALL_ACCESS,

nullptr,

compositionSurfaceHandle.addressof()));

// Create presentation surface bound to the composition surface handle.

FAIL_FAST_IF_FAILED(presentationManager->CreatePresentationSurface(

compositionSurfaceHandle.get(),

presentationSurface.addressof()));

// Return the Direct3D device, presentation manager, and presentation surface to the caller for future

// use.

*ppD3dDevice = d3d11Device.detach();

*ppPresentationManager = presentationManager.detach();

*ppPresentationSurface = presentationSurface.detach();

// Return 'true' out of the call if the composition swapchain API is supported and we were able to

// create a presentation manager.

return true;

}

Esempio 3: Associazione di una superficie di presentazione a un pennello di superficie Windows.UI.Composition

L'esempio seguente illustra come l'applicazione associa un handle di superficie di composizione associato a una superficie di presentazione, come creato nell'esempio precedente, a un pennello di superficie Windows.UI.Composition (WinComp), che può quindi essere associato a un oggetto visivo sprite nella struttura ad albero visuale dell'applicazione.

Esempio di C++

void BindPresentationSurfaceHandleToWinCompTree(

_In_ ICompositor * pCompositor,

_In_ ISpriteVisual * pVisualToBindTo, // The sprite visual we want to bind to.

_In_ unique_handle& compositionSurfaceHandle)

{

// QI an interop compositor from the passed compositor.

com_ptr_failfast<ICompositorInterop> compositorInterop;

FAIL_FAST_IF_FAILED(pCompositor->QueryInterface(IID_PPV_ARGS(&compositorInterop)));

// Create a composition surface for the presentation surface's composition surface handle.

com_ptr_failfast<ICompositionSurface> compositionSurface;

FAIL_FAST_IF_FAILED(compositorInterop->CreateCompositionSurfaceForHandle(

compositionSurfaceHandle.get(),

&compositionSurface));

// Create a composition surface brush, and bind the surface to it.

com_ptr_failfast<ICompositionSurfaceBrush> surfaceBrush;

FAIL_FAST_IF_FAILED(pCompositor->CreateSurfaceBrush(&surfaceBrush));

FAIL_FAST_IF_FAILED(surfaceBrush->put_Surface(compositionSurface.get()));

// Bind the brush to the visual.

auto brush = surfaceBrush.query<ICompositionBrush>();

FAIL_FAST_IF_FAILED(pVisualToBindTo->put_Brush(brush.get()));

}

Esempio 4: Associazione di una superficie di presentazione a un oggetto visivo DirectComposition

L'esempio seguente illustra come l'applicazione associa una superficie di presentazione a un oggetto visivo DirectComposition (DComp) in una struttura ad albero visuale.

Esempio di C++

void BindPresentationSurfaceHandleToDCompTree(

_In_ IDCompositionDevice* pDCompDevice,

_In_ IDCompositionVisual* pVisualToBindTo,

_In_ unique_handle& compositionSurfaceHandle) // The composition surface handle that was

// passed to CreatePresentationSurface.

{

// Create a DComp surface to wrap the presentation surface.

com_ptr_failfast<IUnknown> dcompSurface;

FAIL_FAST_IF_FAILED(pDCompDevice->CreateSurfaceFromHandle(

compositionSurfaceHandle.get(),

&dcompSurface));

// Bind the presentation surface to the visual.

FAIL_FAST_IF_FAILED(pVisualToBindTo->SetContent(dcompSurface.get()));

}

Esempio 5: impostazione della modalità alfa e dello spazio colore su una superficie di presentazione

L'esempio seguente illustra come l'applicazione imposta la modalità alfa e lo spazio dei colori in una superficie di presentazione. La modalità alfa descrive se e come deve essere interpretato il canale alfa nella trama. Lo spazio colori descrive lo spazio dei colori a cui fanno riferimento i pixel della trama.

Tutti gli aggiornamenti delle proprietà come questi avranno effetto come parte del prossimo presente dell'applicazione e avranno effetto atomicamente insieme a tutti gli aggiornamenti del buffer che fanno parte di tale presente. Un presente può anche, se l'applicazione desidera, non aggiornare alcun buffer e, invece, è costituito solo da aggiornamenti delle proprietà. Tutte le superfici di presentazione i cui buffer non vengono aggiornati su un particolare presente rimangono associati a qualsiasi buffer a cui sono stati associati prima di tale presente.

Esempio di C++

void SetAlphaModeAndColorSpace(

_In_ IPresentationSurface* pPresentationSurface)

{

// Set alpha mode.

FAIL_FAST_IF_FAILED(pPresentationSurface->SetAlphaMode(DXGI_ALPHA_MODE_IGNORE));

// Set color space to full RGB.

FAIL_FAST_IF_FAILED(pPresentationSurface->SetColorSpace(DXGI_COLOR_SPACE_RGB_FULL_G22_NONE_P709));

}

Esempio 6: Impostazione dei margini di letterboxing su una superficie di presentazione

L'esempio seguente illustra come l'applicazione specifica i margini di letterboxing in una superficie di presentazione. Il letterboxing viene usato per riempire un'area specificata all'esterno del contenuto della superficie stessa, in modo da tenere conto di proporzioni diverse tra il contenuto e il dispositivo di visualizzazione in cui viene visualizzato. Un buon esempio di questo sono le barre nere che sono spesso visibili sopra e sotto contenuto quando si guarda su un PC un film formattato per i teatri widescreen. L'API swapchain di composizione consente di specificare i margini all'interno dei quali eseguire il rendering del letterboxing in tali casi.

Attualmente, le aree di letterboxing sono sempre riempite con nero opaco.

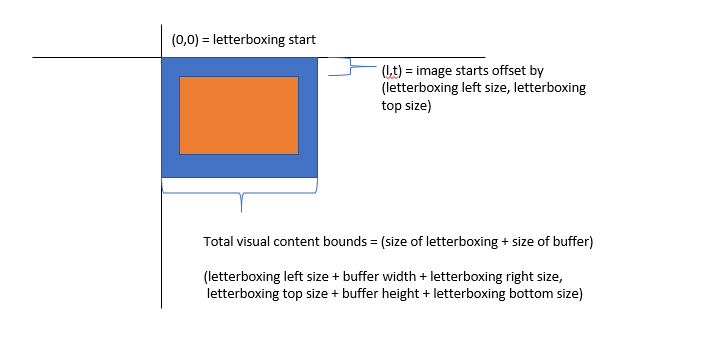

Come contenuto della struttura ad albero visuale, la superficie di presentazione si trova nello spazio delle coordinate dell'oggetto visivo host. Con il letterboxing presente, l'origine dello spazio delle coordinate dell'oggetto visivo corrisponde all'angolo superiore sinistro del letterboxing. Vale a dire, il buffer stesso esiste l'offset nello spazio delle coordinate dell'oggetto visivo. I limiti vengono calcolati come dimensioni del buffer più le dimensioni del letterboxing.

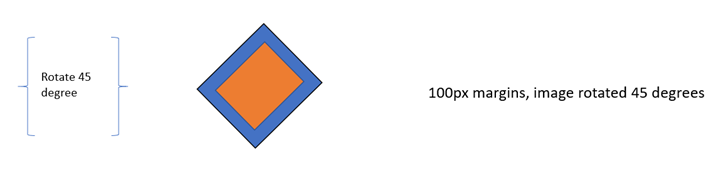

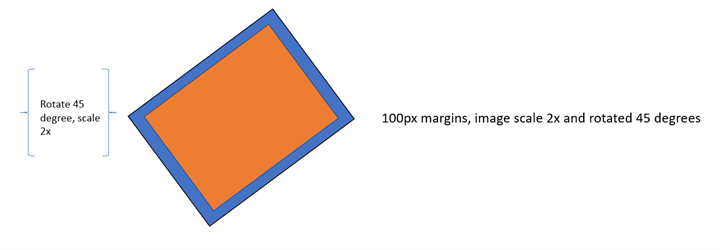

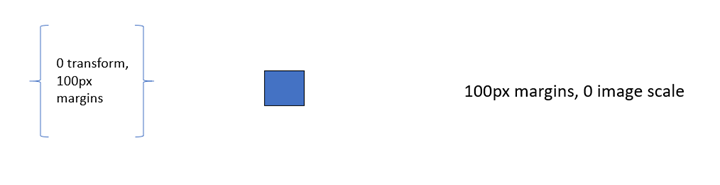

Di seguito viene illustrato dove sono presenti buffer e letterboxing nello spazio delle coordinate visive e come vengono calcolati i limiti.

Infine, se la trasformazione applicata a una superficie di presentazione presenta un offset, l'area non coperta dal buffer o il letterboxing viene considerata al di fuori dei limiti del contenuto e viene considerata trasparente, analogamente alla modalità di trattamento di qualsiasi altro contenuto ad albero visuale al di fuori dei limiti di contenuto.

Interazione con letterboxing e trasformazione

Per fornire dimensioni del margine di letterboxing coerenti indipendentemente dalla scala applicata all'applicazione a un buffer per riempire un'area di contenuto, DWM tenterà di eseguire il rendering dei margini a una dimensione coerente indipendentemente dalla scala, ma tenendo conto del risultato della trasformazione applicata alla superficie di presentazione.

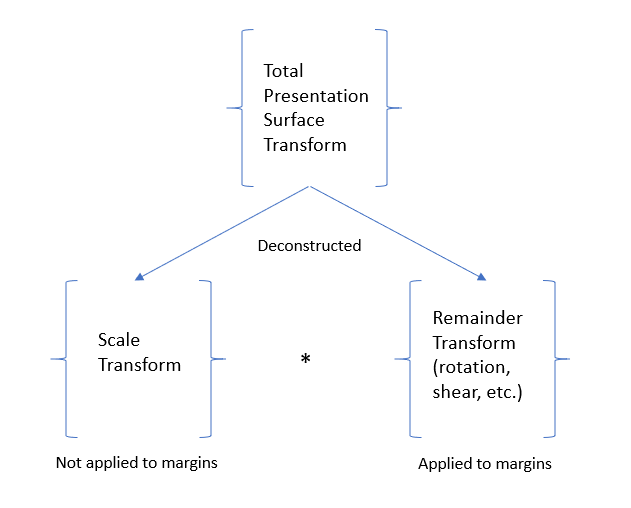

Mettere in un altro modo, i margini di letterboxing vengono tecnicamente applicati prima che venga applicata la trasformazione della superficie di presentazione, ma compensare qualsiasi scala che potrebbe far parte di tale trasformazione. Vale a dire, la trasformazione della superficie di presentazione viene decostruita in due componenti, ovvero la parte della trasformazione che viene ridimensionata e il resto della trasformazione.

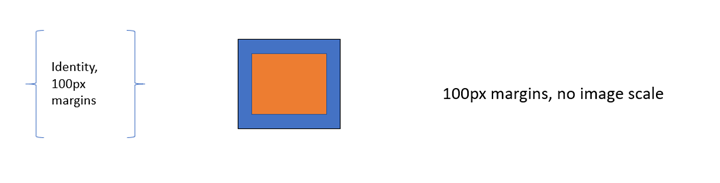

Ad esempio, con margini di 100px letterboxing e nessuna trasformazione applicata all'area di presentazione, il buffer risultante verrà sottoposto a rendering senza scala e i margini di letterboxing saranno 100px wide.

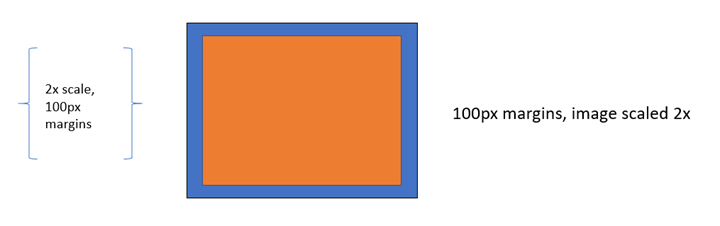

Un altro esempio, con margini di 100px letterboxing e una trasformazione di scala 2x applicata sulla superficie di presentazione, il buffer risultante verrà sottoposto a rendering con una scala 2x e i margini di letterboxing visualizzati sullo schermo saranno comunque 100 px in tutte le dimensioni.

Un altro esempio, con una trasformazione di rotazione di 45 gradi, i margini di letterboxing risultanti appariranno 100 px e i margini di letterboxing verranno ruotati con il buffer.

Un altro esempio, con una trasformazione scala 2x e rotazione di 45 gradi, l'immagine verrà ruotata e ridimensionata e i margini di letterboxing saranno anche 100 px largo e ruotato con il buffer.

Se una trasformazione di scala non può essere estratta in modo ambiguo dalla trasformazione applicata dall'applicazione alla superficie di presentazione, ad esempio se la scala X o Y risultante è 0, il rendering dei margini del letterboxing verrà eseguito con l'intera trasformazione applicata e non si tenterà di compensare la scala.

Esempio di C++

void SetContentLayoutAndFill(

_In_ IPresentationSurface* pPresentationSurface)

{

// Set layout properties. Each layout property is described below.

// The source RECT describes the area from the bound buffer that will be sampled from. The

// RECT is in source texture coordinates. Below we indicate that we'll sample from a

// 100x100 area on the source texture.

RECT sourceRect;

sourceRect.left = 0;

sourceRect.top = 0;

sourceRect.right = 100;

sourceRect.bottom = 100;

FAIL_FAST_IF_FAILED(pPresentationSurface->SetSourceRect(&sourceRect));

// The presentation transform defines how the source rect will be transformed when

// rendering the buffer. In this case, we indicate we want to scale it 2x in both

// width and height, and we also want to offset it 50 pixels to the right.

PresentationTransform transform = { 0 };

transform.M11 = 2.0f; // X scale 2x

transform.M22 = 2.0f; // Y scale 2x

transform.M31 = 50.0f; // X offset 50px

FAIL_FAST_IF_FAILED(pPresentationSurface->SetTransform(&transform));

// The letterboxing parameters describe how to letterbox the content. Letterboxing

// is commonly used to fill area not covered by video/surface content when scaling to

// an aspect ratio that doesn't match the aspect ratio of the surface itself. For

// example, when viewing content formatted for the theater on a 1080p home screen, one

// can typically see black "bars" on the top and bottom of the video, covering the space

// on screen that wasn't covered by the video due to the differing aspect ratios of the

// content and the display device. The composition swapchain API allows the user to specify

// letterboxing margins, which describe the number of pixels to surround the surface

// content with on screen. In this case, surround the top and bottom of our content with

// 100 pixel tall letterboxing.

FAIL_FAST_IF_FAILED(pPresentationSurface->SetLetterboxingMargins(

0.0f,

100.0f,

0.0f,

100.0f));

}

Esempio 7: Impostazione delle restrizioni di contenuto su una superficie di presentazione

L'esempio seguente illustra come l'applicazione impedisce ad altre applicazioni di leggere il contenuto della superficie di presentazione (da tecnologie come PrintScreen, DDA, API di acquisizione e altri) ai fini del contenuto protetto. Viene inoltre illustrato come limitare la visualizzazione di una superficie di presentazione a un singolo output DXGI.

Se il readback del contenuto è disabilitato, quando l'applicazione tenta di eseguire la lettura, l'immagine acquisita conterrà il nero opaco al posto della superficie di presentazione. Se una superficie di presentazione è limitata a un IDXGIOutput, apparirà come nero opaco in tutti gli altri output.

Esempio di C++

void SetContentRestrictions(

_In_ IPresentationSurface* pPresentationSurface,

_In_ IDXGIOutput* pOutputToRestrictTo)

{

// Disable readback of the surface via printscreen, bitblt, etc.

FAIL_FAST_IF_FAILED(pPresentationSurface->SetDisableReadback(true));

// Restrict display of surface to only the passed output.

FAIL_FAST_IF_FAILED(pPresentationSurface->RestrictToOutput(pOutputToRestrictTo));

}

Esempio 8: Aggiunta di buffer di presentazione a un gestore presentazioni

L'esempio seguente illustra come l'applicazione alloca un set di trame Direct3D e le aggiunge al gestore presentazioni da usare come buffer di presentazione, che possono essere presentate alle superfici di presentazione.

Come accennato, non esistono restrizioni relative al numero di manager di presentazione con cui è possibile registrare una trama. Tuttavia, nella maggior parte dei casi d'uso normali, una trama verrà registrata solo in un singolo gestore presentazioni.

Si noti anche che poiché l'API accetta handle di buffer condiviso come valuta durante la registrazione di trame come buffer di presentazione nel gestore presentazioni e poiché DXGI può creare più buffer condivisi per un singolo texture2D, è tecnicamente possibile per l'applicazione creare più handle di buffer condiviso per una singola trama e registrarli entrambi con il responsabile della presentazione, essenzialmente avendo l'effetto di aggiungere lo stesso buffer più di una volta. Questo non è consigliato, perché interromperà i meccanismi di sincronizzazione forniti dal gestore della presentazione, poiché due buffer di presentazione rilevati in modo univoco corrisponderanno effettivamente alla stessa trama. Poiché si tratta di un'API avanzata e poiché in realtà è piuttosto difficile nell'implementazione rilevare questo caso quando si verifica, l'API non tenta di convalidare questo scenario.

Esempio di C++

void AddBuffersToPresentationManager(

_In_ ID3D11Device* pD3D11Device, // The backing Direct3D device

_In_ IPresentationManager* pPresentationManager, // Previously-made presentation manager

_In_ UINT bufferWidth, // The width of the buffers to add

_In_ UINT bufferHeight, // The height of the buffers to add

_In_ UINT numberOfBuffersToAdd, // The number of buffers to add to the presentation manager

_Out_ vector<com_ptr_failfast<ID3D11Texture2D>>& textures, // Array of textures returned

_Out_ vector<com_ptr_failfast<IPresentationBuffer>>& presentationBuffers) // Array of presentation buffers returned

{

// Clear the returned vectors initially.

textures.clear();

presentationBuffers.clear();

// Add the desired buffers to the presentation manager.

for (UINT i = 0; i < numberOfBuffersToAdd; i++)

{

com_ptr_failfast<ID3D11Texture2D> texture;

com_ptr_failfast<IPresentationBuffer> presentationBuffer;

// Call our helper to make a new buffer of the desired type.

AddNewPresentationBuffer(

pD3D11Device,

pPresentationManager,

bufferWidth,

bufferHeight,

&texture,

&presentationBuffer);

// Track our buffers in our own set of vectors.

textures.push_back(texture);

presentationBuffers.push_back(presentationBuffer);

}

}

void AddNewPresentationBuffer(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ UINT bufferWidth,

_In_ UINT bufferHeight,

_Out_ ID3D11Texture2D** ppTexture2D,

_Out_ IPresentationBuffer** ppPresentationBuffer)

{

com_ptr_failfast<ID3D11Texture2D> texture2D;

unique_handle sharedResourceHandle;

// Create a shared Direct3D texture and handle with the passed attributes.

MakeD3D11Texture(

pD3D11Device,

bufferWidth,

bufferHeight,

&texture2D,

out_param(sharedResourceHandle));

// Add the texture2D to the presentation manager, and get back a presentation buffer.

com_ptr_failfast<IPresentationBuffer> presentationBuffer;

FAIL_FAST_IF_FAILED(pPresentationManager->AddBufferFromSharedHandle(

sharedResourceHandle.get(),

&presentationBuffer));

// Return back the texture and buffer presentation buffer.

*ppTexture2D = texture2D.detach();

*ppPresentationBuffer = presentationBuffer.detach();

}

void MakeD3D11Texture(

_In_ ID3D11Device* pD3D11Device,

_In_ UINT textureWidth,

_In_ UINT textureHeight,

_Out_ ID3D11Texture2D** ppTexture2D,

_Out_ HANDLE* sharedResourceHandle)

{

D3D11_TEXTURE2D_DESC textureDesc = {};

// Width and height can be anything within max texture size of the adapter backing the Direct3D

// device.

textureDesc.Width = textureWidth;

textureDesc.Height = textureHeight;

// MipLevels and ArraySize must be 1.

textureDesc.MipLevels = 1;

textureDesc.ArraySize = 1;

// Format can be one of the following:

// DXGI_FORMAT_B8G8R8A8_UNORM

// DXGI_FORMAT_R8G8B8A8_UNORM

// DXGI_FORMAT_R16G16B16A16_FLOAT

// DXGI_FORMAT_R10G10B10A2_UNORM

// DXGI_FORMAT_NV12

// DXGI_FORMAT_YUY2

// DXGI_FORMAT_420_OPAQUE

// For this

textureDesc.Format = DXGI_FORMAT_B8G8R8A8_UNORM;

// SampleDesc count and quality must be 1 and 0 respectively.

textureDesc.SampleDesc.Count = 1;

textureDesc.SampleDesc.Quality = 0;

// Usage must be D3D11_USAGE_DEFAULT.

textureDesc.Usage = D3D11_USAGE_DEFAULT;

// BindFlags must include D3D11_BIND_SHADER_RESOURCE for RGB textures, and D3D11_BIND_DECODER

// for YUV textures. For RGB textures, it is likely your application will want to specify

// D3D11_BIND_RENDER_TARGET in order to render to it.

textureDesc.BindFlags =

D3D11_BIND_SHADER_RESOURCE |

D3D11_BIND_RENDER_TARGET;

// MiscFlags should include D3D11_RESOURCE_MISC_SHARED and D3D11_RESOURCE_MISC_SHARED_NTHANDLE,

// and might also include D3D11_RESOURCE_MISC_SHARED_DISPLAYABLE if your application wishes to

// qualify for MPO and iflip. If D3D11_RESOURCE_MISC_SHARED_DISPLAYABLE is not provided, then the

// content will not qualify for MPO or iflip, but can still be composed by DWM

textureDesc.MiscFlags =

D3D11_RESOURCE_MISC_SHARED |

D3D11_RESOURCE_MISC_SHARED_NTHANDLE |

D3D11_RESOURCE_MISC_SHARED_DISPLAYABLE;

// CPUAccessFlags must be 0.

textureDesc.CPUAccessFlags = 0;

// Use Direct3D to create a texture 2D matching the desired attributes.

com_ptr_failfast<ID3D11Texture2D> texture2D;

FAIL_FAST_IF_FAILED(pD3D11Device->CreateTexture2D(&textureDesc, nullptr, &texture2D));

// Create a shared handle for the texture2D.

unique_handle sharedBufferHandle;

auto dxgiResource = texture2D.query<IDXGIResource1>();

FAIL_FAST_IF_FAILED(dxgiResource->CreateSharedHandle(

nullptr,

GENERIC_ALL,

nullptr,

&sharedBufferHandle));

// Return the handle to the caller.

*ppTexture2D = texture2D.detach();

*sharedResourceHandle = sharedBufferHandle.release();

}

Esempio 9: rimozione di buffer di presentazione da un gestore presentazioni e durata degli oggetti

La rimozione di un buffer di presentazione dal gestore presentazioni è semplice come rilasciare l'oggetto IPresentationBuffer in un conteggio 0. Tuttavia, quando ciò accade, non significa necessariamente che il buffer di presentazione possa essere rilasciato. Possono verificarsi casi in cui un buffer può essere ancora in uso, ad esempio se tale buffer di presentazione è visibile sullo schermo o presenta in sospeso tale riferimento.

In breve, il responsabile della presentazione continuerà a tenere traccia del modo in cui ogni buffer viene usato direttamente dall'applicazione e indirettamente. Continuerà a tenere traccia dei buffer visualizzati, dei buffer in sospeso e dei riferimenti e di tenere traccia internamente di tutto questo stato per assicurarsi che un buffer non venga effettivamente rilasciato/annullato fino a quando non è più in uso.

Un buon modo per pensare alla durata del buffer è che se l'applicazione rilascia un IPresentationBuffer, significa che l'API non userà più tale buffer in qualsiasi chiamata futura. L'API di swapchain di composizione eseguirà il rilevamento, così come qualsiasi altro modo in cui viene usato il buffer e rilascerà completamente il buffer solo quando è completamente sicuro per farlo.

In breve, l'applicazione dovrebbe rilasciare un IPresentationBuffer al termine dell'operazione e sapere che l'API swapchain di composizione rilascerà completamente il buffer quando tutti gli altri usi sono stati completati.

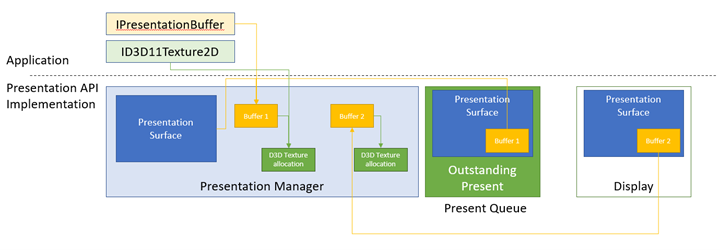

Ecco un'illustrazione dei concetti precedenti.

In questo esempio è disponibile un gestore presentazioni con due buffer di presentazione. Il buffer 1 ha tre riferimenti che lo mantengono attivi.

- L'applicazione contiene un IPresentationBuffer che lo fa riferimento.

- Interno all'API, viene archiviato come buffer associato corrente dell'area di presentazione, come è stato l'ultimo buffer associato all'applicazione, che ha quindi presentato.

- C'è anche un presente in sospeso nella coda presente che intende visualizzare il buffer 1 sulla superficie di presentazione.

Il buffer 1 contiene inoltre un riferimento sull'allocazione della trama Direct3D corrispondente. L'applicazione ha anche un ID3D11Texture2D che fa riferimento a tale allocazione.

Buffer 2 non include riferimenti in sospeso dal lato applicazione, né l'allocazione delle trame a cui fa riferimento, ma il buffer 2 viene mantenuto attivo perché è ciò che viene visualizzato attualmente dalla superficie di presentazione sullo schermo. Quando present 1 viene elaborato e il buffer 1 viene visualizzato sullo schermo, buffer 2 non avrà più riferimenti e verrà rilasciato, a sua volta rilasciando il riferimento sull'allocazione Direct3D texture2D.

Esempio di C++

void ReleasePresentationManagerBuffersExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager)

{

com_ptr_failfast<ID3D11Texture2D> texture2D;

com_ptr_failfast<IPresentationBuffer> newBuffer;

// Create a new texture/presentation buffer.

AddNewPresentationBuffer(

pD3D11Device,

pPresentationManager,

200, // Buffer width

200, // Buffer height

&texture2D,

&newBuffer);

// Release the IPresentationBuffer. This indicates that we have no more intention to use it

// from the application side. However, if we have any presents outstanding that reference

// the buffer, it will be kept alive internally and released when all outstanding presents

// have been retired.

newBuffer.reset();

// When the presentation buffer is truly released internally, it will in turn release its

// reference on the texture2D which it corresponds to. Your application must also release

// its own references to the texture2D for it to be released.

texture2D.reset();

}

Esempio 10: ridimensionamento dei buffer in un gestore presentazioni

L'esempio seguente illustra come l'applicazione eseguirà un ridimensionamento dei buffer di presentazione. Ad esempio, se un servizio di streaming di film è in streaming 480p, ma decide di passare a 1080p a causa della disponibilità di una larghezza di banda di rete elevata, sarebbe necessario riallocare i buffer da 480p a 1080p in modo che possa iniziare a presentare contenuto di 1080p.

In DXGI questa operazione viene definita operazione di ridimensionamento . DXGI rialloca tutti i buffer in modo atomico, che è costoso e può produrre glitch sullo schermo. L'esempio seguente descrive come ottenere il ridimensionamento atomico in modo equivalente a DXGI nell'API swapchain di composizione. Un esempio successivo mostrerà come eseguire un ridimensionamento in modo sfalsato , spaziando la riallocazione tra più regali, ottenendo prestazioni migliori rispetto a un ridimensionamento atomico della porta di scambio.

Esempio di C++

void ResizePresentationManagerBuffersExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager) // Previously-made presentation manager.

{

// Vectors representing the IPresentationBuffer and ID3D11Texture2D collections.

vector<com_ptr_failfast<ID3D11Texture2D>> textures;

vector<com_ptr_failfast<IPresentationBuffer>> presentationBuffers;

// Add 6 50x50 buffers to the presentation manager. See previous example for definition of

// this function.

AddBuffersToPresentationManager(

pD3D11Device,

pPresentationManager,

50, // Buffer width

50, // Buffer height

6, // Number of buffers

textures,

presentationBuffers);

// Release all the buffers we just added. The presentation buffers internally will be released

// when any other references are also removed (outstanding presents, display references, etc.).

textures.clear();

presentationBuffers.clear();

// Add 6 new 100x100 buffers to the presentation manager to replace the

// old ones we just removed.

AddBuffersToPresentationManager(

pD3D11Device,

pPresentationManager,

100, // Buffer width

100, // Buffer height

6, // Number of buffers

textures,

presentationBuffers);

}

Esempio 11: sincronizzazione della presentazione tramite eventi disponibili nel buffer e gestione degli eventi persi di Gestione presentazioni

Se l'applicazione emetterà una presente che coinvolge un buffer di presentazione usato in un momento precedente, è necessario assicurarsi che il presente precedente sia completo per il rendering e presentare di nuovo il buffer di presentazione. L'API swapchain di composizione offre un paio di meccanismi diversi per facilitare questa sincronizzazione. Il più semplice è l'evento disponibile di un buffer di presentazione, ovvero un oggetto evento NT segnalato quando un buffer è disponibile per l'uso( ovvero tutti i regali precedenti sono entrati nello stato di ritiro o ritiro) e non firmati in caso contrario. In questo esempio viene illustrato come usare gli eventi disponibili nel buffer per selezionare i buffer disponibili da presentare. Illustra anche come ascoltare gli errori di perdita del dispositivo che sono moralmente equivalenti alla perdita di dispositivi DXGI e richiedono una ricreazione del responsabile della presentazione.

Errori di perdita di Gestione presentazioni

Un gestore di presentazioni può diventare perso se rileva un errore internamente che non è in grado di recuperare. L'applicazione deve distruggere uno strumento di gestione presentazioni perso e crearne uno nuovo da usare. Quando un manager di presentazione viene perso, smetterà di accettare ulteriori presentazioni. Qualsiasi tentativo di chiamare Present in un manager di presentazione perso restituirà PRE edizione StandardNTATION_ERROR_LOST. Tutti gli altri metodi, tuttavia, funzioneranno normalmente. Ciò consente di assicurarsi che l'applicazione debba solo verificare la presenza di PRE edizione StandardNTATION_ERROR_LOST nelle chiamate presenti e non deve prevedere/gestire gli errori persi in ogni chiamata API. Se l'applicazione desidera verificare o ricevere una notifica degli errori persi all'esterno di una chiamata corrente, può usare l'evento perso restituito da IPresentationManager::GetLostEvent.

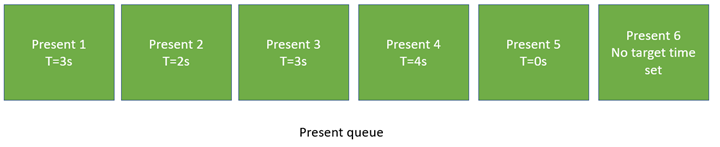

Coda e intervallo presenti

I regali rilasciati dal responsabile della presentazione possono specificare un orario specifico di destinazione. Questo tempo di destinazione è il momento ideale in cui il sistema tenterà di mostrare il presente. Poiché le schermate vengono aggiornate a cadenza limitata, è improbabile che il presente venga visualizzato esattamente al momento specificato, ma verrà visualizzato come vicino all'ora possibile.

Questo tempo di destinazione è un tempo relativo al sistema o l'ora in cui il sistema è stato eseguito dopo l'attivazione, in centinaia di unità di nanosecondo. Un modo semplice per calcolare il tempo corrente consiste nell'eseguire query sul valore queryPerformanceCounter (QPC), dividerlo per la frequenza QPC del sistema e moltiplicarlo per 10.000.000. L'arrotondamento e i limiti di precisione verranno calcolati in unità applicabili. Il sistema potrebbe anche ottenere l'ora corrente chiamando MfGetSystemTime o QueryInterruptTimePrecise.

Una volta che l'ora corrente è nota, l'applicazione genererà in genere presenta a offset crescenti rispetto all'ora corrente.

Indipendentemente dal tempo di destinazione, i regali vengono sempre elaborati in ordine di coda. Anche se un presente è destinato a un'ora precedente rispetto al presente precedente, non verrà elaborato fino a quando non viene elaborato il presente precedente. Ciò significa essenzialmente che qualsiasi presente che non ha come destinazione una volta successiva rispetto a quella prima di eseguirne l'override. Significa anche che se l'applicazione vuole emettere un presente il prima possibile, può semplicemente non impostare un'ora di destinazione (nel qual caso l'ora di destinazione rimarrà quella per l'ultimo presente) o impostare un orario di destinazione pari a 0. Entrambi avrebbero lo stesso effetto. Se l'applicazione non vuole attendere il completamento dei regali precedenti perché venga eseguita una nuova presentazione, sarà necessario annullare i regali precedenti. Un esempio futuro descrive come eseguire questa operazione.

T=3s: presenta 1, 2, 3 tutti pronti e 3, essendo l'ultimo presente, vince. T=4s: presenta 4, 5, 6 tutti pronti e 6, essendo l'ultimo presente, vince.

Il diagramma precedente illustra un esempio di presentazione in sospeso nella coda corrente. Presenti 1 obiettivi un tempo di 3s. Quindi non si svolgeranno regali fino alle 3s. Tuttavia, presenti 2 obiettivi in realtà una volta precedente, 2 e presentare anche 3 obiettivi 3. Di conseguenza, al momento 3, presenta 1, 2 e 3 completerà tutti, e presente 3 sarà il presente per rendere effettivo. In seguito, il prossimo presente, 4, sarà soddisfatto a 4s, ma immediatamente sottoposto a override da Present 5, che ha come obiettivo 0s e Present 6, che non ha un tempo di destinazione impostato. Sia 5 che 6 effettive diventano effettive il prima possibile.

Esempio di C++

bool SimpleEventSynchronizationExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ IPresentationSurface* pPresentationSurface,

_In_ vector<com_ptr_failfast<ID3D11Texture2D>>& textures,

_In_ vector<com_ptr_failfast<IPresentationBuffer>>& presentationBuffers)

{

// Track a time we'll be presenting to below. Default to the current time, then increment by

// 1/10th of a second every present.

SystemInterruptTime presentTime;

QueryInterruptTimePrecise(&presentTime.value);

// Build an array of events that we can wait on to perform various actions in our work loop.

vector<unique_event> waitEvents;

// The lost event will be the first event in our list. This is an event that signifies that

// something went wrong in the system (due to extreme conditions such as memory pressure, or

// driver issues) that indicate that the presentation manager has been lost, and should no

// longer be used, and instead should be recreated.

unique_event lostEvent;

pPresentationManager->GetLostEvent(&lostEvent);

waitEvents.emplace_back(std::move(lostEvent));

// Add each buffer's available event to the list of events we will be waiting on.

for (UINT bufferIndex = 0; bufferIndex < presentationBuffers.size(); bufferIndex++)

{

unique_event availableEvent;

presentationBuffers[bufferIndex]->GetAvailableEvent(&availableEvent);

waitEvents.emplace_back(std::move(availableEvent));

}

// Iterate for 120 presents.

constexpr UINT numberOfPresents = 120;

for (UINT onPresent = 0; onPresent < numberOfPresents; onPresent++)

{

// Advance our present time 1/10th of a second in the future. Note the API accepts

// time in 100ns units, or 1/1e7 of a second, meaning that 1 million units correspond to

// 1/10th of a second.

presentTime.value += 1'000'000;

// Wait for the lost event or an available buffer. Since WaitForMultipleObjects prioritizes

// lower-indexed events, it is recommended to put any higher importance events (like the

// lost event) first, and then follow up with buffer available events.

DWORD waitResult = WaitForMultipleObjects(

static_cast<UINT>(waitEvents.size()),

reinterpret_cast<HANDLE*>(waitEvents.data()),

FALSE,

INFINITE);

// Failfast if the wait hit an error.

FAIL_FAST_IF((waitResult - WAIT_OBJECT_0) >= waitEvents.size());

// Our lost event was the first event in the array. If this is signaled, the caller

// should recreate the presentation manager. This is very similar to how Direct3D devices

// can be lost. Assume our caller knows to handle this return value appropriately.

if (waitResult == WAIT_OBJECT_0)

{

return false;

}

// Otherwise, compute the buffer corresponding to the available event that was signaled.

UINT bufferIndex = waitResult - (WAIT_OBJECT_0 + 1);

// Draw red to that buffer

DrawColorToSurface(

pD3D11Device,

textures[bufferIndex],

1.0f, // red

0.0f, // green

0.0f); // blue

// Bind the presentation buffer to the presentation surface. Changes in this binding will take

// effect on the next present, and the binding persists across presents. That is, any number

// of subsequent presents will imply this binding until it is changed. It is completely fine

// to only update buffers for a subset of the presentation surfaces owned by a presentation

// manager on a given present - the implication is that it simply didn't update.

//

// Similarly, note that if your application were to call SetBuffer on the same presentation

// surface multiple times without calling present, this is fine. The policy is last writer

// wins.

//

// Your application may present without first binding a presentation surface to a buffer.

// The result will be that presentation surface will simply have no content on screen,

// similar to how DComp and WinComp surfaces appear in a tree before they are rendered to.

// In that case system content will show through where the buffer would have been.

//

// Your application may also set a 'null' buffer binding after previously having bound a

// buffer and present - the end result is the same as if your application had presented

// without ever having set the content.

pPresentationSurface->SetBuffer(presentationBuffers[bufferIndex].get());

// Present at the targeted time. Note that a present can target only a single time. If an

// application wants to updates two buffers at two different times, then it must present

// two times.

//

// Presents are always processed in queue order. A present will not take effect before any

// previous present in the queue, even if it targets an earlier time. In such a case, when

// the previous present is processed, the next present will also be processed immediately,

// and override that previous present.

//

// For this reason, if your application wishes to present "now" or "early as possible", then

// it can simply present, without setting a target time. The implied target time will be 0,

// and the new present will override the previous present.

//

// If your application wants to present truly "now", and not wait for previous presents in the

// queue to be processed, then it will need to cancel previous presents. A future example

// demonstrates how to do this.

//

// Your application will receive PRESENTATION_ERROR_LOST if it attempts to Present a lost

// presentation manager. This is the only call that will return such an error. A lost

// presentation manager functions normally in every other case, so applications need only

// to handle this error at the time they call Present.

pPresentationManager->SetTargetTime(presentTime);

HRESULT hrPresent = pPresentationManager->Present();

if (hrPresent == PRESENTATION_ERROR_LOST)

{

// Our presentation manager has been lost. Return 'false' to the caller to indicate that

// the presentation manager should be recreated.

return false;

}

else

{

FAIL_FAST_IF_FAILED(hrPresent);

}

}

return true;

}

void DrawColorToSurface(

_In_ ID3D11Device* pD3D11Device,

_In_ const com_ptr_failfast<ID3D11Texture2D>& texture2D,

_In_ float redValue,

_In_ float greenValue,

_In_ float blueValue)

{

com_ptr_failfast<ID3D11DeviceContext> D3DDeviceContext;

com_ptr_failfast<ID3D11RenderTargetView> renderTargetView;

// Get the immediate context from the D3D11 device.

pD3D11Device->GetImmediateContext(&D3DDeviceContext);

// Create a render target view of the passed texture.

auto resource = texture2D.query<ID3D11Resource>();

FAIL_FAST_IF_FAILED(pD3D11Device->CreateRenderTargetView(

resource.get(),

nullptr,

renderTargetView.addressof()));

// Clear the texture with the specified color.

float clearColor[4] = { redValue, greenValue, blueValue, 1.0f }; // red, green, blue, alpha

D3DDeviceContext->ClearRenderTargetView(renderTargetView.get(), clearColor);

}

Esempio 12: sincronizzazione avanzata: limitazione del flusso di lavoro alle dimensioni della coda presente in sospeso usando limiti di sincronizzazione presenti e gestione degli eventi persi del gestore presentazioni

Nell'esempio seguente viene illustrato come l'applicazione può inviare un numero elevato di regali per il futuro e quindi dormire fino al numero di regali ancora in sospeso fino a una quantità specifica. I framework come Windows Media Foundation limitano questo modo per ridurre al minimo il numero di riattivazioni della CPU che si verificano, garantendo comunque che la coda presente non esaurisca (che impedisce la riproduzione uniforme e causa un errore). Questo ha l'effetto di ridurre al minimo l'utilizzo della potenza della CPU durante il flusso di lavoro della presentazione. L'applicazione accoderà il numero massimo di presentazioni (in base al numero di buffer di presentazione allocati) e quindi si sospendo fino a quando la coda presente non viene esaurita per riempire nuovamente la coda.

Esempio di C++

bool FenceSynchronizationExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ IPresentationSurface* pPresentationSurface,

_In_ vector<com_ptr_failfast<ID3D11Texture2D>>& textures,

_In_ vector<com_ptr_failfast<IPresentationBuffer>>& presentationBuffers)

{

// Track a time we'll be presenting to below. Default to the current time, then increment by

// 1/10th of a second every present.

SystemInterruptTime presentTime;

QueryInterruptTimePrecise(&presentTime.value);

// Get present retiring fence.

com_ptr_failfast<ID3D11Fence> presentRetiringFence;

FAIL_FAST_IF_FAILED(pPresentationManager->GetPresentRetiringFence(

IID_PPV_ARGS(&presentRetiringFence)));

// Get the lost event to query before presentation.

unique_event lostEvent;

pPresentationManager->GetLostEvent(&lostEvent);

// Create an event to synchronize to our queue depth with. We'll use Direct3D to signal this event

// when our synchronization fence indicates reaching a specific present.

unique_event presentQueueSyncEvent;

presentQueueSyncEvent.create(EventOptions::ManualReset);

// Cycle the present queue 10 times.

constexpr UINT numberOfPresentRefillCycles = 10;

for (UINT onRefillCycle = 0; onRefillCycle < numberOfPresentRefillCycles; onRefillCycle++)

{

// Fill up presents for all presentation buffers. We compare the presentation manager's

// next present ID to the present confirmed fence's value to figure out how

// far ahead we are. We stop when we've issued presents for all buffers.

while ((pPresentationManager->GetNextPresentId() -

presentRetiringFence->GetCompletedValue()) < presentationBuffers.size())

{

// Present buffers in cyclical pattern. We can figure out the current buffer to

// present by taking the modulo of the next present ID by the number of buffers. Note that the

// first present of a presentation manager always has a present ID of 1 and increments by 1 on

// each subsequent present. A present ID of 0 is conceptually meant to indicate that "no

// presents have taken place yet".

UINT bufferIndex = static_cast<UINT>(

pPresentationManager->GetNextPresentId() % presentationBuffers.size());

// Assert that the passed buffer is tracked as available for presentation. Because we throttle

// based on the total number of buffers, this should always be true.

NT_ASSERT(presentationBuffers[bufferIndex]->IsAvailable());

// Advance our present time 1/10th of a second in the future.

presentTime.value += 1'000'000;

// Draw red to the texture.

DrawColorToSurface(

pD3D11Device,

textures[bufferIndex],

1.0f, // red

0.0f, // green

0.0f); // blue

// Bind the presentation buffer to the presentation surface.

pPresentationSurface->SetBuffer(presentationBuffers[bufferIndex].get());

// Present at the targeted time.

pPresentationManager->SetTargetTime(presentTime);

HRESULT hrPresent = pPresentationManager->Present();

if (hrPresent == PRESENTATION_ERROR_LOST)

{

// Our presentation manager has been lost. Return 'false' to the caller to indicate that

// the presentation manager should be recreated.

return false;

}

else

{

FAIL_FAST_IF_FAILED(hrPresent);

}

};

// Now that the buffer is full, go to sleep until the present queue has been drained to

// the desired queue depth. To figure out the appropriate present to wake on, we subtract

// the desired wake queue depth from the presentation manager's last present ID. We

// use Direct3D's SetEventOnCompletion to signal our wait event when that particular present

// is retiring, and then wait on that event. Note that the semantic of SetEventOnCompletion

// is such that even if we happen to call it after the fence has already reached the

// requested value, the event will be set immediately.

constexpr UINT wakeOnQueueDepth = 2;

presentQueueSyncEvent.ResetEvent();

FAIL_FAST_IF_FAILED(presentRetiringFence->SetEventOnCompletion(

pPresentationManager->GetNextPresentId() - 1 - wakeOnQueueDepth,

presentQueueSyncEvent.get()));

HANDLE waitHandles[] = { lostEvent.get(), presentQueueSyncEvent.get() };

DWORD waitResult = WaitForMultipleObjects(

ARRAYSIZE(waitHandles),

waitHandles,

FALSE,

INFINITE);

// Failfast if we hit an error during our wait.

FAIL_FAST_IF((waitResult - WAIT_OBJECT_0) >= ARRAYSIZE(waitHandles));

if (waitResult == WAIT_OBJECT_0)

{

// The lost event was signaled - return 'false' to the caller to indicate that

// the presentation manager was lost.

return false;

}

// Iterate into another refill cycle.

}

return true;

}

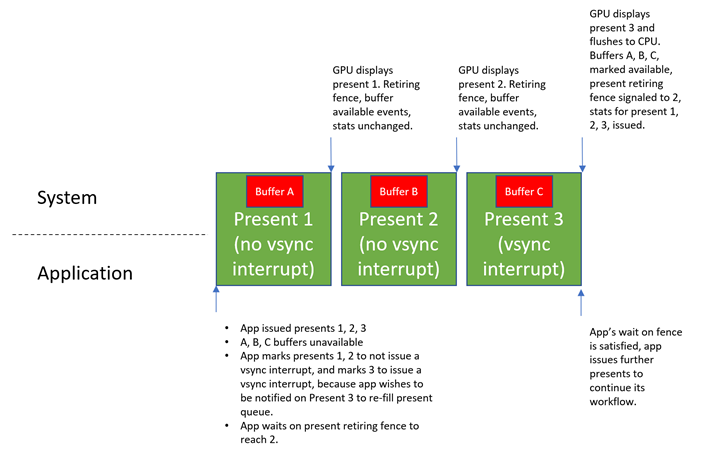

Esempio 13: interruzioni VSync e supporto della coda di scorrimento hardware

Insieme a questa API è stata introdotta una nuova forma di gestione delle code capovolgimento, che consente essenzialmente all'hardware GPU di gestire i regali in modo completamente indipendente dalla CPU. Il vantaggio principale di questo è l'efficienza energetica. Quando la CPU non deve essere coinvolta nel processo di presentazione, viene estratta meno potenza.

Lo svantaggio di avere l'handle GPU presenta in modo indipendente è che lo stato della CPU non può più riflettere immediatamente quando vengono visualizzati i regali. i concetti dell'API di swapchain di composizione, ad esempio eventi disponibili nel buffer, recinzioni di sincronizzazione e statistiche presenti non verranno aggiornate immediatamente. Al contrario, la GPU aggiornerà solo periodicamente lo stato della CPU in base a ciò che è stato visualizzato. Ciò significa che il feedback alle applicazioni relative allo stato presente verrà associato a una latenza.

L'applicazione in genere si preoccupa quando vengono visualizzati alcuni regali, ma non importa molto su altri regali. Ad esempio, se l'applicazione presenta 10 problemi, potrebbe decidere di voler sapere quando viene visualizzato l'8° , in modo che possa iniziare a riempire nuovamente la coda presente. In questo caso, l'unico presente che vuole davvero feedback è l'8°. Non prevede di eseguire alcuna operazione quando vengono visualizzati 1-7 o 9.

Se presenta lo stato di aggiornamento della CPU dipende dal fatto che l'hardware GPU sia configurato per generare un interrupt VSync quando viene visualizzato tale file. Questo interrupt VSync risveglia la CPU se non è già attiva e la CPU esegue codice speciale a livello di kernel per aggiornarsi sui regali che si sono verificati sulla GPU dall'ultima volta che ha controllato, a sua volta aggiornando meccanismi di feedback come gli eventi disponibili del buffer, il limite di ritiro presente e presentano statistiche.

Per consentire all'applicazione di indicare in modo esplicito quali presenta devono emettere un interrupt VSync, lo strumento di gestione presentazioni espone un metodo IPresentationManager::ForceVSyncInterrupt , che specifica se la presentazione successiva deve generare un interrupt VSync. Questa impostazione si applica a tutti i regali futuri fino a quando non viene modificata, in modo analogo a IPresentationManager::SetTargetTime e IPresentationManager::SetPreferredPresentDuration.

Se questa impostazione è abilitata in un particolare presente, l'hardware invia immediatamente una notifica alla CPU quando viene visualizzata, usando una maggiore potenza, ma assicurandosi che la CPU venga immediatamente notificata quando viene eseguita una presente per consentire alle applicazioni di rispondere il più rapidamente possibile. Se questa impostazione è disabilitata in un particolare presente, il sistema potrà rinviare l'aggiornamento della CPU quando viene visualizzato il presente, risparmiando energia, ma rinviando il feedback.

L'applicazione in genere non forza l'interrupt VSync per i regali, ad eccezione di una presente con cui vuole eseguire la sincronizzazione. Nell'esempio precedente, poiché l'applicazione voleva riattivarsi quando l'8° presente veniva visualizzata per riempire la coda presente, richiedeva che presenti 8 segnali un interrupt VSync, ma presenta 1-7 e non presenta 9.

Per impostazione predefinita, se l'applicazione non configura questa impostazione, lo strumento di gestione presentazioni segnalerà sempre l'interrupt VSync quando viene visualizzato ogni presente. Le applicazioni che non sono preoccupate per l'utilizzo dell'alimentazione, o non sono consapevoli del supporto della coda di capovolgimento hardware, possono semplicemente non chiamare ForceVSyncInterrupt e saranno garantite la sincronizzazione corretta come risultato. Le applicazioni che conoscono il supporto della coda di capovolgimento hardware possono controllare in modo esplicito questa impostazione per migliorare l'efficienza energetica.

Di seguito è riportato un diagramma che descrive il comportamento dell'API rispetto alle impostazioni di interrupt VSync.

Esempio di C++

bool ForceVSyncInterruptPresentsExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ IPresentationSurface* pPresentationSurface,

_In_ vector<com_ptr_failfast<ID3D11Texture2D>>& textures,

_In_ vector<com_ptr_failfast<IPresentationBuffer>>& presentationBuffers)

{

// Track a time we'll be presenting to below. Default to the current time, then increment by

// 1/10th of a second every present.

SystemInterruptTime presentTime;

QueryInterruptTimePrecise(&presentTime.value);

// Get present retiring fence.

com_ptr_failfast<ID3D11Fence> presentRetiringFence;

FAIL_FAST_IF_FAILED(pPresentationManager->GetPresentRetiringFence(

IID_PPV_ARGS(&presentRetiringFence)));

// Get the lost event to query before presentation.

unique_event lostEvent;

pPresentationManager->GetLostEvent(&lostEvent);

// Create an event to synchronize to our queue depth with. We will use Direct3D to signal this event

// when our synchronization fence indicates reaching a specific present.

unique_event presentQueueSyncEvent;

presentQueueSyncEvent.create(EventOptions::ManualReset);

// Issue 10 presents, and wake when the present queue is 2 entries deep (which happens when

// present 7 is retiring).

constexpr UINT wakeOnQueueDepth = 2;

constexpr UINT numberOfPresents = 10;

const UINT presentIdToWakeOn = numberOfPresents - 1 - wakeOnQueueDepth;

while (pPresentationManager->GetNextPresentId() <= numberOfPresents)

{

UINT bufferIndex = static_cast<UINT>(

pPresentationManager->GetNextPresentId() % presentationBuffers.size());

// Advance our present time 1/10th of a second in the future.

presentTime.value += 1'000'000;

// Draw red to the texture.

DrawColorToSurface(

pD3D11Device,

textures[bufferIndex],

1.0f, // red

0.0f, // green

0.0f); // blue

// Bind the presentation buffer to the presentation surface.

pPresentationSurface->SetBuffer(presentationBuffers[bufferIndex].get());

// Present at the targeted time.

pPresentationManager->SetTargetTime(presentTime);

// If this present is not going to retire the present that we want to wake on when it is shown, then

// we don't need immediate updates to buffer available events, present retiring fence, or present

// statistics. As such, we can mark it as not requiring a VSync interrupt, to allow for greater

// power efficiency on machines with hardware flip queue support.

bool forceVSyncInterrupt = (pPresentationManager->GetNextPresentId() == (presentIdToWakeOn + 1));

pPresentationManager->ForceVSyncInterrupt(forceVSyncInterrupt);

HRESULT hrPresent = pPresentationManager->Present();

if (hrPresent == PRESENTATION_ERROR_LOST)

{

// Our presentation manager has been lost. Return 'false' to the caller to indicate that

// the presentation manager should be recreated.

return false;

}

else

{

FAIL_FAST_IF_FAILED(hrPresent);

}

}

// Now that the buffer is full, go to sleep until presentIdToWakeOn has begun retiring. We

// configured the subsequent present to force a VSync interrupt when it is shown, which will ensure

// this wait is completed immediately.

presentQueueSyncEvent.ResetEvent();

FAIL_FAST_IF_FAILED(presentRetiringFence->SetEventOnCompletion(

presentIdToWakeOn,

presentQueueSyncEvent.get()));

HANDLE waitHandles[] = { lostEvent.get(), presentQueueSyncEvent.get() };

DWORD waitResult = WaitForMultipleObjects(

ARRAYSIZE(waitHandles),

waitHandles,

FALSE,

INFINITE);

// Failfast if we hit an error during our wait.

FAIL_FAST_IF((waitResult - WAIT_OBJECT_0) >= ARRAYSIZE(waitHandles));

if (waitResult == WAIT_OBJECT_0)

{

// The lost event was signaled - return 'false' to the caller to indicate that

// the presentation manager was lost.

return false;

}

return true;

}

Esempio 14: annullamento dei regali pianificati per il futuro

Le applicazioni multimediali che presentano in modo approfondito per il futuro potrebbero decidere di annullare i regali rilasciati in precedenza. Ciò può verificarsi, ad esempio, se l'applicazione riproduce un video, ha generato un numero elevato di fotogrammi per il futuro e l'utente decide di sospendere la riproduzione video. In questo caso, l'applicazione vuole attenersi al frame corrente e annullare eventuali fotogrammi futuri che non sono ancora stati accodati. Ciò può verificarsi anche se un'applicazione multimediale decide di spostare la riproduzione in un punto diverso nel video. In questo caso, l'applicazione vuole annullare tutti i regali che non sono ancora stati accodati per la posizione precedente nel video e sostituirli con i regali per la nuova posizione. In questo caso, dopo aver annullato le presentazione precedenti, l'applicazione può rilasciare nuovi regali in futuro corrispondenti al nuovo punto nel video.

Esempio di C++

void PresentCancelExample(

_In_ IPresentationManager* pPresentationManager,

_In_ UINT64 firstPresentIDToCancelFrom)

{

// Assume we've issued a number of presents in the future. Something happened in the app, and

// we want to cancel the issued presents that occur after a specified time or present ID. This

// may happen, for example, when the user pauses playback from inside a media application. The

// application will want to cancel all presents posted targeting beyond the pause time. The

// cancel will apply to all previously posted presents whose present IDs are at least

// 'firstPresentIDToCancelFrom'. Note that Present IDs are always unique, and never recycled,

// so even if a present is canceled, no subsequent present will ever reuse its present ID.

//

// Also note that if some presents we attempt to cancel can't be canceled because they've

// already started queueing, then no error will be returned, they simply won't be canceled as

// requested. Cancelation takes a "best effort" approach.

FAIL_FAST_IF_FAILED(pPresentationManager->CancelPresentsFrom(firstPresentIDToCancelFrom));

// In the case where the media application scrubbed to a different position in the video, it may now

// choose to issue new presents to replace the ones canceled. This is not illustrated here, but

// previous examples that demonstrate presentation show how this may be achieved.

}

Esempio 15: operazione di ridimensionamento del buffer sfalsato per migliorare le prestazioni

Questo esempio illustra come l'applicazione può ridimensionare il buffer per migliorare le prestazioni rispetto a DXGI. Ricordare l'esempio di ridimensionamento precedente, in cui un client del servizio di streaming di film vuole modificare la risoluzione della riproduzione da 720p a 1080p. In DXGI, l'applicazione eseguirà un'operazione di ridimensionamento sulla porta di scambio DXGI, che genera in modo atomico tutti i buffer precedenti e rialloca tutti i nuovi buffer da 1080p contemporaneamente e li aggiunge alla swapchain. Questo tipo di ridimensionamento atomico dei buffer è costoso e può richiedere molto tempo e causare glitch. La nuova API offre un controllo più corretto sui singoli buffer di presentazione. Di conseguenza, i buffer possono essere riallocati e sostituiti uno per uno tra più presenta per suddividere il carico di lavoro nel tempo. Questo ha un impatto minore su qualsiasi presente ed è molto meno probabile che causi glitch. Essenzialmente, per un gestore di presentazioni con n buffer di presentazione, per 'n' presenta, l'applicazione può rimuovere un buffer di presentazione precedente alle dimensioni precedenti, allocare un nuovo buffer di presentazione alle nuove dimensioni e presentarlo. Dopo la presentazione di 'n', tutti i buffer saranno alle nuove dimensioni.

Esempio di C++

bool StaggeredResizeExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ IPresentationSurface* pPresentationSurface,

_In_ vector<com_ptr_failfast<ID3D11Texture2D>> textures,

_In_ vector<com_ptr_failfast<IPresentationBuffer>> presentationBuffers)

{

// Track a time we'll be presenting to below. Default to the current time, then increment by

// 1/10th of a second every present.

SystemInterruptTime presentTime;

QueryInterruptTimePrecise(&presentTime.value);

// Assume textures/presentationBuffers vector contains 10 100x100 buffers, and we want to resize

// our swapchain to 200x200. Instead of reallocating 10 200x200 buffers all at once,

// like DXGI does today, we can stagger the reallocation across multiple presents. For

// each present, we can allocate one buffer at the new size, and replace one old buffer

// at the old size with the new one at the new size. After 10 presents, we will have

// reallocated all our buffers, and we will have done so in a manner that's much less

// likely to produce delays or glitches.

constexpr UINT numberOfBuffers = 10;

for (UINT bufferIndex = 0; bufferIndex < numberOfBuffers; bufferIndex++)

{

// Advance our present time 1/10th of a second in the future.

presentTime.value += 1'000'000;

// Release the old texture/presentation buffer at the presented index.

auto& replacedTexture = textures[bufferIndex];

auto& replacedPresentationBuffer = presentationBuffers[bufferIndex];

replacedTexture.reset();

replacedPresentationBuffer.reset();

// Create a new texture/presentation buffer in its place.

AddNewPresentationBuffer(

pD3D11Device,

pPresentationManager,

200, // Buffer width

200, // Buffer height

&replacedTexture,

&replacedPresentationBuffer);

// Draw red to the new texture.

DrawColorToSurface(

pD3D11Device,

replacedTexture,

1.0f, // red

0.0f, // green

0.0f); // blue

// Bind the presentation buffer to the presentation surface.

pPresentationSurface->SetBuffer(replacedPresentationBuffer.get());

// Present at the targeted time.

pPresentationManager->SetTargetTime(presentTime);

HRESULT hrPresent = pPresentationManager->Present();

if (hrPresent == PRESENTATION_ERROR_LOST)

{

// Our presentation manager has been lost. Return 'false' to the caller to indicate that

// the presentation manager should be recreated.

return false;

}

else

{

FAIL_FAST_IF_FAILED(hrPresent);

}

}

return true;

}

Esempio 16: lettura ed elaborazione delle statistiche

I report dell'API presentano statistiche per ogni presente inviato. A livello generale, presentare le statistiche è un meccanismo di feedback che descrive come un particolare presente è stato elaborato o mostrato dal sistema. Esistono diversi tipi di statistiche che l'applicazione può registrare per ricevere e l'infrastruttura delle statistiche nell'API stessa è destinata a essere espandibile, quindi è possibile aggiungere altri tipi di statistiche in futuro. Questa API descrive come leggere le statistiche e descrive i tipi di statistiche definiti oggi e le informazioni che trasmettono a un livello elevato.

Esempio di C++

// This is an identifier we'll assign to our presentation surface that will be used to reference that

// presentation surface in statistics. This is to avoid referring to a presentation surface by pointer

// in a statistics structure, which has unclear refcounting and lifetime semantics.

static constexpr UINT_PTR myPresentedContentTag = 12345;

bool StatisticsExample(

_In_ ID3D11Device* pD3D11Device,

_In_ IPresentationManager* pPresentationManager,

_In_ IPresentationSurface* pPresentationSurface,

_In_ vector<com_ptr_failfast<ID3D11Texture2D>>& textures,

_In_ vector<com_ptr_failfast<IPresentationBuffer>>& presentationBuffers)

{

// Track a time we'll be presenting to below. Default to the current time, then increment by

// 1/10th of a second every present.

SystemInterruptTime presentTime;

QueryInterruptTimePrecise(&presentTime.value);

// Register to receive 3 types of statistics.

FAIL_FAST_IF_FAILED(pPresentationManager->EnablePresentStatisticsKind(

PresentStatisticsKind_CompositionFrame,

true));

FAIL_FAST_IF_FAILED(pPresentationManager->EnablePresentStatisticsKind(

PresentStatisticsKind_PresentStatus,

true));

FAIL_FAST_IF_FAILED(pPresentationManager->EnablePresentStatisticsKind(

PresentStatisticsKind_IndependentFlipFrame,

true));

// Stats come back referencing specific presentation surfaces. We assign 'tags' to presentation

// surfaces in the API that statistics will use to reference the presentation surface in a

// statistic.

pPresentationSurface->SetTag(myPresentedContentTag);

// Build an array of events that we can wait on.

vector<unique_event> waitEvents;

// The lost event will be the first event in our list. This is an event that signifies that

// something went wrong in the system (due to extreme conditions like memory pressure, or

// driver issues) that indicate that the presentation manager has been lost, and should no

// longer be used, and instead should be recreated.

unique_event lostEvent;

FAIL_FAST_IF_FAILED(pPresentationManager->GetLostEvent(&lostEvent));

waitEvents.emplace_back(std::move(lostEvent));

// The statistics event will be the second event in our list. This event will be signaled

// by the presentation manager when there are statistics to read back.

unique_event statisticsEvent;

FAIL_FAST_IF_FAILED(pPresentationManager->GetPresentStatisticsAvailableEvent(&statisticsEvent));

waitEvents.emplace_back(std::move(statisticsEvent));

// Add each buffer's available event to the list of events we will be waiting on.

for (UINT bufferIndex = 0; bufferIndex < presentationBuffers.size(); bufferIndex++)

{

unique_event availableEvent;

presentationBuffers[bufferIndex]->GetAvailableEvent(&availableEvent);

waitEvents.emplace_back(std::move(availableEvent));

}

// Iterate our workflow 120 times.

constexpr UINT iterationCount = 120;

for (UINT i = 0; i < iterationCount; i++)

{

// Wait for an event to be signaled.

DWORD waitResult = WaitForMultipleObjects(

static_cast<UINT>(waitEvents.size()),

reinterpret_cast<HANDLE*>(waitEvents.data()),

FALSE,

INFINITE);

// Failfast if the wait hit an error.

FAIL_FAST_IF((waitResult - WAIT_OBJECT_0) >= waitEvents.size());

// Our lost event was the first event in the array. If this is signaled, then the caller

// should recreate the presentation manager. This is very similar to how Direct3D devices

// can be lost. Assume our caller knows to handle this return value appropriately.

if (waitResult == WAIT_OBJECT_0)

{

return false;

}

// The second event in the array is the statistics event. If this event is signaled,

// read and process our statistics.

if (waitResult == (WAIT_OBJECT_0 + 1))

{

StatisticsExample_ProcessStatistics(pPresentationManager);

}

// Otherwise, the event corresponds to a buffer available event that is signaled.

// Compute the buffer for the available event that was signaled and present a

// frame.

else

{

DWORD bufferIndex = waitResult - (WAIT_OBJECT_0 + 2);

// Draw red to the texture.

DrawColorToSurface(

pD3D11Device,

textures[bufferIndex],

1.0f, // red

0.0f, // green

0.0f); // blue

// Bind the texture to the presentation surface.

pPresentationSurface->SetBuffer(presentationBuffers[bufferIndex].get());

// Advance our present time 1/10th of a second in the future.

presentTime.value += 1'000'000;

// Present at the targeted time.

pPresentationManager->SetTargetTime(presentTime);

HRESULT hrPresent = pPresentationManager->Present();

if (hrPresent == PRESENTATION_ERROR_LOST)

{

// Our presentation manager has been lost. Return 'false' to the caller to indicate that

// the presentation manager should be recreated.

return false;

}

else

{

FAIL_FAST_IF_FAILED(hrPresent);

}

}

}

return true;

}

void StatisticsExample_ProcessStatistics(

_In_ IPresentationManager* pPresentationManager)

{

// Dequeue a single present statistics item. This will return the item

// and pop it off the queue of statistics.

com_ptr_failfast<IPresentStatistics> presentStatisticsItem;

pPresentationManager->GetNextPresentStatistics(&presentStatisticsItem);

// Read back the present ID this corresponds to.

UINT64 presentId = presentStatisticsItem->GetPresentId();

UNREFERENCED_PARAMETER(presentId);

// Switch on the type of statistic this item corresponds to.

switch (presentStatisticsItem->GetKind())

{

case PresentStatisticsKind_PresentStatus:

{

// Present status statistics describe whether a given present was queued for display,

// skipped due to some future present being a better candidate to display on a given

// frame, or canceled via the API.

auto presentStatusStatistics = presentStatisticsItem.query<IPresentStatusStatistics>();

// Read back the status

PresentStatus status = presentStatusStatistics->GetPresentStatus();

UNREFERENCED_PARAMETER(status);

// Possible values for status:

// PresentStatus_Queued

// PresentStatus_Skipped

// PresentStatus_Canceled;

// Depending on the status returned, your application can adjust their workflow

// accordingly. For example, if your application sees that a large percentage of their

// presents are skipped, it means they are presenting more frames than the system can

// display. In such a case, your application might decided to lower the rate at which

// you present frames.

}

break;

case PresentStatisticsKind_CompositionFrame:

{

// Composition frame statistics describe how a given present was used in a DWM frame.

// It includes information such as which monitors displayed the present, whether the

// present was composed or directly scanned out via an MPO plane, and rendering

// properties such as what transforms were applied to the rendering. Composition

// frame statistics are not issued for iflip presents - only for presents issued by the

// compositor. iflip presents have their own type of statistic (described next).

auto compositionFrameStatistics =

presentStatisticsItem.query<ICompositionFramePresentStatistics>();

// Stats should come back for the present statistics item that we tagged earlier.

NT_ASSERT(compositionFrameStatistics->GetContentTag() == myPresentedContentTag);

// The composition frame ID indicates the DWM frame ID that the present was used

// in.

CompositionFrameId frameId = compositionFrameStatistics->GetCompositionFrameId();

// Get the display instance array to indicate which displays showed the present. Each

// instance of the presentation surface will have an entry in this array. For example,

// if your application adds the same presentation surface to four different visuals in the

// visual tree, then each instance in the tree will have an entry in the display instance

// array. Similarly, if the presentation surface shows up on multiple monitors, then each

// monitor instance will be accounted for in the display instance array that is

// returned.

//

// Note that the pointer returned from GetDisplayInstanceArray is valid for the

// lifetime of the ICompositionFramePresentStatistics. Your application must not attempt

// to read this pointer after the ICompositionFramePresentStatistics has been released

// to a refcount of 0.

UINT displayInstanceArrayCount;

const CompositionFrameDisplayInstance* pDisplayInstances;

compositionFrameStatistics->GetDisplayInstanceArray(

&displayInstanceArrayCount,

&pDisplayInstances);

for (UINT i = 0; i < displayInstanceArrayCount; i++)

{

const auto& displayInstance = pDisplayInstances[i];

// The following are fields that are available in a display instance.

// The LUID, VidPnSource, and unique ID of the output and its owning

// adapter. The unique ID will be bumped when a LUID/VidPnSource is

// recycled. Applications should use the unique ID to determine when

// this happens so that they don't try and correlate stats from one

// monitor with another.

displayInstance.outputAdapterLUID;

displayInstance.outputVidPnSourceId;

displayInstance.outputUniqueId;

// The instanceKind field indicates how the present was used. It

// indicates that the present was composed (rendered to DWM's backbuffer),

// scanned out (via MPO/DFlip) or composed to an intermediate buffer by DWM

// for effects.

displayInstance.instanceKind;

// The finalTransform field indicates the transform at which the present was

// shown in world space. It will include all ancestor visual transforms and

// can be used to know how it was rendered in the global visual tree.

displayInstance.finalTransform;

// The requiredCrossAdapterCopy field indicates whether or not we needed to

// copy your application's buffer to a different adapter in order to display

// it. Applications should use this to determine whether or not they should

// reallocate their buffers onto a different adapter for better performance.

displayInstance.requiredCrossAdapterCopy;

// The colorSpace field indicates the colorSpace of the output that the

// present was rendered to.

displayInstance.colorSpace;

// For example, if your application sees that the finalTransform is scaling your

// content by 2x, you might elect to pre-render that scale into your presentation

// surface, and then add a 1/2 scale. At which point, the finalTransform should

// be 1x, and some MPO hardware will be more likely to MPO a presentation surface

// with a 1x scale applied, since some hardware has a maximum they are able to

// scale in an MPO plane. Similarly, if your application's content is being scaled

// down on screen, you may wish to simply render its content at a

// smaller scale to conserve resources, and apply an enlargement transform.

}

// Additionally, we can use the CompositionFrameId reported by the statistic

// to query timing-related information about that specific frame via the new

// composition timing API, such as when that frame showed up on screen.

// Note this is achieved using a separate API from the composition swapchain API, but

// using the composition frame ID reported in the composition swapchain API to

// properly specify which frame your application wants timing information from.

COMPOSITION_FRAME_TARGET_STATS frameTargetStats;

COMPOSITION_TARGET_STATS targetStats[4];

frameTargetStats.targetCount = ARRAYSIZE(targetStats);

frameTargetStats.targetStats = targetStats;

// Specify the frameId that we got from stats in order to pass to the call

// below and retrieve timing information about that frame.

frameTargetStats.frameId = frameId;

FAIL_FAST_IF_FAILED(DCompositionGetTargetStatistics(1, &frameTargetStats));

// If the frameTargetStats comes back with a 0 frameId, it means the frame isn't

// part of statistics. This might mean that it has expired out of

// DCompositionGetTargetStatistics history, but that call keeps a history buffer

// roughly equivalent to ~5 seconds worth of frame history, so if your application

// is processing statistics from the presentation manager relatively regularly,

// by all accounts it shouldn't worry about DCompositionGetTargetStatistics

// history expiring. The more likely scenario when this occurs is that it's too

// early, and that this frame isn't part of statistics YET. In that case, your application

// should defer processing for this frame, and try again later. For the purposes

// if sample brevity, we don't bother trying again here. A good method to use would

// be to add this present info to a list of presents that we haven't gotten target

// statistics for yet, and try again for all presents in that list any time we get

// a new PresentStatisticsKind_CompositionFrame for a future frame.

if (frameTargetStats.frameId == frameId)

{

// The targetCount will represent the count of outputs the given frame

// applied to.

frameTargetStats.targetCount;

// The targetTime corresponds to the wall clock QPC time DWM was

// targeting for the frame.

frameTargetStats.targetTime;

for (UINT i = 0; i < frameTargetStats.targetCount; i++)

{

const auto& targetStat = frameTargetStats.targetStats[i];

// The present time corresponds to the targeted present time of the composition

// frame.

targetStat.presentTime;

// The target ID corresponds to the LUID/VidPnSourceId/Unique ID for the given

// target.

targetStat.targetId;

// The completedStats convey information about the time a compositor frame was

// completed, which marks the time any of its associated composition swapchain API

// presents entered the displayed state. In particular, your application might wish