Azure AI Foundry Models には、Azure によって直接販売されるモデルと 、パートナーとコミュニティのモデルという 2 つのカテゴリに分類されたモデルの包括的なカタログが含まれています。 マネージド コンピューティングでのデプロイに使用できるパートナーとコミュニティのこれらのモデルは、開いているモデルまたは保護されたモデルのいずれかです。 この記事では、Azure Marketplace を介して提供されるパートナーとコミュニティから保護されたモデルを使用して、従量課金制のマネージド コンピューティングにデプロイする方法について説明します。

[前提条件]

有効な支払い方法を持つ Azure サブスクリプション。 無料または試用版の Azure サブスクリプションは機能しません。 Azure サブスクリプションを持っていない場合は、始めるために有料の Azure アカウントを作成してください。

持っていない場合は、ハブ ベースのプロジェクトを作成します。

Azure AI Foundry ポータルでの操作に対するアクセス権を付与するには、Azure ロールベースのアクセス制御 (Azure RBAC) を使用します。 この記事の手順を実行するには、ユーザー アカウントに次のアクセス許可を持つ カスタム ロール を割り当てる必要があります。 Azure サブスクリプションの 所有者 ロールまたは 共同作成者 ロールが割り当てられているユーザー アカウントでも、デプロイを作成できます。 アクセス許可について詳しくは、「Azure AI Foundry ポータルでのロールベースのアクセス制御」をご覧ください。

Azure サブスクリプションで、 ワークスペース/プロジェクトを Azure Marketplace オファリングにサブスクライブするには、次の手順を実行します。

- Microsoft.MarketplaceOrdering/agreements/offers/plans/read

- Microsoft.Marketplace注文/契約/オファー/プラン/署名/アクション

- Microsoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/read

- Microsoft.Marketplace/offerTypes/publishers/offers/plans/agreements/read

- Microsoft.SaaS/register/action

リソース グループで、 SaaS リソースを作成して使用するには、次の手順を実行します。

- Microsoft.SaaS/resources/read

- Microsoft.SaaS/resources/write

ワークスペースでエンドポイント をデプロイするには:

- Microsoft.MachineLearningServices/workspaces/marketplaceModelSubscriptions/*

- Microsoft.MachineLearningServices/workspaces/onlineEndpoints/*

Azure Marketplace オファーのサブスクリプションスコープと測定単位

Azure AI Foundry を使用すると、専用のモデル デプロイを大規模に作成して使用するときに、保護されたモデルのシームレスなサブスクリプションとトランザクション エクスペリエンスを実現できます。 マネージド コンピューティングでの保護されたモデルのデプロイには、顧客に対する従量課金制の 2 つのディメンションが含まれます。

- デプロイで使用される仮想マシンに対する 1 時間あたりの Azure Machine Learning コンピューティングの課金。

- Azure Marketplace のオファーでモデルの発行元が設定したモデルに対する追加料金の請求。

Azure コンピューティングとモデルの追加料金の従量課金は、マネージド オンライン デプロイのアップタイムに基づいて分単位で評価されます。 モデルの追加料金は、Azure AI Foundry マネージド コンピューティングにモデルをデプロイするために使用できる、サポートされているすべての GPU について、パートナー (またはモデルの発行元) が Azure Marketplace で設定した GPU 時間あたりの価格です。

Azure Marketplace の提供へのユーザーのサブスクリプションは、Azure AI Foundry 内のプロジェクト リソースに制約されています。 特定のモデルの Azure Marketplace オファーのサブスクリプションがプロジェクト内に既に存在する場合、ユーザーはデプロイ ウィザードで、プロジェクトのサブスクリプションが既に存在することを通知されます。

Azure サブスクリプションに存在するすべての SaaS サブスクリプションを検索するには:

Azure portal にサインインし、Azure サブスクリプションに移動します。

[ サブスクリプション] を選択し、Azure サブスクリプションを選択して概要ページを開きます。

[設定]>リソースを選択してリソースの一覧を表示します。

種類フィルターを使用して、SaaS リソースの種類を選択します。

従量課金ベースの追加料金は、関連付けられている SaaS サブスクリプションに発生し、Azure Marketplace 経由でユーザーに課金されます。 請求書は、それぞれの SaaS サブスクリプションの [概要 ] タブで確認できます。

マネージド コンピューティングでの登録と展開

Azure AI Foundry にサインインします。

まだプロジェクトを開いていない場合は選びます。

左側のウィンドウから [モデル カタログ ] を選択します。

モデル カタログで [デプロイ オプション ] フィルターを選択し、[ マネージド コンピューティング] を選択します。

選択した コレクション とモデルを選択して、一覧をさらにフィルター処理します。 この記事では、サポートされているモデルの一覧から Cohere Command A を使用して説明します。

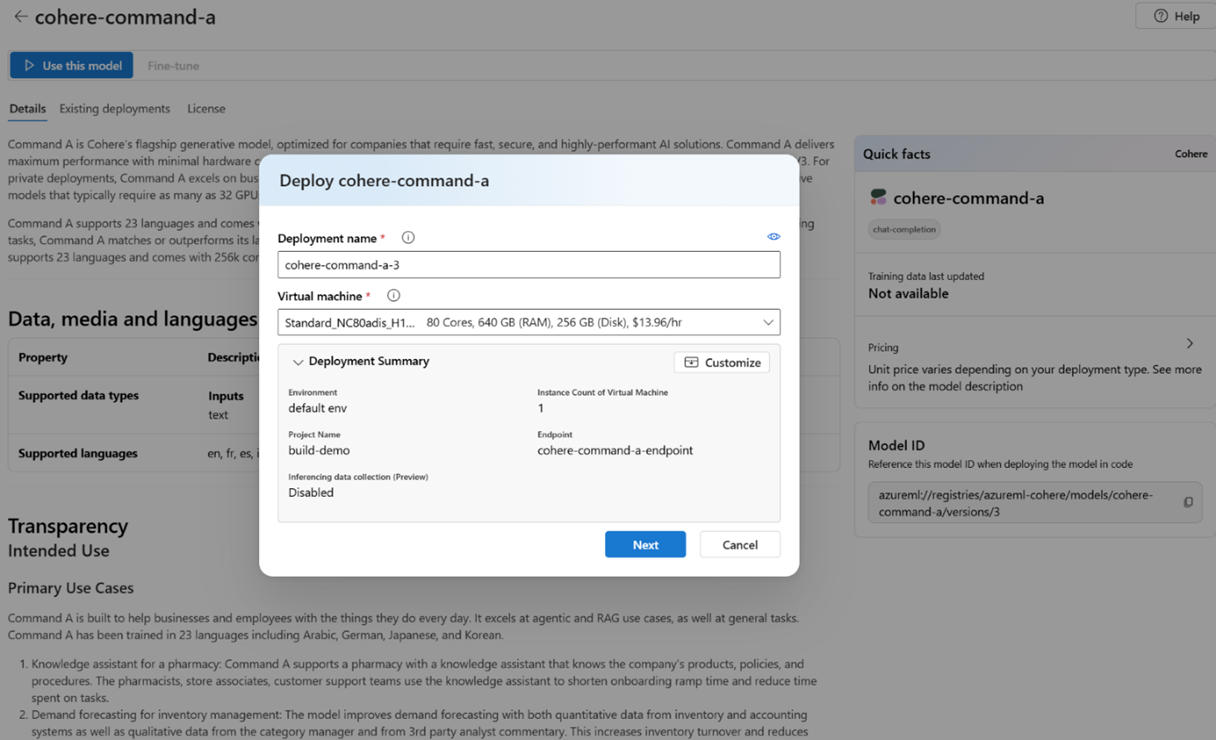

モデルのページで、[ このモデルを使用する ] を選択してデプロイ ウィザードを開きます。

モデルでサポートされている VM SKU のいずれかを選択します。 Azure サブスクリプションでその SKU の Azure Machine Learning コンピューティング クォータが必要です。

[ カスタマイズ ] を選択して、インスタンス数などのパラメーターのデプロイ構成を指定します。 デプロイ用の既存のエンドポイントを選択したり、新しいエンドポイントを作成したりすることもできます。 この例では、インスタンス数 1 を指定し、デプロイ用の新しいエンドポイントを作成します。

[ 次へ ] を選択して 、価格の内訳 ページに進みます。

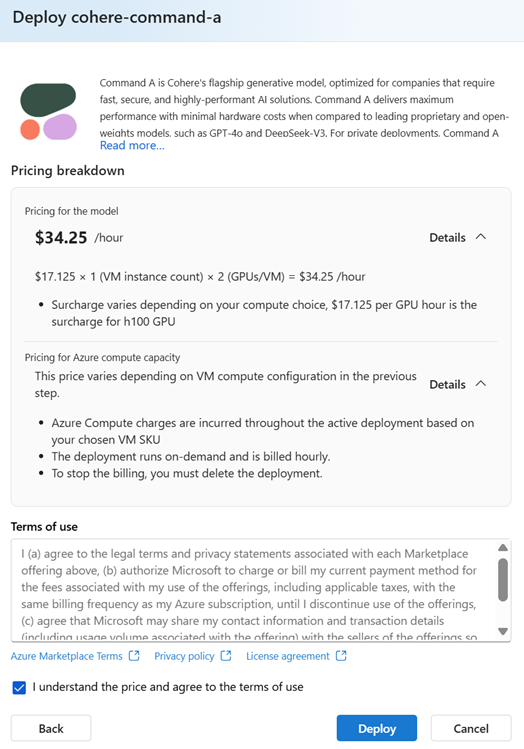

Azure Marketplace でのモデルのオファーに関連付けられているデプロイ、使用条件、およびライセンス契約の価格の内訳を確認します。 価格の内訳は、デプロイされたモデルの集計価格を示します。モデルの追加料金は、前の手順で選択した VM インスタンス内の GPU の数の関数です。 モデルに適用される追加料金に加えて、デプロイ構成に基づいて Azure コンピューティング料金も適用されます。 既存の予約または Azure の節約プランがある場合、コンピューティング料金の請求書が優先され、割引された VM の価格が反映されます。

チェック ボックスをオンにして、使用条件を理解し、同意したことを確認します。 次に、[ デプロイ] を選択します。 Azure AI Foundry は、マーケットプレース オファーに対するユーザーのサブスクリプションを作成し、マネージド コンピューティングにモデルのデプロイを作成します。 デプロイが完了するまでに約 15 ~ 20 分かかります。

展開のネットワークの分離

モデル カタログ内のコレクションは、ワークスペースマネージド仮想ネットワークを使用して、分離されたネットワーク内にデプロイできます。 ワークスペースのマネージド ネットワークを構成する方法の詳細については、「 インターネット送信を許可するようにマネージド仮想ネットワークを構成する」を参照してください。

制限事項

イングレス パブリック ネットワーク アクセスが無効になっている Azure AI Foundry プロジェクトでは、カタログから保護されたモデルの 1 つのアクティブなデプロイのみをサポートできます。 よりアクティブなデプロイを作成しようとすると、デプロイの作成エラーが発生します。

従量課金制のマネージド コンピューティング デプロイでサポートされているモデル

| 徴収 | モデル | 課題 |

|---|---|---|

| Paige AI | Virchow2G | 画像特徴抽出 |

| Paige AI | Virchow2G-Mini | 画像特徴抽出 |

| コヒア | コマンド A | チャット完了 |

| コヒア | Embed v4 | 埋め込み |

| コヒア | Rerank v3.5 | テキスト分類 |

| エヌビディア | Llama-3.3-Nemotron-Super-49B-v1-NIM-microservice | チャット完了 |

| エヌビディア | Llama-3.1-Nemotron-Nano-8B-v1-NIM-microservice | チャット完了 |

| エヌビディア | Deepseek-R1-Distill-Llama-8B-NIM-microservice | チャット完了 |

| エヌビディア | Llama-3.3-70B-Instruct-NIM-microservice | チャット完了 |

| エヌビディア | Llama-3.1-8B-Instruct-NIM-microservice | チャット完了 |

| エヌビディア | Mistral-7B-Instruct-v0.3-NIM-microservice | チャット完了 |

| エヌビディア | Mixtral-8x7B-Instruct-v0.1-NIM-microservice | チャット完了 |

| エヌビディア | Llama-3.2-NV-embedqa-1b-v2-NIM-microservice | 埋め込み |

| エヌビディア | Llama-3.2-NV-rerankqa-1b-v2-NIM-microservice | テキスト分類 |

| エヌビディア | Openfold2-NIM-microservice | タンパク質バインダー |

| エヌビディア | ProteinMPNN-NIM-microservice | タンパク質バインダー |

| エヌビディア | MSA-search-NIM-microservice | タンパク質バインダー |

| エヌビディア | Rfdiffusion-NIM-microservice | タンパク質バインダー |