Databricks Foundation Model API

この記事では、Azure Databricks の Foundation Model API の概要について説明します。 使用要件、サポートされているモデル、制限事項などが含まれます。

Databricks Foundation Model API とは

Databricks Model Serving は、サービス エンドポイントから最先端のオープン モデルにアクセスしてクエリを実行できる Foundation Model API をサポートするようになりました。 Foundation Model API を使うと、独自のモデル デプロイを保守することなく、高品質の生成 AI モデルを利用するアプリケーションを迅速かつ簡単に構築できます。

Foundation Model API は、次の 2 つの価格モードで提供されます。

- トークン単位の支払い: これは Databricks で Foundation Models にアクセスする最も簡単な方法であり、Foundation Models API を使い始めるユーザーにお勧めします。 このモードは、高スループットのアプリケーションやパフォーマンスの高い運用ワークロード向けに設計されていません。

- プロビジョニング済みスループット: このモードは、すべての運用ワークロード、特に高スループット、パフォーマンスの保証、微調整されたモデル、または追加のセキュリティ要件を必要とするワークロードに推奨されます。 プロビジョニングされたスループット エンドポイントは、HIPAA などのコンプライアンス認定で利用できます。

これら 2 つのモードの使用方法とサポートされているモデルのガイダンスについては、「基盤モデル API の使用」を参照してください。

Foundation Model API を使用すると、次のことができます:

- リソースを増やす前に、汎用 LLM のクエリを実行してプロジェクトの有効性を確認する。

- カスタム モデルのトレーニングとデプロイに投資する前に、LLM ベースのアプリケーションの簡単な概念実証を作成するために、汎用 LLM のクエリを実行する。

- 基礎モデルとベクトル データベースを使い、検索拡張生成 (RAG) を使ってチャットボットを構築する。

- 独自のモデルをオープンの代替手段に置き換えて、コストとパフォーマンスを最適化する。

- LLM を効率よく比較して、ユース ケースに最適な候補を確認したり、運用モデルをさらにパフォーマンスの高いものに入れ替えたりする。

- 運用トラフィックの急増に対応できるスケーラブルで SLA によって支えられた LLM サービス ソリューションを基にして、開発または運用のための LLM アプリケーションを構築する。

要件

- エンドポイントへの要求を認証するための Databricks API トークン。

- サーバーレス コンピューティング (プロビジョニングされたスループット モデルの場合)

- サポートされているリージョン内のワークスペース:

Note

DBRX 基本モデルを使用するプロビジョニング済みスループット ワークロードについては、「Foundation Model API の制限」のリージョン可用性を参照してください。

Foundation Model API を使う

Foundation Model API を使用するには、複数のオプションがあります。

これらの API は OpenAI と互換性があるため、OpenAI クライアントを使用してクエリを実行することもできます。 さらに、UI、Foundation Models API の Python SDK、MLflow Deployments SDK、または REST API を使用して、サポートされているモデルに対するクエリを実行することもできます。 Databricks では、拡張操作には MLflow Deployments SDK または REST API を使い、機能を試す場合は UI を使うことをお勧めしています。

スコアリングの例については、「基盤モデルのクエリ」を参照してください。

Foundation Model API のトークン単位の支払い

重要

この機能はパブリック プレビュー段階にあります。

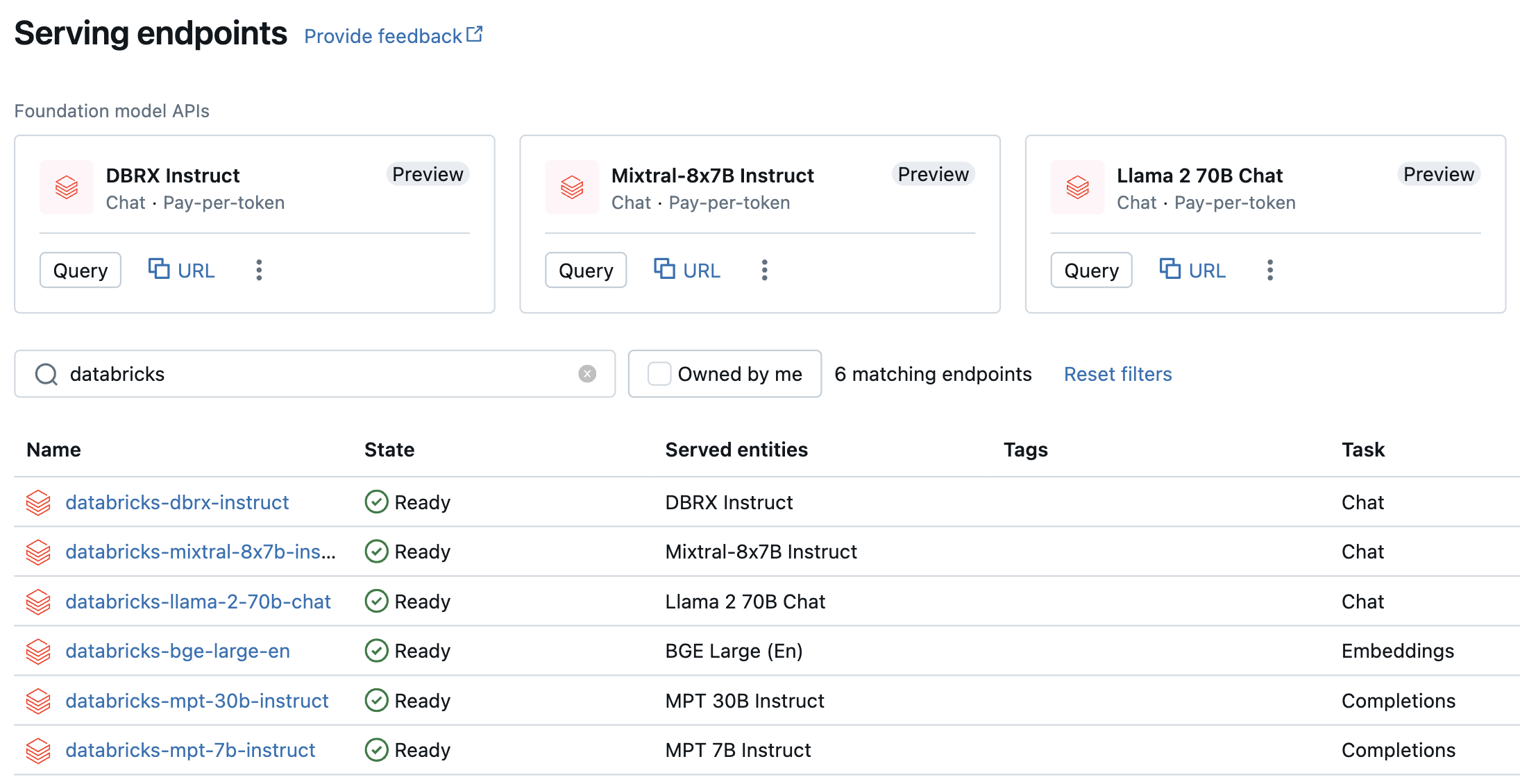

トークン単位の支払いモデルには、Azure Databricks ワークスペースからアクセスでき、作業を開始するために推奨されます。 ワークスペースで Foundation Model API にアクセスするには、左側のサイドバーの [Serving] (提供) タブに移動します。 Foundation Model API は、エンドポイント リスト ビューの上部にあります。

次の表は、トークン単位の支払いがサポートされているモデルをまとめたものです。 その他のモデルの情報については、「トークン単位の支払いでサポートされているモデル」を参照してください。

これらのモデルをテストしてチャットする場合は、AI プレイグラウンドを使用して行うことができます。 「AI プレイグラウンドを使ってサポートされている LLM とチャットする」をご覧ください。

| モデル | タスクの種類 | エンドポイント |

|---|---|---|

| DBRX の指示 | チャット | databricks-dbrx-instruct |

| Meta-Llama-3-70B-Instruct | チャット | databricks-meta-llama-3-70b-instruct |

| Meta-Llama-2-70B-Chat | チャット | databricks-llama-2-70b-chat |

| Mixtral-8x7B 指示 | チャット | databricks-mixtral-8x7b-instruct |

| MPT 7B Instruct | 完了 | databricks-mpt-7b-instruct |

| MPT 30B Instruct | 完了 | databricks-mpt-30b-instruct |

| BGE Large (英語版) | 埋め込み | databricks-bge-large-en |

- Foundation Model API のクエリ方法のガイダンスについては、「基盤モデルのクエリ」を参照してください。

- 必要なパラメーターと構文については、「基盤モデル REST API リファレンス」を参照してください。

プロビジョニング スループット Foundation Model API

プロビジョニング済みスループットは一般提供されており、Databricks では運用環境のワークロードに対してプロビジョニング済みスループットが推奨されます。 プロビジョニング スループットは、パフォーマンス保証を必要とするワークロードの基盤モデル向けに最適化された推論をエンドポイントに提供します。 Foundation Model API をプロビジョニング スループット モードでデプロイする方法のステップバイステップ ガイドについては、「プロビジョニング スループット Foundation Model API」を参照してください。

プロビジョニングされたスループットのサポートには、以下が含まれます。

- すべてのサイズのベース モデル。DBRX ベースなど。 ベース モデルは、Databricks Marketplace を使用してアクセスするか、Hugging Face または他の外部ソースからダウンロードして Unity Catalog に登録できます。 後者のアプローチは、採用されている微調整方法に関係なく、サポートされているモデルのどの微調整されたバリアントでも機能します。

- 微調整されたベース モデルのバリエーション。LlamaGuard-7B など。 これには、専用データ上で微調整されたモデルが含まれます。

- 完全カスタムの重みとトークナイザー。ゼロからトレーニングされたもの、継続的に事前トレーニングされたもの、その他のベース モデル アーキテクチャを使用するバリエーション (例: CodeLlama、Yi-34B-Chat、SOLAR-10.7B など)。

次の表は、プロビジョニングされたスループットでサポートされているモデル アーキテクチャをまとめたものです。

| モデルのアーキテクチャ | タスクの種類 | メモ |

|---|---|---|

| DBRX | Chat または Completion | リージョンの可用性については、「Foundation Model API の制限」を参照してください。 |

| Meta Llama 3 | Chat または Completion | |

| Meta Llama 2 | Chat または Completion | |

| ミストラル | Chat または Completion | |

| Mixtral | Chat または Completion | |

| MPT | Chat または Completion | |

| BGE v1.5 (英語) | 埋め込み |

制限事項

「モデル提供の制限とリージョン」を参照してください。

その他のリソース

フィードバック

以下は間もなく提供いたします。2024 年を通じて、コンテンツのフィードバック メカニズムとして GitHub の issue を段階的に廃止し、新しいフィードバック システムに置き換えます。 詳細については、「https://aka.ms/ContentUserFeedback」を参照してください。

フィードバックの送信と表示