Azure IoT Data Processor プレビュー パイプラインを使用してエッジでデータを処理する

重要

Azure Arc によって有効にされる Azure IoT Operations Preview は、 現在プレビュー段階です。 運用環境ではこのプレビュー ソフトウェアを使わないでください。

ベータ版、プレビュー版、または一般提供としてまだリリースされていない Azure の機能に適用される法律条項については、「Microsoft Azure プレビューの追加使用条件」を参照してください。

産業資産は、さまざまな形式でデータを生成し、さまざまな通信プロトコルを使用します。 このような多様なデータ ソースが、さまざまなスキーマや単位メジャーと組み合わされて使用されるため、生の産業データを効果的に使用および分析することが困難になります。 さらに、コンプライアンス、セキュリティ、パフォーマンス上の理由から、すべてのデータセットをクラウドにアップロードすることはできません。

このデータを処理するには、従来、高価で複雑、かつ時間のかかるデータ エンジニアリングが必要でした。 Azure IoT Data Processor プレビューは、産業データの複雑さと多様性を管理できる構成可能なデータ処理サービスです。 データ プロセッサを使用すれば、さまざまなソースからのデータがより理解しやすく、使いやすく、価値のあるものになります。

Azure IoT Data Processor プレビューとは

Azure IoT Data Processor プレビューは、Azure IoT Operations プレビューのコンポーネントです。 データ プロセッサを使用すると、デバイスのデータを集計、エンリッチ、正規化、フィルター処理できます。 データ プロセッサは、エッジまたはクラウドの他のサービスに送信する前に、エッジでデータを処理できるパイプライン ベースのデータ処理エンジンです。

データ プロセッサは、OPC UA サーバー、ヒストリアン、その他の産業システムなどのソースからリアルタイム ストリーミング データを取り込みます。 さまざまなデータ形式を標準化された構造化形式に変換することで、このデータを正規化します。これにより、クエリと分析が容易になります。 データ プロセッサは、データをコンテキスト化することも可能で、参照データまたは最後の既知の値 (LKV) でデータエンリッチメントを行い、産業運用の包括的なビューを提供できます。

データ プロセッサからの出力は、リアルタイム分析や分析情報ツールなどのダウンストリーム アプリケーションに対応できるクリーンでエンリッチされた標準化データです。 データ プロセッサにより、生データを実用的な分析情報に変換するために要する時間が大幅に短縮されます。

主なデータ プロセッサ機能は次のとおりです。

複数のデータ形式を標準化された構造に変換する柔軟なデータ正規化。

コンテキストを拡張し、より良い分析情報を可能にするために、参照データまたは LKV データを使用したデータ ストリームのエンリッチメント。

クリーン データの分析を簡略化するための組み込みの Microsoft Fabric 統合。

さまざまなソースからのデータを処理し、さまざまな送信先にデータを発行する機能。

データに依存しないデータ処理プラットフォームであるデータ プロセッサは、任意の形式でデータを取り込み、データを処理してから、変換先に書き出すことができます。 これらの機能をサポートするために、データ プロセッサはさまざまな形式を逆シリアル化およびシリアル化できます。 たとえば、ファイルを Microsoft Fabric に書き込むために Parquet 形式にシリアル化できます。

クラウドの宛先にデータを送信する際に一時的なエラーを処理するための自動および構成可能な再試行ポリシー。

パイプラインとは

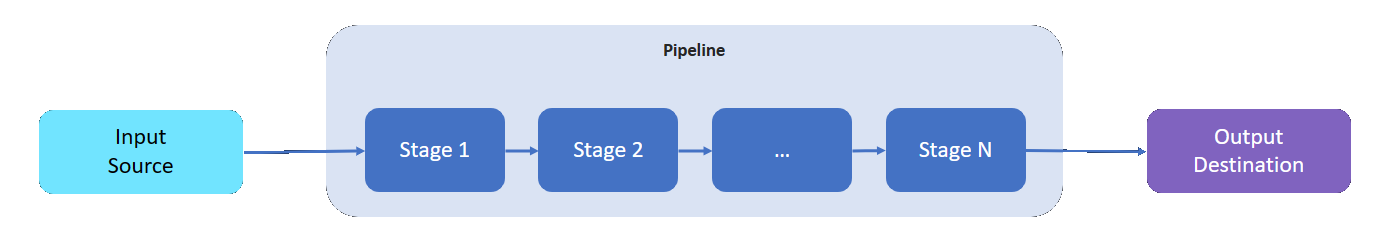

データ プロセッサ パイプラインには、データを読み取る入力ソース、処理されたデータの書き込み先、およびデータを処理するいくつかの中間ステージがあります (中間ステージの数は処理内容によって異なります)。

中間ステージは、使用可能なさまざまなデータ処理機能と言えます。

- パイプラインには、必要な数の中間ステージを追加できます。

- 必要に応じて、パイプラインの中間ステージを並べ替えることができます。 パイプラインを作成した後でステージを並べ替えることができます。

- 各ステージは、定義された実装インターフェイスと入力/出力スキーマ コントラクトに準拠します。

- 各ステージは、パイプライン内の他のステージとは独立しています。

- すべてのステージはパーティションのスコープ内で動作します。 データは、異なるパーティション間では共有されません。

- データは 1 つのステージから次のステージにのみ流れます。

データ プロセッサ パイプラインでは、以下のステージを使用できます。

| 段階 | 説明 |

|---|---|

| ソース - MQ | MQTT ブローカーからデータを取得します。 |

| ソース - HTTP エンドポイント | HTTP エンドポイントからデータを取得します。 |

| ソース - SQL | Microsoft SQL Server データベースからデータを取得します。 |

| ソース - InfluxDB | InfluxDB データベースからデータを取得します。 |

| Assert | ステージを通過するデータをフィルター処理します。 たとえば、温度が 50F-150F 範囲外のメッセージを除外します。 |

| 変換 | データの構造を正規化します。 たとえば、構造体を {"Name": "Temp", "value": 50} から {"temp": 50} に変更します。 |

| LKV | 選択したメトリック値を LKV ストアに格納します。 たとえば、温度と湿度の測定値のみを LKV に格納し、残りは無視します。 後続のステージでは、格納されている LKV データを使用してメッセージをエンリッチできます。 |

| 強化 | 参照データ ストアからのデータを使用してメッセージをエンリッチします。 たとえば、操作データセットからのオペレーター名とロット番号を追加します。 |

| 集計 | ステージを通過する値を集計します。 たとえば、温度値が 100 ミリ秒ごとに送信される場合、30 秒ごとに平均温度メトリックが出力されます。 |

| 呼び出し | 外部 HTTP または gRPC サービスを呼び出します。 たとえば、Azure 関数を呼び出して、カスタム メッセージ形式から JSON に変換します。 |

| 変換先 - MQ | 処理済みのクリーンかつコンテキスト化されたデータを MQTT トピックに書き込みます。 |

| 変換先 - 参照 | 処理されたデータを組み込みの参照ストアに書き込みます。 他のパイプラインでは、参照ストアを使用してメッセージをエンリッチできます。 |

| 変換先 - gRPC | 処理済みのクリーンかつコンテキスト化されたデータを gRPC エンドポイントに送信します。 |

| 宛先 - HTTP | 処理済みのクリーンかつコンテキスト化されたデータを HTTP エンドポイントに送信します。 |

| 変換先 - Fabric Lakehouse | 処理済みのクリーンかつコンテキスト化されたデータを、クラウド内の Microsoft Fabric Lakehouse に送信します。 |

| 変換先 - Azure Data Explorer | 処理済みのクリーンかつコンテキスト化されたデータを、クラウド内の Azure Data Explorer エンドポイントに送信します。 |

| 宛先 - Azure Blob Storage | 処理済みのクリーンかつコンテキスト化されたデータを、クラウド内の Azure Blob Storage エンドポイントに送信します。 |

次のステップ

データ プロセッサ パイプラインを試すには、「Azure IoT Operations のクイックスタート」を参照してください。

データ プロセッサの詳細については、以下をご覧ください。