モデル LLM ツールを開く

Open Model LLM ツールを使用すると、Azure Machine Learning プロンプト フローでの自然言語処理のために、 Falcon Llama 2 など、さまざまなオープン モデルと基本モデルを利用できます。

注意事項

非推奨の通知: Open Model LLM ツールは、 LLM ツールを優先して非推奨となりました。このツールは、 Azure AI モデル推論 API でサポートされているすべてのモデルをサポートするため プロバイダーの柔軟性が向上しています。

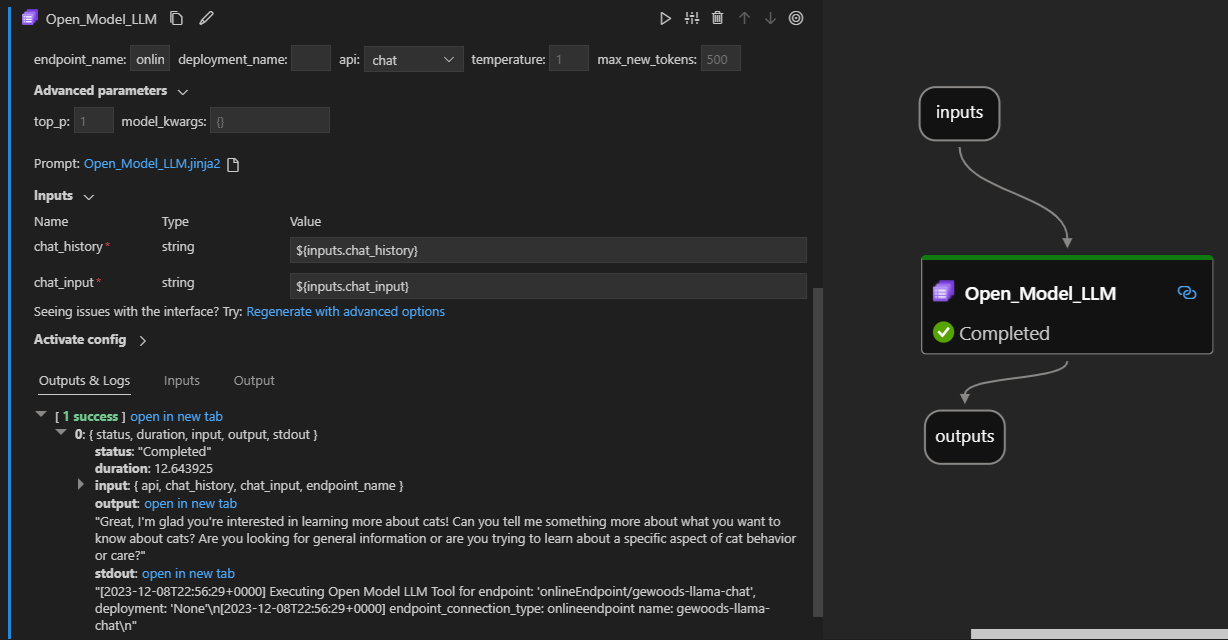

Visual Studio Code プロンプト フロー拡張機能での動作を以下に示します。 この例では、ツールを使用して LlaMa-2 チャット エンドポイントを呼び出し、"CI とは何か" と聞きます。

このプロンプト フロー ツールでは、次の 2 種類の LLM API がサポートされています。

- チャット: 前の例に示します。 チャット API の種類では、テキストベースの入力と応答を使用した対話型の会話が容易になります。

- 入力候補: 入力候補 API の種類は、指定されたプロンプト入力に基づいて単一の応答テキスト入力候補を生成するために使用されます。

概要: オープン モデル LLM ツール操作方法使用しますか?

- Azure Machine Learning モデル カタログからモデルを選択し、デプロイします。

- モデルデプロイに接続します。

- オープン モデル LLM ツールの設定を構成します。

- プロンプトを準備します。

- フローを実行します。

前提条件: モデルのデプロイ

- Azure Machine Learning モデル カタログから、シナリオに一致するモデルを選びます。

- Deploy ボタンを使用して、モデルを Azure Machine Learning オンライン推論エンドポイントにデプロイします。

- 従量課金制のデプロイ オプションのいずれかを使用します。

詳細については、「 推論のためにエンドポイントに基盤モデルをデプロイするを参照してください。

前提条件: モデルに接続する

デプロイされたモデルをプロンプト フローで使用するには、それに接続する必要があります。 接続する方法は 2 つあります。

エンドポイント接続

フローが Azure Machine Learning または Azure AI Studio ワークスペースに関連付けられると、Open Model LLM ツールはそのワークスペース上のエンドポイントを使用できます。

Azure Machine Learning または Azure AI Studio ワークスペースの使用: いずれかの Web ページ ベースのブラウザー ワークスペースでプロンプト フローを使用している場合は、そのワークスペースで自動的に稼働するオンライン エンドポイントを使用できます。

VS Code またはコードを最初に使用する: VS Code またはいずれかの Code First オファリングでプロンプト フローを使用している場合は、ワークスペースに接続する必要があります。 Open Model LLM ツールは、承認に azure.identity DefaultAzureCredential クライアントを使用します。 1 つの方法は、環境の資格情報値 設定することです。

カスタム接続

Open Model LLM ツールは CustomConnection を使用します。 プロンプト フローでは、次の 2 種類の接続がサポートされます。

ワークスペース接続 - Azure Machine Learning ワークスペースにシークレットとして格納される接続。 これらの接続は多くの場所で使用できますが、一般的に Studio UI で作成および管理されます。 Studio UI でカスタム接続を作成する方法については、「 カスタム接続を作成する方法」を参照してください。

ローカル接続 - コンピューターにローカルに格納されている接続。 これらの接続は Studio UX では使用できませんが、VS Code 拡張機能で使用できます。 ローカルのカスタム接続を作成する方法については、「 ローカル接続を作成する方法」を参照してください。

設定する必要があるキーは次のとおりです。

- endpoint_url

- この値は、以前に作成した推論エンドポイントにあります。

- endpoint_api_key

- シークレット値として設定してください。

- この値は、以前に作成した推論エンドポイントにあります。

- model_family

- サポートされている値: LLAMA、DOLLY、GPT2、または FALCON

- この値は、ターゲットとなるデプロイの種類によって異なります。

ツールの実行: 入力

Open Model LLM ツールには多くのパラメーターがあり、その一部が必要です。 詳細については、次の表を参照してください。これらのパラメーターを前のスクリーンショットと照合して、視覚的にわかりやすくすることができます。

| 名前 | 種類 | 内容 | 必須 |

|---|---|---|---|

| api | string | 使用されるモデルと選択したシナリオに依存する API モード。 ''サポートされている値'': (Completion | Chat) | はい |

| endpoint_name | string | サポートされているモデルがデプロイされているオンライン推論エンドポイントの名前。 接続よりも優先されます。 | はい |

| 温度 | float | 生成されるテキストのランダム性。 既定値は 1 です。 | いいえ |

| max_new_tokens | integer | 完了で生成されるトークンの最大数。 既定値は 500 です。 | いいえ |

| top_p | float | 生成されたトークンから一番上の選択肢を使う確率。 既定値は 1 です。 | いいえ |

| model_kwargs | ディクショナリ | この入力は、使用されるモデルに固有の構成を提供するために使用されます。 たとえば、Llama-02 モデルでは {"temperature":0.4} を使用できます。 デフォルト: {} | いいえ |

| deployment_name | string | オンライン推論エンドポイントのターゲットとなるデプロイの名前。 値が渡されない場合は、推論ロード バランサーのトラフィック設定が使用されます。 | いいえ |

| prompt | string | 言語モデルで応答を生成するために使用されるテキスト プロンプト。 | はい |

出力

| API | 戻り値の型 | 説明 |

|---|---|---|

| Completion | string | 1 つの予測される入力候補のテキスト |

| チャット | string | 会話での 1 つの応答のテキスト |

オンライン エンドポイントへのデプロイ

Open Model LLM ツールを含むフローをオンライン エンドポイントにデプロイする場合は、アクセス許可を設定するための追加の手順があります。 Web ページを介したデプロイ中に、システム割り当て ID の種類とユーザー割り当て ID の種類を選択できます。 どちらの方法でも、Azure portal (または同様の機能) を使用して、エンドポイントをホストしている Azure Machine Learning ワークスペースまたは Ai Studio プロジェクトの ID に "閲覧者" ジョブ関数ロールを追加します。 プロンプト フローのデプロイを更新する必要がある場合があります。