このガイドで行うこと:

ワークスペースでパイプラインを作成し、データを OneLake に Delta 形式で取り込みます。

Azure Databricks を使用して OneLake で Delta テーブルを読み取って、変更します。

前提条件

開始する前に、以下が必要になります:

レイクハウス項目を含むワークスペース。

Premium Azure Databricks ワークスペース。 Microsoft Entra の認証情報パススルーは、Premium Azure Databricks ワークスペースでのみサポートされています。 クラスターを作成するときに、[詳細オプション] で [Azure Data Lake Storage 資格情報のパススルー] を有効にします。

サンプル データセット。

データを取り込んで Delta テーブルを変更する

Power BI サービスでレイクハウスに移動し、[データの取得]、[新しいデータ パイプライン] の順に選択します。

![UI から [新しいデータ パイプライン] オプションを選択する方法を示すスクリーンショット。](media/onelake-open-access-quickstart/onelake-new-pipeline.png)

[新しいパイプライン] プロンプトで、新しいパイプラインの名前を入力し、[作成] を選択します。

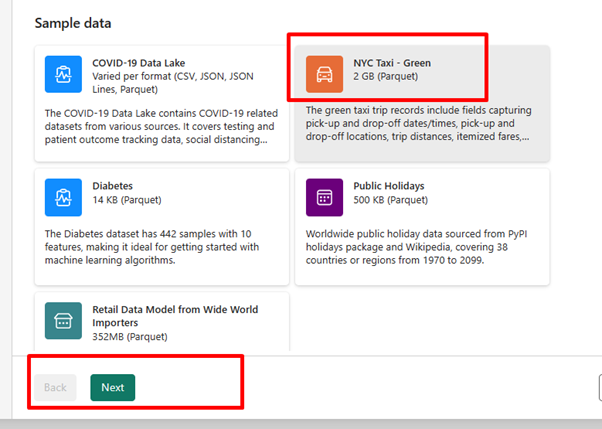

この演習では、データ ソースとして NYC Taxi - Greenサンプル データを選択し、[次へ] を選択します。

プレビュー画面で [次へ] を選択します。

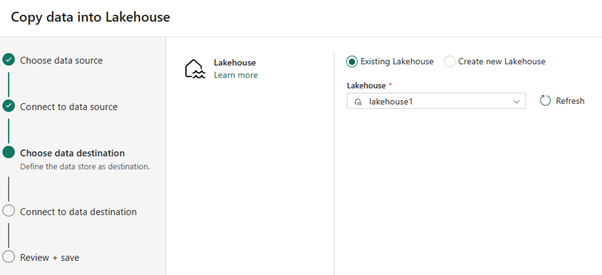

データのコピー先として、OneLake Delta テーブル データを保存するレイクハウスの名前を選択します。 既存のレイクハウスを選択するか、新しいレイクハウスを作成できます。

出力を保存する場所を選択します。 [ルート フォルダー] として [テーブル] を選択し、テーブル名として「nycsample」と入力します。

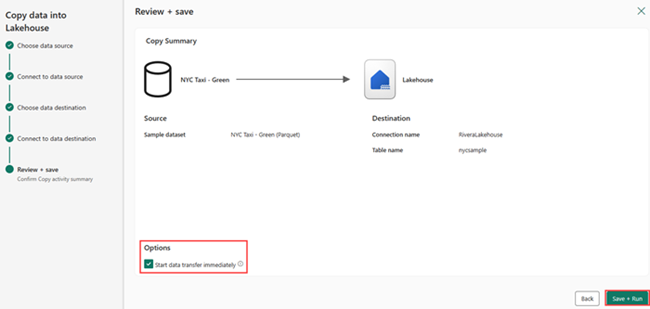

[レビューと保存] 画面で、[データ転送をすぐに開始する] を選択し、[保存と実行] を選択します。

ジョブが完了したら、レイクハウスに移動し、/Tables フォルダーの下に一覧表示されている Delta テーブルを表示します。

作成したテーブル名を右クリックし、[プロパティ] を選択し、Azure Blob Filesystem (ABFS) パスをコピーします。

Azure Databricks ノートブックを開きます。 OneLake の Delta テーブルを読み取ります。

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)フィールド値を変更して Delta テーブル データを更新します。

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;