параметры администрирования рабочей области Инжиниринг данных в Microsoft Fabric

Область применения:✅ Инжиниринг данных и Обработка и анализ данных в Microsoft Fabric

При создании рабочей области в Microsoft Fabric автоматически создается начальный пул , связанный с этой рабочей областью. При упрощенной настройке в Microsoft Fabric нет необходимости выбирать размеры узлов или компьютеров, так как эти параметры обрабатываются за кулисами. Эта конфигурация обеспечивает более быстрый запуск сеанса Apache Spark (5–10 секунд) для пользователей, чтобы приступить к работе и запустить задания Apache Spark во многих распространенных сценариях, не беспокоясь о настройке вычислений. Для расширенных сценариев с определенными требованиями к вычислительным ресурсам пользователи могут создавать настраиваемый пул Apache Spark и размер узлов в зависимости от их потребностей в производительности.

Чтобы внести изменения в параметры Apache Spark в рабочей области, необходимо иметь роль администратора для этой рабочей области. Дополнительные сведения см. в статье "Роли" в рабочих областях.

Чтобы управлять параметрами Spark для пула, связанного с рабочей областью, выполните следующие действия.

Перейдите к параметрам рабочей области и выберите параметр Инжиниринг данных/Science, чтобы развернуть меню:

В меню слева отображается параметр вычислений Spark:

Примечание.

При изменении пула по умолчанию с начального пула на настраиваемый пул Spark может отображаться более длительный запуск сеанса (около 3 минут).

Пул

Пул по умолчанию для рабочей области

Вы можете использовать автоматически созданный начальный пул или создать настраиваемые пулы для рабочей области.

Начальный пул: предварительно созданные динамические пулы автоматически создаются для более быстрого взаимодействия. Эти кластеры имеют средний размер. Начальный пул имеет конфигурацию по умолчанию на основе приобретенного номера SKU емкости Fabric. Администраторы могут настраивать максимальные узлы и исполнителей на основе требований к масштабированию рабочей нагрузки Spark. Дополнительные сведения см. в разделе "Настройка начальных пулов"

Настраиваемый пул Spark. Вы можете размер узлов, автомасштабирования и динамического выделения исполнителей на основе требований задания Spark. Чтобы создать настраиваемый пул Spark, администратор емкости должен включить параметр настраиваемых пулов рабочих областей в разделе "Вычислительные ресурсы Spark" параметров администратора емкости.

Примечание.

Элемент управления уровня емкости для настраиваемых пулов рабочих областей включен по умолчанию. Дополнительные сведения см. в статье "Настройка и управление параметрами инженерии и обработки и анализа данных" для емкостей Fabric.

Администраторы могут создавать настраиваемые пулы Spark на основе требований к вычислительным ресурсам, выбрав параметр "Создать пул ".

Apache Spark для Microsoft Fabric поддерживает кластеры с одним узлом, что позволяет пользователям выбирать минимальную конфигурацию узлов 1, в этом случае драйвер и исполнитель выполняются на одном узле. Эти кластеры с одним узлом обеспечивают восстановление высокой доступности во время сбоев узлов и более высокую надежность заданий для рабочих нагрузок с меньшими требованиями к вычислительным ресурсам. Вы также можете включить или отключить параметр автомасштабирования для пользовательских пулов Spark. При включении автомасштабирования пул получит новые узлы в пределах максимального предела узла, указанного пользователем, и отключает их после выполнения задания для повышения производительности.

Вы также можете выбрать параметр динамического выделения исполнителей пулу автоматически оптимального количества исполнителей в пределах максимальной границы, указанной на основе тома данных для повышения производительности.

Дополнительные сведения о вычислениях Apache Spark для Fabric.

- Настройка конфигурации вычислений для элементов: администратор рабочей области позволяет пользователям настраивать конфигурации вычислений (свойства уровня сеанса, которые включают Driver/Executor Core, Driver/Executor Memory) для отдельных элементов, таких как записные книжки, определения заданий Spark с помощью среды.

Если параметр отключен администратором рабочей области, пул по умолчанию и его конфигурации вычислений используются для всех сред в рабочей области.

Среда

Среда предоставляет гибкие конфигурации для выполнения заданий Spark (записных книжек, определений заданий Spark). В среде можно настроить свойства вычислений, выбрать другую среду выполнения, зависимости пакета библиотеки установки в зависимости от требований рабочей нагрузки.

На вкладке "Среда" можно задать среду по умолчанию. Вы можете выбрать версию Spark, которую вы хотите использовать для рабочей области.

Администратор рабочей области Fabric может выбрать среду в качестве среды по умолчанию.

Вы также можете создать новый с помощью раскрывающегося списка "Среда ".

Если параметр отключен для среды по умолчанию, вы можете выбрать версию среды выполнения Fabric из доступных версий среды выполнения, перечисленных в раскрывающемся списке.

Дополнительные сведения о средах выполнения Apache Spark.

Работы

Параметры заданий позволяют администраторам управлять логикой допуска заданий для всех заданий Spark в рабочей области.

По умолчанию все рабочие области включены с оптимистическим приемом заданий. Дополнительные сведения о приеме заданий для Spark в Microsoft Fabric.

Вы можете включить резервные максимальные ядра для активных заданий Spark, чтобы включить подход на основе оптимистического допуска заданий и зарезервировать максимальные ядра для своих заданий Spark.

Вы также можете задать время ожидания сеанса Spark, чтобы настроить срок действия сеанса для всех интерактивных сеансов записной книжки.

Примечание.

Срок действия сеанса по умолчанию составляет 20 минут для интерактивных сеансов Spark.

Высокая степень параллелизма

Режим высокой параллелизма позволяет пользователям совместно использовать одни и те же сеансы Spark в Apache Spark для проектирования данных и рабочих нагрузок обработки и анализа данных. Элемент, такой как записная книжка, использует сеанс Spark для его выполнения, а при включении позволяет пользователям совместно использовать один сеанс Spark в нескольких записных книжках.

Дополнительные сведения о высокой параллелизме в Apache Spark для Fabric.

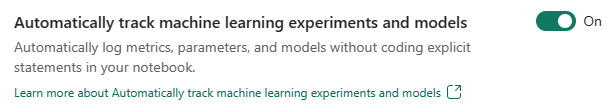

Автоматическое ведение журнала для моделей и экспериментов Машинное обучение

Теперь администраторы могут включить автологирование для моделей машинного обучения и экспериментов. Этот параметр автоматически фиксирует значения входных параметров, выходных метрик и выходных элементов модели машинного обучения по мере обучения. Узнайте больше об автологе.

Связанный контент

- Ознакомьтесь со сведениями об средах выполнения Apache Spark в Fabric: обзор, управление версиями, поддержка нескольких сред выполнения и обновление протокола Delta Lake.

- Дополнительные сведения см. в общедоступной документации Apache Spark.

- Найдите ответы на часто задаваемые вопросы: параметры администрирования рабочей области Apache Spark.