Azure Stack HCI에 대한 호스트 네트워크 요구 사항

적용 대상: Azure Stack HCI, 버전 23H2 및 22H2

이 항목에서는 Azure Stack HCI에 대한 호스트 네트워킹 고려 사항 및 요구 사항에 대해 설명합니다. 데이터 센터 아키텍처 및 서버 간의 물리적 연결에 대한 자세한 내용은 물리적 네트워크 요구 사항을 참조 하세요.

네트워크 ATC를 사용하여 호스트 네트워킹을 간소화하는 방법에 대한 자세한 내용은 네트워크 ATC를 사용하여 호스트 네트워킹 간소화를 참조하세요.

네트워크 트래픽 유형

Azure Stack HCI 네트워크 트래픽은 의도한 용도로 분류할 수 있습니다.

- 관리 트래픽: 로컬 클러스터를 오가는 트래픽입니다. 예를 들어 스토리지 복제본 트래픽 또는 관리자가 원격 데스크톱, Windows Admin Center, Active Directory 등과 같은 클러스터를 관리하는 데 사용하는 트래픽입니다.

- 컴퓨팅 트래픽: VM(가상 머신)에서 발생하거나 대상으로 하는 트래픽입니다.

- 스토리지 트래픽: SMB(서버 메시지 블록)를 사용하는 트래픽(예: 직접 또는 SMB 기반 실시간 마이그레이션 저장소 공간). 이 트래픽은 계층 2 트래픽이며 라우팅할 수 없습니다.

Important

스토리지 복제본은 RDMA 기반이 아닌 SMB 트래픽을 사용합니다. 이와 교통의 방향성(남북)은 기존 파일 공유와 유사하게 위에 나열된 "관리" 트래픽과 밀접하게 일치합니다.

네트워크 어댑터 선택

네트워크 어댑터는 사용할 수 있도록 지원되는 네트워크 트래픽 유형(위 참조)에 의해 정규화됩니다. Windows Server 카탈로그를 검토할 때 Windows Server 2022 인증은 이제 다음 역할 중 하나 이상을 나타냅니다. Azure Stack HCI용 서버를 구매하기 전에 Azure Stack HCI에서 세 가지 트래픽 유형이 모두 필요하므로 관리, 컴퓨팅 및 스토리지에 적합한 어댑터가 하나 이상 있어야 합니다. 그런 다음 네트워크 ATC를 사용하여 적절한 트래픽 유형에 대한 어댑터를 구성할 수 있습니다.

이 역할 기반 NIC 자격에 대한 자세한 내용은 이 링크를 참조하세요.

Important

정규화된 트래픽 유형 외부에서 어댑터를 사용하는 것은 지원되지 않습니다.

| 수준 | 관리 역할 | 컴퓨팅 역할 | 스토리지 역할 |

|---|---|---|---|

| 역할 기반 구분 | 관리 | Compute Standard | 스토리지 표준 |

| 최대 수상 | 해당 없음 | Compute Premium | Storage Premium |

참고 항목

에코시스템의 모든 어댑터에 대한 최고 자격에는 관리, 컴퓨팅 프리미엄 및 Storage Premium 자격이 포함됩니다.

드라이버 요구 사항

받은 편지함 드라이버는 Azure Stack HCI에서 사용할 수 없습니다. 어댑터가 받은 편지함 드라이버를 사용하고 있는지 확인하려면 다음 cmdlet을 실행합니다. DriverProvider 속성이 Microsoft인 경우 어댑터가 받은 편지함 드라이버를 사용합니다.

Get-NetAdapter -Name <AdapterName> | Select *Driver*

주요 네트워크 어댑터 기능 개요

Azure Stack HCI에서 사용하는 중요한 네트워크 어댑터 기능은 다음과 같습니다.

- 동적 Virtual Machine 다중 큐(동적 VMMQ 또는 d.VMMQ)

- RDMA(원격 직접 메모리 액세스)

- 게스트 RDMA

- 스위치가 포함 된 팀 (설정)

동적 VMMQ

Compute(프리미엄) 한정을 사용하는 모든 네트워크 어댑터는 동적 VMMQ를 지원합니다. 동적 VMMQ를 사용하려면 Switch Embedded Teaming을 사용해야 합니다.

적용 가능한 트래픽 유형: 컴퓨팅

인증 필요: 컴퓨팅(프리미엄)

동적 VMMQ는 지능형 수신측 기술입니다. VMQ(Virtual Machine Queue), vRSS(Virtual Receive Side Scaling) 및 VMMQ의 이전 버전에 따라 빌드되어 다음과 같은 세 가지 주요 개선 사항을 제공합니다.

- 더 적은 CPU 코어를 사용하여 호스트 효율성을 최적화합니다.

- CPU 코어에 대한 네트워크 트래픽 처리를 자동으로 조정하여 VM이 예상 처리량을 충족하고 유지 관리할 수 있도록 합니다.

- "버스트" 워크로드가 예상 트래픽 양을 수신할 수 있도록 합니다.

동적 VMMQ에 대한 자세한 내용은 가상 가속 블로그 게시물을 참조하세요.

RDMA

RDMA는 네트워크 어댑터에 대한 네트워크 스택 오프로드입니다. 이를 통해 SMB 스토리지 트래픽이 처리를 위해 운영 체제를 무시할 수 있습니다.

RDMA를 사용하면 최소한의 호스트 CPU 리소스를 사용하여 처리량이 높고 대기 시간이 짧은 네트워킹을 사용할 수 있습니다. 그런 다음 이러한 호스트 CPU 리소스를 사용하여 추가 VM 또는 컨테이너를 실행할 수 있습니다.

적용 가능한 트래픽 유형: 호스트 스토리지

인증 필요: 스토리지(표준)

스토리지(표준) 또는 스토리지(프리미엄) 자격이 있는 모든 어댑터는 호스트 쪽 RDMA를 지원합니다. 게스트 워크로드에서 RDMA를 사용하는 방법에 대한 자세한 내용은 이 문서의 뒷부분에 있는 "게스트 RDMA" 섹션을 참조하세요.

Azure Stack HCI는 IWARP(Internet Wide Area RDMA Protocol) 또는 RDMA over Converged Ethernet(RoCE) 프로토콜 구현을 통해 RDMA를 지원합니다.

Important

RDMA 어댑터는 동일한 RDMA 프로토콜(iWARP 또는 RoCE)을 구현하는 다른 RDMA 어댑터에서만 작동합니다.

공급업체의 모든 네트워크 어댑터가 RDMA를 지원하는 것은 아닙니다. 다음 표에서는 인증된 RDMA 어댑터를 제공하는 공급업체(사전순)를 나열합니다. 그러나 이 목록에는 RDMA를 지원하는 하드웨어 공급업체도 포함되어 있지 않습니다. RDMA 지원이 필요한 스토리지(표준) 또는 스토리지(프리미엄) 자격이 있는 어댑터를 찾으려면 Windows Server 카탈로그를 참조하세요.

참고 항목

IB(InfiniBand)는 Azure Stack HCI에서 지원되지 않습니다.

| NIC 공급업체 | iWARP | RoCE |

|---|---|---|

| Broadcom | 예 | 예 |

| Intel | 예 | 예(일부 모델) |

| Marvell(Qlogic) | 예 | 예 |

| Nvidia | 예 | 예 |

호스트용 RDMA 배포에 대한 자세한 내용은 네트워크 ATC를 사용하는 것이 좋습니다. 수동 배포에 대한 자세한 내용은 SDN GitHub 리포지토리를 참조하세요.

iWARP

iWARP는 TCP(Transmission Control Protocol)를 사용하며, 필요에 따라 PFC(우선 순위 기반 흐름 제어) 및 ETS(고급 전송 서비스)를 사용하여 향상될 수 있습니다.

다음과 같은 경우 iWARP를 사용합니다.

- RDMA 네트워크를 관리한 경험이 없습니다.

- ToR(Top-of-Rack) 스위치를 관리하거나 관리하지 않습니다.

- 배포 후에는 솔루션을 관리하지 않습니다.

- iWARP를 사용하는 배포가 이미 있습니다.

- 어떤 옵션을 선택할지 잘 모를 수 있습니다.

RoCE

RoCE는 UDP(사용자 데이터그램 프로토콜)를 사용하며 안정성을 제공하려면 PFC 및 ETS가 필요합니다.

다음과 같은 경우 RoCE를 사용합니다.

- 데이터 센터에 RoCE를 사용한 배포가 이미 있습니다.

- DCB 네트워크 요구 사항을 관리하는 것이 편합니다.

게스트 RDMA

게스트 RDMA를 사용하면 VM에 대한 SMB 워크로드가 호스트에서 RDMA를 사용하는 것과 동일한 이점을 얻을 수 있습니다.

적용 가능한 트래픽 유형: 게스트 기반 스토리지

인증 필요: 컴퓨팅(프리미엄)

게스트 RDMA를 사용할 경우의 주요 이점은 다음과 같습니다.

- 네트워크 트래픽 처리를 위해 NIC에 CPU 오프로드.

- 대기 시간이 매우 짧습니다.

- 높은 처리량.

자세한 내용은 SDN GitHub 리포지토리에서 문서를 다운로드합니다.

스위치가 포함 된 팀 (설정)

SET는 Windows Server 2016 이후 Windows Server 운영 체제에 포함된 소프트웨어 기반 팀 기술입니다. SET는 Azure Stack HCI에서 지원하는 유일한 팀 구성 기술입니다. SET은 컴퓨팅, 스토리지 및 관리 트래픽에서 잘 작동하며 동일한 팀에서 최대 8개의 어댑터에서 지원됩니다.

적용 가능한 트래픽 유형: 컴퓨팅, 스토리지 및 관리

인증 필요: 컴퓨팅(표준) 또는 컴퓨팅(프리미엄)

SET는 Azure Stack HCI에서 지원하는 유일한 팀 구성 기술입니다. SET는 컴퓨팅, 스토리지 및 관리 트래픽에서 잘 작동합니다.

Important

Azure Stack HCI는 이전 LBFO(부하 분산/장애 조치)와 NIC 팀을 지원하지 않습니다. Azure Stack HCI의 LBFO에 대한 자세한 내용은 Azure Stack HCI의 블로그 게시물 팀을 참조하세요.

SET는 다음을 지원하는 유일한 팀 기술이므로 Azure Stack HCI에 중요합니다.

- RDMA 어댑터 팀(필요한 경우).

- 게스트 RDMA.

- 동적 VMMQ.

- 다른 주요 Azure Stack HCI 기능(Azure Stack HCI의 팀 참조).

SET에는 대칭(동일한) 어댑터를 사용해야 합니다. 대칭 네트워크 어댑터는 다음과 같은 특성이 있습니다.

- 제조사(공급업체)

- 모델(버전)

- 속도(처리량)

- configuration

22H2에서 네트워크 ATC는 선택한 어댑터가 비대칭인지 자동으로 감지하고 알려줍니다. 어댑터가 대칭인지 수동으로 식별하는 가장 쉬운 방법은 속도 및 인터페이스 설명이 정확히 일치하는지 확인하는 것입니다. 설명에 나열된 숫자에서만 벗어날 수 있습니다. cmdlet을 Get-NetAdapterAdvancedProperty 사용하여 보고된 구성에 동일한 속성 값이 나열되도록 합니다.

숫자(#)로만 변하는 인터페이스 설명의 예는 다음 표를 참조하세요.

| 속성 | 인터페이스 설명 | 링크 속도 |

|---|---|---|

| NIC1 | 네트워크 어댑터 #1 | 25Gbps |

| NIC2 | 네트워크 어댑터 #2 | 25Gbps |

| NIC3 | 네트워크 어댑터 #3 | 25Gbps |

| NIC4 | 네트워크 어댑터 #4 | 25Gbps |

참고 항목

SET는 동적 또는 Hyper-V 포트 부하 분산 알고리즘을 사용하여 스위치 독립적 구성만 지원합니다. 최상의 성능을 위해 Hyper-V 포트는 10Gbps 이상에서 작동하는 모든 NIC에서 사용하는 것이 좋습니다. 네트워크 ATC는 SET에 필요한 모든 구성을 만듭니다.

RDMA 트래픽 고려 사항

DCB를 구현하는 경우 네트워크 스위치를 포함하여 모든 네트워크 포트에서 PFC 및 ETS 구성이 제대로 구현되었는지 확인해야 합니다. DCB는 RoCE에 필요하며 iWARP의 경우 선택 사항입니다.

RDMA를 배포하는 방법에 대한 자세한 내용은 SDN GitHub 리포지토리에서 문서를 다운로드합니다.

RoCE 기반 Azure Stack HCI 구현에는 패브릭 및 모든 호스트에서 기본 트래픽 클래스를 포함하여 세 개의 PFC 트래픽 클래스를 구성해야 합니다.

클러스터 트래픽 클래스

이 트래픽 클래스는 클러스터 하트비트에 대해 예약된 충분한 대역폭이 있는지 확인합니다.

- 필수: 예

- PFC 사용: 아니요

- 권장 트래픽 우선 순위: 우선 순위 7

- 권장 대역폭 예약:

- 10GbE 이하 RDMA 네트워크 = 2%

- 25GbE 이상 RDMA 네트워크 = 1%

RDMA 트래픽 클래스

이 트래픽 클래스는 SMB Direct를 사용하여 손실 없는 RDMA 통신을 위해 예약된 충분한 대역폭을 보장합니다.

- 필수: 예

- PFC 사용: 예

- 권장 트래픽 우선 순위: 우선 순위 3 또는 4

- 권장 대역폭 예약: 50%

기본 트래픽 클래스

이 트래픽 클래스는 VM 트래픽 및 관리 트래픽을 포함하여 클러스터 또는 RDMA 트래픽 클래스에 정의되지 않은 다른 모든 트래픽을 전달합니다.

- 필수: 기본적으로(호스트에 필요한 구성 없음)

- 흐름 제어(PFC) 사용: 아니요

- 권장 트래픽 클래스: 기본적으로(우선 순위 0)

- 권장 대역폭 예약: 기본적으로(호스트 구성 필요 없음)

스토리지 트래픽 모델

SMB는 SMB 다중 채널을 포함하여 Azure Stack HCI에 대한 스토리지 프로토콜로 많은 이점을 제공합니다. SMB 다중 채널은 이 문서에서 다루지 않지만 SMB 다중 채널에서 사용할 수 있는 모든 가능한 링크에서 트래픽이 멀티플렉싱된다는 점을 이해하는 것이 중요합니다.

참고 항목

여러 서브넷 및 VLAN을 사용하여 Azure Stack HCI에서 스토리지 트래픽을 구분하는 것이 좋습니다.

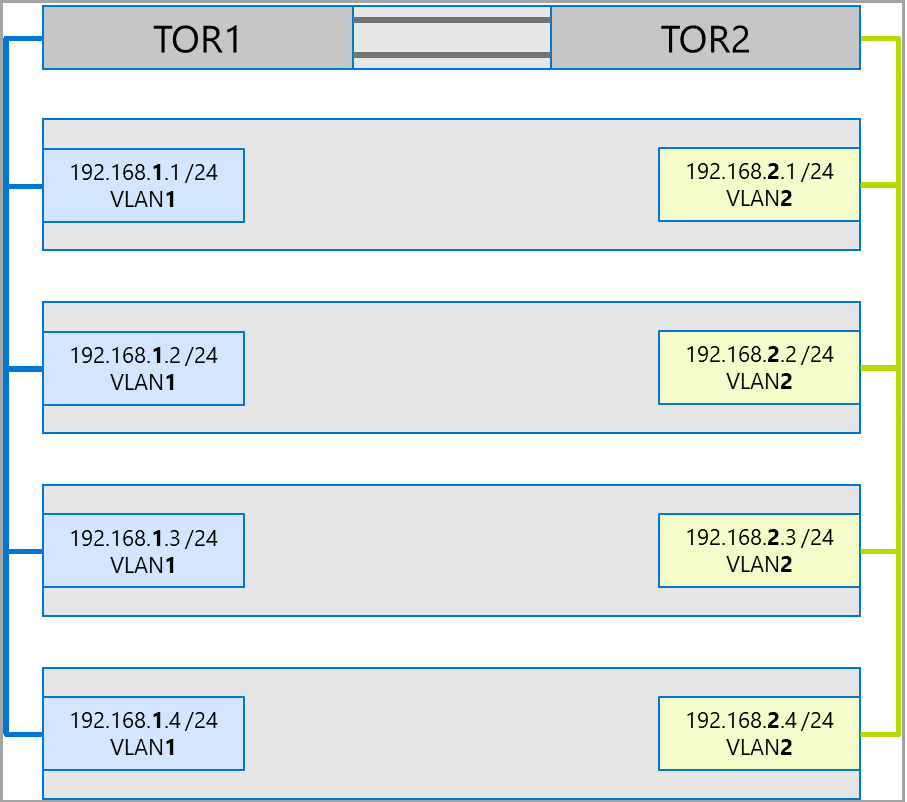

4개의 노드 클러스터에 대한 다음 예제를 생각해 보세요. 각 서버에는 두 개의 스토리지 포트(왼쪽 및 오른쪽)가 있습니다. 각 어댑터는 동일한 서브넷 및 VLAN에 있으므로 SMB 다중 채널은 사용 가능한 모든 링크에 연결을 분산합니다. 따라서 첫 번째 서버의 왼쪽 포트(192.168.1.1)는 두 번째 서버(192.168.1.2)의 왼쪽 포트에 연결합니다. 첫 번째 서버의 오른쪽 포트(192.168.1.12)는 두 번째 서버의 오른쪽 포트에 연결됩니다. 세 번째 및 네 번째 서버에 대해 유사한 연결이 설정됩니다.

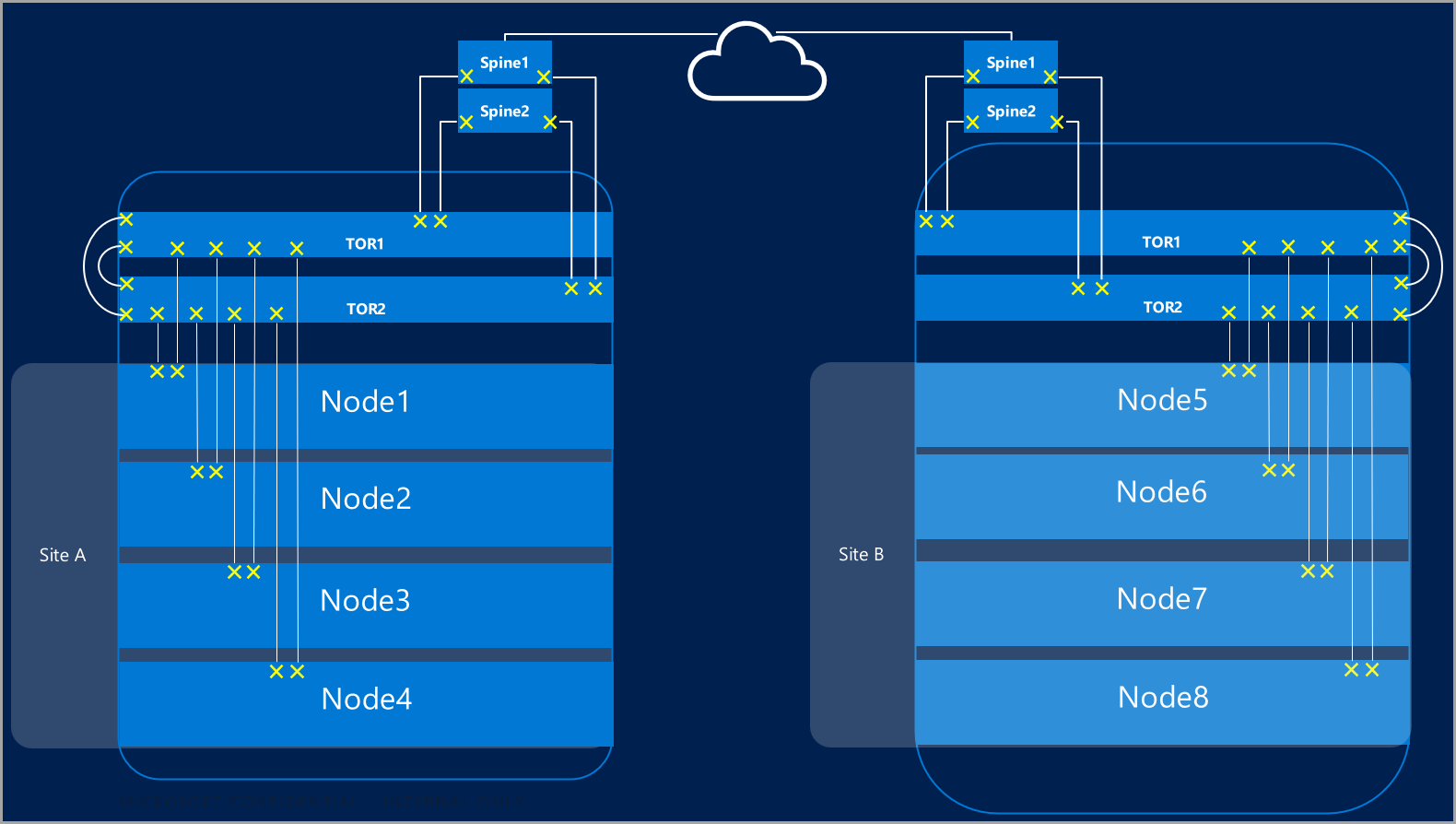

그러나 이로 인해 불필요한 연결이 생성되고 ToR 스위치(Xs로 표시됨)를 연결하는 인터링크(다중 섀시 링크 집계 그룹 또는 MC-LAG)에서 정체가 발생합니다. 다음 다이어그램을 참조하세요.

권장되는 방법은 각 어댑터 집합에 대해 별도의 서브넷 및 VLAN을 사용하는 것입니다. 다음 다이어그램에서 오른쪽 포트는 이제 서브넷 192.168.2.x /24 및 VLAN2를 사용합니다. 이렇게 하면 왼쪽 포트의 트래픽이 TOR1에 남아 있고 오른쪽 포트의 트래픽이 TOR2에 남아 있을 수 있습니다.

트래픽 대역폭 할당

다음 표에서는 Azure Stack HCI에서 일반적인 어댑터 속도를 사용하여 다양한 트래픽 유형의 대역폭 할당 예제를 보여 줍니다. 이는 모든 트래픽 유형(컴퓨팅, 스토리지 및 관리)이 동일한 물리적 어댑터를 통해 실행되고 SET를 사용하여 팀을 이루는 수렴형 솔루션의 예입니다.

이 사용 사례는 가장 많은 제약 조건을 제기하므로 좋은 기준을 나타냅니다. 그러나 어댑터 및 속도 수에 대한 순열을 고려하면 지원 요구 사항이 아닌 예제로 간주되어야 합니다.

이 예제에서는 다음과 같은 가정이 수행됩니다.

팀당 두 개의 어댑터가 있습니다.

SBL(Storage Bus 계층), CSV(클러스터 공유 볼륨) 및 Hyper-V(실시간 마이그레이션) 트래픽:

- 동일한 실제 어댑터를 사용합니다.

- SMB를 사용합니다.

SMB는 DCB를 사용하여 50% 대역폭 할당을 받습니다.

- SBL/CSV는 우선 순위가 가장 높은 트래픽이며 SMB 대역폭 예약의 70%를 받습니다.

- LM(실시간 마이그레이션)은 cmdlet을 사용하여

Set-SMBBandwidthLimit제한되며 나머지 대역폭의 29%를 받습니다.라이브 마이그레이션에 사용 가능한 대역폭이 5Gbps이고 >네트워크 어댑터가 가능한 경우 RDMA를 사용합니다. 이렇게 하려면 다음 cmdlet을 사용합니다.

Set-VMHost -VirtualMachineMigrationPerformanceOption SMB라이브 마이그레이션에 사용할 수 있는 대역폭이 5Gbps인 < 경우 압축을 사용하여 정전 시간을 줄입니다. 이렇게 하려면 다음 cmdlet을 사용합니다.

Set-VMHost -VirtualMachineMigrationPerformanceOption Compression

실시간 마이그레이션 트래픽에 RDMA를 사용하는 경우 라이브 마이그레이션 트래픽이 SMB 대역폭 제한을 사용하여 RDMA 트래픽 클래스에 할당된 전체 대역폭을 사용할 수 없는지 확인합니다. 이 cmdlet은 초당 바이트(Bps)로 입력하는 반면 네트워크 어댑터는 초당 비트(bps)로 나열되므로 주의해야 합니다. 예를 들어 다음 cmdlet을 사용하여 대역폭 제한을 6Gbps로 설정합니다.

Set-SMBBandwidthLimit -Category LiveMigration -BytesPerSecond 750MB참고 항목

이 예제의 750MBps는 6Gbps와 같습니다.

다음은 대역폭 할당 테이블의 예입니다.

| NIC 속도 | 팀 대역폭 | SMB 대역폭 예약** | SBL/CSV % | SBL/CSV 대역폭 | 실시간 마이그레이션 % | 최대 라이브 마이그레이션 대역폭 | 하트비트 % | 하트비트 대역폭 |

|---|---|---|---|---|---|---|---|---|

| 10Gbps | 20Gbps | 10Gbps | 70% | 7Gbps | * | 200Mbps | ||

| 25Gbps | 50Gbps | 25Gbps | 70% | 17.5Gbps | 29% | 7.25Gbps | %1 | 250Mbps |

| 40Gbps | 80Gbps | 40Gbps | 70% | 28Gbps | 29% | 11.6Gbps | %1 | 400Mbps |

| 50Gbps | 100Gbps | 50Gbps | 70% | 35Gbps | 29% | 14.5Gbps | %1 | 500Mbps |

| 100Gbps | 200Gbps | 100Gbps | 70% | 70Gbps | 29% | 29Gbps | %1 | 1Gbps |

| 200Gbps | 400Gbps | 200Gbps | 70% | 140Gbps | 29% | 58Gbps | %1 | 2Gbps |

* 실시간 마이그레이션 트래픽에 대한 대역폭 할당이 5Gbps이므로 <RDMA 대신 압축을 사용합니다.

** 50%는 대역폭 예약의 예입니다.

확장된 클러스터

확장된 클러스터는 여러 데이터 센터에 걸쳐 있는 재해 복구를 제공합니다. 가장 간단한 형태로 확장된 Azure Stack HCI 클러스터 네트워크는 다음과 같습니다.

확장된 클러스터 요구 사항

Important

확장된 클러스터 기능은 Azure Stack HCI 버전 22H2에서만 사용할 수 있습니다.

확장된 클러스터에는 다음과 같은 요구 사항과 특성이 있습니다.

RDMA는 단일 사이트로 제한되며 여러 사이트 또는 서브넷에서 지원되지 않습니다.

동일한 사이트의 서버는 동일한 랙 및 계층 2 경계에 있어야 합니다.

사이트 간 호스트 통신은 계층 3 경계를 넘어야 합니다. 확장 계층-2 토폴로지 지원되지 않습니다.

다른 사이트에서 워크로드를 실행하기에 충분한 대역폭을 갖습니다. 장애 조치(failover)가 발생할 경우 대체 사이트는 모든 트래픽을 실행해야 합니다. 사용 가능한 네트워크 용량의 50%로 사이트를 프로비전하는 것이 좋습니다. 그러나 장애 조치(failover) 중에 더 낮은 성능을 허용할 수 있는 경우 이는 요구 사항이 아닙니다.

사이트 간 통신에 사용되는 어댑터:

물리적 또는 가상(호스트 vNIC)일 수 있습니다. 어댑터가 가상인 경우 자체 서브넷에 하나의 vNIC를 프로비전하고 물리적 NIC당 VLAN을 프로비전해야 합니다.

사이트 간에 라우팅할 수 있는 자체 서브넷 및 VLAN에 있어야 합니다.

cmdlet을 사용하여 RDMA를

Disable-NetAdapterRDMA사용하지 않도록 설정해야 합니다. cmdlet을 사용하여 특정 인터페이스를 사용하려면 스토리지 복제본을Set-SRNetworkConstraint명시적으로 요구하는 것이 좋습니다.스토리지 복제본에 대한 추가 요구 사항을 충족해야 합니다.

다음 단계

- 네트워크 스위치 및 물리적 네트워크 요구 사항에 대해 알아봅니다. 물리적 네트워크 요구 사항을 참조 하세요.

- 네트워크 ATC를 사용하여 호스트 네트워킹을 간소화하는 방법을 알아봅니다. 네트워크 ATC를 사용하여 호스트 네트워킹 간소화를 참조하세요.

- 장애 조치(failover) 클러스터링 네트워킹 기본 사항을 확인합니다.

- Azure Portal을 사용하여 배포를 참조하세요.

- Azure Resource Manager 템플릿을 사용하여 배포를 참조하세요.