Azure IoT Edge 비전 AI에 대한 카메라 선택

컴퓨터 비전 시스템에서 가장 중요한 구성 요소 중 하나는 카메라입니다. 카메라는 AI(인공 지능) 또는 ML(기계 학습) 모델이 올바르게 평가하고 식별할 수 있는 이미지를 캡처하고 표시해야 합니다. 이 문서에서는 다양한 카메라 유형, 기능 및 고려 사항에 대한 심층적인 이해를 제공합니다.

카메라 유형

카메라 유형에는 영역 스캔, 라인 스캔 및 포함된 스마트 카메라가 포함됩니다. 여러 다양한 업체가 이러한 카메라를 제조하고 있습니다. 특정 요구 사항에 맞는 공급업체를 선택합니다.

영역 스캔 카메라

영역 스캔 카메라는 기존 카메라 이미지를 생성합니다. 이 카메라에는 일반적으로 픽셀 센서 행렬이 있습니다. 카메라는 2D 이미지를 캡처하고 평가를 위해 Azure IoT Edge 하드웨어로 보냅니다.

영역 스캔 카메라는 넓은 영역을 보고 변경 내용을 감지하는 데 적합합니다. 영역 스캔 카메라를 사용할 수 있는 워크로드의 예로는 작업 공간 안전 또는 환경에서 개체 감지 또는 계산이 있습니다.

라인 스캔 카메라

라인 스캔 카메라에는 선형 픽셀 센서의 단일 행이 있습니다. 카메라는 1픽셀 너비의 이미지를 연속해서 가져와 비디오 스트림에 연결하고 처리를 위해 스트림을 IoT Edge 디바이스로 보냅니다.

라인 스캔 카메라는 항목이 카메라를 지나 이동하거나 결함을 감지하기 위해 회전해야 하는 비전 워크로드에 적합합니다. 그런 다음, 라인 스캔 카메라는 평가를 위해 연속 이미지 스트림을 생성합니다. 라인 스캔 카메라에서 가장 잘 작동하는 워크로드의 예는 다음과 같습니다.

- 컨베이어 벨트에서 이동하는 부품의 항목 결함 감지

- 원통형 개체를 보기 위해 회전해야 하는 워크로드

- 회전이 필요한 워크로드

포함된 스마트 카메라

포함된 스마트 카메라는 이미지를 처리하고 획득할 수 있는 독립 실행형 독립 실행형 시스템입니다. 포함된 스마트 카메라는 영역 스캔 또는 라인 스캔 카메라를 사용하여 이미지를 캡처할 수 있지만, 라인 스캔 스마트 카메라를 사용하는 경우는 드뭅니다. 이러한 카메라에는 일반적으로 RS232 또는 이더넷 출력 포트가 있으므로 PLC(프로그래밍 가능한 논리 컨트롤러) 또는 기타 IIoT(산업용 IoT) 컨트롤러에 직접 통합할 수 있습니다.

카메라 기능

비전 워크로드용 카메라를 선택할 때 고려해야 할 몇 가지 기능이 있습니다. 다음 섹션에서는 센서 크기, 해상도 및 속도에 대해 설명합니다. 고려해야 할 다른 카메라 기능은 다음과 같습니다.

- 렌즈 선택

- 초점

- 단색 또는 색 깊이

- 스테레오 깊이

- 트리거

- 물리적 크기

- 지원

카메라 제조업체는 애플리케이션에 필요한 특정 기능을 이해하는 데 도움이 될 수 있습니다.

센서 크기

센서 크기는 카메라에서 평가해야 하는 가장 중요한 요소 중 하나입니다. 센서는 대상을 캡처하고 신호로 변환한 다음, 이미지를 생성하는 카메라 내의 하드웨어입니다. 센서에는 포토 사이트라고 불리는 수백만 개의 반도체 광검출기가 포함되어 있습니다.

메가픽셀 수가 많을수록 항상 더 나은 이미지가 생성되는 것은 아닙니다. 예를 들어 1,200만 개의 사진 사이트와 1인치 센서가 있는 카메라는 1,200만 개의 광사이트와 1/2인치 센서가 있는 카메라보다 더 선명하고 선명한 이미지를 생성합니다. 컴퓨터 비전 워크로드용 카메라는 일반적으로 센서 크기가 1/4인치에서 1인치 사이입니다. 경우에 따라 훨씬 더 큰 센서가 필요할 수 있습니다.

비전 워크로드에 다음이 있는 경우 더 큰 센서를 선택합니다.

- 정밀도 측정의 필요성

- 낮은 조명 조건

- 노출 시간 단축 또는 빠르게 움직이는 항목

해결 방법

해상도는 카메라 선택에서 또 다른 중요한 요소입니다. 다음 워크로드의 경우 고해상도 카메라가 필요합니다.

- 통합 회로 칩의 쓰기와 같은 미세한 기능을 식별해야 합니다.

- 얼굴을 감지하려고 합니다.

- 원거리에서 차량을 식별해야 합니다.

다음 이미지는 지정된 사용 사례에 대해 잘못된 해결을 사용하는 문제를 보여 줍니다. 두 이미지 모두 차에서 20피트 떨어진 곳에서 촬영되었습니다. 작은 빨간색 상자는 1픽셀을 나타냅니다.

다음 이미지는 480개의 가로 픽셀로 촬영되었습니다.

다음 이미지는 5184개의 가로 픽셀로 촬영되었습니다.

속도

비전 워크로드에서 초당 많은 이미지를 캡처해야 하는 경우 두 가지 요소가 중요합니다. 첫 번째 요소는 카메라 인터페이스 연결 속도입니다. 두 번째 요소는 센서의 유형입니다. 센서는 CCD(충전 결합 디바이스) 및 CMOS(활성 픽셀 센서)의 두 가지 유형으로 제공됩니다. CMOS 센서는 사진 사이트에서 직접 판독하므로 일반적으로 더 높은 프레임 속도를 제공합니다.

카메라 배치

비전 워크로드에서 캡처해야 하는 항목은 카메라 배치의 위치와 각도를 결정합니다. 카메라 위치는 센서 유형, 렌즈 유형 및 카메라 본문 유형과도 상호 작용할 수 있습니다. 카메라 배치를 결정하는 데 가장 중요한 두 가지 요소는 조명과 시야입니다.

카메라 조명

컴퓨터 비전 워크로드에서 조명은 카메라 배치에 매우 중요합니다. 여러 가지 조명 조건을 적용할 수 있습니다. 하나의 비전 워크로드에 유용한 조명 조건은 다른 워크로드에서 바람직하지 않은 영향을 미칠 수 있습니다.

컴퓨터 비전 워크로드에는 다음과 같은 몇 가지 일반적인 조명 유형이 있습니다.

- 직접 조명은 가장 일반적인 조명 조건입니다. 광원은 캡처할 개체에 투사됩니다.

- 라인 조명은 라인 스캔 카메라에 가장 많이 사용되는 단일 조명 배열입니다. 라인 조명은 카메라의 초점에 한 줄의 빛을 만듭니다.

- 확산 조명은 물체를 비추지만 거친 그림자를 방지합니다. 확산 조명은 주로 반사 또는 반사 개체 주위에 사용됩니다.

- 축 확산 조명은 종종 반사가 높은 개체와 함께 사용되거나 부분의 그림자가 캡처되지 않도록 방지합니다.

- 후면 조명은 개체 뒤에 사용되어 개체의 실루엣을 생성합니다. 후면 조명은 측정, 에지 감지 또는 개체 방향에 가장 유용합니다.

- 사용자 지정 그리드 조명은 개체에 조명 그리드를 배치하는 구조화된 조명 조건입니다. 알려진 그리드 프로젝션은 항목 구성 요소, 부품 및 배치를 보다 정확하게 측정합니다.

- 스트로브 조명은 고속 이동 부품에 사용됩니다. 평가를 위해 개체를 고정하려면 스트로브가 카메라와 동기화되어야 합니다. 스트로브 조명은 동작 흐림 효과를 방지하는 데 도움이 됩니다.

- 어두운 필드 조명은 캡처할 부분에 서로 다른 각도의 여러 조명을 사용합니다. 예를 들어 부품이 컨베이어 벨트에 평평하게 놓여 있으면 조명은 벨트에 45도 각도입니다. 어두운 필드 조명은 반사가 매우 명확한 물체에 가장 유용하며 일반적으로 렌즈 스크래치 감지에 사용됩니다.

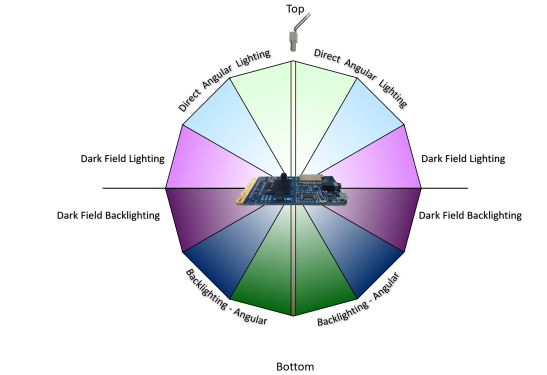

다음 그림에서는 광원의 각도 배치를 보여 줍니다.

보기 필드

비전 워크로드를 계획할 때 평가 중인 개체의 FOV(보기 필드)에 대해 알아야 합니다. FOV는 카메라 선택, 센서 선택 및 렌즈 구성에서 중요한 역할을 합니다. FOV 구성 요소는 다음과 같습니다.

- 개체와의 거리. 예를 들어, 60cm 위에 카메라가 달린 컨베이어 벨트 위의 개체 또는 주차장 건너편의 개체를 모니터링하고 있나요? 카메라 센서와 렌즈 구성은 거리에 따라 다릅니다.

- 적용 범위의 영역. 컴퓨터 비전이 작거나 큰 모니터링을 시도하는 영역인가요? 이 요소는 카메라의 해상도, 렌즈 및 센서 유형과 직접 상관 관계가 있습니다.

- 태양의 방향. 컴퓨터 비전 워크로드가 야외에 있는 경우 하루 종일 태양의 방향을 고려해야 합니다. 태양이 움직일 때의 각도는 컴퓨터 비전 모델에 영향을 미칠 수 있습니다. 카메라가 렌즈에 직사광선이 생기면 태양의 각도가 변할 때까지 눈이 멀어질 수 있습니다. 태양이 모니터링되는 개체 위에 그림자를 드리우면 개체가 가려질 수 있습니다.

- 개체에 대한 카메라 각도. 카메라가 너무 높거나 너무 낮으면 워크로드가 캡처하려는 세부 정보를 놓칠 수 있습니다.

통신 인터페이스

컴퓨터 비전 워크로드를 계획할 때 카메라 출력이 시스템의 나머지 부분과 상호 작용하는 방식을 이해하는 것이 중요합니다. 카메라가 IoT Edge 디바이스와 통신하는 몇 가지 표준 방법이 있습니다.

RTSP(실시간 스트리밍 프로토콜)는 스트리밍 비디오 서버를 제어하는 애플리케이션 수준 네트워크 프로토콜입니다. RTSP는 TCP/IP 연결을 통해 카메라에서 IoT Edge 컴퓨팅 엔드포인트로 실시간 비디오 데이터를 전송합니다.

ONVIF(Open Network Video Interface Forum)는 IP 기반 카메라에 대한 개방형 표준을 개발하는 글로벌 개방형 산업 포럼입니다. 이러한 표준은 IP 카메라와 다운스트림 시스템 간의 통신, 상호 운용성 및 오픈 소스 설명합니다.

USB(유니버설 직렬 버스)에 연결된 카메라는 USB 포트를 통해 IoT Edge 컴퓨팅 디바이스에 직접 연결합니다. 이 연결은 덜 복잡하지만 IoT Edge 디바이스에서 카메라를 배치할 수 있는 거리가 제한적입니다.

CSI(카메라 직렬 인터페이스)에는 MIPI(모바일 산업 프로세서 인터페이스) Alliance의 여러 표준이 포함되어 있습니다. CSI는 카메라와 호스트 프로세서 간에 통신하는 방법을 설명합니다. 2005년에 릴리스된 CSI-2에는 다음과 같은 여러 계층이 있습니다.

- 물리적 계층(C-PHY 또는 D-PHY)

- 레인 합병 계층

- 하위 수준 프로토콜 계층

- 픽셀-바이트 변환 계층

- 애플리케이션 레이어

CSI-2 v3.0은 RAW-24 색 깊이, 통합 직렬 링크 및 스마트 관심 지역에 대한 지원을 추가했습니다.

참가자

Microsoft에서 이 문서를 유지 관리합니다. 원래 다음 기여자가 작성했습니다.

보안 주체 작성자:

- Keith Hill | 선임 PM 관리자

비공개 LinkedIn 프로필을 보려면 LinkedIn에 로그인합니다.