Azure Stream Analytics를 사용하여 Azure Storage Blob에서 Azure Data Lake Storage Gen1에 데이터 스트리밍

이 문서에서는 Azure Data Lake Storage Gen1을 Azure Stream Analytics 작업의 출력으로 사용하는 방법을 알아봅니다. 이 문서에서는 Azure Storage Blob(입력)에서 데이터를 읽고 Data Lake Storage Gen1(출력)에 데이터를 기록하는 간단한 시나리오를 보여줍니다.

사전 요구 사항

이 자습서를 시작하기 전에 다음이 있어야 합니다.

Azure 구독. Azure 평가판을 참조하세요.

Azure Storage 계정. 이 계정에서 Blob 컨테이너를 사용하여 Stream Analytics 작업에 대한 데이터를 입력합니다. 이 자습서의 경우 storageforasa라는 스토리지 계정 및 storageforasacontainer라는 계정 내의 컨테이너가 있다고 가정합니다. 컨테이너를 만든 후에 샘플 데이터 파일을 거기에 업로드합니다.

Data Lake Storage Gen1 계정. Azure Portal을 사용하여 Azure Data Lake Storage Gen1 시작에 있는 지침을 따릅니다. myadlsg1라는 Data Lake Storage Gen1 계정이 있다고 가정합니다.

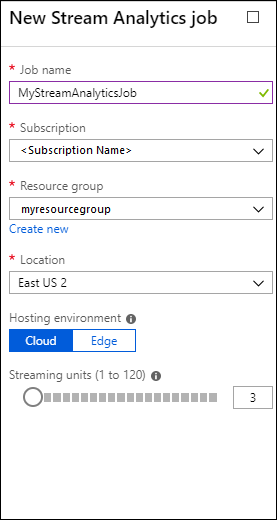

Stream Analytics 작업 만들기

입력 원본 및 출력 대상을 포함하는 Stream Analytics 작업을 만들어 시작합니다. 이 자습서의 경우 원본은 Azure blob 컨테이너이고 대상은 Data Lake Storage Gen1입니다.

Azure Portal에 로그인합니다.

왼쪽 창에서 Stream Analytics 작업을 클릭한 후 추가를 클릭합니다.

참고

스토리지 계정과 동일한 지역에 작업을 만들지 않으면 지역 간에 데이터를 이동하는 데 추가 비용이 발생합니다.

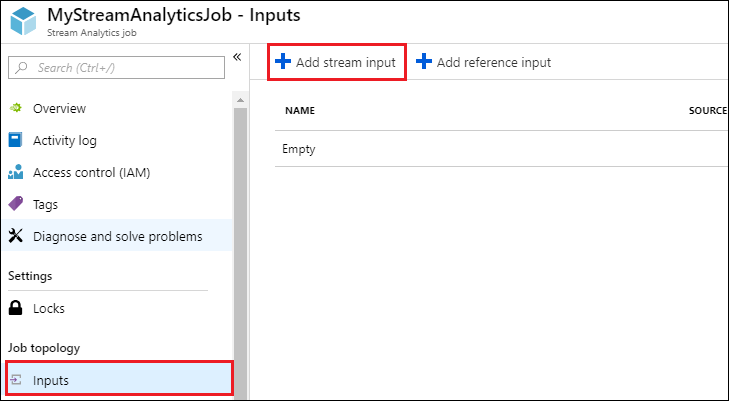

작업에 대한 Blob 입력 만들기

Stream Analytics 작업 페이지를 열고 왼쪽 창에서 입력 탭을 클릭한 다음 추가를 클릭합니다.

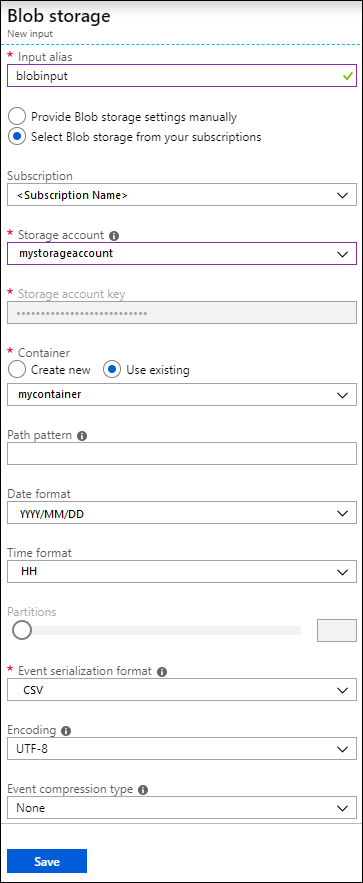

새 입력 블레이드에서 다음 값을 제공합니다.

입력 별칭에 작업 입력에 대한 고유한 이름을 입력합니다.

원본 형식으로 데이터 스트림을 선택합니다.

원본으로 Blob Storage를 선택합니다.

구독에 대해 현재 구독의 Blob Storage 사용을 선택합니다.

Storage 계정에서 필수 조건의 일부로 만든 Storage 계정을 선택합니다.

컨테이너에 대해 선택한 스토리지 계정에서 만든 컨테이너를 선택합니다.

이벤트 직렬화 형식으로 CSV를 선택합니다.

구분 기호로 탭을 선택합니다.

Encoding으로 UTF-8을 선택합니다.

만들기를 클릭합니다. 이제 포털에 입력이 추가되고 연결을 테스트합니다.

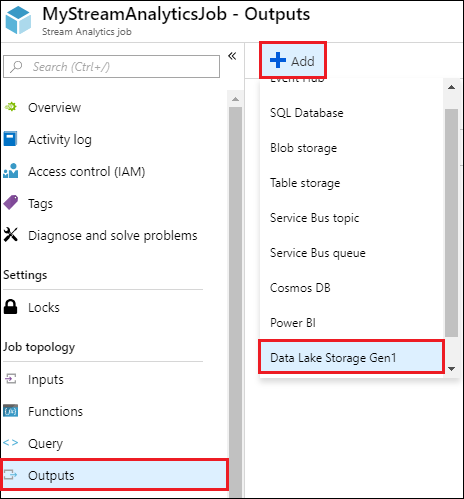

작업에 대한 Data Lake Storage Gen1 출력 만들기

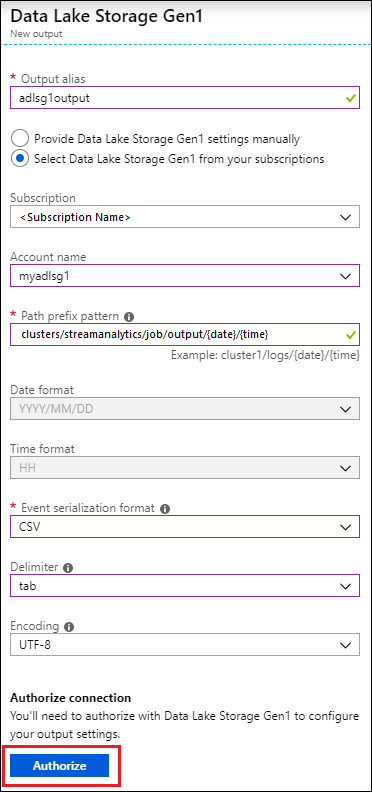

Stream Analytics 작업에 대한 페이지를 열고 출력 탭을 클릭한 다음, 추가를 클릭하고 Data Lake Storage Gen1을 선택합니다.

새 출력 블레이드에서 다음 값을 제공합니다.

- 입력 별칭에 작업 출력에 대한 고유한 이름을 입력합니다. 쿼리 출력을 이 Data Lake Storage Gen1 계정으로 직접 보내기 위해 쿼리에서 사용되는 식별 이름입니다.

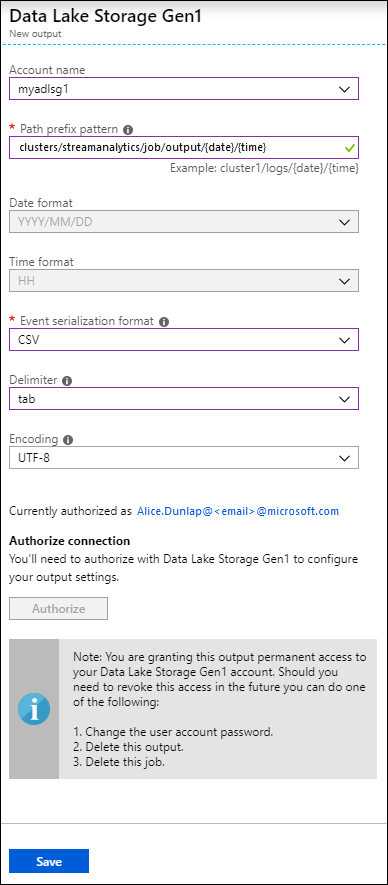

- Data Lake Storage Gen1 계정에 대한 액세스 권한을 부여하라는 메시지가 표시됩니다. 권한 부여를 클릭합니다.

새 출력 블레이드에서 계속 다음 값을 제공합니다.

계정 이름에는 작업 출력을 전송하려는 위치에 미리 만든 Data Lake Storage Gen1 계정을 선택합니다.

경로 접두사 패턴에는 지정된 Data Lake Storage Gen1 계정 내에서 파일을 작성하는 데 사용되는 파일 경로를 입력합니다.

날짜 형식의 경우, 접두사 경로에 날짜 토큰을 사용한 경우 파일을 구성하는 날짜 형식을 선택할 수 있습니다.

시간 형식의 경우, 접두사 경로에 시간 토큰을 사용한 경우 파일을 구성하는 시간 형식을 지정합니다.

이벤트 직렬화 형식으로 CSV를 선택합니다.

구분 기호로 탭을 선택합니다.

Encoding으로 UTF-8을 선택합니다.

만들기를 클릭합니다. 이제 포털에 출력이 추가되고 연결을 테스트합니다.

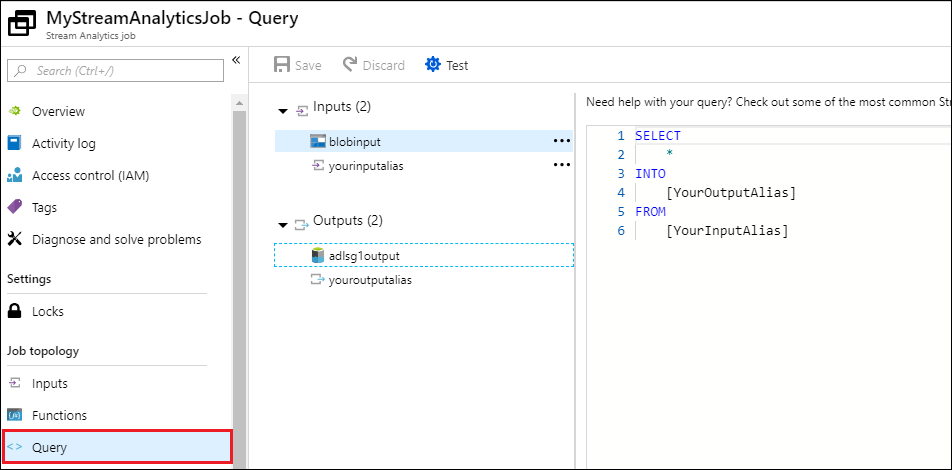

Stream Analytics 작업 실행

Stream Analytics 작업을 실행하려면 쿼리 탭에서 쿼리를 실행해야 합니다. 이 자습서에서는 아래 화면 캡처와 같이 자리 표시자를 작업 입력 및 출력 별칭으로 대체하여 샘플 쿼리를 실행할 수 있습니다.

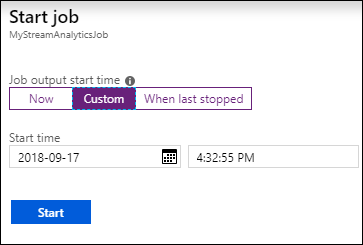

화면 맨 위에서 저장을 클릭한 다음 개요 탭에서 시작을 클릭합니다. 대화 상자에서 사용자 지정 시간을 선택한 다음 현재 날짜 및 시간을 설정합니다.

시작을 클릭하여 작업을 시작합니다. 작업을 시작하는 데 최대 몇 분이 걸릴 수 있습니다.

Blob에서 데이터를 선택하는 작업을 트리거하려면 샘플 데이터 파일을 Blob 컨테이너에 복사합니다. Azure Data Lake Git 리포지토리에서 샘플 데이터 파일을 가져올 수 있습니다. 이 자습서에서는 vehicle1_09142014.csv 파일을 복사하겠습니다. Azure Storage Explorer와 같은 다양한 클라이언트를 사용하여 Blob 컨테이너에 데이터를 업로드할 수 있습니다.

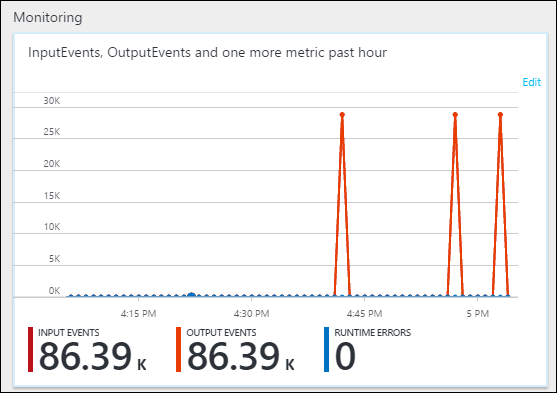

개요 탭의 모니터링 아래에서 데이터가 처리된 방식을 확인합니다.

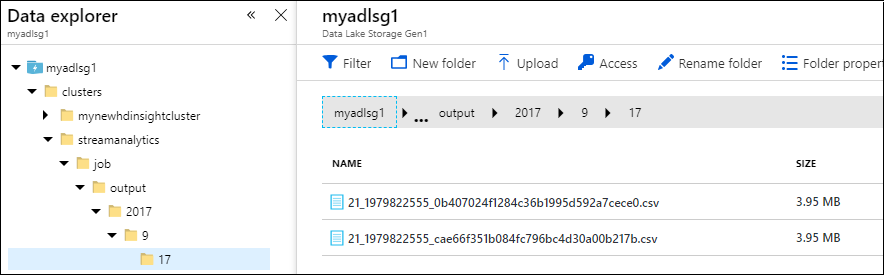

마지막으로 Data Lake Storage Gen1 계정에서 작업 출력 데이터가 제공되는 것을 확인할 수 있습니다.

데이터 탐색기 창에서 Data Lake Storage Gen1 출력 설정(

streamanalytics/job/output/{date}/{time})에 지정된 대로 출력이 폴더 경로에 기록됩니다.