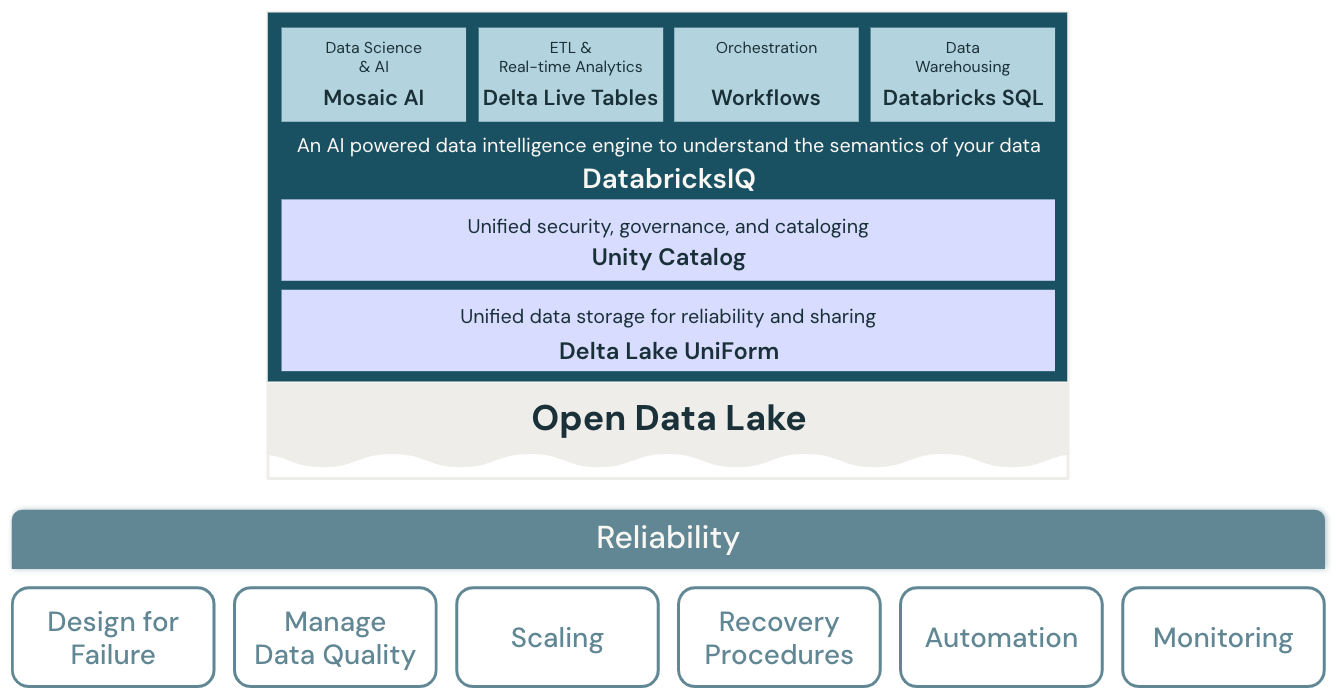

데이터 레이크하우스의 안정성

안정성 핵심 요소의 아키텍처 원칙은 오류로부터 복구하고 계속 작동하는 시스템의 기능을 다룹니다.

안정성 원칙

오류를 고려한 디자인

고도로 분산된 환경에서 중단이 발생할 수 있습니다. 플랫폼 및 스트리밍 작업, 일괄 처리 작업, 모델 학습 및 BI 쿼리와 같은 다양한 워크로드의 경우 오류를 예상해야 하며 안정성을 높이기 위해 복원력 있는 솔루션을 개발해야 합니다. 신속하게 복구하고 최상의 경우 자동으로 복구하도록 애플리케이션을 디자인하는 데 중점을 두고 있습니다.

데이터 품질 관리

데이터 품질은 데이터에서 정확하고 의미 있는 인사이트를 도출하는 데 기본입니다. 데이터 품질에는 완전성, 정확도, 유효성 및 일관성을 비롯한 다양한 차원이 있습니다. 데이터가 비즈니스 사용자에게 안정적이고 신뢰할 수 있는 정보로 작동하도록 최종 데이터 세트의 품질을 개선하기 위해 적극적으로 관리해야 합니다.

자동 크기 조정을 위한 디자인

표준 ETL 프로세스, 비즈니스 보고서 및 대시보드에는 종종 메모리 및 컴퓨팅 측면에서 예측 가능한 리소스 요구 사항이 있습니다. 그러나 새 프로젝트, 계절 작업 또는 모델 학습(변동, 예측 및 기본 테넌트)과 같은 고급 접근 방식은 리소스 요구 사항의 급증을 만듭니다. 조직에서 이러한 모든 워크로드를 처리하려면 확장 가능한 스토리지 및 컴퓨팅 플랫폼이 필요합니다. 필요에 따라 새 리소스를 추가하는 것은 쉬워야 하며 실제 소비량만 청구해야 합니다. 피크가 끝나면 리소스를 확보하고 그에 따라 비용을 절감할 수 있습니다. 이를 수평적 크기 조정(노드 수) 및 세로 크기 조정(노드 크기)이라고도 합니다.

복구 절차 테스트

대부분의 애플리케이션 및 시스템에 대한 엔터프라이즈 차원의 재해 복구 전략에는 우선 순위, 기능, 제한 사항 및 비용에 대한 평가가 필요합니다. 신뢰할 수 있는 재해 복구 방법은 워크로드가 실패하는 방법을 정기적으로 테스트하고 복구 절차의 유효성을 검사합니다. 자동화를 사용하여 여러 오류를 시뮬레이션하거나 과거에 오류를 발생시킨 시나리오를 다시 만들 수 있습니다.

배포 및 워크로드 자동화

Lakehouse에 대한 배포 및 워크로드를 자동화하면 이러한 프로세스를 표준화하고, 사용자 오류를 제거하고, 생산성을 향상하고, 더 큰 반복성을 제공할 수 있습니다. 여기에는 구성 드리프트를 방지하기 위해 "코드로 구성"을 사용하고 필요한 모든 Lakehouse 및 클라우드 서비스의 프로비저닝을 자동화하는 "코드로서의 인프라"를 사용하는 것이 포함됩니다.

모니터링, 경고 및 로깅 설정

레이크하우스의 워크로드는 일반적으로 Databricks 플랫폼 서비스 및 외부 클라우드 서비스(예: 데이터 원본 또는 대상)를 통합합니다. 실행 체인의 각 서비스가 제대로 작동하는 경우에만 성공적인 실행이 발생할 수 있습니다. 그렇지 않은 경우 모니터링, 경고 및 로깅은 문제를 감지 및 추적하고 시스템 동작을 이해하는 데 중요합니다.