사용자 고유의 LLM 엔드포인트 벤치마킹 수행

이 문서에서는 LLM 엔드포인트를 벤치마킹하기 위한 Databricks 권장 Notebook 예제를 제공합니다. 또한 Databricks가 LLM 유추를 수행하고 대기 시간 및 처리량을 엔드포인트 성능 메트릭으로 계산하는 방법을 간략하게 소개합니다.

Databricks에 대한 LLM 유추는 파운데이션 모델 API에 대해 프로비전된 처리량 모드에 대해 초당 토큰을 측정합니다. 프로비전된 처리량의 초당 토큰 범위는 무엇을 의미합니까?를 참조하세요.

벤치마킹 예제 Notebook

다음 Notebook을 Databricks 환경으로 가져오고 LLM 엔드포인트의 이름을 지정하여 부하 테스트를 실행할 수 있습니다.

LLM 엔드포인트 벤치마킹

LLM 유추 소개

LLM은 2단계 프로세스에서 유추를 수행합니다.

- 미리 채우기는 입력 프롬프트의 토큰이 병렬로 처리됩니다.

- 디코딩은 텍스트가 자동 회귀 방식으로 한 번에 하나의 토큰을 생성합니다. 생성된 각 토큰은 입력에 추가되고 모델에 다시 공급되어 다음 토큰을 생성합니다. LLM이 특수 중지 토큰을 출력하거나 사용자 정의 조건이 충족되면 생성이 중지됩니다.

대부분의 프로덕션 애플리케이션에는 대기 시간 예산이 있으며, Databricks는 대기 시간 예산을 고려할 때 처리량을 최대화하는 것이 좋습니다.

- 입력 토큰의 수는 요청을 처리하는 데 필요한 메모리에 상당한 영향을 줍니다.

- 출력 토큰 수가 전체 응답 대기 시간을 지배합니다.

Databricks는 LLM 유추를 다음 하위 메트릭으로 나눕니다.

- TTFT(Time to First 토큰): 쿼리를 입력한 후 사용자가 모델의 출력을 빠르게 볼 수 있는 방법입니다. 응답 대기 시간이 짧다는 것은 실시간 상호 작용에서 필수적이지만 오프라인 워크로드에서는 덜 중요합니다. 이 메트릭은 프롬프트를 처리한 다음 첫 번째 출력 토큰을 생성하는 데 필요한 시간에 따라 결정됩니다.

- TPOT(출력 토큰 당 시간): 시스템을 쿼리하는 각 사용자에 대한 출력 토큰을 생성하는 시간입니다. 이 메트릭은 각 사용자가 모델의 "속도"를 인식하는 방식에 해당합니다. 예를 들어 토큰당 100밀리초의 TPOT은 초당 10개의 토큰 또는 분당 최대 450단어로 일반적인 사람이 읽을 수 있는 것보다 빠릅니다.

이러한 메트릭에 따라 총 대기 시간 및 처리량을 다음과 같이 정의할 수 있습니다.

- 대기 시간 = TTFT + (TPOT) * (생성할 토큰 수)

- 처리량 = 모든 동시성 요청에서 초당 출력 토큰 수

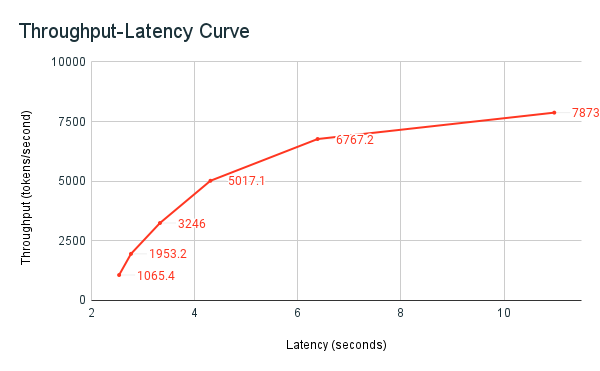

Databricks에서 엔드포인트를 제공하는 LLM은 여러 동시 요청이 있는 클라이언트에서 보낸 부하와 일치하도록 크기를 조정할 수 있습니다. 대기 시간과 처리량 사이에는 균형이 있습니다. 이는 엔드포인트를 제공하는 LLM에서 동시 요청이 동시에 처리될 수 있고 처리되기 때문입니다. 낮은 동시 요청 로드에서 대기 시간이 가능한 가장 낮습니다. 그러나 요청 부하를 늘리면 대기 시간이 증가할 수 있지만 처리량도 증가할 수 있습니다. 초당 두 개의 요청 가치가 있는 토큰을 두 배 미만의 시간 안에 처리할 수 있기 때문입니다.

따라서 시스템에 대한 병렬 요청 수를 제어하는 것이 대기 시간과 처리량의 균형을 맞추는 핵심입니다. 짧은 대기 시간 사용 사례가 있는 경우 대기 시간을 낮게 유지하기 위해 엔드포인트에 더 적은 동시 요청을 보내야 합니다. 처리량 사용 사례가 높은 경우 처리량이 많을수록 대기 시간이 절약되기 때문에 많은 동시성 요청으로 엔드포인트를 포화시켜야 합니다.

Databricks 벤치마킹 하니스

이전에 공유된 벤치마킹 예제 Notebook은 Databricks의 벤치마킹 도구입니다. Notebook은 대기 시간 및 처리량 메트릭을 표시하고 여러 병렬 요청 수에 걸쳐 처리량과 대기 시간 곡선을 그립니다. Databricks 엔드포인트 자동 크기 조정은 대기 시간과 처리량 간의 "균형 잡힌" 전략을 기반으로 합니다. Notebook에서 더 많은 동시 사용자가 동시에 엔드포인트를 쿼리할 때 대기 시간이 늘어나고 처리량이 늘어나고 있음을 확인할 수 있습니다.

LLM 성능 벤치마킹에 대한 Databricks 철학에 대한 자세한 내용은 LLM 유추 성능 엔지니어링: 모범 사례 블로그에 설명되어 있습니다.