Azure Synapse Analytics는 데이터를 수집, 변환, 모델링, 분석 및 배포하는 데 도움이 되는 다양한 분석 엔진을 제공합니다. Apache Spark 풀은 오픈 소스 빅 데이터 컴퓨팅 기능을 제공합니다. Synapse 작업 영역에서 Apache Spark 풀을 만든 후에는 더 빠른 분석 인사이트를 위해 데이터를 로드, 모델링, 처리 및 배포할 수 있습니다.

이 빠른 시작에서는 Azure Portal을 사용하여 Synapse 작업 영역에서 Apache Spark 풀을 만드는 방법을 알아봅니다.

중요합니다

Spark 인스턴스 요금은 인스턴스 사용 여부에 관계없이 분 단위 비례 배분 방식으로 청구됩니다. Spark 인스턴스를 사용한 후 꼭 인스턴스를 종료하거나 짧은 시간 제한을 설정해야 합니다. 자세한 내용은 이 문서의 리소스 정리 섹션을 참조하세요.

Azure 구독이 아직 없는 경우 시작하기 전에 체험 계정을 만듭니다.

필수 조건

- Azure 구독이 필요합니다. 필요한 경우 체험 Azure 계정 만들기

- Synapse 작업 영역을 사용하게 됩니다.

Azure Portal에 로그인

Azure 포털에 로그인하세요.

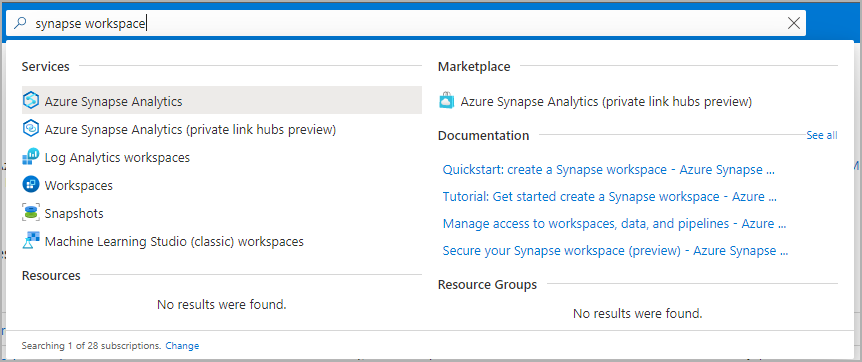

Synapse 작업 영역으로 이동

검색 창에 서비스 이름(또는 리소스 이름)을 직접 입력하여 Apache Spark 풀이 생성될 때 Synapse 작업 영역으로 이동합니다.

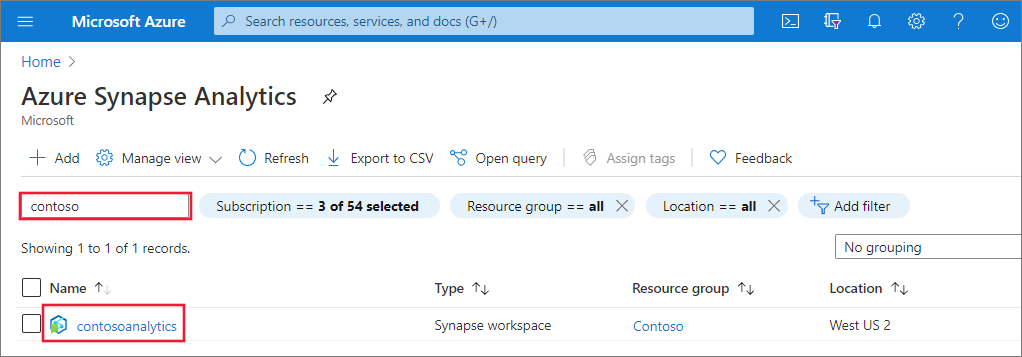

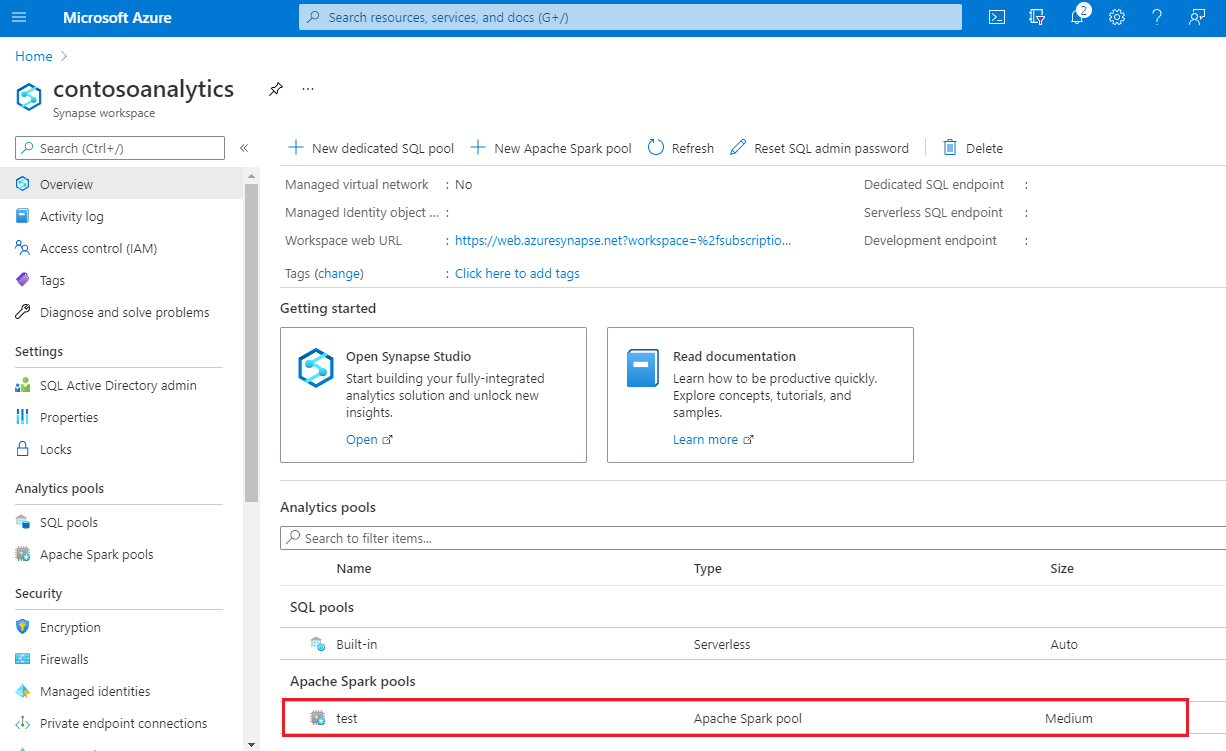

작업 영역 목록에서 열려는 작업 영역의 이름(또는 이름의 일부)을 입력합니다. 이 예에서는 contosoanalytics라는 작업 영역을 사용합니다.

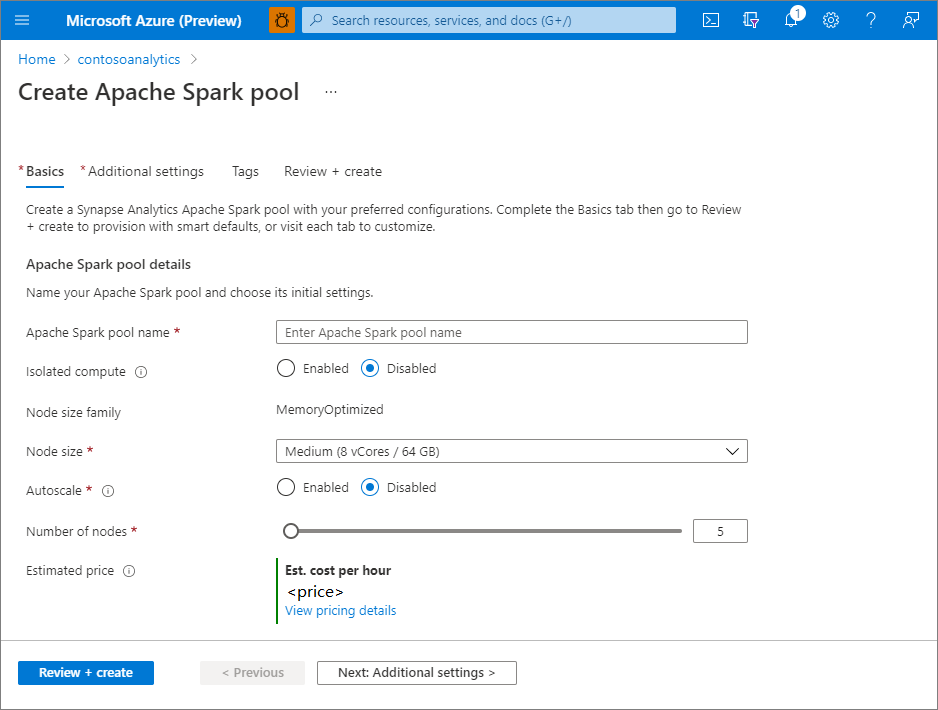

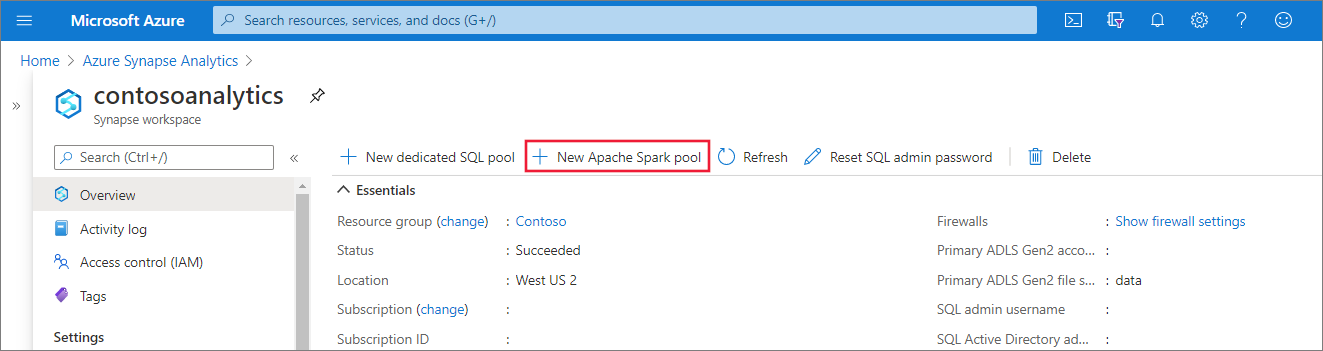

새 Apache Spark 풀 만들기

Apache Spark 풀을 만들려는 Synapse 작업 영역에서 새 Apache Spark 풀을 선택합니다.

기본 사항 탭에서 다음 정보를 입력합니다.

설정 제안된 값 설명 Apache Spark 풀 이름 contosospark와 같은 유효한 풀 이름Apache Spark 풀이 사용할 이름입니다. 노드 크기 작음(4 vCPU/32GB) 이 빠른 시작에서는 비용을 줄이기 위해 이 값을 가장 작은 크기로 설정합니다. 자동 크기 조정 사용 안 함 이 빠른 시작에서는 자동 크기 조정이 필요하지 않습니다. 노드 수 5 이 빠른 시작의 비용을 제한하려면 작은 크기를 사용합니다. 중요합니다

Apache Spark 풀에서 사용할 수 있는 이름에는 특정 제한 사항이 있습니다. 이름은 문자 또는 숫자만 포함해야 하고, 15자 이하여야 하고, 문자로 시작하고 예약어를 포함하지 않아야 하고, 작업 영역에서 고유해야 합니다.

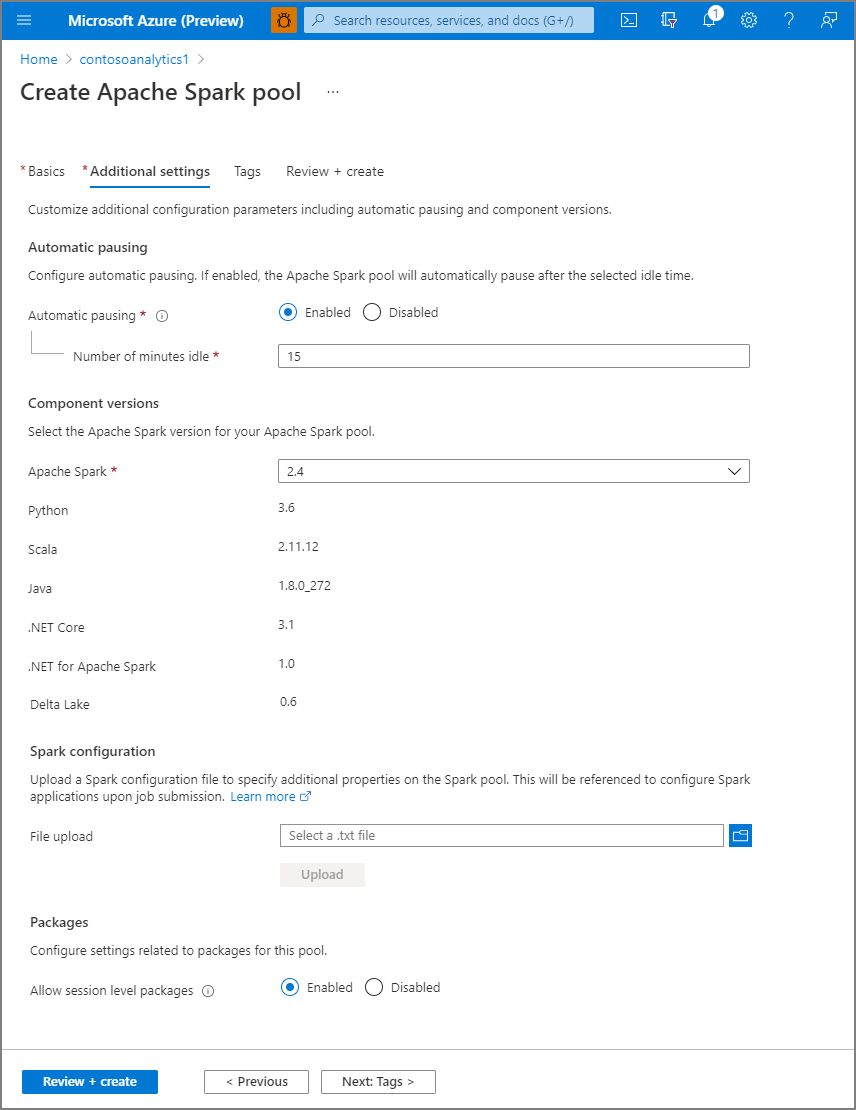

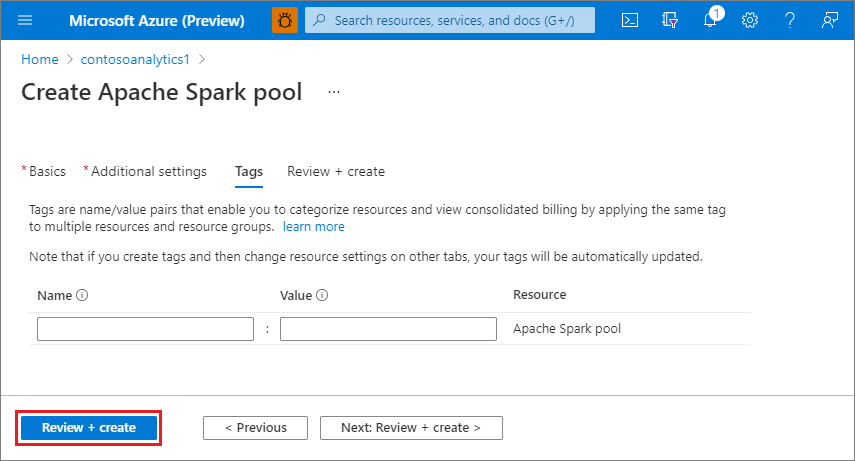

다음: 태그를 선택합니다. Azure 태그를 사용하는 것이 좋습니다. 예를 들어, 리소스를 만든 사용자를 식별하기 위한 "소유자" 또는 "작성자" 태그와 이 리소스가 프로덕션, 개발 등인지 식별하기 위한 "환경" 태그가 있습니다. 자세한 내용은 Azure 리소스에 대한 명명 및 태그 지정 전략 개발을 참조하세요.

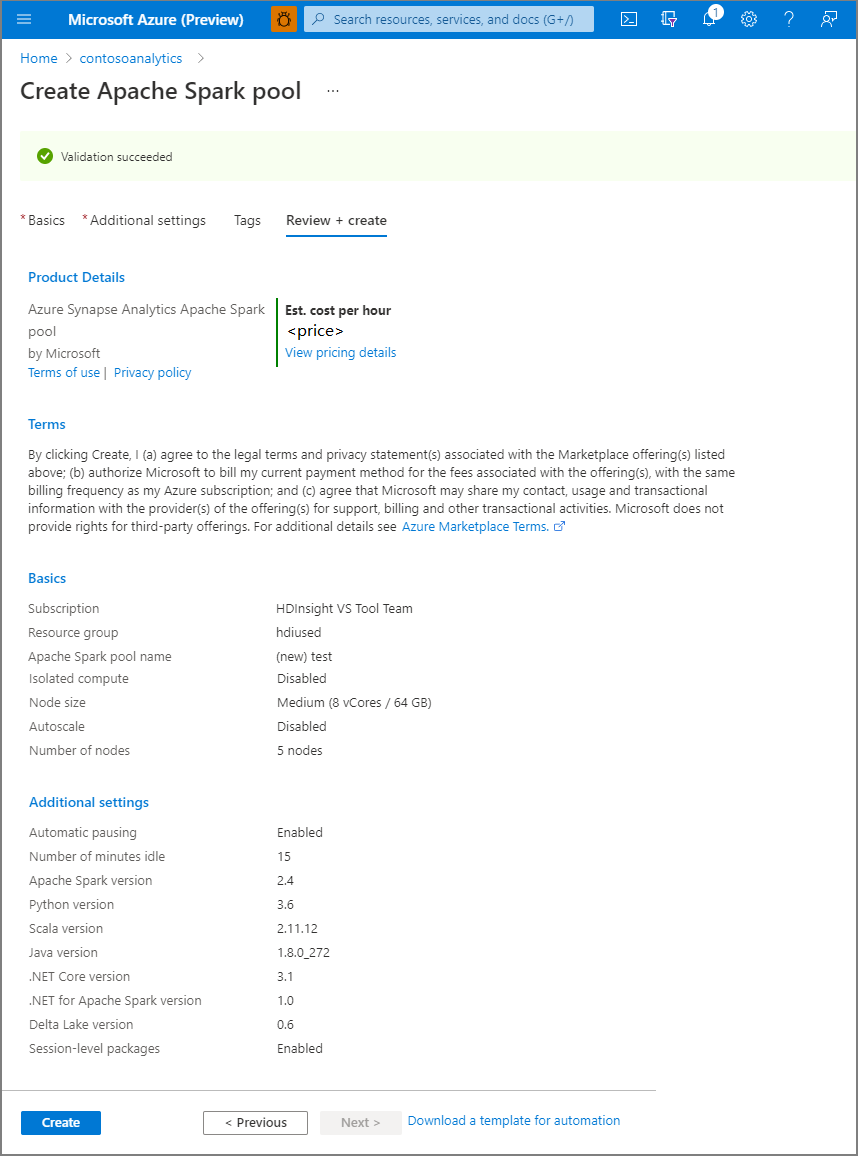

Review + create를 선택합니다.

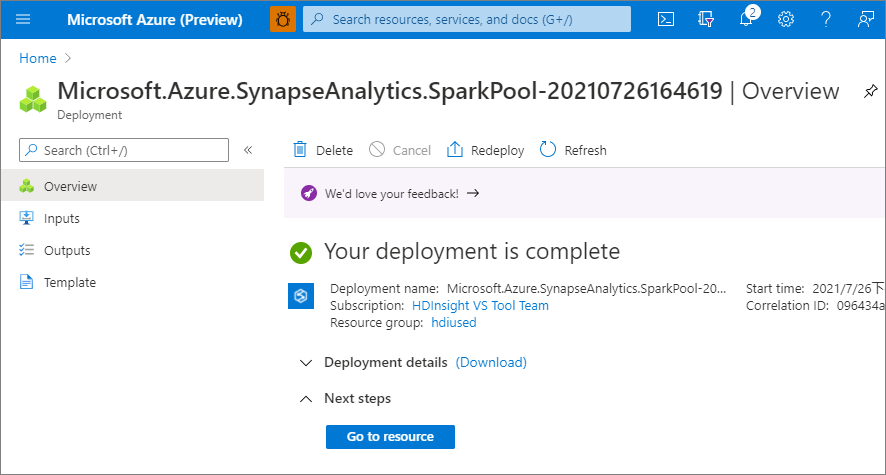

프로비전이 완료되면 작업 영역으로 다시 이동하면 새로 만든 Apache Spark 풀에 대한 새 항목이 표시됩니다.

이 시점에서는 실행 중인 리소스가 없고, Spark에 대한 요금이 부과되지 않으며, 만들려는 Spark 인스턴스에 대한 메타데이터를 만들었습니다.

자원을 정리하세요

다음 단계에서는 작업 영역에서 Apache Spark 풀을 삭제합니다.

경고

Apache Spark 풀을 삭제하면 작업 영역에서 분석 엔진이 제거됩니다. 더 이상 풀에 연결할 수 없으며 이 Apache Spark 풀을 사용하는 모든 쿼리, 파이프라인 및 Notebook이 더 이상 작동하지 않습니다.

Apache Spark 풀을 삭제하려면 다음 단계를 따릅니다.

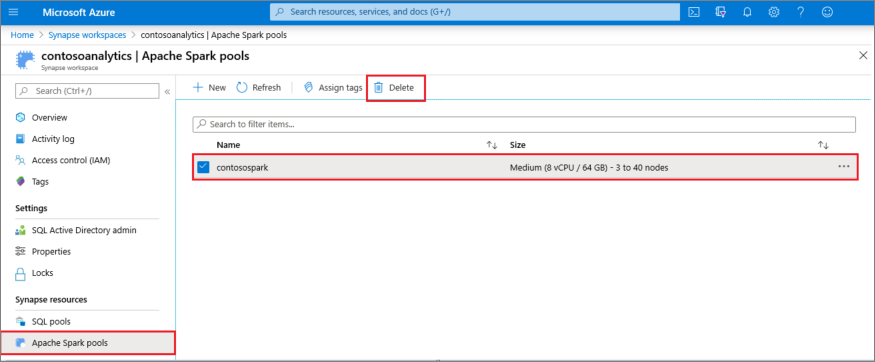

- 작업 영역에서 Apache Spark 풀 창으로 이동합니다.

- 삭제할 Apache Spark 풀을 선택합니다(이 경우 contosospark).

-

을 선택하고을 삭제합니다.

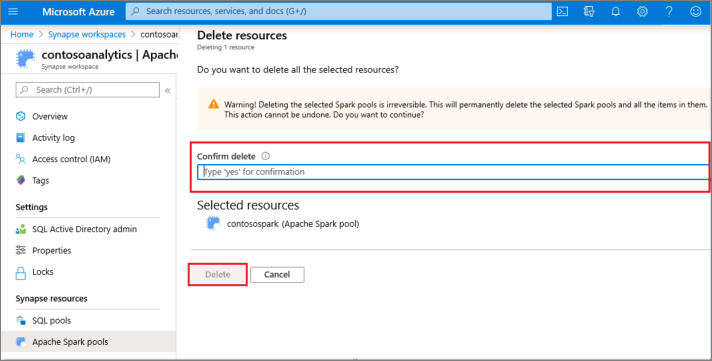

- 삭제를 확인하고 삭제 단추를 선택합니다.

- 프로세스가 성공적으로 완료되면 Apache Spark 풀이 작업 영역 리소스에 더 이상 나열되지 않습니다.