이 모듈은 파이프라인의 복사 작업을 사용하여 원본 저장소에서 데이터 레이크하우스의 브론즈 데이터 계층에 있는 테이블로 원시 데이터를 수집하는 데 10분이 걸립니다.

모듈 1의 개략적인 단계는 다음과 같습니다.

데이터 파이프라인 만들기

활성 구독이 있는 Microsoft Fabric 테넌넌트 계정이 필요합니다. 무료 계정을 만듭니다.

Microsoft Fabric 사용 작업 영역: 작업 영역 만들기가 있는지 확인합니다.

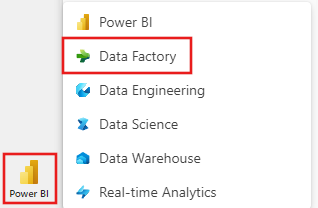

Power BI에 로그인합니다.

화면 왼쪽 아래에서 기본 Power BI 아이콘을 선택하고 Fabric선택합니다.

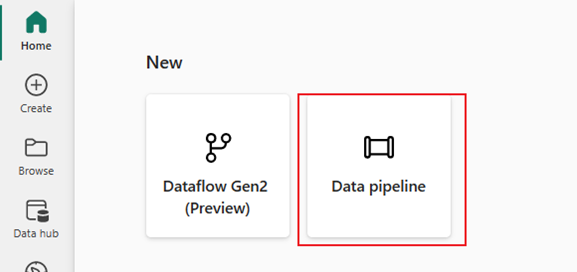

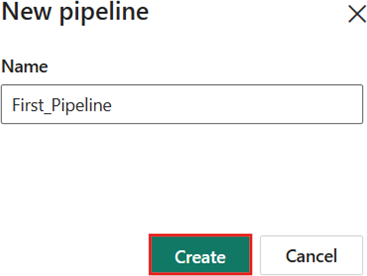

작업 영역 탭에서 작업 영역을 선택한 다음, + 새 항목선택하고 데이터 파이프라인 선택합니다. 파이프라인 이름을 제공합니다. 다음으로 만들기를 선택합니다.

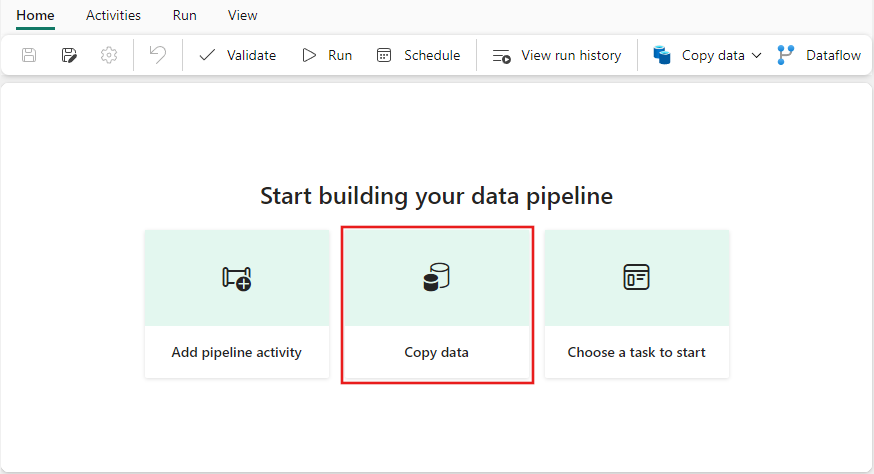

파이프라인에서 복사 작업을 사용하여 데이터 레이크하우스에 샘플 데이터를 로드하십시오.

1단계: 복사 도우미를 사용하여 복사 작업을 구성합니다.

복사 데이터 도우미를 선택하여 복사 도우미 도구를 엽니다.

2단계: 복사 도우미에서 설정을 구성합니다.

데이터 복사 대화 상자가 첫 번째 단계인 데이터 원본 선택과 함께 표시됩니다. 대화 상자 맨 위에 있는 옵션에서 샘플 데이터을 선택한 다음, NYC 택시 - 녹색을 선택합니다.

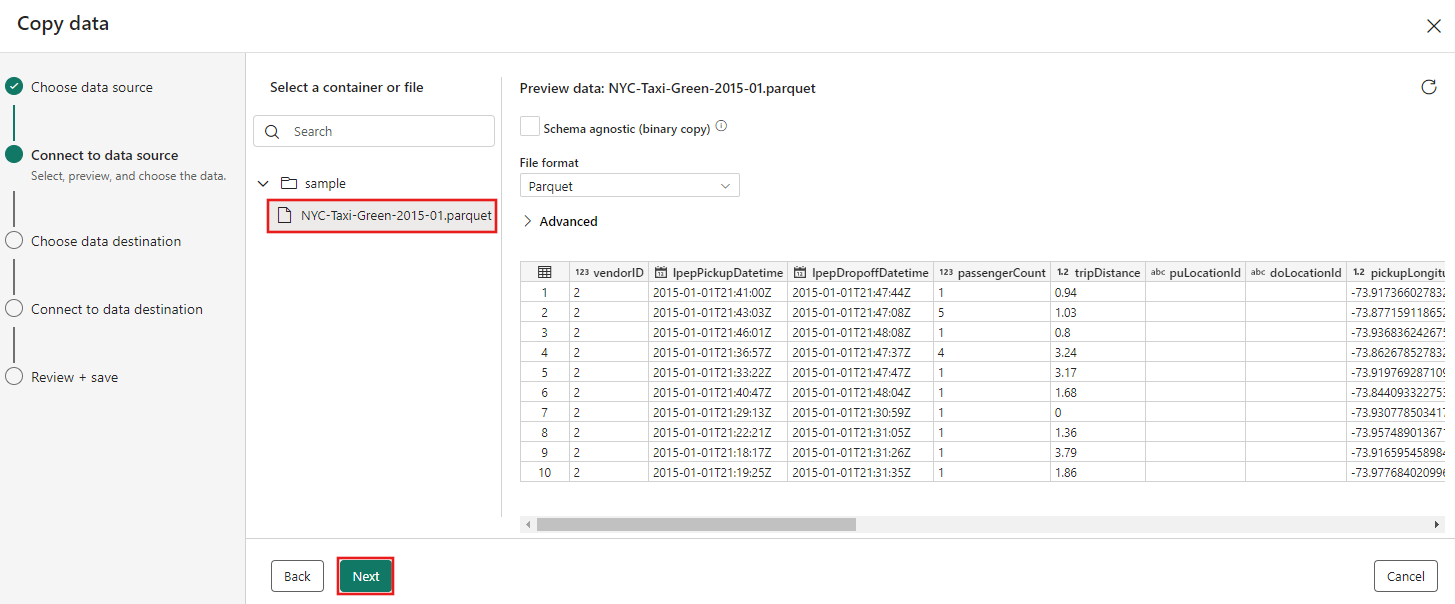

데이터 원본 미리 보기가 다음으로 데이터 원본 페이지에 나타납니다. 검토한 다음 선택합니다.

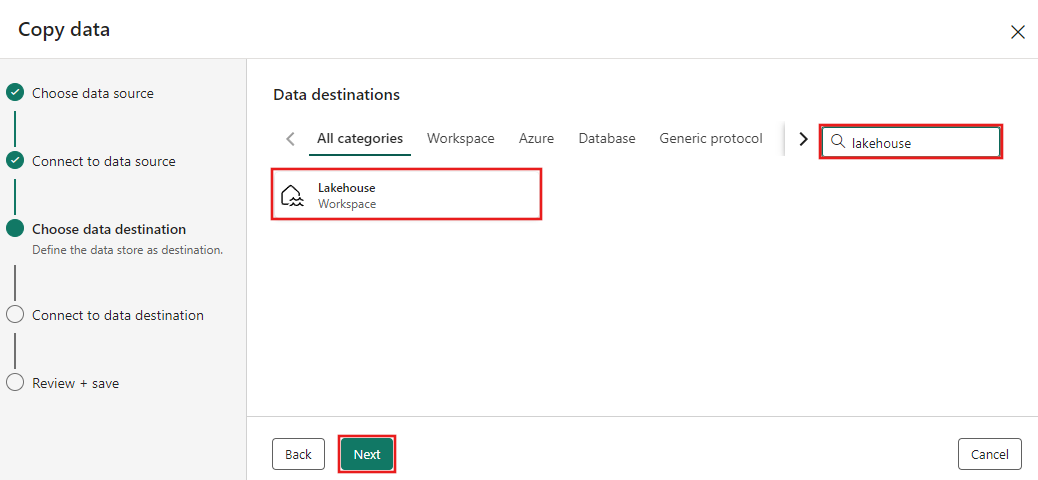

복사 도우미의 데이터 대상 단계를 선택하려면 Lakehouse선택합니다.

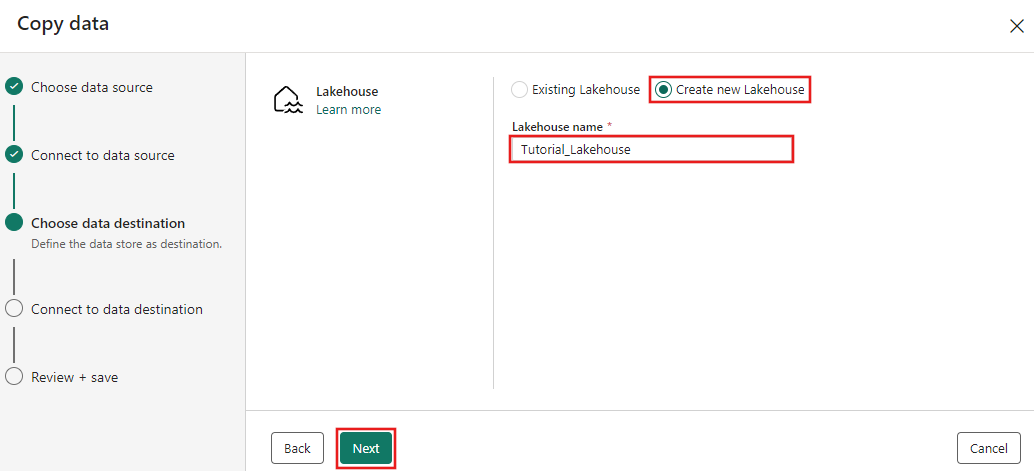

Lakehouse 이름을 입력한 다음 만들고연결합니다.

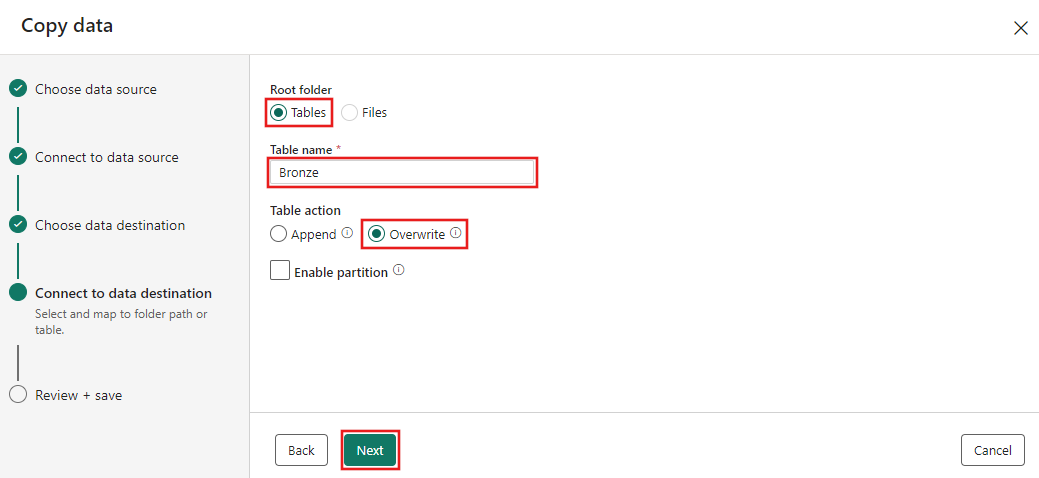

이제 선택에서 레이크하우스 대상의 세부 정보를 구성하고 폴더 경로 또는 테이블 페이지에 매핑합니다. 루트 폴더테이블 선택하고 로드 설정새 테이블 로드를. 테이블 이름을 입력하고 다음을 선택합니다.

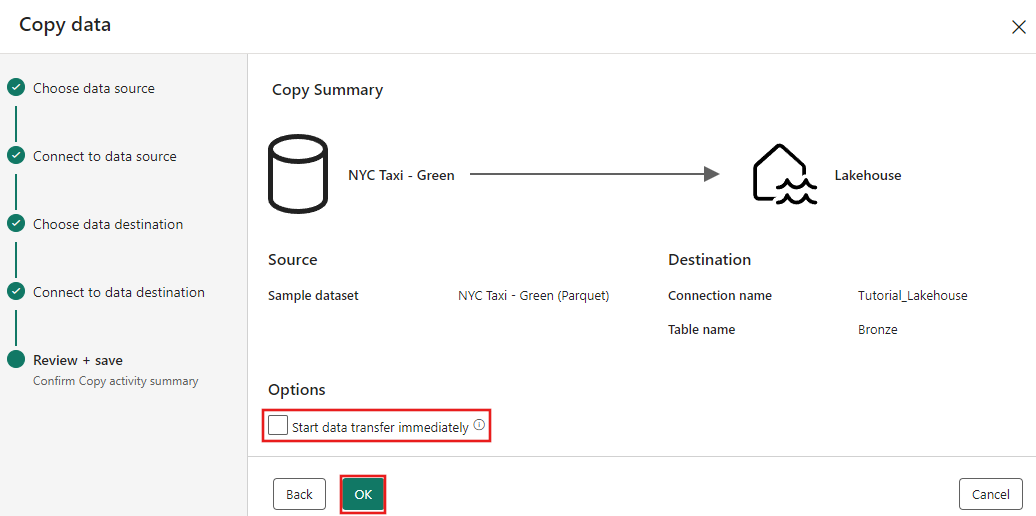

마지막으로 복사 데이터 도우미의 검토 + 저장 페이지에서 구성을 검토합니다. 이 자습서에서는 다음 단계에서 작업을 수동으로 실행하므로 데이터 전송 즉시 시작 확인란의 선택을 취소합니다. 그런 다음 확인을 선택합니다.

3단계: 복사 작업 결과를 실행하고 확인합니다.

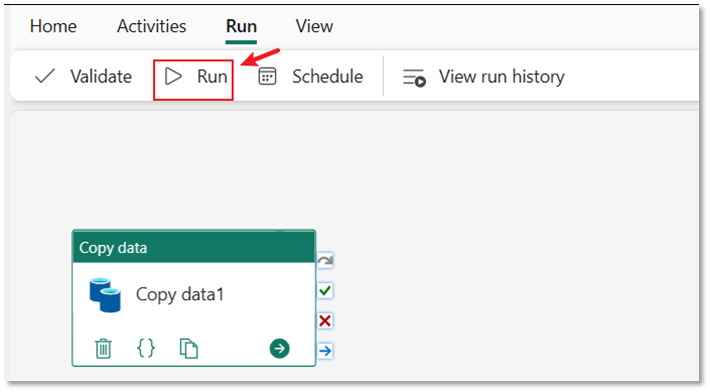

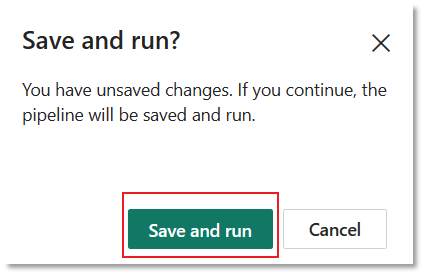

파이프라인 편집기에서 실행 탭을 선택합니다. 그런 다음 실행 버튼을 선택한 다음, 프롬프트에서 저장하고 실행하여 복사 작업 실행합니다.

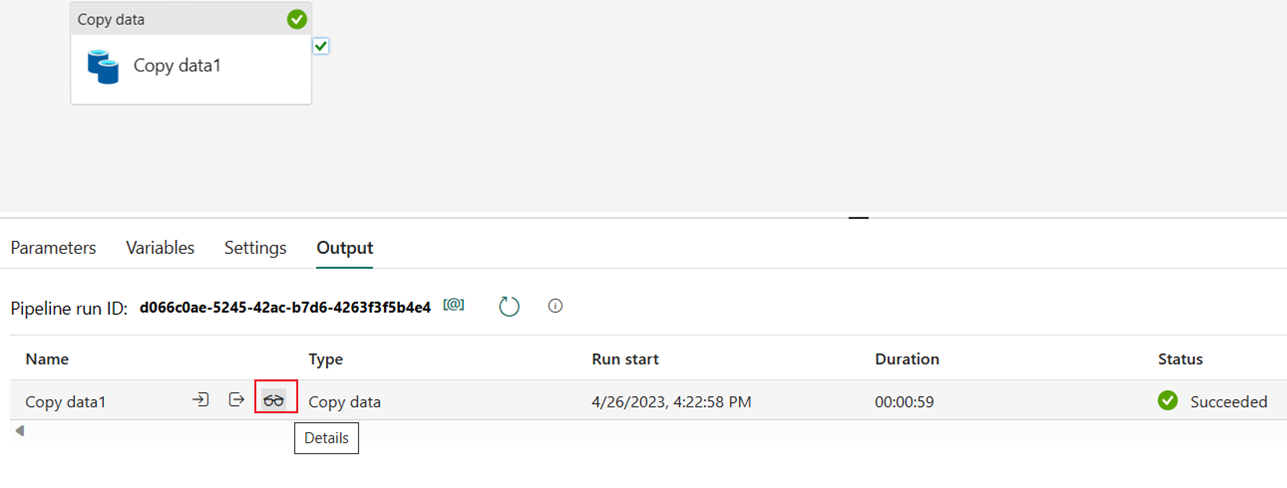

실행을 모니터링하고 파이프라인 캔버스 아래의 출력 탭에서 결과를 확인할 수 있습니다. 파이프라인의 이름을 선택하여 실행 세부 정보를 봅니다.

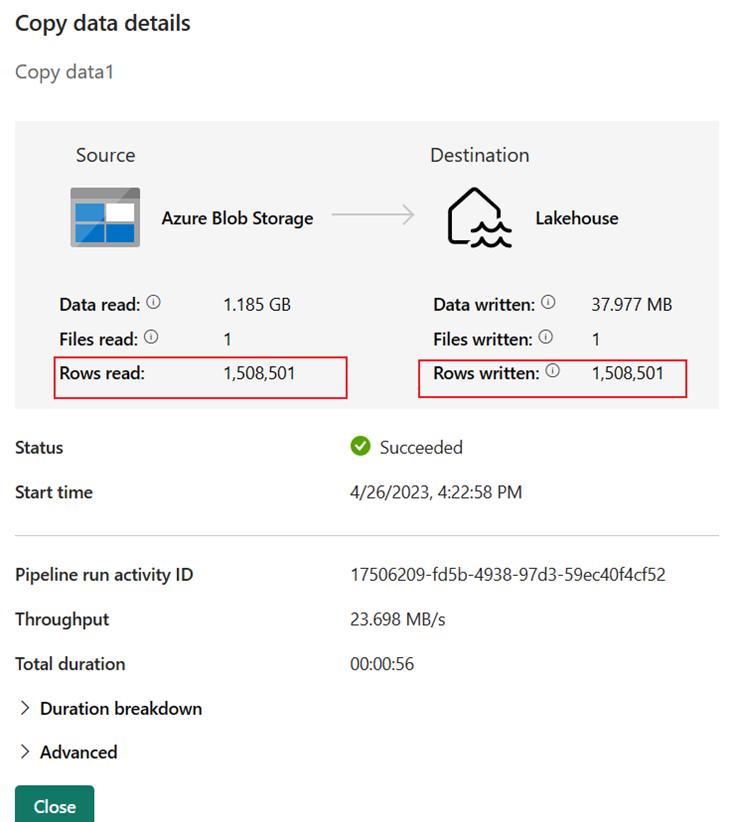

실행 세부 정보에는 읽고 쓴 1,508,501개의 행이 표시됩니다.

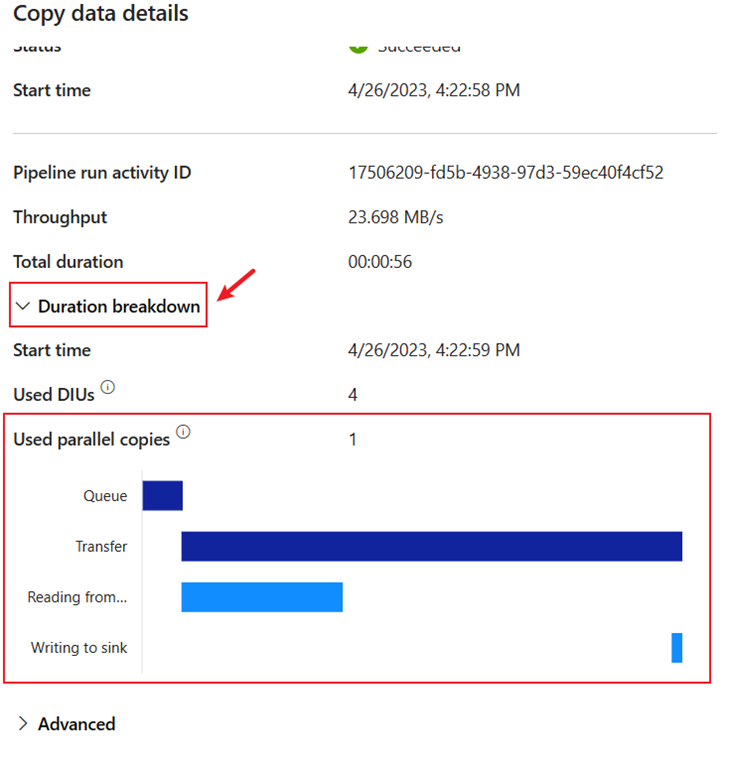

기간 분석 구역을 확장하여 복사 작업 각 단계의 기간을 확인합니다. 복사 세부 정보를 검토한 후 닫기를 선택합니다.

관련 콘텐츠

Microsoft Fabric에서 Data Factory를 사용하여 첫 번째 데이터 통합을 위한 엔드 투 엔드 자습서의 첫 번째 모듈에서는 다음 방법을 알아보았습니다.

- 데이터 파이프라인 만들기.

- 파이프라인에 복사 작업을 추가하세요.

- 샘플 데이터를 사용하여 데이터 레이크하우스를 생성하고, 데이터를 새 테이블에 저장합니다.

- 파이프라인을 실행하고 세부 정보 및 기간 분석을 확인합니다.

이제 다음 구역으로 이동하여 데이터 흐름을 만듭니다.