한눈에 보기

목표: 로컬 LLM을 사용하여 OpenAI 시뮬레이션

시간: 15분

플러그 인:OpenAIMockResponsePlugin

필수 구성 요소:개발 프록시, 로컬 언어 모델 설정

OpenAI에 연결된 앱을 빌드할 때 앱의 일부만 OpenAI API와 상호 작용하는 경우가 많습니다. OpenAI API에서 실제 회신이 필요하지 않은 앱 부분에서 작업하는 경우 개발자 프록시를 사용하여 응답을 시뮬레이션할 수 있습니다. 시뮬레이션된 응답을 사용하면 불필요한 비용이 발생하지 않도록 할 수 있습니다.

OpenAIMockResponsePlugin 로컬 언어 모델을 사용하여 OpenAI API의 응답을 시뮬레이션합니다.

시작하기 전에

Dev Proxy를 사용하여 OpenAI API 응답을 시뮬레이션하려면 지원되는 언어 모델 클라이언트가 컴퓨터에 설치되어 있어야 합니다.

기본적으로 Dev Proxy는 Ollama에서 실행되는 llama3.2 언어 모델을 사용합니다. 다른 클라이언트 또는 모델을 사용하려면 Dev Proxy 구성 파일에서 언어 모델 설정을 업데이트합니다.

OpenAI API 응답을 시뮬레이션하도록 개발 프록시 구성

팁

이 자습서에 설명된 단계는 바로 사용할 수 있는 개발 프록시 사전 설정에서 사용할 수 있습니다. 사전 설정을 사용하려면 명령줄에서 명령을 실행하고 devproxy config get simulate-openai지침을 따릅니다.

Dev Proxy를 사용하여 OpenAI API 응답을 시뮬레이션하려면 OpenAIMockResponsePlugin 파일에서 devproxyrc.json를 활성화해야 합니다.

파일: devproxyrc.json

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v2.0.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/DevProxy.Plugins.dll"

}

]

}

다음으로 OpenAI API에 대한 요청을 가로채도록 개발 프록시를 구성합니다. OpenAI는 최신 모델 및 기능을 활용할 수 있는 엔드포인트를 사용하는 https://api.openai.com/v1/chat/completions 것이 좋습니다.

파일: devproxyrc.json(루트 수준에 추가)

{

// [...] trimmed for brevity

"urlsToWatch": [

"https://api.openai.com/v1/chat/completions"

]

}

마지막으로, 로컬 언어 모델을 사용하도록 개발 프록시를 구성합니다.

파일: devproxyrc.json(루트 수준에 추가)

{

// [...] trimmed for brevity

"languageModel": {

"enabled": true

}

}

전체 구성 파일은 다음과 같습니다.

파일: devproxyrc.json(완료)

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v2.0.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/DevProxy.Plugins.dll"

}

],

"urlsToWatch": [

"https://api.openai.com/v1/chat/completions"

],

"languageModel": {

"enabled": true

}

}

OpenAI API 응답 시뮬레이션

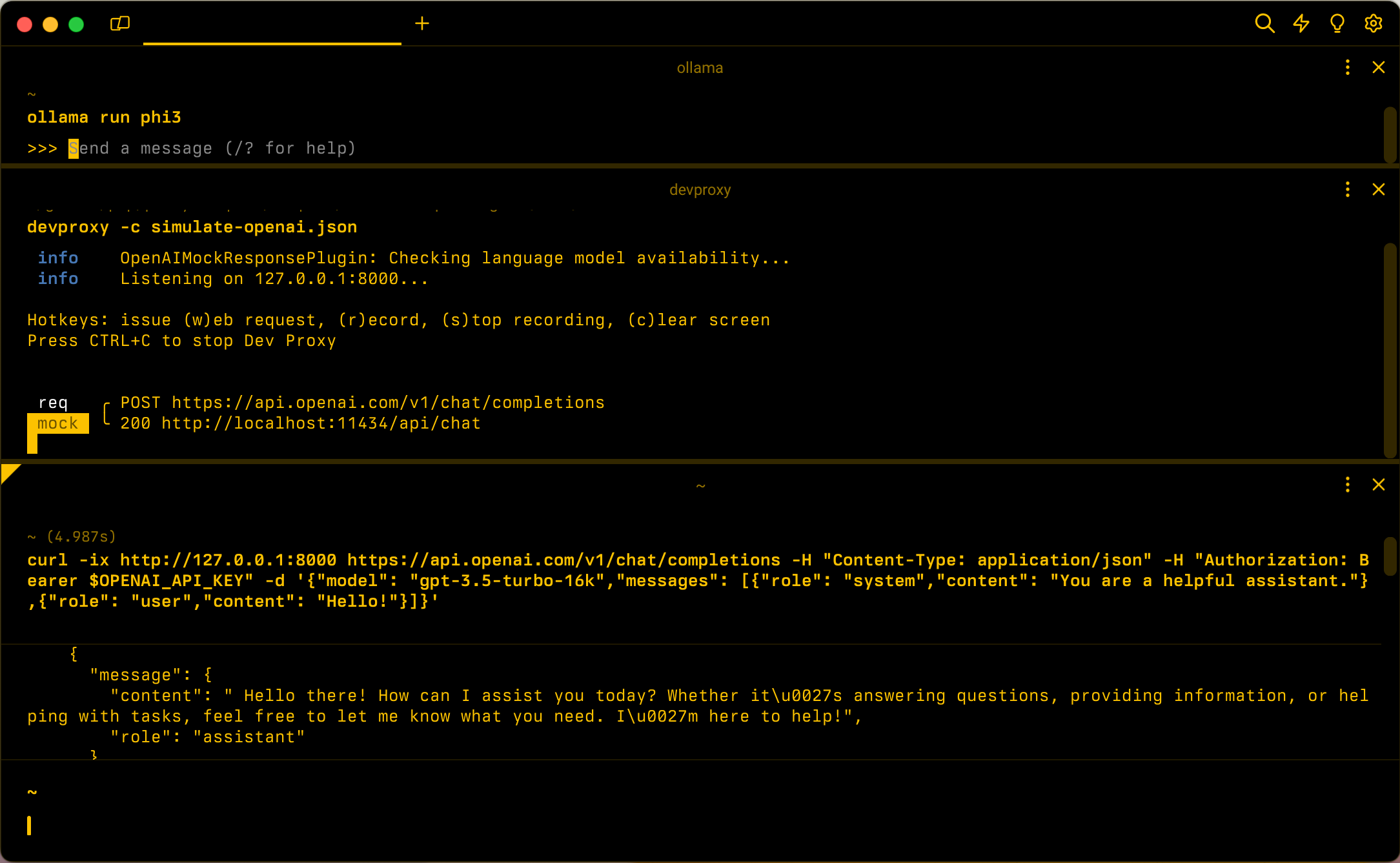

기본 구성을 가정하고 llama3.2 언어 모델로 Ollama를 시작합니다. 명령줄에서 .를 실행합니다 ollama run llama3.2.

다음으로 Dev 프록시를 시작합니다. 사전 설정을 사용하는 경우 를 실행합니다 devproxy -c "~appFolder/config/simulate-openai/simulate-openai.json. 현재 작업 디렉터리에 저장된 명명 devproxyrc.json된 사용자 지정 구성 파일을 사용하는 경우 실행 devproxy합니다. Dev Proxy는 Ollama의 언어 모델에 액세스할 수 있는지 확인하고 OpenAI API 응답을 시뮬레이션할 준비가 되었는지 확인합니다.

info OpenAIMockResponsePlugin: Checking language model availability...

info Listening on 127.0.0.1:8000...

Hotkeys: issue (w)eb request, (r)ecord, (s)top recording, (c)lear screen

Press CTRL+C to stop Dev Proxy

애플리케이션을 실행하고 OpenAI API에 요청합니다. 개발자 프록시는 요청을 가로채고 로컬 언어 모델을 사용하여 응답을 시뮬레이션합니다.

다음 단계

OpenAIMockResponsePlugin에 대해 자세히 알아봅니다.

샘플

관련 개발 프록시 샘플도 참조하세요.

Dev Proxy