Azure Databricks의 데이터 탐색 도구

원본에서 데이터를 수집한 후 Azure Databricks 플랫폼을 사용하여 공동으로 데이터를 탐색하고 분석할 수 있습니다.

Azure Databricks에서 데이터 작업 시 사용하는 도구를 살펴보겠습니다.

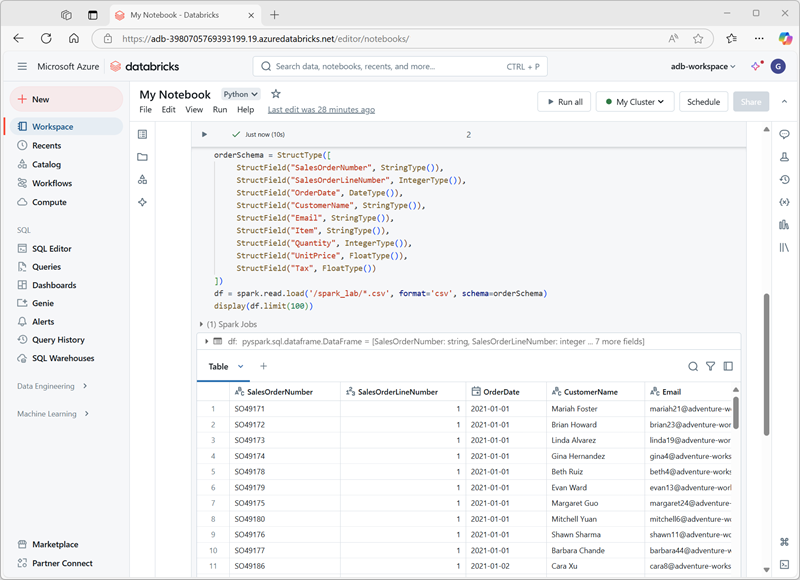

Notebook을 사용하여 코드 공동 작업 및 실행

Azure Databricks의 Notebook을 사용하여 Python, SQL, Scala 또는 R 코드를 작성하여 데이터를 탐색하고 시각화할 수 있습니다. Notebooks는 대화형 데이터 탐색을 지원하며 팀 멤버들 간에 공유할 수 있습니다. 또한 데이터 과학자가 데이터의 형태와 콘텐츠를 이해할 수 있도록 데이터 프로파일링 기능도 지원합니다.

기본 제공 시각화를 사용하여 데이터 배포, 추세 및 패턴을 빠르게 이해할 수 있습니다. Azure Databricks를 사용하면 기본 제공 기능 외에도 Matplotlib, Seaborn, D3.js와 같이 일반적으로 사용되는 오픈 소스 라이브러리와 통합하여 보다 복잡한 시각화를 구현할 수 있습니다.

Spark DataFrames로 작업

Notebook에서 데이터를 사용하는 경우 Apache Spark를 기반으로 하는 Spark DataFrame을 사용합니다. DataFrames를 사용하면 대용량 데이터 세트를 효율적으로 조작할 수 있습니다.

예를 들어 간단한 DataFrame을 만들려면 다음 코드를 실행할 수 있습니다.

data = [("Alice", 34), ("Bob", 45), ("Cathy", 29)]

columns = ["Name", "Age"]

df = spark.createDataFrame(data, columns)

DataFrames는 데이터 탐색에 중요한 필터링, 집계, 조인과 같은 작업을 지원합니다.

예를 들어, DataFrame을 필터링할 수 있습니다.

filtered_df = df.filter(df["Age"] > 30)

또한 Azure Databricks는 DataFrame 작업과 SQL 쿼리 간에 전환하여 가장 자연스러운 방식으로 데이터와 상호 작용할 수 있도록 하여 SQL 을 지원합니다.

SQL 쿼리를 사용하여 DataFrame을 필터링하려면 먼저 임시 뷰를 만듭니다.

df.createOrReplaceTempView("people")

sql_df = spark.sql("SELECT Name, Age FROM people WHERE Age > 30")

팁

데이터 프레임에 대한 자세한 내용은 자습서: Apache Spark DataFrames를 사용하여 데이터 로드 및 변환을 참조하세요.

라이브러리와 API를 사용하여 데이터 탐색

데이터를 어떻게 활용하느냐에 따라, 원하는 데이터 처리 단계를 수행할 수 있는 기능을 제공하는 특정 라이브러리와 API가 필요합니다.

오픈 소스 라이브러리 설치

데이터 분석가, 데이터 엔지니어 또는 데이터 과학자로서 기본 오픈 소스 라이브러리를 사용하여 데이터를 탐색하고 처리할 수 있습니다. Azure Databricks를 사용하면 Pandas, NumPy, Scikit-learn과 같은 Python 라이브러리를 설치하여 추가적인 데이터 분석 기능을 사용할 수 있습니다.

팁

Azure Databricks에서 라이브러리를 사용하는 방법에 대한 자세한 내용은 라이브러리를 참조 하세요.

기계 학습 워크로드에 MLlib 사용

기계 학습 모델을 학습하여 데이터를 탐색하고 처리하기 위해 도움을 받을 수 있습니다. Spark의 MLlib를 사용하면 Notebook에 연결된 분산 컴퓨팅 클러스터를 최적으로 활용할 수 있습니다. MLlib 라이브러리를 사용하면 클러스터링, 회귀, 분류와 같은 기계 학습 기술을 적용하여 데이터 속에 숨겨진 복잡한 패턴을 발견하는 데 도움이 됩니다.

외부 시각화 도구를 사용하여 데이터 시각화

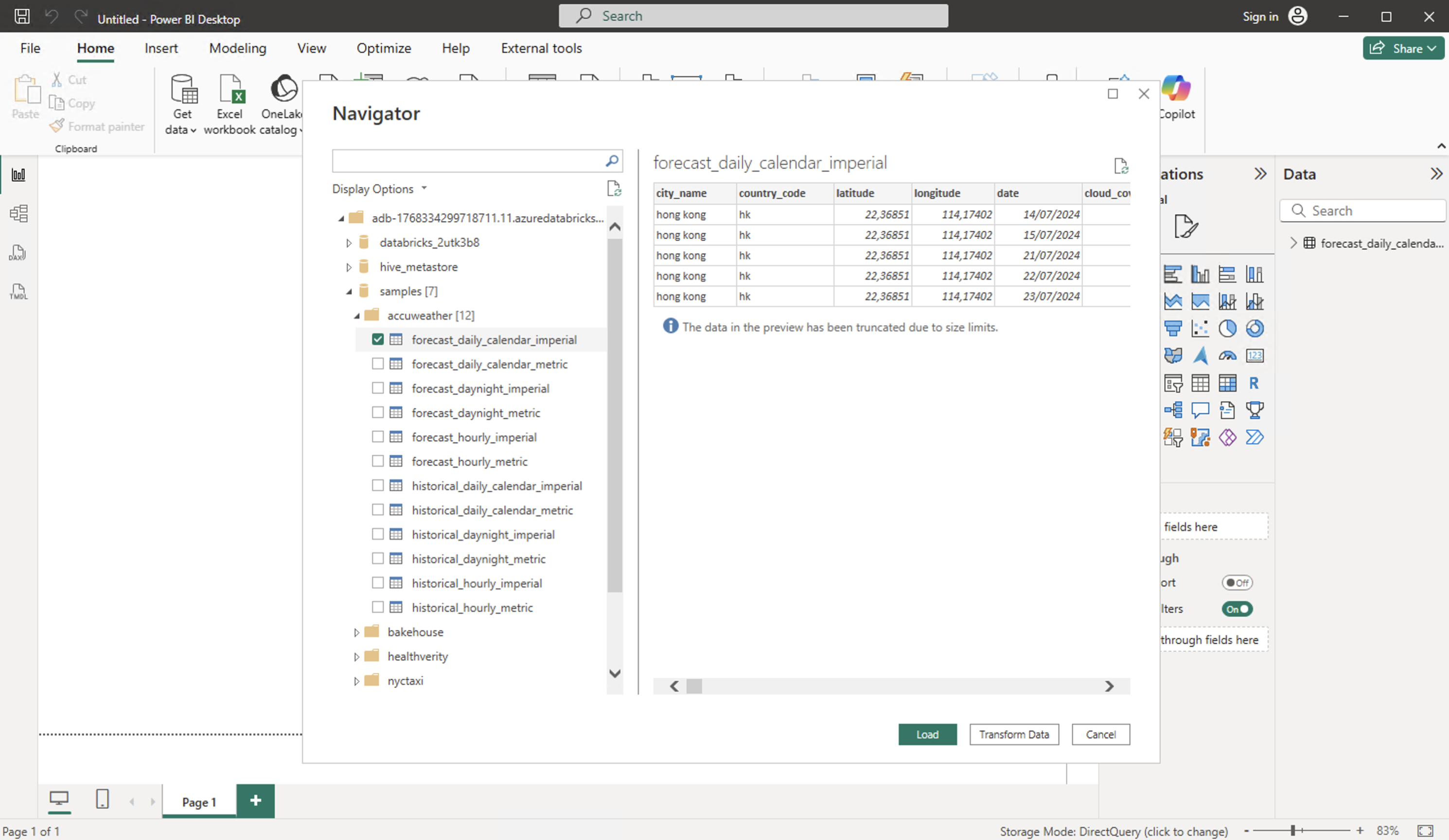

기본 제공 차트 옵션 외에도 Azure Databricks는 향상된 대시보드 기능을 위해 Tableau 또는 Power BI와 같은 외부 시각화 도구와 통합됩니다.

Power BI Desktop을 Azure Databricks 클러스터 및 Databricks SQL 웨어하우스에 연결할 수 있습니다. Power BI 서비스에 Power BI 보고서를 게시하고 사용자가 SSO(Single Sign-On)를 사용하여 기본 Azure Databricks 데이터에 액세스할 수 있도록 하여 보고서에 액세스하는 데 사용하는 것과 동일한 Microsoft Entra ID 자격 증명을 전달할 수도 있습니다.

Power BI Desktop에서 Azure Databricks를 연결하는 방법에는 여러 가지가 있습니다.

파트너 연결을 사용하여 Azure Databricks에 연결: 최소한의 수동 단계로 Databricks SQL Warehouse에 연결하도록 Power BI를 자동으로 구성하는 Databricks의 단계별 설정입니다.

Azure Databricks에 수동으로 연결: Power BI Databricks 커넥터를 사용하고, 작업 영역 SQL 웨어하우스 엔드포인트를 입력하고, 인증하여 연결을 설정하는 수동 프로세스입니다.

Power BI 델타 공유 커넥터: Power BI가 Databricks 작업 영역 또는 클러스터에 직접 액세스할 필요 없이 델타 공유를 통해 공유 델타 테이블을 쿼리할 수 있도록 하는 커넥터입니다.

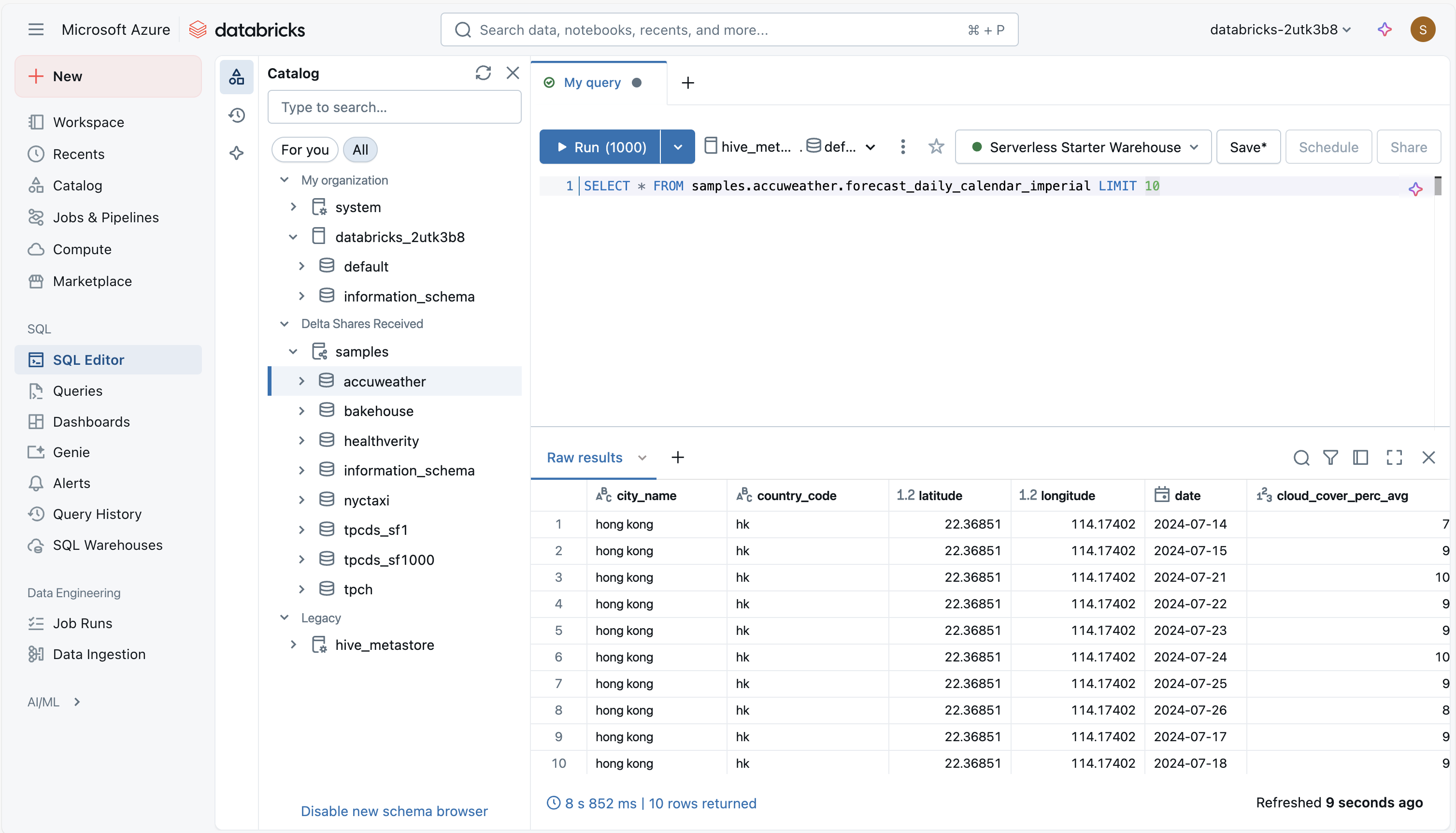

SQL 편집기에서 데이터 탐색

Azure Databricks의 SQL 편집기는 레이크하우스의 데이터에 대해 SQL 쿼리를 작성하고 실행할 수 있는 작업 영역입니다. 표준 SQL 명령을 지원하며 구문 강조 표시, 자동 완성 및 이전 쿼리의 기록과 같은 유용한 기능을 포함합니다. 이렇게 하면 쿼리를 더 쉽게 시도하고, 구체화하고, 이미 탐색한 내용을 추적할 수 있습니다.

탐색을 시작하려면 카탈로그 탐색기 창을 사용하여 사용 가능한 데이터베이스, 스키마 및 테이블을 확인할 수 있습니다. 테이블을 선택하면 쿼리를 실행하기 전에 구조를 이해할 수 있도록 해당 열과 데이터 형식이 표시됩니다. 여기에서 쿼리를 작성하여 샘플 행을 보거나, 결과를 필터링하거나, 집계를 적용하여 데이터의 내용과 품질을 빠르게 파악할 수 있습니다. 결과는 기본적으로 테이블 형식으로 표시되지만 패턴이나 추세를 파악하는 간단한 차트로 볼 수도 있습니다.

또한 SQL 편집기를 사용하면 나중에 사용할 쿼리를 저장하고 반복 가능한 탐색을 위해 구성할 수 있습니다. 매개 변수를 추가하여 저장된 쿼리를 조정하거나 동일한 데이터에서 작업하는 팀원과 공유할 수 있습니다. 정기적으로 결과가 필요한 경우 쿼리를 예약하거나 대시보드에 추가하여 더 쉽게 액세스할 수 있습니다. 이러한 기능을 통해 SQL 편집기에서는 Databricks를 종료하지 않고도 데이터를 검사, 쿼리 및 분석할 수 있는 실질적인 방법을 제공합니다.

이러한 도구를 통해 Azure Databricks는 기본 데이터 정리부터 고급 기계 학습 프로젝트까지 모든 것을 처리하는 유연한 데이터 탐색 플랫폼이 됩니다.