Overvåking av Apache Spark-programdetaljer

Med Microsoft Fabric kan du bruke Apache Spark til å kjøre notatblokker, jobber og andre typer programmer i arbeidsområdet. Denne artikkelen forklarer hvordan du overvåker Apache Spark-programmet, slik at du kan holde et øye med statusen for nylige kjøringer, problemer og fremdriften til jobbene dine.

Vis Apache Spark-programmer

Du kan vise alle Apache Spark-programmer fra Spark-jobbdefinisjon, eller hurtigmenyen for notatblokkelementer viser det nylige kjørealternativet –>Nylige kjøringer.

Du kan velge navnet på programmet du vil vise i programlisten, på programdetaljersiden kan du vise programdetaljene.

Overvåk Apache Spark-programstatus

Åpne nylig brukte kjøringer-siden i notatblokken eller Spark-jobbdefinisjonen, og du kan vise statusen for Apache-programmet.

- Suksess

- I kø

- Stoppet

- Kansellert

- Mislykket

Prosjekter

Åpne en Apache Spark-programjobb fra hurtigmenyen Spark-jobbdefinisjon eller notatblokkelement , som viser alternativet For nylig kjøring –> Nylige kjøringer –> velg en jobb på siden for nylige kjøringer.

På siden med overvåkingsdetaljer for Apache Spark-programmet vises listen over jobbkjøringer i kategorien Jobber, du kan vise detaljene for hver jobb her, inkludert jobb-ID, beskrivelse, status, faser, oppgaver, varighet, behandlet, datalesing, dataskrevet og kodesnutt.

- Hvis du klikker jobb-ID, kan du vise/skjule jobben.

- Klikk på stillingsbeskrivelsen, du kan hoppe til jobb- eller scenesiden i spark-brukergrensesnittet.

- Klikk på kodesnutten for jobben, du kan kontrollere og kopiere koden som er relatert til denne jobben.

Ressurser (forhåndsvisning)

Eksekutorbruksgrafen viser visuelt tildelingen av Spark-jobb-eksekutorer og ressursbruk. For øyeblikket vises bare kjøretidsinformasjonen for spark 3.4 og nyere denne funksjonen. Velg Ressurser (forhåndsversjon), og deretter tegnes fire typer kurver om kjørerbruk, inkludert kjøring, inaktiv, tildelt, maksimalt antall forekomster.

For Tildelt refererer du til kjernesituasjonen som tildeles under kjøringen av Spark-programmet.

For maksimumsforekomster refererer du til maksimalt antall kjerner som er tildelt Spark-programmet.

Når det gjelder kjøring, refererer du til det faktiske antallet kjerner som brukes av Spark-programmet når det kjører. Klikk på et tidspunkt mens spark-programmet kjører. Du kan se kjernetildelingsdetaljene for den kjørende eksekutoren nederst i grafen.

For Idled er det antall ubrukte kjerner mens Spark-programmet kjører.

I noen tilfeller kan antallet aktiviteter på et tidspunkt overskride kapasiteten til eksekutorkjernene (det vil eksempelvis > totalt antallet eksekutorkjerner / spark.task.cpus). Dette er som forventet, fordi det er tidsgap mellom en aktivitet merket som kjører, og den kjører faktisk på en eksekutorkjerne. Så noen oppgaver kan vises som kjører, men det kjører ikke på noen kjerne.

Velg fargeikonet for å merke eller fjerne merkingen av det tilsvarende innholdet i hele grafen.

Sammendragspanel

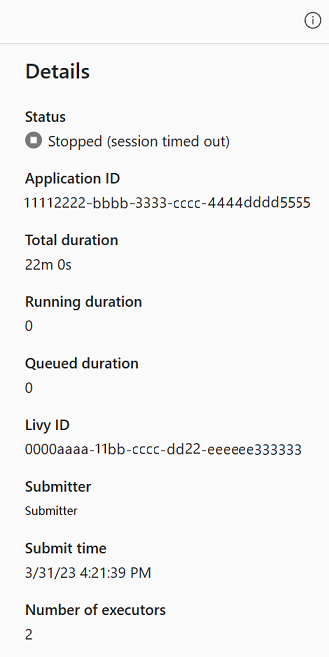

Klikk Egenskaper-knappen på overvåkingssiden for Apache Spark-programmet for å åpne/skjule sammendragspanelet. Du kan vise detaljene for dette programmet i Detaljer.

- Status for spark-programmet.

- Spark-programmets ID.

- Total varighet.

- Kjørevarighet for spark-programmet.

- Varighet i kø for spark-programmet.

- Livy-ID

- Innsendr for spark-programmet.

- Send inn tid for spark-programmet.

- Antall eksekutorer.

Logger

For Logger-fanen kan du vise den fullstendige loggen av Livy, Prelaunch, Driverlogg med forskjellige alternativer valgt i venstre panel. Du kan også hente den nødvendige logginformasjonen direkte ved å søke i nøkkelord og vise loggene ved å filtrere loggstatusen. Klikk Last ned logg for å laste ned logginformasjonen til den lokale.

Noen ganger er ingen logger tilgjengelige, for eksempel statusen for jobben i kø, og oppretting av klynge mislyktes.

Live-logger er bare tilgjengelige når appinnsending mislykkes, og driverlogger er også angitt.

Data

For Data-fanen kan du kopiere datalisten på utklippstavlen, laste ned datalisten og enkeltdata og kontrollere egenskapene for hver data.

- Venstre panel kan utvides eller skjules.

- Navnet, leseformatet, størrelsen, kilden og banen til inndata- og utdatafilene vises i denne listen.

- Filene i inndata og utdata kan lastes ned, kopiere bane- og visningsegenskaper.

Relaterte elementer

Med fanen Relaterte elementer kan du bla gjennom og vise elementer som er knyttet til Apache Spark-programmet, inkludert notatblokker, Spark-jobbdefinisjon og/eller pipeliner. Siden for relaterte elementer viser øyeblikksbildet av kode- og parameterverdiene på tidspunktet for kjøring for notatblokker. Den viser også øyeblikksbildet av alle innstillinger og parametere på tidspunktet for innsending for Spark-jobbdefinisjoner. Hvis Apache Spark-programmet er knyttet til et datasamlebånd, presenterer den relaterte elementsiden også det tilsvarende datasamlebåndet og Spark-aktiviteten.

Du kan gjøre følgende i skjermbildet Relaterte elementer:

- Bla gjennom og naviger de relaterte elementene i det hierarkiske treet.

- Klikk ellipseikonet «En liste over flere handlinger» for hvert element for å utføre forskjellige handlinger.

- Klikk øyeblikksbildeelementet for å vise innholdet.

- Vis brødsmulen for å se banen fra det valgte elementet til roten.

Diagnostikk

Diagnosepanelet gir brukerne anbefalinger i sanntid og feilanalyse, som genereres av Spark Advisor gjennom en analyse av brukerens kode. Med innebygde mønstre hjelper Apache Spark Advisor brukere med å unngå vanlige feil og analysere feil for å identifisere grunnårsaken.

Relatert innhold

Neste trinn etter at du har vist detaljene i et Apache Spark-program, er å vise Fremdrift for Spark-jobben under notatblokkcellen. Du kan referere til: