Azure Data Lake Storage Gen1 gebruiken voor vereisten voor big data

Notitie

Azure Data Lake Storage Gen1 is nu buiten gebruik gesteld. Bekijk hier de aankondiging van de buitengebruikstelling. Data Lake Storage Gen1-resources zijn niet meer toegankelijk.

Er zijn vier belangrijke fasen in de verwerking van big data:

- Grote hoeveelheden gegevens opnemen in een gegevensarchief, in realtime of in batches

- De gegevens verwerken

- De gegevens downloaden

- De gegevens visualiseren

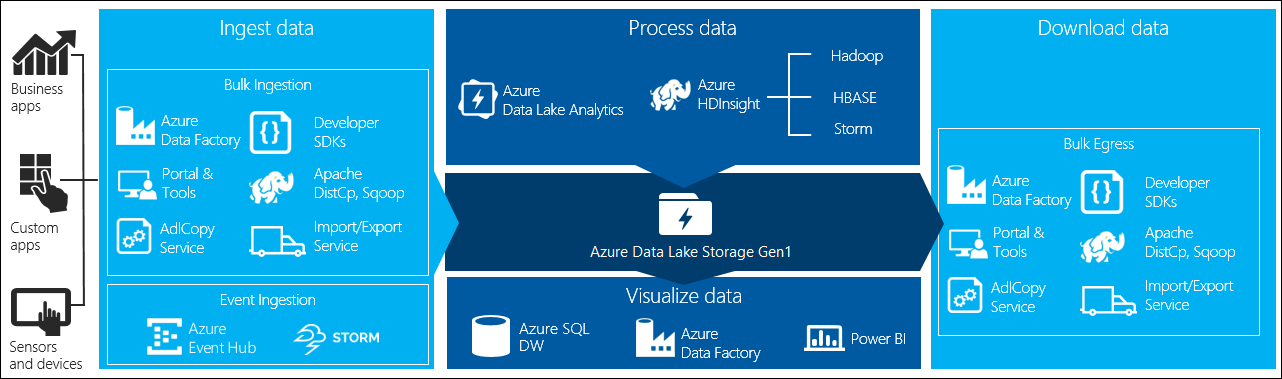

In dit artikel bekijken we deze fasen met betrekking tot Azure Data Lake Storage Gen1 om inzicht te hebben in de opties en hulpprogramma's die beschikbaar zijn om te voldoen aan uw big data-behoeften.

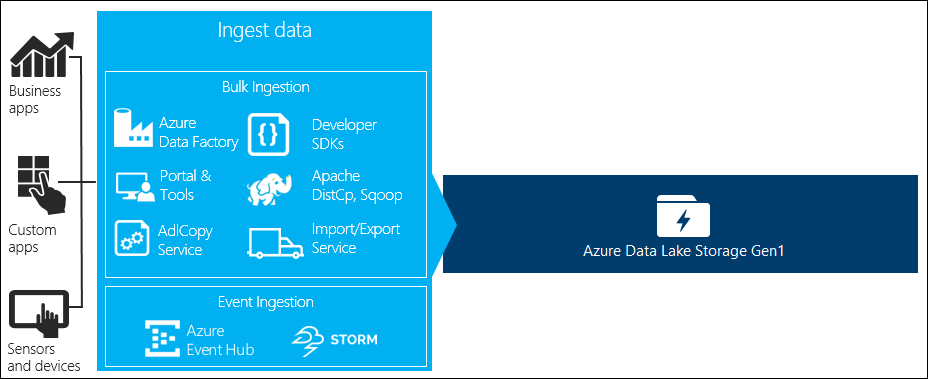

Gegevens opnemen in Data Lake Storage Gen1

In deze sectie worden de verschillende gegevensbronnen en de verschillende manieren beschreven waarop die gegevens kunnen worden opgenomen in een Data Lake Storage Gen1-account.

Ad-hocgegevens

Dit vertegenwoordigt kleinere gegevenssets die worden gebruikt voor het maken van prototypen van een big data-toepassing. Er zijn verschillende manieren om ad-hocgegevens op te nemen, afhankelijk van de bron van de gegevens.

| Gegevensbron | Opnemen met behulp van |

|---|---|

| Lokale computer | |

| Azure Storage Blob |

Gestreamde gegevens

Dit vertegenwoordigt gegevens die kunnen worden gegenereerd door verschillende bronnen, zoals toepassingen, apparaten, sensoren, enzovoort. Deze gegevens kunnen worden opgenomen in Data Lake Storage Gen1 door verschillende hulpprogramma's. Met deze hulpprogramma's worden de gegevens meestal in realtime vastgelegd en verwerkt, en worden de gebeurtenissen vervolgens in batches naar Data Lake Storage Gen1 geschreven, zodat ze verder kunnen worden verwerkt.

Hieronder vindt u hulpprogramma's die u kunt gebruiken:

- Azure Stream Analytics : gebeurtenissen die zijn opgenomen in Event Hubs, kunnen worden geschreven naar Azure Data Lake Storage Gen1 met behulp van een Azure Data Lake Storage Gen1-uitvoer.

- EventProcessorHost : u kunt gebeurtenissen ontvangen van Event Hubs en deze vervolgens naar Data Lake Storage Gen1 schrijven met behulp van de Data Lake Storage Gen1 .NET SDK.

Relationele gegevens

U kunt ook gegevens uit relationele databases ophalen. In de loop van de tijd verzamelen relationele databases enorme hoeveelheden gegevens die belangrijke inzichten kunnen bieden als ze worden verwerkt via een pijplijn voor big data. U kunt de volgende hulpprogramma's gebruiken om dergelijke gegevens naar Data Lake Storage Gen1 te verplaatsen.

Webserverlogboekgegevens (uploaden met aangepaste toepassingen)

Dit type gegevensset wordt specifiek aangeroepen omdat analyse van webserverlogboekgegevens een veelvoorkomende use-case is voor big data-toepassingen en vereist dat grote hoeveelheden logboekbestanden worden geüpload naar Data Lake Storage Gen1. U kunt een van de volgende hulpprogramma's gebruiken om uw eigen scripts of toepassingen te schrijven om dergelijke gegevens te uploaden.

Voor het uploaden van webserverlogboekgegevens en voor het uploaden van andere soorten gegevens (bijvoorbeeld gegevens over sociale sentimenten), is het een goede benadering om uw eigen aangepaste scripts/toepassingen te schrijven, omdat u hiermee de flexibiliteit krijgt om uw gegevens te uploaden als onderdeel van uw grotere big data-toepassing. In sommige gevallen kan deze code de vorm hebben van een script of een eenvoudig opdrachtregelprogramma. In andere gevallen kan de code worden gebruikt om big data-verwerking te integreren in een zakelijke toepassing of oplossing.

Gegevens die zijn gekoppeld aan Azure HDInsight-clusters

De meeste HDInsight-clustertypen (Hadoop, HBase, Storm) ondersteunen Data Lake Storage Gen1 als opslagplaats voor gegevensopslag. HDInsight-clusters hebben toegang tot gegevens van Azure Storage-blobs (WASB). Voor betere prestaties kunt u de gegevens van WASB kopiëren naar een Data Lake Storage Gen1-account dat is gekoppeld aan het cluster. U kunt de volgende hulpprogramma's gebruiken om de gegevens te kopiëren.

Gegevens die zijn opgeslagen in on-premises of IaaS Hadoop-clusters

Grote hoeveelheden gegevens kunnen worden opgeslagen in bestaande Hadoop-clusters, lokaal op computers met HDFS. De Hadoop-clusters bevinden zich mogelijk in een on-premises implementatie of bevinden zich in een IaaS-cluster in Azure. Er kunnen vereisten zijn voor het kopiëren van dergelijke gegevens naar Azure Data Lake Storage Gen1 voor een eenmalige benadering of op een terugkerende manier. Er zijn verschillende opties die u kunt gebruiken om dit te bereiken. Hieronder vindt u een lijst met alternatieven en de bijbehorende afwegingen.

| Methode | DETAILS | Voordelen | Overwegingen |

|---|---|---|---|

| Azure Data Factory (ADF) gebruiken om gegevens rechtstreeks vanuit Hadoop-clusters te kopiëren naar Azure Data Lake Storage Gen1 | ADF ondersteunt HDFS als gegevensbron | ADF biedt kant-en-klare ondersteuning voor HDFS en end-to-end-beheer en -bewaking van de eerste klasse | Vereist dat Gegevensbeheer Gateway on-premises of in het IaaS-cluster wordt geïmplementeerd |

| Gegevens exporteren uit Hadoop als bestanden. Kopieer vervolgens de bestanden naar Azure Data Lake Storage Gen1 met behulp van het juiste mechanisme. | U kunt bestanden kopiëren naar Azure Data Lake Storage Gen1 met behulp van:

|

Snel aan de slag. Kan aangepaste uploads uitvoeren | Proces met meerdere stappen waarbij meerdere technologieën zijn betrokken. Beheer en bewaking zal in de loop van de tijd een uitdaging zijn gezien de aangepaste aard van de hulpprogramma's |

| Gebruik Distcp om gegevens van Hadoop naar Azure Storage te kopiëren. Kopieer vervolgens gegevens van Azure Storage naar Data Lake Storage Gen1 met behulp van het juiste mechanisme. | U kunt gegevens kopiëren van Azure Storage naar Data Lake Storage Gen1 met behulp van: | U kunt opensource-hulpprogramma's gebruiken. | Proces met meerdere stappen waarbij meerdere technologieën zijn betrokken |

Echt grote gegevenssets

Voor het uploaden van gegevenssets die variëren in verschillende terabytes, kan het soms traag en kostbaar zijn met behulp van de hierboven beschreven methoden. In dergelijke gevallen kunt u de onderstaande opties gebruiken.

Azure ExpressRoute gebruiken. Met Azure ExpressRoute kunt u privéverbindingen maken tussen Azure-datacenters en infrastructuur on-premises. Dit biedt een betrouwbare optie voor het overdragen van grote hoeveelheden gegevens. Zie de Documentatie voor Azure ExpressRoute voor meer informatie.

'Offline' upload van gegevens. Als het gebruik van Azure ExpressRoute om welke reden dan ook niet haalbaar is, kunt u de Azure Import/Export-service gebruiken om harde schijven met uw gegevens naar een Azure-datacenter te verzenden. Uw gegevens worden eerst geüpload naar Azure Storage-blobs. Vervolgens kunt u het hulpprogramma Azure Data Factory of AdlCopy gebruiken om gegevens van Azure Storage-blobs te kopiëren naar Data Lake Storage Gen1.

Notitie

Tijdens het gebruik van de Import/Export-service mogen de bestandsgrootten op de schijven die u naar het Azure-datacenter verzendt, niet groter zijn dan 195 GB.

Gegevens verwerken die zijn opgeslagen in Data Lake Storage Gen1

Zodra de gegevens beschikbaar zijn in Data Lake Storage Gen1, kunt u analyses uitvoeren op die gegevens met behulp van de ondersteunde big data-toepassingen. Op dit moment kunt u Azure HDInsight en Azure Data Lake Analytics gebruiken om gegevensanalysetaken uit te voeren op de gegevens die zijn opgeslagen in Data Lake Storage Gen1.

U kunt de volgende voorbeelden bekijken.

- Een HDInsight-cluster maken met Data Lake Storage Gen1 als opslag

- Azure Data Lake Analytics gebruiken met Data Lake Storage Gen1

Gegevens downloaden uit Data Lake Storage Gen1

U kunt ook gegevens downloaden of verplaatsen van Azure Data Lake Storage Gen1 voor scenario's zoals:

- Verplaats gegevens naar andere opslagplaatsen om te communiceren met uw bestaande pijplijnen voor gegevensverwerking. U kunt bijvoorbeeld gegevens verplaatsen van Data Lake Storage Gen1 naar Azure SQL Database of SQL Server.

- Download gegevens naar uw lokale computer voor verwerking in IDE-omgevingen tijdens het bouwen van prototypen van toepassingen.

In dergelijke gevallen kunt u een van de volgende opties gebruiken:

U kunt ook de volgende methoden gebruiken om uw eigen script/toepassing te schrijven om gegevens te downloaden uit Data Lake Storage Gen1.

Gegevens visualiseren in Data Lake Storage Gen1

U kunt een combinatie van services gebruiken om visuele representaties te maken van gegevens die zijn opgeslagen in Data Lake Storage Gen1.

- U kunt beginnen met het gebruik van Azure Data Factory om gegevens van Data Lake Storage Gen1 te verplaatsen naar Azure Synapse Analytics

- Daarna kunt u Power BI integreren met Azure Synapse Analytics om een visuele weergave van de gegevens te maken.