Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Importante

O Content Moderator do Azure foi preterido a partir de fevereiro de 2024 e será desativado em 15 de março de 2027. Ele foi substituído pela Segurança de Conteúdo de IA do Azure, que oferece recursos avançados de IA e desempenho aprimorado.

A Segurança de Conteúdo de IA do Azure é uma solução abrangente projetada para detectar conteúdo gerado pelo usuário prejudicial e gerado por IA em aplicativos e serviços. A Segurança de Conteúdo de IA do Azure é adequada para muitos cenários, como marketplaces online, empresas de jogos, plataformas de mensagens sociais, empresas de mídia corporativa e provedores de soluções de educação K-12. Aqui está uma visão geral de seus recursos e funcionalidades:

- APIs de detecção de texto e imagem: examina texto e imagens em busca de conteúdo sexual, violência, ódio e automutilação com vários níveis de gravidade.

- Content Safety Studio: uma ferramenta online projetada para lidar com conteúdo potencialmente ofensivo, arriscado ou indesejável usando nossos mais recentes modelos de ML de moderação de conteúdo. Ele fornece modelos e fluxos de trabalho personalizados que permitem aos usuários criar seus próprios sistemas de moderação de conteúdo.

- Suporte a idiomas: a Segurança de Conteúdo do IA do Azure dá suporte a mais de 100 idiomas e é especificamente treinado em inglês, alemão, japonês, espanhol, francês, italiano, português e chinês.

A Segurança de Conteúdo de IA do Azure fornece uma solução robusta e flexível para suas necessidades de moderação de conteúdo. Ao alternar do Content Moderator para a Segurança de Conteúdo de IA do Azure, você pode aproveitar as ferramentas e tecnologias mais recentes para garantir que seu conteúdo seja sempre moderado às suas especificações exatas.

Saiba mais sobre a Segurança de Conteúdo de IA do Azure e explore como ela pode elevar sua estratégia de moderação de conteúdo.

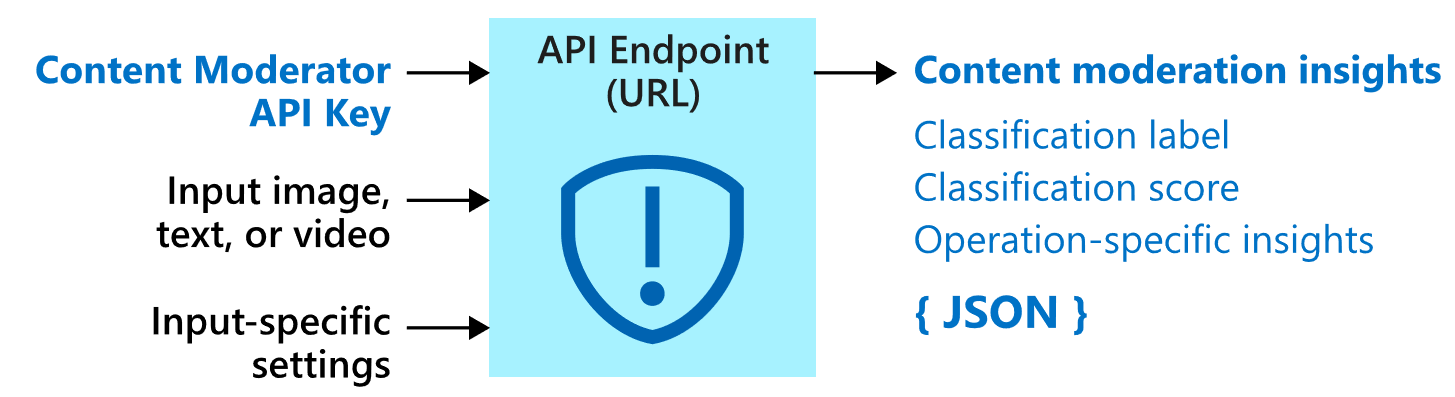

O Azure Content Moderator é um serviço de IA que permite que você lide com conteúdos potencialmente ofensivos, arriscados ou, de alguma outra forma, indesejáveis. Ele inclui o serviço de moderação de conteúdo baseado em IA que examinar texto, imagem e vídeos e aplica sinalizadores de conteúdo automaticamente.

Talvez você queira criar software de filtragem de conteúdo em seu aplicativo para cumprir os regulamentos ou manter o ambiente pretendido para os seus usuários.

Esta documentação contém os seguintes tipos de artigos:

- Os guias de início rápido são instruções de introdução que orientam sobre como fazer solicitações ao serviço.

- Os guias de instruções contêm instruções de uso do serviço de maneiras mais específicas ou personalizadas.

- Os conceitos fornecem explicações detalhadas sobre a funcionalidade e os recursos do serviço.

Para obter uma abordagem mais estruturada, siga um módulo de treinamento para o Content Moderator.

Como ele é usado

Estes são alguns cenários nos quais uma equipe ou um desenvolvedor de software precisaria de um software de moderação de conteúdo:

- Marketplaces online que moderam catálogos de produtos e outros tipos de conteúdo gerados pelo usuário.

- Empresas de jogos que moderam artefatos de jogos gerados pelo usuário e salas de chat.

- Plataformas de mensagens sociais que moderam imagens, textos e vídeos adicionados pelos usuários.

- Empresas de mídia corporativa que implementam moderação de conteúdo centralizada para seu conteúdo.

- Provedores de soluções de ensino fundamental e médio que filtram conteúdo considerado inapropriado para alunos e professores.

Importante

Não é possível usar o Content Moderator para examinar imagens ilícitas de exploração infantil. No entanto, as organizações qualificadas podem usar oServiço de Nuvem PhotoDNA para examinar este tipo de conteúdo.

O que inclui

O serviço Content Moderator consiste em várias APIs de serviço Web disponíveis por meio de chamadas REST e um SDK do .NET.

APIs de Moderação

O serviço Content Moderator inclui APIs de Moderação que verificam se o conteúdo do material que é potencialmente indesejável ou inapropriado.

A tabela a seguir descreve os diferentes tipos de APIs de moderação.

| Grupo de APIs | Descrição |

|---|---|

| Moderação de texto | Examina o texto quanto a conteúdo ofensivo, conteúdo sexualmente explícito ou sugestivo, conteúdo ofensivo e dados pessoais. |

| Listas de termos personalizadas | Examina o texto em relação a uma lista de termos personalizados juntamente com os termos internos. Use listas personalizadas para bloquear ou permitir conteúdo de acordo com suas próprias políticas de conteúdo. |

| Moderação de imagem | Verifica conteúdo adulto ou erótico em imagens, detecta textos em imagens com o recurso de OCR (reconhecimento óptico de caracteres) e detecta rostos. |

| Listas de imagens personalizadas | Verifica imagens em relação a uma lista personalizada de imagens. Use listas de imagem personalizadas para filtrar instâncias de conteúdo recorrentes que você não deseja classificar novamente. |

| Moderação de vídeo | Verifica conteúdo adulto ou erótico em vídeos e retorna os marcadores de tempo para esse conteúdo. |

Segurança e privacidade de dados

Assim como ocorre com todos os serviços de IA do Azure, os desenvolvedores que usam o serviço de Moderador de Conteúdo devem estar cientes das políticas da Microsoft com relação aos dados do cliente. Confira a página de serviços de IA do Azure na Central de Confiabilidade da Microsoft para saber mais.

Próximas etapas

- Ou execute um início rápido da biblioteca de cliente ou API REST para implementar os cenários básicos no código.