Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Este artigo mostra como começar a usar o Serviço OpenAI do Azure no IntelliJ IDEA. Ele mostra como usar modelos de chat como GPT-3.5-Turbo e GPT-4 para testar e experimentar diferentes parâmetros e fontes de dados.

Pré-requisitos

Um JDK (Java Development Kit) com suporte. Para obter mais informações sobre os JDKs disponíveis para uso ao desenvolver no Azure, consulte suporte a Java no Azure e no Azure Stack.

IntelliJ IDEA, Ultimate ou Community Edition.

O Kit de Ferramentas do Azure para IntelliJ. Para obter mais informações, consulte Instalar o Kit de Ferramentas do Azure para IntelliJ. Você também precisa entrar em sua conta do Azure para o Kit de Ferramentas do Azure para IntelliJ. Para obter mais informações, consulte Instruções de login para o Azure Toolkit for IntelliJ.

Uma assinatura do Azure – Crie uma gratuitamente.

Acesso permitido ao OpenAI do Azure na assinatura do Azure desejada.

No momento, o acesso a esse serviço é permitido somente por aplicativo. Você pode solicitar acesso ao Azure OpenAI concluindo o formulário no Request Access to Azure OpenAI Service.

Um recurso do Serviço OpenAI do Azure com os modelos do

gpt-35-turboougpt-4implantados. Para obter mais informações sobre a implantação de modelo, confira Criar e implantar um recurso do Serviço OpenAI do Azure.

Instalar e entrar

As etapas a seguir orientam você pelo processo de entrada do Azure em seu ambiente de desenvolvimento do IntelliJ:

Se você não tiver o plug-in instalado, consulte o Kit de Ferramentas do Azure para IntelliJ.

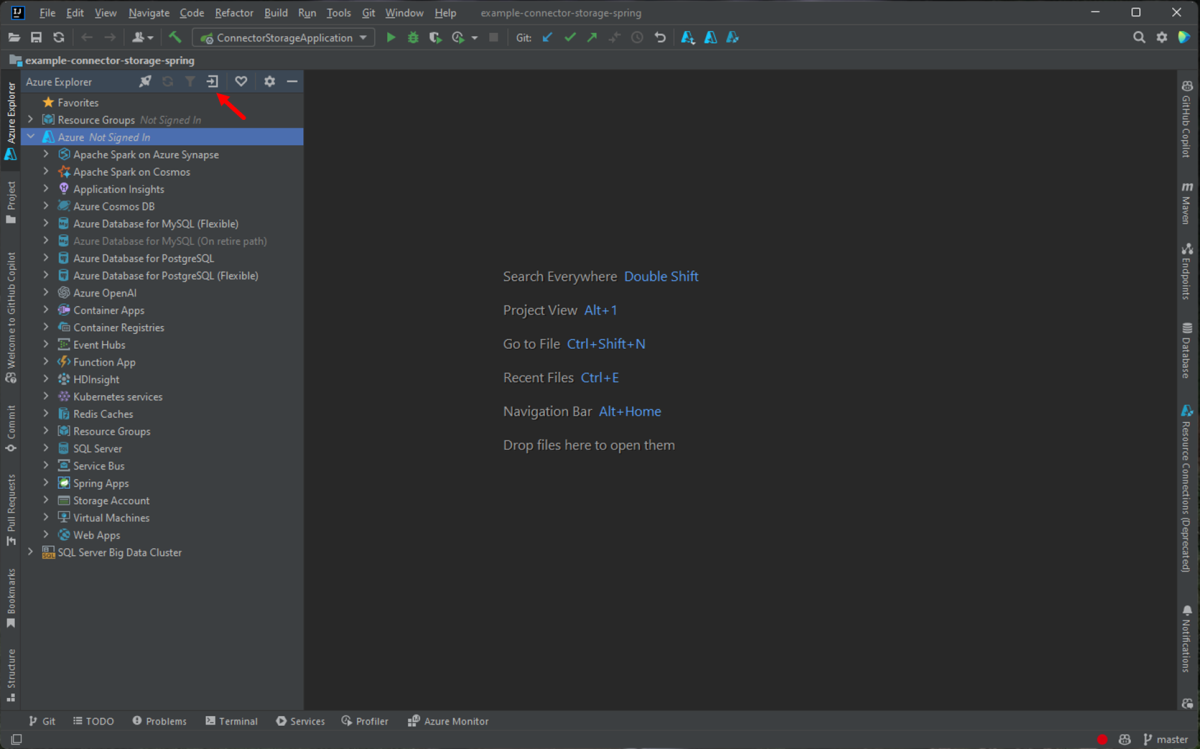

Para entrar em sua conta do Azure, navegue até a barra lateral esquerda do Azure Explorer e selecione o ícone de Entrada do Azure . Como alternativa, você pode navegar até Ferramentas, expandir o Azure e selecionar Entrar no Azure.

Na janela Entrada no Azure, selecione OAuth 2.0 e clique em Entrar. Para outras opções de entrada, confira as Instruções de entrada do Azure Toolkit for IntelliJ.

No navegador, entre com sua conta que tenha acesso ao recurso OpenAI e volte para o IntelliJ. Na caixa de diálogo Selecionar Assinaturas , selecione a assinatura que deseja usar e selecione Selecionar.

Criar e implantar um recurso do Serviço OpenAI do Azure

Após o fluxo de trabalho de entrada, clique com o botão direito do mouse no item do Azure OpenAI no Azure Explorer e selecione Criar Serviço OpenAI do Azure.

Na caixa de diálogo Criar Serviço OpenAI do Azure , especifique as seguintes informações e selecione OK:

- Nome: um nome descritivo para o recurso do Serviço OpenAI do Azure, como MyOpenAIResource. Este nome também é seu domínio personalizado no ponto de extremidade. O nome do recurso só pode incluir caracteres alfanuméricos e hifens e não pode iniciar ou terminar com um hífen.

- Região: o local da instância. Determinados modelos só estão disponíveis em regiões específicas. Para obter mais informações, consulte Modelos do Serviço OpenAI do Azure.

- Sku: os recursos openai padrão do Azure são cobrados com base no uso do token. Para obter mais informações, consulte os preços do Serviço OpenAI do Azure.

Antes de poder usar completamentos de chat, você precisa implantar um modelo. Clique com o botão direito do mouse na instância do Azure OpenAI e selecione Criar Nova Implantação. Na caixa de diálogo Criar Implantação do Azure OpenAI , especifique as seguintes informações e selecione OK:

- Nome da implantação: escolha um nome com cuidado. O nome da implantação é usado em seu código para chamar o modelo usando as bibliotecas de cliente e as APIs REST.

- Modelo: selecione um modelo. A disponibilidade do modelo varia de acordo com a região. Para obter uma lista de modelos disponíveis por região, consulte a seção de tabela de resumo de modelos e disponibilidade por região de modelos do Azure OpenAI Service.

O kit de ferramentas exibe uma mensagem de status quando a implantação está concluída e pronta para uso.

Interagir com o Azure OpenAI usando prompts e configurações

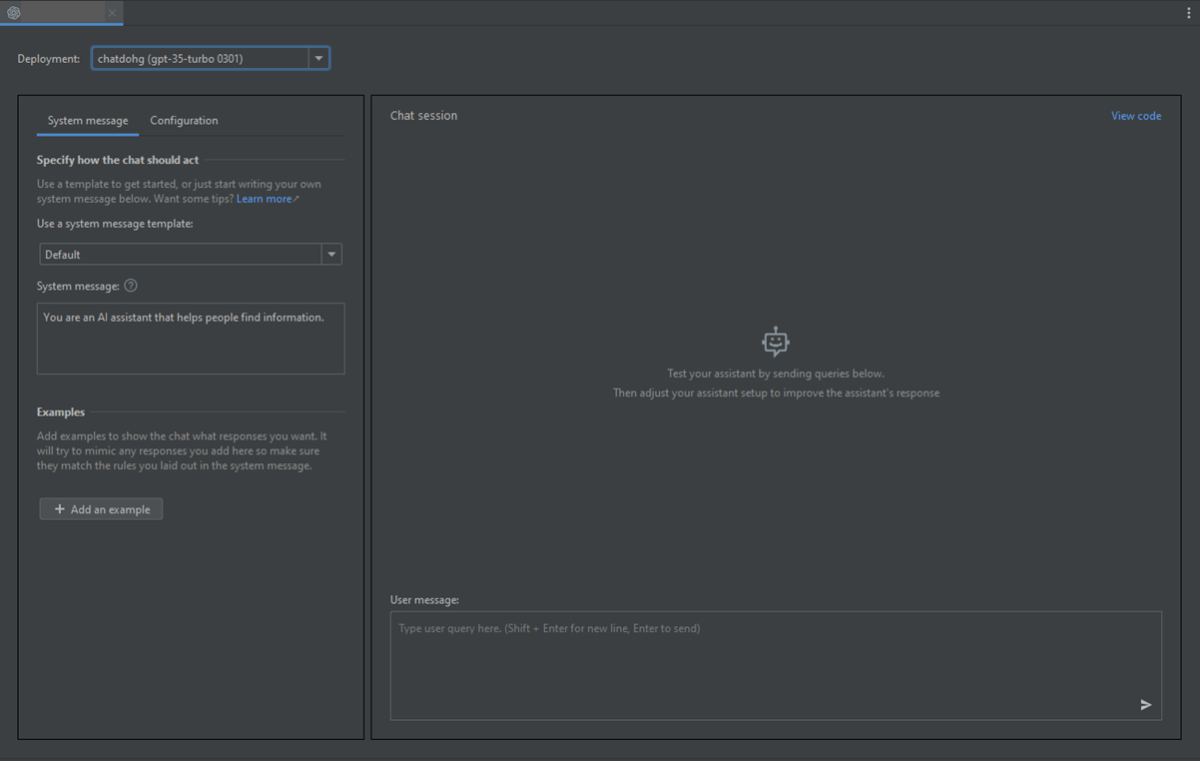

Clique com o botão direito do mouse no recurso do Azure OpenAI e selecione Abrir no AI Playground.

Você pode começar a explorar os recursos do OpenAI através do espaço de experimentação de Chat do Azure OpenAI Studio no IntelliJ IDEA.

Para disparar a conclusão, você pode inserir algum texto como um prompt. O modelo gera a conclusão e tenta corresponder ao seu contexto ou padrão.

Para iniciar uma sessão de chat, siga estas etapas:

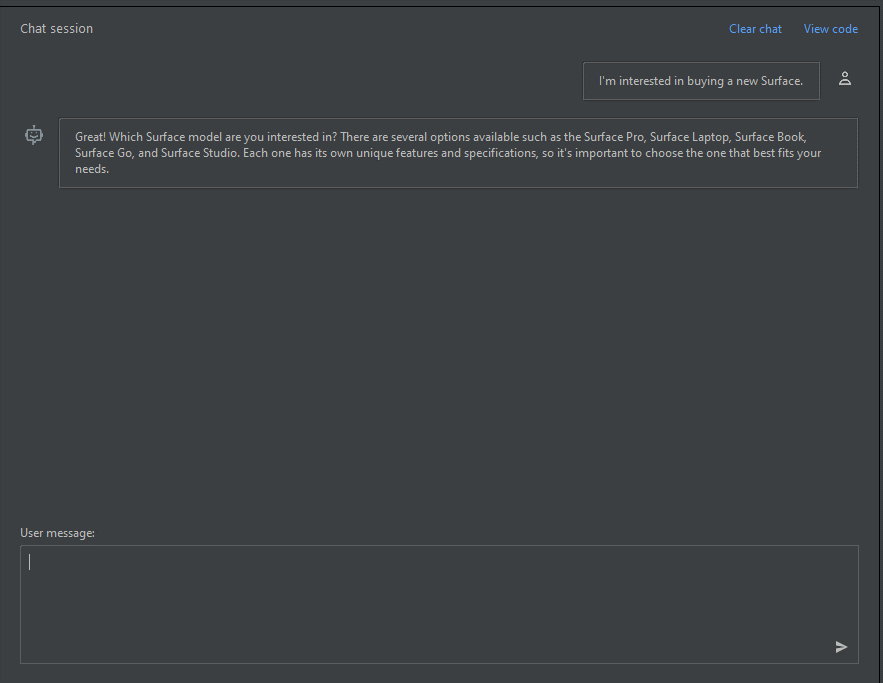

No painel de sessão de chat, você pode começar com um prompt simples como este: "Estou interessado em comprar um novo Surface". Depois de digitar o prompt, selecione Enviar. Você recebe uma resposta semelhante ao seguinte exemplo:

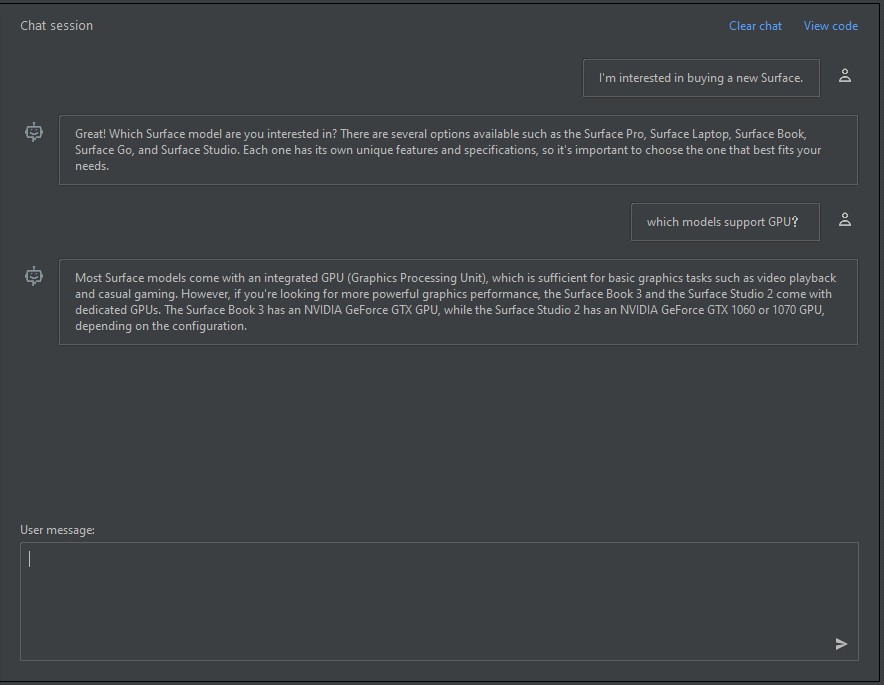

Great! Which Surface model are you interested in? There are several options available such as the Surface Pro, Surface Laptop, Surface Book, Surface Go, and Surface Studio. Each one has its own unique features and specifications, so it's important to choose the one that best fits your needs.Insira uma pergunta de acompanhamento como: "Quais modelos dão suporte à GPU?" e selecione Enviar. Você recebe uma resposta semelhante ao seguinte exemplo:

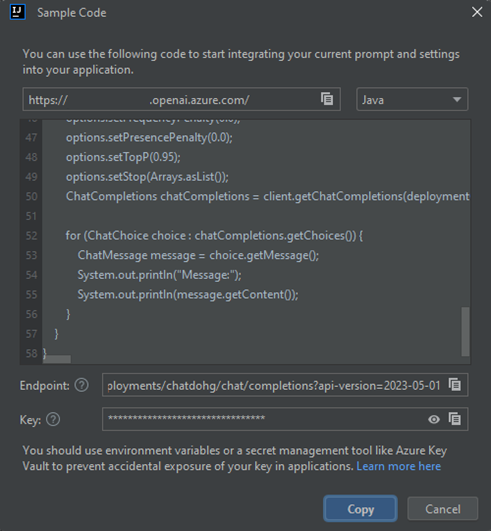

Most Surface models come with an integrated GPU (Graphics Processing Unit), which is sufficient for basic graphics tasks such as video playback and casual gaming. However, if you're looking for more powerful graphics performance, the Surface Book 3 and the Surface Studio 2 come with dedicated GPUs. The Surface Book 3 has an NVIDIA GeForce GTX GPU, while the Surface Studio 2 has an NVIDIA GeForce GTX 1060 or 1070 GPU, depending on the configuration.Agora que você tem uma conversa básica, selecione Exibir código no painel e você tem uma reprodução do código por trás de toda a conversa até agora. Você pode ver os exemplos de código com base no SDK do Java, curl e JSON que correspondem à sessão de chat e às configurações, conforme mostrado na captura de tela a seguir:

Em seguida, você pode selecionar Copiar para pegar esse código e escrever um aplicativo para concluir a mesma tarefa que você está executando no momento com o playground.

Configurações

Você pode selecionar a guia Configuração para definir os seguintes parâmetros:

| Nome | Descrição |

|---|---|

| Resposta máxima | Define um limite no número de tokens que o modelo pode gerar. O total de tokens (prompt + resposta) que você pode enviar depende do modelo que você implanta: • gpt-35-turbo-1106 / 0125 – até 16.385 tokens • gpt-35-turbo-16k-0613 – até 16 385 tokens • gpt-4-turbo-2024-04-09 – até 128 000 tokens • gpt-4o-2024-05-13 – até 128 000 tokens Para obter a lista completa e atualizada de limites, consulte a Tabela de resumo de modelos e disponibilidade na região. Sempre verifique se a soma do seu prompt e da conclusão esperada cabe na janela de contexto do modelo. |

| Temperatura | Controla a aleatoriedade. Reduzir a temperatura significa que o modelo produz respostas mais repetitivas e determinísticas. Aumentar a temperatura resulta em respostas mais inesperadas ou criativas. Tente ajustar a temperatura ou probabilidades superiores, mas não ambos. |

| Principais probabilidades | Semelhante à temperatura, controla a aleatoriedade, mas usa um método diferente. A redução do valor das principais probabilidades restringe a seleção de token do modelo a tokens mais semelhantes. Aumentar o valor permite que o modelo escolha entre tokens com alta e baixa probabilidade. Tente ajustar a temperatura ou probabilidades superiores, mas não ambos. |

| Parar sequências | Faz com que o modelo encerre sua resposta em um ponto desejado. A resposta do modelo termina antes da sequência especificada, portanto, ela não contém o texto de sequência de interrupção. Para o GPT-35-Turbo, usar <|im_end|> garante que a resposta do modelo não gere uma consulta de acompanhamento do usuário. Você pode incluir até quatro sequências de parada. |

| Frequência de penalidade | Reduz a chance de repetir um token proporcionalmente com base na frequência com que ele aparece no texto até agora. Essa ação diminui a probabilidade de repetir exatamente o mesmo texto em uma resposta. |

| Penalidade de presença | Reduz a chance de repetir qualquer token que apareça no texto até agora. Isso aumenta a probabilidade de introduzir novos tópicos em uma resposta. |

Limpar os recursos

Depois de terminar de testar o playground de chat, se você quiser limpar e remover um recurso do OpenAI, poderá excluir o recurso ou o grupo de recursos. Excluir o grupo de recursos também exclui todos os recursos associados a ele. Use as seguintes etapas para limpar os recursos:

Para excluir os recursos do Azure OpenAI, navegue até a barra lateral esquerda do Azure Explorer e localize o item do Azure OpenAI .

Clique com o botão direito do mouse no serviço Azure OpenAI que você deseja excluir e selecione Excluir.

Para excluir o grupo de recursos, visite o portal do Azure e exclua manualmente os recursos em sua assinatura.

Próximas etapas

Para obter mais informações, consulte Saiba como trabalhar com os modelos GPT-35-Turbo e GPT-4.

Para obter mais exemplos, confira o repositório do GitHub para amostras do OpenAI do Azure.