Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Aplica-se a: ✔️ VMs Linux ✔️ VMs Windows ✔️ Conjuntos de dimensionamento flexíveis

Para aproveitar as funcionalidades de GPU das VMs da série N do Azure que contam com GPUs da NVIDIA, é preciso instalar os drivers para GPU NVIDIA. A Extensão de Driver de GPU NVIDIA instala drivers CUDA ou GRID NVIDIA apropriados em VMs da série N. Instale ou gerencie a extensão usando o portal do Azure ou ferramentas, como Azure PowerShell ou modelos do Azure Resource Manager. Confira a documentação da Extensão de Driver de GPU NVIDIA para saber quais são os sistemas operacionais compatíveis e as etapas de implantação.

Se você optar por instalar os drivers de GPU NVIDIA manualmente, este artigo fornece os sistemas operacionais suportados, os drivers e as etapas de instalação e verificação. As informações de instalação manual de driver também estão disponíveis para VMs do Linux.

Para especificações básicas, capacidades de armazenamento e detalhes de disco, consulte tamanhos de VM Windows da GPU.

Sistemas operacionais e drivers com suporte

Drivers NVIDIA Tesla (CUDA)

Observação

As VMs do Azure NVads A10 v5 dão suporte apenas à versão de driver vGPU 16.x(536.25) ou superior. O driver de vGPU para o SKU A10 é um driver unificado que dá suporte a cargas de trabalho de computação e elementos gráficos.

Os drivers NVIDIA Tesla (CUDA) de todas as VMs da série NC* e ND(opcional para séries NV) são genéricos e não específicos do Azure. Para os drivers mais recentes, visite o site da NVIDIA.

Dica

Como alternativa à instalação manual do driver CUDA em uma VM do Windows Server, você pode implantar uma imagem da Máquina Virtual de Ciência de Dados do Azure. As edições DSVM do Windows Server 2016 instalam previamente os drivers NVIDIA CUDA, a Biblioteca de Rede Neural Profunda CUDA e outras ferramentas.

Drivers NVIDIA GRID/vGPU

Observação

Para VMs do Azure NVads A10 v5, recomendamos que os clientes estejam sempre na versão mais recente do driver. O branch de driver principal NVIDIA mais recente(n) só tem compatibilidade com versões anteriores para o branch principal anterior(n-1). Por exemplo, vGPU 17.x é compatível com versões anteriores somente para vGPU 16.x. Todas as VMs que ainda executam n-2 ou inferior podem ver falhas de driver quando o branch de unidade mais recente é distribuído para hosts do Azure.

As VMs NVs_v3 dão suporte apenas à versão de driver vGPU 16 ou inferior.

O suporte ao Windows Server 2019 só está disponível até o vGPU 16.x.

A Microsoft redistribui os instaladores do driver NVIDIA GRID para as VMs das séries NV, NVv3 e NVads A10 v5 usadas como estações de trabalho virtuais ou para aplicativos virtuais. Instale somente esses drivers GRID em VMs da série NV do Azure, somente em sistemas operacionais listados na tabela a seguir. Esses drivers incluem o licenciamento de Software de GPU Virtual de GRID no Azure. Não é necessário configurar um servidor de licença de software vGPU NVIDIA.

Os drivers GRID redistribuídos pelo Azure não funcionam em VMs que não são da série NV, como as VMs das séries NCv2, NCv3, ND e NDv2. A única exceção é a série de VMs NCas_T4_V3, em que os drivers GRID habilitam funcionalidades de elementos gráficos semelhantes às da série NV.

A extensão Nvidia sempre instala o driver mais recente.

Para Windows 11 (até e incluindo a versão 24H2), Windows 10 (até e incluindo a versão 22H2) e Server 2022:

- GRID 17.5 (553.62) (.exe)

Os links a seguir para versões anteriores são fornecidos para dar suporte a dependências em versões mais antigas do driver.

Para Windows Server 2016 1607, 1709:

- GRID 14.1 (512.78) (.exe) é o último driver com suporte da NVIDIA. A versão 15.x mais recente e as versões posteriores não dão suporte ao Windows Server 2016.

Para Windows Server 2012 R2:

- GRID 13.1 (472.39) (.exe)

- GRID 13 (471,68) (.exe)

Para ver links para todas as versões anteriores do driver Nvidia GRID, visite GitHub.

Instalação do driver

Conecte-se pela Área de Trabalho Remota a cada VM da série N.

Baixe, extraia e instale o driver com suporte para o sistema operacional Windows.

Uma reinicialização é necessária após a instalação do driver de GRID em uma VM. Uma reinicialização não é necessária após a instalação do driver de CUDA.

Verificar a instalação de drivers

Observe que o painel controle NVIDIA só está acessível com a instalação do driver GRID. Se você tiver instalado drivers CUDA, o painel de controle NVIDIA não estará visível.

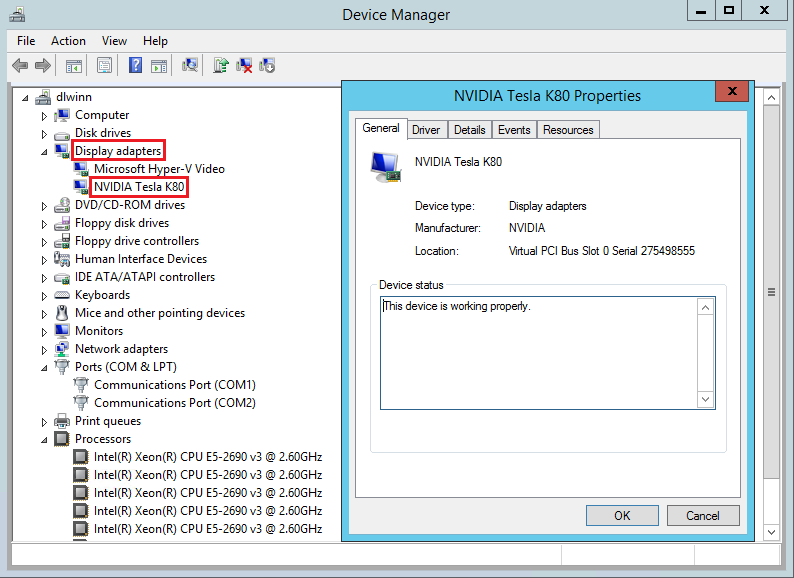

É possível verificar a instalação de drivers no Gerenciador de Dispositivos. O exemplo a seguir mostra uma configuração bem-sucedida da placa Tesla K80 em uma VM NC do Azure.

Observação

Se você estiver executando o Windows 10 build 1903 ou superior, o dxdiag não mostrará nenhuma informação na guia "Exibir". Use a opção 'Salvar Todas as Informações' na parte inferior e o arquivo de saída mostra as informações relacionadas à GPU NVIDIA.

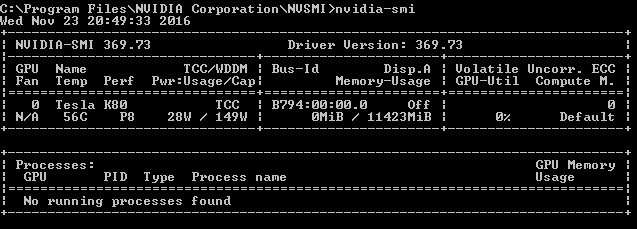

Para consultar o estado do dispositivo GPU, execute o utilitário de linha de comando nvidia-smi instalado com o driver.

Abra um prompt de comando e mude para o diretório C:\Program Files\NVIDIA Corporation\NVSMI.

Execute

nvidia-smi. Se o driver estiver instalado, você verá uma saída parecida com a mostrada a seguir. O GPU-Util mostra 0%, a menos que você esteja atualmente executando uma carga de trabalho de GPU na VM. Sua versão de driver e os detalhes GPU podem ser diferentes daqueles mostrados.

Conectividade de rede RDMA

A conectividade de rede RDMA pode ser ativada em VMs da série N com capacidade de RDMA, como o NC24r implementado no mesmo conjunto de disponibilidade ou em um único grupo de posicionamento em um conjunto de dimensionamento de máquina virtual. A extensão HpcVmDrivers deve ser adicionada para instalar drivers de dispositivo de rede do Windows que habilitam a conectividade RDMA. Para adicionar a extensão de VM a uma VM da série N habilitada para RDMA, use cmdlets do Azure PowerShell para o Azure Resource Manager.

Para instalar a última extensão HpcVMDrivers versão 1.1 em uma VM compatível com RDMA existente chamada myVM na região Oeste dos EUA:

Set-AzVMExtension -ResourceGroupName "myResourceGroup" -Location "westus" -VMName "myVM" -ExtensionName "HpcVmDrivers" -Publisher "Microsoft.HpcCompute" -Type "HpcVmDrivers" -TypeHandlerVersion "1.1"

Para obter mais informações, consulte Recursos e extensões da máquina virtual para Windows.

A rede RDMA dá suporte ao tráfego da Interface de Passagem de Mensagem (MPI) para aplicativos executados com Microsoft MPI ou Intel MPI 5.x.

Próximas etapas

- Desenvolvedores compilando aplicativos acelerados por GPU para GPUs NVIDIA Tesla também podem baixar e instalar o CUDA Toolkit. Para obter mais informações, consulte o Guia de instalação do CUDA.