Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Neste início rápido, você aprenderá como fluxos de dados e pipelines funcionam juntos para criar uma solução poderosa do Data Factory. Você limpará os dados com fluxos de dados e os moverá com pipelines.

Pré-requisitos

Antes de começar, você precisa:

- Uma conta de locatário com uma assinatura ativa. Criar uma conta gratuita.

- Um espaço de trabalho com suporte ao Microsoft Fabric: um espaço de trabalho configurado que não seja o My Workspace padrão.

- Um banco de dados SQL do Azure com dados da tabela.

- Uma conta do Armazenamento de Blobs.

Comparar fluxos de dados e pipelines

O Dataflow Gen2 fornece uma interface de baixo código com mais de 300 transformações baseadas em dados e IA. Você pode limpar, preparar e transformar dados facilmente com flexibilidade. Os pipelines oferecem recursos avançados de orquestração de dados para compor fluxos de trabalho de dados flexíveis que atendem às suas necessidades corporativas.

Em um pipeline, você pode criar agrupamentos lógicos de atividades que executam uma tarefa. Isso pode incluir a chamada de um fluxo de dados para limpar e preparar seus dados. Embora haja alguma sobreposição de funcionalidade entre os dois, sua escolha depende se você precisa dos recursos completos de pipelines ou pode usar os recursos mais simples de fluxos de dados. Para obter mais informações, consulte o guia de decisão do Fabric.

Transformar dados com fluxos de dados

Siga estas etapas para configurar o fluxo de dados.

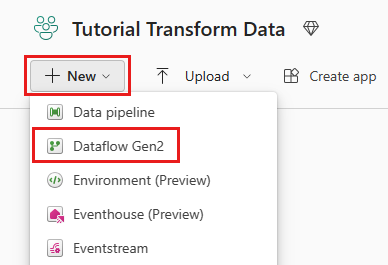

Criar um fluxo de dados

Selecione seu workspace habilitado para Fabric e, em seguida, Novo e escolha Fluxo de Dados Gen2.

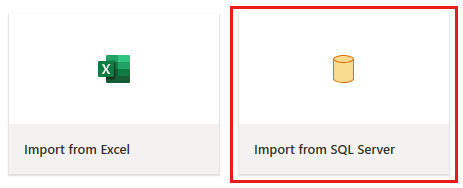

No editor de fluxo de dados, selecione Importar do SQL Server.

Obter dados

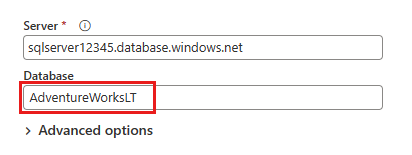

Na caixa de diálogo Conectar à fonte de dados , insira os detalhes do banco de dados SQL do Azure e selecione Avançar. Utilize o banco de dados de exemplo AdventureWorksLT listado nos pré-requisitos.

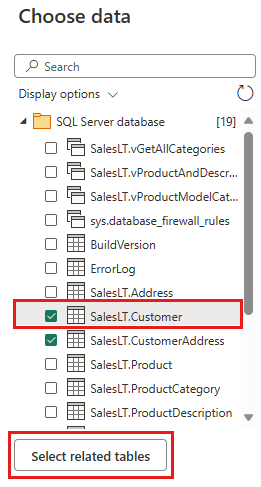

Selecione os dados a serem transformados, como SalesLT.Customer, e use Selecionar tabelas relacionadas para incluir tabelas relacionadas. Em seguida, selecione Criar.

Transformar seus dados

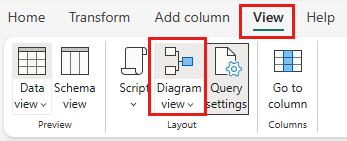

Selecione a exibição Diagrama na barra de status ou no menu Exibir no editor do Power Query.

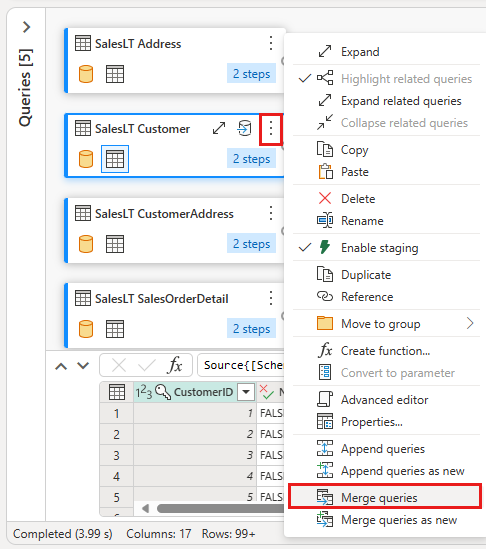

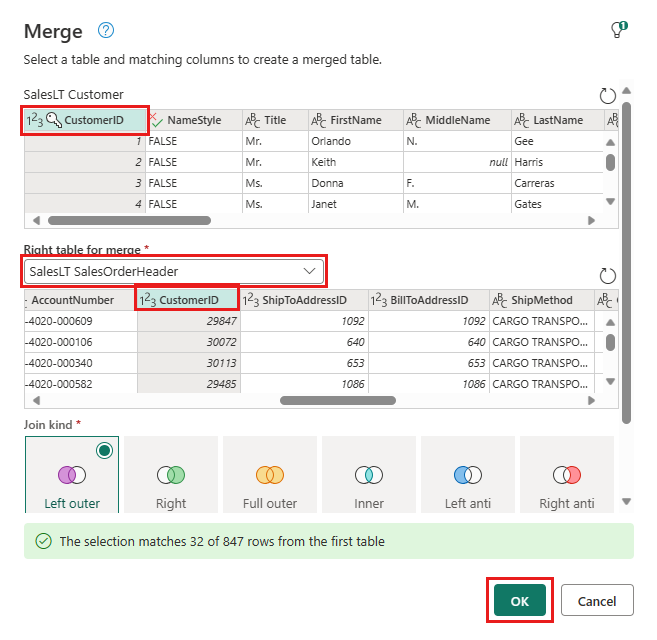

Selecione com o botão direito do mouse sua consulta SalesLT Customer ou selecione as reticências verticais à direita da consulta e selecione Mesclar consultas.

Configure a mesclagem com SalesLTOrderHeader como a tabela direita, CustomerID como a coluna de junção e left outer como o tipo de junção. Selecione OK.

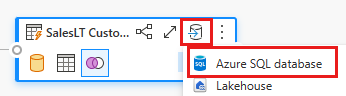

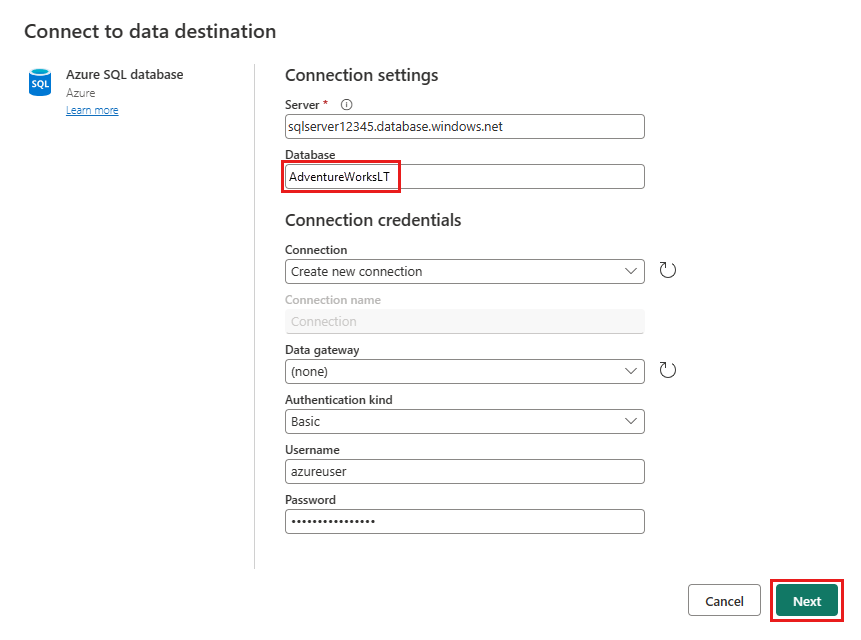

Adicione um destino de dados selecionando o símbolo de banco de dados com uma seta. Escolha o banco de dados SQL do Azure como o tipo de destino.

Forneça os detalhes da conexão do banco de dados SQL do Azure em que a consulta de mesclagem deve ser publicada. Neste exemplo, usamos o banco de dados AdventureWorksLT que usamos como fonte de dados para o destino também.

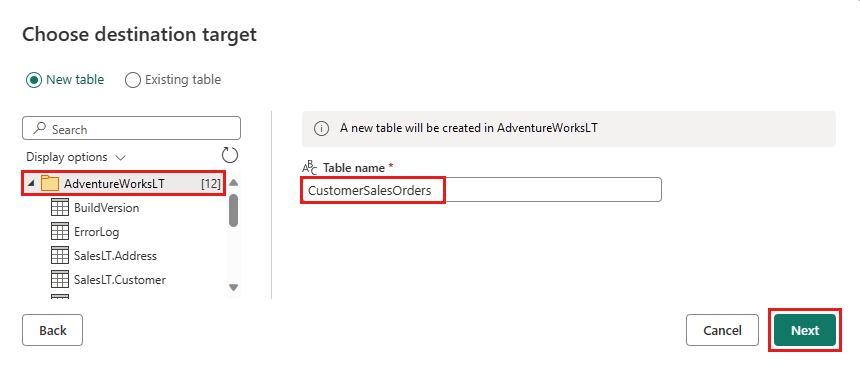

Escolha um banco de dados para armazenar os dados e forneça um nome de tabela e selecione Avançar.

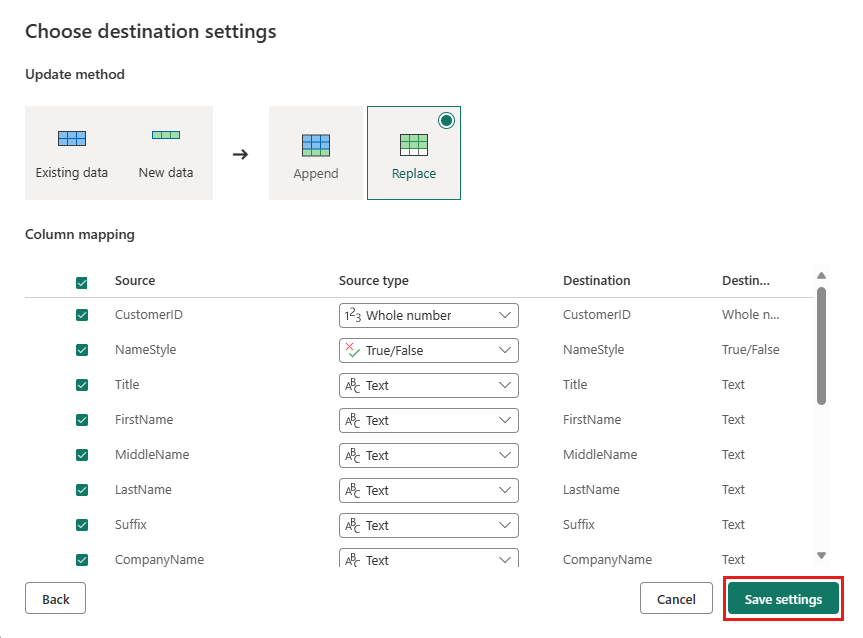

Aceite as configurações padrão na caixa de diálogo Escolher configurações de destino e selecione Salvar configurações.

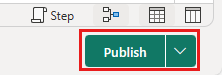

Selecione Publicar no editor de fluxo de dados para publicar o fluxo de dados.

Movimentar dados com pipelines

Agora que você criou um Dataflow Gen2, poderá operá-lo em um pipeline. Neste exemplo, você copia os dados gerados do fluxo de dados para o formato de texto em uma conta do Armazenamento de Blobs do Azure.

Criar um novo pipeline

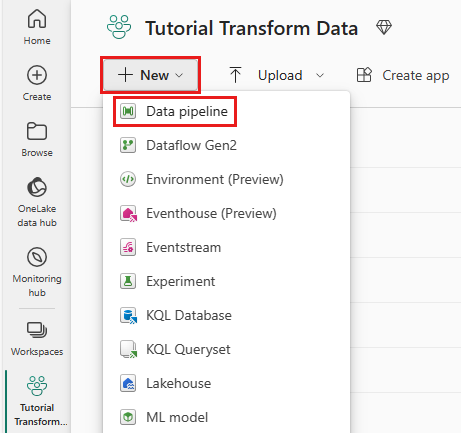

Em seu workspace, selecione Novo e, em seguida, Pipeline.

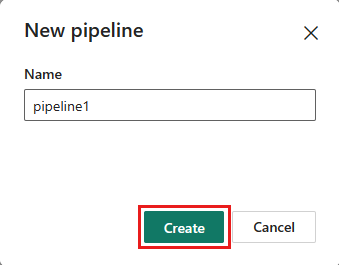

Nomeie seu pipeline e selecione Criar.

Configurar o fluxo de dados

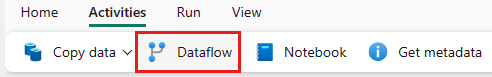

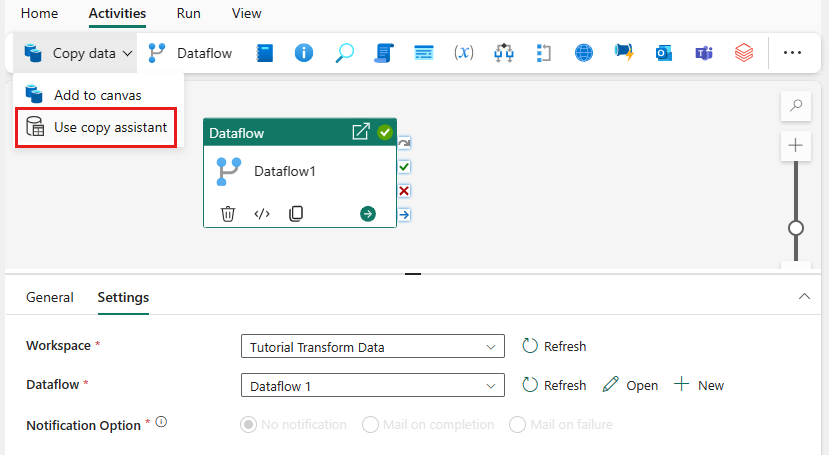

Adicione uma atividade de fluxo de dados ao pipeline selecionando o fluxo de dados na guia Atividades .

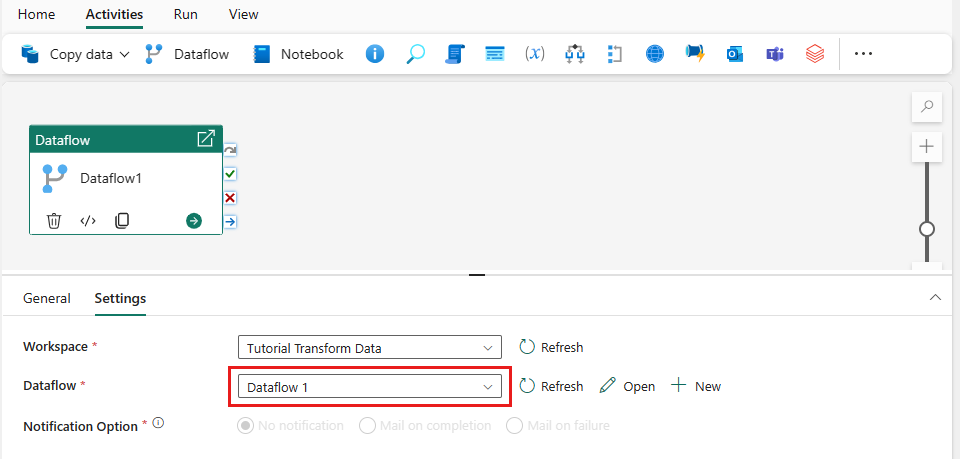

Selecione o fluxo de dados na tela do pipeline, vá para a guia Configurações e escolha o fluxo de dados que você criou anteriormente.

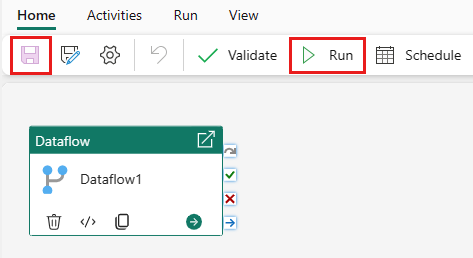

Selecione Salvar e, em seguida, executar para preencher a tabela de consulta mesclada.

Adicione uma atividade de Cópia

Selecione Copiar dados na tela ou use o Assistente de Cópia na guia Atividades .

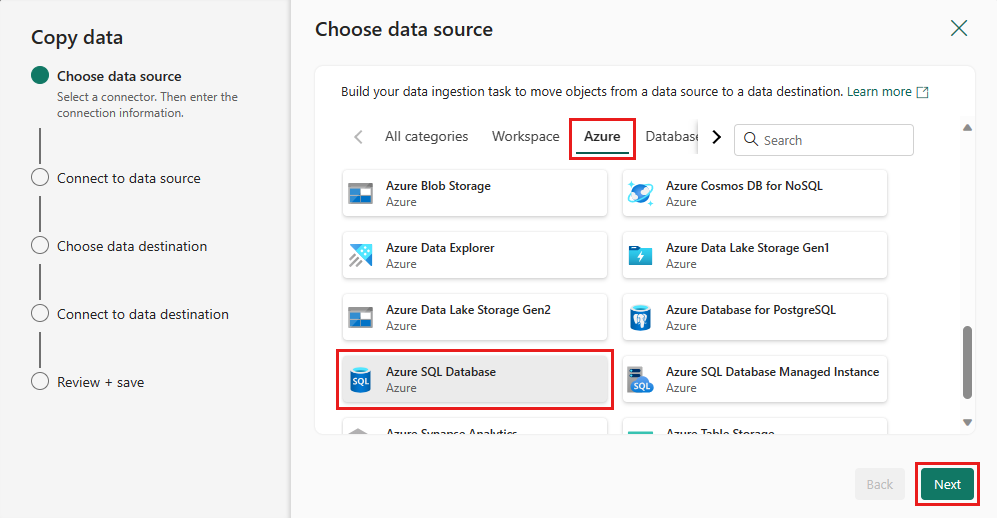

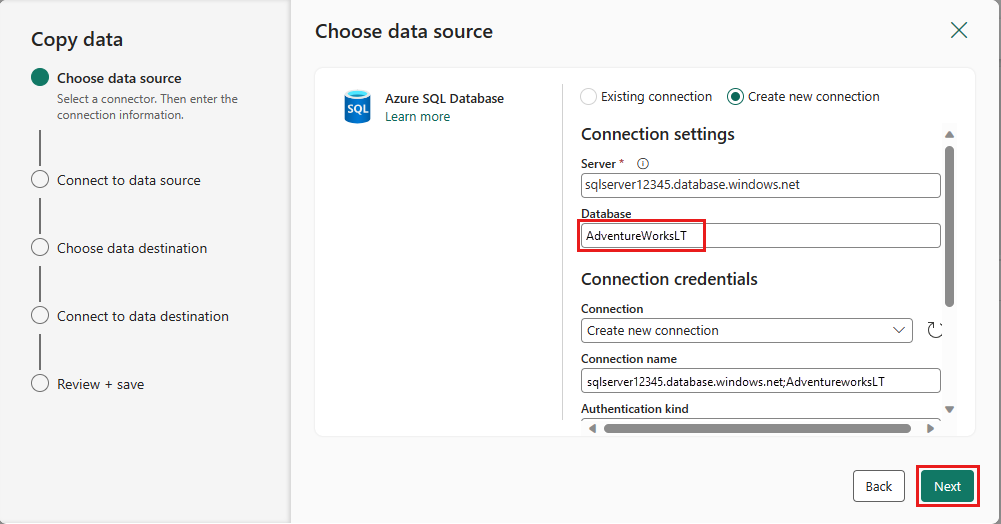

Escolha o Banco de Dados SQL do Azure como a fonte de dados e selecione Avançar.

Crie uma conexão com sua fonte de dados selecionando Criar nova conexão. Preencha as informações de conexão necessárias no painel e insira o AdventureWorksLT para o banco de dados, onde geramos a consulta de mesclagem no fluxo de dados. Em seguida, selecione Próximo.

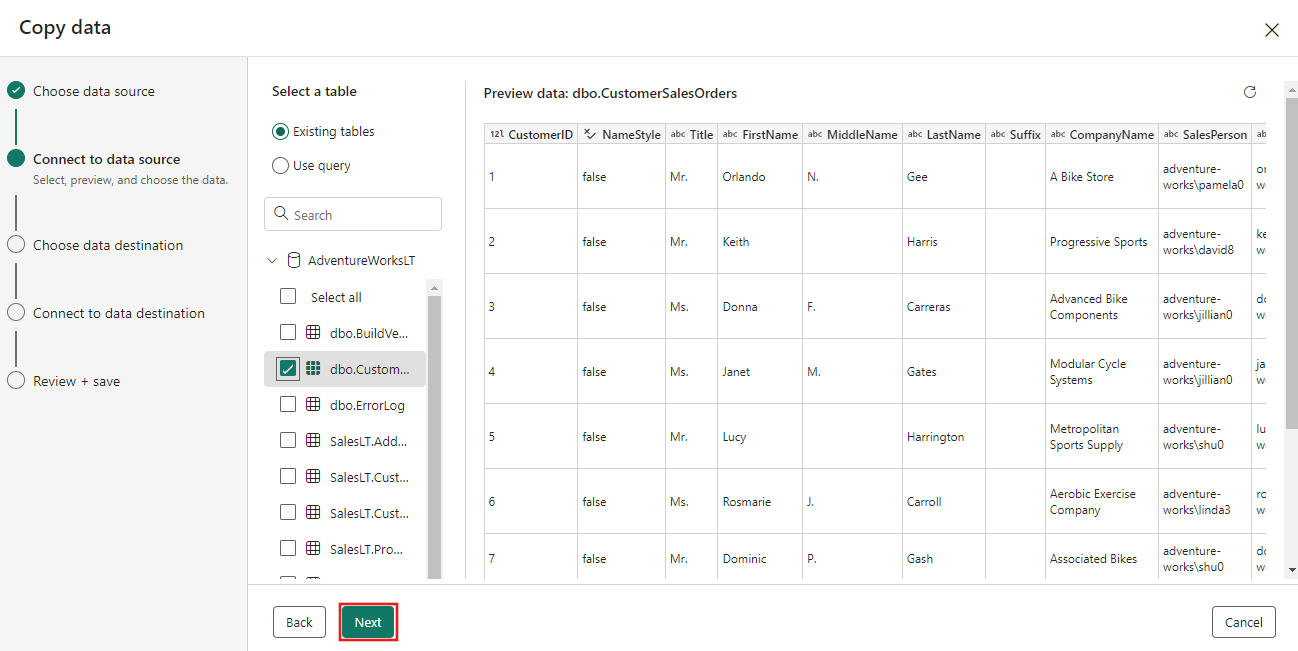

Selecione a tabela gerada na etapa de fluxo de dados anteriormente e selecione Próximo.

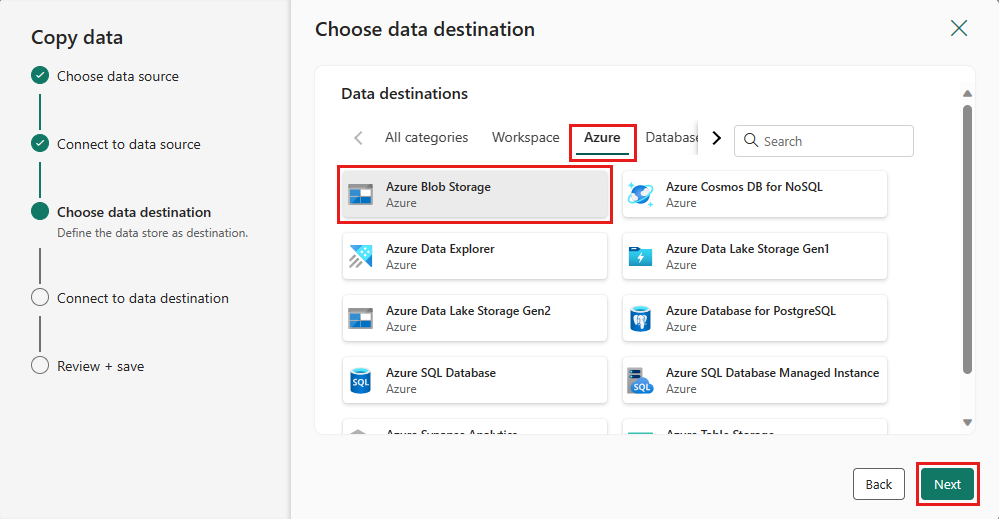

Para seu destino, escolha Armazenamento de Blobs do Azure e selecione Avançar.

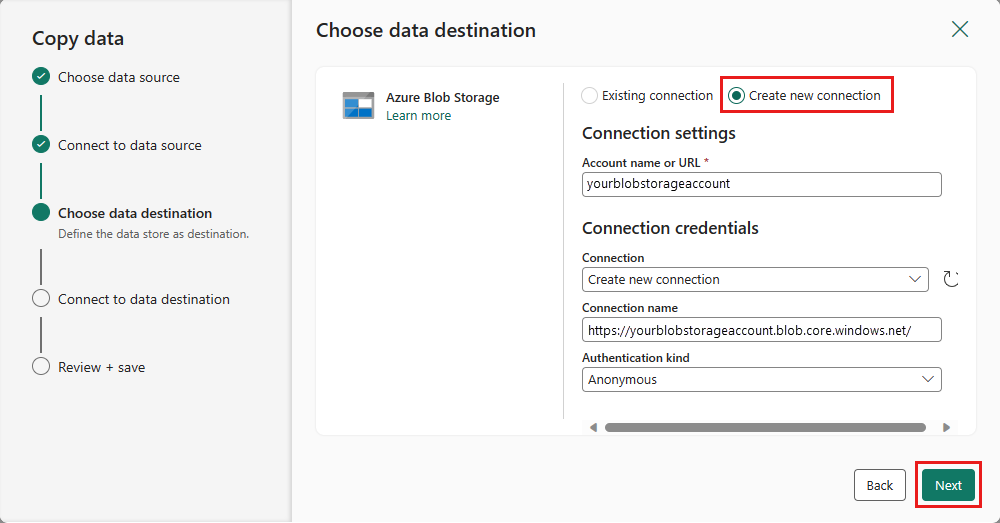

Crie uma conexão com seu destino selecionando Criar nova conexão. Forneça os detalhes da conexão e selecione Próximo.

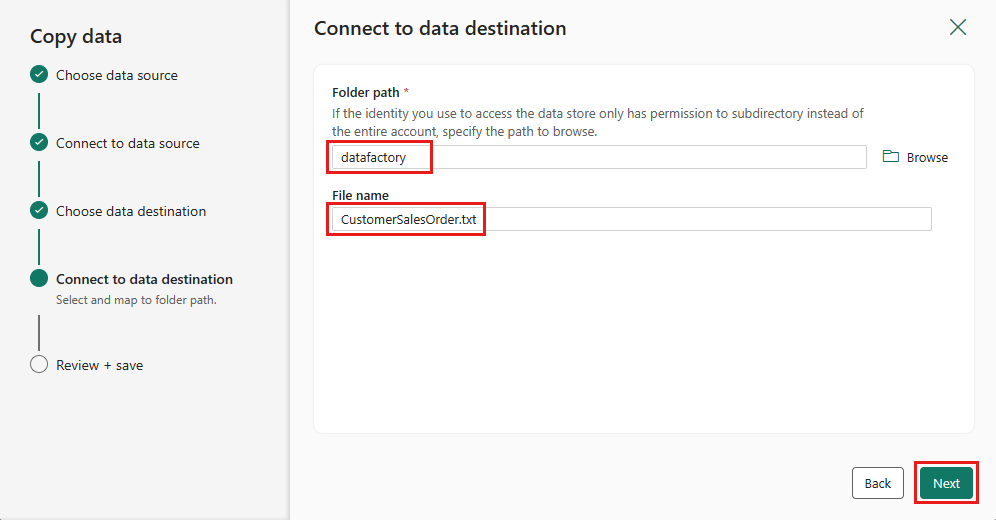

Selecione o Caminho da pasta e forneça um Nome de arquivo e, em seguida, selecione Avançar.

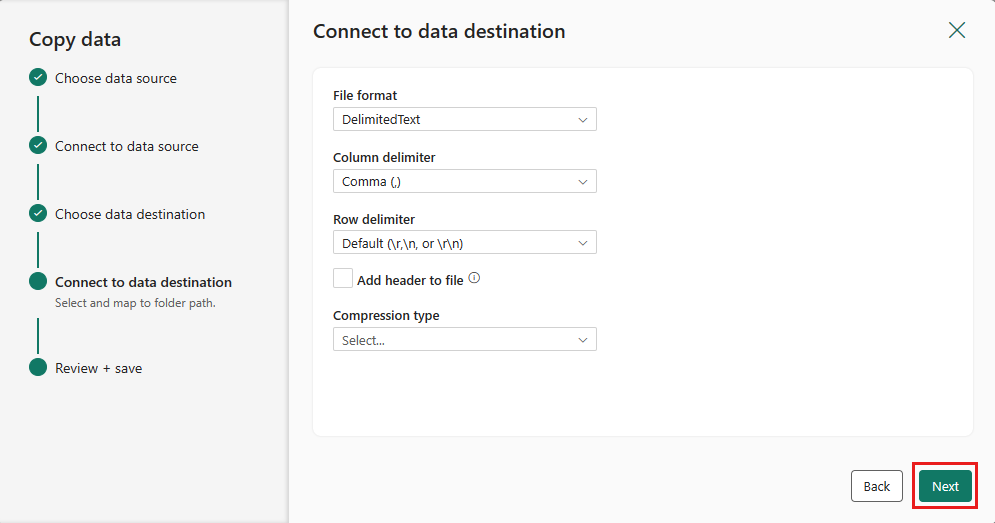

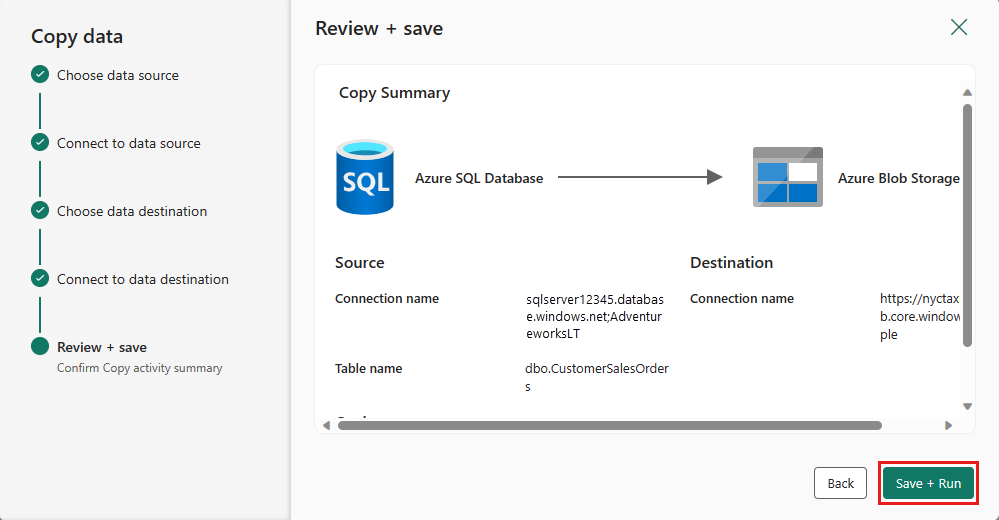

Selecione Avançar novamente para aceitar o formato de arquivo padrão, o delimitador de coluna, o delimitador de linha e o tipo de compactação, incluindo opcionalmente um cabeçalho.

Finalize suas configurações. Em seguida, examine e selecione Salvar + Executar para concluir o processo.

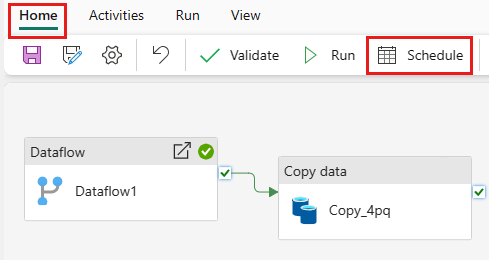

Projete o seu pipeline e salve para executar e carregar dados

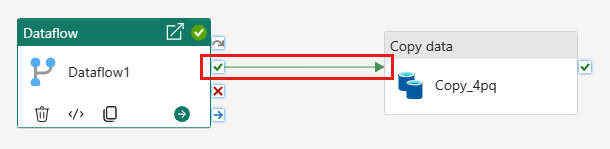

Para executar a atividade de Cópia após a atividade do Fluxo de Dados, arraste de Êxito na atividade do Fluxo de Dados para a atividade de Cópia. A atividade Copiar só é executada após a atividade Fluxo de Dados ser concluída com sucesso.

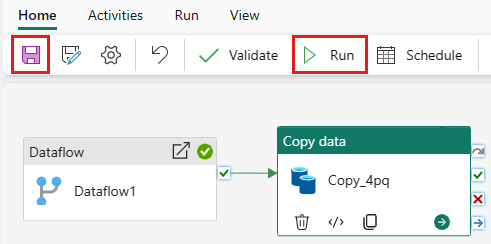

Selecione Salvar para salvar seu pipeline. Em seguida, selecione Executar para executar o pipeline e carregar seus dados.

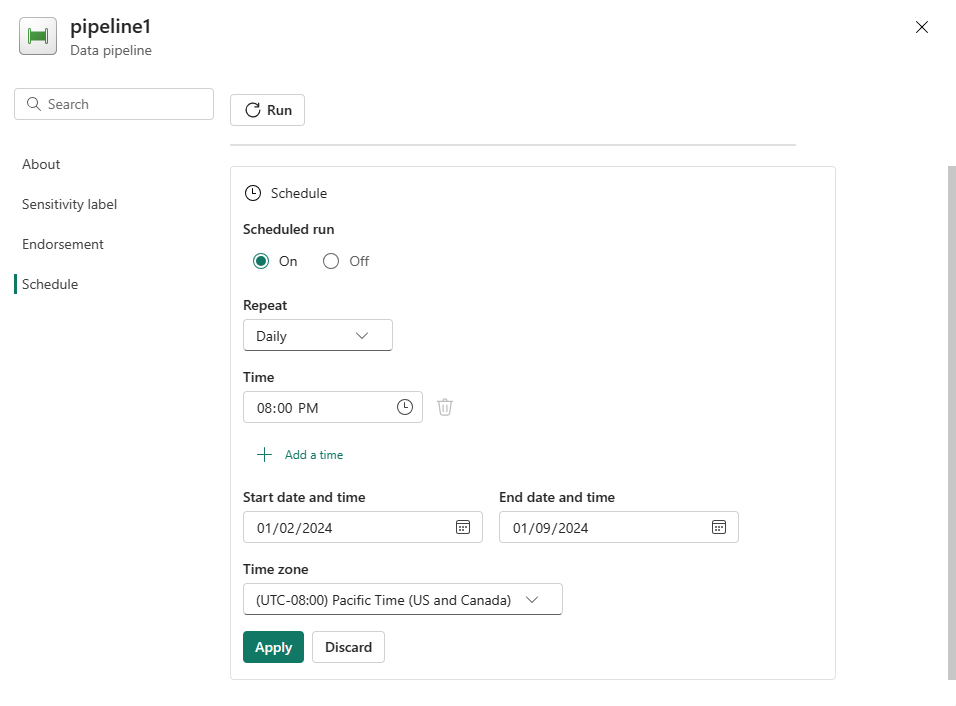

Agendar a execução do pipeline

Depois de concluir o desenvolvimento e o teste do pipeline, você poderá agendá-lo para ser executado automaticamente.

Na guia Página Inicial da janela do editor de pipeline, selecione Agendamento.

Configure o agendamento conforme necessário. O exemplo aqui agenda o pipeline a ser executado diariamente às 20h até o final do ano.

Conteúdo relacionado

Este exemplo mostra como criar e configurar um Dataflow Gen2 para criar uma consulta de mesclagem e armazená-la em um banco de dados SQL do Azure e copiar dados do banco de dados para um arquivo de texto no Armazenamento de Blobs do Azure. Você aprendeu a:

- Crie um fluxo de dados.

- Transforme os dados com o fluxo de dados.

- Crie um pipeline usando o fluxo de dados.

- Ordene a execução das etapas no pipeline.

- Copie dados com o Assistente de Cópia.

- Execute e agende seu pipeline.

Em seguida, prossiga para saber mais sobre como monitorar as execuções de pipeline.