Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

ПРИМЕНЯЕТСЯ КО ВСЕМ уровням управления API

В этой статье показано, как импортировать API Google Gemini, совместимый с OpenAI, для доступа к таким моделям, как gemini-2.0-flash. Для этих моделей управление API Azure может управлять конечной точкой завершения чата, совместимого с OpenAI.

Узнайте больше об управлении AI API в API Management.

- Возможности шлюза искусственного интеллекта в службе "Управление API Azure"

- Импорт API языковой модели

Предпосылки

- Существующий экземпляр системы управления API. Создайте его, если у вас его нет.

- Ключ API для API Gemini. Если у вас его нет, создайте его в Google AI Studio и сохраните его в безопасном месте.

Импорт API Gemini, совместимый с OpenAI, с помощью портала

Перейдите на портал Azure и откройте ваш экземпляр диспетчера API.

В меню слева в разделе API выберите API>+ Добавить API.

В разделе "Определение нового API" выберите API языковой модели.

На вкладке "Настройка API" :

Введите отображаемое имя и необязательное описание для API.

В url-адресе введите следующий базовый URL-адрес из документации по совместимости Gemini OpenAI:

https://generativelanguage.googleapis.com/v1beta/openaiВ path добавьте путь, который используется экземпляром службы управления API для маршрутизации запросов к конечным точкам API Gemini.

В поле "Тип" выберите "Создать API OpenAI".

В разделе "Ключ доступа" введите следующее:

- Имя заголовка: авторизация.

-

Значение заголовка (ключ):

Bearerза ним следует ключ API для API Gemini.

На оставшихся вкладках при необходимости настройте политики для управления потреблением токенов, семантического кэширования и безопасностью контента ИИ. Дополнительные сведения см. в разделе "Импорт API языковой модели".

Выберите Review.

После проверки параметров нажмите кнопку "Создать".

Управление API создает API и настраивает следующее:

- Ресурс для бэкенда и политика настройки бэкенд-службы, которые направляют запросы API к конечной точке Google Gemini.

- Доступ к серверной части LLM с помощью предоставленного ключа API Gemini. Ключ защищен как секретное именованное значение в службе управления API.

- (необязательно) Политики, помогающие отслеживать API и управлять ими.

Тестирование модели Gemini

После импорта API можно протестировать конечную точку завершения чата для API.

Выберите API, созданный на предыдущем шаге.

Откройте вкладку Тест.

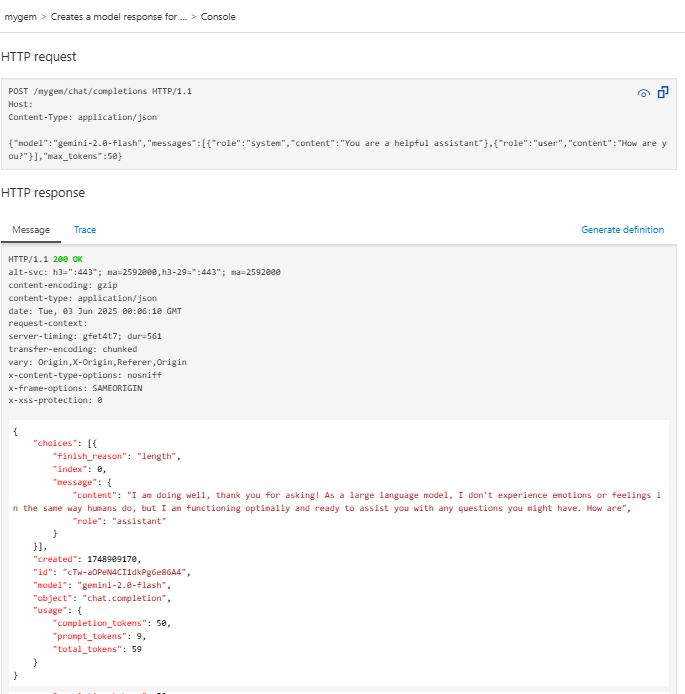

POST Creates a model response for the given chat conversationВыберите операцию, которая является запросом к конечнойPOSTточке/chat/completions.В разделе "Текст запроса" введите следующий код JSON, чтобы указать модель и пример запроса. В этом примере используется модель

gemini-2.0-flash.{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }При успешном выполнении теста серверная часть возвращает успешный HTTP-код ответа и некоторые данные. Добавлен к ответу данные об использовании маркеров, помогающие отслеживать потребление маркеров языковой модели и управлять ими.