В этой статье представлен обзор решений базы данных Azure, описанных в Центре архитектуры Azure.

Apache, Apache® Cassandra® и логотип Hadoop являются зарегистрированными товарными знаками или товарными знаками Apache Software Foundation в США и/или других странах. Использование этих меток не подразумевает подтверждения от Apache Software Foundation.

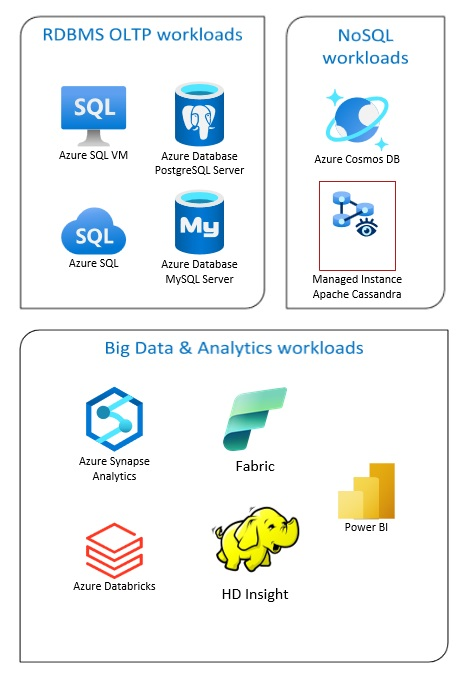

Решения базы данных Azure включают традиционные системы управления реляционными базами данных (RDBMS и OLTP), рабочие нагрузки больших данных и аналитики (включая OLAP) и рабочие нагрузки NoSQL.

Рабочие нагрузки RDBMS включают обработку транзакций в сети (OLTP) и интерактивную аналитическую обработку (OLAP). Данные из нескольких источников в организации можно объединить в хранилище данных. Вы можете использовать процесс извлечения, преобразования и загрузки (ETL) или извлечения, загрузки и преобразования (ELT) для перемещения и преобразования исходных данных. Дополнительные сведения о базах данных RDBMS см. в статье "Изучение реляционных баз данных в Azure".

Архитектура больших данных предназначена для обработки приема, обработки и анализа больших или сложных данных. Решения для больших данных обычно включают большое количество реляционных и нереляционных данных, которые традиционные системы RDBMS не подходят для хранения. Обычно эти решения включают такие решения, как Data Lake, Delta Lake и lakehouses. Дополнительные сведения см. в разделе "Архитектура аналитики".

Базы данных NoSQL взаимозаменяемо называются нереляционными, noSQL DBS или не SQL, чтобы подчеркнуть тот факт, что они могут обрабатывать огромные объемы быстро изменяющихся неструктурированных данных. Они не хранят данные в таблицах, строках и столбцах, таких как базы данных SQL. Дополнительные сведения о no SQL DBS Database см. в разделе NoSQL Data and What are No База данных SQL s?.

В этой статье содержатся ресурсы для получения сведений о базах данных Azure. В нем описаны пути реализации архитектур, которые соответствуют вашим потребностям и рекомендациям, которые следует учитывать при разработке решений.

Существует множество архитектур для решения потребностей базы данных. Мы также предоставляем идеи решения для вас, которые включают ссылки на все необходимые компоненты.

Сведения о базах данных в Azure

По мере того как вы начинаете думать о возможных архитектурах для вашего решения, важно выбрать правильное хранилище данных. Если вы не знакомы с базами данных в Azure, лучше всего начать microsoft Learn. Эта бесплатная онлайн-платформа предоставляет видео и учебники для практического обучения. Microsoft Learn предлагает схемы обучения, основанные на вашей роли задания, например разработчик или аналитик данных.

Вы можете начать с общего описания разных баз данных в Azure и их использования. Вы также можете просматривать модули данных Azure и выбирать подход к хранилищу данных в Azure. Эти статьи помогут вам понять варианты в решениях данных Azure и узнать, почему некоторые решения рекомендуется в определенных сценариях.

Ниже приведены некоторые модули Learn, которые могут оказаться полезными.

- Проектирование миграции в Azure

- Развертывание База данных SQL Azure

- Изучение баз данных Azure и служб аналитики

- Защита базы данных SQL Azure

- Azure Cosmos DB

- База данных Azure для PostgreSQL

- База данных Azure для MySQL

- SQL Server на виртуальных машинах Azure

Путь к рабочей среде

Чтобы найти варианты, полезные для работы с реляционными данными, рассмотрите следующие ресурсы:

- Сведения о ресурсах для сбора данных из нескольких источников и способах и применении преобразований данных в конвейерах данных см. в статье Аналитика в Azure.

- Сведения о OLAP, которая упорядочивает крупные бизнес-базы данных и поддерживает сложный анализ, см. в статье "Онлайн-аналитика".

- Сведения о системе OLTP записывают бизнес-взаимодействия по мере их возникновения, см. в разделе "Обработка транзакций в Сети".

Нереляционная база данных не использует табличную схему строк и столбцов. Дополнительные сведения см. в статье о нереляционных данных и NoSQL.

Сведения о озерах данных, которые содержат большое количество данных в собственном формате, см. в разделе Озера данных.

Архитектура больших данных может обрабатывать прием, обработку и анализ данных, которые слишком большие или слишком сложные для традиционных систем баз данных. Дополнительные сведения см. в разделе "Архитектура больших данных" и "Аналитика".

Гибридное облако — это ИТ-среда, которая объединяет общедоступные облачные и локальные центры обработки данных. Дополнительные сведения см. в статье "Расширение локальных решений данных в облаке " или рассмотрение Azure Arc в сочетании с базами данных Azure.

Azure Cosmos DB является полностью управляемой службой для баз данных NoSQL и предназначена для разработки современных приложений. Дополнительные сведения см. в статье о модели ресурсов Azure Cosmos DB.

Сведения о вариантах передачи данных в Azure и из нее см. в статье "Передача данных в Azure и из Azure".

Рекомендации

Ознакомьтесь с этими рекомендациями при разработке решений.

| Рекомендации | Description |

|---|---|

| Шаблоны управления данными | Управление данными является ключевым элементом облачных приложений. Он влияет на наиболее качественные атрибуты. |

| Реализация шаблона транзакционной папки исходящих сообщений с Azure Cosmos DB | Узнайте, как использовать шаблон исходящих транзакций для надежного обмена сообщениями и гарантированной доставки событий. |

| Глобальное распределение данных с помощью Azure Cosmos DB | Чтобы обеспечить низкую задержку и высокую доступность, некоторые приложения необходимо развернуть в центрах обработки данных, близких к их пользователям. |

| Безопасность в Azure Cosmos DB | Рекомендации по обеспечению безопасности помогают предотвратить, обнаруживать и реагировать на нарушения базы данных. |

| Непрерывное резервное копирование с восстановлением на определенный момент времени в Azure Cosmos DB | Узнайте о функции восстановления на определенный момент времени в Azure Cosmos DB. |

| Обеспечение высокой доступности с помощью Azure Cosmos DB | Azure Cosmos DB предоставляет несколько функций и параметров конфигурации для обеспечения высокой доступности. |

| Высокий уровень доступности для База данных SQL Azure и Управляемый экземпляр SQL | База данных не должна быть одной точкой сбоя в архитектуре. |

Выбор технологий

Существует множество вариантов использования технологий с базами данных Azure. Эти статьи помогут вам выбрать лучшие технологии для ваших потребностей.

- Выбор хранилища данных

- Выбор хранилища аналитических данных в Azure

- Выбор технологии для анализа данных в Azure

- Выбор технологии пакетной обработки в Azure

- Выбор технологии хранилища больших данных в Azure

- Выбор технологии оркестрации конвейера данных в Azure

- Выбор хранилища данных поиска в Azure

- Выбор технологии потоковой обработки в Azure

Оставайтесь актуальными с базами данных

Ознакомьтесь с обновлениями Azure, чтобы поддерживать актуальность технологии баз данных Azure.

Связанные ресурсы

- Сценарий Adatum Corporation для управления данными и аналитики в Azure

- Сценарий Lamna Healthcare для управления данными и аналитики в Azure

- Оптимизация администрирования экземпляров SQL Server

- Сценарий Relecloud для управления данными и аналитики в Azure

Примеры решений

Эти идеи решения являются некоторыми из примеров подходов, которые можно адаптировать к вашим потребностям.

- Кэш данных

- Корпоративное хранилище данных

- Обмен сообщениями

- Бессерверные приложения с помощью Azure Cosmos DB

Аналогичные продукты базы данных

Если вы знакомы с Amazon Web Services (AWS) или Google Cloud, ознакомьтесь со следующими сравнениями: