Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

В этой статье описываются показатели производительности, которые датасторы Azure NetApp Files предоставляют для виртуальных машин на Azure VMware Solution (AVS).

Тестируемые сценарии приведены следующим образом:

- Запуск нескольких виртуальных машин на одном узле AVS и одном хранилище данных Azure NetApp Files

- Одно для нескольких хранилищ данных Azure NetApp Files с одним хостом AVS

- Масштабирование хранилища Azure NetApp Files с несколькими узлами AVS

Для каждого сценария были проверены следующие read:write коэффициенты ввода-вывода: 100:0, 75:25, 50:50, 25:75, 0:100

Бенчмарки, описанные в этой статье, были выполнены с достаточной пропускной способностью, чтобы предотвратить влияние софт лимитов на производительность. Уровни производительности могут быть достигнуты с помощью уровней обслуживания Azure NetApp Files Premium и Ultra, а в некоторых случаях — с помощью уровня обслуживания Standard. Дополнительные сведения о пропускной способности тома см. в рекомендациях по производительности для Azure NetApp Files.

Задержка

Задержка трафика от AVS к хранилищам данных Azure NetApp Files зависит от субмиллисекунда (для сред под минимальной нагрузкой) до 2–3 миллисекунда (для сред в условиях средней и тяжелой нагрузки). Задержка потенциально выше для сред, пытающихся выйти за пределы пропускной способности различных компонентов. Задержка и пропускная способность могут отличаться в зависимости от факторов, включая размер ввода-вывода, коэффициенты чтения и записи, конкурирующий сетевой трафик и другие.

Масштабирование производительности

Каждый узел AVS подключается к каждому хранилищу данных Azure NetApp Files с фиксированным числом сетевых потоков, которые могут ограничить пропускную способность отдельного диска виртуальной машины (VMDK) или узла AVS к каждому хранилищу данных. В зависимости от заданного набора рабочих нагрузок и их требований к производительности может потребоваться несколько хранилищ данных. Общая производительность хранилища для каждого узла AVS может быть увеличена путем распространения рабочих нагрузок в нескольких хранилищах данных. Вы также можете повысить производительность, распространяя рабочую нагрузку на каждое хранилище данных между узлами AVS. На следующем графике показана относительная производительность масштабирования дополнительных хранилищ данных.

Примечание.

Потолк пропускной способности для внешних хранилищ данных может быть ограничен другими факторами, включая пропускную способность сети, ограничения SKU или потолки уровней обслуживания для томов Azure NetApp Files.

Пропускная способность каждого отдельного узла может быть затронута выбранным SKU AVS. Номер SKU AV64 оборудован сетевыми картами с 100-гигабитным Ethernet (GbE). Другие номера SKU имеют сетевые адаптеры с поддержкой 25 GbE. Отдельные сетевые потоки (например, подключения NFS) могут быть ограничены сетевыми адаптерами с интерфейсом 25 Гбит/с.

Сведения о среде AV64

Результаты этой статьи были достигнуты с помощью следующей конфигурации среды:

- Размер узла Azure VMware Solution: AV64, работающий под управлением VMware ESXi версии 7u3.

- Подключение частного облака в Microsoft Azure VMware Solution: шлюз UltraPerformance с FastPath

- Гостевые виртуальные машины: Rocky Linux 9, 16 виртуальных ЦП, 64 ГБ памяти

- Генератор рабочей нагрузки:

fio3.35

Примечание.

Тесты AV64 сосредоточены только на оценке одного узла ESXi. Масштабирование числа узлов ESXi рассматривается в разделе AV36.

Хранилища данных Azure NetApp Files, подключенные к одному узлу AV64, работающему с несколькими хранилищами.

На следующих графиках сравнивается пропускная способность одной виртуальной машины в одном хранилище данных Azure NetApp Files с агрегированной пропускной способностью восьми виртуальных машин, каждая из которых содержит собственные хранилища данных Azure NetApp Files. Аналогичная пропускная способность может быть достигнута меньшим количеством виртуальных машин с дополнительными VMDK, распределенными по тому же количеству хранилищ данных.

Этот граф сравнивает пропускную способность:

На этом графе сравнивается I/OPS:

Сведения о среде AV36

Эти тесты проводились с помощью конфигурации среды:

- Решение Azure VMware размер хоста: AV36 под управлением VMware ESXi версии 7u3

- Подключение частного облака в Microsoft Azure VMware Solution: шлюз UltraPerformance с FastPath

- Гостевые виртуальные машины: Ubuntu 21.04, 16 виртуальных ЦП, 64 ГБ памяти

- Генератор рабочей нагрузки:

fio

Одно-несколько виртуальных машин, работающих на одном узле AV36 и одном хранилище данных Azure NetApp Files

В запросе узла AVS ввод-вывод данных в хранилище Azure NetApp Files происходит через единственный сетевой поток. Эти графы сравнивают пропускную способность и операции ввода-вывода одной виртуальной машины с агрегированной пропускной способностью и I/OPS из четырех виртуальных машин. В последующих сценариях число сетевых потоков увеличивается по мере добавления дополнительных узлов и хранилищ данных.

Один узел AV36 взаимодействует с несколькими хранилищами данных Azure NetApp Files

Следующие графы сравнивают пропускную способность одной виртуальной машины в одном хранилище данных Azure NetApp Files с агрегированной пропускной способностью четырех хранилищ данных Azure NetApp Files. В обоих сценариях каждая виртуальная машина имеет VMDK в каждом хранилище данных Azure NetApp Files.

Следующие графики сравнивают I/OPS одной виртуальной машины в одном хранилище данных Azure NetApp Files с суммарным I/OPS из восьми хранилищ данных Azure NetApp Files. В обоих сценариях каждая виртуальная машина имеет VMDK в каждом хранилище данных Azure NetApp Files.

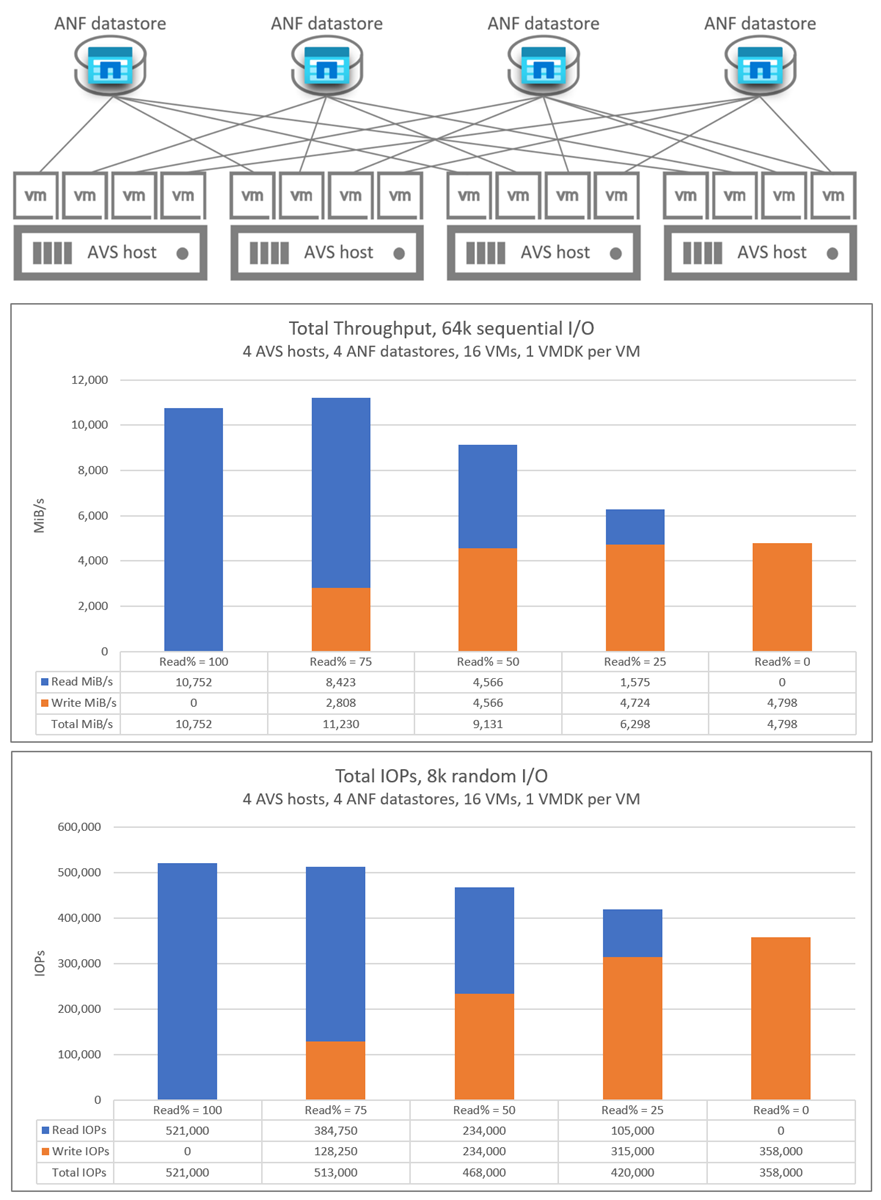

Масштабирование хранилищ данных Azure NetApp Files с несколькими узлами AV36

На следующем графике показана агрегированная пропускная способность и I/OPS 16 виртуальных машин, распределенных между четырьмя узлами AVS. Существует четыре виртуальных машины на узел AVS, каждая из которых размещена в другом хранилище данных Azure NetApp Files. Практически идентичные результаты были достигнуты с помощью одной виртуальной машины на каждом узле с четырьмя виртуальными дисками для каждой виртуальной машины, и каждый из этих виртуальных дисков находился в отдельном хранилище данных.