Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

ОБЛАСТЬ ПРИМЕНЕНИЯ:  Фабрика данных Azure

Фабрика данных Azure  Azure Synapse Analytics

Azure Synapse Analytics

Совет

Попробуйте использовать фабрику данных в Microsoft Fabric, решение для аналитики с одним интерфейсом для предприятий. Microsoft Fabric охватывает все, от перемещения данных до обработки и анализа данных в режиме реального времени, бизнес-аналитики и отчетности. Узнайте, как бесплатно запустить новую пробную версию !

Примечание.

Диспетчер оркестрации рабочих процессов управляется Apache Airflow.

Примечание.

Диспетчер оркестрации рабочих процессов для Фабрика данных Azure зависит от приложения Apache Airflow открытый код. Документация и дополнительные руководства по Airflow можно найти на страницах документации по Apache Airflow или сообщества.

Диспетчер оркестрации рабочих процессов в Фабрика данных Azure использует ациклические графы на основе Python для выполнения рабочих процессов оркестрации. Чтобы использовать эту функцию, необходимо предоставить группы доступности и подключаемые модули в Хранилище BLOB-объектов Azure. Вы можете запустить пользовательский интерфейс Airflow из ADF с помощью интерфейса командной строки (CLI) или пакета SDK для управления группами доступности программного обеспечения.

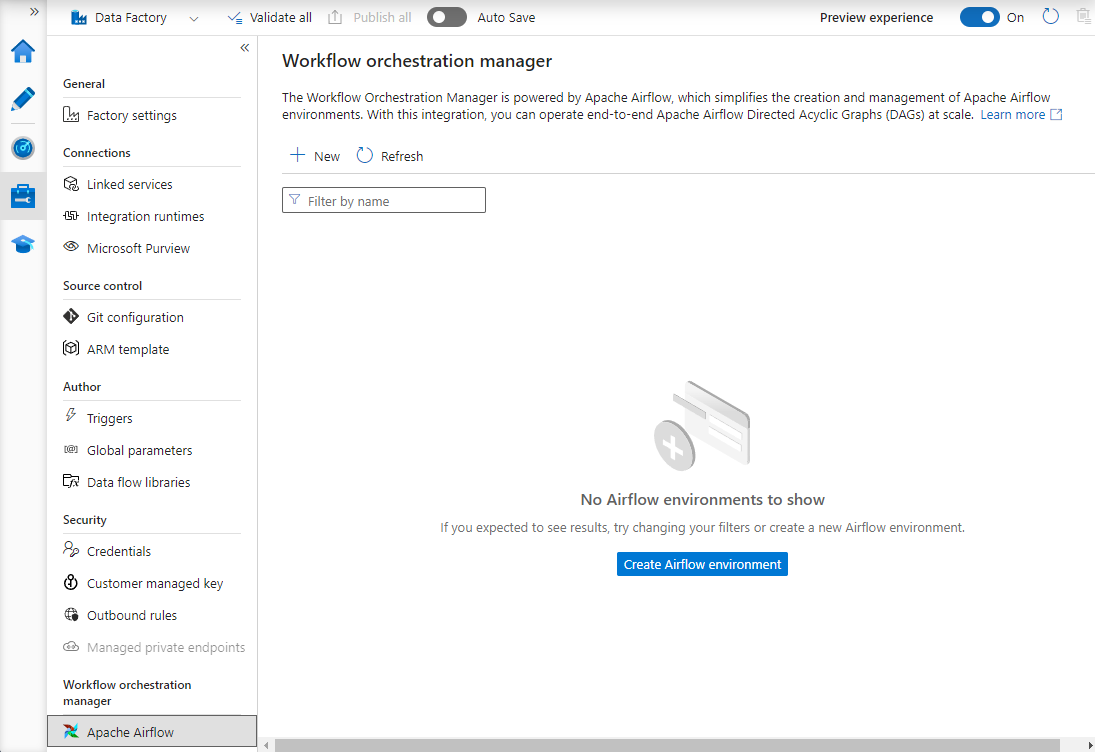

Создание среды диспетчера оркестрации рабочих процессов

Следующие шаги настраивают и настраивают среду Диспетчера оркестрации рабочих процессов.

Необходимые компоненты

Подписка Azure. Если у вас нет подписки Azure, создайте бесплатную учетную запись, прежде чем начинать работу. Создайте или выберите существующую фабрику данных в регионе, где поддерживается предварительная версия диспетчера оркестрации рабочих процессов.

Процедура создания среды

Создайте новую среду Диспетчера оркестрации рабочих процессов. Перейдите к разделу "Управление центром ->Airflow (предварительная версия) ->+Создать , чтобы создать новую среду Airflow

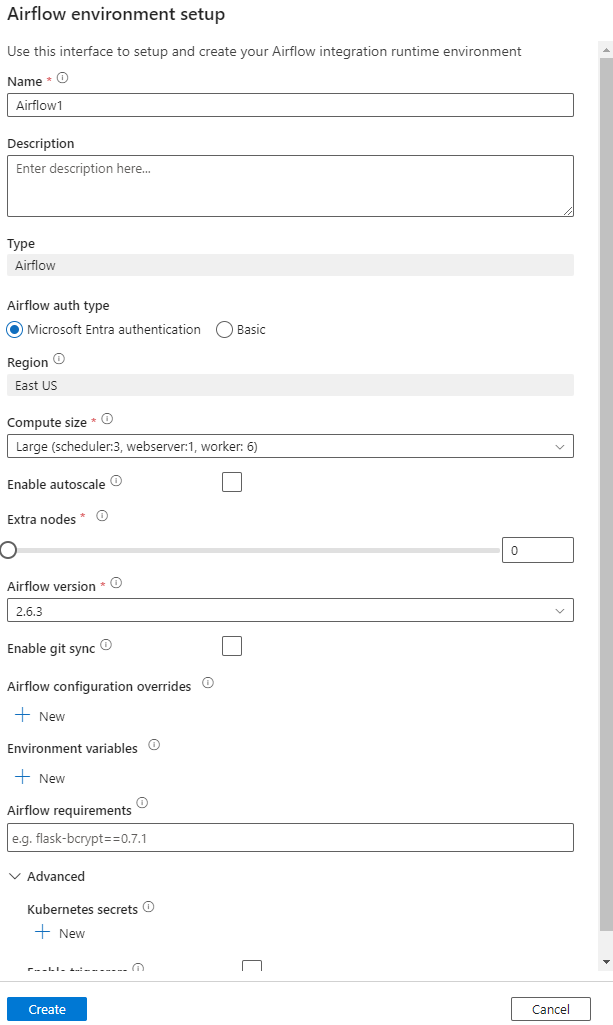

Укажите сведения (конфигурация Airflow)

Внимание

При использовании базовой проверки подлинности запомните имя пользователя и пароль, указанные на этом экране. Он потребуется для входа позже в пользовательский интерфейс Диспетчера рабочих процессов. По умолчанию используется идентификатор Microsoft Entra, и он не требует создания имени пользователя или пароля для среды Airflow, а вместо этого использует учетные данные пользователя, вошедшего в систему, для Фабрика данных Azure для входа в систему или отслеживания daGs.

Переменные среды простое хранилище значений ключа в Airflow для хранения и получения произвольного содержимого или параметров.

Требования можно использовать для предварительной установки библиотек Python. Вы также можете обновить их позже.

Импорт групп daGs

В следующих шагах описывается импорт daGs в диспетчер оркестрации рабочих процессов.

Необходимые компоненты

Вам потребуется отправить пример DAG в доступную учетную запись хранения (должна находиться в папке dags).

Примечание.

Хранилище BLOB-объектов за виртуальной сетью не поддерживается во время предварительной версии.

Конфигурация KeyVault в storageLinkedServices не поддерживается для импорта dags.

Пример Apache Airflow версии 2.x DAG. Пример Apache Airflow версии 1.10 DAG.

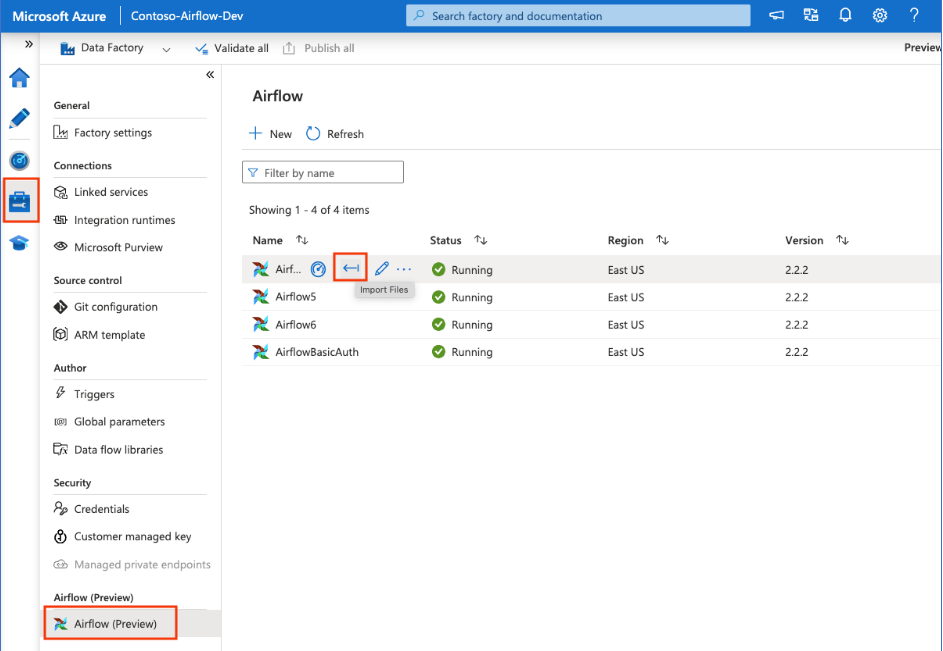

Действия по импорту

Скопируйте содержимое (версии 2.x или версии 1.10 на основе среды Airflow, которую вы настроили) в новый файл, который называется tutorial.py.

Отправьте tutorial.py в хранилище BLOB-объектов. (Как отправить файл в большой двоичный объект)

Примечание.

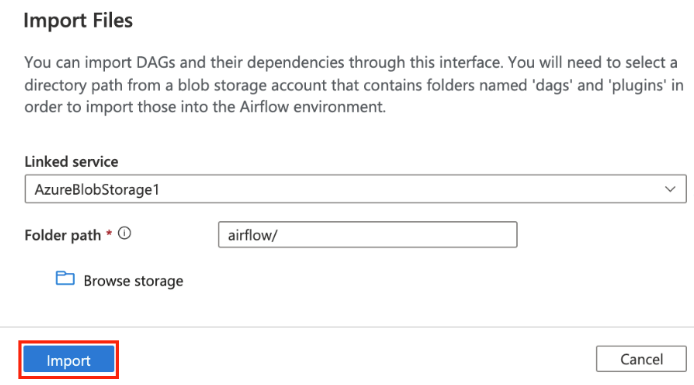

Вам потребуется выбрать путь к каталогу из учетной записи хранения BLOB-объектов, содержащей папки с именем dags и подключаемых модулей, чтобы импортировать их в среду Airflow. Подключаемые модули не являются обязательными. Вы также можете использовать контейнер с именем dags и отправить в него все файлы Airflow.

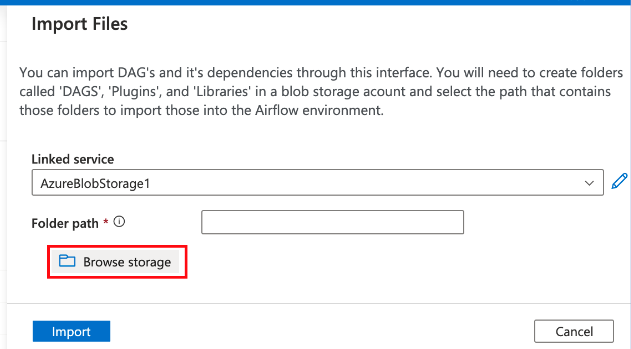

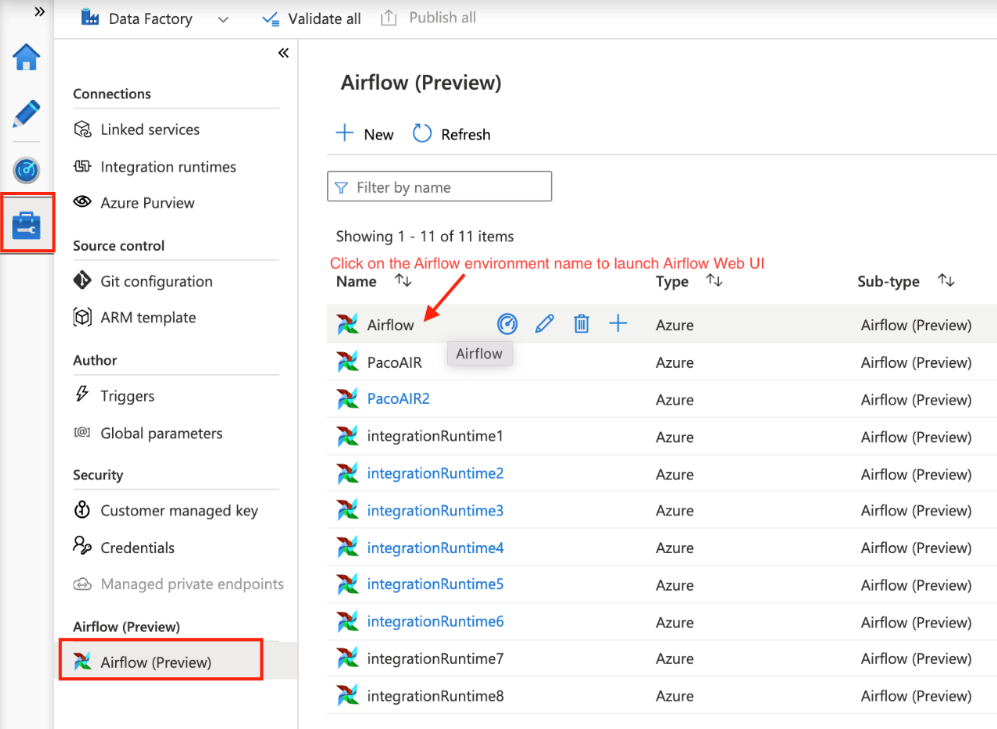

Выберите в разделе "Управление" (предварительная версия) в разделе "Управление". Затем наведите указатель мыши на ранее созданную среду Airflow и выберите импорт файлов для импорта всех зависимостей и зависимостей в среду Airflow.

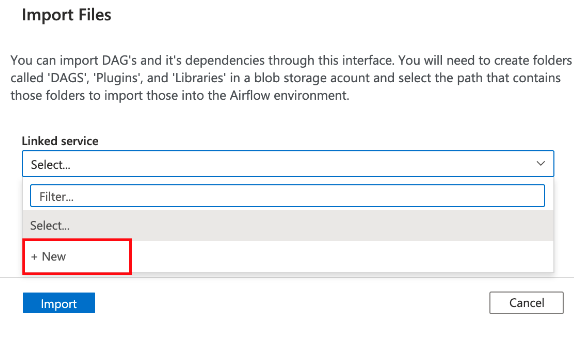

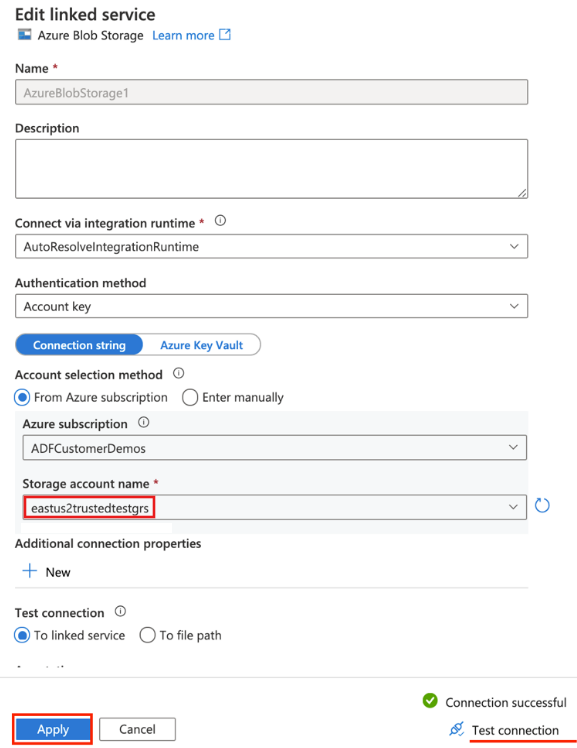

Создайте связанную службу для доступной учетной записи хранения, указанной в предварительных требованиях (или используйте существующую, если у вас уже есть собственные группы управления доступом).

Используйте учетную запись хранения, в которой вы отправили DAG (проверьте предварительные требования). Проверьте подключение, а затем нажмите кнопку "Создать".

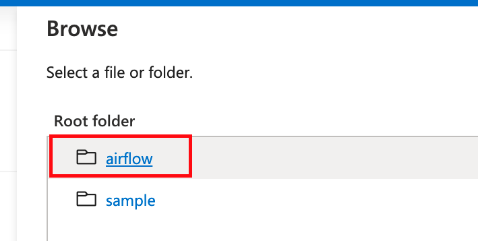

Найдите и выберите поток воздуха, если используется пример URL-адреса SAS или выберите папку, содержащую папку dags с файлами DAG.

Примечание.

Вы можете импортировать группы УПРАВЛЕНИЯ и их зависимости с помощью этого интерфейса. Вам потребуется выбрать путь к каталогу из учетной записи хранения BLOB-объектов, содержащей папки с именем dags и подключаемых модулей, чтобы импортировать их в среду Airflow. Подключаемые модули не являются обязательными.

Примечание.

Импорт daGs может занять несколько минут во время предварительной версии. Центр уведомлений (значок колокольчика в пользовательском интерфейсе ADF) можно использовать для отслеживания обновлений состояния импорта.

Устранение неполадок с импортом DAG

Проблема. Импорт DAG занимает более 5 минут: уменьшите размер импортированных групп daG с одним импортом. Одним из способов этого является создание нескольких папок DAG с меньшим количеством daG в нескольких контейнерах.

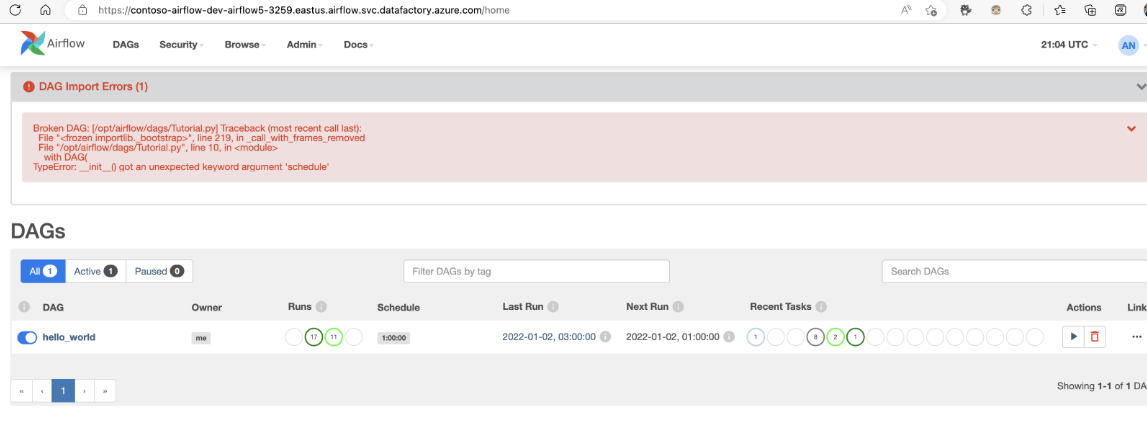

Проблема. Импортированные группы управления доступности не отображаются при входе в пользовательский интерфейс Airflow. Устранение неполадок. Войдите в пользовательский интерфейс Airflow и просмотрите, существуют ли ошибки синтаксического анализа DAG. Это может произойти, если файлы DAG содержат любой несовместимый код. Вы найдете точные номера строк и файлы, которые имеют проблему через пользовательский интерфейс Airflow.

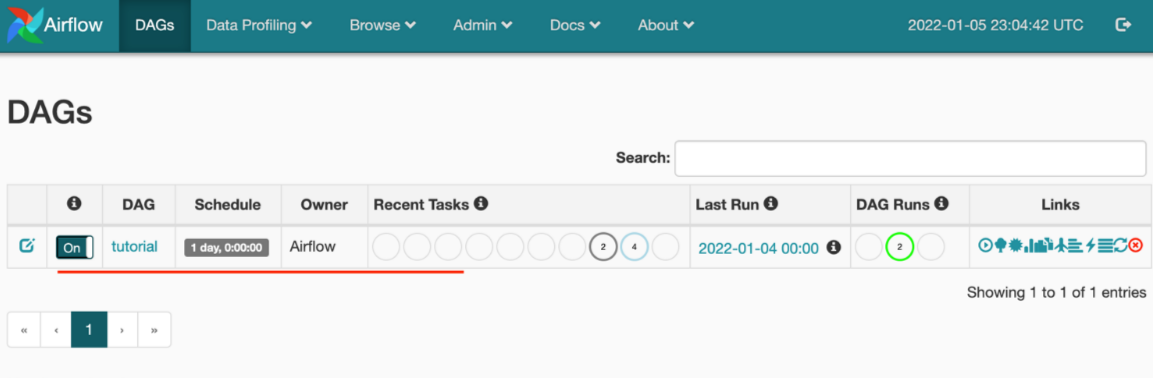

Мониторинг запусков DAG

Чтобы отслеживать группы доступности Airflow, войдите в пользовательский интерфейс Airflow с помощью ранее созданного имени пользователя и пароля.

Выберите созданную среду Airflow.

Войдите с помощью имени пользователя и пароля, предоставленного во время создания среды выполнения интеграции Airflow. (При необходимости можно сбросить имя пользователя или пароль, изменив среду выполнения интеграции Airflow)

Удаление групп доступности из среды Airflow

Если вы используете Airflow версии 1.x, удалите группы DAG, развернутые в любой среде Airflow (IR), необходимо удалить группы доступности в двух разных местах.

- Удаление DAG из пользовательского интерфейса Airflow

- Удаление DAG в пользовательском интерфейсе ADF

Примечание.

Это текущий интерфейс во время общедоступной предварительной версии, и мы будем улучшать этот интерфейс.