Репликация нескольких объектов из SAP через SAP CDC

ОБЛАСТЬ ПРИМЕНЕНИЯ:  Фабрика данных Azure

Фабрика данных Azure  Azure Synapse Analytics

Azure Synapse Analytics

Совет

Попробуйте использовать фабрику данных в Microsoft Fabric, решение для аналитики с одним интерфейсом для предприятий. Microsoft Fabric охватывает все, от перемещения данных до обработки и анализа данных в режиме реального времени, бизнес-аналитики и отчетности. Узнайте, как бесплатно запустить новую пробную версию !

В этой статье описывается шаблон решения, который можно использовать для репликации нескольких объектов ODP из SAP через соединитель SAP CDC в Azure Data Lake 2-го поколения в формате Delta с разделом ключа.

Информация о шаблоне решения

Этот шаблон считывает файл внешнего элемента управления в формате JSON в хранилище хранилища, который содержит контексты SAP ODP, объекты SAP ODP и ключевые столбцы из исходной системы SAP, а также контейнеры, папки и секции из целевого хранилища Azure Data Lake 2-го поколения. Затем он копирует каждый из объектов SAP ODP из системы SAP в Azure Data Lake 2-го поколения в формате Delta.

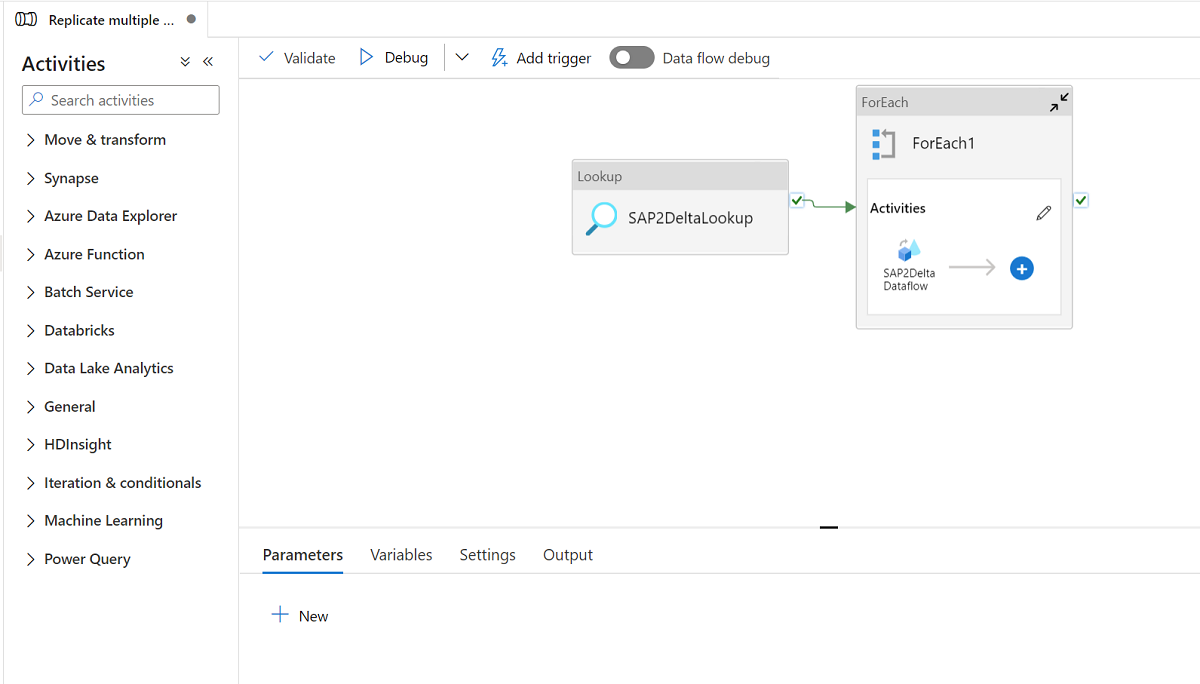

Шаблон состоит из трех действий.

- Подстановка извлекает список объектов SAP ODP для загрузки и путь к целевому хранилищу из файла внешнего элемента управления в хранилище Azure Data Lake 2-го поколения.

- ForEach получает список объектов SAP ODP из действия подстановки и выполняет итерацию каждого объекта в действие потока данных сопоставления.

- Сопоставление потока данных реплицирует каждый объект SAP ODP из системы SAP в Azure Data Lake 2-го поколения в формате Delta. Она выполнит начальную полную нагрузку в первом запуске, а затем выполняет добавочную нагрузку в последующих запусках автоматически. Он объединит изменения в Azure Data Lake 2-го поколения в разностном формате.

В этом шаблоне требуется файл внешнего элемента управления в формате JSON. Схема для файла элемента управления приведена ниже.

- checkPointKey — это пользовательский ключ для управления контрольной точкой измененной записи данных в ADF. Дополнительные сведения см. в этой статье.

- sapContext — это контекст SAP ODP из исходной системы SAP. Дополнительные сведения см. в этой статье.

- sapObjectName — это имя объекта SAP ODP для загрузки из системы SAP. Дополнительные сведения см. в этой статье.

- sapRunMode — определить способ загрузки объекта SAP. Она может быть fullLoad, добавочная загрузка или fullAndIncrementalLoad.

- sapKeyColumns — это имена ключевых столбцов из объектов SAP ODP, используемых для выполнения дедуп в потоке данных сопоставления.

- sapPartitions — это список условий секции, что приводит к отдельным процессам извлечения в подключенной системе SAP.

- deltaContainer — это имя контейнера в Azure Data Lake 2-го поколения в качестве целевого хранилища.

- deltaFolder — это имя папки в Azure Data Lake 2-го поколения в качестве целевого хранилища.

- deltaKeyColumns — это столбцы, используемые для определения того, соответствует ли строка из источника строке из приемника при необходимости обновления или удаления строки.

- deltaPartition — это столбец, используемый для создания секций для каждого уникального значения в таком столбце для записи данных в разностный формат в Azure Data Lake 2-го поколения через кластер Spark, используемый при сопоставлении потока данных. Дополнительные сведения см. здесь

Пример файла элемента управления приведен ниже:

[

{

"checkPointKey":"CheckPointFor_ZPERFCDPOS$F",

"sapContext": "ABAP_CDS",

"sapObjectName": "ZPERFCDPOS$F",

"sapRunMode": "fullAndIncrementalLoad",

"sapKeyColumns": [

"TABKEY"

],

"sapPartitions": [

[{

"fieldName": "TEXTCASE",

"sign": "I",

"option": "EQ",

"low": "1"

},

{

"fieldName": "TEXTCASE",

"sign": "I",

"option": "EQ",

"low": "X"

}]

],

"deltaContainer":"delta",

"deltaFolder":"ZPERFCDPOS",

"deltaKeyColumns":["TABKEY"],

"deltaPartition":"TEXTCASE",

"stagingStorageFolder":"stagingcontainer/stagingfolder"

},

{

"checkPointKey":"CheckPointFor_Z0131",

"sapContext": "SAPI",

"sapObjectName": "Z0131",

"sapRunMode": "incrementalLoad",

"sapKeyColumns": [

"ID"

],

"sapPartitions": [],

"deltaContainer":"delta",

"deltaFolder":"Z0131",

"deltaKeyColumns":["ID"],

"deltaPartition":"COMPANY",

"stagingStorageFolder":"stagingcontainer/stagingfolder"

}

]

Использование шаблона решения

Создайте и отправьте файл управления в формат JSON в azure Data Lake 2-го поколения в качестве целевого хранилища. Контейнер по умолчанию для хранения файла элемента управления — демонстрация , а имя файла управления по умолчанию — SapToDeltaParameters.json.

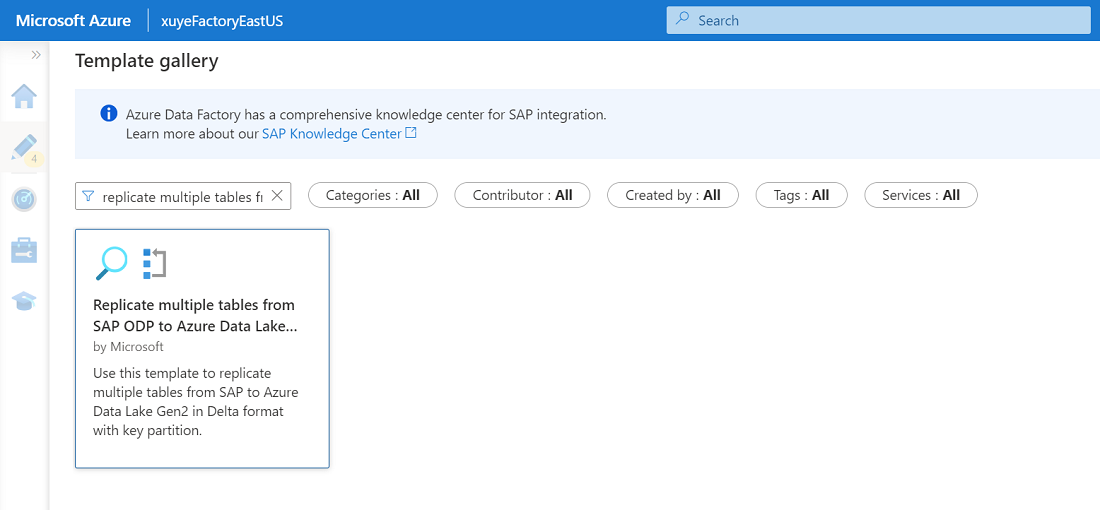

Перейдите в раздел "Репликация нескольких таблиц из SAP ODP", чтобы Azure Data Lake Storage 2-го поколения в шаблоне разностного формата и щелкните его.

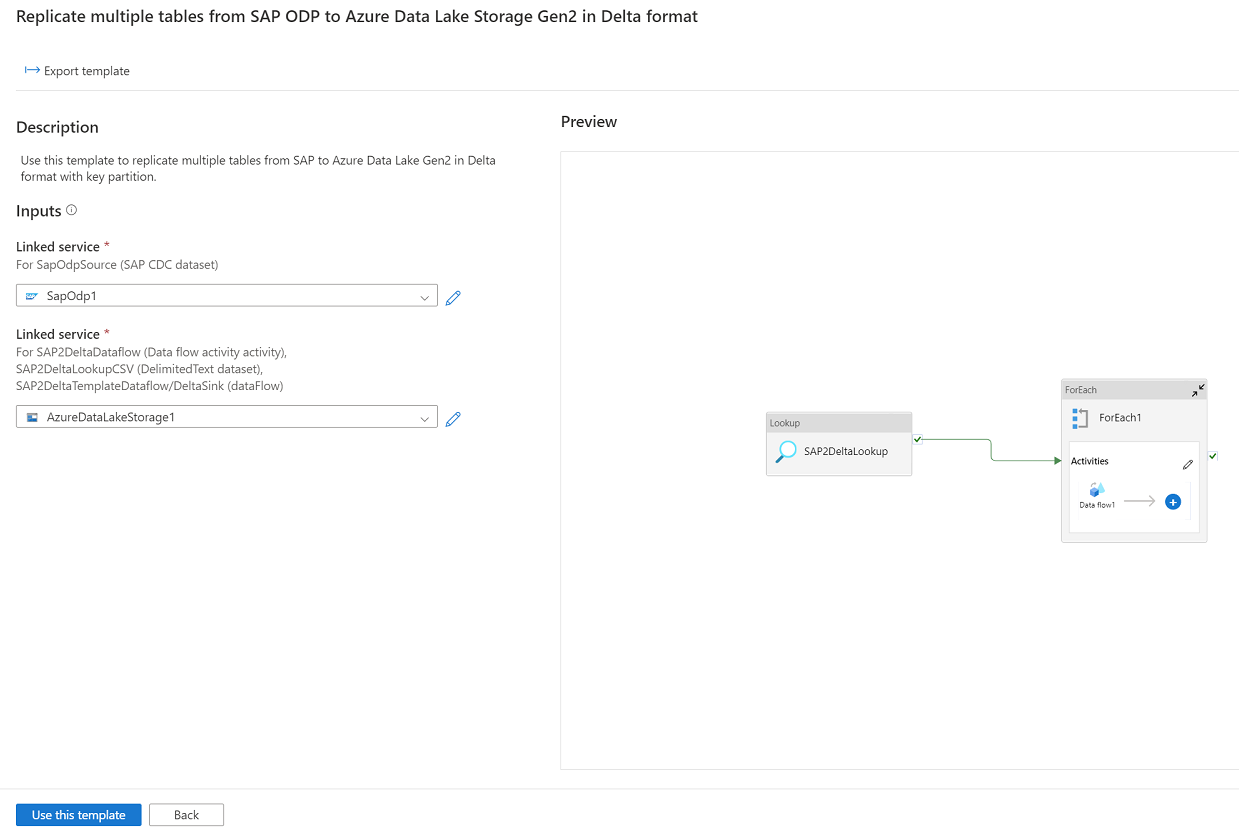

Нажмите кнопку "Продолжить " и введите связанную службу, подключенную к системе SAP в качестве источника, и связанная служба, подключенная к Azure Data Lake 2-го поколения в качестве назначения. Дополнительные сведения о связанной службе SAP CDC см. здесь. Помните, что файл внешнего элемента управления должен быть отправлен в ту же учетную запись Azure Data Lake 2-го поколения.

Нажмите кнопку "Использовать этот шаблон ", и вы увидите, что конвейер готов к использованию.

Связанный контент

Обратная связь

Ожидается в ближайшее время: в течение 2024 года мы постепенно откажемся от GitHub Issues как механизма обратной связи для контента и заменим его новой системой обратной связи. Дополнительные сведения см. в разделе https://aka.ms/ContentUserFeedback.

Отправить и просмотреть отзыв по